Рост любой компании сопровождается ростом ИТ-инфраструктуры. А если ты — облачный провайдер, то инфраструктуры очень много. И нагрузка на неё тоже высокая. Когда нам стало тесно в границах используемых ЦОД, мы решили построить собственный — под рабочим названием DC4Y.1-Марфино. Сегодня расскажем о том, как началось строительство собственного дата-центра Cloud4Y и каким он должен стать.

Зачем провайдеру собственный дата-центр и чем это грозит

Собственный дата-центр даёт облачному провайдеру полный контроль над всей инфраструктурой, включая питание, охлаждение, климатические системы, резервирование и физическую безопасность. Это позволяет минимизировать риски, связанные с зависимостью от внешних подрядчиков, и обеспечить максимальную отказоустойчивость на всех уровнях: от аппаратных решений до инфраструктуры электроснабжения. Провайдер получает возможность разрабатывать собственные стандарты безопасности, контроля и оперативности обслуживания, адаптированные к специфическим потребностям клиентов.

Такой подход делает провайдера единственным ответственным за качество услуг, что повышает доверие клиентов. Более того, собственный ЦОД открывает дополнительные бизнес-возможности: сдача в аренду серверных стоек, предоставление места для размещения оборудования заказчиков и возможность предлагать гибридные решения, сочетающие облачные сервисы и физическую инфраструктуру.

Важное преимущество заключается и в снижении зависимости от других провайдеров ЦОД, что уменьшает риски простоев и повышает отказоустойчивость. Кроме того, обладающий собственным дата‑центром облачный провайдер может улучшить клиентский сервис, предлагая индивидуальные решения и снижая время отклика на запросы.

Казалось бы, одни плюсы. Так почему для облачных провайдеров обычное дело сотрудничать с ДЦ, арендовать стойки и ставить там своё оборудование? Всё дело в специализации.

Для облачного провайдера управление ЦОДом — это отдельное направление бизнеса, требующее квалифицированных специалистов и специфических знаний. Часто провайдеры сталкиваются с нехваткой опыта и кадров, что приводит к распылению собственных ресурсов. Вместо фокусировки на развитии облачных услуг, компания вынуждена обучать сотрудников работе с инфраструктурой и инженерными системами, что повышает риск разного рода инцидентов из-за человеческого фактора. Это может негативно сказаться как на работе самого ЦОДа, так и на качестве облачных сервисов.

Кроме того, постройка и содержание собственного ЦОДа сопряжены с большими тратами. Требуется не только возведение здания, но и внедрение сложных инженерных систем: бесперебойного электропитания, промышленных систем охлаждения, пожаротушения, мониторинга, контроля доступа и т. д. Кроме того, необходима сертификация всех процессов, что требует согласования с регуляторами.

Даже после ввода в эксплуатацию ЦОД требует постоянных инвестиций в модернизацию оборудования, регламентные работы и мониторинг, чтобы поддерживать уровень отказоустойчивости и соответствие современным требованиям.

По этой причине многие провайдеры предпочитают аренду ЦОД, а не строительство своего. Это позволяет снизить капитальные затраты, избежать рисков, связанных с управлением инженерной инфраструктурой, и сосредоточиться на главной задаче — развитии и предоставлении облачных услуг. До собственного дата‑центра нужно «дозреть». Cloud4Y — уже 15 лет предлагает облачные сервисы, поэтому вопрос строительства собственного ЦОД назревал. И вот — свершилось.

Местоположение

DC4Y.1-Марфино — современный технологический объект, расположенный в Московской области, село Марфино. После строительства ему присвоят официальное название — TerraBit

ЦОД располагается на участке площадью более 8,2 га в 22 км от МКАД, в непосредственной близости от транспортных узлов. Этот участок долгое время эксплуатировался, но уже несколько десятков лет как заброшен.

Поэтому место тихое и красивое, но здесь хватает старого хлама, который нужно выкапывать, выкорчёвывать и вывозить. Хорошо, что объект обеспечен удобными подъездными путями. А ещё предусмотрено место для складских зон для временного хранения оборудования клиентов, которые будут размещаться здесь в будущем.

Кстати, во время расчистки территории мы начали облагораживать маленький естественный прудик, который был на территории и который решили оставить. Он в ужасном состоянии, но благодаря источнику, бьющему из-под земли, сумел дожить до наших ней. Да, из-за пруда мы немного перекроим проект (сейчас как раз ведутся проектировочные работы), зато он будет ещё более красивым. В пруд ещё рыбу запустим, и совсем хорошо станет.

Новый дата-центр Cloud4Y в Подмосковье должен стать важным элементом региональной ИТ-инфраструктуры, способствуя развитию цифровой экономики региона. Близость к Москве и хорошая транспортная доступность обеспечат поддержку местных предприятий, малого и среднего бизнеса, а также госучреждений, которым необходимы производительные ресурсы для обработки данных. Создание ЦОД в Марфино также открывает новые рабочие места для технических специалистов, что способствует экономическому развитию региона.

Структура и мощности дата-центра

Проект реализуется и будет вводиться в эксплуатацию поэтапно

- Этап 1: 1200 стойкомест, до 10 МВт мощностей на площади 5,5 тыс. кв. м.

- Этап 2: 2400 стойкомест, до 20 МВт мощностей, 11 тыс. кв. м.

- Этап 3: 3600 стойкомест, до 30 МВт, 16,5 тыс. кв. м.

- Этап 4: 4800 стойкомест, до 40 МВт на 22 тыс. кв. м.

Все системы объекта имеют резервирование от уровня N+1 до 2N, что обеспечивает надёжность и отказоустойчивость. Дата-центр разработан с учётом международных требований и нацелен на сертификацию уровня TIER III и TIER IV от Uptime Institute.

Энергоснабжение и системы охлаждения

Объект запитывается от городских электросетей, а также имеет резервные ИБП и дизель-генераторы, что позволяет работать автономно. Топливохранилище на территории обеспечит длительную бесперебойную работу при необходимости. Системы холодоснабжения разработаны с использованием «зелёных» технологий, что позволяет минимизировать воздействие на окружающую среду и повысить энергоэффективность.

Противопожарные и охранные системы

ЦОД оборудован современными системами противопожарной защиты:

- Использование негорючих материалов и изоляция пожароопасных зон.

- Системы раннего оповещения и пожарной сигнализации.

- Газовое пожаротушение, обеспечивающее надёжную защиту оборудования.

Предусмотрена круглосуточная служба безопасности территории и объекта с несколькими периметрами контроля и охраны. Также у нас в проекте заложено создание антидроновой защиты (в частности, укреплённые стены и противодроновые сетки) систем ЦОД. Важный пункт, особенно в наше неспокойное время.

Услуги и возможности для клиентов

Основные услуги, которые будут реализованы на базе ЦОД:

- Традиционные облачные ИТ-услуги (облачные серверы и сервисы)

- Размещение ИТ-оборудования клиента в надёжной инженерной инфраструктуре.

- Услуги связи.

- Предоставление ИТ-оборудования в аренду.

- Услуги по сопровождению ИТ-инфраструктуры заказчика.

50+ IaaS & SaaS решений, среди которых:

- Облачные сервера в отказоустойчивом исполнении с работой в нескольких ЦОД

- Решение «Облако ФЗ-152», аттестованное по 17 и 21 приказам ФСТЭК по классам УЗ-1, К-1

- Решения аварийного восстановления, резервного копирования

- Решения облачного хранения (Объектное хранилище S3, файлообменник NextCloud)

- Решения SaaS (удалённые рабочие столы, корпоративная почта в облаке, 1С в облаке, решения облачного видеонаблюдения и др.)

- Решения безопасности (VPN, WAF, NGFW, защита от DDoS, DLP – решение, AntiSpam, AntiVirus и др.)

Сервисы предоставляются по модели подписки с оплатой по факту потребления (pay-as-you-go).

Ещё одно направление — это размещение ИТ-оборудования на стандартных стойкоместах в машзалах ЦОД. Условия:

- Место для установки серверной стойки 19”, высота 48 юнитов, габариты 600х1070

- Гарантированная электрическая мощность от 5 до 20кВт

- Два независимых электрических ввода (линии к стойке, внутризальные шкафы, ИБП, ДГУ, ТП).

- Бесперебойное электроснабжение в машзале, поддержание климата с температурой 18-27град, влажностью 30-60%.

- Ограничение несанкционированного доступа и физическая безопасность.

- Возможность установки 2/4 блоков распределителя питания PDU.

- Возможность установки АВР.

- Выделенный сервис-менеджер.

- Базовый уровень технической поддержки 24/7.

- Доступ 24/7 и неограниченное количество посещений.

- Временное рабочее место для подготовки к установке и настройке ИТ-оборудования.

- Временное предоставление консольного оборудования.

- Круглосуточный ввоз-вывоз оборудования.

Дополнительные услуги:

- Аренда стойки (в том числе с нестандартными габаритами), установка системы управления доступом (СКУД) и видеонаблюдения (ОВН).

- Услуги удалённого мониторинга и управления.

- Аренда и монтаж ИТ-оборудования, замена замков под индивидуальные ключи, а также установка системы холодного коридора.

- Установка защитного ограждения вокруг стоек клиента.

- Аренда ДатаРум или места хранения оборудования и ЗИП.

Сервисные услуги:

- Поддержка клиентов в режиме 24/7.

- Услуги SmartHands для помощи в базовых операциях.

- Монтаж оборудования клиента в стойку.

- Сборка и тестирование серверного оборудования.

- Мониторинг, резервное копирование, инвентаризация и техническое обслуживание оборудования.

Сетевая связность и телекоммуникации

Для обеспечения высокой пропускной способности DC4Y.1-Марфино проектирует независимые волоконно-оптические линии (ВОЛС) до МКАД. Синхронизация с планами региональных и федеральных операторов связи позволит дата-центру поддерживать стабильные и высокоскоростные соединения в северном направлении Московской области.

Что сейчас уже сделано

Прямо сейчас, как мы уже сказали, идёт расчистка территории и демонтаж старых построек. Поэтому выглядит всё несколько грязновато:

Проект находится на начальном этапе. Мы уже успели поставить забор, аккуратный КПП с переговорками, а также пробили несколько скважин глубиной 125 м для будущего водоснабжения дата-центра.

Когда закончим с расчисткой, начнём заниматься коммуникациями, фундаментом и другими задачами.

На данный момент на участке почти завершены работы по сносу старых построек и выравниванию земли. Это важный шаг, который определит успех всего проекта, ведь именно от качества подготовки территории зависит долговечность и надёжность будущего сооружения.

Но снос — это не просто разрушение. Многие кажущиеся небольшими постройки оказались буквально «зарыты в землю»: у них были большие подвалы и сложные фундаменты. Вот как это выглядит:

Ломать, крушить и рвать на части

Ломать, крушить и рвать на части

Это не строчка из песни, а краткое описание того, что происходит на нашей стройплощадке. После экспертизы и многочисленных обсуждений внутри Cloud4Y и с экспертами решили, что снесём почти все здания, которые есть на участке.

На это есть две главные причины.

Первая причина: здания, которые мы решили сносить, находились в разном техническом состоянии. Некоторые выглядели так:

А другие — так:

Вторая причина: невозможность как‑либо приспособить их под наши нужды. Старые постройки не соответствовали никаким нормам, предъявляемым к современным дата‑центрам.

Одновременно со сносом организована переработка строительного мусора. После сноса здания образовавшиеся материалы (бетон, кирпич, крупные булыжники) перемалываются в камнедробилке, образуя курганы мелкой щебёнки.

Зачем это делать вообще?

Тут несколько причин.

- Экономия ресурсов. Переработка строительных отходов позволяет повторно использовать материалы, что снижает затраты на их утилизацию и покупку новых.

- Создание устойчивого основания. Перемолотые в крошево здания используются для отсыпки территории. Они уплотняют грунт, улучшают дренаж и создают прочное основание для будущих построек.

- Экологическая польза. Такая переработка сокращает количество отходов, которые попадают на свалки, и уменьшает нагрузку на окружающую среду.

- Снижение затрат на логистику. Переработка и переиспользование материалов на месте строительства уменьшает необходимость в транспортировке новых материалов, что выгодно в плане бюджета и позволяет уменьшить сроки строительства.

Отсыпка дроблёным материалом помогает создать пористую структуру, способствующую хорошему дренажу, предотвращает возможные проблемы с усадкой грунта. Повышается устойчивость, обеспечивается равномерное распределение нагрузки на грунт, соблюдаются другие требования, предъявляемые к такого рода сооружениям.

Подготовка территории включает не только расчистку участка от растительности и мусора с последующим уплотнением грунта для повышения его несущей способности, но и прокладку дренажной системы, чтобы избежать затопления во время дождей или паводков. А ещё подведение инженерных коммуникаций, включая электричество, водоснабжение и интернет.

С дренажом и коммуникациями работа ещё только начинается, поэтому сейчас показывать фактически нечего. Вот ещё пара кадров с места событий:

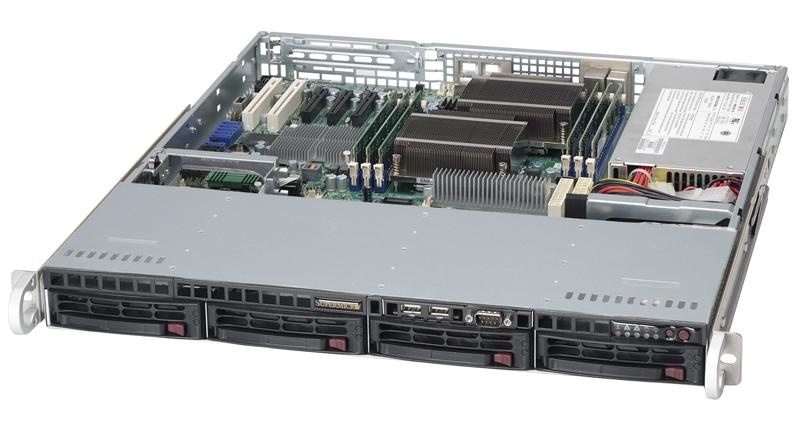

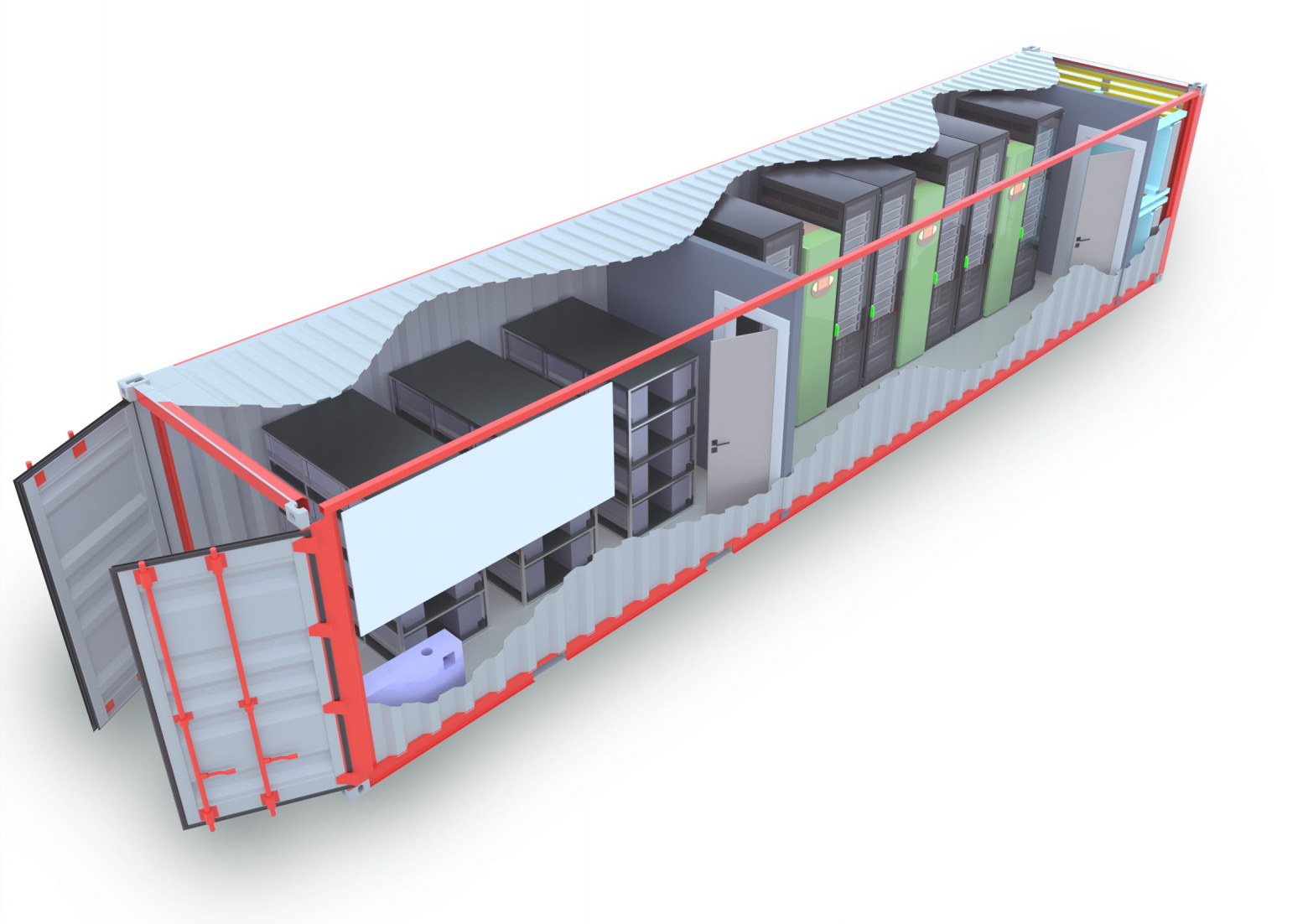

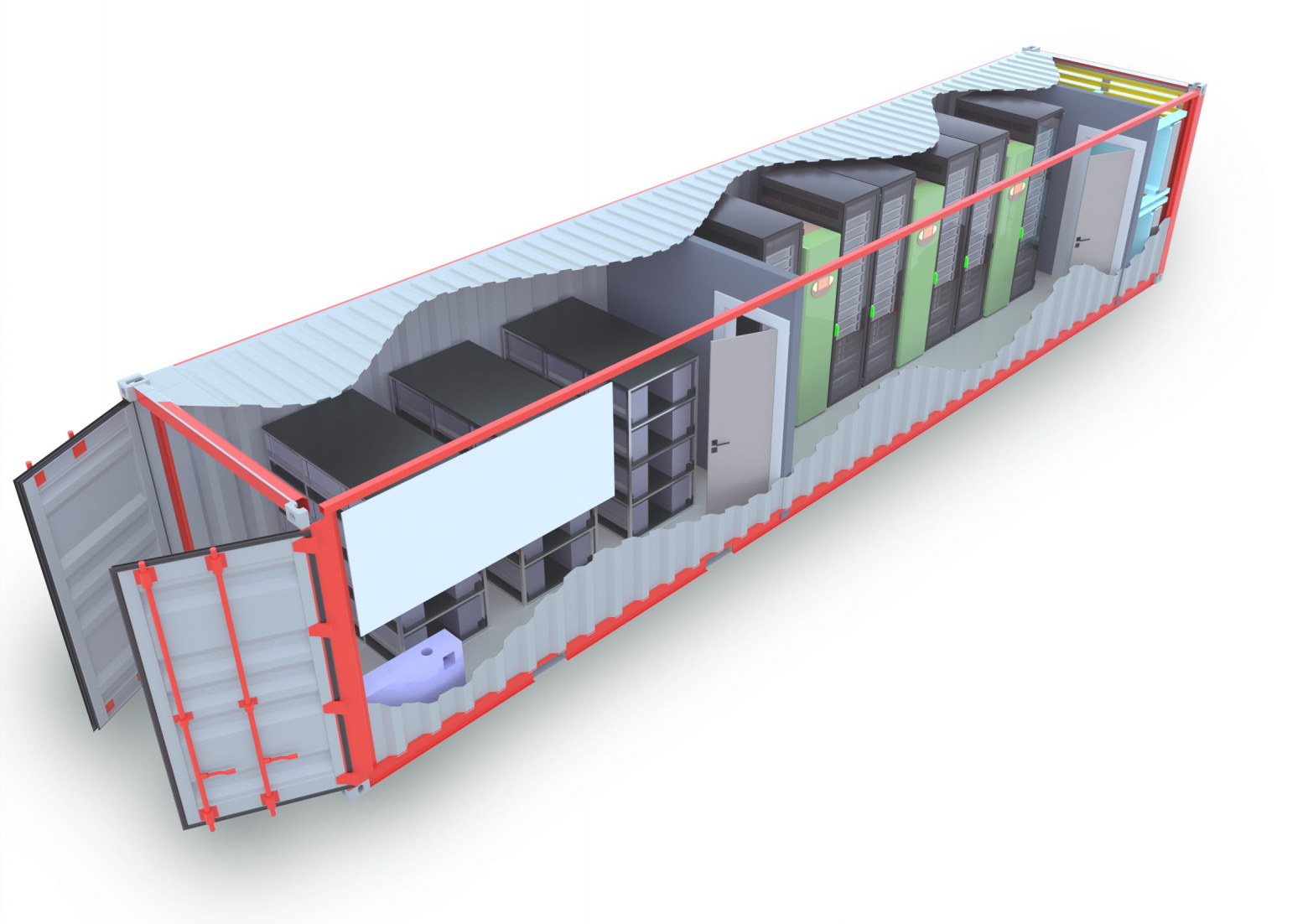

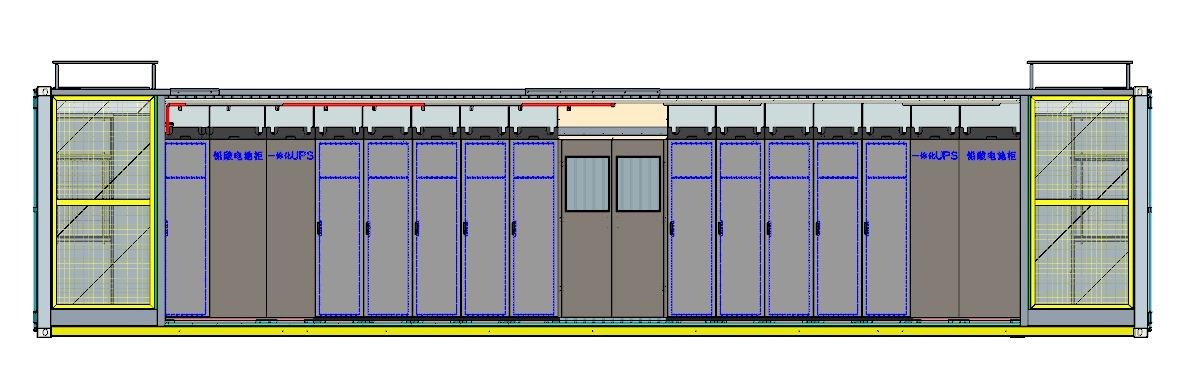

Помимо строительных работ, мы продолжаем заниматься покупкой начального комплекта оборудования, чтобы уже в этом году запустить первые стойки с серверами. Они будут размещены к модульных контейнерах вроде такого:

Позднее, когда закончим постройку зданий и укомплектуем его, основная часть оборудования будет расположена именно в защищённом здании. Хотя контейнеры на 10 стойкомест, скорее всего, останутся. Впрочем, подробнее о контейнерах мы расскажем в следующий раз.

Также уже сейчас мы настраиваем системы видеонаблюдения, которые будут обеспечивать контроль территории.

Строительство ведётся в соответствии с графиком, и уже в ближайшие месяцы начнётся монтаж ключевых систем. Открытие объекта планируется в следующем году. Вот только знаете, что? Мы вошли во вкус и купили в Мытищах участок под второй дата-центр на пару гектар. На первом объекте будем набивать шишки, а со вторым всё должно получиться попроще. Ну, мы на это рассчитываем.

Ранее мы подняли тему КЦОД — контейнерных дата-центров, которые первыми у нас примут рабочую нагрузку. У вас возникли вопросы, поэтому сегодня расскажем, что это такое, как выглядит и почему мы используем КЦОД вместе с традиционным зданием дата-центра.

Что такое контейнерный дата-центр?

Контейнерный дата-центр — это автономный модуль, размещённый в специализированном металлическом контейнере, подготовленном к эксплуатации оборудования в конкретных климатических условиях и оснащённом всем необходимым оборудованием для хранения, обработки и передачи данных. В контейнерном дата-центре размещаются стойки с ИТ-оборудованием, системы охлаждения, источники бесперебойного питания (ИБП), системы безопасности и мониторинга. КЦОД можно легко перевозить по обычным дорогам и можно поставить практически в любом месте. Там, где есть источник электроснабжения и связь. Поэтому контейнерные дата-центры считаются хорошей альтернативой традиционным ЦОД.

Контейнерные ЦОДы используются в разных ситуациях. Чаще всего это:

- Удалённые регионы. Внедрение вычислительных мощностей на объектах, где капитальное строительство невозможно или невыгодно.

- Временные проекты. Использование на крупных мероприятиях (выставки, спортивные события).

- Резервные мощности. Обеспечение бесперебойной работы при пиковых нагрузках.

- Экстремальные условия. Поддержка критически важной инфраструктуры в суровых климатических зонах.

- Промышленные предприятия. Развёртывание вычислительных мощностей на удалённых производственных площадках.

- Размещение ИТ-инфраструктуры незначительного масштаба и отсутствие потребностей в дальнейшем росте.

- Оперативная реализация проекта при отсутствии времени на проведение работ по проектированию, согласованию, строительству/реконструкции и вводу в эксплуатацию объекта капитального строительства.

В России контейнерные дата‑центры набирают популярность благодаря своей универсальности и возможности использования в сложных климатических условиях. Например, они активно используются в нефтегазовой отрасли, например, на месторождениях в Сибири и на Крайнем Севере, где традиционные ЦОД построить сложно и дорого. Также такие решения востребованы в телекоммуникационной отрасли, особенно в регионах с низкой плотностью населения, где порой бывает очень нужно быстро развернуть инфраструктуру с хорошей производительностью.

Ставить контейнерные дата-центры можно на любой фундамент – сваи, плита или лента. Если ваш бизнес зависит от IT, но строить огромный ЦОД нет времени или бюджета – контейнерные дата-центры Cloud4Y решат проблему без лишних нервов.

Особенности контейнерных дата-центров Cloud4Y

Когда мы впервые задумались над КЦОД, то сначала посмотрели, что есть на рынке. Оказалось, что поставщиков совсем немного. А компаний, которые готовы серьёзно дорабатывать готовые модели под требования заказчика — и того меньше.

Так возникла новая задача: найти производителя, который обладает необходимым опытом, может изготовить контейнер с учётом наших запросов, а также готов будет вносить изменения в конструкцию в будущем. И это не просто добавление утеплителя, например. А перестройка внутреннего пространства для большей автономности или изменение расположения оборудования в контейнере.

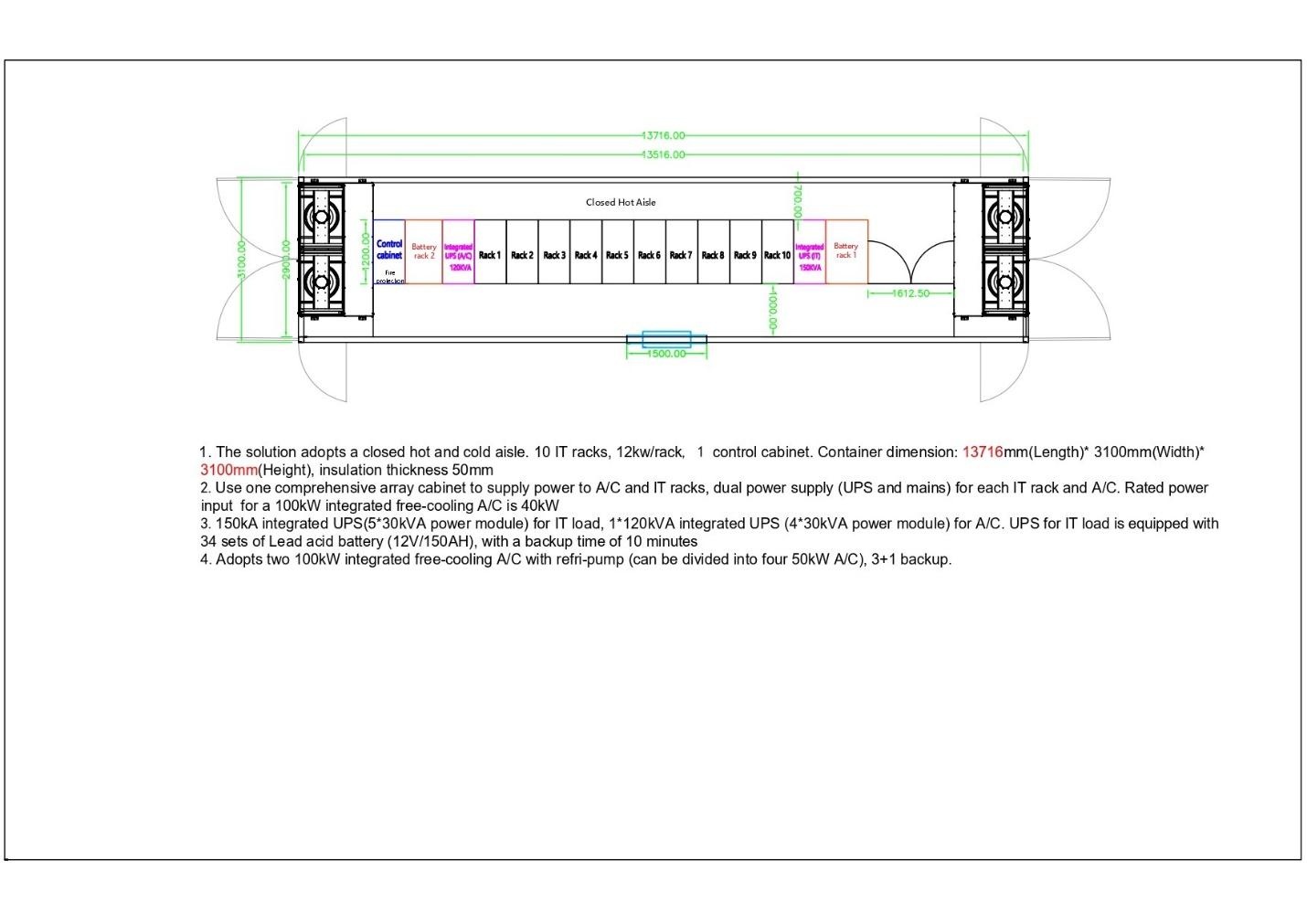

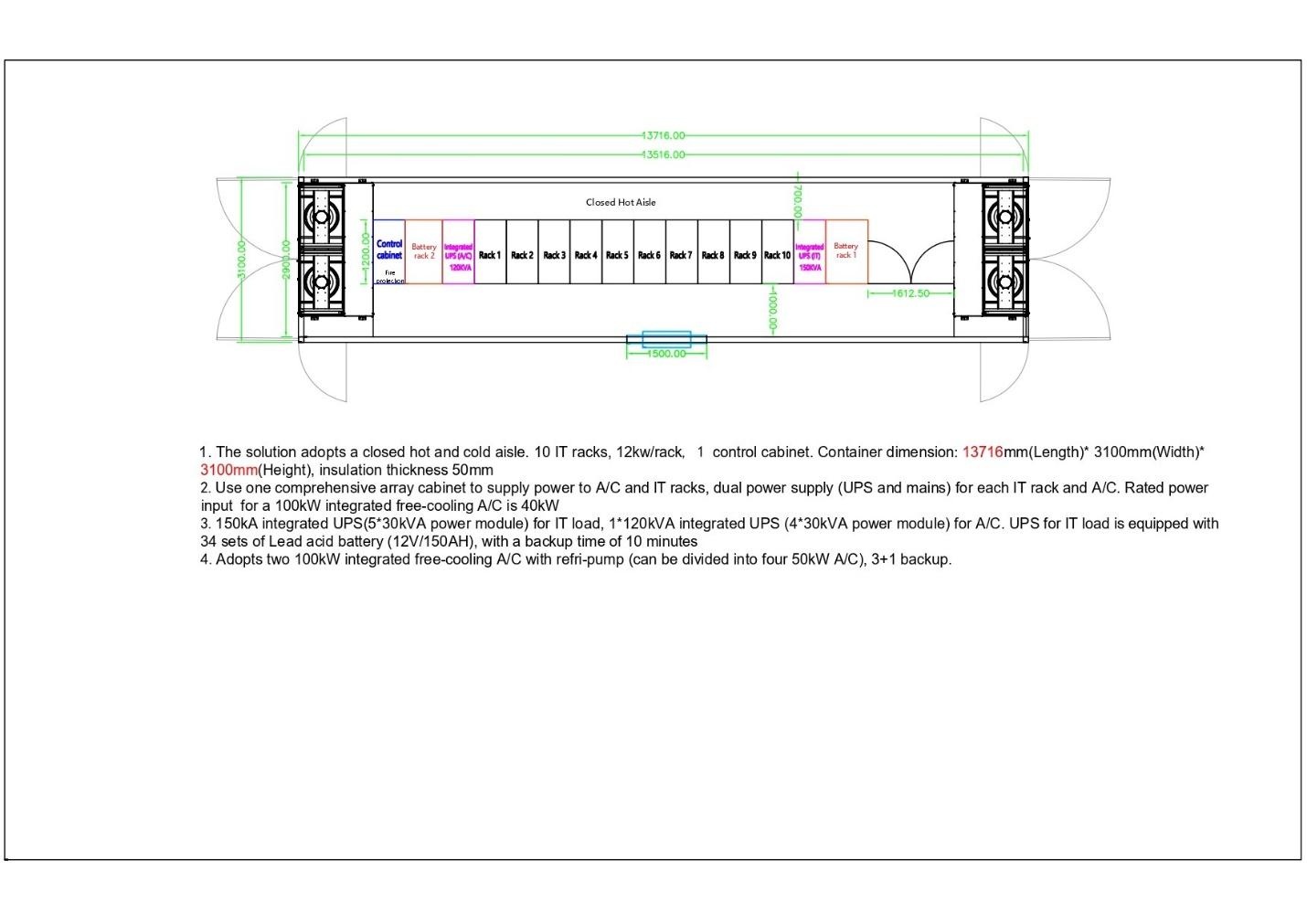

Поиски были долгими, но мы справились. И заказали первые контейнеры для установки на территории наших строящихся дата-центров. Немного — чтобы обкатать их, а потом, если потребуется, доработать. Вот схема такого контейнера.

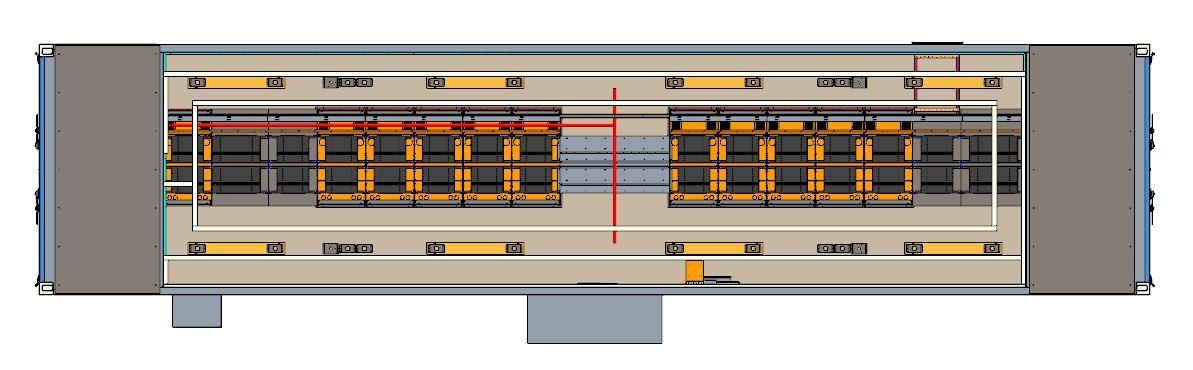

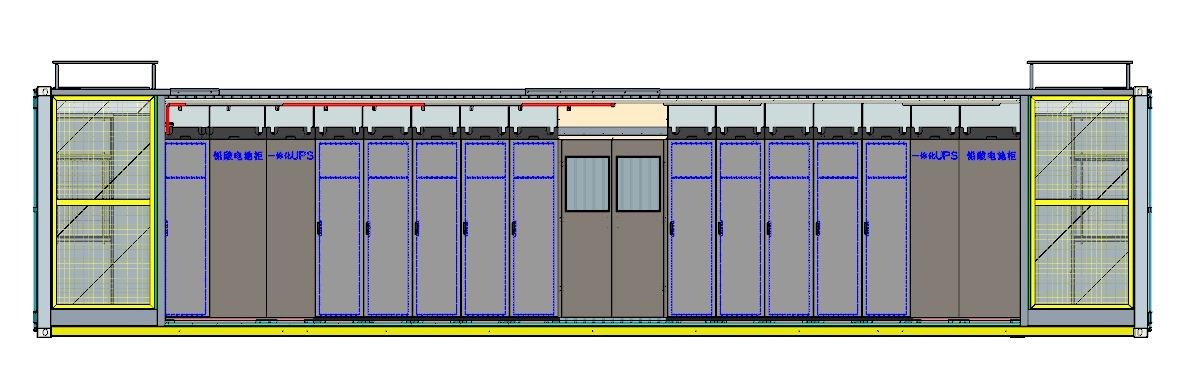

Решение предусматривает использование закрытых горячих и холодных коридоров. 10 серверных стоек, 12 кВт/стойка, 1 управляющий шкаф, ИБП для серверных стоек и для систем охлаждения, эффективное охлаждение в конфигурации N+1, переход на резервное электроснабжение от ДГУ (дизель‑генераторной установки), системы контроля климатических параметров, безопасности и пожаротушения.

Чему мы уделили особое внимание?

- Эффективное и надёжное охлаждение. Используются установки косвенного фрикулинга с дополнительным фреоновым контуром доохлаждения. 4 системы охлаждения с резервированием N+1 (расположены по торцам контейнера). При умеренной температуре воздух в замкнутом контуре (без забора воздуха с улицы) охлаждается через теплообменник, что существенно экономичнее традиционных методов охлаждения. Внутри контейнера спереди и сзади от стоек организованы горячий и холодный коридоры. Холодный воздух забирается IT‑оборудованием, горячий выводится в систему охлаждения.

- Утепление. Мы спроектировали контейнеры, способные работать при низких температурах нашего региона.

- Удобство, вместительность и энергоэффективность. В контейнере размещены 10 IT‑стоек высотой 47U и 4 служебные (расположены по краям). Заводская установка и подключение зарезервированных модулей распределения питания стоек (PDU). Готовые трассы лотков для укладке кабелей связи. Ко всему оборудованию есть удобный доступ.

- Безопасность. В служебных стойках размещены системы мониторинга (температура, влажность, задымление, доступ). Есть СКУД.

Преимущества контейнерных дата-центров

Как показывает практика, КЦОД популярны по той причине, что они компакты, быстро вводятся в эксплуатацию и могут быть доработаны под нужды компании. Это надёжное практичное решение даже для крупных провайдеров.

Попробуем объяснить, что делает контейнерные дата-центры такими востребованными в России.

- Быстрота внедрения. Полная заводская готовность позволяет быстро запустить систему в эксплуатацию при наличии внешних источников питания и связи.

- Мобильность. Простая транспортировка и установка на объектах без сложных подготовительных работ.

- Экономичность. Снижение затрат за счёт использования стандартных контейнеров — не нужно ничего изобретать и строить с нуля.

- Энергоэффективность. Прецизионные системы охлаждения уменьшают энергопотребление, что снижает эксплуатационные расходы. Косвенный фрикулинг обеспечивает нужный уровень охлаждения при меньших затратах.

- Гибкость применения. Адаптация к экстремальным температурам от –35 °C до +45 °C.

- Автономность. Полное резервирование инженерных систем обеспечивает работу без привязки к внешним источникам.

Характеристики контейнерных ЦОД Cloud4Y

- Соответствие требованиям TIER III.

- Всепогодный утеплённый контейнер, антистатический пол, заземление.

- Резерв электроснабжения от ДГУ.

- Зарезервированные линии связи.

- Круглосуточный доступ. Служба охраны.

- Размещение оборудование в 10 стойках 47U каждая до 12кВт.

- Бесперебойное электроснабжение оборудования в ИТ‑стойках (модульный ИБП в конфигурации N+1).

- Выделенный ИБП для механической нагрузки в конфигурации N+1.

- Герметичные холодный и горячие коридоры.

- Системы контроля и безопасности (СКУД, видеонаблюдение, датчики температуры, влажности, задымления, газового пожаротушения и др.).

Каждая IT‑стойка и кондиционер имеют дублированные линии бесперебойного электроснабжения о ИБП с внешним подключением как от внешней электросети, так и от ДГУ.

Система охлаждения:

- Установлены четыре интегрированных кондиционера свободного охлаждения общей мощностью 200 кВт, оснащённых насосами для хладагента.

- Косвенный фрикулинг.

- Система резервирования: 3+1 (три рабочих и один резервный)

Возможность масштабирования. Масштабируемся в рамках стоек существующего контейнера или путём разнесения ИТ-оборудования по нескольким отдельно стоящим контейнерам, что увеличивает отказоустойчивость работы информационных систем.

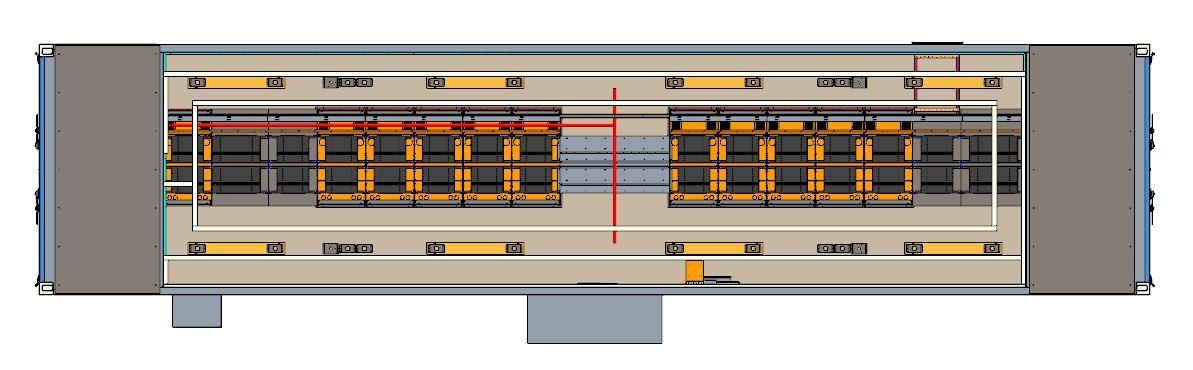

Вот ещё немного иллюстраций, как будут выглядеть контейнерные дата-центры Cloud4Y.

Первые контейнеры появятся на нашей площадке в Марфино уже летом 2025

Первые контейнеры появятся на нашей площадке в Марфино уже летом 2025. Они будут укомплектованы и готовы к эксплуатации. Таким образом, мы запустим наш собственный дата‑центр ещё до того, как достроим капитальное здание. Предполагаем, что на этой площадке клиентам будет предоставляться инфраструктура в двух вариантах: основном здании или контейнерах. Также можно будет комбинировать эти две возможности.

Сейчас мы работаем сразу в двух направлениях

- Первое — это предоставление в аренду мощностей, размещённых в наших КЦОД. Ну, или аренда контейнеров целиком.

- Второе — поставка подготовленных под заказчика контейнеров.

Мытищи: подготовка к масштабному запуску

На площадке в Мытищах запланировано подключение 40 МВт электроэнергии, и процесс энергоподключения уже запущен. Эксперты провели обследование существующих построек: административное здание находится в хорошем состоянии, а вот сооружение, предназначенное под дата‑центр, требует капитального ремонта. Будем заниматься проектированием и решать, как лучше поступить — снести частично/полностью, или реконструировать.

Параллельно завершены работы по расчистке территории — строительный мусор убран, площадка выровнена. Процесс небыстрый из‑за большой запущенности территории.

Марфино: юридические и технические работы в активной фазе

В Марфино Cloud4Y решает юридические вопросы, связанные с организацией контрольно‑пропускного пункта (КПП). Одновременно с этим:

- Заложен фундамент под контейнерный ЦОД, который ожидается на площадке до конца июня.

- Идёт процесс подключения электроснабжения мощностью 150 кВт.

- Заключён договор на оптоволоконное подключение — готовность ожидается в июле.

- Для обеспечения бесперебойного энергоснабжения установлен временный ангар под газовый генератор, который будет обслуживать первый КЦОД.

Привезли первый контейнерный ЦОД в Марфино

Привезли первый контейнерный ЦОД в Марфино

Первый контейнерный дата-центр в Марфино уже доставлен на площадку. Транспортировка была непростой: часть пути контейнер преодолел по воде — сначала его везли морем до Риги, а затем перегрузили на автомобильный транспорт. Подрядчик, имеющий опыт таких перевозок, организовал всю логистику, включая доставку прямо на участок с помощью крана.

Площадка под размещение была подготовлена заранее: залит фундамент, расширена зона для маневров спецтехники. Хотя территория пока не заасфальтирована, тяжёлая техника смогла заехать без проблем.

Ещё мы привезли газопоршневую станцию. Сделали под неё фундамент, установили. Фундамент тут — обязательное требование поставщика. У них есть свои нормы, чтобы контейнер стоял на ровной горизонтальной поверхности, на твёрдом основании. Чтобы под станцией ничего не расплывалось, не уходило в сторону. Например, во время слива конденсата или других стоков, чтобы они, размягчая грунт, не увели нашу станцию в сторону куда-нибудь.

Подключение электричества и инфраструктура

Сейчас ключевая задача — подключение 150 кВт мощности, необходимой для запуска первого контейнерного дата-центра Cloud4Y. Договор с энергетиками уже подписан, идут работы по замене трансформатора и согласованию подвода кабеля. Параллельно решаются вопросы с парковкой для спецтехники и подземными коммуникациями.

Мощность в 150 кВт выбрана не случайно: это оптимальный вариант для текущей конфигурации контейнера с учётом пиковых нагрузок и дополнительного оборудования (охлаждения, сигнализации, освещения). Сейчас всё заводится с расчётом на первый контейнер. В будущем для второго и следующих контейнеров потребуется ещё столько же. Так что согласования по энергоснабжению отнюдь не закончены.

Резервное питание и коммуникации

Чтобы обеспечить бесперебойную работу, предусмотрены резервные источники питания: ИБП (на 10–30 минут автономной работы) и дизельные генераторы, которые включатся в случае длительного отключения электричества.

Также ведётся строительство напорной канализации — из-за протяжённости трассы стоки будут откачиваться насосами. Канализация будет собирать со всех наших, скажем так, ангаров ЦОД, которые будут расположены на территории в Марфино. Параллельно завершается монтаж металлоконструкций навеса над КПП, благоустраивается территория и прорабатывается проект водоснабжения.

Облагораживаем Мытищи

В Мытищах работы пока на стартовой стадии: оформлена аренда земли, проведена экспертиза здания, где разместится ЦОД. Сейчас проектировщики изучают существующие коммуникации и разрабатывают схему въезда на участок.

Главная задача — обеспечить мощное энергоснабжение: ведутся переговоры о подключении 40 МВт и правильной логистике. Это долгий процесс, но подходить к нему нужно комплексно, сразу закладывая инфраструктуру под будущее расширение.

Цель — надёжность и доверие клиентов

Мы стремимся к тому, чтобы клиенты получали стабильный доступ к облачным сервисам без перебоев. Успешный запуск первых собственных дата-центров укрепит наши позиции на рынке, привлечёт новых заказчиков. А мы сможем предлагать больше услуг по более доступным ценам.

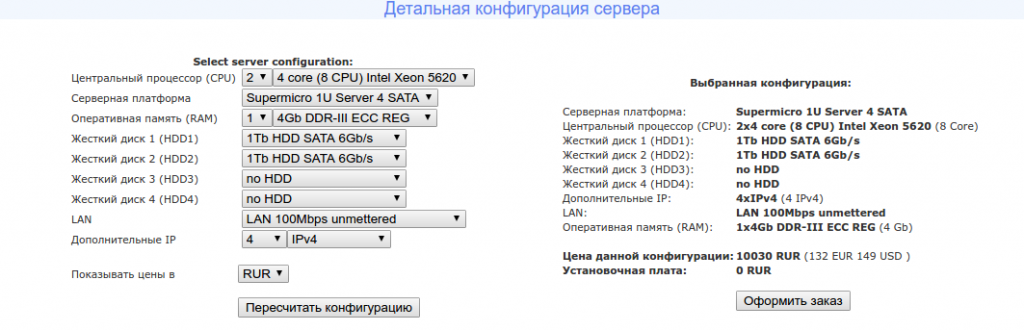

Поэтому Cloud4Y расширяет и сетевую инфраструктуру. В условиях дефицита IPv4-адресов мы успешно приобрели новый пул из 4500 IP. Покупка позволяет нам отреагировать на растущие потребности клиентов и увеличить гибкость предоставляемых услуг. Теперь существующие и новые клиенты могут получить выделенные IP-адреса для решения широкого круга задач: от размещения серверов до реализации сложных интеграционных проектов. Новые адреса уже добавлены в сеть провайдера и доступны для заказа.

Марфино: электричество — дело тонкое (и мощное!)

Марфино: электричество — дело тонкое (и мощное!)

Главное в Марфино за июль — электричество, ведь без него не раскрыть потенциал нашего первого контейнерного ЦОДа. И тут мы здорово продвинулись.

Энергетики взялись за прокладку кабельной линии (КЛ-0,4кВ) от трансформаторной подстанции. Это та самая 150 кВт — оптимальный выбор для запуска первого контейнера. Параллельно занимаемся дополнительными подключениями.

Почему 150 кВт — это правильное решение? Всё просто: мы закладываем мощность с запасом и под высокие нагрузки. Наш контейнерный ЦОД спроектирован так, что одна стойка может «съедать» до 15 кВт. Это в 2-3 раза выше, чем в обычных дата-центрах (где держатся в рамках 5-6 кВт). Зачем? Чтобы вы могли ставить самое мощное «железо» для AI, расчётов или анализа огромных данных — без оглядки на лимиты. Эти честные 150 кВт — не просто цифра, это гарантия, что внутри контейнера будет работать всё: и серверы на полную, и системы охлаждения, и безопасность. И это только на первый контейнер — для следующих будем тянуть ещё.

И другая важная новость: согласовали подключение по оптическому волокну для системы видеонаблюдения территории. Скорость в 1 Гбит/с позволит без задержек получать изображение максимального качества.

КПП: почему он важен

КПП: почему он важен

Параллельно с электрикой активно строим контрольно-пропускной пункт (КПП). Это не просто формальность — в мире дата-центров КПП создаёт первый рубеж защиты. Его роль — предотвращать несанкционированное проникновение на территорию и строго соблюдать регламент доступа (проверка пропусков, досмотр). КПП будет оснащён навесом — для защиты персонала и критически важного оборудования поста (камеры, системы контроля и т. д.) от непогоды.

Что сделано: на площадку привезли и разгрузили изготовленные металлоконструкции (мы за всем процессом следили). Нашли надёжного подрядчика, оформили договор. Установили 4 мощные колонны-опоры. На них будем монтировать конструкции навеса, которые уже начали собирать.

Мытищи: готовим платформу для гиганта

Мытищи: готовим платформу для гиганта

В Мытищах пока тише, но не менее важно. Продолжаем кропотливую подготовку. Активно прорабатываем вопрос удобного съезда на наш земельный участок.

В энергетике тоже есть прогресс: занимаемся расключением вводного щита 0,4 кВ (15 кВт) — скоро подача тестового напряжения. Это важный шаг к большим мощностям для нашего контейнерного дата-центра.

И, конечно, не забываем про инфраструктуру: собрали пакет документов и запросили технические условия на всё необходимое — пожарное водоснабжение, холодное и горячее водоснабжение, канализация и теплоснабжение. Без этого — никуда.

В фокусе — ваше спокойствие

Каждый элемент и каждое действие на стройплощадке — это шаг к нашей главной цели: дать вам максимально надёжный и безопасный доступ к облачным сервисам. Собственные дата-центры — это фундамент для стабильности, роста и новых возможностей по отличным ценам.

www.cloud4y.ru/cloud-hosting/container-data-center-rental/