С точки зрения законодателей вам пора бы уже ходить в Интернет по паспорту. И первые шаги для этого сделали.

Из-за этого мы сейчас переживаем крупнейший передел рынка хостинга в России.

С 1 декабря новый федеральный закон запрещает заниматься хостингом тем, кто не в специальном реестре. В специальный реестр можно попасть, грубо говоря, если выполнить требования по хранению трафика клиентов и их авторизации по паспорту, «Госуслугам» или платёжной карте. Там куча нюансов, но примерно так.

Ещё в этом году в ЦОДы начало поступать полностью отечественное железо из отечественной компонентной базы и отечественных плат (на самом деле — нет), отвалилась страховка от киберрисков от AIG (вместе с AIG), и пришлось искать российский аналог. Были скандал и мир с Казахстаном при открытии двух новых площадок, мы взяли премию «Хостер года», запустили собственный бесплатный DNS (аналог Route53), перешли на OpenAPI в хостинге, открыли ещё две площадки: ЦОДы во Владивостоке и в Турции в Измире (это там, где было наводнение), запустили и сломали спутник (дважды), пережили крупную аварию и после неё ввели понятное SLA на доступность с денежной гарантией.

В общем, сложный был год. Налоги, катастрофы, проституция, бандитизм и недобор в армию. С последним мириться было нельзя… Простите, рассказываю по существу.

Юридический катаклизм и деанонимизация Рунета

В этом году началось регулирование хостингов в России.

Вообще-то и так с 2016 года для предоставления хостинг-услуг требуется получение лицензии у Федеральной службы по надзору в сфере связи, информационных технологий и массовых коммуникаций (Роскомнадзора).

Но по факту до 1 декабря 2023 года любой школьник мог арендовать сервер, назвать его «Мегахостинг2000» и заняться услугами хостинга. То есть для ведения деятельности хостинга в реальности не надо было получать никакой лицензии.

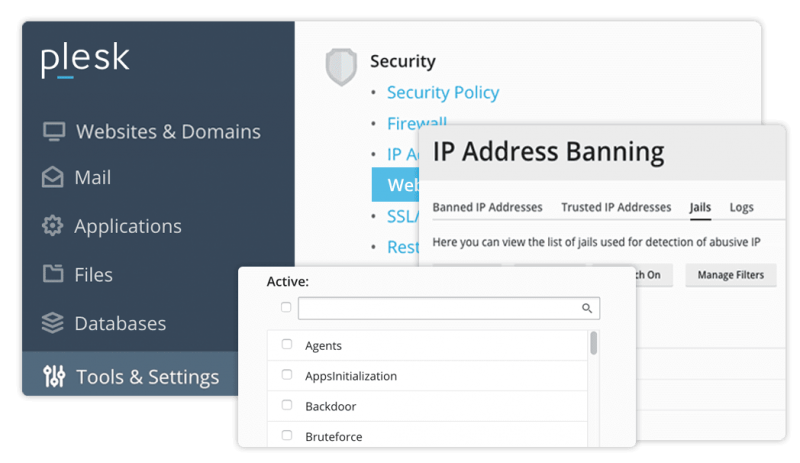

Теперь это регулируется ФЗ №14512 от 28.07.2023, и чтобы быть хостингом, нужно быть в реестре. Если вы не там и предоставляете услуги хостинга — вы нарушаете закон, но пока ответственность за это не установлена. Точнее, даже так: непонятна, потому что нет правоприменительной практики. Но будьте уверены: эцилопы будут приходить по ночам, чтобы бить вас в той или иной форме. Ответственность появится!

То есть, по сути, теперь лицензия на деятельность хостинга — нахождение в специальном реестре.

Это можно сделать только в том случае, если вы выполните ряд требований контролирующих органов. Там куча всего, но главное — подключиться к СОРМу (это и так требуется сейчас для операторов трафика, то есть для хостингов в том числе), а значит, все крупные хостинги и так либо уже имели подключение, либо были в процессе тестовой эксплуатации. Потому что, если нельзя доказать, что это сделали не вы, а ваш клиент, либо вы скрываете что-то, то легко стать соучастником.

Теперь это касается и мелких хостингов тоже.

Это требование понятное, и оно есть во всех западных практиках. В других странах ваш трафик сканируется практически сразу на стороне и провайдера, и облачных сервисов. В России очень долго была какая-никакая, но приватность. Теперь в этом направлении мы подтянулись к европейско-американскому опыту.

Соответственно, нужно хранить netflow трафика, чтобы представить её по запросу. Это аналог пакета Яровой, и всё равно эту копию так или иначе вы должны были иметь. Опять же крупные хостинги это делали и так, а маленькие были готовы рисковать штрафами на юрлицо с уставным капиталом 10 тысяч рублей.

Третья особенность — маркировка IP-адресов. Сразу говорю, что сейчас я буду объяснять не как юрист, а как обыватель, то есть неточно и поверхностно с точки зрения конкретных норм, но общее представление это даст.

Теперь каждый клиент хостинга должен иметь авторизованный IP. То есть ваш айпишник (точнее, вашего, например, VPN-сервера) должен быть однозначно связан с вашим паспортом.

Это можно сделать напрямую через контракт, через банковский ID с помощью карты (она связана с паспортом) или через авторизацию на «Госуслугах» (там ваш аккаунт тоже связан с паспортом).

Это передовой опыт Китая и ряда других стран.

Дальше будет маркировка на доверенные IP и не очень. Каждый элемент критичной инфраструктуры Рунета сможет определять, что делать с разными IP. Например, если у вас доверенный айпишник — вас можно пускать на сайты Почты России, «Госуслуг», РЖД и, утрируя, в комментарии к губернатору. Если нет — можно смело вас блекхолить. Уровни доверия могут быть на усмотрение объекта инфраструктуры, например, «смотреть можно, логиниться недоверенным нельзя» и так далее.

Эта классификация — самое сложное в законе: много суеты, надо менять маркировки. Мы, как и десятки других хостингов, вошли в рабочую группу Минцифры по законодательству. Могу сказать, что предложения от нас и других представителей индустрии точно были услышаны, и всё стало чуть более здравым. Однако всё равно всё это — очень крупное испытание. Одно слово в законе меняет всё. Была, например, некоторая вероятность, что прямо сейчас будет авторизация только по «Госуслугам», это, конечно, был бы обвал рынка! В итоге все хостеры вместе собрали нечто такое, что решает задачи государства, но при этом с этим очень даже можно работать. Я знаю, как сейчас буду выглядеть в ваших глазах, но мне даже понравилось взаимодействие с Минцифрой: там работают очень адекватные люди. А я знаю, о чём говорю, потому что это не первый и не второй мой опыт взаимодействия с госорганами.

На волне всех этих историй про закон особенно активизировались те, кто хотел бы скупить конкурентов. Я отлично видел, как были заказаны крупные пиар-кампании по «ужас-ужас, мы все умрём!» и как разгонялась паника на рынке. Мы сами в какой-то момент чуть было не решили, что пора завязывать и продавать бизнес, но потом трезво взглянули на вещи и разобрались, что происходит. Ничего принципиально нового в требованиях не было, но кто-то кого-то купил, и так получился самый серьёзный передел хостинг-рынка за всю его историю.

Кстати, процесс ещё не закончился: сейчас ждём вторую волну с применением санкций к тем, кто не осознал, что надо играть по новым правилам.

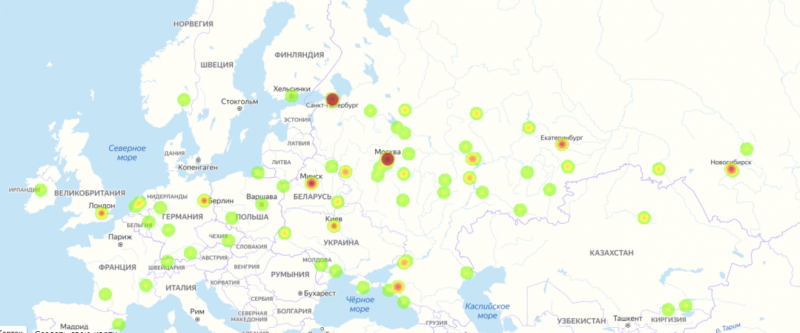

В мире история с лицензиями выглядит примерно вот так:

- США (в некоторых штатах).

- Китай — обязательная гослицензия.

- Германия — для предоставления хостинг-услуг требуется получение лицензии у Федерального агентства по сетевым технологиям (BNetzA).

- Франция — лицензия у Агентства по электронным коммуникациям и почтовым услугам (ARCEP).

- Япония — лицензия у Министерства внутренних дел и коммуникаций (MIC).

Аналогично — с ограничениями на внутренние доступы. Например, хорошо знакомая российским айтишникам Турция не пустит вас в критичную инфраструктуру без турецкого телефона.

Вот тут у меня

две статьи на «Форбс» про эту историю и ещё возможные варианты. Если коротко: важнее всего то, что иностранным хостингам будет очень сложно выполнять эту часть законодательства, то есть сейчас будет отток с иностранных площадок в нашу сторону. Это частично компенсирует те неудобства и затраты, на которые пришлось пойти из-за реализации закона. Наши расходы растут, но государство убивает наших иностранных конкурентов (в том числе законом про регистрацию на сайтах по российским почтам и телефонам). Кажется, что в целом это нормальная сделка.

ЦОДы

В этом году — плюс четыре площадки. Первые две вы, вероятно, знаете, если читаете нас: это Казахстан — Астана и Алма-Ата. Там журналисты замечательного издания «Коммерсантъ» и не менее замечательного «Форбс» вместо «встаём в сегмент партнёров в ЦОДы крупнейшего оператора» написали сразу «заключили партнёрство с крупнейшим оператором». К чему все вот эти мелочи и лишние слова, да? Топы «ТрансТелеКома» узнали об этом из газеты за завтраком, поперхнулись чаем и спросили, кто мы такие и не охренели ли мы в край. В общем, через некоторое время всё решилось. Детали — вот

тут в посте. Закончилось всё тем, что мы таким образом вышли на их руководство и встали на прямом контракте, то есть для всех сторон история завершилась максимально хорошо, насколько это было возможно.

Потом — Владивосток. Там просто хороший ЦОД. Владивосток выгодно отличается от других городов своей географией: вряд ли вы найдёте что-то ещё более далёкое и такое населённое.

Там прямо через сопку — Китай и Корея, поэтому для многих сервер там очень нужен. Если что, и пользователи всяких облачных сервисов, и игроки в «Контр-Страйк» часто гоняют трафик через Москву или вообще через Европу, потому что Россия — в EMEA, а маршрутизация часто идёт странным образом. Локальные серверы очень даже нужны!

Дата-центр расположен на территории градообразующего предприятия с высочайшим уровнем безопасности, собственной службой безопасности и новейшими технологиями предотвращения чп

Ну и самая свежая наша площадка — в Измире в Турции. Это как раз там, где в последнее время происходят всякие катаклизмы. Про сейсмоопасность Турции мы знали заранее, про затопления после сильных ливней и штормы — тоже, поэтому выбрали нормальную площадку на возвышенности.

Учитывая последующие события — очень мудро! ЦОД во всех этих историях не пострадал.

Дата-центр Netdirekt — единственный центр обработки данных, который подключается к большинству операторской инфраструктуры в Турции

Оплаты

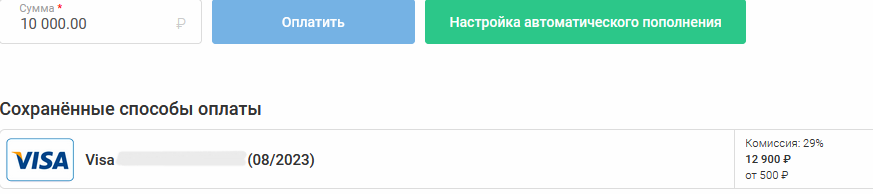

В начале года стало сложно с оплатами из-за рубежа. Для нас это очень болезненная история, потому что мы — за надёжную приватность, и если пользователь решил грохнуть сервер, то это значит, что он решил грохнуть сервер. В этом случае можно быть уверенными, что данные нигде не сохранятся. Это очень радовало большинство пользователей, но ровно до того момента, пока не возникла проблема с оплатой из стран СНГ в российское юрлицо. Карты МИР были не у всех. В общей сложности речь идёт примерно про 15 % платежей.

Мы пришли в хостинг из мира финансов, поэтому довольно быстро нашли шлюз. И заодно посоветовали новый маршрут платёжной системе, с которой работали. То есть заодно помогли ещё примерно десятку хостингов и нескольким процентам от общего числа отечественных проектов вообще, включая различную розницу. Эти же данные про практический способ наладить оплату мы расшарили всему рынку (то есть в том числе — прямым конкурентам), потому что было не время прятать такие вещи. Конкуренция конкуренцией, но выживать надо вместе.

Какое-то время это работало, пока не прилетел очередной сервис-пак с апдейтом для блока санкций. Ключевой банк прекратил работу из-за возможных вторичных санкций.

Пришлось искать другой путь, более сложный. И мы его нашли! Весь остаток года оплаты спокойно ходили. И речь шла не про мутки с промежуточным юрлицом с непонятными налогами, если что, а про вполне легальный путь. С договорами, чеками — всё как надо.

Ещё одна забавная вещь про оплаты — для российского рынка мы внедрили рассрочки через Яндекс.Сплит. Изначально я не понимал, кому они в принципе нужны, потому что при оплате за год мы даём скидку 30 %, а при покупке за год в рассрочку по Сплиту скидка получается 10 %.

Можно платить помесячно. Тем не менее есть те, кто покупает хостинг в рассрочку на год. Кто эти люди — я не знаю, но, раз им так удобнее, то почему бы и нет?

Железо

Железо можно где-то купить и привезти в Россию, но тогда это будет грозить поставщику вторичными санкциями. Либо купить сразу в России. Как я уже говорил раньше, мы были уверены, что крупнейшие банки и операторы связи будут закупаться и надо делать это вместе с ними. Так и получилось.

За границей мы берём «Икс-Фьюжн». Это вот в точности как «Хуавей», только совсем-совсем не «Хуавей». Никакой связи!

В России мы берём линейки крупных дистрибьюторов. Это либо самосбор из железа мутного происхождения (в смысле качественного, но возникшего на территории России как-то спонтанно), либо же очень хорошо знакомые нам линейки железа, но почему-то с лейблами с русскими буквами. Причём свежими, ещё клей не засох.

Собственно, задачей было найти гомогенное хорошее железо, мы провели десятки тестов и нашли. За последние два года мы обновили 27 % оборудования. Прирост парка оборудования — 48 % по отношению к осени 2021-го.

Страховка

Во всех юрисдикциях у нас есть страховка на случай киберрисков. Это когда из-за действий хостинга что-то пошло конкретно не так в реальном мире. Это часть нашего контракта, когда вы получаете дополнительный запас уверенности в том, что всё будет хорошо. Точнее, как раз если что-то пойдёт не так, то за хостингом есть ещё кто-то, кто не пропадёт и не продаст юрлицо в Грозный.

В России это тоже была AIG, но сами понимаете, что они ушли из России.

Мы обошли российские компании и столкнулись с тем, что никто не понимает, как считать киберриски. В итоге нашли одного страховщика, который сделал тот же пакет, но при этом был категорически против того, чтобы мы рассказывали детали, потому что они живут в России и слишком хорошо знают отечественный менталитет. Если мы объясним, что и кто страхует, то точно появится умный замотивированный хакер, который попробует доказать им их неправоту.

Поэтому не называем их в рекламе )

И сразу — про новую историю с оборотными штрафами за утечку персональных данных, которые могут появиться в достаточно обозримой перспективе. Страховка хостинга никак не защищает от таких штрафов, а только от ущерба от простоя, например, при перехвате контроля инфраструктурой в результате атак и парализации работы либо при глобальных авариях ДЦ, когда длительность перерыва уже смертельна для бизнеса.

Другие хостинги, как выяснилось, практически не страхуют таких рисков. Почему — я не знаю, но, возможно, дело — в практике смены юрлиц вместо разруливания последствий. Мы точно не хотим попасть на такие последствия, из которых не сможем выкарабкаться.

Если что — лежат все. Простой и падение статистически будут всегда. Можно погуглить название любого хостинга со словом «упал» и получить подборку случаев. Кто-то просто заметает эти истории под ковёр, а кто-то рассказывает. У нас, например, в этом году был крупный простой в Королёве, который затронул около 0,5 % всех наших клиентов.

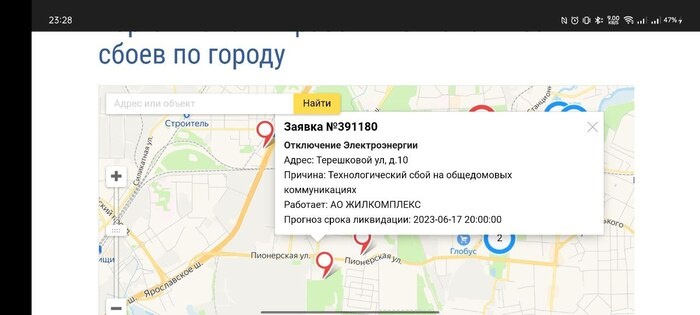

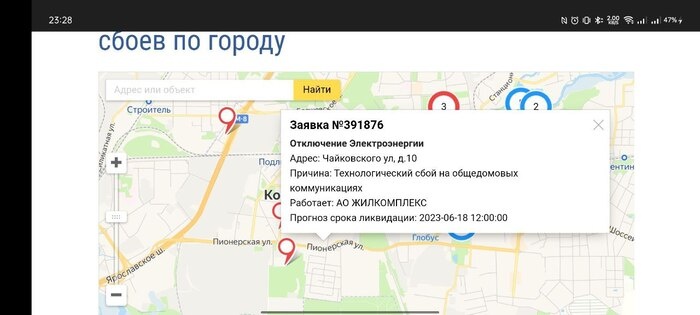

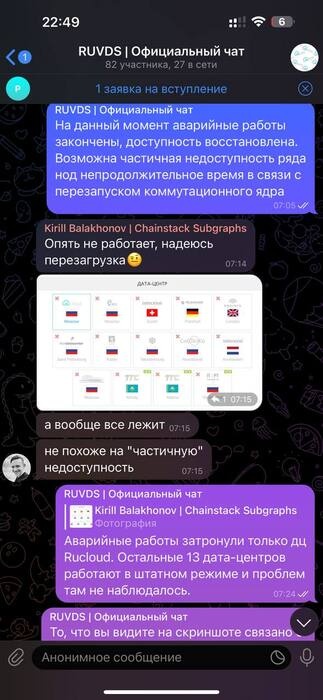

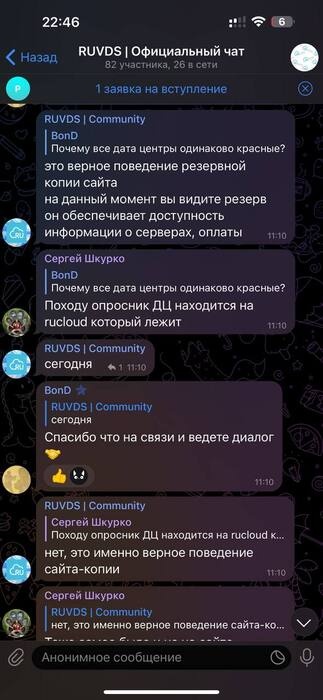

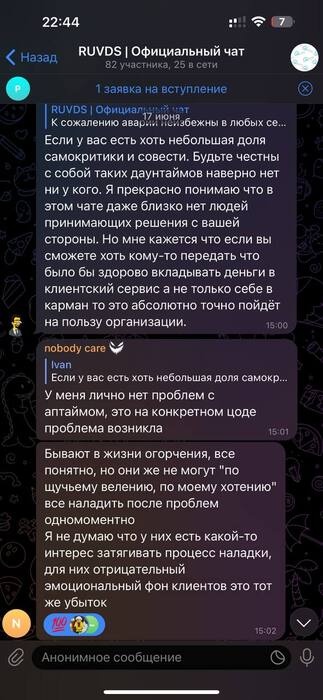

Про большую аварию

17 июня у нас была большая авария в Королёве. На три с лишним часа отключилось от 7 до 10 % виртуальных машин ЦОДа. Подробный разбор — вот

тут, последствия — вот

здесь. Как видите, мы рассказали, что там было (сейчас это читается уже со смехом, правда, немного истерическим), какие выводы мы сделали.

Из важного: вы тогда много говорили про финансовые гарантии на такие случаи. У нас в договоре их на тот момент не было, но мы считали хорошим тоном компенсировать клиентам простои.

Теперь мы апдейтнули договор и ввели первое внятное SLA на доступность. Сейчас компенсируем время простоя в пятикратном размере. На всякий случай: мировая практика на данный момент — «ну лежит и лежит», то есть, если вы опытный админ, то используйте две площадки. Дальше вам добавят время простоя или х 2 от времени простоя во время аренды сервера.

В России есть хостинги, которые платят при простоях ниже, например, 99,6 % и на премиум-тарифах (либо компенсацию до 35 % от стоимости услуг в месяц). Наше предложение работает на всех тарифах. У нас х 5 — с первой секунды. Да, это не совсем то, что идеально защитило бы каждого клиента, и всё ещё сидеть на одном инстансе не стоит, если вам важна доступность. Но пока это хороший компромисс. И это важный шаг для всего рынка. Так получилось, что мы задаём некоторые стандарты, и я надеюсь, что хотя бы такой стандарт, который мы точно можем обещать, станет базовым для сферы.

Естественно, мы сделали многое, чтобы это не повторилось, но вот эта история с SLA — для нас она очень важна, потому что мало кто делает что-то подобное. Пока смотрим.

Спутник

Мы наконец-то запустили свой

спутник. Разбор — вот здесь, разбор аварии с ним — вот

тут.

Коротко: флеш-память борткомпьютера смёрзлась и не читается. Когда мы разбирали аварию, то говорили, что есть призрачный шанс перезапустить всё по питанию и посмотреть, что получится.

Успешно перезапустить борткомпьютер так и не получилось.

Мы отработали на спутнике первый космический CTF, а потом решили, что раз уж борткомпьютер не пашет, то почему бы не отдать это всё на благо науки. Было очень конкретное применение: наши друзья из «Позитива» просили пожертвовать спутник для изучения, чтобы русские хакеры (белые шляпы) попробовали отработать его практический взлом и перехват управления. Потому что такая угроза сейчас возникает всё сильнее, а учиться особо не на чем.

Ну мы и отдали спутник сообществу. В CTF летом спутник использовался пассивно, ключ забирался просто с ретрансляции. А в Hacking Week «Позитива» уже надо было взломать его полноценно. То есть мы развернули копию ЦУПа для хакеров, куда надо было пробиться через реальные защиты, спереть протокол для управления, получить доступ к управлению антенной, навестись на нужный спутник по координатам, дать сигнал. Единственное исключение — в протоколе для Hacking Week были вставки «учебный», на которые спутник отвечал: «Типа ОК» вместо настоящих действий.

Эта история очень хорошая, потому что раньше для анализа киберрисков никто не давал спутников. А история заключается в том, что раньше все спутники были военными с кастомными платформами, и достать второй экземпляр было сложно. С появлением кубсатов можно скачать базовые прошивки примерно 10 % спутников в опенсорсе, воспользоваться уязвимостями ОС Linux и других систем, аппаратными багами стандартных платформ и так далее. То есть можно просто купить домой железо и сидеть анализировать его. Это резко повышает опасность для новых проектов. Понятно, что все кубсаты с орбиты не свести, но повредить несколько процентов вполне реально.

Наши партнёры с МКС очень опасались этой истории, потому что всё это звучит несколько страшно для индустрии, где рулит Security through obscurity. Но тут мы независимые исследователи. Поиск уязвимостей космических аппаратов — это научно-образовательный проект. Пикоспутник — наш, нам его не жалко, даём ломать. Он выполнил программу, насколько смог, дальше можно добивать.

Надо сказать, что не добили, и можно попробовать то же самое ещё раз, наверное.

DNS-сервис

Функционально это почти амазоновский Route53. Интересные применения такие:

- GeoIP, чтобы разрешать пользователя в ту страну, откуда он. Например, если из Швеции — на шведский поддомен. Точность получилась около 70–80 %.

- LoadBalancing: можно задать доли распределения, и пользователь будет пробрасываться на площадку не балансировщиком, а прямо с уровня DNS. Не самая точная в мире балансировка, но очень простая и применимая. И бесплатная.

- TimeOfDay: куда направлять и в какое время. Например, на пиковые вечерние часы можно добавлять дополнительный сервер, который отключается в спокойное время.

- GeoIPFilter: пускать или не пускать по GeoIP.

И так далее. Подробности —

тут. Получилась бесплатная штука (в «Амазоне» это за деньги), которая не так чтобы увеличивала нам поток клиентов, но точно полезна для рынка.

Технически она сейчас в публичной бете, как только доведём до полного прода, возможно, станет платной.

Всё почему? Админы привыкают к хорошему! В России функционал хостингов — не Digital Ocean и не «Амазон», конечно, но мы делаем самые важные штуки, которые юзабельны. DNS плюс OpenAPI — это хороший шаг в сторону удобства.

OpenAPI

Ну тут всё просто. У нас был свой API, перешли стандарты OpenAPI. Теперь у нас — как в лучших домах Парижа: как в Digital Ocean.

Мобильной версии сайта снова нет

В прошлом году нас часто критиковали за то, что нельзя купить виртуалку с мобильного телефона. Серьёзно, есть админы, которые привыкли покупать виртуалку с мобильного телефона! Переделывать весь сайт долго, но со временем мы это сделаем. И опыт мобила очень сильно отличается от опыта десктопа.

Поэтому мы сделали бота в «Телеграме». Он может продать вам виртуалку. Посмотрим, к чему всё это приведёт. Сам бот-магазин — вот тут. Кажется, что это похоже на новый подход к интерфейсам мобила и тренд рынка, но мы подумаем про это позже. Сейчас это просто игрушка.

Хостер года

Несколько лет мы подавались на эту номинацию и наконец-то выиграли.

rdca.ru/2023/nominant/319

В первый и второй год это была мечта. Теперь это всё ещё и очень приятно, но уже далеко не главное в жизни.

В этом году мы сделали столько, что знали: мы отлично поработали! Плюс 47 % к клиентской базе, продажи лицензионного софта на хостинге, решение вопроса с платежами для себя и части рынка, выход в Казахстан и так далее.