Новый регион Google Cloud появится в Кувейте

Чтобы удовлетворить растущий спрос на облачные услуги на Ближнем Востоке, мы рады объявить о планах открыть новый регион Google Cloud в Кувейте для поддержки нашей растущей клиентской базы.

Когда он откроется, регион Кувейт будет предоставлять высокопроизводительные услуги, которые позволят организациям обслуживать своих пользователей быстрее, надежнее и безопаснее. Местные клиенты, такие как правительство Кувейта и Alshaya Group, выиграют от ключевых элементов управления, которые позволят им поддерживать низкую задержку и самые высокие стандарты безопасности и соответствия.

«Благодаря нашему стратегическому партнерству с Google Cloud Государство Кувейт продолжит добиваться больших успехов в направлении цифровой трансформации, которая является основной опорой нашего видения Нового Кувейта (Кувейт 2035). Наш союз с Google Cloud будет иметь значительные преимущества для Кувейта и обеспечит значительный импульс для достижения социально-экономических приоритетов страны, включая повышение эффективности государственного управления, улучшение здравоохранения и образования, а также диверсификацию экономики», — сказал Его Превосходительство. Г-н Мазин Саад Аль-Нахед, министр торговли и промышленности и государственный министр по вопросам связи и информационных технологий.

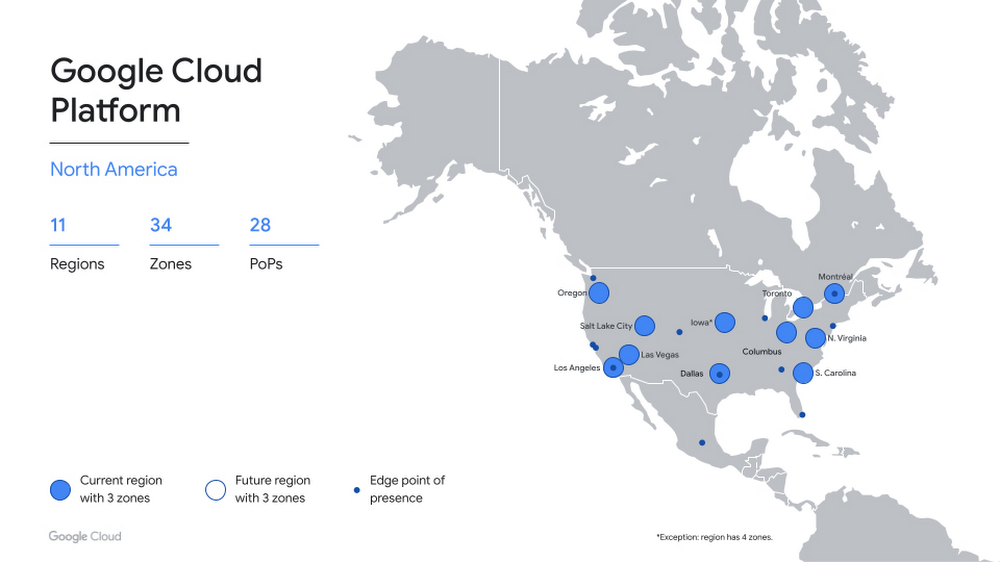

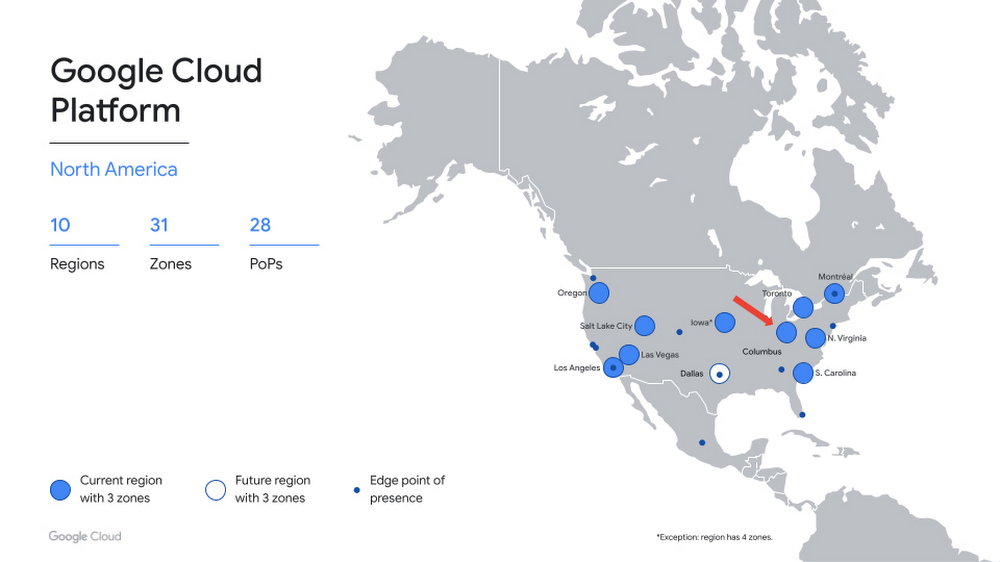

С 35 регионами и 106 зонами, которые в настоящее время работают по всему миру, глобальная сеть облачных регионов Google Cloud является основой инфраструктуры, которую она создает для поддержки клиентов любого размера и из разных отраслей. От розничной торговли, средств массовой информации и развлечений до финансовых услуг, здравоохранения и государственного сектора ведущие организации выбирают Google Cloud в качестве надежного партнера по инновациям для решения пяти ключевых задач:

Понимание и использование данных: Google Cloud помогает клиентам стать умнее и принимать более взвешенные решения с помощью единой платформы данных. Мы помогаем клиентам снизить сложность и объединить неструктурированные и структурированные данные, где бы они ни находились, чтобы быстро и легко получать ценную информацию.

Создание открытой основы для роста. Когда клиенты переходят на Google Cloud, они получают гибкую, безопасную и открытую платформу, которая развивается вместе с их организацией. Наша приверженность мультиоблаку, гибридному облаку и открытому исходному коду дает организациям свободу выбора, позволяя их разработчикам строить быстрее и интуитивно понятнее.

Защита систем и пользователей. По мере того, как каждая компания пересматривает свою систему безопасности, мы помогаем клиентам защищать их данные, используя ту же инфраструктуру и службы безопасности, которые Google использует для своих операций.

Создание среды для совместной работы. В современной гибридной рабочей среде Google Cloud предоставляет инструменты, необходимые для изменения того, как люди подключаются, создают и сотрудничают.

Построение более чистого и устойчивого будущего: компания Google придерживается нулевого уровня выбросов углерода с 2007 года, и мы работаем над достижением амбициозной цели – полностью перейти на безуглеродную энергию к 2030 году. Сегодня, когда клиенты используют Google Cloud, их рабочие нагрузки совпадают со 100 % Возобновляемая энергия.

Предстоящий облачный регион Кувейта отражает нашу постоянную приверженность поддержке цифровой трансформации на Ближнем Востоке и следует за предыдущими объявлениями о наших планах по переносу облачных регионов в Доху и Даммам.

Узнайте больше о нашей глобальной облачной инфраструктуре, включая новые и перспективные регионы.

Когда он откроется, регион Кувейт будет предоставлять высокопроизводительные услуги, которые позволят организациям обслуживать своих пользователей быстрее, надежнее и безопаснее. Местные клиенты, такие как правительство Кувейта и Alshaya Group, выиграют от ключевых элементов управления, которые позволят им поддерживать низкую задержку и самые высокие стандарты безопасности и соответствия.

«Благодаря нашему стратегическому партнерству с Google Cloud Государство Кувейт продолжит добиваться больших успехов в направлении цифровой трансформации, которая является основной опорой нашего видения Нового Кувейта (Кувейт 2035). Наш союз с Google Cloud будет иметь значительные преимущества для Кувейта и обеспечит значительный импульс для достижения социально-экономических приоритетов страны, включая повышение эффективности государственного управления, улучшение здравоохранения и образования, а также диверсификацию экономики», — сказал Его Превосходительство. Г-н Мазин Саад Аль-Нахед, министр торговли и промышленности и государственный министр по вопросам связи и информационных технологий.

Alshaya является пионером и лидером в нашей отрасли, а масштаб и расширение платформы Google Cloud позволят нам предоставлять безопасные и надежные услуги клиентам на Ближнем Востоке и в Африкесказал Чади Юнан, директор по данным, аналитике, BI и наука о данных в Alshaya Group.

С 35 регионами и 106 зонами, которые в настоящее время работают по всему миру, глобальная сеть облачных регионов Google Cloud является основой инфраструктуры, которую она создает для поддержки клиентов любого размера и из разных отраслей. От розничной торговли, средств массовой информации и развлечений до финансовых услуг, здравоохранения и государственного сектора ведущие организации выбирают Google Cloud в качестве надежного партнера по инновациям для решения пяти ключевых задач:

Понимание и использование данных: Google Cloud помогает клиентам стать умнее и принимать более взвешенные решения с помощью единой платформы данных. Мы помогаем клиентам снизить сложность и объединить неструктурированные и структурированные данные, где бы они ни находились, чтобы быстро и легко получать ценную информацию.

Создание открытой основы для роста. Когда клиенты переходят на Google Cloud, они получают гибкую, безопасную и открытую платформу, которая развивается вместе с их организацией. Наша приверженность мультиоблаку, гибридному облаку и открытому исходному коду дает организациям свободу выбора, позволяя их разработчикам строить быстрее и интуитивно понятнее.

Защита систем и пользователей. По мере того, как каждая компания пересматривает свою систему безопасности, мы помогаем клиентам защищать их данные, используя ту же инфраструктуру и службы безопасности, которые Google использует для своих операций.

Создание среды для совместной работы. В современной гибридной рабочей среде Google Cloud предоставляет инструменты, необходимые для изменения того, как люди подключаются, создают и сотрудничают.

Построение более чистого и устойчивого будущего: компания Google придерживается нулевого уровня выбросов углерода с 2007 года, и мы работаем над достижением амбициозной цели – полностью перейти на безуглеродную энергию к 2030 году. Сегодня, когда клиенты используют Google Cloud, их рабочие нагрузки совпадают со 100 % Возобновляемая энергия.

Предстоящий облачный регион Кувейта отражает нашу постоянную приверженность поддержке цифровой трансформации на Ближнем Востоке и следует за предыдущими объявлениями о наших планах по переносу облачных регионов в Доху и Даммам.

Узнайте больше о нашей глобальной облачной инфраструктуре, включая новые и перспективные регионы.