Архив 2021-2025

Декабрь, 2025

Выбираем видеокарту для ИИ до 24GB: обзор и сравнение NVIDIA L4 и T4

В этом году компания mClouds вошла в топ-10 российских GPU-провайдеров, по версии CNews. Весь год мы работали, чтобы наша платформа стала мощнее, удобнее и безопаснее. Каждое из обновлений — это шаг к росту эффективности вашей работы в облаке.

- На полную мощность заработала платформа для AI и VDI с картами NVIDIA L40S 48GB, L4, A16 и высокочастотными процессорами AMD EPYC 9374F. Серверы активируются автоматически за пару кликов, а драйверы для работы с GPU — предустановлены. Платформа оптимально подойдет для задач виртуализации рабочих столов, генеративного ИИ, инференса больших языковых моделей (LLM) и профессиональной визуализации.

- Ускорили GPU-платформу до 10% за счет возможности использовать любые драйверы NVIDIA для видеокарт L40S 48GB. Теперь процесс обучения нейросетей будет идти быстрее, а объема памяти хватит для работы с LLM и для рендеринга изображений высокого разрешения.

- Прокачали сеть до 200 Gbit/s на коммутаторах Huawei CloudEngine 6885 до уровня ЦОД. Подключили порты 25/50 Gbit/s на доступ и 100/200 Gbit/s на аплинках, продублировали сетевое оборудование, включая блоки питания и вентиляторы. Так что пропускная способность и отказоустойчивость сети для ваших проектов стали еще выше, даже при увеличении нагрузки.

- Внедрили централизованную авторизацию через Keycloak и расширили двухфакторную аутентификацию (2FA) на все критичные сервисы, включая управление резервными копиями.

- Добавили обновленные образы ОС. В нашем каталоге появились актуальные сборки Debian 13, Ubuntu 24.04, а Windows Server 2025 включают актуальные обновления. Это значит, что развертывание сервисов происходит мгновенно.

- Для Linux-образов работает авторасширение дисков. При необходимости система сама займет всё свободное место. Администраторам больше не придется тратить время на пересоздание ВМ из-за полного диска, а сервисы будут работать стабильнее.

- Запустили бонусную программу: при долгосрочной оплате (3/6/12 месяцев) бонусы начисляются автоматически — до 20% к сумме.

- Недавно снизили цену на облачные серверы с GPU NVIDIA L4 24GB, а также были выгодные предложения на NVIDIA L40S 48GB. Не переживайте, если пропустили, они обязательно будут еще — следите в нашем телеграм-канале за акциями!

Ноябрь, 2025

Запустили тестирование S3

Открыли предзаказ на видеокарты NVIDIA RTX Pro 6000 Blackwell Server Edition на наших серверах по специальной цене 119 900 руб/мес. Бронируйте, если для работы с ИИ вам уже не хватает 48GB на один GPU.

Снизили стоимость аренды сервера с видеокартой NVIDIA L4 24GB — теперь всего 27 990 руб/мес за готовую конфигурацию! Предлагаем решение для ваших проектов в области машинного обучения и инференса LLM до 7–13 млрд параметров, компьютерного зрения, VDI, CAD, рендеринга и моделирования.

Октябрь, 2025

Выбираем GPU для ИИ: Видеокарты NVIDIA RTX 4090 и 5090 vs L40S 48GB

Прокачали облако mClouds для работы с нейросетями

Как использовать GPU сервер на максимум для работы с нейросетями

Август, 2025

Материалы вебинара «GPU в облаке: как выжать максимум без лишних затрат»

Что нового в июле: усилили защиту облака, свежие статьи и обновления базы знаний

Июль, 2025

Как прошел июнь в mClouds: начисляем бонусы, ускоряем поддержку, изучаем технику

Мы упростили и ускорили процесс начисления бонусов, чтобы вы могли сразу пользоваться преимуществами. Поэтому теперь при оплате сервера на 3, 6 или 12 месяцев вы сразу получаете бонусы на счет. Активировать ничего не нужно — система все сделает за вас.

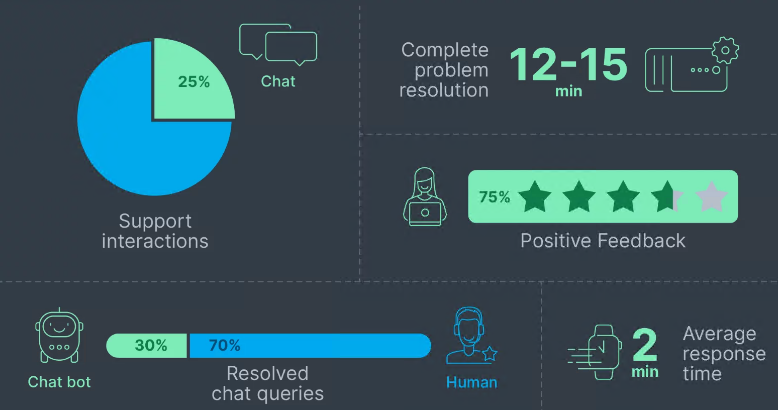

Во втором квартале мы ускорили работу поддержки — почти 90% обращений получили ответ в течение первых 10 минут.

Вебинар Clouds: GPU в облаке: как выжать максимум без лишних затрат

Расширили двухфакторную аутентификацию для ключевых сервисов

Июнь, 2025

Использование Autodesk Revit с видеокартой и как GPU влияет на работу CAD-систем

Новая система авторизации в панели vCloud Director: теперь через Keycloak

Май, 2025

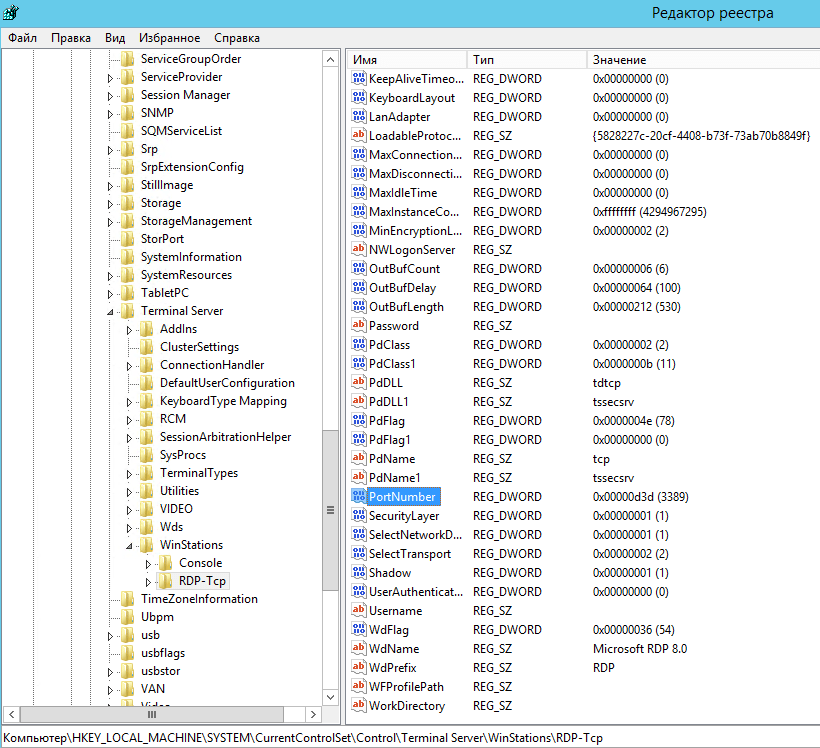

Если не работает RDP: способы исправления ошибок в Windows

Использование WebUI для Nginx: обзор веб-интерфейсов

Специальные цены на серверы с GPU NVIDIA L40S со скидкой 25%

Почему Autodesk Revit может тормозить и как обеспечить его стабильную работу

Как выбрать сервер для 1С-Битрикс: Управление сайтом, чтобы сайт быстро работал и не падал

Апрель, 2025

Обновили тарифы облачных серверов

- Увеличили производительность серверов благодаря процессорам AMD EPYC 9374F 3.85–4.1 ГГц с поддержкой памяти DDR5.

- Увеличили объем SSD. В тарифах доступен объем от 70 до 150 ГБ

- Каждый тариф облачного сервера имеет подключение к сети до 120 Мбит/с и встроенную защиту от DDoS-атак.

Rsync для синхронизации данных: настройка и примеры использования

Как установить и использовать rclone

Какую видеокарту выбрать для обучения и инференса нейросетей: обзор NVIDIA L40S, A100, H100 и A40

Как развернуть DeepSeek на своем сервере

Как развернуть LLM на сервере или локально на примере Llama 3.2

Март, 2025

Как защитить сервер от шифровальщика: практические шаги

Как настроить публикацию базы 1С на веб-сервере с https и защитой

Как использовать машинное обучение и LLM в бизнесе?

Как создать и настроить кластер серверов для 1С на Linux

VMware выявила критическую уязвимость в своей продукции

Изучаем новый RDP-клиент от Microsoft

Февраль, 2025

Как оптимизировать расходы на IT-инфраструктуру

Виды и методы резервного копирования

Как застройщик «Звезда» ускорил работу 1С и упростил IT-инфраструктуру с mClouds

Развертывание сервера 1С на Linux: полный гайд на примере Astra Linux

Январь, 2025

Оптимизация Postgres и MS SQL для работы с 1С

Как начать работать с ИИ Whisper: тестируем производительность разных платформ

Декабрь, 2024

LLM: выбор фреймворка и работа в облаке

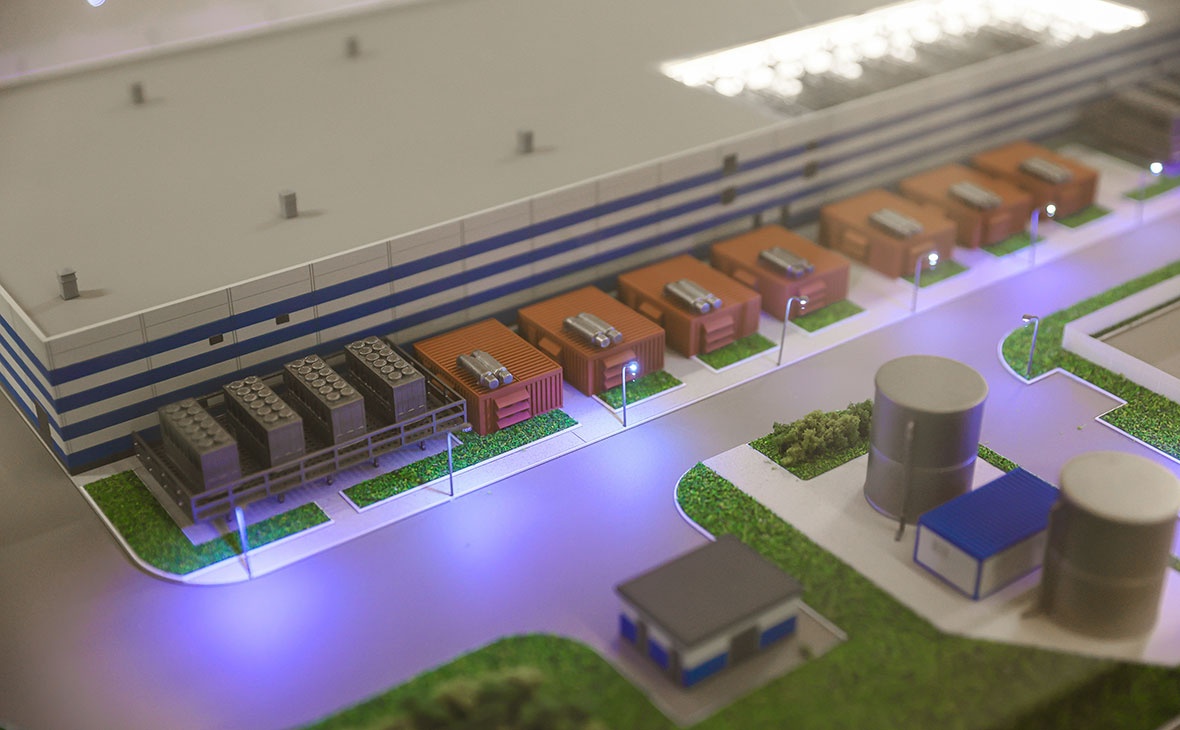

Запустили новую облачную платформу с GPU для AI, BIM и CAD

Мы в mClouds запустили новую облачную платформу для задач, требующих высокопроизводительных вычислений. В её основе — высокочастотные процессоры AMD EPYC 9374F и производительные видеокарты NVIDIA L4, L40S и A16.

Что мы сделали в 2024 году: дайджест событий и достижений

- Запустили новую облачную платформу с GP для AI, BIM и CAD. Сейчас это одна из самых быстрых GPU-платформ в России.

- Полностью перешли с HDD на SSD и NVME. Для продуктивных серверов клиентов теперь используем только быстрые твердотельные накопители, а HDD — для работы с архивными данными. Это значительно ускоряет работу в облаке для сервисов и делает ее более комфортной.

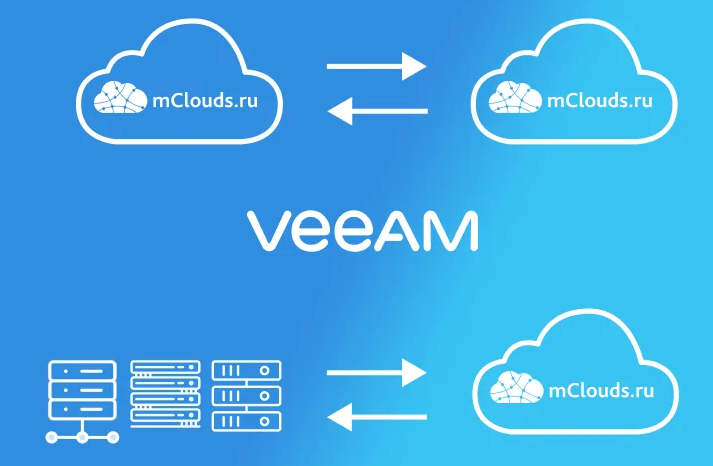

- Ускорили миграцию в облако. Применяем Hystax Acura для миграции в облако в режиме реального времени и без приостановки работы приложений. Решение используем не только для миграции, но и для аварийного восстановления данных, IT-инфраструктуры и облачного бэкапа данных. Доступна полная автоматизация миграционных процессов: создание виртуальных машин, подбор конфигураций, контроль переноса данных.

Ноябрь, 2024

Облачный GPU-сервер: для чего нужен и как выбрать

Как подобрать облачный GPU-сервер для BIM и CAD

Вебинар mClouds: «Производительность 1С: Intel vs AMD — что эффективнее?»

Октябрь, 2024

Что такое виртуализация серверов и как ее использовать

5 ключевых критериев выбора облачного сервера в аренду

Какой дистрибутив Linux выбрать для сервера

GPU для нейросетей: выбор карты для машинного обучения в облаке

Сентябрь, 2024

Тест Гилева для 1С: как установить, провести и понять результаты

Как защитить облачный сервер от взлома и хакерских атак

Резервное копирование в облако: что нужно знать о клауд-бэкапах

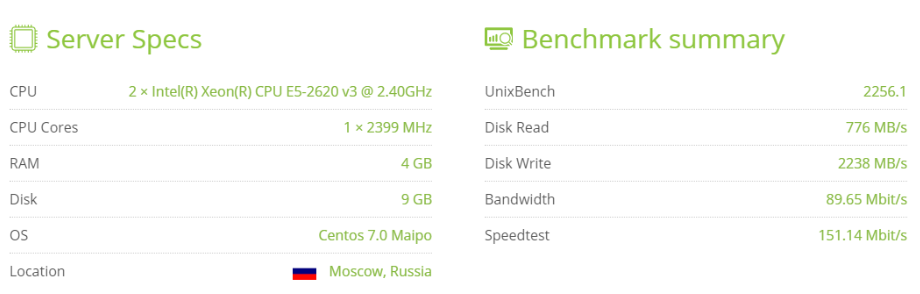

Сервер для Форекс в облаке: как выбрать и настроить

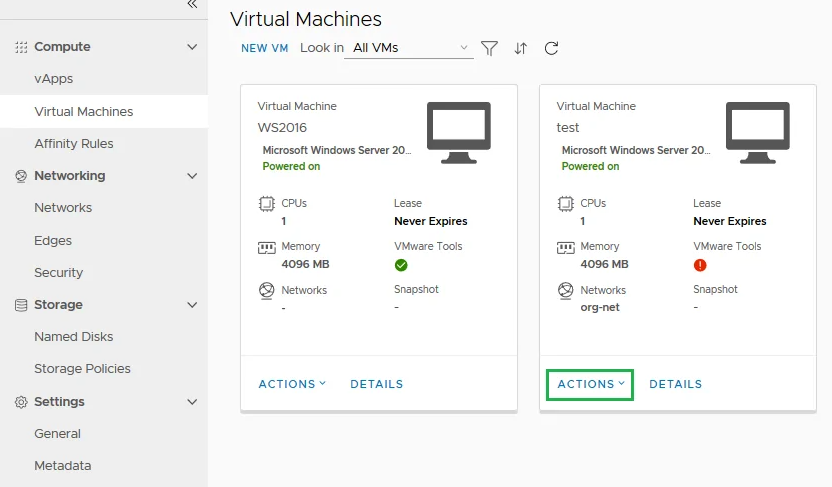

Как мы используем продукты VMware для виртуальных серверов

Август, 2024

Сценарии размещения 1С в облаке

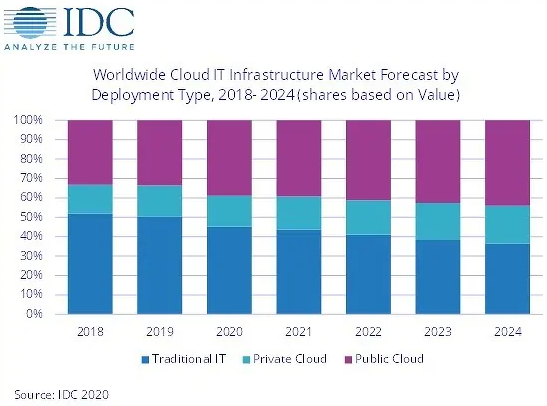

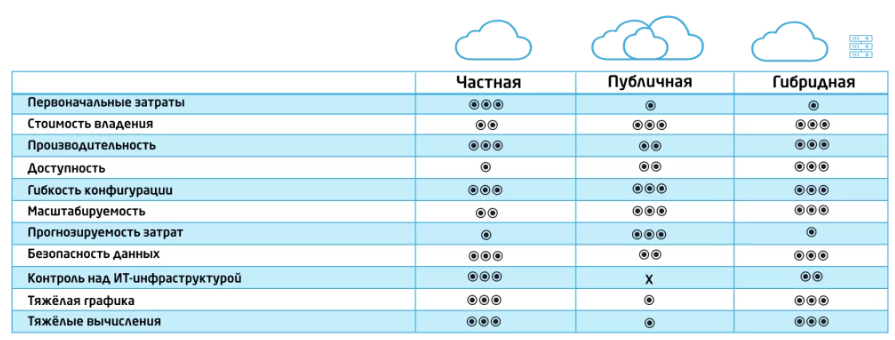

Частные, публичные и гибридные облака: разные виды облачных сервисов

Как устроен виртуальный ЦОД: работа облачных дата-центров

DRaaS (Disaster Recovery): облачный сервис аварийного восстановления данных

Июль, 2024

Уязвимость в OpenSSH

Облачные модели IaaS, SaaS, PaaS: гайд по выбору

Облако или свои серверы: что выбрать

Июнь, 2024

Топ ошибок при планировании облачной инфраструктуры для 1С. Часть вторая — Память, Диски и Сеть.

Май, 2024

Microsoft открыла доступ к обновлениям Windows систем и приложений

В топе рейтинга партнерских программ облачных провайдеров 2024

Мы с гордостью сообщаем, что наша партнерская программа заняла третье место в рейтинге лучших партнерских программ среди облачных провайдеров в 2024 году. Этот рейтинг был опубликован IT-маркетплейсом Market.CNews.

Апрель, 2024

Приближаются даты окончания срока поддержки для CentOS 7 и Debian 10

Федеральная сеть аптек «Я+аптека» улучшила работу учетных систем в облаке mClouds.ru

Обзор ключевых анонсов и трендов по следам Intel Vision 2024

Топ ошибок при планировании облачной инфраструктуры для 1С. Часть первая — выбор и особенности работы с процессорами.

Март, 2024

Функционал облачного диска

Облачный диск — платформа, с помощью которой можно создать собственное безопасное облачное хранилище. Он похож на Dropbox, Яндекс Диск, Google Drive, но обладает большей функциональностью.

Microsoft и Amazon закрывают доступ к облачным сервисам в России

Январь, 2024

Кейс: как виртуальный дата-центр обеспечил непрерывную работу сайта заказчика

Декабрь, 2023

Как настроить безопасный доступ к RDP

Провели новогоднюю викторину

22 декабря в 14:00 мы провели Новогоднюю онлайн-викторину для действующих пользователей облака mClouds. Интерактивный формат викторины прошел в соревновательном духе! Мы разыграли: Яндекс Станцию Миди, Яндекс Станцию Мини, наборы мерча от mClouds и бонусный баланс.

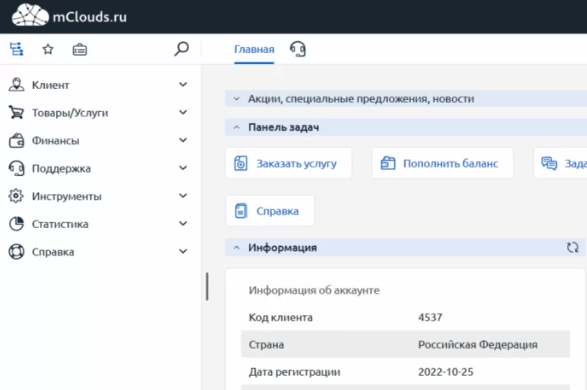

Облако mClouds: обновления за 2023 год

- Обновление облачной инфраструктуры

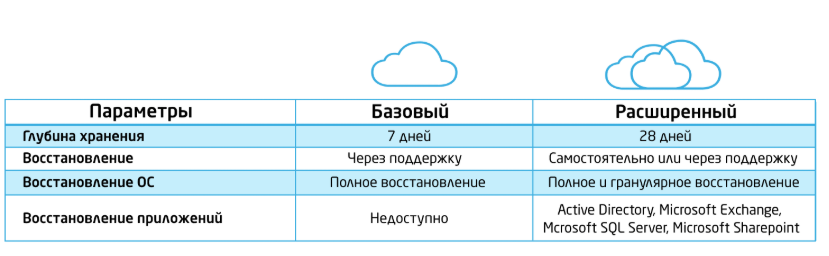

- Обновления сервисов: услуги резервного копирования

- Личный кабинет услуг

Ноябрь, 2023

Обновленный кластер “Silver”: завершили миграцию пользователей

- Мы завершили миграцию пользователей IaaS на 100% и пользователей облачного сервера базового кластера. За это время переместили более 42 ТБ данных, 18 ночных сессии и столько же дневных, провели более 200 минут разговоров по телефону во время миграции: всегда были на связи и помогали проверять сервисы нашим клиентам.

- Название. Ранее проекты размещались в базовом кластере, где использовались процессоры Intel Xeon E5 с частотой от 2.5 до 2.8 GHz. Сейчас новый кластер называется Silver с процессорами Intel Xeon Gold 6330, работающих на эффективной частоте 2,6 ГГц в режиме постоянного turbo boost.

Terraform: создание и управление инфраструктурой

Настройка терминального сервера Windows Server 2022. Часть I

Управление vCloud Director из командной строки vCD-CLI

Настройка терминального сервера с доменом. Часть II

Октябрь, 2023

Переходим на новую платформу в базовом сегменте облака

- Gold сегмент построен на высокопроизводительных процессорах серии Intel Xeon Gold 6254, 6242R и 6354 c эффективными частотами от 3,6 до 3,9 ГГЦ в режиме постоянного Turbo Boost на все ядра.

Антивирусная защита в облаке: угрозы и способы защиты ИТ-ресурсов

Сентябрь, 2023

Российский IT-рынок: к двукратному росту к 2030

Вебинар «Облачное резервное копирование: как выйти сухим из воды»

Август, 2023

Открытые альтернативы современным программам

Как организовать миграцию данных самостоятельно

Метод резервного копирования: как выбрать оптимальный?

Добавили в облако mClouds платформы нового поколения

- Мы обновили облако mClouds платформами нового поколения, установили серверы DELL R650 с высокопроизводительными процессорами Intel Xeon Gold 6354, частота оперативной памяти 3200 МГц. Выполнили тестирование и интеграцию в нашу облачную платформу, теперь делимся с вами результатами.

- Новые серверы имеют производительность на 1 виртуальное ядро выше, в среднем на 5%, чем текущие процессоры. Разница в производительности на 8 ядрах, в среднем на 40%.

- Мы успешно тестировали: платформу DELL R650 с двумя процессорами Intel Xeon Gold 6354, 1 Тбайт оперативной памяти (3200 MT/s), сетевой адаптер Mellanox ConnectX-5 25 Гбит/с.

- 48.2998 GFlops на одно ядро процессора;

- 7-Zip — 5 878 MIPS на одно виртуальное ядро (compress, dict 25);

- пропускная способность 25 Гбит/с.

Июль, 2023

Миграция в облако: рекомендации по легкому и безопасному переносу данных

Облачный диск: какие задачи решает и варианты использования

Июнь, 2023

Кейс: настроили IP-телефонию на базе MikoPBX в облаке для компании сферы оптовой торговли автомобильными деталями

Как обеспечить информационную безопасность в облачных сервисах?

Debian 12 и Ubuntu 23.04: обновления дистрибутивов операционной системы Linux

Как работать с правами доступа Unix

Обновленная версия Личного кабинета: возможности управления

Май, 2023

Эффективные способы защиты Windows Server 2022

Миграция ИТ-инфраструктуры в облако: как подготовиться и перенести данные без проблем.

Кейс: как масштабировали ИТ-инфраструктуру и сэкономили на дополнительном оборудовании.

Какие возможности получают клиенты от cloud-сервисов облачного провайдера

Обновили функционал услуги Резервного копирования

24 Апреля, 2023

Кейс: как настроили файловое хранилище с разграничением уровня доступа пользователей

19 Апреля, 2023

Подборка современных альтернатив популярным Linux программ

10 Апреля, 2023

Провели апгрейд услуги резервного копирования

Провели апгрейд услуги резервного копирования: скорость создания резервных копий увеличилась в 6 раз! Это значит, что процесс создания резервных копий теперь занимает значительно меньше времени, что повышает эффективность работы.

04 Апреля, 2023

Безопасный перенос 1С в облако mClouds

Чем управляют пользователи в модели Iaas?

24 Марта, 2023

Как интегрировали единую систему управления ресурсами для НПП

13 Марта, 2023

Преимущества резервного копирования в облако

21 Февраля, 2023

Для чего используют облачные модели IaaS

15 Февраля, 2023

Как перенести «1С» в облако быстро и безопасно

27 Января, 2023

Как обеспечить современную защиту персональных данных в облаке?

Как выбрать облачного провайдера для миграции базы 1С?

Зачем тестировать облачные сервисы? Нюансы и преимущества

11 Января, 2023

Установка сервиса видеоконференцсвязи Jitsi

09 Января, 2023

Вошли в ТОП-10 рейтинга партнерских программ IaaS 2022

27 Декабря, 2022

Облачный сервер для миграции 1С

15 Декабря, 2022

Обновление VMware Tools до версии 12.1.5

08 Декабря, 2022

Гибридная ИТ-инфраструктура: как настроить интеграцию локальных и облачных ресурсов

01 Декабря, 2022

Тенденции развития облачных технологий до 2025 года: 85% компаний будут в “облаках”

25 Ноября, 2022

Работа с терминалом Linux

18 Ноября, 2022

Вебинар «Как провести интеграцию локальной и облачной инфраструктуры»

16 Ноября, 2022

Подборка горячих клавиш в терминале Linux

11 Ноября, 2022

Сравнение популярных облачных дисков 2022

25 Октября, 2022

Настройка Active Directory: установка бесплатного мессенджера Mattermost

21 Октября, 2022

mClouds вошел в ТОП-5 рейтинга GPU Cloud 2022!

ИТ-маркетплейс Market.CNews опубликовали рейтинг GPU Cloud 2022, среди облачных провайдеров mClouds занял 4 строку рейтинга.

12 Октября, 2022

Как настроить Nextcloud сервер и провести его интеграцию с LDAP

17 Сентября, 2022

Как установить 1С: Предприятие на облачный сервер с PostgreSQL

30 Августа, 2022

Как настроить Active Directory в облаке

25 Августа, 2022

Обновление VMware Tools до версии 12.1.0

12 Августа, 2022

Ключевые шаги успешной миграции в облако

02 Августа, 2022

Настраиваем сеть в облаке на базе VMware

21 Июля, 2022

Устанавливаем Mattermost — быстрый и бесплатный командный мессенджер

18 Июля, 2022

Как установить собственный менеджер паролей

05 Июля, 2022

Антивирусная защита облачных серверов на базе решений Лаборатории Касперского

29 Июня, 2022

НАЦ «Информзащиты» аттестовал защищенный ЦОД облачного провайдера mClouds

«Национальный аттестационный центр», входящий в группу компаний «Информзащита», аттестовал по требованиям 152-ФЗ центр обработки данных облачного провайдера mClouds.

mClouds – федеральный провайдер облачных услуг для бизнеса, работающий на рынке более 5 лет, доверил аттестацию своего центра обработки данных (ЦОД) специалистам ООО «НАЦ».

27 Июня, 2022

Ускорили создание серверов на базе Linux

Наша команда добавила одну из ваших идей — новые образы для автоматической активации. Помимо актуальной версии Ubuntu и Debian, добавили CentOS Stream. Команда добавила следующие образы:

Теперь пользователи могут получать доступ к актуальным версиям ОС в течение 5 минут после оплаты.

10 Июня, 2022

Опубликована новая версия VMware Tools 12.

01 Апреля, 2022

Оплата услуг с помощью QIWI

18 Марта, 2022

Цифровая платформа для вузов программы «Приоритет 2030» запущена в облаке mClouds

16 Марта, 2022

Как быстро мигрировать в российские облака?

15 Марта, 2022

Изменение цен на продукты Microsoft

10 Марта, 2022

Отвечаем на вопросы о работе в текущей ситуации

Возможно ли переехать в облако mClouds из зарубежных дата-центров?

Да, переезд возможен. Мы оказываем всестороннюю помощь в быстрой миграции. Запасов мощности оборудования хватит для решения всех задач. Мы понимаем вашу нынешнюю ситуацию и предоставляем приоритет, а также индивидуальные скидки для миграции с западных хостинг-провайдеров. Мы можем провести миграцию с любого гипервизора и с минимальным простоем для ваших сервисов.

Откуда планируют миграцию в mClouds: Hetzner, DigitalOcean, Linode, Microsoft Azure, Google Cloud, Amazon, Oracle Cloud, IBM Cloud и др.

Помогаете ли вы с миграцией и оптимизацией ресурсов?

Да. В случае переноса инфраструктуры к нам из другого облака или локальной инфраструктуры, наши специалисты помогут вам мигрировать. Проводим перенос с минимальным простоем или без него. При необходимости инженеры помогут с отладкой и оптимизацией производительности работы серверов.

А если у нас другой гипервизор?

Миграция может быть осуществлена с любого гипервизора, с помощью репликации в реальном режиме времени. Когда репликация данных в облака будет окончена, достаточно переключиться на работу в нашем облаке.

Хотим перенести свои сервисы в ваше облако. Есть ли у вас ресурсы с учетом спроса?

Наша облачная платформа имеет запасы по расширению ресурсов клиентов на длительную перспективу. Мы тщательно новые каналы поставок оборудования в облако, учитывая текущие ограничения.

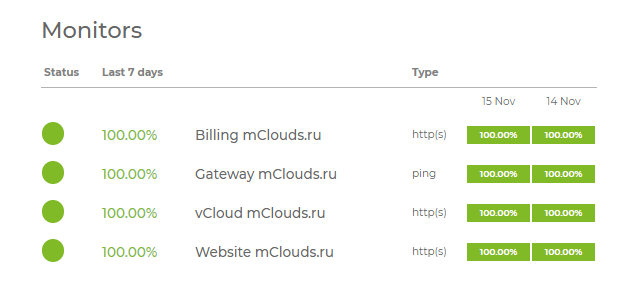

Насколько стабильны и доступны сервисы mClouds?

Платформа работает в штатном режиме. Вся инфраструктура дублирована, нет единой точки отказа. Оборудование находится в защищенном дата-центре с системой гарантированного и бесперебойного энергоснабжения. Каналы связи с облаком, также имеют несколько подключений, и не зависят от зарубежных операторов связи.

Планируете ли закупать оборудование дополнительно, например в рамках импортозамещения?

Мы планируем приобретение нового оборудования. Сейчас изучаем план закупок с учётом введенных ограничений. Наша платформа использует технологии и архитектуру Intel, развитие платформы планируется в рамках этой архитектуры. Мы уже изучаем новые каналы поставок серверного оборудования, а также предмет их совместимости с текущими аппаратными компонентами. Переходить на российские платформы пока не планируется.

Как может сказаться нынешняя ситуация на ресурсах, которые вы используете?

В краткосрочной перспективе эти сложности не отразятся на действующих и новых проектах. На стоимость услуг влияет значительное изменения курсов валют. Пока их удается удерживать, но в дальнейшем возможен рост стоимости облачных услуг, ввиду увеличения сроков поставок и повышения цен на оборудование. Вы внимательно следим за ситуацией.

Как будет работать программное обеспечение вендоров, которые уйдут из РФ?

Мы не ожидаем каких-либо изменений в работе для текущих клиентов платформы, так как не получаем от производителей информации по лицензионным ограничениям для действующих клиентов.

Можно ли использовать облако mClouds в качестве резервной площадки?

Да, вы можете размещать в mClouds резервные виртуальные машины для обеспечения работы ваших корпоративных сервисов с помощью услуги IaaS. Также можно организовать резервное копирование вашей текущей локальной или облачной инфраструктуры в облако mClouds с помощью услуги BaaS. Оба варианта обеспечат высокий уровень защиты данных.

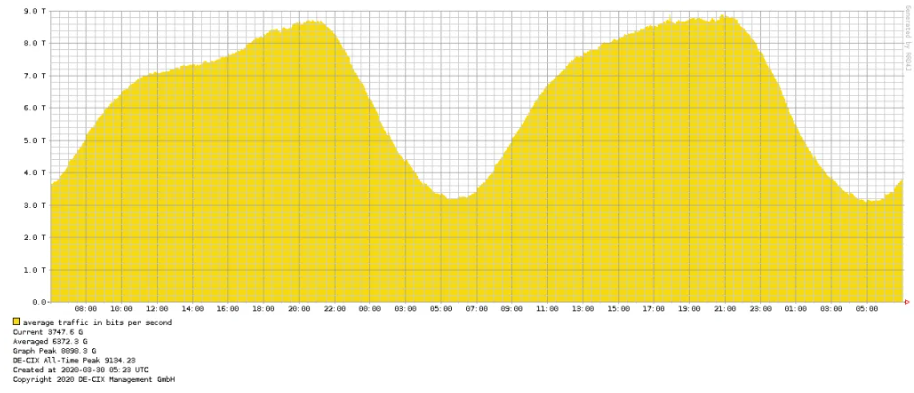

Сейчас происходит множество DDoS-атак. Задели ли они сервера ваших клиентов? Есть ли у вас защита?

На текущий момент мы не наблюдаем увеличения динамики атак на сетевую инфраструктуру облака и сервисов наших клиентов. Наши каналы связи находятся под постоянной защитой от атак типа DDoS и мы не ожижаем прерывания сервисов.

09 Марта, 2022

Изменения в оплате картами Visa и Mastercard

С 10 марта Visa и Mastercard прекращают проводить в России операции по своим зарубежным картам.

Если ваша карта Visa и Mastercard, а также JCB и American Express выпущена в иностранном банке, с 9 марта вы не сможете провести оплату. Альтернативой для вас может стать карта платежной системы “МИР” — она продолжает работать.

24 Февраля, 2022

Отмена приема платежей через WebMoney

В связи с тем, что 11 февраля 2022 года ЦБ России была отозвана лицензия на осуществление банковских операций у «Консервативного коммерческого банка», который обслуживал WebMoney, нельзя будет совершать платежи WebMoney.

17 Февраля, 2022

Новые образы ОС

02 Февраля, 2022

Как правильно сделать рабочий бекап?

31 Января, 2022

Итоги конференции Dell Technologies Roadshow 2022

Павел Карнаух, директор технического департамента Dell Technologies в России отметил среди трендов:

- Мультиоблачный подход

- Контейнеризация

- 5g как мейнстрим

- Кибербезопасность

29 Декабря, 2021

График работы в праздничные дни

28 Декабря, 2021

Итоги года в mClouds: что нового появилось в 2021 году

- Резервное копирование в облако

- Виртуальные рабочие места VDI в облаке

- Облачный диск

- Провели два вебинара

21 Декабря, 2021

VDI: простое решение для размещения рабочих мест в облаке

15 Декабря, 2021

Критическая уязвимость в Log4j

13 Декабря, 2021

Резервное копирование: почему стоит перейти в облако?

25 Ноября, 2021

Изменение стоимости лицензий в рамках программы SPLA

24 Ноября, 2021

mClouds в ТОП-5 лидеров партнерских программ облачных провайдеров по версии CNews

- Платформа облака корпоративного класса — VMware. Управление облаком и его ресурсами через VMware vCloud Director 10

- Быстрые процессоры последнего поколения Intel Xeon Gold 6254 с частотой 3.1 ГГЦ и возможностью работы на частоте 3.9 ГГЦ

- Использование систем хранения данных IBM, работающих полностью на флеш дисках.

- Крупнейший в РФ ЦОД NORD4 в г. Москва, сертифицированный на уровне TEIR III.

- Отличные показатели в отраслевых тестах по 1С Предприятие и SAP.

09 Ноября, 2021

Windows Server 2022: особенности и возможности версии

26 Октября, 2021

Новая возможность: уведомления в Телеграм

14 Октября, 2021

Новый сервис «Виртуальные рабочие места»

Сервис VDI позволяет быстро развернуть и использовать рабочие столы в облаке. При необходимости их легко масштабировать, а на этапе подключения не нужно больших инвестиций. Услуга работает на базе технологий Citrix.

21 Сентября, 2021

Новые сервисы резервного копирования в облако

03 Сентября, 2021

Обновление цен на лицензии Microsoft с 1 октября 2021 года

18 Августа, 2021

Вебинар «5 проблем, которые решает облако»

04 Августа, 2021

Новый сервис «Облачный диск»

Представляем вам новую услугу для корпоративных клиентов «Облачный диск». Доступ к сервису предоставляется как классическое SaaS-решение — готовый сервис из публичного облака по подписке, либо как интеграция в облачной инфраструктуре IaaS в контуре облака клиента.

24 Июля, 2021

Преимущества аренды облачных серверов

17 Июля, 2021

Основные плюсы и минусы VPS сервера

26 Июня, 2021

Что такое VDS и как его можно использовать

01 Июня, 2021

Окончание поддержки ISPmanager 5. Переход на ISPmanager 6

31 Мая, 2021

Инфраструктура как услуга или что такое IaaS

28 Мая, 2021

«Облачная инфраструктура»: в чем преимущество перед корпоративным сервером

25 Мая, 2021

Миграция в облако на базе VMware c помощью Hystax Acura

28 Апреля, 2021

Как перенести базу 1С в облако

13 Апреля, 2021

Преимущества виртуализации 1С: оптимальная конфигурация на виртуальном сервере

23 Февраля, 2021

Обновленный раздел Поддержка

11 Января, 2021

Передача файлов на облачный Linux сервер

Для передачи файлов и папок на облачный сервер под управлением Linux ОС потребуется скачать WinSCP. WinSCP — это популярный SFTP клиент и FTP клиент для Microsoft Windows! Поможет скопировать файл и папку между локальным компьютером и удаленным сервером, используя протоколы передачи файлов FTP, FTPS, SCP, SFTP, WebDAV или S3.