Январь — это сплошные эмоциональные качели. В первой половине месяца мы пытаемся забыть о задачах, чтобы хорошенько перезагрузиться на праздниках. А во вторую — делаем нечеловеческие усилия, чтобы вспомнить, чем занимались до каникул :) Но если вы начали узнавать коллег — это хороший знак: значит, самые сложные деньки позади, и вы почти вошли в рабочий ритм.

Мы тоже уже в строю и подготовили традиционный дайджест. Коротко и по делу рассказываем, что интересного выпустили в январе: в подборке новые инструкции, вдохновляющие истории на Хабре и новости от нас и наших партнёров.

Статьи и инструкции

Топ-10 лучших HTML-редакторов для новичков и профессионалов

Обзор редакторов кода HTML: от простого софта до мощных IDE для специфических задач. Сравниваем особенности, преимущества и ограничения программ.

firstvds.ru/blog/top-10-luchshikh-html-redaktorov-dlya-novichkov-i-professionalov

Установка и настройка fail2ban

Fail2Ban — инструмент, который позволяет предотвращать атаки на Linux-серверы. В статье в подробностях объясняем, как настроить утилиту для протокола SSH и веб-сервера nginx.

firstvds.ru/technology/ustanovka-i-nastroyka-fail2ban

Habr: самое интересное за январь

Чтобы начать новый год с правильного настроя, нужен заряд мотивации. На Хабре собрали примеры невероятных свершений — истории о людях, решивших грандиозные задачи без современных технологий, и о неугомонных учёных, не отступающих перед новыми вызовами. А также припасли практические советы, которые можно сразу использовать в деле: например, чтобы организовать киберзащиту без бюджета или сделать диктофон с распознаванием речи.

Ищем авторов для блога на Хабр

Подготовьте статью на одну из специальных тем или отправьте материал на тему месяца. И если ваша статья подойдёт для блога, получите повышенный гонорар.

Тема февраля: компьютерное железо.

firstvds.ru/avtoram

Новости января

firstvds.ru/avtoram

Новости января

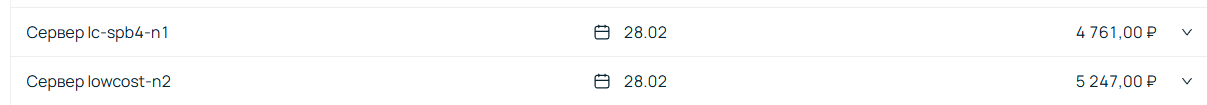

Ispmanager повышает цены

Компания ispmanager повысит стоимость панели управления. Поэтому с 1 февраля 2026 года мы также вводим новый прайс:

Цены с 1 февраля 2026 года

- ispmanager 6 Lite — 399 ₽/мес

- ispmanager 6 Pro — 789 ₽/мес

- ispmanager 6 Host — 1439 ₽/мес

Для серверов, которые продолжат работу с ispmanager 5, цена составит:

- для версии Lite — 399 ₽/мес

- для версии Pro — 789 ₽/мес

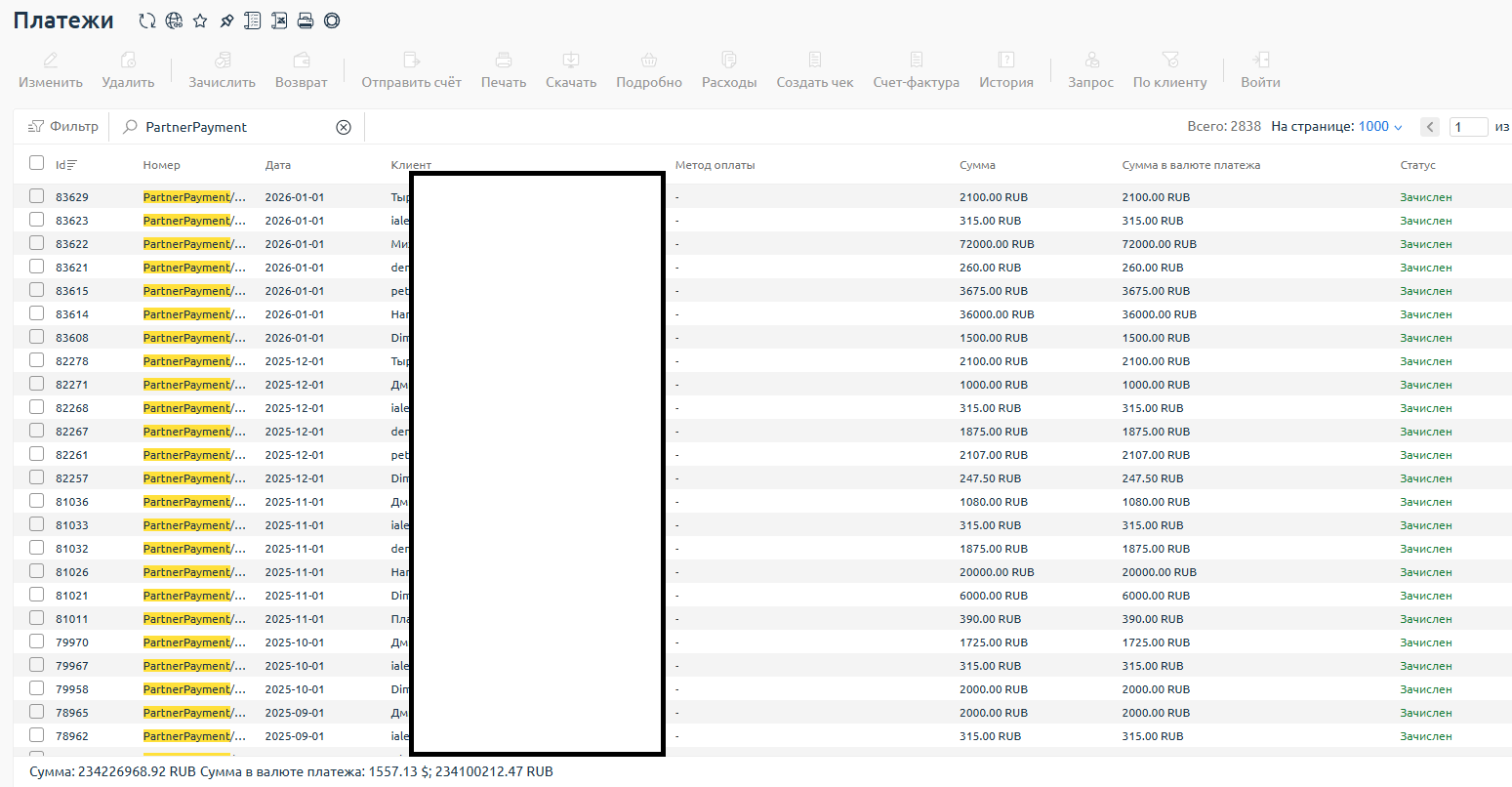

Новая функция проекта CLO — мультипроектность CLO.RU

Новая функция проекта CLO — мультипроектность CLO.RU

Наш партнёр CLO, провайдер облачной инфраструктуры, постоянно развивает свою платформу. В январе команда проекта запустила новую функцию — мультипроектность. Она позволяет работать в рамках одного аккаунта с несколькими изолированными проектами. Теперь можно:

- создавать до 5 проектов по умолчанию;

- называть проекты как удобно и оставлять к ним комментарии;

- управлять каждым проектом отдельно: запускать, останавливать, удалять;

- назначать свои лимиты на каждый проект или использовать общие;

- привязывать тикеты поддержки к конкретному проекту;

- фильтровать расходы по проектам и типам операций.

Новый функционал подойдёт тем, кто:

- управляет инфраструктурой нескольких клиентов,

- разделяет среды (dev / test / prod),

- запускает разные сервисы и хочет держать всё в одном месте, но без хаоса.

Также в Public API добавлены эндпоинты для управления проектами и лимитами — документация уже обновлена.

Топ новостей из мира безопасности

Критическая уязвимость в плагине Modular DS WordPress

В плагине WordPress Modular DS обнаружена критическая уязвимость (CVE-2026-23550), позволяющая без аутентификации повысить привилегии до администратора. Она затрагивает все версии плагина до 2.5.1 включительно и набрала 10 баллов из 10 по шкале CVSS. Сейчас плагин установлен на более чем 40 000 сайтов, а 13 января 2026 года зафиксировали первые активные атаки с использованием этой уязвимости.

Корень проблемы — в ошибке механизма маршрутизации плагина. Чувствительные маршруты с префиксом /api/modular-connector/ (например, /login/, /backup/) должны быть защищены, но защиту можно обойти, если на сайте включен режим «прямого запроса». Например, для обхода достаточно отправить запрос с параметрами origin=mo и любым значением type (например, origin=mo&type=xxx). Система воспринимает такой запрос как легитимный от сервиса Modular и пропускает проверку аутентификации. Это позволяет злоумышленнику получить доступ к защищенным эндпоинтам.

Самый опасный маршрут — /api/modular-connector/login/, который позволяет атакующему получить права администратора WordPress, и скомпрометировать сайт: внедрить вредоносный код, разместить на ресурсе малварь или перенаправить посетителей на фишинговые страницы. На практике злоумышленники уже использовали этот метод для создания новых административных учётных записей (например, с логином backup).

Основной и обязательный способ защиты — немедленно обновить плагин Modular DS до исправленной версии 2.5.2. Также разработчики рекомендуют проверить сайты на признаки компрометации:

появление новых пользователей с административными правами;

наличие в логах подозрительных запросов к /api/modular-connector/ от автоматических сканеров.

xakep.ru/2026/01/20/modular-ds/

Zero-click уязвимость в Android-прошивке Pixel 9, затрагивающая широкий спектр устройств и ОС

Исследователи из Google Project Zero создали эксплойт для смартфонов Google Pixel 9. Он позволяет удалённо выполнить произвольный код с правами ядра операционной системы, отправив SMS или RCS-сообщение со звуковым вложением. Атака не требует никаких действий от пользователя (zero-click) — достаточно получения сообщения.

Эксплойт основан на последовательном использовании двух уязвимостей:

CVE-2025-54957 в библиотеке Dolby Unified Decoder (libcodec2_soft_ddpdec.so). При автоматической обработке полученного звукового вложения (например, для создания транскрипции AI-помощником в Google Messages) возникает целочисленное переполнение. Это позволяет выйти за границы буфера и перезаписать критический указатель, что в итоге приводит к выполнению кода атакующего в привилегированном контексте процесса mediacodec.

CVE-2025-36934 в драйвере ядра Linux bigwave. Из контекста mediacodec атакующий код получает доступ к уязвимому драйверу /dev/bigwave, специфичному для прошивки Pixel. Через уязвимость в ioctl-вызове он перезаписывает структуры ядра, что в итоге даёт полный контроль над системой с наивысшими привилегиями.

Ключевую роль играет автоматическая обработка медиафайлов современными системами (AI-помощники, транскрипция), что превращает атаку в «zero-click».

Первая уязвимость (в библиотеке Dolby Unified Decoder) также проявляется в других платформах (Samsung S24, MacBook Air M1, iPhone 17 Pro, Windows, ChromeOS и т.п.). Анализ возможности создания подобных эксплоитов для других платформ и Android-прошивок пока не проводился.

Что предпринять для защиты:

Установить обновления безопасности — это основной метод. Исправления для библиотеки Dolby и ядра уже выпущены Google (5 января для Pixel) и Samsung (12 ноября). Пользователям других ОС и устройств нужно следить за обновлениями от производителей.

Использовать встроенные механизмы защиты. Например, активировать Memory Tagging Extension (MTE) на Pixel 8/9. Эта аппаратная функция безопасности значительно затрудняет эксплуатацию уязвимостей переполнения буфера. Включается в настройках в режиме «Advanced Protection».

www.opennet.ru/opennews/art.shtml?num=64632

Уязвимость в telnetd, позволяющая получить удалённый root-доступ без пароля

В сервере telnetd из набора GNU InetUtils обнаружена уязвимость, которая позволяет удалённо подключиться к системе под любым пользователем, в том числе с root-правами, без ввода пароля. Уязвимость присутствует во всех версиях, начиная с InetUtils 1.9.3 (с 2015 года) и вплоть до актуальной 2.7.0.

Проблема возникает из-за некорректной обработки имени пользователя в режиме автоматического подключения (autologin).

Для проверки пароля telnetd вызывает системную утилиту /usr/bin/login, которая имеет опцию -f, позволяющую войти без аутентификации. В обычном режиме подставить -f root в качестве имени пользователя нельзя. Однако при подключении с опцией -a (autologin) имя пользователя берётся из переменной окружения USER.

Значение этой переменной передаётся в login без проверки. Поэтому, если установить USER='-f root' и выполнить команду telnet -a имя_сервера, сервер выполнит вход от имени root-пользователя без запроса пароля.

Единственный способ защиты — применить официальные исправления (патчи), которые опубликованы здесь и здесь.

www.opennet.ru/opennews/art.shtml?num=64649