Конкурентные цены на услуги всегда были «королем аргументов» для клиентов при выборе дата-центра. А из чего складываются эти цены? Первыми на ум приходят расходы на IT-оборудование и электричество, но значительную долю в структуре цен составляют расходы на охлаждение серверов, систем хранения (СХД) и сетевых устройств. К примеру, сервер с несколькими процессорами выделяет до 600 Вт и более тепловой энергии, которую надо эффективно удалить, а на вход вентиляционных отверстий сервера подать холодный воздух.

Сейчас мы познакомим вас с технологиями климатических систем в дата-центрах Selectel и расскажем, каким образом новинки в этой сфере снижают операционные расходы дата-центров, а косвенно — и суммы в счетах наших клиентов.

3 рынка услуг — 3 требования к охлаждению

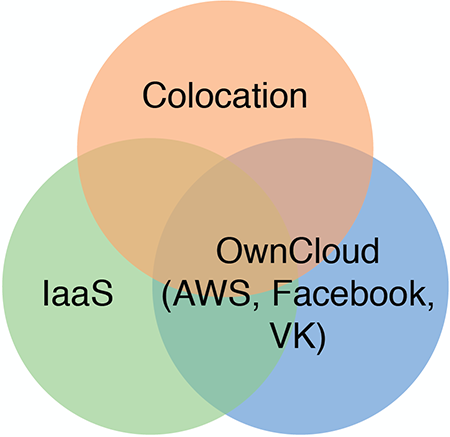

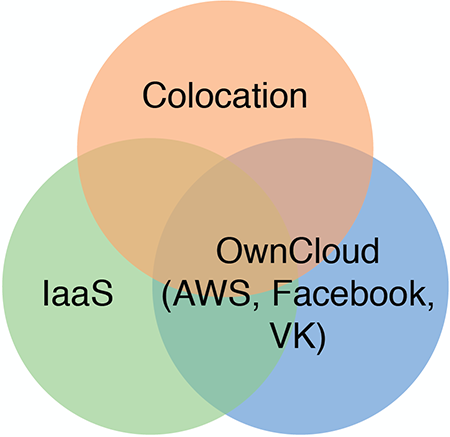

На рынке услуг ЦОД, — если оценивать грубо, — присутствуют три основных сегмента. Это во-первых, колокейшн, далее инфраструктура IaaS — выделенные серверы плюс облачное хранилище, и третий сегмент — облачные серверы (VPC, VPS, VMware Cloud), включая публичные, приватные и гибридные облака.

Каким бы удивительным это ни казалось, но клиенты каждого из сегментов предъявляют разные требования к климатическим системам. Наиболее требовательны клиенты, размещающие в дата-центре свое собственное оборудование (колокейшн). Среди них много IT-руководителей с многолетней практикой и консервативным представлением о том, какая температура должна быть в серверных залах. Еще 10-15 лет назад требование обеспечить +18°C в холодном коридоре было действительно критически важным. Но современные серверы и СХД стабильно работают до температуры +27°C.

К слову, конкретный диапазон температуры воздуха для серверных помещений ЦОД довольно строго регламентирован рекомендациями ASHRAE (Американское общество инженеров по отоплению, охлаждению и кондиционированию воздуха), которыми руководствуются во всем мире, включая Россию. Рекомендованный диапазон температур со временем меняется, где-то в начале 2000-х годов это, действительно, было 16-20°C, затем 18-22°C, а сегодня рекомендованная температура воздуха для охлаждения серверов уже 20-27°C.

Selectel в своих дата-центрах стремится поддерживать температуру воздуха у нижней границы рекомендованного диапазона по ASHRAE, в среднем порядка 23°C

отметил для статьи Кирилл Малеванов, технический директор Selectel

Какой из этого можно сделать вывод для бизнеса дата-центра? Использовать дорогостоящее охлаждение с помощью кондиционеров следует преимущественно для серверных залов, выделенных под услугу колокейшн. Соответственно, для серверных залов под услуги IaaS и тем более для облачных серверов можно применять оборудование, которое максимально эффективно использует охлаждение за счет окружающей среды — вплоть до простого обдува серверов забортным воздухом.

При этом, поскольку Selectel владеет несколькими дата-центрами, причем в разных регионах, появляется свобода маневра. Иными словами, можно еще на стадии проектирования, строительства ЦОД и выбора климатического оборудования учитывать требования к охлаждению в выбранном сегменте услуг. И позже в процессе эксплуатации проводить модернизацию климатических систем с учетом снижения ТСО при предоставлении именно этих услуг.

Что такое PUE

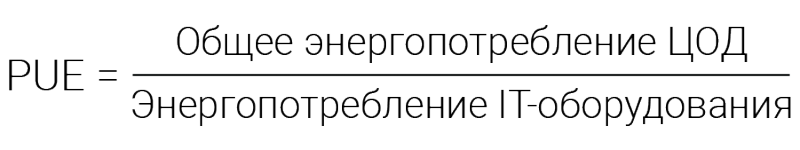

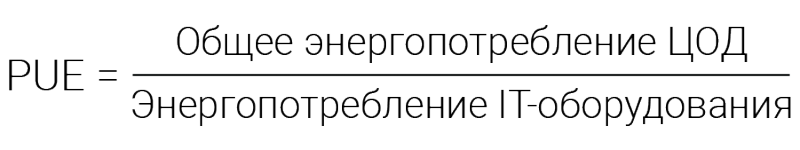

Основным показателем эффективности ЦОД является коэффициент эффективности использования энергии (Power usage effectiveness, PUE), используемый в индустрии ЦОД с 2007 года. Что же из себя представляет этот коэффициент:

Иными словами, чем ближе PUE к 1, тем более совершенным является дата-центр. Однако, значения 1.0 достичь в принципе невозможно, поскольку это соответствует уровню энергоэффективности вечного двигателя. К слову, с полным определением термина PUE можно ознакомиться в документе

PUE, A Comprehensive Examination of the Metric (PDF).

На практике превосходными считаются значения PUE, лежащие на уровне 1.10 – 1.15. К примеру, согласно публикациям, для дата-центров Google значение PUE, усредненное по всем ЦОД в разных регионах и в разное время года, составляет 1.12.

Далее, познакомимся подробнее с системами охлаждения в отдельных дата-центрах Selectel.

«Цветочная 1» — фреон

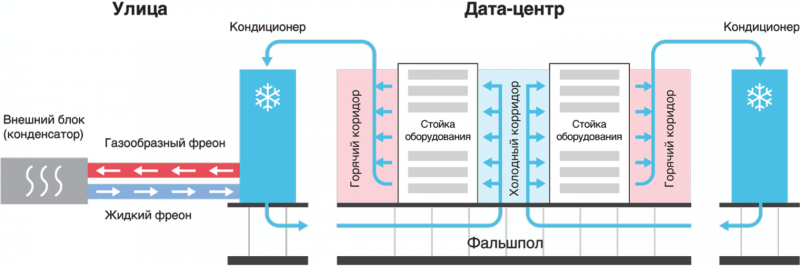

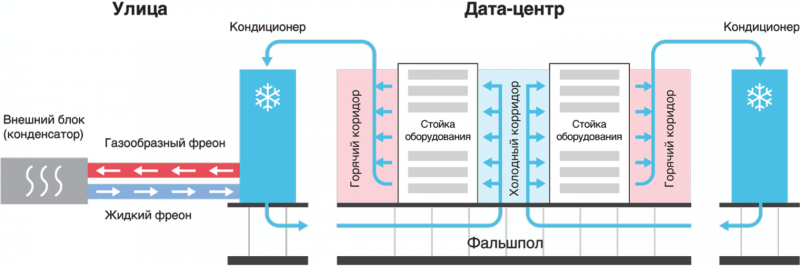

Первый дата-центр «Цветочная 1» был запущен в эксплуатацию в 2008 году, когда услуга колокейшн была доминирующей на рынке. Кроме того, это центр Петербурга — со свободными площадями ситуация тогда была несколько стесненная. Соответственно, в дата-центре «Цветочная 1» были установлены классические промышленные кондиционеры для ЦОД на фреоне, которые работают до настоящего времени.

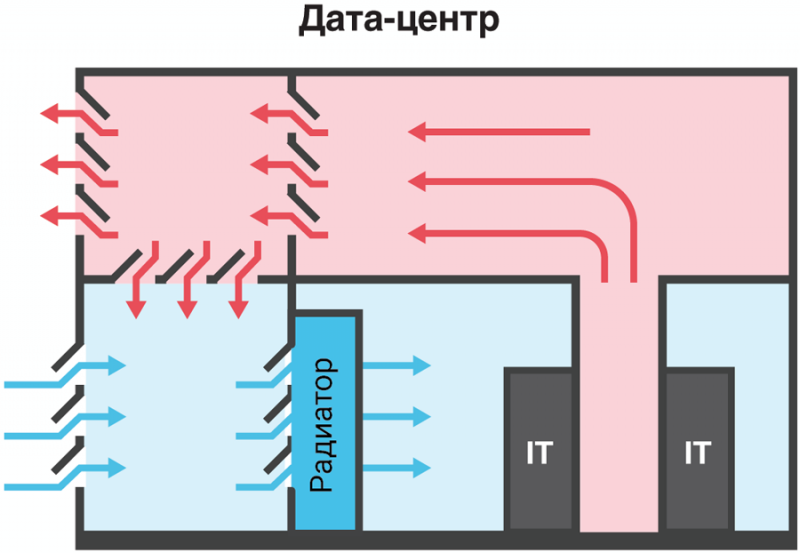

Принцип работы такого кондиционера основан на переходе фреона в различные агрегатные состояния. Холодный воздух под фальшполом подается в так называемые «холодные коридоры» с вычислительным оборудованием, а нагретый воздух уходит в серверный зал (в «горячие коридоры»), откуда опять засасывается в теплообменник кондиционера, охлаждается и вновь подается к серверам и СХД.

КПД классического кондиционера оставляет желать лучшего, и поэтому коэффициент эффективности использования энергии для дата-центра «Цветочная 1» по современным меркам довольно высок, PUE=1.7. Но учитывая, что здесь предоставляются услуги колокейшн, с таким положением вполне можно смириться до момента кардинальной модернизации всего ЦОД.

«Дубровка 1», «Берзарина 1», «Цветочная 2» — чиллеры

«Дубровка 1», «Берзарина 1», «Цветочная 2» — чиллеры

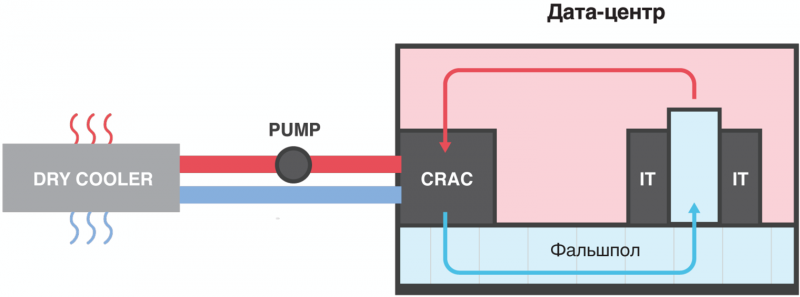

Следующую технологию охлаждения в Selectel опробовали в 2010 году, когда построили ЦОД «Дубровка 1» в поселке Дубровка Ленинградской области. В нем впервые в практике компании была применена чиллерная система охлаждения.

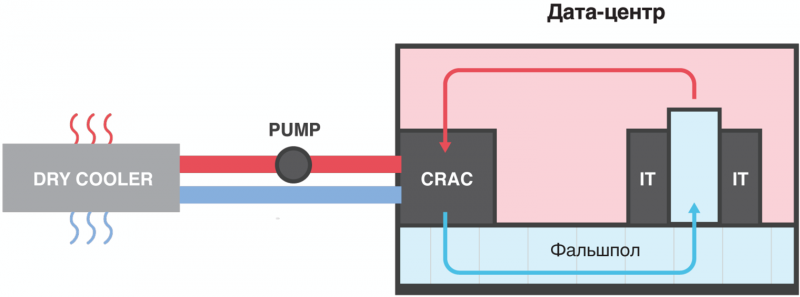

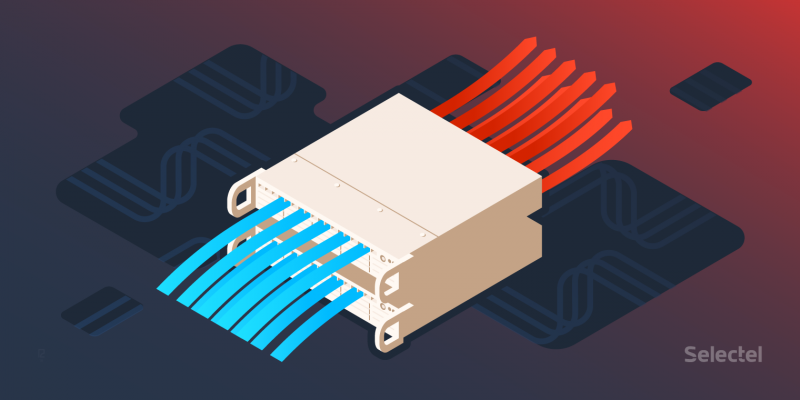

Отличие чиллерной системы от фреоновых кондиционеров состоит в том, что в трубопроводах между внутренними и внешними блоками циркулирует незамерзающий гликолевый раствор, который остается все время жидким и в газообразное состояние не переходит. Раствор прогоняется насосом через кондиционер в серверном зале, где нагревается от горячего радиатора кондиционера и откуда выкачивается в выносной наружный теплообменник, называемый чиллером.

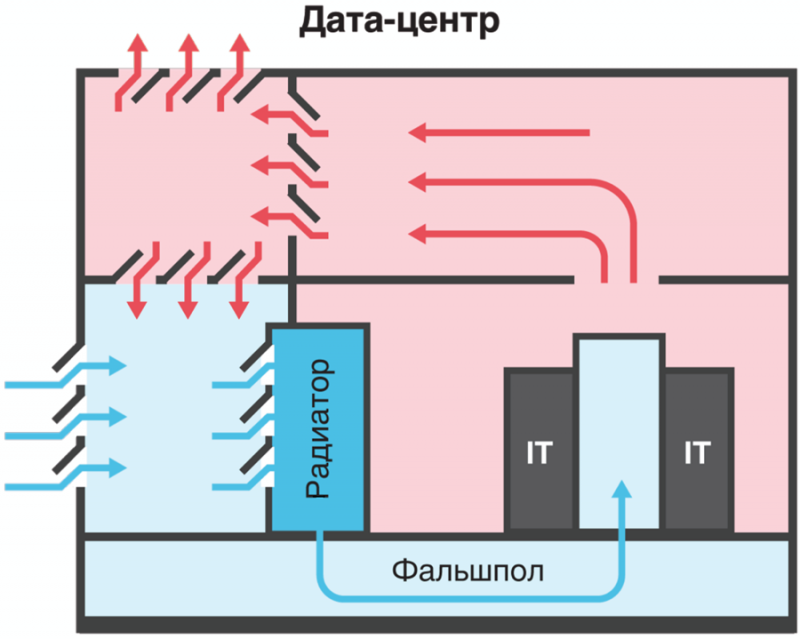

В чиллере гликолевый раствор охлаждается с помощью наружного воздуха и дополнительного компрессорно-конденсаторного блока. Затем уже охлажденный гликолевый раствор вновь подается в кондиционер внутри серверного помещения дата-центра. При этом охлаждение вычислительного оборудования происходит по традиционной схеме — холодный воздух подается снизу через фальшпол в «холодные коридоры», а горячий — уходит в общий зал и далее в теплообменник.

Схема с холодными и горячими коридорами дает до 5% экономии электроэнергии, поэтому так важно провести изоляцию холодного и горячего воздушных бассейнов (коридоров и накопителей воздуха).

Энергоэффективность чиллерной схемы выше в сравнении с кондиционерами, и это объясняется тем, что внешний компрессорно-конденсаторный блок чиллера включается в работу лишь при температурах окружающей среды выше +12°C, причем вентиляторы внешнего блока включаются постепенно, по мере роста температуры гликолевого теплоносителя. Это очень похоже на то, как работает система охлаждения двигателя обычного автомобиля.

По чиллерной схеме в Selectel построено охлаждение трех дата-центров — «Дубровка 1» (2010 год), «Берзарина 1» (2011 год) и «Цветочная 2» (2015 год). В случае с ЦОД «Цветочная 2» был учтен опыт эксплуатации, накопленный за 5 лет работы ЦОД «Дубровка 1» в части многочисленных нюансов обслуживания. Как оказалось, несмотря на внешнюю простоту принципа действия, численная система довольно капризна в работе и требует внимательного обслуживания и соблюдения регламентов. Более подробно о работе чиллерной системы в дата-центре «Берзарина 1» читайте в нашей предыдущей статье.

«Дубровка 3», «Берзарина 2» — фрикулинг

«Дубровка 3», «Берзарина 2» — фрикулинг

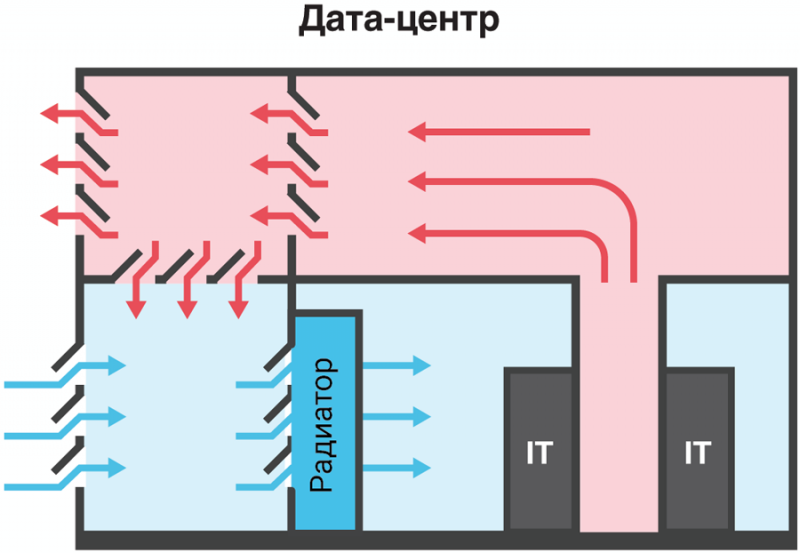

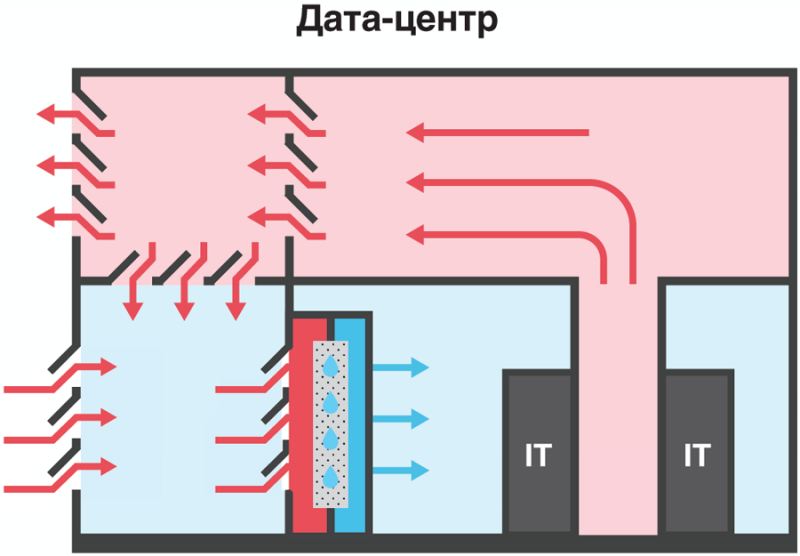

Следующий шаг в повышении энергоэффективности систем охлаждения был сделан в Selectel при переходе к схеме прямого фрикулинга. Принцип действия классического прямого фрикулинга заключается в отказе от теплообменников, и охлаждение вычислительного оборудования происходит за счет обдува с помощью забортного воздуха.

Забортный воздух проходит через фильтры, где очищается от пыли, и далее поступает в машинный зал. В зимнее время по мере необходимости холодный воздух предварительно «разбавляется» теплым воздухом от серверов в камере смешения для поддержания постоянной температуры обдува оборудования.

Как уже говорилось выше, современные серверы и СХД надежно работают при температурах в холодных коридорах до +27°C. Учитывая климат Ленинградской области, где многолетняя среднесуточная температура даже в июле находится у отметки +20°C, такое решение казалось вполне работоспособным. Однако, учитывая температурный рекорд +37.8°C, зафиксированный в Ленинградской области в 2010 году, полагаться только на милость природы было нельзя. Кстати, «горячее лето 2018 года» подтвердило правоту этих расчетов.

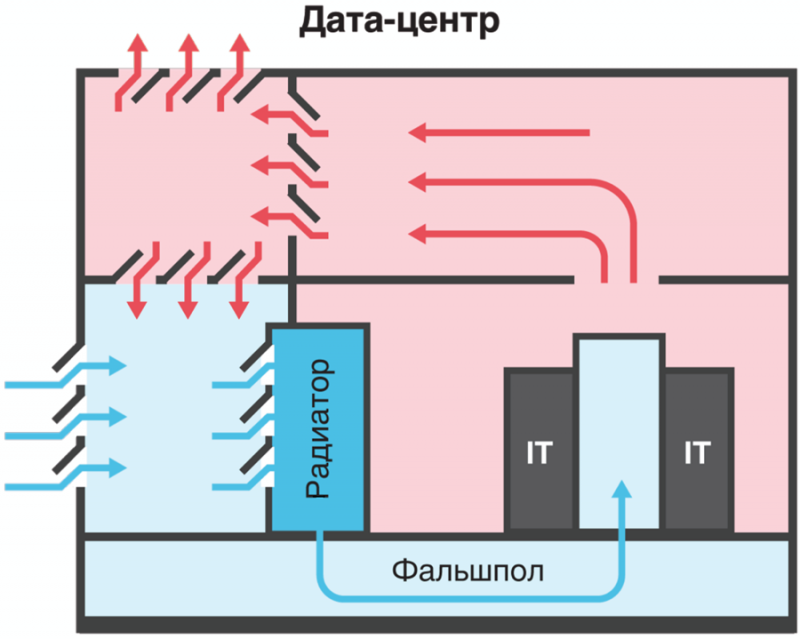

Соответственно, в дата-центре «Дубровка 3», введенном в эксплуатацию в 2013 году, используется прямой фрикулинг с блоком дополнительного охлаждения (АБХМ, абсорбционная холодильная машина) на случай летней жары. Забортный воздух проходит через фильтры и далее проходит через теплообменник АБХМ. В холодные коридоры серверного зала воздух подается под фальшполом.

Как показал опыт эксплуатации, такое решение работает без включения АБХМ до температуры окружающей среды +21°C, что практически означает, что АБХМ функционирует только в летние месяцы. Таким образом, это достаточно энергоэффективное решение с PUE ~1.25.

Важным преимуществом АБХМ является экологическая безопасность, так как она работает на обычной воде без использования фреона. Среди недостатков АБХМ — гигантские внешние теплообменники, но учитывая размещение дата-центра «Дубровка 3» практически в чистом поле, это не играет особой роли с точки зрения размера площадей под оборудование АБХМ.

С 2013 года схема прямого фрикулинга с доохлаждением показала свою высокую эффективность и будет вновь реализована в строящемся дата-центре «Берзарина 2» в Москве. Однако ввиду ограниченного пространства, блок доохлаждения будет реализован с помощью адиабатической системы.

Пара слов о резервировании

Традиционно, системы охлаждения в дата-центрах уровня Tier III резервируются по схеме не ниже N+1. Это значит, что в запасе всегда должна быть как минимум одна установка охлаждения, которая вводится в действие при аварии или ремонте (плановом обслуживании) одной из задействованных систем. Так, в дата-центре «Дубровка 1» используется 4 вентиляционных машины для фрикулинга при потребности в 3-х, а в ЦОД «Дубровка 3» — три машины АБХМ, из которых одна машина выключена и находится в резерве, подготовленная к запуску.

К слову, Selectel в своих дата-центрах стремится по возможности ужесточить требование резервирования N+1, и иметь в запасе не одну, а две резервных системы охлаждения. К примеру, в ЦОД «Цветочная 1» и «Цветочная 2» имеется по 2 резервных кондиционера и чиллера, соответственно.

«Берзарина 2» — вскоре в строю

«Берзарина 2» — вскоре в строю

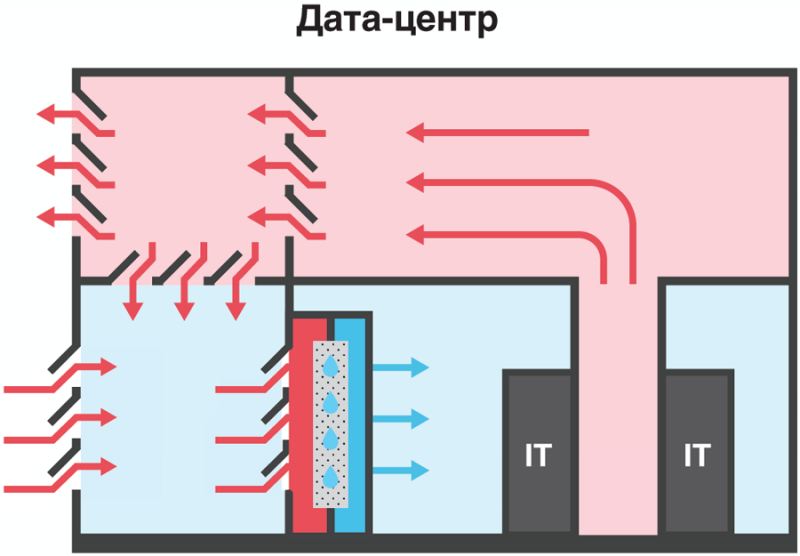

В ноябре 2018 года в эксплуатацию вводится новый дата-центр «Берзарина 2» в Москве, где впервые в практике компании будет применена схема фрикулинга с доохлаждением с помощью адиабатической системы. Если забортный воздух слишком теплый, — а температура в Москве в летнее время часто превышает 23°C, — то включается система адиабатического охлаждения.

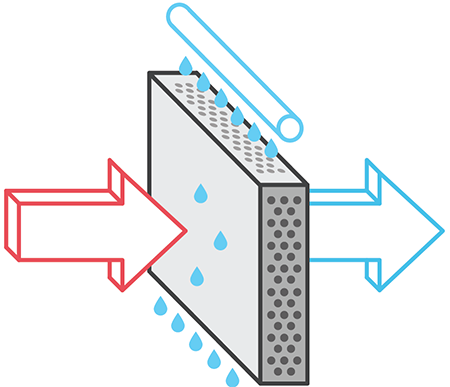

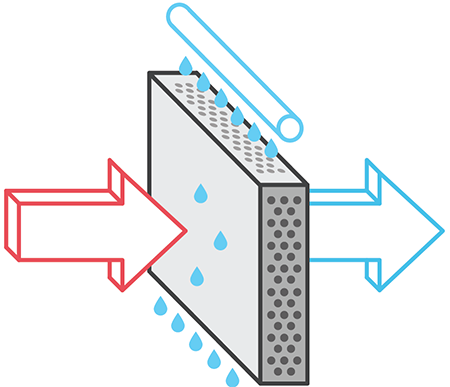

Технология адиабатического охлаждения построена на распылении воды в виде мельчайших капель на пути воздушного потока, что позволяет охлаждать воздух за счет испарения воды. При использовании увлажнителей воздуха распылительного типа затраты электроэнергии на сам процесс охлаждения невелики, сравнительно с другими системами охлаждения. Сложная ячеистая структура смачиваемой преграды на пути подаваемого воздуха не позволяет микрокаплям воды попадать дальше в воздуховоды ЦОД. При этом уровень влажности остается в пределах допустимых значений для IT-оборудования.

В мире много интересных решений по системам охлаждения, которые позволяют экономить электроэнергию. Однако все новинки попробовать невозможно — требуется получить финансирование, провести проектирование, затем выполнить закупку оборудования, подготовку и ввод техники в эксплуатацию. Стадии поставки, монтажа, настройки и обкатки — это все очень продолжительные процедуры. Поэтому климатические системы после запуска работают минимум десятилетие и редко кардинально модернизируются в процессе эксплуатации уже построенного ЦОД. А интересные новинки приходят уже в новый ЦОД, в котором они прослужат свои 10-15 лет

подвел итог Кирилл Малеванов, технический директор Selectel.