05.12.2025 ГК Key Point представила вторую очередь дата-центра в Новосибирске

05.12.2025 ГК Key Point представила вторую очередь дата-центра в Новосибирске

3 декабря в Новосибирске прошла презентация второй очереди дата-центра ГК Key Point.

В рамках презентации генеральный директор управляющей компании «Кей Поинт Менеджмент» Сергей Рубцов рассказал гостям про сеть ГК Key Point и технические особенности ЦОДа в Новосибирске. Для гостей была организована экскурсия по дата-центру, на которой участники смогли посмотреть техническое оснащение ЦОДа, а также оценить масштаб, надежность и современность инженерных решений.

Емкость второй очереди дата центра ГК Key Point Новосибирск составляет 440 ИТ-стоек мощностью 7 кВт каждая. В сумме ЦОД рассчитан на размещение 880 коммерческих стоек, а его общая проектная мощность составляет 11 МВт. Дата-центр соответствует всем международным требованиям к обеспечению стабильной работы базовой цифровой инфраструктуры и прошёл двухступенчатую сертификацию Uptime Institute по уровню надёжности Tier III.

ЦОД ГК Key Point Новосибирск является крупнейшим коммерческим дата-центром в Сибири. Строительство велось по модульной технологии с использованием собственных префаб-решений. Инженерная инфраструктура построена с многоуровневым резервированием — по схеме 4/3N для энергоснабжения и N+1 для систем охлаждения, что обеспечивает высокую отказоустойчивость и возможность размещения высоконагруженных стоек до 20 кВт. Дата-центр также оснащён комплексом энергетических, климатических и сервисных решений, позволяющих обеспечивать непрерывную работу 24/7/365.

«Сегодня клиентам важна не просто стойка и мощность — им нужна устойчивая инфраструктура, понятные стандарты эксплуатации, возможность развития и гарантированная связность. Новый Новосибирский ЦОД отвечает этим требованиям: на объекте есть доступ к услугам девяти операторов связи», — отметил Сергей Рубцов.

04.12.2025 ГК Key Point приняла участие в форуме «ЦОД: модели, сервисы, инфраструктура» в Екатеринбурге

В конце ноября ГК Key Point традиционно приняла участие в форуме «ЦОД: модели, сервисы, инфраструктура» в Екатеринбурге. Мероприятие, посвященное развитию дата-центров и облачных технологий на Урале, организовал медиахолдинг ИКС Медиа.

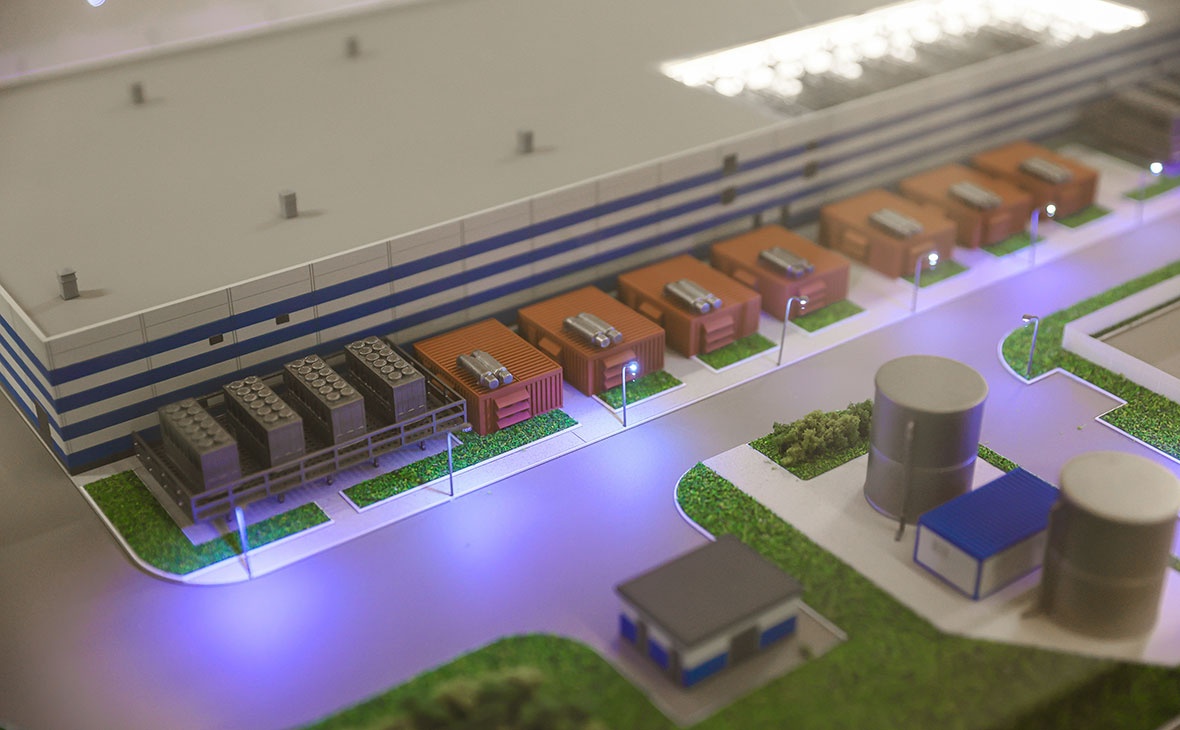

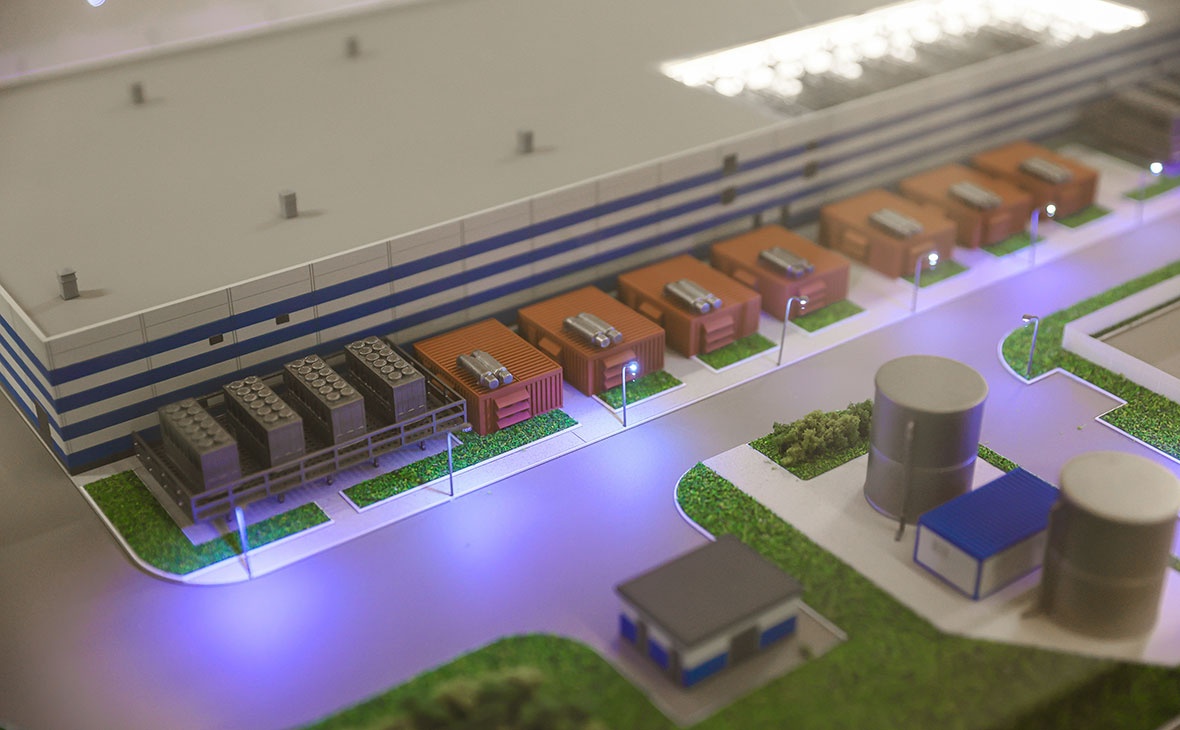

На стенде компании гости могли ознакомиться с детальным макетом будущего ЦОДа в Екатеринбурге и посетить объекты региональной сети в формате виртуальной экскурсии.

В рамках пленарной части форума основатель ГК Key Point и генеральный директор «Свободные Технологии Инжиниринг» Евгений Вирцер рассказал о текущих проектах и планах по расширению сети ЦОД. Особое внимание было уделено дата-центру в Екатеринбурге, открытие которого запланировано на I квартал 2026 года. После ввода в эксплуатацию он станет крупнейшим коммерческим ЦОДом в Уральском федеральном округе. Объект будет сертифицирован по стандартам отказоустойчивости Tier III и станет частью единой георезервируемой сети ЦОД, включающей действующие объекты во Владивостоке и Новосибирске, а также проекты в Санкт-Петербурге, Дагестане и других городах. Кроме того, были обозначены принципы стандартизированной эксплуатации, обеспечивающие единый уровень качества на всех площадках. Евгений Вирцер подчеркнул важность распределенности инфраструктуры и ее масштабируемости — как для самой сети ЦОД, так и для клиентов, которым требуется предсказуемое расширение ресурсов.

«Рынок сегодня нуждается в современных центрах обработки данных, способных обеспечить стабильность, масштабируемость и высокие стандарты эксплуатации. Новый ЦОД в Екатеринбурге создается именно как ответ на эти запросы», — подчеркнул Евгений Вирцер.

Константин Нагорный, заместитель директора по управлению эксплуатацией ГК Key Point, поделился опытом совмещения лучших мировых практик эксплуатации ЦОД и требований норм, действующих в РФ. Он рассказал, какие классы эксплуатации ЦОД выделяются в классификации и почему они не зависят от классов инфраструктуры ЦОД. По словам Константина, четкие и понятные правила эксплуатации для сотрудников напрямую влияют на минимизацию вероятности ошибок. Использование отечественной модели классификации позволяет создать современную и эффективную систему эксплуатации, которая поможет и операторам ЦОД, и клиентам.

01.12.2025 Интервью Евгения Вирцера «Арифметика ЦОДостроения»

В Санкт-Петербурге анонсировано строительство первого на Северо-Западе дата-центра уровня надежности Tier IV. Инициатор и инвестор проекта — ГК Key Point — отмечает, что объект станет новым стандартом отказоустойчивости для цифровой инфраструктуры региона. О том, как развивается базовая IT-инфраструктура в Северной столице и других регионах, какие вызовы стоят перед отраслью в интервью рассказал Евгений Вирцер, генеральный директор «Свободные Технологии Инжиниринг» и основатель ГК Key Point.

Санкт-Петербург стал очередным пунктом в расширении сети Key Point после Владивостока, Новосибирска и Екатеринбурга. Почему выход на Северо-Западный рынок происходит именно сейчас?

ЕВГЕНИЙ ВИРЦЕР: Мы давно присматривались к рынку Северо-Запада. За последние пару лет здесь сформировался устойчивый дефицит стойко-мест, поэтому выход логичен. Однако масштаб задачи оказался значительным на фоне наших стандартных региональных проектов. Изначальное решение созрело примерно год назад. За это время был проведен целый фронт невидимой работы — от приобретения участка до согласования всех условий. Сейчас мы наконец расставили точки над i и потому официально объявляем о старте начала работ.

Как бы вы охарактеризовали текущий уровень развития цифровой инфраструктуры Санкт-Петербурга? В чем заключается преимущество будущего ЦОД?

Е.В.: Мы не проводили отдельной оценки цифровой инфраструктуры Петербурга, однако, полагаю, ее уровень соответствует общероссийскому — с поправкой на то, что это второй по величине и деловой активности город страны. Безусловно, как и в любом другом регионе, здесь есть свои сложности с инфраструктурой, но так или иначе они постепенно решаются. При этом дефицит мощностей наблюдается по всей стране уже лет пять-шесть и пока не снижается.

Существующие в Петербурге дата-центры практически полностью заполнены, а новых строек не так много. Наш объект будет крупным: общей мощностью 20 МВт, рассчитан на 1626 IT-стоек. Абсолютно точно это будет первый в Санкт-Петербурге объект уровня надежности Tier IV по классификации Uptime Institute. Отдельное преимущество — это наша команда эксплуатации из Key Point, хорошо известные люди в отрасли ЦОД, в том числе в Санкт-Петербурге.

Что в большей степени диктует широкую географию присутствия Key Point: прямой запрос из регионов или ваша опережающая стратегия формирования цифровой инфраструктуры страны?

Е. В.: Это комбинация двух факторов. Готового спроса в виде предварительных договоров пока нет — для серьезных контрактов клиентам нужны четкие сроки и технические параметры. Гарантировать их, не имея площадки и не решив вопросы с электроснабжением, невозможно.

Поэтому мы действуем по иной логике: ориентируемся на столицы федеральных округов как центры деловой активности с высоким спросом на инфраструктуру. Мы приходим туда, где ЦОД объективно нужен: где сосредоточена активность бизнеса и государства. Именно она и является главным драйвером.

Кто ваши ключевые клиенты в регионах?

Е. В.: Основной вектор смещается в сторону крупных федеральных компаний или очень значимых локальных. Значительный процент — это клиенты из числа операторов связи. Причем сами операторы бывают разные: и федеральные, и локальные, которые, в свою очередь, приходят к нам со своими клиентами — теми, кому они оказывают услуги связи и облачные сервисы. Также представлены банки, ритейл, промышленность. На самом деле, мы сегодня прекрасно понимаем, что цифровая инфраструктура стала неотъемлемой частью любого предприятия, любого бизнеса. Поэтому, так или иначе, за исключением, пожалуй, совсем уж закрытых секретных проектов, в целом у нас представлены все отрасли экономики.

Сталкиваетесь ли вы с дефицитом энергомощностей при реализации проектов и как решаете эти задачи?

Е. В.: Все площадки, которые у нас сегодня либо уже реализованы, либо находятся в процессе разработки, полностью обеспечены электроэнергией в необходимом объеме — даже с некоторым запасом. Что касается Санкт-Петербурга… Не могу сказать, что нам пришлось пройти там какой-то особый путь. Пока мы не сталкивались с непреодолимыми препятствиями. В Москве, кстати, получить энергоснабжение необходимой мощности тоже непростая задача.

Вопрос импортозамещения остается критическим. На каких компонентах ЦОД доля российского оборудования уже является значимой, а где сохраняется наиболее острая зависимость?

Е. В.: Для нас ЦОД — это в первую очередь объект инженерной инфраструктуры. Мы прекрасно понимаем, что дефицит, связанный с импортозамещением, острее стоит в IT-сфере: серверное и сетевое оборудование, программное обеспечение — здесь, на наш взгляд, вопрос сложнее. Что касается нашей части — инженерных систем, то за эти три года, после смены географии поставщиков, вопрос в целом удалось решить. По каждой позиции — будь то генераторные установки, источники бесперебойного питания, чиллеры или системы кондиционирования — у нас уже сформировалась достаточно большая группа конкурентных производителей. Это российские, китайские, турецкие компании — в общем, страны, с которыми мы активно сотрудничаем. Так что на сегодняшний день мы не видим проблем с инженерными компонентами. Всегда, конечно, хочется лучшего, но жить можно.

Реализация таких проектов требует высококвалифицированных инженеров и техников. Сталкиваетесь ли вы с их нехваткой и что делаете для подготовки кадров?

Е. В.: Мне кажется, сейчас в принципе существует проблема с кадрами — неважно, инженеры это или другие специалисты. Безусловно, в нашей отрасли дефицит чувствуется, и, на наш взгляд, он не уменьшается. Более того, будет только расти. Причин несколько: рынок развивается, задач перед цодостроителями и операторами становится больше, появляются более сложные и крупные объекты, которые требуют высокой квалификации. Да, проблемы есть, и мы работаем над ними в нескольких направлениях: воспитываем сотрудников внутри коллектива, создаем привлекательные условия для работы молодых специалистов, а также сотрудничаем с разными учебными заведениями.

Кадры нужно подбирать заранее. Не получится найти и собрать полноценную команду для эксплуатации ЦОД за месяц до его запуска. У нас, например, были случаи, когда ключевые специалисты приходили к нам за полтора года до открытия объекта.

Как вы оцениваете недавние законодательные инициативы, такие как новый закон о ЦОД и создание отдельного ОКВЭД для отрасли?

Е. В.: На законодательном уровне наконец-то определили, что такое ЦОД. На мой взгляд, это первый важный шаг, но если за ним не последуют другие, скорее всего, окажется бесполезным. Отрасль нуждается в четкой регуляторике и, безусловно, в мерах поддержки. По сути, это должна быть некая база, чтобы отрасль могла жить по корректным и комфортным правилам и получать поддержку от государства в определенных вопросах.

Можете ли вы как-то влиять на эту динамику растущей стоимости стойко-мест?

Е. В.: Сдержать рост стоимости очень сложно. Специфика рынка коммерческих ЦОД такова, что 95% клиентов, которые уже разместились в дата-центре, оттуда не уезжают — переезд из одного ЦОД в другой очень сложен. Свободных мощностей в ЦОД, которые были построены в более благоприятных условиях — при более низких ставках и дешевых деньгах,— по сути, не осталось. Все доступные сегодня стойко-места находятся в дата-центрах, построенных в текущих реалиях. А любой инвестор, желающий вернуть вложения в разумный срок, вынужден устанавливать цену, которая не отодвигает порог окупаемости за грань целесообразности.

Таким образом, сдержать рост цен можно, только снизив финансовую нагрузку на инвестора на этапе реализации проекта.

Какие меры господдержки сейчас были бы наиболее эффективны?

Е. В.: Самая очевидная — это доступ к субсидированным кредитам. Проекты в нашей отрасли, во-первых, капиталоемкие, а во-вторых, достаточно длинные по времени реализации. Возврат инвестиций, по сути, начинается — в лучшем случае — только через три года после старта проекта, и то в зависимости от его масштабов.

Учитывая сегодняшнюю стоимость денег, это достаточно чувствительная и болезненная история. Более того, эта проблема продолжает усугубляться: многие инвестпроекты поставлены на паузу, уменьшены в масштабах или вовсе остановлены как раз из-за дороговизны финансирования. Таким образом, возможность получать субсидии, то есть кредиты на выгодных условиях, безусловно, сильно помогла бы становлению отрасли.

Все остальные механизмы — будь то льготное присоединение к электросетям или выделение земли,— на мой взгляд, во-первых, менее действенные, а во-вторых, более сложные с точки реализации.

У нас ведь достаточно примеров, когда другие отрасли успешно развивались именно благодаря целевым государственным кредитам. Мы надеемся, что внимание наконец обратят и на нас, и это позволит развиваться более интенсивно и в конечном счете закрыть нарастающий дефицит мощностей.

14.11.2025 Эксперты ГК Key Point выступили с серией лекций «Нормативная база и стандарты ЦОД»

23–24 октября на базе АНО КС ЦОД прошли учебные курсы, посвященные нормативной базе и стандартам центров обработки данных. Сотрудники ГК Key Point представили серию лекций на эту тему.

Роман Вышинский, руководитель проектного направления ГК Key Point, в ходе своей лекции представил структуру нормативной системы в области проектирования ЦОД, рассказал о требованиях первого специализированного свода правил для ЦОД, и объяснил, как сочетать российские и международные стандарты, не нарушая требований законодательства.

Константин Нагорный, заместитель директора по управлению эксплуатацией ГК Key Point, представил разработанную методику оценки уровня эксплуатации ЦОД, основанную на лучших международных практиках и адаптированную под российские реалии.

Тарас Чирков, директор по управлению эксплуатацией ГК Key Point, рассказал в своей лекции о ключевых стандартах, применяемых в мировой практике, сравнил их подходы к операционной устойчивости и зрелости процессов, а также показал, как эти модели могут быть использованы для совершенствования российских систем эксплуатации.

13.11.2025 ГК Key Point объявила о начале строительства нового дата-центра в Санкт-Петербурге

Группа компаний Key Point начинает строительство нового коммерческого центра обработки данных в Санкт-Петербурге. Первый в пределах города дата-центр такого масштаба появится на улице Прокофьева, 10. Будущий объект станет крупнейшей площадкой для колокейшн в Санкт-Петербурге и во всем Северо-Западном федеральном округе. Он войдет в состав сети ЦОД ГК Key Point, объединяющей разные регионы России.

Проект дата-центра общей мощностью 20 МВт рассчитан на 1626 ИТ-стоек. Запуск в эксплуатацию первой очереди общей мощностью 5 МВт и емкостью 330 ИТ-стоек средней мощностью 8 кВт каждая планируется на I квартал 2027 года. Первая очередь будет сертифицирована по уровню надежности Tier III согласно классификации Uptime Institute.

Вторая и третья очереди ЦОД, рассчитанные на 1296 стоек общей мощностью 15 МВт, будут введены в эксплуатацию в III квартале 2027 года и II квартале 2028 года соответственно. Они будут сертифицированы по уровню Tier IV — максимальному уровню отказоустойчивости по классификации Uptime Institute. Петербургский объект станет первым дата-центром уровня Tier IV в Северо-Западном регионе.

EPC-подрядчиком проекта выступает компания «Свободные Технологии Инжиниринг» — один из лидеров рынка проектирования и строительства центров обработки данных в России.

«Потребность в современной цифровой инфраструктуре в Санкт-Петербурге с каждым годом только растет. Новый надежный ЦОД станет опорой для цифровой экономики всего Северо-Западного региона. Начало строительства дата-центра в Санкт-Петербурге — очередной шаг в реализации программы по развитию нашей сети ЦОД», — отметил Евгений Вирцер, основатель ГК Key Point.

Директор по управлению эксплуатацией ГК Key Point Тарас Чирков подчеркнул: «Этот ЦОД станет не просто первым в городе, но и самым крупным дата-центром, отвечающим всем ключевым потребностям потенциальных клиентов. Мы предусмотрели все: от масштаба и наивысшего уровня надежности Tier IV до удобной транспортной доступности, позволяющей добраться до ЦОДа общественным транспортом. Кроме того, команда по эксплуатации состоит из высококвалифицированных экспертов, являющихся авторами руководства по эксплуатации и разработчиками российской модели классификации ЦОД. Для нас это проект, в котором реализуются лучшие практики и собственные инженерные стандарты ГК Key Point».

01.11.2025 ГК Key Point приняла участие в Каспийском цифровом форуме

30–31 октября в Дагестане состоялся Каспийский цифровой форум — ключевая площадка для развития делового и технологического диалога между Россией и странами Каспийского региона. В центре внимания участников были вопросы формирования единой цифровой экосистемы, повышения устойчивости экономики и внедрения инновационных технологий.

Группа компаний Key Point анонсировала на форуме новый центр обработки данных в Дагестане, запланированный к вводу в эксплуатацию в конце 2026 года, а также рассказала о других объектах региональной сети дата-центров.

В рамках деловой программы генеральный директор компании «Кей Поинт Менеджмент», управляющей компании ГК Key Point, Сергей Рубцов раскрыл тему центра обработки данных как основы ИТ-инфраструктуры региона. По итогам сессии компания предложила конкретные инициативы для включения в резолюцию форума: использование ЦОД в Дагестане для размещения сервисов цифровой транспортной платформы и обработки электронных перевозочных документов, а также создание сети модульных ЦОД вблизи ключевых транспортных узлов для ускорения реализации проекта транспортного коридора «Север-Юг».

31.10.2025 ГК Key Point построит новый дата-центр в Дагестане

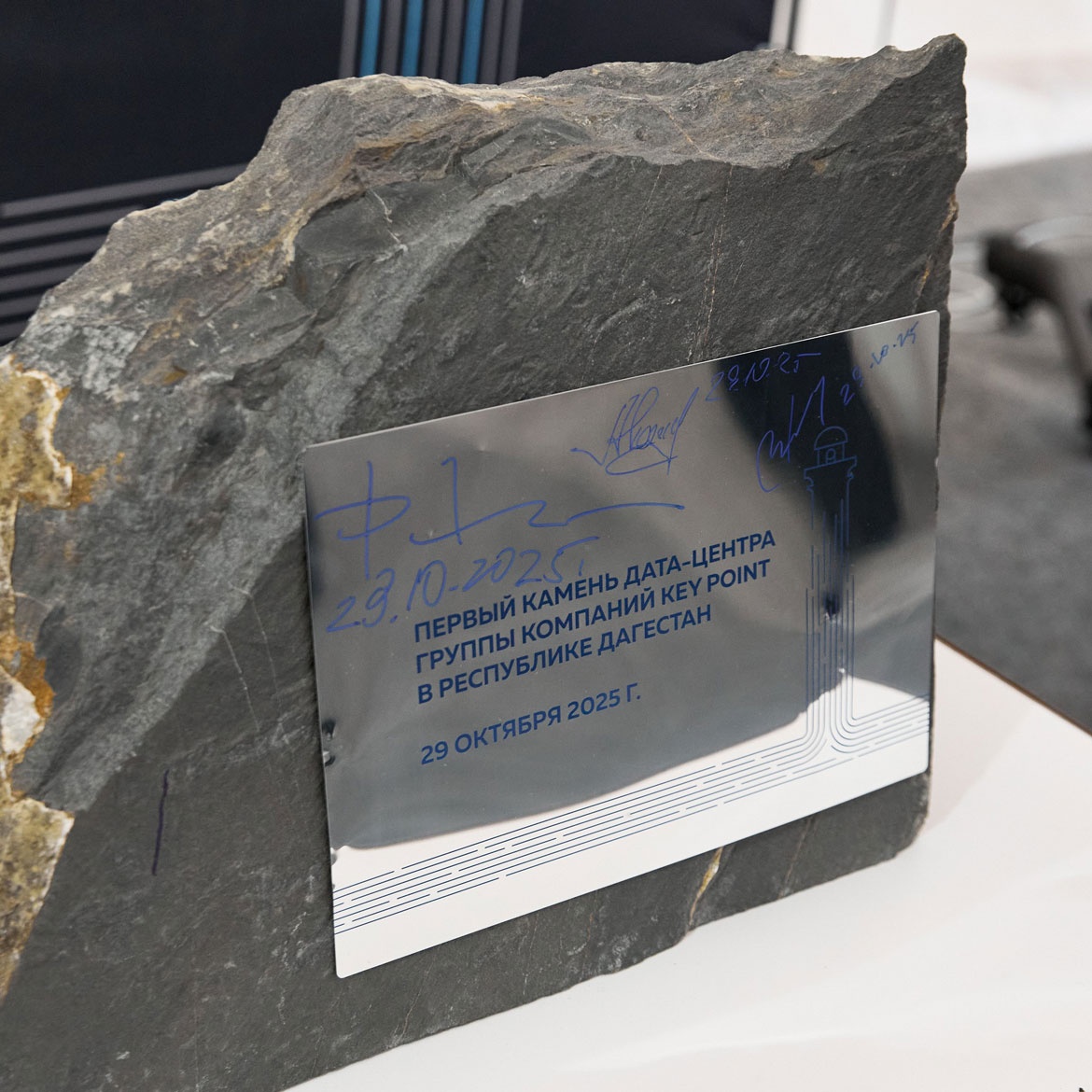

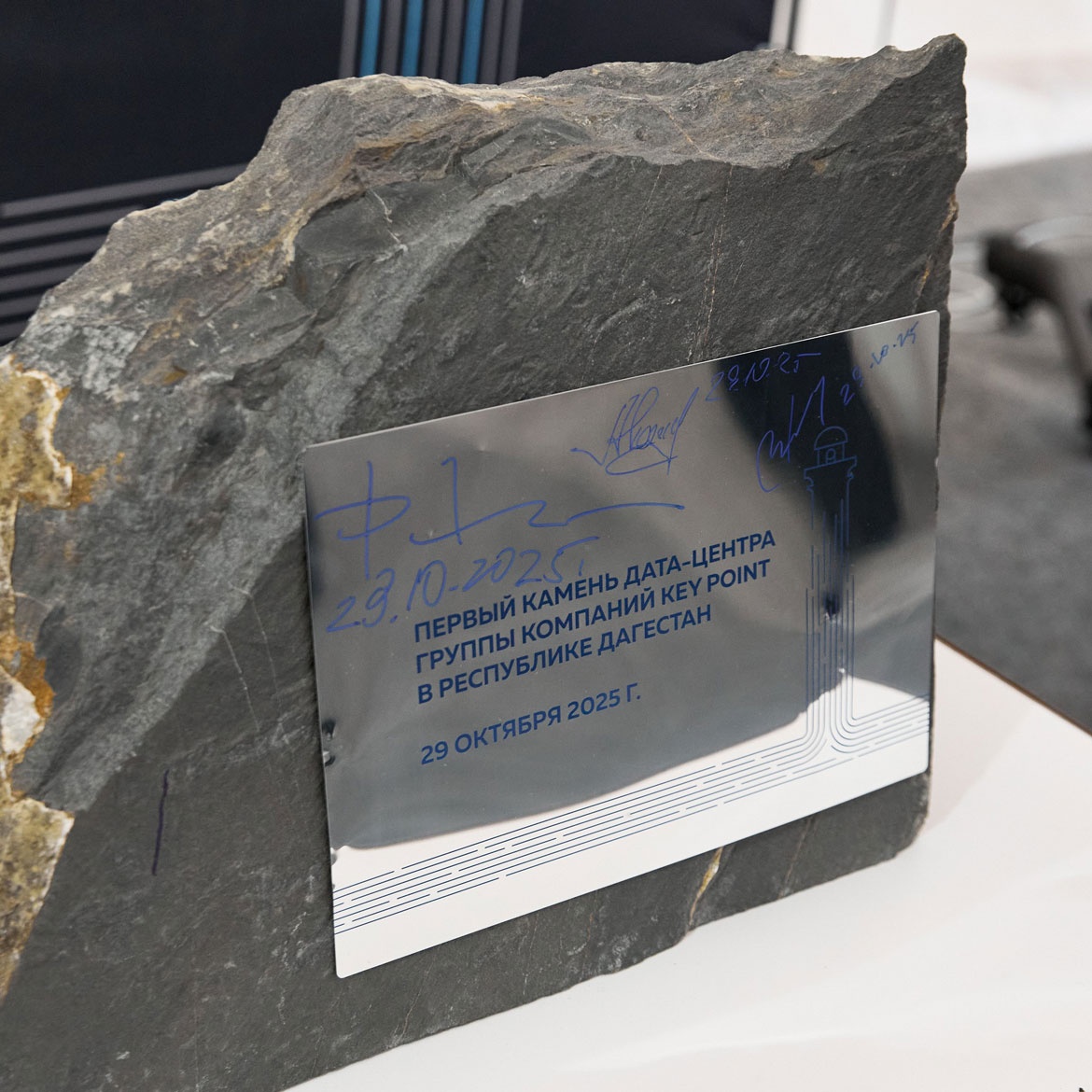

29 октября в Хасавюртовском районе Дагестана состоялась церемония закладки первого камня нового коммерческого центра обработки данных ГК Key Point в Дагестане. Мероприятие стало официальным стартом строительных работ. Планируется, что первая очередь ЦОД будет запущена в IV квартале 2026 года. Будущий дата-центр, как и все дата-центры ГК Key Point, пройдет двухступенчатую сертификацию Uptime Institute на уровень надежности Tier III.

Генеральным подрядчиком и генеральным проектировщиком объекта является компания «Свободные Технологии Инжиниринг» — один из лидеров в области проектирования и строительства дата-центров в России. Партнером проекта выступает компания «Электросвязь» — ведущий оператор связи в регион.

Данный проект реализуется в рамках ранее анонсированной ГК Key Point программы по развитию региональной сети ЦОД. Создание дата-центра в Дагестане, расположенного на ключевой волоконно-оптической линии связи до трансграничного перехода, позволит не только размещать инфраструктуру для передовых цифровых сервисов и государственных проектов и обеспечить хранение большого объема данных, но и размещать специализированное телеком-оборудование наших партнеров-операторов для расширения каналов связи. Это многократно увеличит пропускную способность каналов связи на базе существующих ресурсов ВОЛС, превращая ЦОД в необходимый хаб для хранения и передачи трафика, в том числе ИТ-сервисов как в сторону России, так и для экспорта в страны Каспийского бассейна, такие как Иран, Армения и Грузия.

Строительство будет вестись в два этапа, что позволит гибко наращивать мощности. На первом этапе возведут административно-бытовой корпус и технологический модуль на 220 ИТ-стоек. На втором этапе будет построен дополнительный модуль такой же емкости.

В результате регион получит современную базовую инфраструктуру, соответствующую международным стандартам, для размещения вычислительных систем любого уровня. Финансирование проекта осуществляется за счет частных инвестиций.

Клиентами нового дата-центра станут телеком-операторы, интернет-провайдеры, ИТ- и сервисные компании, государственные, медицинские и образовательные учреждения, предприятия топливно-энергетического комплекса и финансового сектора, а также промышленные, транспортные, логистические и другие компании.

30.10.2025 Вторая очередь Дата-центра ГК Key Point в Новосибирске успешно прошла сертификацию института Uptime Institute и получила сертификат соответствия построенного объекта стандарту Tier III Constr

30.10.2025 Вторая очередь Дата-центра ГК Key Point в Новосибирске успешно прошла сертификацию института Uptime Institute и получила сертификат соответствия построенного объекта стандарту Tier III Constr

Испытания проведены с первой попытки и без замечаний, что подтверждает высокий уровень компетенций и профессионализма инженерной команды ГК СТ и специалистов ЦОДа ГК Key Point Новосибирск.

Объект общей мощностью 11 МВт и емкостью 880 ИТ-стоек реализован в две очереди и полностью введен в коммерческую эксплуатацию.

Поздравляет участников проекта технический директор «СТИ» Евгений Колосков:

«Успешно завершены процедуры сертификации второй очереди дата-центра в Новосибирске, проведённые по методологии и при участии специалистов Uptime Institute. Процесс на площадке занял рекордно короткое время для наших проектов — всего 2,5 дня. Огромная благодарность всей команде, принимавшей участие в строительстве ЦОДа, подготовке и проведении испытаний. Все — большие молодцы!»

Поздравляем проектную команду с успешно пройденной сертификацией!

02.10.2025 ГК Key Point приняла участие в форуме «Время цифровых перемен — Владивосток»

25 сентября во Владивостоке прошел форум «Время цифровых перемен». Директор по продажам Группы компаний Key Point, Денис Казачков принял участие в программе форума, представив стратегию развития региональной сети дата-центров ГК Key Point.

В своей презентации он отметил, что в современных условиях критически важно создание инфраструктуры георезервирования. По словам спикера, киберугрозы, атаки дронов, перебои в каналах связи и природные катастрофы делают распределение IT-нагрузки между географически разнесенными объектами не опцией, а необходимостью.

«Ключевая цель нашей стратегии — создание единой отказоустойчивой платформы, где клиенты могут гибко размещать рабочие нагрузки в разных географических точках, — подчеркнул Денис. — Это обеспечивает не просто резервирование на уровне оборудования, а полную непрерывность бизнес-процессов даже при реализации региональных сценариев сбоя. Такая архитектура соответствует строгим требованиям регуляторов и является высшим уровнем доверия для клиентов».

В качестве примера реализации этой стратегии спикер привел развертывание сети центров обработки данных в ключевых точках страны: от Владивостока до Санкт-Петербурга. Особое внимание уделяется созданию «цифровых близнецов» критически важных мощностей в Сибири и на Дальнем Востоке, что позволяет обеспечить кросс-региональное резервирование. Новосибирский ЦОД и объект во Владивостоке, сертифицированный Uptime Institute по уровню отказоустойчивости Tier III, становятся узлами этой распределенной системы.

Отдельно была отмечена кадровая экспертиза компании: команда ГК Key Point четыре раза проходила аттестацию M&O Stamp of Approval Uptime Institute — единственный подобный результат в России и СНГ, что гарантирует высокую надежность управления всеми объектами сети.

По мнению экспертов, развитая сеть георезервирования станет важным фактором развития цифровой экономики страны, обеспечивая бизнесу устойчивость, гибкость и доступ к современным IT-ресурсам вне зависимости от региона.

01.10.2025 С Днем работников отрасли ЦОД!

Поздравляем вас с профессиональным праздником — Днем работников отрасли ЦОД!

ГК Key Point стоит у истоков формирования геораспределенной сети дата-центров. ЦОДы во Владивостоке и Новосибирске уже стали фундаментом для будущего масштабного проекта. Впереди — строительство новых площадок в Екатеринбурге, Махачкале, Ростове-на-Дону, Санкт-Петербурге и Иркутске.

Мы вместе создаем инфраструктуру, которая обеспечит цифровую устойчивость бизнеса и государства на годы вперед. Каждый из вас вносит вклад в этот процесс: от проектирования и запуска оборудования до поддержки круглосуточной работы уже действующих ЦОДов.

Особая гордость — это наша команда. Благодаря вашему опыту и профессионализму мы уверенно реализуем проекты, которые изменят карту цифровой экономики страны.

Спасибо за ваш труд, вовлеченность и ответственность. Пусть впереди нас ждут новые победы, а каждый введенный в эксплуатацию объект станет доказательством силы нашей команды и важности дела, которым мы занимаемся!

30.09.2025 ГК Key Point представила региональную сеть ЦОД на Телекоммуникационном форуме «Восток» во Владивостоке

С 17 по 19 сентября во Владивостоке прошел Телекоммуникационный форум «Восток», объединивший ведущих представителей ИТ-индустрии для обсуждения актуальных вопросов развития отрасли. ГК Key Point приняла активное участие в мероприятии, представив свои проекты в сфере создания региональной сети центров обработки данных.

В рамках выставочной программы компания демонстрировала возможности современных ЦОДов, организовав для гостей виртуальные туры по дата-центрам во Владивостоке и Новосибирске.

Ключевым событием стало выступление директора по развитию ГК Key Point Дениса Карайланиди на сессии «Гибридная инфраструктура. Комплексная роль ЦОДов и операторов связи в её формировании». Денис подчеркнул важность создания георезервируемой инфраструктуры на базе сертифицированных ЦОД и партнерства с операторами связи.

«На примере недавнего аварийного отключения электричества во Владивостоке мы наглядно видим необходимость гибридных решений, — отметил Денис Карайланиди. — Наш дата-центр штатно перешел на дизельные генераторы, но клиенты без резервных каналов связи столкнулись с проблемами. Именно поэтому мы создаем распределенную сеть ЦОДов и сотрудничаем с ведущими операторами».

Спикер подробно рассказал о концепции гибридной инфраструктуры, которая объединяет возможности ЦОДов ГК Key Point в Екатеринбурге, Новосибирске и Владивостоке с услугами операторов связи и облачных провайдеров. Это позволяет клиентам реализовывать оптимальные отказоустойчивые решения с резервированием на всех уровнях.

Форум стал площадкой для профессионального диалога о ключевых трендах телекоммуникационной отрасли и выработки практических решений по построению в России распределенной ИТ-инфраструктуры.

17.09.2025 ГК Key Point приняла участие в юбилейном международном форуме «ЦОД-2025»

В начале сентября в Москве состоялся 20-й юбилейный международный форум «ЦОД-2025», организованный холдингом «ИКС-МЕДИА». ГК Key Point вошла в число ключевых участников мероприятия, собравшего более 2500 отраслевых специалистов в сфере дата-центров и облачных технологий.

Основатель ГК Key Point Евгений Вирцер принял участие в ключевой дискуссии «Путь длиной 20 лет: текущие отраслевые проблемы и перспективы». В ходе сессии представители министерств и отраслевые эксперты обсудили новый закон о ЦОДах, создание отдельного ОКВЭД для отрасли, а также меры государственной поддержки.

Заместитель министра Минпромторга РФ Михаил Иванов отметил устойчивый рост отечественной промышленности и возможности для развития производства оборудования для ЦОДов. Дмитрий Никитин, директор Департамента развития отрасли ИТ Минцифры РФ, подчеркнул: «Мы сделали большой рывок — закон принят, и это серьезная победа. Но на этом работа только начинается: нужно прорабатывать регулирование, прописывать регламенты и создавать понятные правила для всех игроков».

Основатель ГК Key Point Евгений Вирцер добавил: «Все мы заинтересованы в том, чтобы именно рынок коммерческих ЦОДов продолжал расти. Уже существуют определенные меры поддержки от государства, однако их получение требует очень больших усилий. Надеемся, что принятие нового закона поможет упростить эти процессы и даст рынку дополнительный импульс».

На стенде компании гости могли ознакомиться с уже реализованными и будущими проектами региональной сети дата-центров. Особый интерес вызвали детализированные макеты ЦОДов в Новосибирске и Владивостоке, а также возможность виртуального посещения этих объектов с помощью VR-технологий.

Во второй день форума выступил заместитель директора по управлению эксплуатацией Константин Нагорный, представивший отечественную модель классификации эксплуатации дата-центров. В своем выступлении он сделал главный акцент на том, что с помощью отечественной модели классификации возможно создание современной и эффективной системы эксплуатации, которая поможет и операторам ЦОД, и заказчикам: от подготовки к аттестациям и унификации процессов до повышения качества обслуживания и доверия клиентов. Константин поделился опытом совмещения лучших мировых практик эксплуатации ЦОД и требований норм, действующих в РФ, рассказал, какие классы эксплуатации ЦОД выделяются в классификации и почему они не зависят от классов инфраструктуры ЦОД. Константин Нагорный также выступил модератором секции «Проектирование, построение и эксплуатация. Системы мониторинга и управления».

Директор по управлению эксплуатацией Тарас Чирков представил концепцию DCM360 — комплексную модель управления ЦОД как услугой. В своем выступлении он подчеркнул ключевую мысль о критической важности раннего вовлечения эксплуатационной команды в проект для обеспечения максимальной надежности объекта. В рамках услуги DCM360 объединены решения по консалтингу, эксплуатации и бизнес-управлению, что позволяет клиентам получать высокий уровень сервиса с первого дня работы ЦОДа. Кроме того, Тарас Чирков принял участие в дискуссии «Генерация в ЦОД: в поисках выхода из тупика», где обсуждались вопросы локальной генерации энергии и альтернативные решения для энергообеспечения дата-центров.

08.09.2025 Минцифры Приморья и ГК Key Point заключили соглашение о стратегическом партнерстве на ВЭФ 2025

5 сентября на полях Восточного экономического форума, проходящего во Владивостоке подписано стратегическое соглашение о технологическом партнерстве между Министерством цифрового развития и связи Приморского края и сетью дата-центров ГК Key Point. Документ закрепляет намерения сторон по совместной работе в сфере цифровизации региона на базе современного центра обработки данных международного уровня ГК Key Point, расположенного в ТОР «Приморье». Соглашение подписали врио министра цифрового развития и связи Приморского края Андрей Клементьев и основатель ГК Key Point Евгений Вирцер.

В рамках партнерства ГК Key Point выступает технологическим и инфраструктурным партнером для министерства и его подведомственных организаций. Компания будет предоставлять комплексные ИТ-услуги на базе своего ЦОД. Минцифры Приморского края, в свою очередь, получит приоритетный статус для размещения оборудования и обработки технических запросов.

«Современный ЦОД, отвечающий высоким стандартам безопасности – это ключевой элемент обеспечения надежности цифровой инфраструктуры Приморья. Соглашение с ГК Key Point открывает перспективы использования многокомпонентной системы с консолидированным централизованным хранением и обработкой данных, и гарантированное бесперебойное функционирование всех бизнес-процессов Правительства Приморского края», — отметил врио министра цифрового развития и связи Приморского края Андрей Клементьев.

Со своей стороны, ГК Key Point обязуется обеспечить всестороннюю поддержку, включая необходимые технические и консультационные услуги.

Очень важно, чтобы развитие цифровой инфраструктуры было результатом совместной работы государства и бизнеса. Со своей стороны мы обеспечим весь спектр технологической поддержки, чтобы гарантировать надёжную и бесперебойную работу ЦОДа

прокомментировал основать ГК «Кей Поинт» Евгений Вирцер.

Данное соглашение, несомненно, будет способствовать развитию цифровой инфраструктуры Дальнего Востока, закладывая прочный фундамент для реализации масштабных ИТ-проектов и повышения качества цифровых услуг для жителей Приморского края.