Информационный бюллетень HETZNER

Информационный бюллетень HETZNER

Мы рады сообщить вам о наших новых продуктах и новостях компании.

Наслаждайся чтением!

НОВЫЕ УПРАВЛЯЕМЫЕ СЕРВЕРЫ: 100% ПРОИЗВОДИТЕЛЬНОСТЬ, 100% ОБСЛУЖИВАНИЕ

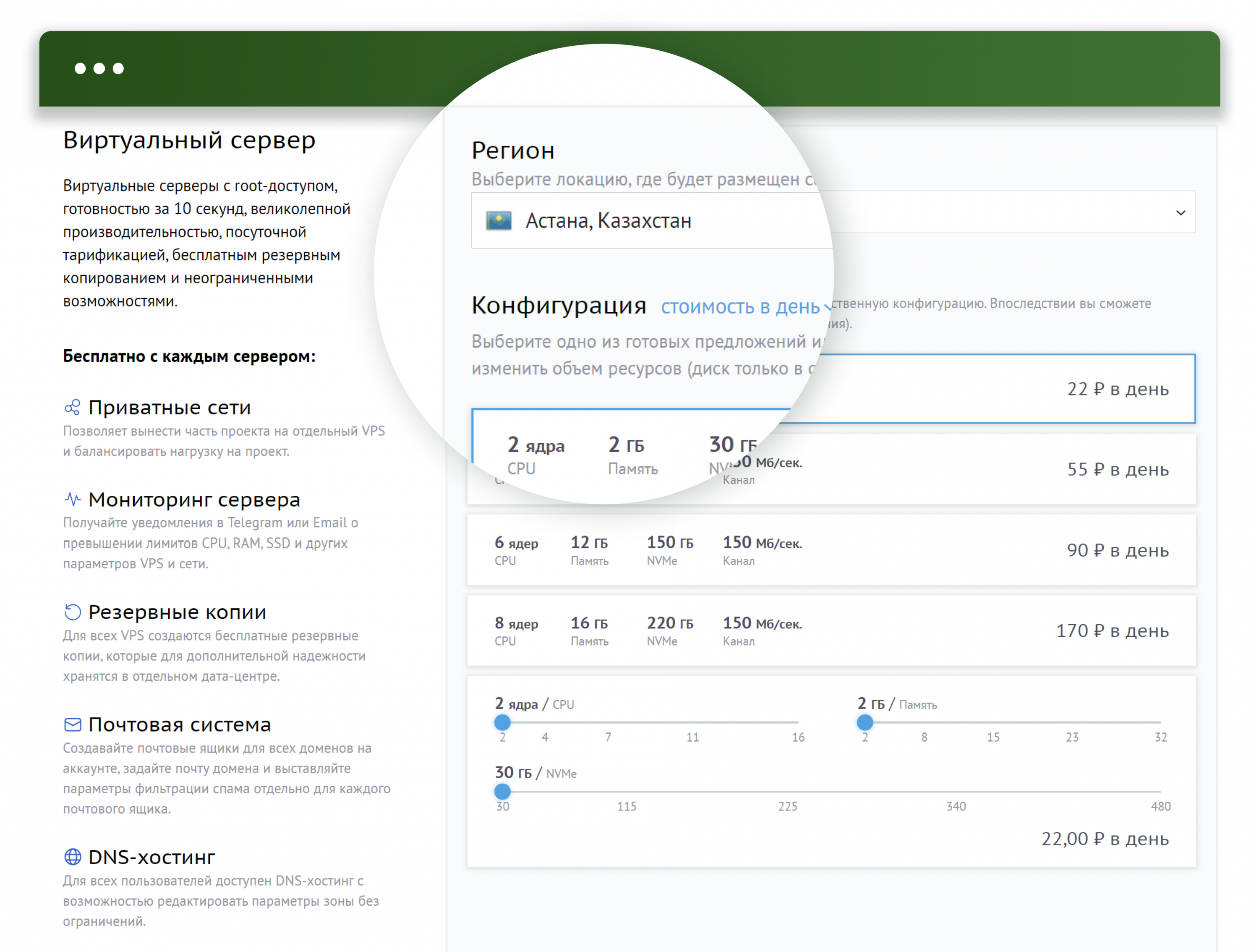

Воспользуйтесь преимуществами стабильного оборудования в сочетании с преимуществами управляемого сервера, который контролируется нашими опытными администраторами. С помощью наших управляемых серверов наши хорошо обученные технические специалисты выполняют обновления программного обеспечения и операционной системы, ежедневно создают резервные копии ваших данных, защищают ваш сервер от атак и обеспечивают постоянную работоспособность и доступность вашего сервера. С нашими новыми управляемыми серверами вы можете расслабиться и сосредоточиться на своем основном бизнесе. Выбирайте из пяти возможных управляемых моделей. Существует две разные модели vServer и три специализированные модели; один из них обязательно подойдет вашему варианту использования.

Модель vServer начального уровня, MC30, включает в себя 4 виртуальных ядра, 16 ГБ гарантированной оперативной памяти и 200 ГБ хранилища на твердотельных накопителях SATA всего за 34,00 евро плюс единовременную плату за установку в размере 34,00 евро. С vServer MC60 ресурсы удваиваются до 8 виртуальных ядер, 32 ГБ гарантированной оперативной памяти и 400 ГБ хранилища на твердотельных накопителях SATA всего за 54,00 евро плюс единовременная плата за установку в размере 54,00 евро.

Новые управляемые серверы MA (MA80, MA130 и MA200) оснащены специализированным оборудованием, что обеспечивает лучшее соотношение цены и качества. MA80 оснащен процессором AMD Ryzen 7 3700X с 8 ядрами и 16 потоками, 64 ГБ оперативной памяти ECC и 2 твердотельными накопителями NVMe 512 по низкой цене 79,00 евро плюс установка 79,00 евро.

Управляемый сервер MA130 основан на процессоре AMD Ryzen 9 5950X с 16 ядрами и 32 потоками, обеспечивающим превосходную производительность, идеальную практически для всех случаев использования. Он включает в себя 128 ГБ оперативной памяти ECC и 2 твердотельных накопителя Datacenter Edition NVMe емкостью 960 ГБ, что делает его идеальным универсальным сервером всего за 139,00 евро плюс 139,00 евро за установку.

Флагманский MA200 оснащен мощным процессором AMD EPYC 7502P. Этот процессор сочетает в себе превосходную одноядерную производительность и благодаря своей высокопараллельной архитектуре может обрабатывать множество запросов одновременно. Благодаря технологии одновременной многопоточности AMD 32 ядра обеспечивают вычислительную мощность 64 потоков, что делает эту модель идеальной для рендеринга, кодирования и веб-приложений с высоким трафиком. Сочетание 256 ГБ оперативной памяти ECC и двух твердотельных накопителей Datacenter Edition NVMe емкостью 1,92 ТБ делает высококлассную модель MA200 готовой к решению любых задач — и все это всего за 199,00 евро в месяц плюс 199,00 евро за установку.

Не идите на компромисс с качеством — воспользуйтесь потрясающим соотношением цены и качества и профессиональным обслуживанием, которое обеспечивают эти впечатляющие новые управляемые серверы.

www.hetzner.com/managed-server

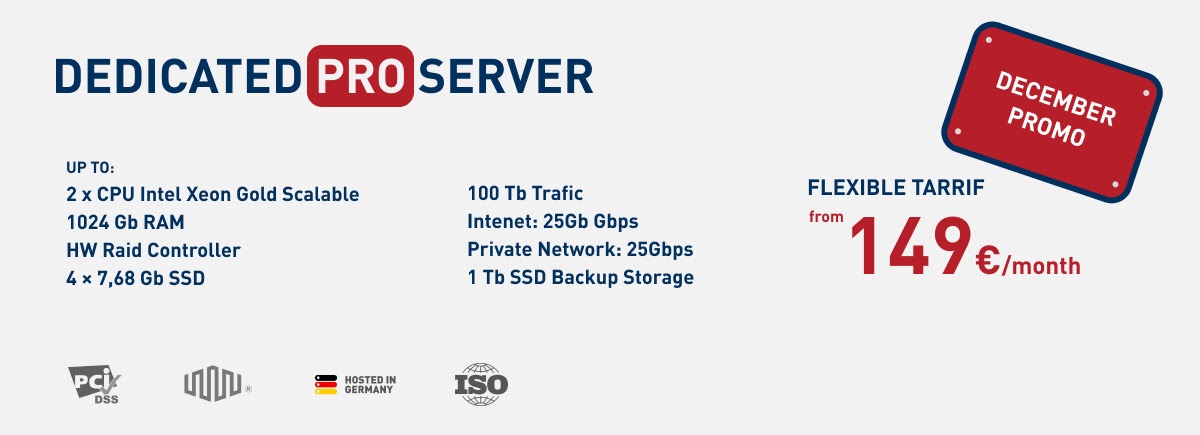

НОВЫЙ ВЫДЕЛЕННЫЙ СЕРВЕР DX153 С НАДЕЖНОСТЬЮ DELL

Появился выделенный сервер DX153, который дополняет недавно обновленную линейку серверов Hetzner, основанную на надежном оборудовании Dell. Dell PowerEdge R660 DX153 создан на базе двух 12-ядерных процессоров Intel Xeon Silver 4410Y «Sapphire Rapids», обеспечивающих впечатляющую производительность. Технология Intel Hyper-Threading повышает эффективность использования ресурсов процессора, а благодаря Intel-VT вы можете гибко и легко управлять своими ресурсами.

Что касается памяти, вы можете положиться на проверенную и надежную 64 ГБ оперативной памяти DDR5 ECC на DX153; а для более требовательных случаев использования вы можете добавить до 1024 ГБ оперативной памяти DDR5 ECC. Хранилище также масштабируется по мере необходимости; можно приобрести твердотельные накопители NVMe или твердотельные накопители SATA различных размеров. DX153 поддерживает горячую замену, поэтому вы можете заменять или добавлять диски во время работы системы.

Одним из преимуществ DX153 является набор включенных аппаратных функций премиум-класса, таких как RAID-контроллер Dell PERC11 H755 и встроенный контроллер удаленного доступа Dell (iDRAC 9 Enterprise), который дает вам еще больший контроль над управлением сервером. И последнее, но не менее важное: этот сервер оснащен резервным источником питания для повышения надежности.

Два адреса IPv4 поставляются с выделенным сервером DX153 по очень разумной цене от 209,00 евро в месяц плюс единовременная плата за установку в размере 79,00 евро. Эта модель доступна во всех трех собственных центрах обработки данных Hetzner в Хельсинки, Финляндия, а также в Фалькенштайне и Нюрнберге, Германия.

www.hetzner.com/dedicated-rootserver/dx153

ОБУЧЕНИЕ: KUBERNETES НА ОБЛАКЕ HETZNER С CLAUDIE

В этом руководстве объясняется процесс настройки кластера Kubernetes в Hetzner Cloud с помощью инструмента под названием «Claudie». Claudie — это платформа для управления мультиоблачными и гибридными облачными кластерами Kubernetes с поддержкой пулов узлов различных облачных провайдеров и локальных центров обработки данных, включая Hetzner Cloud.

community.hetzner.com/tutorials/kubernetes-with-claudie

НОВЫЙ #TKKTIMONIAL С TWIPLA

TWIPLA (ранее называвшаяся «Аналитика посетителей») — это инновационная платформа анализа веб-сайтов с рядом удобных для пользователя инструментов анализа веб-сайтов, соответствующих правилам защиты данных. Они также являются давними клиентами Hetzner.

Генеральный директор Александр Вейт и технический директор Михай Муресан рассказывают о своем опыте работы с Hetzner и объясняют, почему сочетание выделенных и облачных серверов было для них лучшим решением. Узнайте больше о них и о том, как Hetzner помог им вырасти, в нашем новом #Tkktimonial.

www.youtube.com/watch?v=JldW2RHFYo8

ВИРТУАЛЬНЫЕ ВОЛШЕБНИКИ, ОВЦЫ И МНОГОЕ ДРУГОЕ НА HETZNER GAME JAM

Три дня практического обучения, полные творчества, веселья и сотрудничества — вот что испытали фанаты ИТ на Hetzner Game Jam в Гунценхаузене и Мюнхене.

У участников было всего 48 часов на создание игр на общую тему: «цикл». Например, в игре «Туда и обратно» игрок берет на себя роль волшебника, который спускается в подземелье по бесконечной винтовой лестнице. А в игре «Chomp & Chew» животные поедали друг друга, чтобы подняться по эволюционному циклу. А в игре «Марафон» вы играете за овцу по имени Фридолин, которая прыгает и пробирается сквозь постоянно вращающуюся среду.

www.youtube.com/watch?v=R-wxfEdk2Tk

С ПРАЗДНИЧНЫМ СЕЗОНОМ!

Спасибо, что доверяете нам в Hetzner Online еще один год! Мы надеемся, что вы проведете спокойное и приятное Рождество среди своих близких.

Пусть новый год принесет Вам крепкое здоровье, счастье и удачу! Вся команда Hetzner желает вам успехов во всех начинаниях.