Последние обновления Март-Июнь 2025

Кластеры Kubernetes теперь совместимы с Agones

После периода тщательного сквозного тестирования мы рады подтвердить, что наши кластеры Kubernetes официально совместимы с Agones.

Agones — это бесплатная платформа с открытым исходным кодом, созданная на основе Kubernetes, которая позволяет разворачивать, размещать и организовывать выделенные игровые серверы для многопользовательских игр. Наши клиенты могут начать использовать Agones уже сейчас, получая такие преимущества, как снижение затрат на разработку и эксплуатацию, упрощение инструментария (Agones позволяет запускать игровые сервисы и серверы на одной платформе) и доступ к обширному сообществу разработчиков платформы.Просто установите Agones непосредственно на ваши существующие кластеры Kubernetes на серверах (servers.com), следуя инструкциям по установке на сайте Agones. Если вам нужна дополнительная информация, свяжитесь с нашей командой.

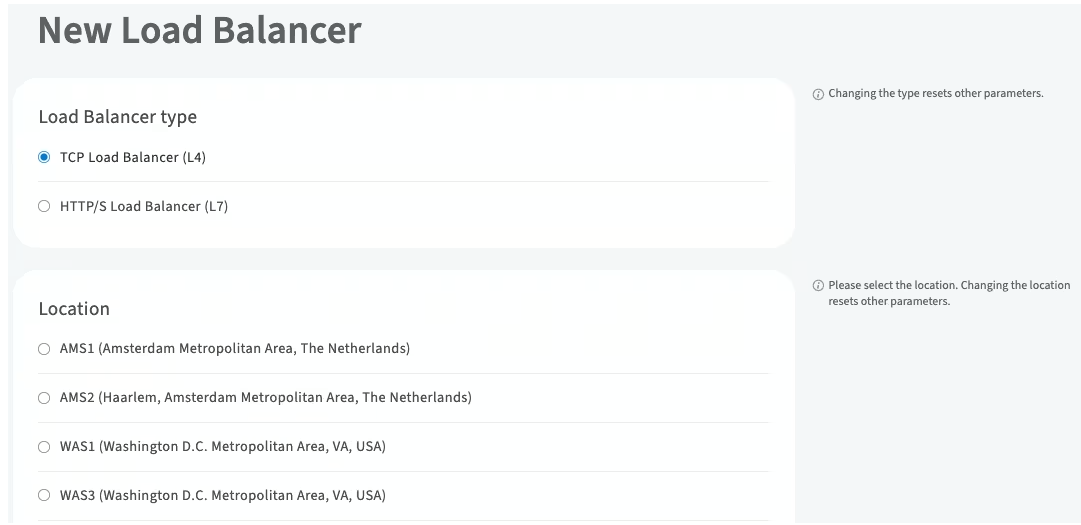

Наш сервис балансировки нагрузки теперь доступен в WAS3

Наш сервис балансировки нагрузки теперь доступен в нашем дата-центре WAS3. Благодаря этому мы можем предложить клиентам из Вашингтона (округ Колумбия) и агломерации доступ к выделенному серверному хостингу с повышенной эффективностью работы серверов и производительностью приложений, уменьшенной задержкой сети и ускоренным временем отклика.

www.servers.com/products/load-balancing-service

Планировать обновление оборудования для вашего выделенного сервера стало проще

Мы упростили для наших клиентов планирование модернизации оборудования. При отправке нам запроса на обновление дисков или оперативной памяти на вашем выделенном сервере теперь вы можете указать предпочитаемый часовой пояс для выбранного временного интервала. Кроме того, вы можете указать, хотите ли вы, чтобы ваш сервер был включён или выключен после модернизации.

Новые улучшения функциональности

Мы внесли функциональные улучшения, чтобы улучшить общее впечатление наших клиентов. В их число входят:

- Назначение нескольких типов сертификатов на одну и ту же конечную точку балансировщика нагрузки

- Изменение сети по умолчанию для вашего выделенного сервера

- Перевод облачного экземпляра в режим восстановления путем добавления устаревшего образа в публичный API

- Новые и улучшенные виджеты на панели управления клиентского портала

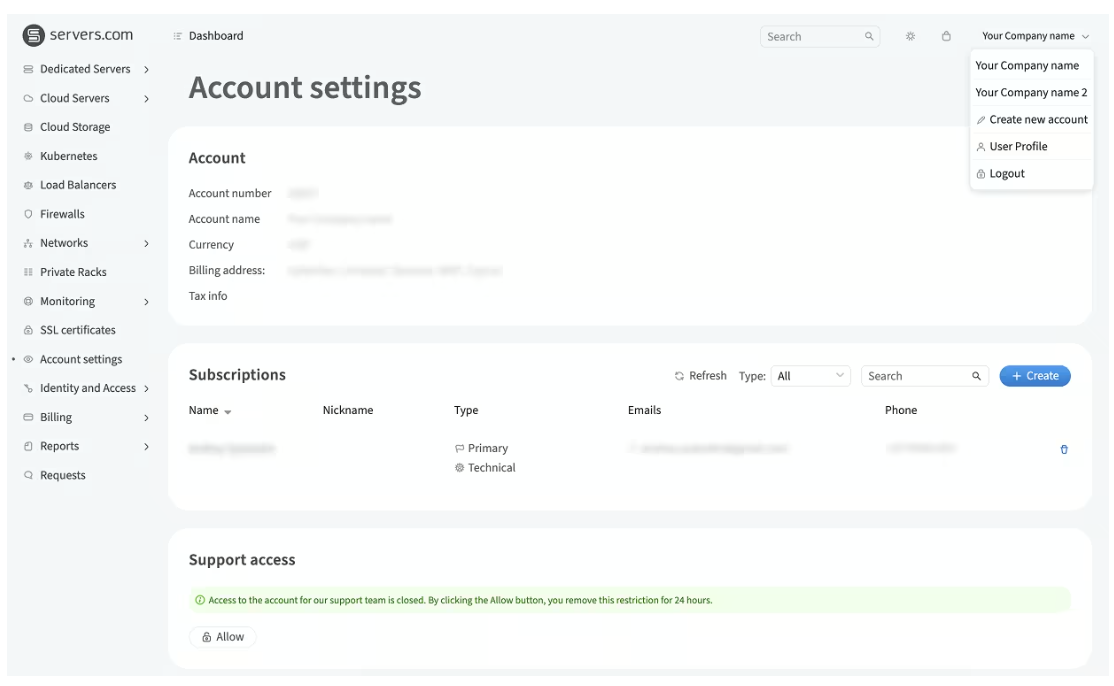

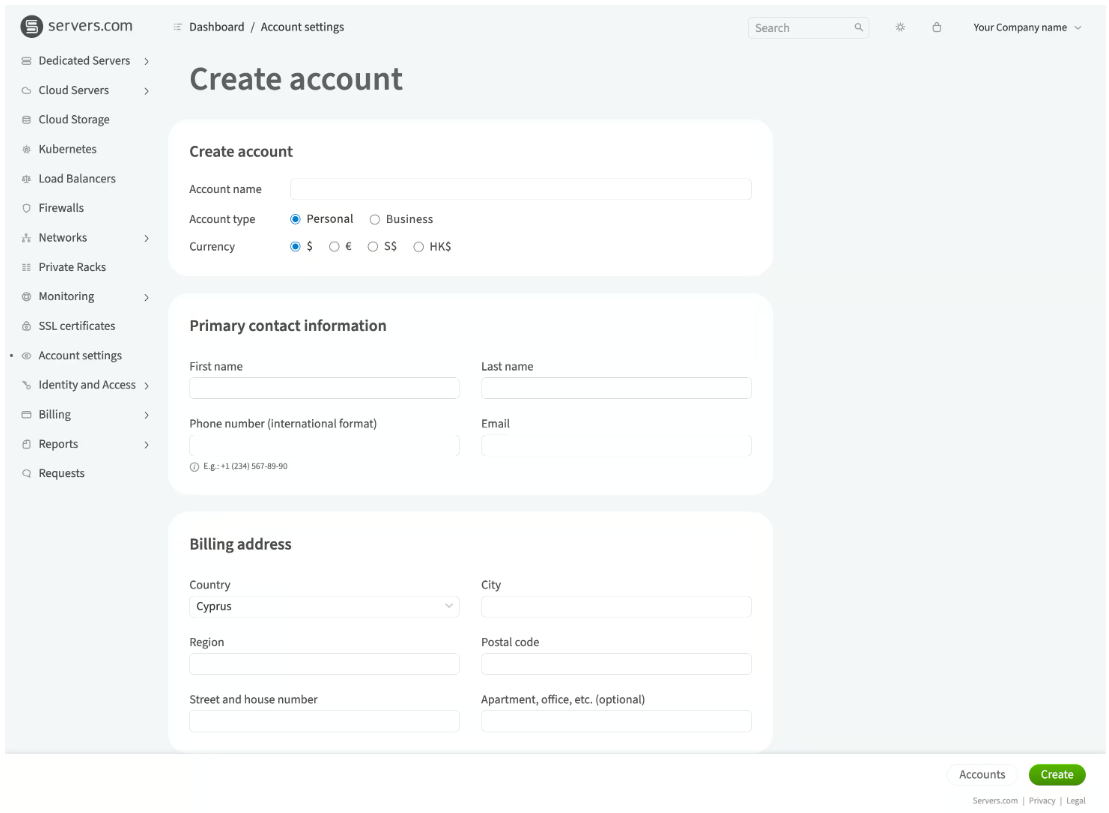

Новая функция мультиаккаунтов для клиентского портала

Мы выпустили новую функцию для работы с несколькими учетными записями, призванную улучшить управление учетными записями и ресурсами, а также обеспечить эффективный контроль над несколькими ресурсами и учетными записями пользователей в рамках одного входа в систему.

Эта функция позволяет нашим клиентам эффективно распределять ресурсы и приглашать членов команды к совместной работе над проектами, что делает ее идеально подходящей для компаний, стремящихся экспериментировать с различными проектами и идеями.

Основные характеристики включают в себя:

- Настраиваемая валюта и адрес выставления счетов

- Раздельное распределение ресурсов по отдельным счетам (способствует выставлению счетов и составлению бюджета, поскольку все организовано по отдельным счетам)

- Пользователи аккаунта могут получать доступ к нескольким аккаунтам и переключаться между аккаунтами.

- Ресурсы изолированы под определенными учетными записями для предотвращения нарушений безопасности.

Эта функция будет особенно полезна для компаний, работающих в нескольких регионах и выставляющих счета в разных базовых валютах, а также для тех, кто хочет создать отдельные учетные записи для автономных проектов.

Подробнее о функции нескольких аккаунтов можно прочитать в нашей базе знаний.

www.servers.com/support/knowledge/accounts/multi-accounts

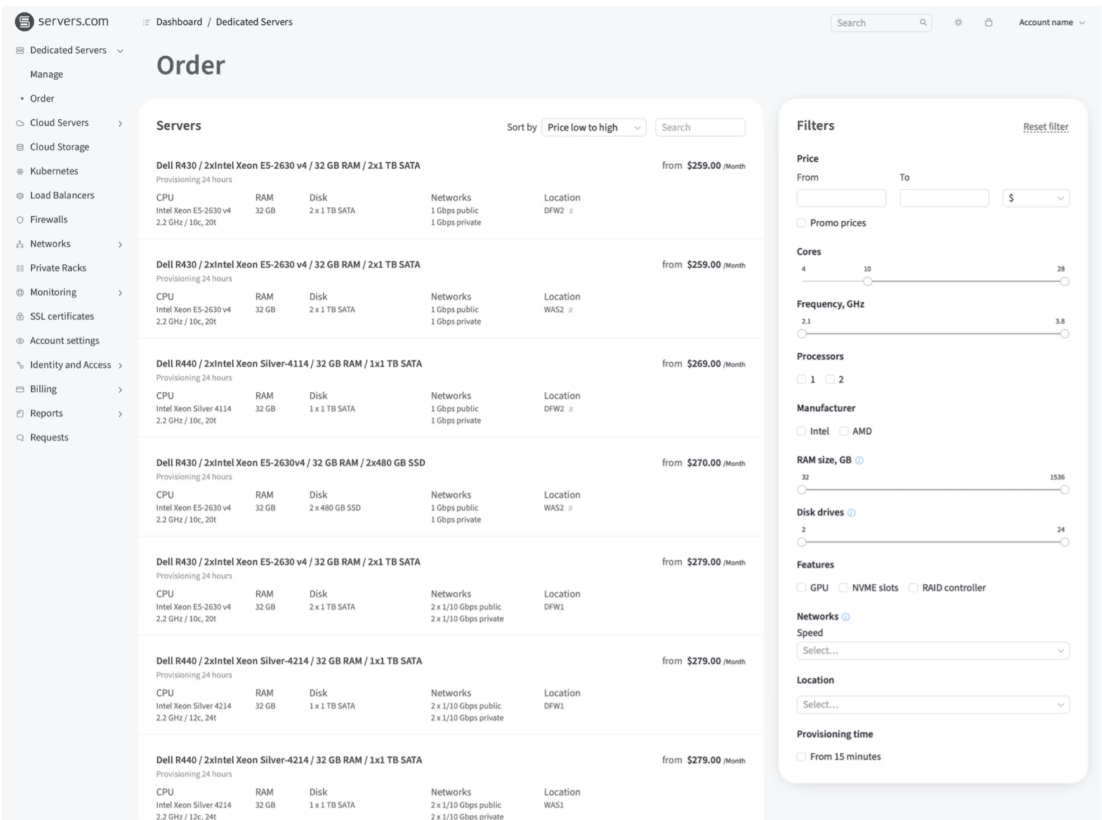

Конфигуратор серверов в клиентском портале был переработан.

Наш конфигуратор серверов обновлён для заказа и изменения конфигурации выделенного сервера в разделе дисков. Это крупное обновление, которое значительно снизит вероятность ошибок при настройке сервера, а также позволит пользователям работать с дисками на нескольких контроллерах.

Ключевые элементы редизайна включают в себя:

- Контроллер хранилища для каждого слота теперь отображается на наших страницах заказа, переустановки и обновления диска.

- Мы сделали создание разделов более гибким с помощью специального диалогового окна.

- Мы добавили поддержку напрямую подключенных дисков NVMe.

- Мы внедрили новый конфигуратор на страницах переустановки и обновления диска.

- Теперь вы можете использовать несколько контроллеров на одном сервере одновременно.

Улучшена проверка платежного адреса для клиентских аккаунтов

Мы улучшили процесс проверки платёжного адреса, чтобы обеспечить более плавную и быструю активацию учётной записи для наших клиентов. Снижая вероятность ввода неполного или неверного адреса, клиенты теперь могут избежать задержек и наслаждаться более плавным процессом подключения.

Улучшения для удобства пользователя

Для удобства пользователей мы добавили на портал два ключевых обновления, касающихся качества жизни (QoL). Вот они:

- Инструменты балансировки нагрузки теперь позволяют сортировать кандидатов на серверы верхнего уровня по имени хоста и IP-адресу. Это упрощает для наших клиентов поиск конкретных серверов, позволяет структурировать список в удобном порядке и быстро устранять неполадки.

- Наши клиенты теперь могут обновлять пользовательские SSL-сертификаты через публичный API. Это экономит время, особенно для клиентов, управляющих большим количеством веб-сайтов или серверов.

Два ключевых обновления портала

Мы обновили наш клиентский портал двумя способами:

На странице выбора серверов теперь можно фильтровать серверы по:

- Частота процессора

- Количество ядер

- Размер диска

- БАРАН

Интерфейс выбора ОС на странице заказа был переработан, став более компактным и удобным для навигации. Мы также добавим логотипы ОС для быстрой идентификации — следите за обновлениями!

До этих обновлений клиентам приходилось либо вручную проверять характеристики каждого сервера, либо обращаться к своему менеджеру по работе с клиентами. Благодаря улучшению интерфейса выбора ОС и добавлению гибкой и удобной фильтрации для выбора серверов, теперь нашим пользователям стало гораздо проще выбирать серверы, наилучшим образом соответствующие их потребностям.

Windows Server 2025 теперь доступен на наших платформах

Новейшая версия серверной операционной системы (ОС) Microsoft, Windows Server 2025, теперь доступна на наших выделенных и облачных серверных платформах.

Это обновление обеспечивает значительные улучшения во многих различных областях, таких как виртуализация, безопасность и управление серверами.

Виртуализация Hyper-V

Windows Server 2025 предоставляет следующие преимущества виртуализации Hyper-V:

Разбиение графического процессора

Теперь вы можете разделить графический процессор (GPU) между несколькими виртуальными машинами (ВМ). В отличие от предыдущих версий Windows, Windows Server 2025 позволяет нескольким виртуальным машинам использовать один физический графический процессор. Ранее это было возможно благодаря RemoteFX, но затем эта функция была удалена из соображений безопасности. В Windows Server 2025 эта функция вернулась с улучшенной безопасностью и даже поддерживает динамическую миграцию, позволяя перемещать виртуальную машину с одного сервера на другой без простоя.

Совместимость с динамическими процессорами

Динамическая совместимость процессоров позволяет виртуальным машинам использовать одни и те же функции процессора во всем кластере, даже если физические серверы в кластере имеют разные модели процессоров. В предыдущих поколениях ОС Windows не рекомендовалось использовать разные процессоры в одном кластере. Вместо этого приходилось использовать функцию, называемую режимом совместимости, которая отключала новые функции процессора, чтобы все серверы в кластере работали одинаково. Однако это могло ограничить производительность, снижая скорость обработки и эффективность при выполнении ресурсоёмких задач.

Active Directory не требуется

Отличным дополнением, особенно для небольших сред или более изолированных сред, является возможность создания кластера без домена Active Directory. В Windows Server 2025 новый тип отказоустойчивого кластера «Кластер рабочей группы» позволяет создавать кластеры Hyper-V из узлов, не входящих в домен (рабочей группы).

Повышенная масштабируемость

Windows Server 2025 может обрабатывать:

- 2048 логических ядер ЦП и 4 ПБ ОЗУ на сервер

- 2048 виртуальных ЦП и 240 ТБ ОЗУ на ВМ

- 1024 логических ядра ЦП и 4 ПБ ОЗУ на сервер

- 1024 виртуальных ЦП и 240 ТБ ОЗУ на ВМ

Безопасность

Windows Server 2025 обеспечивает следующие преимущества безопасности:

Перевод страниц, осуществляемый гипервизором

Трансляция страниц, принудительно осуществляемая гипервизором (HVPT), — это новая технология Windows, защищающая ОС от уязвимостей ядра. Она включена по умолчанию на поддерживаемом оборудовании, поэтому не требует настройки. Это защищает Windows от системных уязвимостей, которые хакеры могут использовать для получения контроля над машиной.

Более подробную информацию вы можете получить, прочитав презентацию HVPT от инженеров, создавших эту функцию.

Windows LAPS (решение для пароля локального администратора)

В Windows Server 2025 встроена система Windows LAPS. Это усовершенствованная версия уже существующей системы Microsoft LAPS: решение для автоматического локального управления паролями, позволяющее автоматически менять пароли локальных учётных записей на серверах и рабочих станциях. Новшеством этой версии является возможность генерировать не только обычные сложные и случайные пароли, но и понятные для запоминания парольные фразы.

Делегированная управляемая учетная запись службы

Если вам не удалось заменить обычные учётные записи служб групповой управляемой учётной записью службы, решением в Windows Server 2025 станет делегированная управляемая учётная запись службы (dMSA). Вместо использования статических учётных записей служб с фиксированными паролями dMSA позволяет постепенно переходить на учётные записи с автоматическим обновлением паролей.

Больший контроль над версиями протокола SMB (Server Message Block)

SMB — это протокол, используемый Windows для обмена файлами между компьютерами. Раньше можно было включить или отключить только SMB2 полностью; теперь можно указать конкретную версию SMB. Например, можно разрешить только последнюю версию SMB 3.1.1 и легко заблокировать остальные протоколы. Это помогает повысить безопасность, отключая устаревшие и уязвимые протоколы.

Шифрование LDAP (Lightweight Directory Access Protocol) по умолчанию

Протокол TLS (Transport Layer Security) защищает данные, передаваемые через интернет. Благодаря TLS 1.3 шифрование LDAP в Windows Server 2025 стало быстрее и безопаснее, а Kerberos (система аутентификации Windows) теперь поддерживает новые криптографические алгоритмы.

Блокировка старых, небезопасных паролей

Windows Server 2025 по умолчанию блокирует старые, небезопасные методы смены паролей в Active Directory, обеспечивая использование более надежных, современных механизмов смены паролей.

Службы домена Active Directory

Если у вас очень большая инфраструктура доменных служб Active Directory (AD DS), Windows Server 2025 будет особенно выгоден по следующим причинам:

Улучшенная производительность для больших сред Active Directory

Служба AD DS теперь использует возможности оборудования с поддержкой NUMA и задействует процессоры во всех группах процессоров. Это повышает производительность служб каталогов, делая процессоры более эффективными для более быстрой аутентификации пользователей, обработки групповых политик и поиска в каталогах.

Хранение крупных объектов

Windows Server 2025 поддерживает размер страницы базы данных 32 КБ. Это позволяет хранить объекты большего размера в базе данных AD DS, где может быть до 3200 различных записей в многозначных атрибутах.

Управляемость

Благодаря следующим функциям Windows Server 2025 обладает улучшенными возможностями управления:

Сервер OpenSSH теперь встроен

Раньше вам приходилось устанавливать сервер OpenSSH вручную из отдельного пакета, но теперь этот безопасный инструмент управления сервером предустановлен и не требует дополнительной настройки.

Более безопасный способ доступа к файловым серверам

SMB через QUIC (Quick UDP Internet Connections) позволяет вашим пользователям получать доступ к файловому серверу не через устаревший TCP (Transmission Control Protocol), а через современное безопасное шифрование (TLS 1.3). Теперь вы можете безопасно получать доступ к общим файлам из любой точки мира без использования VPN.

learn.microsoft.com/en-us/windows-server/storage/file-server/smb-over-quic