Выйти из версий, которые больше не поддерживаются, создавать расширение центра обработки данных, заменять центр обработки данных, настраивать аварийное восстановление, использовать случаи, требующие перемещения рабочей нагрузки между различными центрами обработки данных. И никогда не было так легко и быстро переместиться с Западного побережья на восточное побережье или из Амстердама в Лимбург. За несколько кликов рабочие нагрузки отправляются через защищенные туннели HCX между разными центрами обработки данных.

Чтобы дать некоторые цифры, клиенту потребовалось 5 недель для перемещения 300 ТБ виртуальных машин, включая планирование, установку, репликацию и переход на другой ресурс. За один день этот клиент установил 23 ТБ данных, или 1 ТБ / час между двумя центрами обработки данных в Германии. Другой клиент переместился из своего центра обработки данных более 200 ТБ, распространив более 750 виртуальных машин без простоя.

Год назад никто не мог представить себе эти горячие движения. Сама концепция смещения рабочих нагрузок между двумя центрами обработки данных была фантазией, делая ее горячей, просто химерической.

Перемещение рабочей нагрузки зависит от технологии VMware, HCX, для платформы Private Cloud. Эта технология, помимо управления безопасным перемещением рабочих нагрузок, обеспечивает плавный переход путем предоставления сетевого соединения между исходным дата-центром и дата-центром назначения через расширенную сеть L2, протянутую. Виртуальная машина, которая отправляется в Private Cloud hot, не теряет связи с другими машинами, с которыми она работает в номинальных условиях.

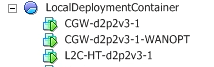

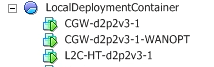

HCX использует 3 устройства, один для управления передачей виртуальных машин из одного центра обработки данных в другой, Cloud Gateway (CGW), один из которых работает с CGW, WAN Accelerator и тот, который используется для растянутой сети (L2C). Эти устройства автоматически развертываются на стороне частного облака и требуют четвертого устройства на стороне помещения, чтобы пилотировать развертывание и настройку этих трех основных элементов.

Примечание: CGW также отображается в инвентаре в качестве зарегистрированного хоста.

Подводя итог, будут созданы два минимальных туннеля между исходным дата-центром и целевым центром обработки данных, частным облаком OVH. Туннель между CGW для передачи виртуальных машин и туннель между L2C, который будет создавать растянутую сеть в случае необходимости расширения подсети. Само собой разумеется, что можно развернуть несколько L2C, в зависимости от количества расширяемых сетей.

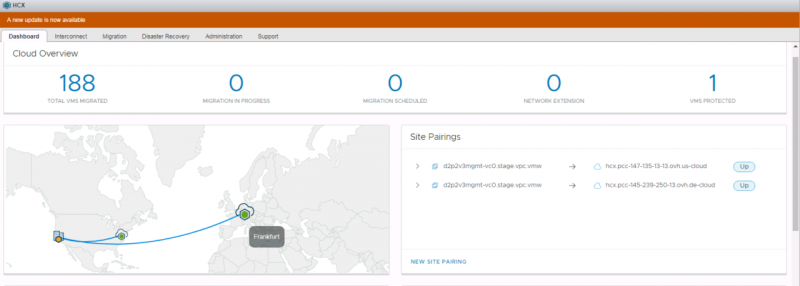

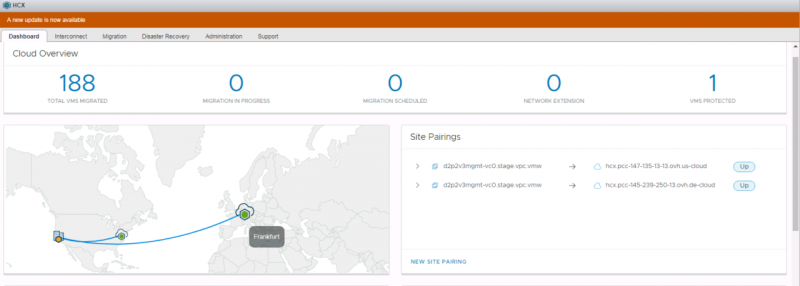

Как только архитектура станет готовой предпосылкой, мы увидим панель управления, которая суммирует возможности миграции и имеет историю.

Существует множество способов перемещения виртуальных машин, горячей миграции, теплой миграции и холодной миграции.

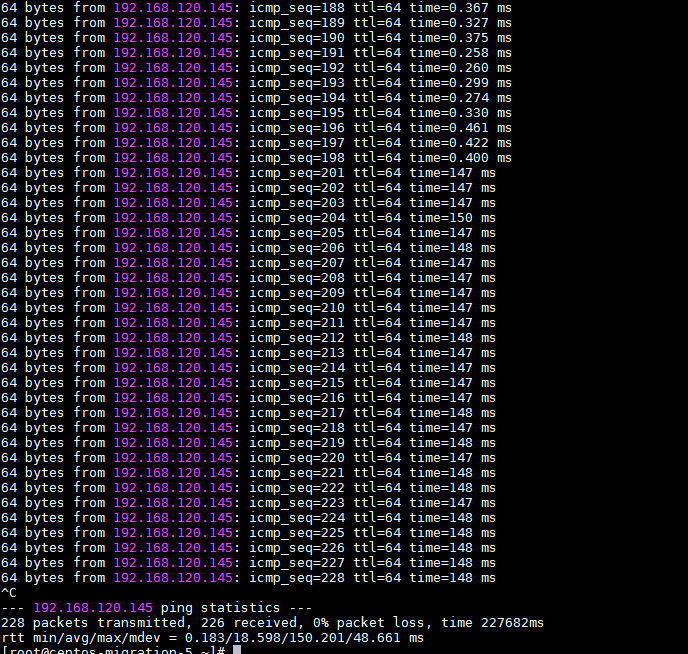

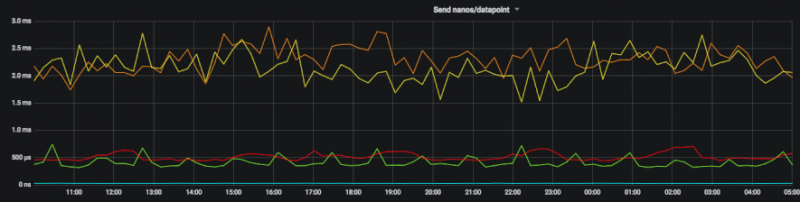

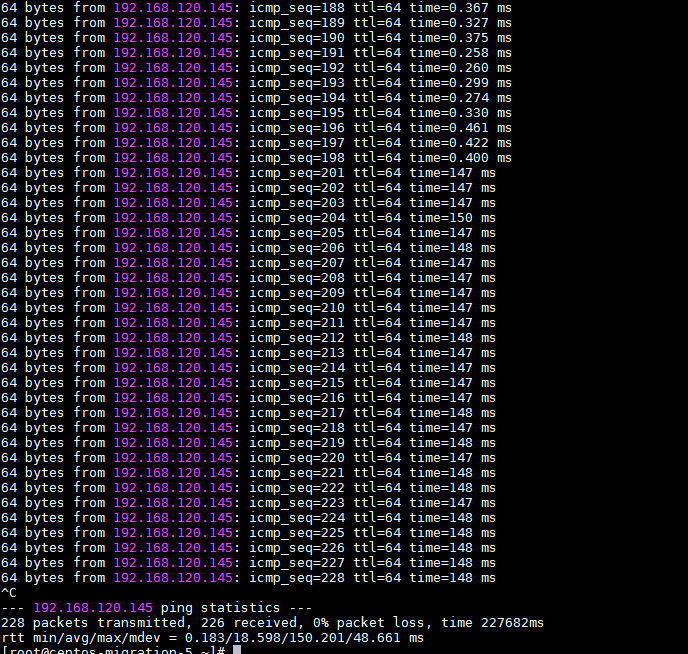

Горячая миграция, безусловно, самая впечатляющая. Через несколько кликов виртуальная машина находится в целевом центре данных без потери состояния, возможности подключения и контекста. Метод похож на vMotion, известных пользователей VMware, этот метод называется vMotion Migration. Принцип заключается в том, что хранение виртуальной машины отправляется в целевой центр назначения, как только хранилище виртуальной машины полностью синхронизировано, необходимо синхронизировать очередь памяти и ЦП, а центр данных назначения возьмите реле. Ограничением этого метода является секвенциализация процесса, который может влиять на рабочие нагрузкираспространяются через несколько виртуальных машин и требуют низкой задержки между виртуальными машинами. Когда VM мигрирует, латентность между центрами данных будет ощущаться:

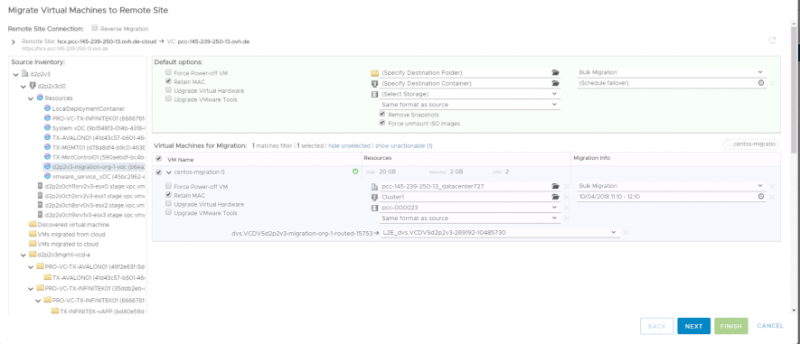

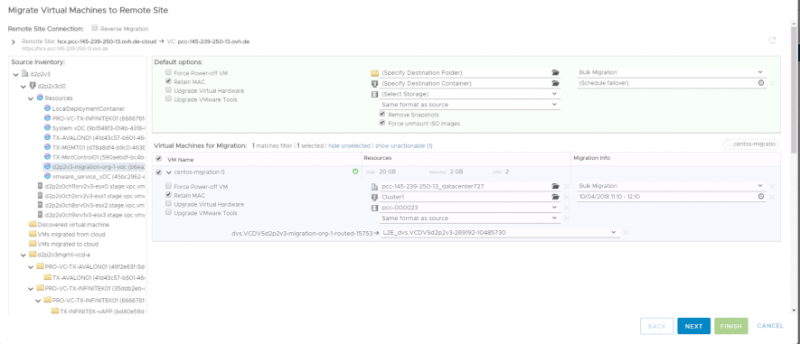

Так что с «Массовая миграция» «Мы рассмотрим эту проблему, добавив, кроме того, функции, которые помогут контролировать миграцию. Цель этой миграции — синхронизировать один или несколько виртуальных машин с центром данных назначения, пока они все еще находятся в исходном центре данных, и поддерживать эту синхронизацию с течением времени. Рокер всех виртуальных машин будет проходить в течение выбранного администратора за эту миграцией, более благоприятной временной интервал в качалке, который будет проходить через угасания VM в центре источника и данных Запуск виртуальной машины в целевом центре данных. В дополнение к освоению триггера можно настроить виртуальную машину (обновление VMware Tools, обновление виртуального оборудования и т.д.) Поскольку все виртуальные машины перемещаются одновременно, растянутая сеть.

Последний способ переключения является разрушительным для производственных машин и поэтому скорее предназначен для миграции шаблонов, архивов, резервных копий. Холодно, VM выключено, и будет просто синхронизировать данные и автоматически переключаться, когда все данные поступают в датацентр назначения.

У нас есть более чем трехлетний опыт безопасной миграции рабочих нагрузок, сначала в центрах обработки данных vCloud Air, а затем в собственных дата-центрах OVH. В течение этого периода мы мигрировали экзабайты данных по всему миру.

HCX — это инструмент, который был предназначен для ответа на несколько проблем, связанных с миграцией, а также обеспечения работы виртуальных машин во время их передачи, необходимости переключения групп виртуальных машин, а также сетевого соединения между различными центрами обработки данных, и мы должны ассоциировать архитектурную работу. Действительно, миграция готовит вверх по течению, с проклейкой достаточно центра обработки данных назначения, которые могут адаптироваться с течением времени на OVH Private Cloud. Также необходимо работать над оценкой времени качания и стратегии качания, связанной с различными рабочими нагрузками источника центра обработки данных. В остальном это всего лишь история нескольких кликов в HCX.