66666 тикет :)

Так как у нас в биллинге используется не только домен Yacolo, а еще и Понаехали или ФакЗемКлауд всякий тд тд, то ID распределяются по проектам. На Яколо вообще

было не более 3000 тикетов за все время существования, да и на других не особо много, а 50000 тикетов в том биллинге накрутилось в 2020 или 2021 году, когда какой-то тролль завистник подключил бот регалку тупо чтобы засрать биллинг моему другу, поэтому такие огромные ID и образовались.

Сначала я анонсировал

топиком у себя в мелких заметках. Оттуда видимо появился 1 желающий и он стал по 100р закидывать раз в день :) И никто больше не писал кроме него, я ему даже сказал что ты единственный желающий видимо поучаствовать.

Потом уже почти рядом с ID — я анонсировал в

топике черной пятницы. Оттуда видимо, где-то через час появился 2-ой желающий, он успел создать несколько тикетов или даже написал что может клонов замутить, на что я ему ответил что если будет заниматься накрутками, то приз точно не получит.

В итоге второй чел который хотел заспамить — перестал писать.

А тот первый чел который раз в пару дней делал платеж — тот и победил.

Но если бы любой из них начал тупо спамить ради накрутки — я бы думаю им не засчитал.

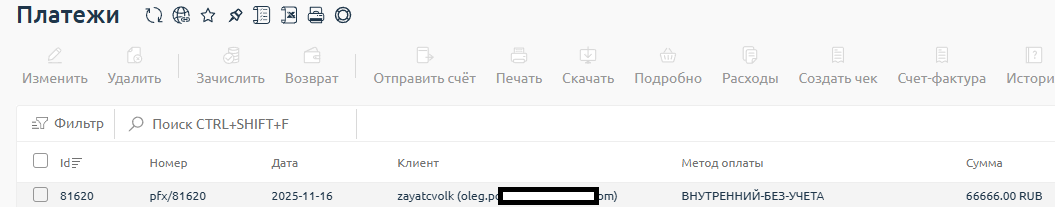

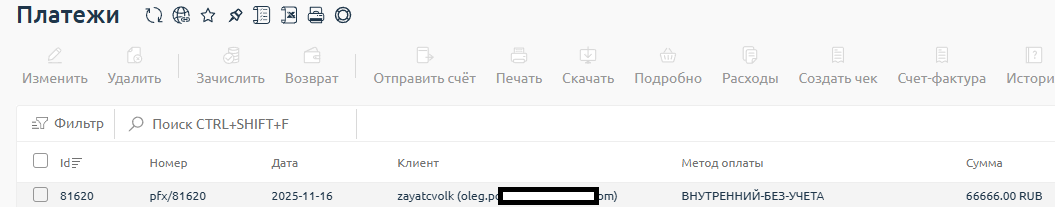

Итого получилось так.

Сам 66666 ID выпал на другом проекте, т.к. биллинг корпоративный. Почему вообще YaColo оказалось тут добавлено? В 2021 году

Сгорел нахуй ОВХ SBG вместе с биллингом yacolo, бекап не был настроен, т.к. ДЦ спросом не пользовался и продаж то и не было там с 2016 и т.к. как вы знаете ДЦ пустовал, то мне просто было лень создавать новый биллинг после пожара и я его добавил в уже рабочий любой корпорейт по тем годам. В 2021 году еще были разные версии биллинга это он сейчас стал по умолчанию корпорейтом для любой версии. А когда пошло второе дыхание ДЦ я просто не стал переделывать.

Честно получает свои 66666 рублей

Почему же я решил устроить анонс заранее?

Ведь гораздо приятнее случайно выйграть бонусные деньги.

А потому что уже было такое. И человек даже не воспользовался ими.

66666 пользователь достался вот этому челику, но он хуй забил.

Стало