Давным-давно в далекой-далекой галактике мы начали собирать и хранить данные Drive Stats. Точнее это было 10 лет назад, а галактика была как раз Северной Калифорнией, хотя с тех пор она расширилась (как известно галактики делают). За последние 10 лет многое произошло с тем, где, когда и как мы получаем данные статистики вождения, но, тем не менее, данные статистики вождения за первый квартал 2023 года готовы, так что давайте начнем.

По состоянию на конец первого квартала 2023 года Backblaze отслеживала 241 678 жестких дисков (HDD) и твердотельных накопителей (SSD) в наших центрах обработки данных по всему миру. Из этого числа 4400 являются загрузочными дисками, из них 3038 твердотельных накопителей и 1362 жестких диска. Частота отказов твердотельных накопителей анализируется в обзоре SSD Edition: 2022 Drive Stats.

Сегодня мы сосредоточимся на 237 278 дисках с данными, находящихся под управлением, и проанализируем их ежеквартальную и пожизненную частоту отказов по состоянию на конец первого квартала 2023 года. более. Попутно мы будем делиться своими наблюдениями и выводами о представленных данных и, как всегда, надеемся, что вы сделаете то же самое в разделе комментариев в конце поста.

Частота отказов жестких дисков за первый квартал 2023г.

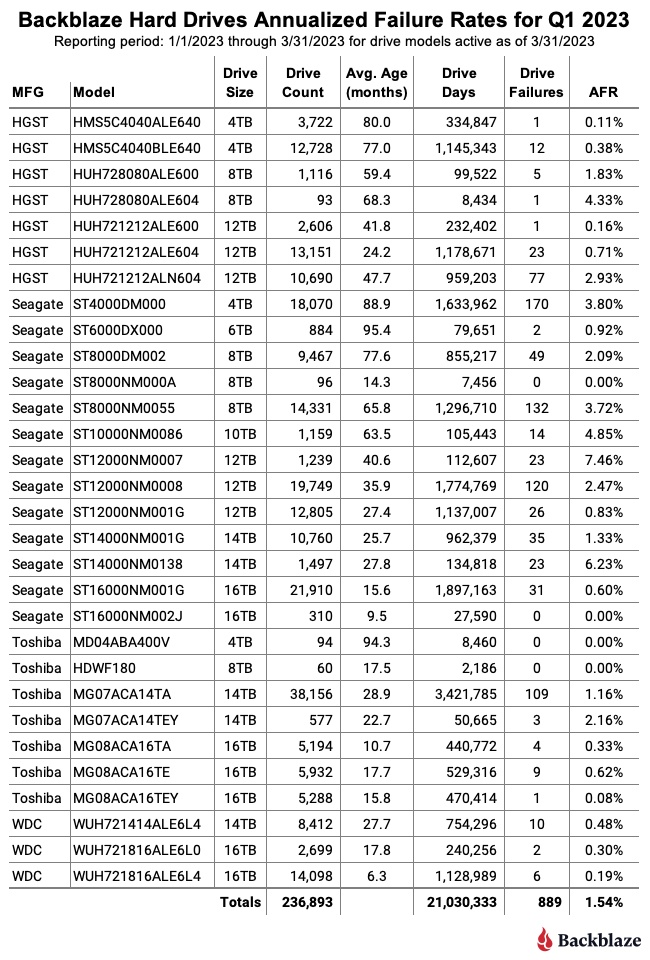

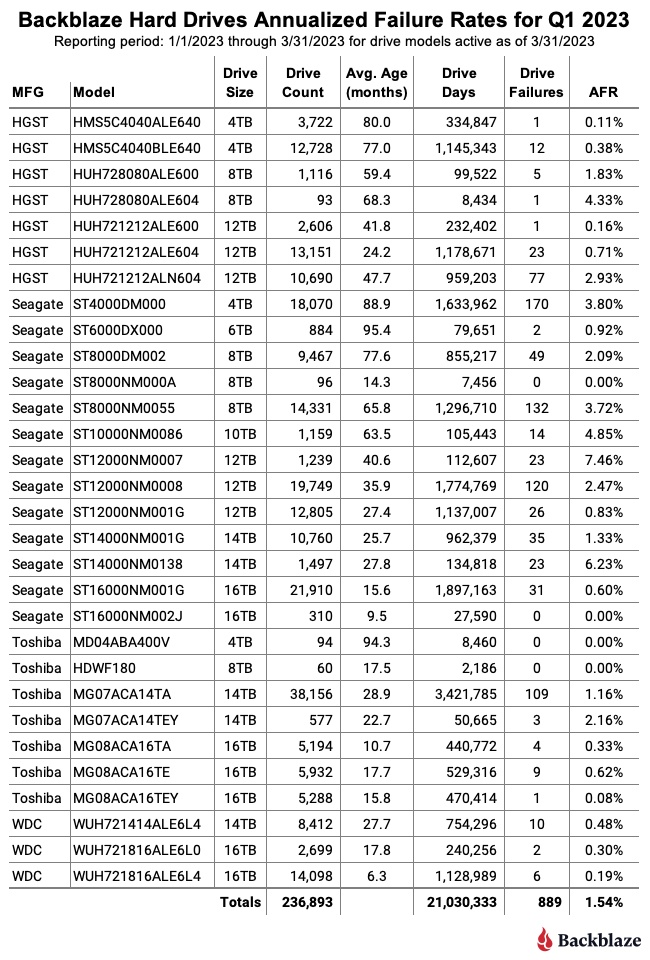

Начнем с обзора наших данных за первый квартал 2023 года. В этом квартале мы отследили 237 278 жестких дисков, используемых для хранения данных клиентов. Для нашей оценки мы исключили из рассмотрения 385 дисков, поскольку они использовались для целей тестирования или представляли собой модели дисков, в которых не было по крайней мере 60 дисков. Это оставляет нам 236 893 жестких диска, сгруппированных по 30 различным моделям для анализа.

Примечания и наблюдения по статистике привода за первый квартал 2023 г.

Примечания и наблюдения по статистике привода за первый квартал 2023 г.

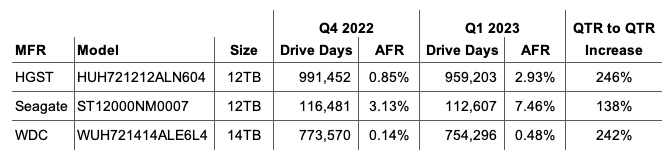

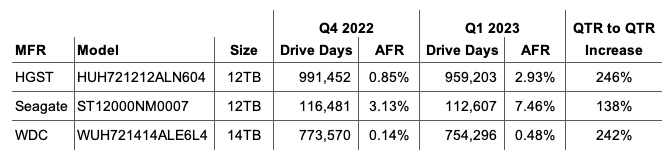

Повышение AFR: Годовая частота отказов (AFR) за 1 квартал 2023 г. составила 1,54%, что выше, чем в 4 квартале 2022 г. на 1,21%, и по сравнению с 1 кварталом 2022 г. год назад на 1,22%. Квартальные показатели AFR могут быть неустойчивыми, но они могут быть полезны для определения тенденции, требующей дальнейшего изучения. Например, три диска в первом квартале 2023 года (перечисленные ниже) более чем удвоили свой индивидуальный AFR с четвертого квартала 2022 года по первый квартал 2023 года. Как следствие, требуется дополнительная проверка (или, в некоторых случаях, продолжение проверки) этих дисков.

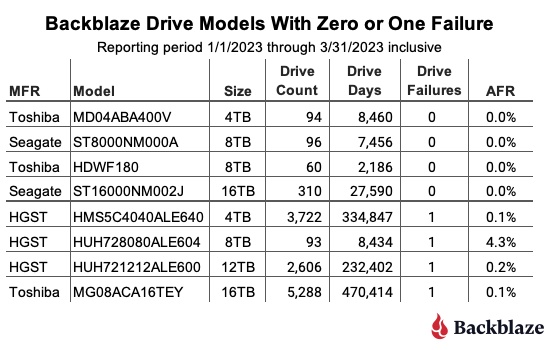

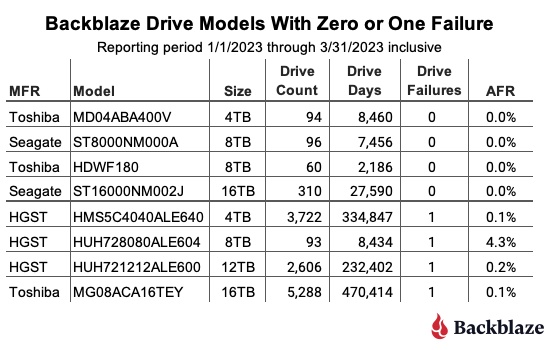

Нули и единицы: в приведенной ниже таблице показаны модели дисков, у которых в первом квартале 2023 г. не было ни одного, ни одного отказа.

При просмотре таблицы любая модель привода с менее чем 50 000 дней вождения за квартал не имеет достаточного количества данных для статистической значимости за этот период. Тем не менее, для двух из перечисленных моделей приводов сообщение об отсутствии сбоев не является чем-то новым. У Seagate на 16 ТБ (модель: ST16000NM002J) также не было сбоев в прошлом квартале, а у Seagate на 8 ТБ (модель: ST8000NM000A) не было сбоев с момента его первой установки в третьем квартале 2022 года, при этом AFR за весь срок службы составляет 0 %.

Новая, но не такая уж новая модель накопителя: в первом квартале 2023 года появится одна новая модель накопителя — Toshiba емкостью 8 ТБ (модель: HDWF180). На самом деле, это не ново, просто в этом квартале у нас сейчас в производстве 60 дисков, так что это попало в чарты. Эта модель фактически находится в производстве с первого квартала 2022 года, начиная с 18 дисков и со временем добавляя больше дисков. Почему? Эта модель диска заменит некоторые из 187 отказавших дисков емкостью 8 ТБ в этом квартале. У нас есть запасы дисков разных размеров, которые мы держим под рукой именно по этой причине.

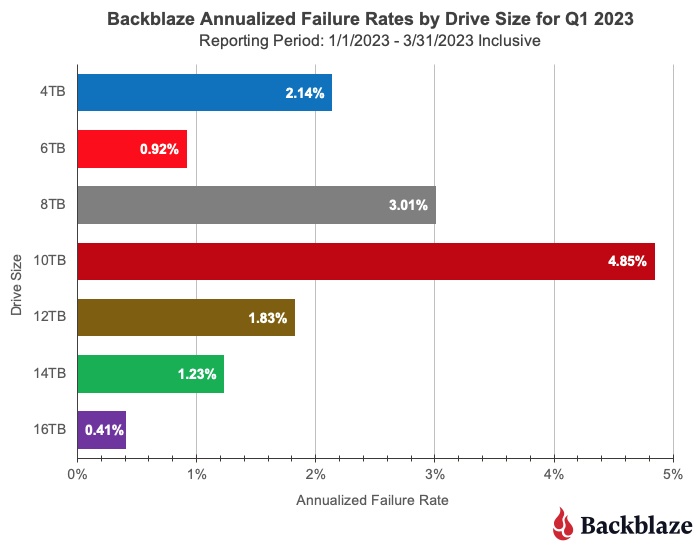

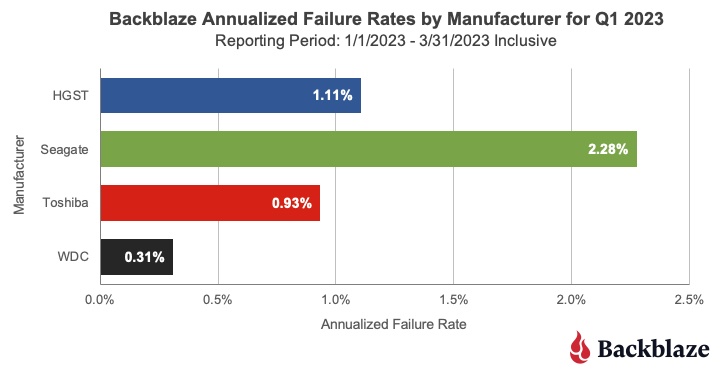

Количество отказов в годовом исчислении за 1 квартал 2023 г. по размеру накопителя и производителю

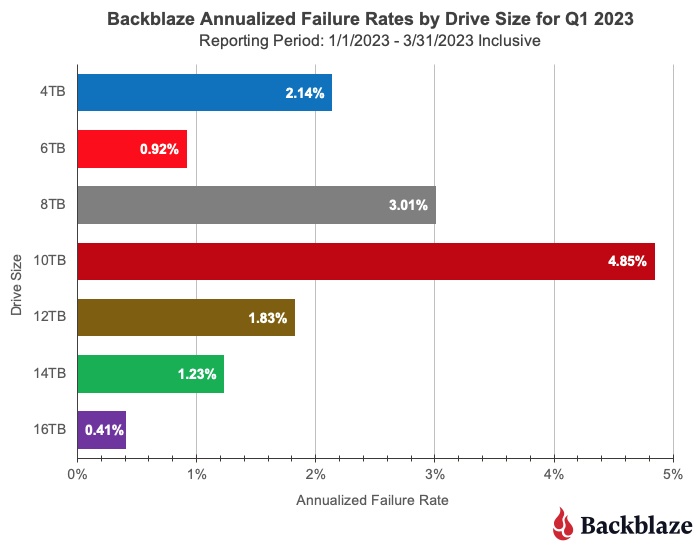

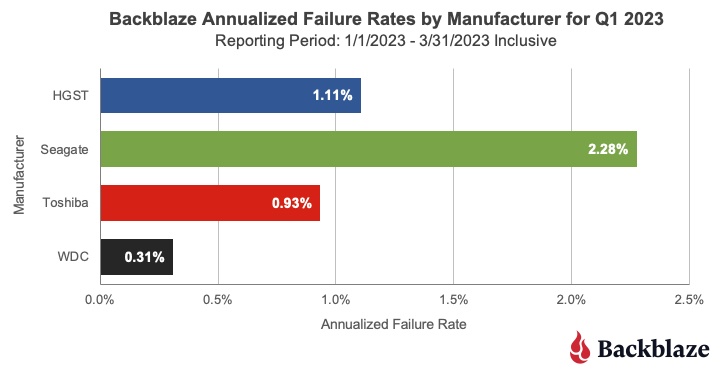

На приведенных ниже диаграммах приведены данные за первый квартал 2023 года сначала по размеру диска, а затем по производителю.

Хотя мы включили все размеры дисков, которые мы используем в настоящее время, размеры дисков 6 ТБ и 10 ТБ состоят из одной модели для каждой, и у каждого есть ограниченное количество дней работы в квартале: 79 651 для дисков 6 ТБ и 105 443 для дисков 10 ТБ. Каждый из оставшихся размеров дисков имеет не менее 2,2 миллиона дней работы, что делает их квартальные годовые коэффициенты отказов более надежными.

В этой таблице объединены все модели приводов производителя независимо от их возраста. В нашем случае многие из старых моделей накопителей произведены Seagate, и это помогает повысить их общую AFR. Например, 60 % дисков емкостью 4 ТБ произведены Seagate, и их средний возраст составляет 89 месяцев, а более 95 % находящихся в производстве дисков емкостью 8 ТБ произведены Seagate, и им в среднем более 70 месяцев. Как мы видели, изучая ожидаемый срок службы жесткого диска с помощью кривой ванны, старые диски имеют тенденцию к более частым отказам.

Тем не менее, есть исключения, такие как наш бесстрашный парк дисков Seagate емкостью 6 ТБ, средний возраст которых составляет 95,4 месяца, а показатель AFR за первый квартал 2023 года составляет 0,92 %, а показатель AFR за весь срок службы — 0,89 %, как мы увидим далее в этом отчете.

Средний возраст отказа диска

Недавно ребята из Blocks & Files опубликовали статью, в которой описывается средний возраст жесткого диска на момент выхода из строя. Статья основана на работе Тимоти Берли в Secure Data Recovery. Подводя итог, статья показала, что для 2007 проанализированных отказавших жестких дисков средний возраст выхода из строя составил 1051 день, или два года и 10 месяцев. Мы подумали, что это интересный способ взглянуть на отказ диска, и мы хотели знать, что мы обнаружим, если зададим тот же вопрос о наших данных Drive Stats. Они также определили текущее количество ожидающих секторов для каждого отказавшего диска, но сегодня мы сосредоточимся на среднем возрасте отказа диска.

Начиная

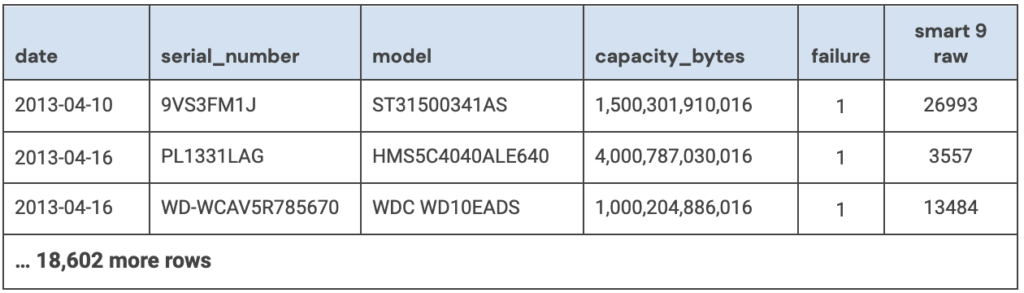

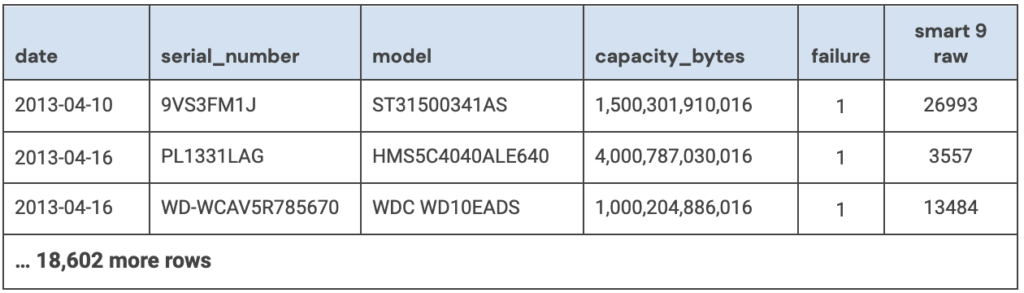

В статье не указано, как они собирали количество времени, в течение которого диск работал до того, как он вышел из строя, но мы предполагаем, что они использовали необработанное значение SMART 9 для часов включения. Учитывая это, нашей первой задачей было собрать все неисправные диски в нашем наборе данных и записать время работы каждого диска. Этот запрос выдал список из 18 605 дисков, которые вышли из строя в период с 10 апреля 2013 г. по 30 марта 2023 г. включительно.

Для каждого вышедшего из строя диска мы записали дату, серийный_номер, модель, емкость_диска, сбой и необработанное значение SMART 9. Образец ниже.

Чтобы начать процесс очистки данных, мы сначала удалили из набора данных 1355 неисправных загрузочных дисков, оставив нам 17 250 дисков с данными.

Затем мы удалили 95 дисков по одной из следующих причин:

- На отказавшем диске не было записанных данных или был ноль в атрибуте SMART 9 raw.

- Неисправный диск имел данные за пределами допустимых значений в одном или нескольких полях.

Например, поле capacity_bytes было отрицательным или модель повреждена, то есть неизвестна или непонятна.

В обоих этих случаях рассматриваемые диски находились в неудовлетворительном состоянии на момент сбора данных, и поэтому любые другие собранные данные могли быть ненадежными.

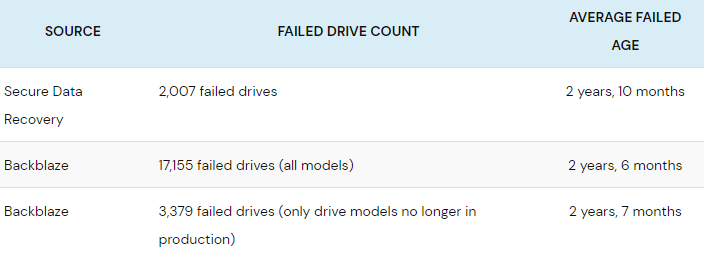

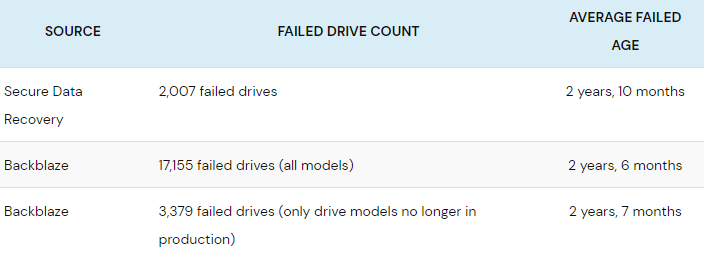

У нас осталось 17 155 неисправных дисков для анализа. Когда мы вычисляем средний возраст, в котором эта когорта дисков вышла из строя, мы получаем 22 360 часов, что составляет 932 дня, или чуть более двух лет и шести месяцев. Это довольно близко к двум годам и 10 месяцам из статьи Blocks & Files, но прежде чем мы подтвердим их цифры, давайте немного углубимся в наши результаты.

Средний возраст отказов дисков по моделям и размерам

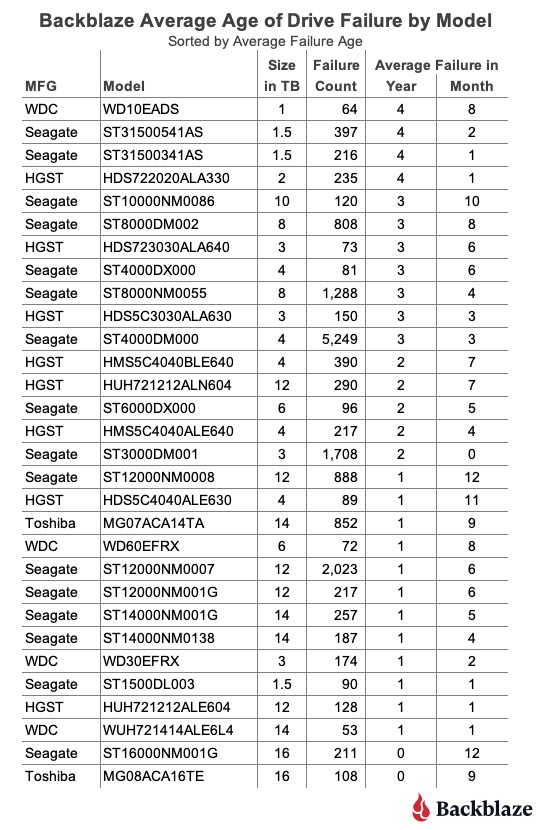

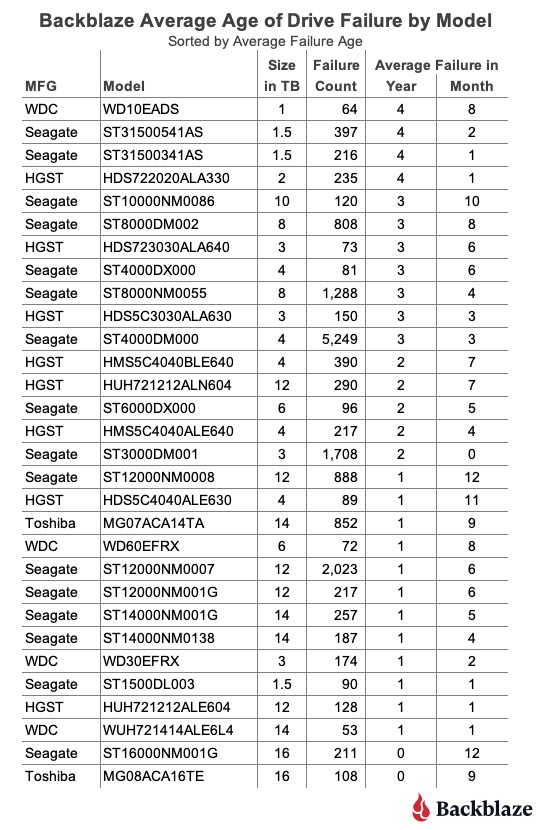

Наш набор данных Drive Stats содержит сведения о сбоях дисков для 72 моделей дисков, и это число не включает загрузочные диски. Чтобы сделать нашу таблицу более управляемой, мы ограничили список теми моделями накопителей, в которых зафиксировано 50 и более отказов. Полученный список содержит 30 моделей, которые мы отсортировали по среднему возрасту отказов:

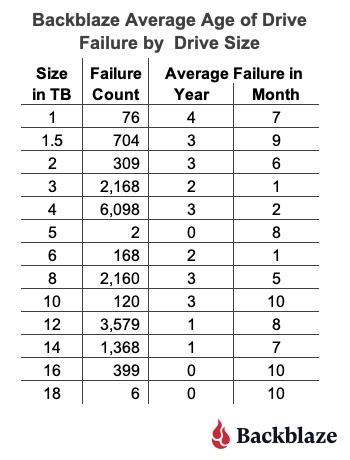

Как и следовало ожидать, существуют модели накопителей старше и младше нашего общего среднего возраста отказов, составляющего два года и шесть месяцев. Одно наблюдение состоит в том, что средний срок отказа многих моделей накопителей меньшего размера (1 ТБ, 1,5 ТБ, 2 ТБ и т. д.) выше, чем наш общий средний показатель, составляющий два года и шесть месяцев. И наоборот, для многих моделей дисков большего размера (12 ТБ, 14 ТБ и т. д.) средний срок службы после отказа был ниже среднего. Прежде чем делать какие-либо выводы, давайте посмотрим, что произойдет, если мы рассмотрим средний возраст отказа по размеру диска, как показано ниже.

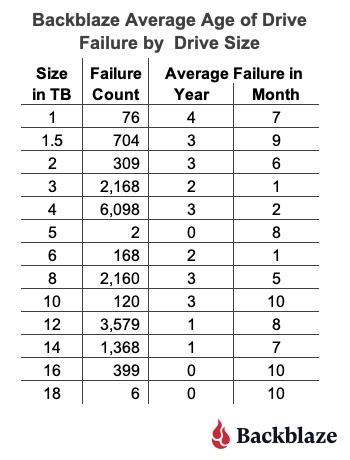

Эта диаграмма, по-видимому, подтверждает общую тенденцию, заключающуюся в том, что средний срок службы до отказа небольших моделей дисков выше, чем у более крупных моделей.

На этом этапе вы можете начать размышлять о том, повлияют ли технологии в более крупных накопителях, такие как дополнительные пластины, повышенная плотность записи или даже использование гелия, на средний срок службы этих накопителей. Но как сказал бы невозмутимый адмирал Акбар:

«Это ловушка»

Ловушка заключается в том, что набор данных для моделей дисков меньшего размера в нашем случае является полным — в нашем наборе данных больше нет дисков емкостью 1 ТБ, 1,5 ТБ, 2 ТБ, 3 ТБ или даже 5 ТБ. Наоборот, большинство моделей дисков большего размера все еще находятся в эксплуатации и, следовательно, они «еще не перестали выходить из строя». Другими словами, поскольку эти более крупные диски будут продолжать выходить из строя в ближайшие месяцы и годы, они могут увеличить или уменьшить средний срок отказа этой модели диска.

Новая надежда

Один из способов продвинуться вперед на этом этапе — ограничить наши вычисления только теми моделями дисков, которые больше не используются в наших центрах обработки данных. Сделав это, мы обнаружим, что у нас есть 35 моделей дисков, состоящих из 3379 дисков, средний срок эксплуатации которых составляет два года и семь месяцев.

Ловушка или нет, но наши результаты согласуются со статьей Blocks & Files, поскольку их средний возраст неудачного набора данных составляет два года и 10 месяцев. Будет интересно посмотреть, как это сравнение сохранится с течением времени, поскольку все больше моделей накопителей в нашем наборе данных заканчивают свой срок службы Backblaze.

Второй способ взглянуть на неисправность диска — рассмотреть проблему с точки зрения ожидаемого срока службы. Этот подход берет пример из биологии и использует методы Каплана-Мейера для получения кривых ожидаемой продолжительности жизни (также известных как выживание) для различных когорт, в нашем случае для моделей жестких дисков. Мы использовали такие кривые ранее в наших сообщениях в блогах Hard Drive Life Expectancy и Bathtub Curve. Такой подход позволяет нам отслеживать частоту отказов с течением времени и помогает ответить на такие вопросы, как «Если я куплю диск сегодня, каковы шансы, что он прослужит x лет?»

Давайте подведем итоги

У нас есть три разных, но похожих значения среднего срока службы жестких дисков до отказа, и они следующие:

Когда мы впервые увидели средний возраст отказов безопасного восстановления данных, мы подумали, что два года и 10 месяцев — это слишком мало. Мы были удивлены тем, что нам рассказали наши данные, но немного математики еще никому не повредило. Учитывая, что мы всегда добавляем дополнительные неисправные диски в наш набор данных и попутно выводим из эксплуатации модели дисков, мы продолжим отслеживать средний возраст отказов наших моделей дисков и сообщим, если обнаружим что-нибудь интересное.

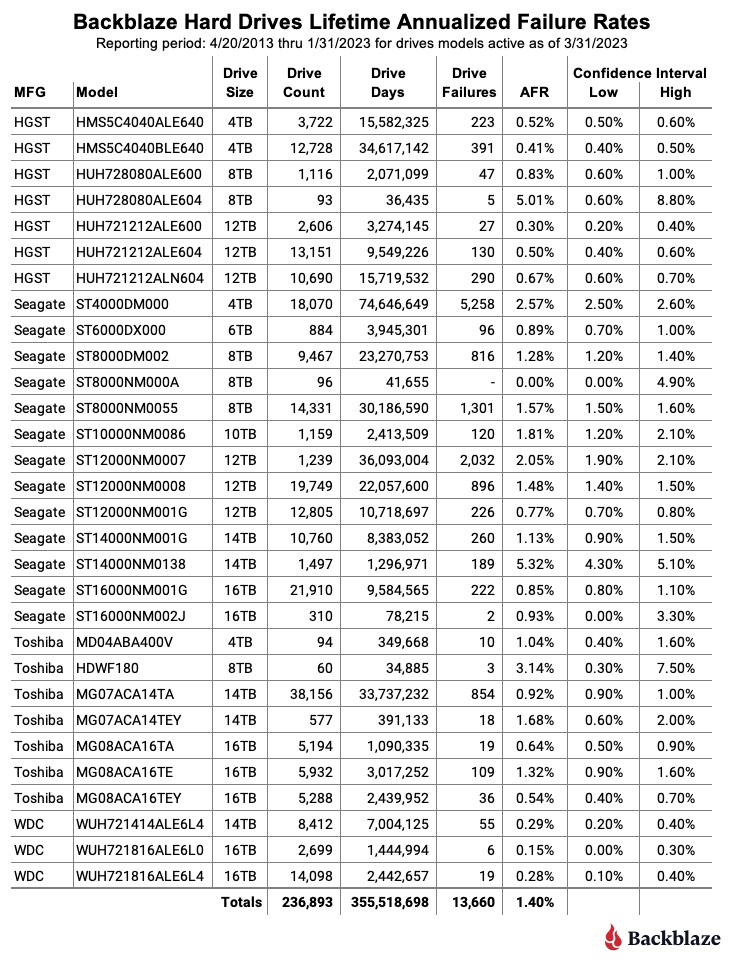

Частота отказов жестких дисков за весь срок службы

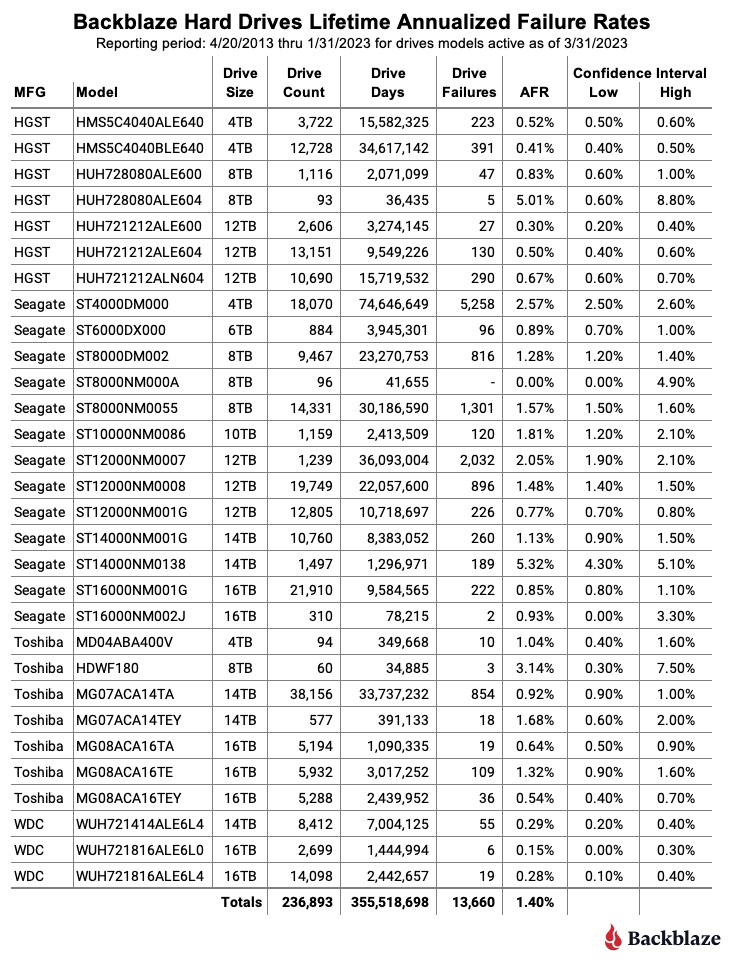

По состоянию на 31 марта 2023 г. мы отслеживали 237 278 жестких дисков. Для нашего анализа жизненного цикла мы удалили 385 дисков, которые использовались только в целях тестирования или не имели по крайней мере 60 дисков. Таким образом, у нас остается 236 893 жестких диска, сгруппированных по 30 различным моделям, для анализа приведенной ниже таблицы срока службы.

Примечания и наблюдения о статистике жизни

Примечания и наблюдения о статистике жизни

Срок службы AFR для всех перечисленных выше дисков составляет 1,40%. Это незначительное увеличение по сравнению с предыдущим кварталом на 1,39%. Число AFR за весь срок службы для всех наших жестких дисков, по-видимому, составляет около 1,40%, хотя каждая модель диска имеет свое уникальное значение AFR.

В течение последних 10 лет мы собираем и храним данные Drive Stats, которые являются источником AFR за весь срок службы, перечисленных в таблице выше. Но зачем вообще отслеживать данные? Что ж, помимо создания этого отчета каждый квартал, мы используем данные для внутреннего использования, чтобы помочь нам вести наш бизнес. Хотя на решения, которые мы принимаем, влияет множество других факторов, данные Drive Stats помогают быстрее выявлять потенциальные проблемы, позволяют нам предпринимать более обоснованные действия, связанные с дисками, и в целом добавляют уровень уверенности в решениях, которые мы принимаем на основе дисков.