Сегодня расскажем о новых конфигурациях выделенных серверов на основе недавно выпущенных серверных процессоров серии EPYC 4004, которые уже доступны у нас на сайте.

Данная линейка процессоров заявлена как конкурент Xeon E-2400 и идеально подходит для задач, требующих высокой производительности на ядро, сохраняя при этом высокую производительность в многопоточных приложениях.

EPYC 4004 – первый релиз AMD в данном сегменте рынка, предоставляющий высокую производительность на ядро, полюбившуюся нам всем в серии Ryzen, и дополненный официальной поддержкой ECC-памяти до 192 GB DDR5-5200 и другими фичами безопасности. AMD заявляет о значительном приросте производительности по сравнению с решениями конкурентов:

Но насколько реальны данные заявления? Давайте посмотрим на сторонние бенчмарки!

Сперва взглянем на производительность при компиляции кода в сравнении с флагманом E-серии Intel – Xeon E-2488, источник: Phoronix.

В целом в задачах, связанных с компиляцией кода, линейка AMD EPYC 4004 показывает себя уверенно в данном ценовом сегменте, что делает эти процессоры хорошим выбором для CI/CD-серверов и окружений сборки.

Компиляция кода – это здорово, но что насчет производительности в более привычных при хостинге сайтов приложениях?

Новые процессоры при работе с nginx показывают примерно равную производительность при одинаковом количестве ядер, но значительно вырываются вперед по мере увеличения количества ядер.

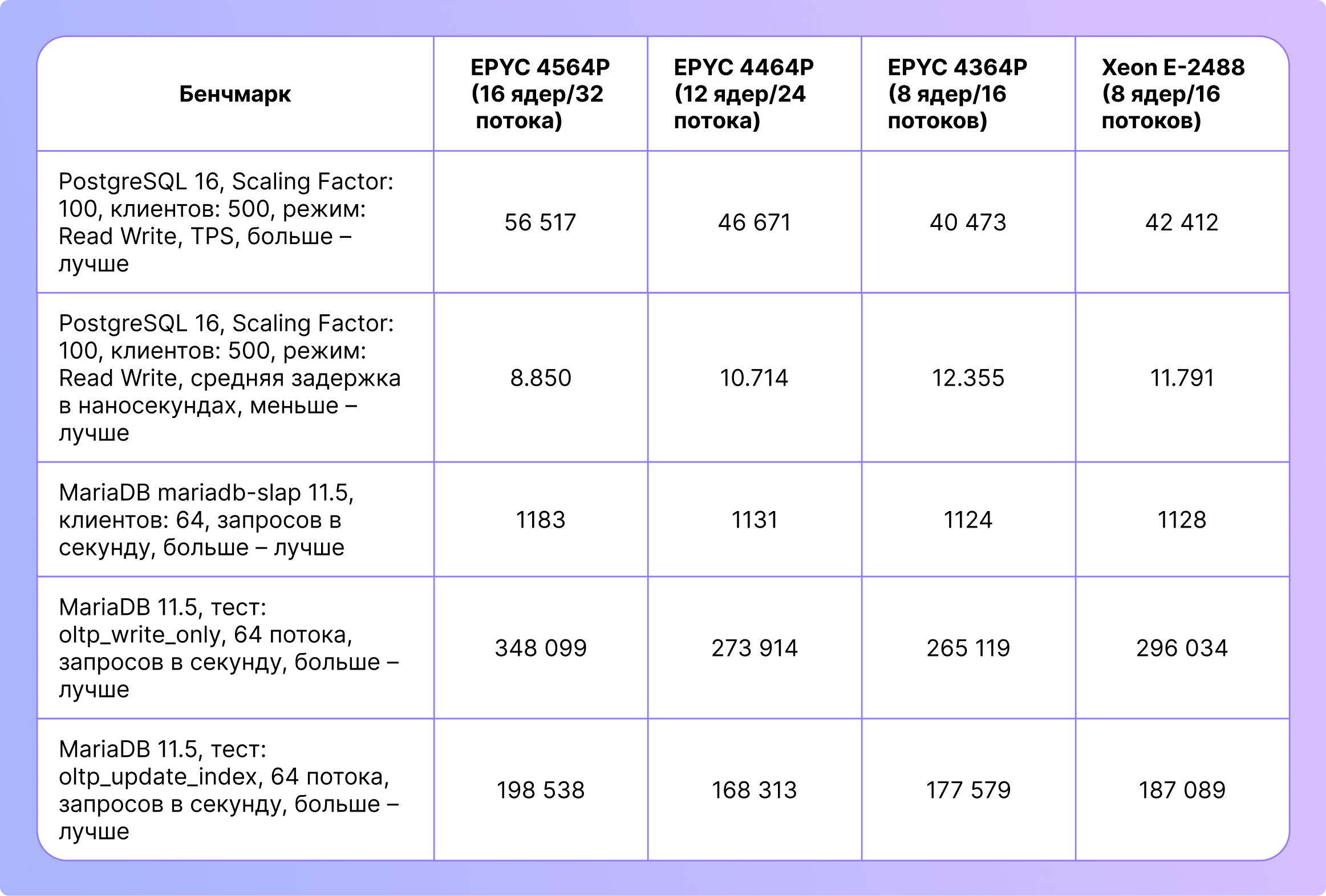

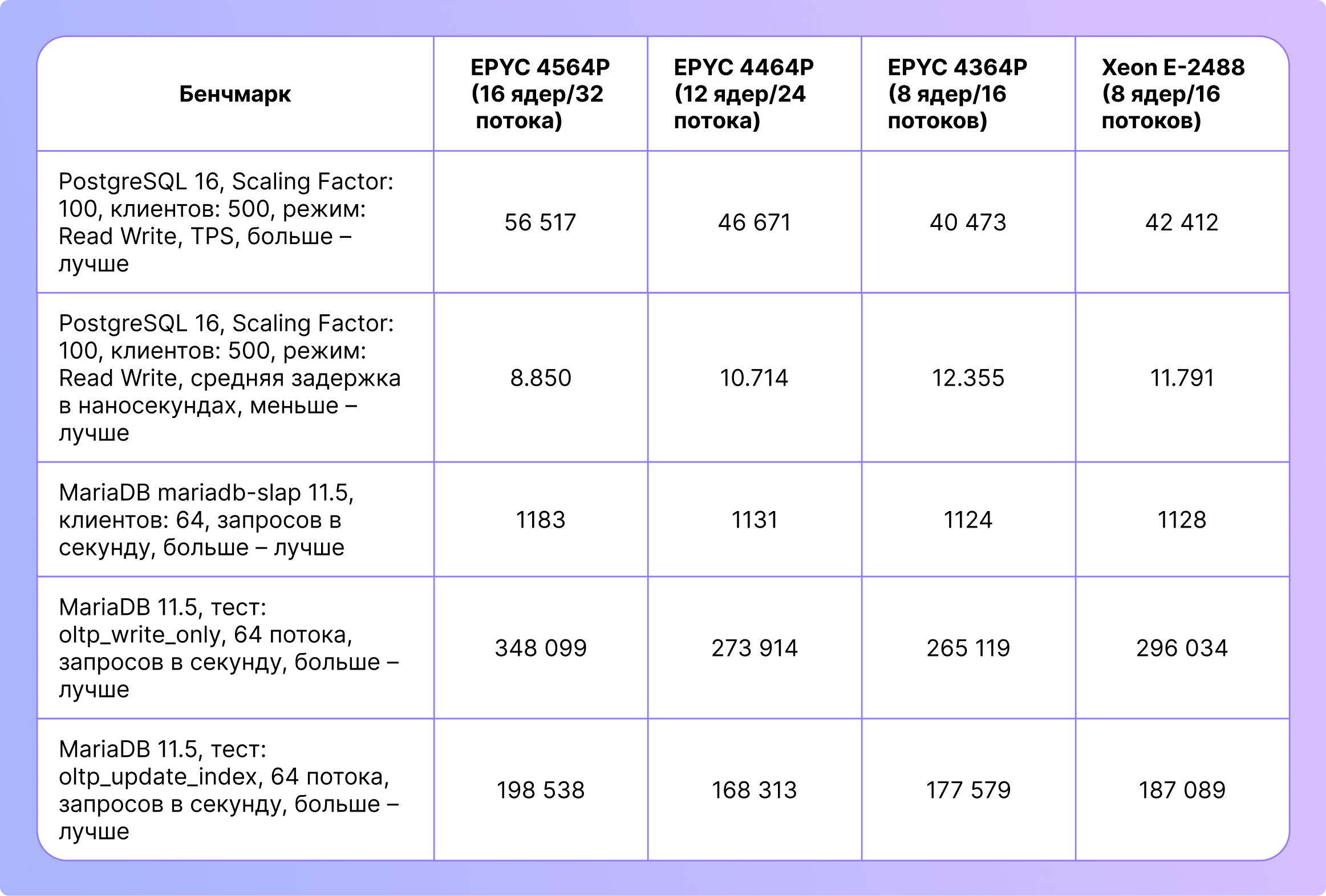

Одна из частых задач, выполняемых серверами, – работа с базами данных различных видов. Взглянем на производительность при работе с PostgreSQL, MariaDB, Memcached и Clickhouse.

При работе с классическими реляционными СУБД преимущество в чистой производительности без учета энергоэффективности смещается в зависимости от количества ядер – при равной конфигурации решение от Intel выигрывает, а вот по мере увеличения количества ядер EPYC вырывается вперед.

В Clickhouse и Memcached преимущество по большей части оказывается за решением от Intel, проигрывая только 16-ядерной версии в большинстве бенчмарков.

Заключение

Новые процессоры от AMD хорошо показывают себя в различных видах задач, демонстрируя высокую производительность на ядро подобно десктопным собратьям, сохраняя при этом официальную поддержку таких важных функций, как ECC-память. Заинтересовали? Тогда приглашаем протестировать новые процессоры самостоятельно.

На момент написания статьи для заказа доступны готовые серверы следующих конфигураций:

В бюджете 25–35 тысяч рублей в месяц мы собрали отличный вариант конфигурации для требовательных проектов, которым необходима возможность дальнейшего масштабирования.

Если ваш бюджет ограничен, то оптимальным решением могут быть конфигурации на процессорах линейки Xeon E, такие как: Blade 2 и Blade 3.

Если же вам нужно более персонализированное решение с данными процессорами – мы всегда готовы собрать сервер под ваши нужды.

beget.com/ru/dedicated-servers