Аукцион свежего оборудования: почему подержанные серверы могут быть выгодны

Аукцион свежего оборудования: почему подержанные серверы могут быть выгодны

Для компаний и разработчиков, стремящихся к масштабированию без лишних трат, покупка серверов на аукционе может быть заманчивым вариантом. На GTHost наш аукцион выделенных серверов предлагает доступ к подержанному оборудованию по сниженным ценам — иногда значительно ниже, чем на новые серверы. Но подходит ли этот вариант вашим потребностям? Давайте разберем преимущества, возможные компромиссы и выясним, какие пользователи получают наибольшую выгоду от продажи выделенных и физических серверов на аукционе.

Что такое аукцион серверов и в чем его суть?

Аукцион серверов — это торговая площадка, на которой такие провайдеры, как GTHost, выставляют на продажу бывшие в употреблении или выведенные из эксплуатации серверы по сниженным ценам. Эти машины могли быть исключены из стандартных предложений аренды в связи с модернизацией оборудования или обновлением инвентаря, но они по-прежнему полностью работоспособны. Цель аукциона серверов — предоставить пользователям доступ к доступному и работоспособному оборудованию, которое иначе оставалось бы без дела. Это выгодно обеим сторонам: хостинг-провайдеры освобождают место, а клиенты получают недорогие серверы для разработки, тестирования или даже для небольших производственных задач.

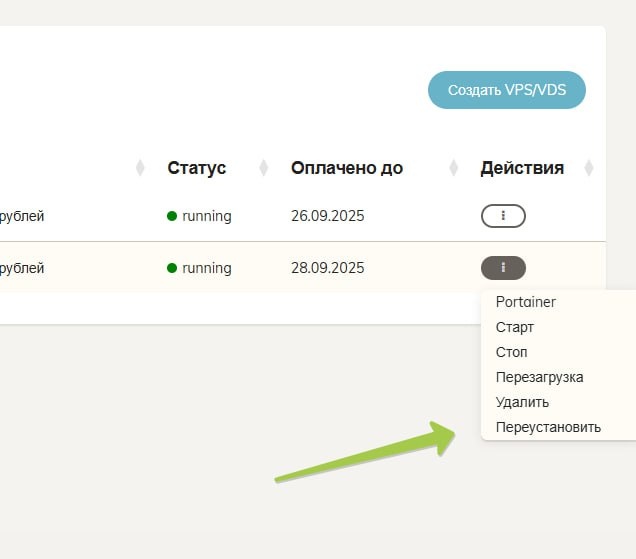

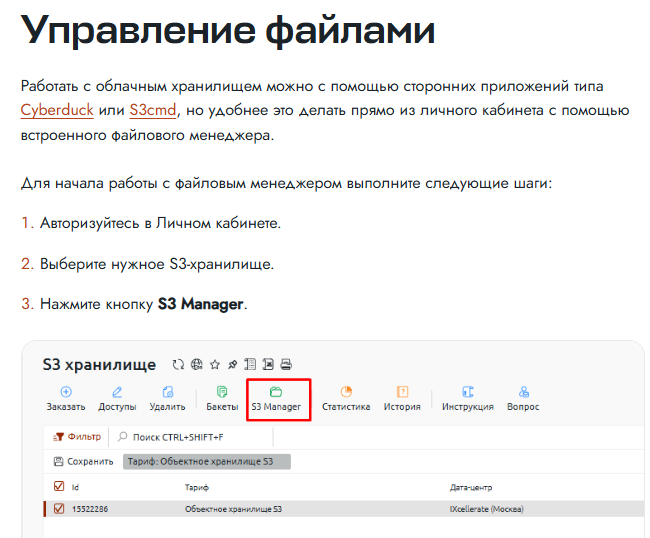

В GTHost аукцион очень прост. Вы просматриваете доступные серверы, выбираете конфигурацию и разворачиваете её — часто в течение нескольких минут. Никаких торгов или ожидания; это модель с фиксированной ценой и принципом «кто первый пришёл, тот и обслужен», разработанная для быстрого доступа и минимизации сложностей.

Почему стоит выбрать аукционные серверы?

Покупка сервера на аукционе даёт одно очевидное преимущество: экономию средств. Эти серверы часто сняты с производства, но всё ещё достаточно мощны и надёжны для многих бизнес-задач. GTHost тестирует и проверяет всё оборудование перед его выставлением на аукцион, а это значит, что вы не получите ничего сломанного, а получите что-то по доступной цене.

Например, высокопроизводительный сервер стоимостью 150–250 долларов в месяц может быть доступен на аукционе за 70–120 долларов в месяц. Это существенная скидка, особенно для стартапов, системных администраторов, тестирующих среды, или компаний, которым требуется краткосрочная производительность без долгосрочного контракта.

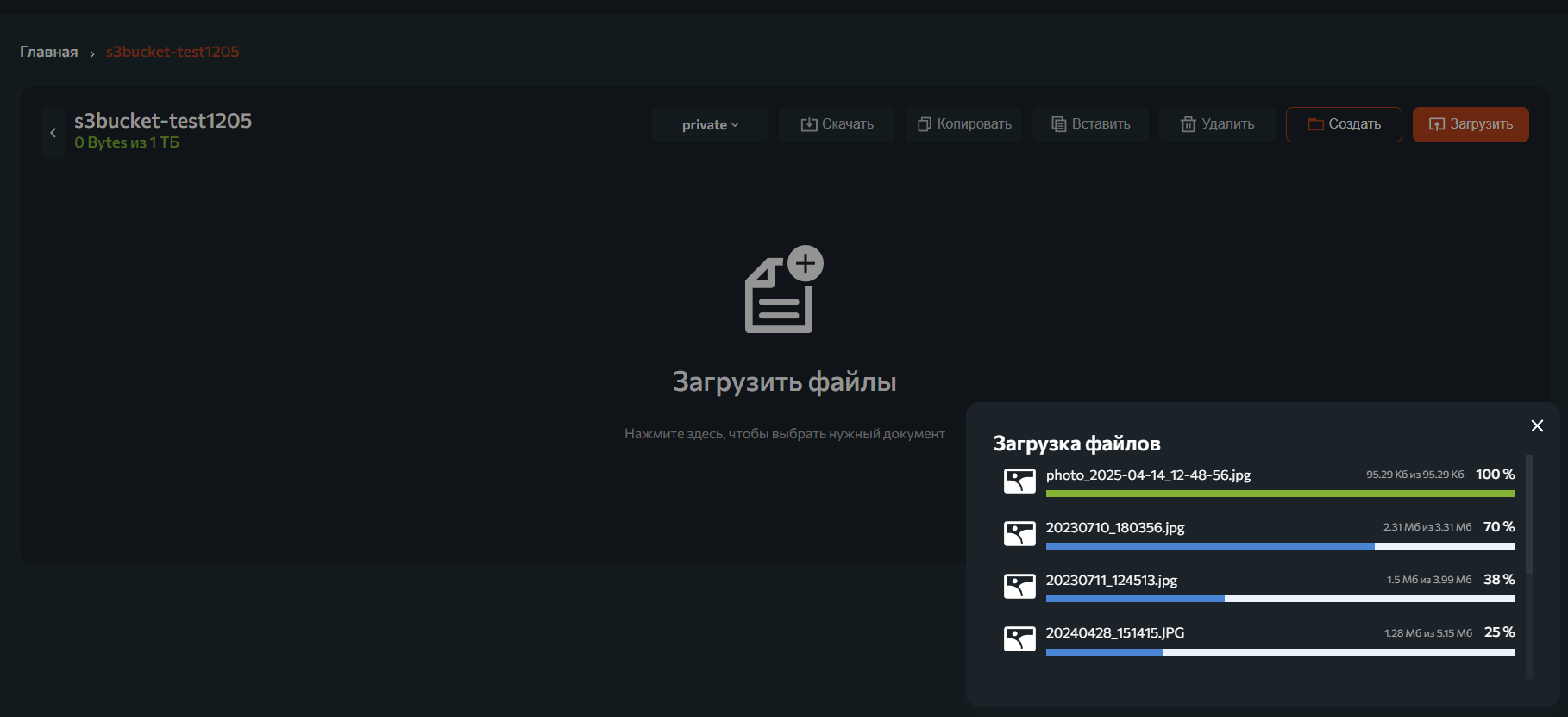

Некоторые серверы на аукционе предлагают 10–20 ТБ памяти и большой объём оперативной памяти за половину стоимости новых моделей. Это означает больше места для резервных копий, журналов, больших файлов или приложений для работы с большими данными — без ущерба для вашего бюджета.

В чем подвох?

Аукционные серверы не всегда идеально подходят для любого случая. Вот что следует учитывать:

- Ограниченные возможности настройки: вы покупаете то, что доступно. Возможно, у вас не будет возможности выбрать желаемый процессор, объём SSD или конфигурацию оперативной памяти.

- Устаревшее оборудование: хотя серверы, выставленные на аукцион, все еще работоспособны, они могут не включать компоненты последнего поколения, такие как процессоры EPYC или хранилище NVMe.

- Более короткие гарантии или их отсутствие: большинство аукционных серверов предлагаются «как есть» или с сокращенным объемом поддержки по сравнению с новыми серверами.

- Если вашему бизнесу требуется максимальное время безотказной работы, высочайшая производительность или индивидуальные конфигурации, совершенно новый выделенный сервер может оказаться более выгодным в долгосрочной перспективе.

Кому следует рассмотреть возможность аукционов серверов?

Аукцион GTHost особенно полезен для:

- Системные администраторы и разработчики, создающие тестовые среды или промежуточные серверы.

- Стартапы и малый бизнес, которым требуется надежное хранилище при ограниченном бюджете.

- Краткосрочные проекты, такие как миграция данных, резервное копирование, архивирование файлов или сезонные рабочие нагрузки.

- Образовательные учреждения или учебные лаборатории, которым требуется масштабируемая, но недорогая инфраструктура.

Если вы знаете свою рабочую нагрузку и вам не нужны новейшие характеристики, серверы, выставленные на аукцион, могут обеспечить исключительную ценность.

Почему аукцион серверов GTHost работает

В отличие от многих хостинг-провайдеров, аукционные серверы GTHost готовы к мгновенному развертыванию — часто в течение 15 минут. Вы получаете доступ к тем же функциям, что и на новых серверах: неограниченная пропускная способность, полное удалённое управление по IPMI и развёртывание в 21 центре обработки данных по всему миру, включая Канаду, США и Европу.

Несмотря на более низкую цену, вы не жертвуете качеством сети или доступом. Служба поддержки работает так же быстро, а процесс настройки сервера не менее быстрый.

Когда следует переходить на обычные серверы?

Выбирайте новые серверы, если:

- Вам нужны скорости NVMe, возможность настройки RAID или высокодоступные конфигурации.

- Вы размещаете критически важные производственные рабочие нагрузки, такие как базы данных клиентов, платформы электронной коммерции или SaaS-приложения.

- Вашей компании требуются сертификаты соответствия, специальные контракты на поддержку или соглашения об уровне обслуживания (SLA) по оборудованию.

- Вам нужна новейшая архитектура ЦП (например, AMD EPYC, Intel Xeon Gold), а также память или сетевые возможности нового поколения.

Совершенно новые серверы также предоставляют вам полный контроль над характеристиками и более длительный срок службы в условиях интенсивной нагрузки.

Покупка подержанных выделенных серверов через аукцион GTHost может стать разумным и экономичным решением для многих пользователей. Это особенно актуально, когда скорость, гибкость и бюджет важнее, чем необходимость в передовых характеристиках. Но если ваш бизнес зависит от максимальной производительности или определённых конфигураций, новый сервер станет более выгодной долгосрочной инвестицией.

Хорошие новости? Благодаря обоим вариантам — аукциону и совершенно новому — GTHost позволяет масштабировать инфраструктуру на ваших условиях. Независимо от того, запускаете ли вы стартап или управляете корпоративным хранилищем больших масштабов, у нас есть решение, которое вас ждёт.

gthost.com/server-auction