SBG

SBG1:

SBG4:

SBG3:

UPDATE

SBG3:

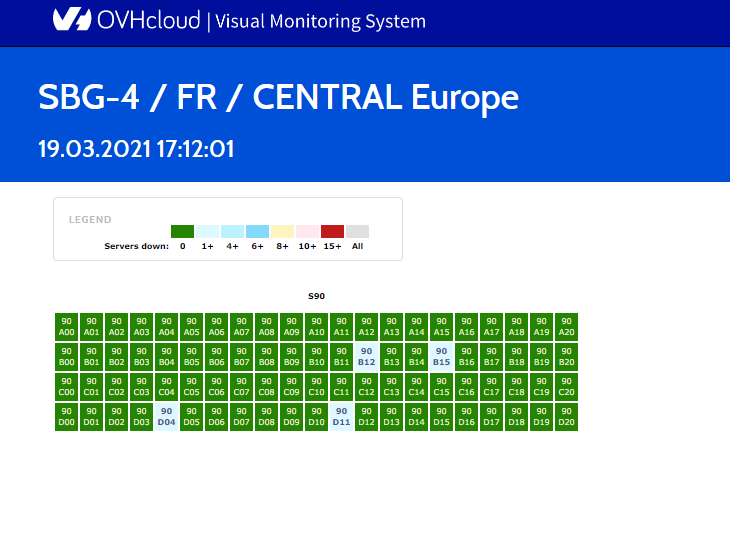

SBG4:

SBG1:

travaux.ovh.net/vms/index_sbg3.html

- Мы не планируем перезапускать SBG1. Навсегда.

- Серверы в 61A / D + 62A / D будут перемещены в SBG4.

- Серверы в 61E / 62E будут перемещены в Croix и очищены, а затем перезапущены в RBX / GRA.

SBG4:

- работает от питания + сеть от SBG3. Затем перезапускаем SBG4.

SBG3:

- В DC работает 60 техников. мы очищаем серверы и перезапускаем.

- Все органы власти (пожарные, префектура, полиция, страховые компании, эксперты и т.д.) Очень поддерживают и понимают важность перезапуска ДЦ. Все делают лучше.

UPDATE

SBG3:

- Больше стоек ВВЕРХ. 60 технических специалистов работают в SBG3. 24/24. Нам помогают 2 компании, специалисты по очистке серверов после пожара.

SBG4:

- Новый кабель питания будет подключен от SBG3 к SBG4.

SBG1:

- работают над планом по переносу серверов на RBX / GRA + SBG4.

travaux.ovh.net/vms/index_sbg3.html