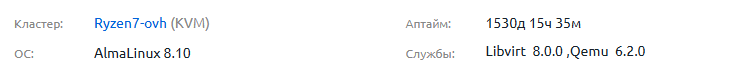

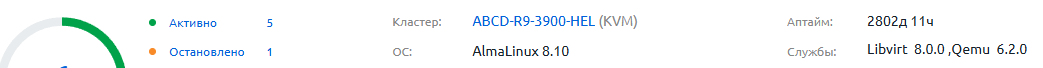

В последние месяцы дата-центр OVH существенно повысил стоимость аренды серверов. Причина — глобальный дефицит комплектующих и огромный спрос на мощности из-за бума искусственного интеллекта. Как реселлер OVH мы не могли оставить цены прежними, иначе начали бы работать в минус.

С 3 марта 2026 года на ABCD.HOST действуют новые цены:

- VPS-1 (4 ядра / 8 GB / 75 GB NVMe / 400Mbps) — 11.9 €

- VPS-2 (6 ядер / 12 GB / 100 GB NVMe / 1Gbps) — 17.9 €

- VPS-3 (8 ядер / 24 GB / 200 GB NVMe / 1.5Gbps) — 33.9 €

- VPS-4 (12 ядер / 48 GB / 300 GB NVMe / 2Gbps) — 59.9 €

- VPS-5 (16 ядер / 64 GB / 350 GB NVMe / 2.5Gbps) — 87.9 €

- VPS-6 (24 ядра / 96 GB / 400 GB NVMe / 3 Gbps) — 114 €

Арендовать VPS можно в 18 локациях: Германия — Лимбург, Франция — Рубе, Франция — Гравлин, Франция — Страсбург, Великобритания — Эрит, Польша — Варшава, Италия — Милан, Швейцария — Цюрих, Чехия — Прага, Испания — Мадрид, Нидерланды — Амстердам, Бельгия — Брюссель, Франция — Марсель, Австрия — Вена, Канада — Восток — Босарнуа, Сингапур — Сингапур, Австралия — Сидней, Индия — Мумбаи.

Мы сделали повышение максимально мягким и честным. Средний рост составил 25–30 %, при этом все характеристики остались прежними: Европа, NVMe SSD, безлимитный трафик, защита Anti-DDoS и скорость до 3 Гбит/с.

Хорошая новость! Мы запускаем постоянную акцию: Экономьте 9 % при аренде сервера на 6 месяцев и 19 % при аренде на 12 месяцев.

Примеры выгоды:

VPS-1 на год: вместо 142.8 € всего 115.67 € (~9.64 €/мес)

VPS-6 на год: вместо 1368 € всего 1108.08 € (~92.34 €/мес)

Мы ценим каждого клиента и стараемся держать цены одними из самых привлекательных в Европе при таком железе и скорости. Спасибо, что остаётесь с ABCD.HOST ❤️

Все старые клиенты остаются на прежних тарифах.

Готовы к заказу? Переходите в раздел VPS —

abcd.host/vps

С уважением,

Команда ABCD.HOST