18 июня 2025 г.

18 июня 2025 г.

Рег.ру и Fozzy договорились о переводе клиентов в инфраструктуру Рег.ру

Российская технологическая компания Рег.ру и хостинг-провайдер Fozzy заключили соглашение о переходе клиентов Fozzy в инфраструктуру Рег.ру.

Хостинг-провайдер Fozzy был основан в 2012 году. Компания специализируется на предоставлении хостинговых услуг владельцам сайтов и интернет-проектов, веб-мастерам, дизайн-студиям, веб-разработчикам, системным администраторам.

Миграция клиентов происходит на фоне закрытия проекта Fozzy. Клиентам предоставлен расширенный период для миграции (не менее 60 календарных дней) и техническая поддержка. Текущий баланс и предзаказанные услуги будут сохранены при переезде. Более подробная информация предоставлена клиентам на привязанную к аккаунту электронную почту.

Миграция пользователей Fozzy будет происходить в автоматическом режиме при усиленной поддержке технических специалистов обеих компаний.

«Рег.ру активно наращивает свои доли как в облачных услугах, так и в хостинговых. Мы открыты и для новых предложений о слияниях и поглощениях от небольших компаний. С технической стороны у нас всё подготовлено, процесс отлажен, и миграция проходит практически незаметно для пользователя. Помимо хостинг-услуг новым клиентам будут доступны все продукты экосистемы Рег.ру, в том числе и облачные решения», — комментирует Сергей Рыжков, руководитель департамента хостинга и профессиональных сервисов Рег.ру.

Сегодня доля Рег.ру на рынке хостинговых услуг составляет 16%. В 2023 году на фоне новостей о создании государственного реестра хостинг-провайдеров, исполнение требований которого могло потребовать дополнительных расходов, достаточно существенных для игроков с небольшими клиентскими базами в хостинге, Рег.ру объявила о стремлении приобрести компании, для которых хостинг не является приоритетным видом деятельности, или же их клиентские базы. Ранее компания сообщала о переводе в свой периметр клиентов компаний Reddock и Ethernalhost.

17 июня 2025 г.

Рег.ру вдвое нарастил пользователей облачных услуг

В публичное облако Рег.ру мигрировали 12 тысяч клиентов, а суммарно всеми облачными сервисами компании сегодня пользуется более 25 тысяч компаний и частных лиц.

Российская технологическая компания Рег.ру продолжает усиливать позиции на рынке облачных услуг. Облачная платформа Рег.ру за два года существенно нарастила число активных пользователей — к Облаку Рег.ру подключились 12 тысяч клиентов, это вдвое больше прошлого года, а общее число пользователей облачных услуг превысило 25 тысяч. Наибольшую долю среди заказчиков составляют компании из IT-сектора — 42%, из сферы производства — 13%, из сегмента розничной торговли и e-commerce — 11%. Облако Рег.ру активно применяется для разработки, тестирования и размещения IT-инфраструктуры любого масштаба и сложности.

С активным ростом компания нарастила и собственную технологическую базу — в 2024 году был запущен третий регион на базе технопарка «Жигулевская долина» в Самарской области, а также завершен переезд на площадку нового «Дата-Центра N1» в Санкт-Петербурге. Сегодня серверы Рег.ру размещены в десяти дата-центрах РФ уровня Tier III (Uptime Institute), количество стоек достигло 550, а общая пропускная способность оптических каналов связи выросла до 200 Гбит.

Компания сделала важный шаг на пути развития в качестве облачного провайдера: расширила SLA для облачных и bare-metal сервисов и обновила Pay-as-you-go учет, а облачная платформа Рег.ру была включена в реестр российского ПО. Кроме того, Рег.ру продолжает расширять экспертизу в области информационной безопасности. Компания прошла аттестацию ISO, подтверждающую соответствие международным требованиям кибербезопасности, и запустила обновленную линейку ИБ-сервисов, в числе которых защита от DDoS-атак уровней L3, L4 и L7, облачный WAF, публичные плавающие IP-адреса и приватные сети для управления локальными сетями в облаке.

«За два года наша компания нарастила не только пользовательскую базу, но и собственную экспертизу, технологический и продуктовый стек. Рег.ру продолжает наращивать позиции не только в хостинговых, но и в облачных услугах. Мы прошли уже несколько успешных M&A сделок и открыты для новых предложений от других участников отрасли. В наших дальнейших планах продолжить наращивать долю и на рынке облачных услуг, уверенно расти в качестве надежного провайдера облачных решений», — говорит Евгений Мартынов, директор по информационным технологиям Рег.ру.

В Облаке Рег.ру было выпущено порядка 350 продуктовых релизов, среди ключевых — облачные серверы с GPU, объектное хранилище S3, KaaS (Kubernetes as a Service). А также были подключены расширенные инструменты управления сетевой инфраструктурой, бэкапы с гибкими политиками хранения, линейка выделенных CPU, ленточная система хранения для архивации данных объемом до нескольких петабайт. Общий объем хранящихся данных в Облаке Рег.ру превысил 2,7 Пбайт.

04 июня 2025 г.

Рег.ру помог цифровизировать в облаке 5 тысяч российских строительных компаний

Компания мигрировала в облако цифровой сервис для строительных, отделочных и архитектурных компаний от IT-разработчика Stworka.

Российская технологическая компания Рег.ру развернула отказоустойчивую облачную инфраструктуру для обслуживания цифровой ERP-системы и маркетплейса строительных материалов с более чем 1,5 млн товарных наименований от IT-разработчика Stworka, специализирующемся на автоматизации строительной отрасли.

Российская SaaS-платформа Stworka ориентирована на цифровизацию строительных и производственных компаний. В системе доступны решения для автоматизации документооборота, учета оборудования, контроля исполнения задач, закупок и логистики на объектах строительства.

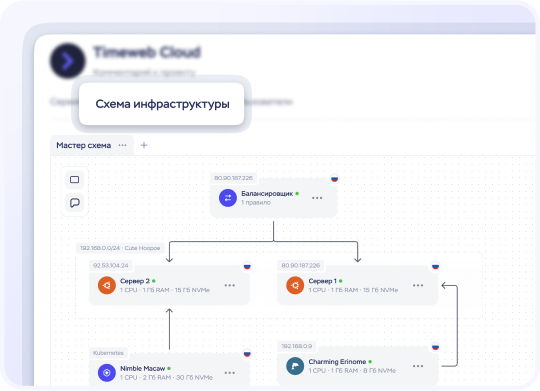

Облачная инфраструктура, развернутая специалистами Рег.ру, включает в себя распределенные облачные серверы, dev- и stage-контуры, виртуальные машины для мониторинга и управления разработкой, а также отказоустойчивую базу данных для хранения и обработки больших объемов прайс-листов. Производительность системы обеспечивается использованием NVMe-дисков и контейнерной архитектуры с Docker. В рамках проекта также было реализовано автоматическое резервное копирование. Время отклика серверной части системы в 90% случаев не превышает 300 миллисекунд — критичный показатель для ERP-систем и b2b-маркетплейсов.

«Наши сервисы обрабатывают десятки гигабайт прайс-листов ежедневно. От производительности зависит качество сервиса для пользователей — обновление остатков, цен и позиций должно происходить без задержек. В облаке Рег.ру мы получили стабильную инфраструктуру с необходимыми характеристиками и гибкостью масштабирования под рост нагрузки», — комментирует Александр Матовников, CEO Stworka.

«Для цифровых проектов в строительной и производственной отраслях особенно важны надежность, гибкость и управляемость инфраструктуры — от этого зависит эффективность работы подрядчиков и поставщиков на всех этапах проектов. Мы видим, что облако становится логичной технологической основой для таких решений. Облако Рег.ру спроектировано с учетом этих потребностей: мы обеспечиваем SLA до 99,98%, поддерживаем геораспределенность и возможность быстрого расширения мощностей под бизнес-задачи заказчиков», — отмечает Андрей Серпецкий, руководитель отдела продаж Рег.ру.

Облачная платформа Рег.ру построена на базе технологий OpenStack, KVM и Kubernetes. Решения используются для разработки, тестирования, запуска нагруженных бизнес-приложений и размещения IT-инфраструктуры компаний любого уровня.

29 мая 2025 г.

Рег.ру запустил сервис резервного копирования в облаке

Новое решение стало дополнением к комплексной системе защиты данных в облаке Рег.ру.

Российская технологическая компания Рег.ру начинает работу по запуску полноценного Backup as Service в облаке. Первый шаг — предоставление возможности создания пользовательских сценариев резервного копирования. Сервис направлен на обеспечение непрерывной работы виртуальных серверов за счет автоматизированного создания, хранения и восстановления резервных копий.

Облачное решение позволяет пользователям настраивать политику хранения бэкапа — от ежемесячной до ежедневной, и количество копий в хранилище. Консистентные резервные копии хранятся в удаленном объектном хранилище, что обеспечивает защиту от потери данных в случае локальных сбоев и повышает катастрофоустойчивость ИТ-инфраструктуры клиентов в целом, минимизируя риски. Сервис запущен одновременно во всех регионах присутствия.

«Обеспечение непрерывной работы бизнеса заказчика является первостепенной задачей для любого облачного провайдера. Каждая компания сегодня оперирует большим объемом важных данных, и их защита требует многоуровневого подхода. В нашей облачной платформе уже используются современные инструменты для защиты: шифрование, контроль доступа, системы обнаружения вторжений, решения по информационной безопасности и прочие. Теперь комплекс средств защиты данных включает и резервное копирование», — комментирует Анна Абрамова, руководитель направления разработки облачных решений Рег.ру.

Облако Рег.ру представляет собой масштабируемую отказоустойчивую инфраструктуру, объединяющую лучшие IaaS, PaaS и SaaS решения в одном месте. Облачная платформа предназначена для запуска, разработки и тестирования IT-проектов, а также размещения IT-инфраструктуры для бизнеса любого уровня.

27 мая 2025 г.

Рег.ру и Контур договорились о партнерстве

Российская технологическая компания Рег.ру и ИТ-компания Контур упростят владельцам сайтов работу с документами.

Пользователям Рег.ру теперь доступны новые цифровые сервисы: предприниматели могут оформить электронную подпись от Удостоверяющего центра Контура и подключить сервис для электронного документооборота Контур.Диадок.

Новые инструменты дают бизнесу возможность работать с документами полностью онлайн — от заключения договоров до взаимодействия с государственными органами и контрагентами. Электронная подпись от УЦ Контура позволяет без личного присутствия подписывать официальные документы, сдавать отчетность и участвовать в электронных торгах. А с помощью Контур.Диадока предприниматели могут быстро обмениваться закрывающими документами по сделкам, актами, счетами и УПД без почты и курьеров.

Благодаря интеграции с Контуром, пользователи Рег.ру получат доступ к проверенным сервисам без регистрации на сторонних платформах. Это особенно актуально для малого и среднего бизнеса, где скорость принятия решений и простота в использовании сервисов играют ключевую роль.

«В условиях современного рынка, перегруженного цифровыми предложениями, мы считаем очень важным предоставлять бизнесу сервисы, которые соответствуют их реальным потребностям. Мы встраиваем качественные программные решения в бизнес-процессы клиентов так, чтобы обеспечить бизнесу устойчивую работу и рост эффективности», — рассказала Наталья Ларионова, руководитель службы по работе с федеральными партнерами в Контуре.

«Мы понимаем, что предпринимателям важно тратить меньше времени на рутину и сосредоточиться на развитии своего дела. Поэтому объединяем на своей платформе всё, что нужно для работы бизнеса в онлайне: от регистрации доменов и создания сайта до оформления электронной подписи и ведения документооборота. Сервисы от Контура — логичное и важное расширение этой экосистемы», — рассказал Максим Сысоев, руководитель проектов направления по работе с партнерами в Рег.ру.

Рег.ру с 2006 года развивает продукты и сервисы для создания и продвижения бизнеса в онлайне. Сегодня в линейке ключевых продуктов компании — хостинг, облачные решения, аренда физических серверов, регистрация доменов, SSL, почта, конструктор сайтов и другие онлайн-сервисы для предпринимателей.

Контур создает программное обеспечение для бизнеса с 1988 года. Продукты компании помогают тратить меньше времени на рутину, а общение с госорганами и поставщиками делают проще и прозрачнее. Количество пользователей превысило 2,5 млн: сервисы Контура использует каждая третья компания в стране.

В портфеле Контура более 70 продуктов — интернет-отчетность и онлайн-бухгалтерия, сервисы для ЭДО и работы с маркировкой, облачный товароучет и онлайн-кассы, проверка контрагентов, решения по обеспечению информационной безопасности, электронные подписи для любых задач.

26 мая 2025 г.

Рег.ру и Unisender запускают мотивационный проект ко Дню предпринимателя

В честь Дня предпринимателя компании расскажут, как фаундерам найти вдохновение и инструменты для роста бизнеса.

26 мая отмечается День российского предпринимательства. Российская технологическая компания Рег.ру и платформа автоматизации маркетинга Unisender объединились в совместной коллаборации «Предприниматели пишут (в) будущее», чтобы вдохновить предпринимателей мечтать, планировать и двигаться к своему бизнес-будущему.

В проекте примут участие пять успешных бизнесменов, которые помогут сотням молодых предпринимателей по всей России поверить в себя и вывести свой стартап на новый уровень. Благодаря проекту они смогут узнать, с какими трудностями сталкивались известные бренды на пути к успеху, и подписаться на серию мотивационных писем от фаундеров состоявшихся бизнесов.

Свои послания участникам проекта напишут Ирина Мамай (Cheaptrip), Юрий Мурадян (5 Prism), Кира Долгова (LaserLove), Максим Спиридонов («Нетология»), Зина Овштейн (Bonneville). Они расскажут, как представляли свое будущее в самом начале бизнес-карьеры, о чем мечтали и чего боялись. Покажут, какие ошибки сделали на пути к успеху и какие уроки извлекли.

«Главный актив предпринимателя — это путь. Со всеми факапами, шишками и выбитыми зубами, которые порой приходится собирать сломанными пальцами. И учиться на этом пути, в том числе на чужом опыте — крайне важно для любого бизнес-лидера», — говорит Максим Спиридонов. За его плечами множество успешных проектов: Insight Estate, «Нетология», «Фоксфорд» и бизнес-клуб Reforma.

«Будущее бизнеса рождается с мечты. Рег.ру совместно с Unisender хотят напомнить, что любой путь начинается с воображения и плана. И каждый предприниматель, каким бы опытным он ни был, нуждается в поддержке и вдохновении. Мы же со стороны Рег.ру предлагаем все необходимые сервисы и решения для уверенного старта бизнеса в онлайне», — подчеркивает Иван Грибов, директор по развитию продуктов для предпринимателей Рег.ру.

Серию писем дополнят полезные инструменты для развития бизнеса, льготный доступ к которым предоставят Рег.ру и Unisender. Участники проекта смогут воспользоваться сервисом автоматизации email-рассылок для увеличения продаж и оптимизировать расходы на создание сайта с помощью конструктора лендингов для бизнеса.

21 мая 2025 г.

Рег.ру выводит на рынок «Сайт под ключ» — старт серии простых решений для предпринимателей

С этого релиза компания стартует серию новых продуктов для начинающих предпринимателей и собственников небольших бизнесов. Команда ставит перед собой задачу кратно снизить сложность цифровизации для предпринимателей, учитывая специфику различных отраслей.

Крупнейший российский регистратор доменов и облачный хостинг-провайдер Рег.ру перезапускает линейку продуктов для малого бизнеса. Первым в линейке компания представляет готовое пакетное решение по созданию и продвижению сайта, призванное решить ключевые проблемы предпринимателей: высокую стоимость разработки (от 50 тыс. рублей за базовый сайт в веб-студиях) и сложности самостоятельного создания сайтов на конструкторах.

С продуктом «Сайт под ключ» начинающие предприниматели и владельцы небольших компаний, а также любые пользователи, развивающие собственное дело, смогут получить полностью готовый сайт менее чем за неделю. Специалисты Рег.ру проведут все необходимые работы: от подключения домена и SSL/TLS-сертификата до настройки и наполнения сайта контентом, вплоть до создания логотипа. К веб-ресурсу сразу будут подключены статистические и аналитические сервисы и подготовлены рекомендации для дальнейшего онлайн-продвижения. Сайт разрабатывается на собственной платформе Рег.ру, поддерживает адаптивный дизайн и инструменты аналитики. Также предусмотрена возможность дальнейшего расширения функциональности и внесения изменений в веб-ресурсе. Для заказа пользователю нужно будет только заполнить простую онлайн-форму.

«Мы создали продукт, который занимает промежуточное положение между дорогостоящими агентскими услугами и сложными платформами для самостоятельной верстки. Мы не нацелены конкурировать с агентствами и частными разработчиками сайтов, а, наоборот, заинтересованы занять собственную нишу. “Сайт под ключ” — это работающий инструмент для бизнеса с понятными условиями и гарантиями, как скорости, так и качества», — рассказывает Иван Грибов, директор по развитию продуктов для предпринимателей Рег.ру.

В планах компании формирование целой линейки пакетных предложений для МСП, которые будут соответствовать различным целям клиента (старт и продвижение бизнеса, создание личного бренда, привлечение партнеров или сотрудников), и специфике конкретной отрасли (на первом этапе запланированы решения для цифровизации малого бизнеса в индустрии красоты, электронной торговле и сфере услуг).

15 мая 2025 г.

Рег.ру зафиксировал всплеск интереса к запуску сайтов в сфере услуг

72% опрошенных хотели бы запустить сайт и продвигать собственное дело.

Российская технологическая компания Рег.ру провела опрос среди своих клиентов. В исследовании приняло участие более 4,2 тысячи владельцев сайтов.

Самый высокий спрос на запуск сайтов среди предпринимателей — их 43%. В более половины случаев (69%) сфера деятельности предпринимателя — это оказание услуг, еще 18% — торговля и производство. Остальные участники опроса — 15% фрилансеры, а 9% представляют интересы компаний, где работают по найму.

Половина предпринимателей имеет устойчивый бизнес, а треть только придумали идею. Согласно данным исследования, большинство (72%) новых и текущих клиентов Рег.ру зарегистрировали домен как первый шаг для запуска сайта и дальнейшего его продвижения. Из них 46% хотят зафиксировать только начальную идею и название продукта, а 26% — уже название компании.

«Сайт для предпринимателей – это обязательный атрибут и визитная карточка для продвижения услуг и продуктов в Сети. Сейчас мы видим повышенный спрос среди аудитории и готовы предложить все самые необходимые технологические сервисы: от регистрации домена до готовых решений “под ключ”. Наша задача — сделать старт в интернете максимально простым и быстрым, чтобы каждый мог сосредоточиться на развитии своего проекта», — комментирует Иван Грибов, директор по развитию продуктов для предпринимателей Рег.ру.

Каждый десятый опрошенный намерен сделать сайт «под ключ». Наиболее востребованный формат сайта — визитка, далее по популярности следует сайт с каталогом продукции для продвижения или под интернет-проект.

24 апреля 2025 г.

Рег.ру адаптировал облако для запуска приложений на базе 1С

Решение позволяет компаниям быстро и эффективно развернуть и масштабировать 1С в облаке с высокой производительностью.

Российская технологическая компания Рег.ру представила новый сервис — облачную инфраструктуру для работы с 1С. Это решение нацелено на оптимизацию работы приложений 1С и предполагает гибкое развертывание и администрирование инфраструктуры в облаке.

Облако 1С от Рег.ру предлагает готовый кластер серверов, индивидуально настроенный под задачи каждого клиента, на базе мощных процессоров AMD EPYC с производительными NVMe-дисками. Серверы в кластере резервируются, что обеспечивает высокую надежность и бесперебойную работу приложений.

Облачная инфраструктура полностью готова к работе, что позволяет пользователям сосредоточиться на своем бизнесе, не заботясь о настройке и обслуживании серверов. Услуга ориентирована на крупные и средние предприятия, активно использующие системы 1С, а также на аутсорс-разработчиков и системных администраторов. Решение станет полезным для компаний, предоставляющих решения 1С по модели SaaS и оказывающих консультационные услуги.

«Наша цель — предоставить бизнесу надежную и масштабируемую инфраструктуру, на которой компании смогут легко и безопасно работать с 1С. Новый продукт значительно упрощает работу, избавляя пользователей от необходимости вникать в развертывание и администрирование серверного оборудования. Клиентам не нужно беспокоиться о серверной инфраструктуре, и они могут сосредоточиться на ключевых задачах и развитии своих проектов», — отметил Сергей Белов, руководитель департамента корпоративных продуктов Рег.ру.

В Рег.ру также доступны SaaS-решения для небольших компаний, а также услуги аудита и нагрузочного тестирования. Они помогут оценить производительность, выявить и устранить слабые места системы, а также повысить производительность сервиса.