14 марта OVH получила сертификат ISO / IEC 27001: 2013 для Системы управления информационной безопасностью выделенных серверов.

Выделенные серверы OVH сертифицированы по ISO 27001

Эта сертификация, полученная после независимого аудита

компанией LNE, дает уверенность клиентам и пользователям услуг, размещенных на этих серверах.

Что такое стандарт ISO 27001 и сертификация?

Что такое стандарт ISO 27001 и сертификация?

ISO / IEC 27001 — это международный стандарт, который описывает «требования к созданию, внедрению, поддержанию и постоянному совершенствованию системы управления информационной безопасностью» (СМИБ). В нем описывается организационный метод, который обеспечивает конфиденциальность, целостность, доступность и отслеживаемость информационной системы.

Ежедневная охрана

С самого начала OVH безопасность была одной из основных задач команд, которые проектируют, эксплуатируют и развивают сервисы. СУИБ направлена на обеспечение систематического, сопоставимого и наглядного функционирования средств, применяемых для обеспечения безопасности.

СУИБ — это подход к созданию, поддержанию, мониторингу и обеспечению постоянного улучшения инструментов и процессов для:

- Идентифицировать и консолидировать обязательства и обязательства OVH с точки зрения информационной безопасности.

- Установите соответствующие, понятные и последовательные цели информационной безопасности.

- Внедрить подход, основанный на оценке риска, для определения и определения приоритетов улучшений безопасности.

- Установить, индустриализировать и использовать меры безопасности.

- Общайтесь и координируйте свою деятельность со всеми вовлеченными внутренними и внешними заинтересованными сторонами.

На ежедневной основе СУИБ состоит из управления всеми рискованными действиями для службы, такими как права доступа, конфигурации системы и оборудования, обновления программного обеспечения, обновления инфраструктуры, удаление данных, распределение между средами, мониторинг и инциденты. Обеспечение абсолютной безопасности не является реалистичной целью, но СМИБ помогает быстрее и надежнее выявлять уязвимости, ошибки и неисправности. СУИБ обеспечивает быстрое выполнение корректирующих действий, и эти действия выполняются с течением времени.

Усилие команды

Команда экспертов по безопасности работает с командами, отвечающими за разработку и эксплуатацию сервиса, службы поддержки клиентов, отделов продаж и руководства OVH, чтобы определить приоритеты этих улучшений. Координируя эти различные перспективы в рамках жизненного цикла продукта, подход, основанный на оценке риска, обеспечивает быструю, прагматичную и промышленную адаптацию систем и процессов к быстро развивающейся среде угроз.

Сертифицированный аудит

Сертификационные аудиты проводятся аккредитованными компаниями, в данном случае LNE, аккредитованными COFRAC. Сам аудит следует строгому формату и основан на формальных требованиях. Аудит является сложной задачей как для команд, так и для аудитора. На основе визитов в офис и центр обработки данных, собеседования в группах, подробного анализа документации и системного наблюдения в течение нескольких недель аудитор должен сформулировать свое мнение об актуальности проведенных мероприятий, их эффективности и, конечно же, их соответствие всем требованиям стандарта ISO 27001. Аудитор также определяет возможности для улучшения, которые следует рассмотреть в конце аудита.

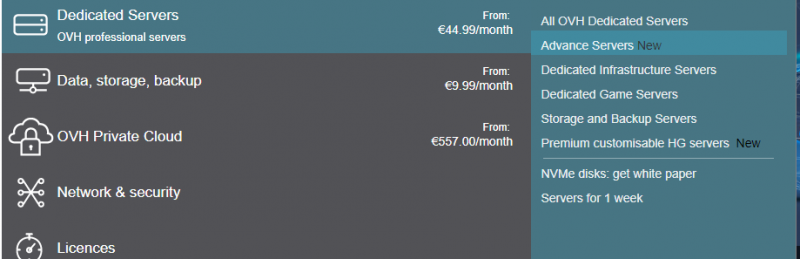

Каков объем?

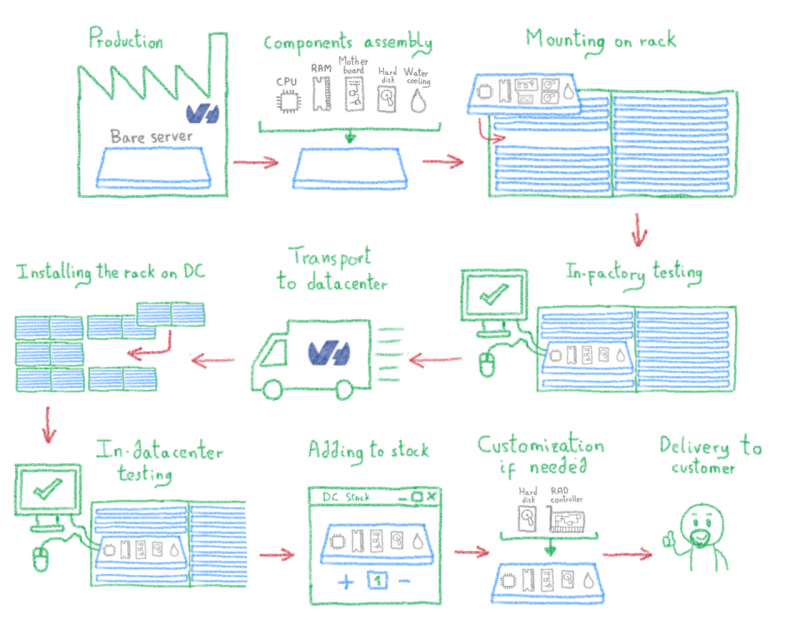

В сферу применения Системы управления информационной безопасностью входят предоставление, подключение, эксплуатационная поддержка и вывод из эксплуатации выделенных серверов, выделенных клиентам, ресурсы, предоставляемые клиентам для настройки, использования и мониторинга выделенной инфраструктуры и управления услугами группами OVH. Таким образом, СУИБ прочно ориентирована на обслуживание, предоставляемое клиенту.

Модульная система управления информационной безопасностью (СУИБ)

В некоторой степени все продукты OVH используют информационные системы для поддержки сервиса, и они сами размещены на выделенных серверах, как и все другие продукты OVH. Определение графа зависимостей и внутренних обязанностей является чем-то вроде загадки. Это было, однако, предпосылкой для определения ясной и понятной организации безопасности, которая позволила бы СМИБ эффективно функционировать. Был применен модульный подход для сегментирования и структурирования обязанностей каждой задействованной команды. Эти отношения определяются набором внутренних соглашений об обслуживании, определенных и отслеживаемых в СМИБ.

Например, центры обработки данных имеют отдельную СУИБ для обеспечения физической безопасности узлов хостинга и безопасности операций центра обработки данных. Данная СУИБ сертифицирована независимо и обеспечивает прочную основу для соответствия требованиям.

Сертификация ISMS выделенного сервера основана на сертификации центра обработки данных и охватывает серверы, размещенные в этих сертифицированных центрах обработки данных. На сегодняшний день речь идет о центрах обработки данных в Рубе (RBX 2,3,5,6,7), во всех центрах обработки данных в Страсбурге, Богарном, Сингапуре и Сиднее. Это касается и парижского центра обработки данных (P19), в котором размещается часть информационной системы, поддерживающей эту услугу, хотя он не размещает никаких выделенных серверов, выделенных клиентам. Хотя все серверы компании охвачены СМИБ, сертификация касается только этих центров обработки данных.

Что дальше?

ISO 27001 — это общий стандарт, который решает проблемы большинства наших клиентов и устанавливает основу и организацию для обеспечения безопасности обслуживания. Тем не менее, он не учитывает соответствие требованиям, связанным с конкретным сектором бизнеса. Стандарт ISO 27001 предусматривает возможность добавления дополнительных требований, и для этой цели разработана СУИБ «Выделенные серверы». Поэтому в СУИБ будут постепенно интегрироваться новые конкретные меры, чтобы покрыть, например, потребности в размещении личных данных о здоровье, требования банковского сектора или нормативные особенности государственного сектора в разных странах, где OVH предоставляет услуги.

Параллельно команды работают над расширением периметра сертификации, чтобы включить все центры обработки данных группы, в частности в ERI(UK), LIM(DE), WAW(PL) и GRA(FR). Цель состоит в том, чтобы предоставить всем клиентам OVH единый уровень обеспечения безопасности независимо от выбранного региона центра обработки данных.

Наконец, команды будут продолжать работать с другими командами продуктов, чтобы завершить каталог сертифицированных продуктов и постепенно расширять его до всех предложений OVH «Инфраструктура как услуга».