все новости по филиалам

Поиск

Roubaix vs Dallas

US-E (VA)

SYS Fee Setup

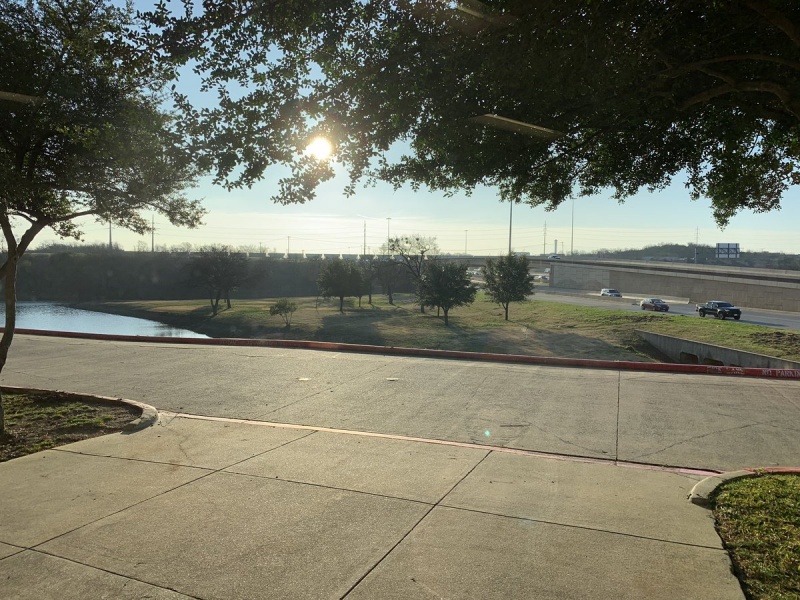

Office Dallas,TX

Почему Октав Клаба, босс OVH, покидает Рубе, чтобы поселиться в Техасе

Объявление в Твиттере об отъезде Октавы Клабы в Соединенные Штаты сначала удивило и встревожило мир французских технологий. Это утечка, искать преимущества? «Ничего из этого» Это всегда и снова навязывать в облаке против Google, Amazon, Microsoft и китайской Alibaba.

«Наконец, в Далласе, штат Техас, я собираюсь жить со своей семьей в 2019 году. Моя четвертая жизнь в OVH началась сегодня утром». Это сообщение Октавы Клабы, владельца и основателя OVH, опубликованное ранее в этом году, чтобы подорвать европейские технологии.

Некоторые говорят, что «Ch'ti of tech» эмигрирует по финансовым причинам, или он больше не верит в технологическое будущее Франции или что он стремится оживить деятельность, которая застоялась в Европе после наступления Американские конкуренты из Облака, Google, Amazon и Microsoft. Октава Клаба оставит ли он Рубэ на равнинах Техаса?

«Ничего из этого», — сказала пресс-секретарь OVH, заявив, что «этот отъезд не окончательный», и что он должен укрепить свои международные амбиции. «Октава Клаба не бежит из Франции, он держит свой дом на севере, его пристанище в Париже», — продолжает менеджер. Он добавляет, что присутствие в Соединенных Штатах неизбежно в облаке, и что этот проект некоторое время был готов к продолжению развития OVH.

Выбор Далласа также был обеспокоен, и подозрения в фискальном интересе были подняты. «Octave не ожидает, что станет налоговым резидентом США», — отвечает представитель. «Этот город предлагает центральное расположение и центр аэропорта, что позволяет легко путешествовать, особенно в наших двух центрах обработки данных, расположенных на каждом побережье», — говорит OVH, добавив, что в городе также имеется «большой резерв рабочих мест в Технический сектор ". Но, прежде всего, французская группа уже имеет команды и инфраструктуру с момента покупки vCloudAir для VMware в 2017 году.

«Штаб-квартира OVH есть и останется в Рубе»

Будет ли это американское наступление за счет стратегии группы в Европе? На этом этапе OVH подтверждает свою привязанность к старому континенту. «Головной офис OVH есть и останется в Рубе, а парижские офисы Batignolles сохраняют свою роль», — сказал представитель OVH. «Приход Мишеля Полена в 2018 году в качестве генерального директора теперь позволяет Октаве Клабе полностью посвятить себя должности «председателя» OVH.

Что касается инициативы «Виртуальный GAFAM», которая направлена на то, чтобы вывести европейских технических чемпионов, то это не подвергается сомнению. «Чтобы быть европейским лидером, мы должны атаковать на международном уровне, у нас также есть деятельность в Индии», — сказала группа, которая не намерена ограничиваться несколькими географическими районами. «Если мы сможем запустить в Азиатско-Тихоокеанском регионе или Латинской Америке, мы не будем колебаться, это проект, упомянутый в нашем стратегическом плане 2021-2026».

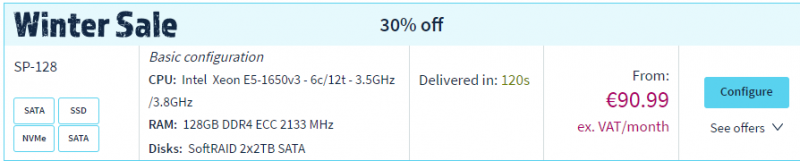

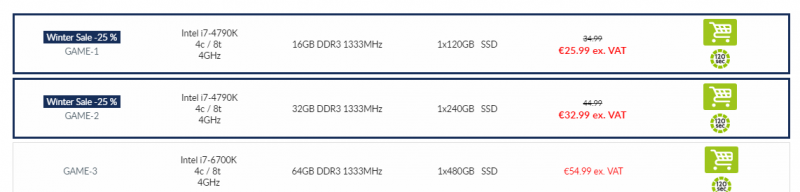

Winter Sale

Happy New Year from OVH

We wish you the very best for this year's projects!

2019 is a special year for us, as it marks our 20th year as a cloud services provider. And we're continuing with our efforts to drive your projects to success, with four new universes:

- OVHmarket, a digital toolbox to accelerate your growth

- OVHspirit, all the infrastructures you need to build a cloud platform

- OVHstack, a public cloud platform with open standards

- OVHenterprise, an alternative cloud to make your digital transformation a success

With 20 years of know-how, co-operation and ideas shared so that we can fit your needs, we'll carry on developing SMART cloud solutions that are:

- Simple and easy to configure

- Multi-local, close to you and your customers, wherever you are in the world

- Accessible and clear in terms of price

- Reversible, open and interoperable (open-source)

- Transparent and responsible

On a wider scale, our ambition is to help everyone benefit from the data revolution. We'd like to help you get full, independent control over your data. We believe that this freedom should be protected, and we always develop innovative technology with this goal in mind. And this is the meaning behind our motto, Innovation for Freedom.

As a proud holder of these values, we'd like to wish you a fantastic year 2019, with plenty of new opportunities on the horizon. As the saying goes

If you want to go fast, go alone. If you want to go far, go together.All the very best for the New Year!

The OVH team

Четвёртая жизнь в OVH началась

//

от редакции

неужели теперь США будет развиваться, а то весь прошедший 2018 особо ничего не происходило

или это означает что теперь все новинки и инновации будут только на новом сайте? а значит «старое доброе привычное» может умереть? например топики про удобство оплаты без ежемесячных счетов. а так же топики 2х летней давности о переходе KS SYS на 1 API. А так же топики которые писали что новый основной сайт будет ovhcloud вместо старых привычных филиалов ОВХ в разных доменных зонах разных стран

а может быть это означает что европа как страна для ведения бизнеса получается хуже? раз он аж переехал.

в любом случае считаю это важное событие. и от него зависит теперь как будет идти развитие.