Earthcube убеждает Армию и Октава Клаба поддержать его разведывательные технологии

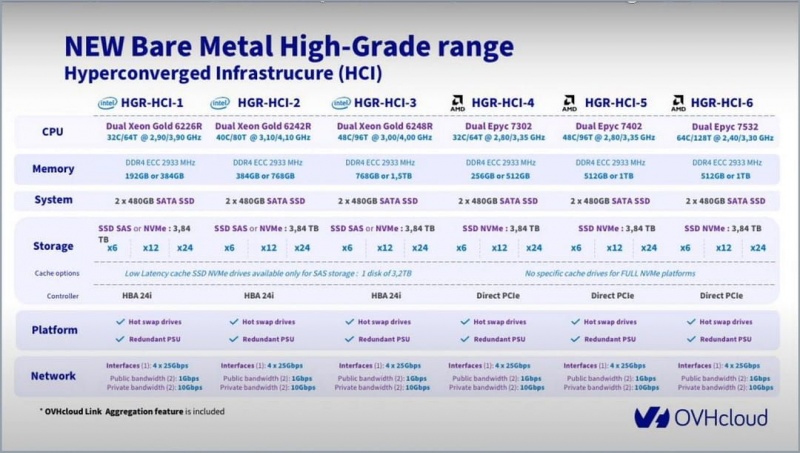

Согласно опубликованному заявлению, французский стартап Earthcube, специализирующийся на анализе геопространственных данных с помощью искусственного интеллекта (ИИ), привлек 20 миллионов евро из трех фондов, в том числе одного из министерства вооруженных сил, для продолжения своего роста. Четверг. В этом случае Eartcube меняет свое название на Preligens. Сбор средств проводился с инвестиционными компаниями Ace Management и 360 Capital, а также с Definvest, фондом Министерства вооруженных сил, занимающимся стратегическими оборонными компаниями, говорится в пресс-релизе министерства. Согласно Les Echos, Октав Клаба, основатель французского единорога OVH, также войдет в столицу через свой финансовый инструмент Jezby Ventures.

Основанная в 2016 году компания Earthcube рассчитывает на этот сбор средств, чтобы «сохранить свое технологическое лидерство в области искусственного интеллекта, применяемого в сфере обороны и разведки». Компания из 80 человек, базирующаяся в Париже и учрежденная в Вашингтоне и Лондоне, также хочет «продолжить и активизировать свое международное развитие». «Применение этого национального самородка имеет важное значение для области обороны», — комментирует министр Флоренс Парли, цитируемая в пресс-релизе. «Они приносят нам реальную операционную выгоду от использования нашей геопространственной информации: без Preligens мы не смогли бы видеть определенные вещи».

В сентябре Минобороны объявило о создании инвестиционного фонда «Дефиннов» совместно с BpiFrance. С выделением 200 миллионов евро он будет направлен на развитие двойных технологий (гражданских и военных) и трансверсальных технологий через долевое финансирование инновационных компаний. Этот фонд добавлен к Definvest, наделенному 100 миллионами евро.

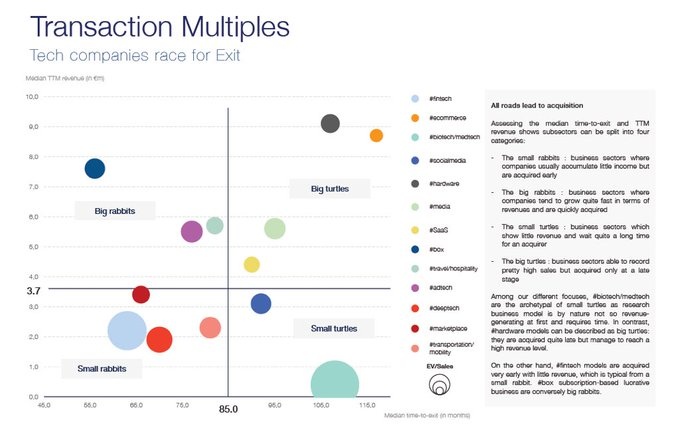

По словам Les Echos, фонд ЦРУ In-Q-tel, стоящий за Palantir, несколько месяцев назад пытался проникнуть в столицу. На вопрос газеты, генеральный директор Арно Герэн уточняет, что компания умножила оборот в 16 раз вдвое « с переходом к точке равновесия». Согласно ежедневной газете, Earthcube должна стремиться привлечь более крупные суммы в течение двух лет и осуществить выкуп бизнеса для своих технологий или их создания за рубежом.

Основанная в 2016 году компания Earthcube рассчитывает на этот сбор средств, чтобы «сохранить свое технологическое лидерство в области искусственного интеллекта, применяемого в сфере обороны и разведки». Компания из 80 человек, базирующаяся в Париже и учрежденная в Вашингтоне и Лондоне, также хочет «продолжить и активизировать свое международное развитие». «Применение этого национального самородка имеет важное значение для области обороны», — комментирует министр Флоренс Парли, цитируемая в пресс-релизе. «Они приносят нам реальную операционную выгоду от использования нашей геопространственной информации: без Preligens мы не смогли бы видеть определенные вещи».

В сентябре Минобороны объявило о создании инвестиционного фонда «Дефиннов» совместно с BpiFrance. С выделением 200 миллионов евро он будет направлен на развитие двойных технологий (гражданских и военных) и трансверсальных технологий через долевое финансирование инновационных компаний. Этот фонд добавлен к Definvest, наделенному 100 миллионами евро.

По словам Les Echos, фонд ЦРУ In-Q-tel, стоящий за Palantir, несколько месяцев назад пытался проникнуть в столицу. На вопрос газеты, генеральный директор Арно Герэн уточняет, что компания умножила оборот в 16 раз вдвое « с переходом к точке равновесия». Согласно ежедневной газете, Earthcube должна стремиться привлечь более крупные суммы в течение двух лет и осуществить выкуп бизнеса для своих технологий или их создания за рубежом.