Информационной безопасности в малом и среднем бизнесе не существует

Я давно в ИТ, помню хриплые стоны модема и то, почему кота зовут Зухелем. Всё это время мне казалось, что сейчас ещё чуть-чуть — и у нас будет нормальная ИБ. Все эти годы.

Но на самом деле ИБ в малом и среднем бизнесе нет. И не будет.

То, что мы иногда видим под вывеской ИБ, — это либо иллюзия, либо какая-то вынужденная формальность, чтобы отвязались. Такова суровая реальность.

Почему так:

- Доступные зарубежные вендоры ушли. Российские аналоги очень дороги, ориентированы на крупный бизнес и госсектор, а для малого бизнеса пока ничего нет.

- Бюджетов на ИБ у малого бизнеса обычно нет. Реальных ИБ-специалистов за зарплаты малого бизнеса тоже мало. И вообще их зарплаты неподъёмны.

- ИБ часто требует круглосуточной работы целой службы, а не одного человека. Для реальной защиты нужен дорогой стек технологий (антивирусы, NGFW, IDS/IPS, SIEM, IRP и т. д.).

- Низкая культура ИБ и беспечность. Распространены практики вроде бесконтрольного использования личных устройств (BYOD), устаревшего и необновляемого ПО (пример с Bitrix), слабых и неизменяемых паролей.

В итоге сейчас малый и средний бизнес — лёгкая мишень для массовых автоматизированных атак, а не только для целевых APT.

Давайте поковыряемся чуть детальнее.

Доступные зарубежные вендоры ушли, а наши не пришли

Раньше на рынке были понятные и относительно доступные зарубежные решения. Теперь они ушли. А что осталось? По моим подсчётам, два с половиной, ну, может, три с половиной, если считать «Лабораторию Касперского», российских ИБ-вендора.

И вот тут начинаются проблемы. Их решения, во-первых, совершенно не покрывают реальных потребностей малого и среднего бизнеса. Они заточены под крупняк и госсектор.

Сейчас мы не будем касаться освоения бюджетов. Но недавно я был на конференции, где крупный российский вендор гордо заявил, что цены на закупку поднимаются в восемь раз! Речь шла про то, что среди прочего это может помочь решить вопрос недоиспользованных бюджетов госкорпораций. Если что, их цена теперь становится нерелевантной даже для среднего бизнеса с оборотом в полтора миллиарда в год.

Или вот ещё пример из нашей практики: когда нам понадобилось подключиться к ГосСОПКА, нам предложили «коробку» — по сути, программку, которая дёргает три метода API и имеет простенький интерфейс для учёта событий — за 10 миллионов рублей! Десять миллионов за софтину, которую нужно ещё и самим настраивать для отгрузки данных с датчиков! Это же абсурд для компании, которая не ворочает десятками миллиардов. И да, потом оказалось, что можно закрыть задачу купив железку и почитав регламенты. И то до недавнего времени от неё нужен был только серийник, а в эксплуатацию мы её ввели для совсем других задач (не пропадать же добру!).

То есть иностранные вендоры ушли, а доступных отечественных решений пока нет. Может быть, позже будут. Но сейчас говорить о том, что можно взять коробками и в next-next-done настроить что-то для малого и среднего бизнеса, не получается. А вот раньше кое-как, но было можно.

Нет денег на ИБ

Давайте посмотрим, кто это такой — малый бизнес. По официальным меркам, это оборот до 800 миллионов рублей в год. Средний — до двух миллиардов. Суммы вроде бы внушительные, но если копнуть глубже — налоги, расходы, закупки (если это торговля), — то на IT-инфраструктуру остаются крохи. А на информационную безопасность как часть этой инфраструктуры денег не остаётся совсем. Даже если компания наскребёт на какое-то железо или софт — это лишь верхушка айсберга.

Чтобы построить хотя бы подобие нормальной системы ИБ, нужен целый стек технологий:

- Антивирусы на всех рабочих станциях и серверах (если это Win, на других ОС — свои нюансы).

- Next Generation Firewall (NGFW) для защиты сетевого уровня.

- IDS/IPS (системы обнаружения и предотвращения вторжений), чтобы автоматически выявлять попытки вторжения.

- SIEM (система управления событиями ИБ), куда будут стекаться все логи и события безопасности.

- В идеале — ещё и IRP (платформа реагирования на инциденты) для автоматизации ответных мер.

Если пройтись по прайс-листам вендоров (а они часто закрыты и выдаются по запросу), то чек за весь этот комплекс легко может составить существенную часть годового оборота среднего предприятия. И не забываем, что ко всему этому великолепию нужны те самые дорогие и дефицитные специалисты, которые знают, что со всем этим делать.

Польза от ИБ — тоже не самая очевидная: есть оборотные штрафы за утечку персональных данных. Но, как мы помним, флагман этого направления — Яндекс.Лавка, которая благодаря материнской компании как раз могла позволить себе нормальную ИБ, но не стала, чтобы не замедлять развития проекта. Вот детали.

Тенденция в целом такая, что никому эта ИБ особо-то и не нужна.

Неподъёмные зарплаты безопасников

Специалисты — самая больная тема. Даже если бы у малого бизнеса и были деньги на дорогие ИБ-решения, то кто будет всем этим управлять? Реальных ИБ-специалистов на рынке — раз-два и обчёлся. А те, кто есть, особенно если они не фейковые, просят зарплаты, сравнимые со стоимостью крыла от Боинга.

В годовом пересчёте они могут стоить дороже всех этих железок вместе взятых и при этом не дадут никаких гарантий.

Да, есть модные онлайн-курсы по ИБ. Но это капля в море. Когда мы искали специалистов себе в Security Operation Center, к нам приходили люди, чей потолок компетенций — это настроить домашний файрвол, чтобы можно было качать торренты, а к тебе в компьютер никто не залез. И так сейчас реально выглядит рынок кандидатов среднего уровня под средний бизнес. Ну и что нам с этим делать в масштабах облачного провайдера?

Или вот ещё живой пример некомпетентности, которым делились коллеги на одном бизнес-завтраке. Взломали компанию, заразили шифровальщиком. Приехали разбираться специалисты по форензике, а там директор по безопасности — молодой парень, увешанный сертификатами о свежеоконченных курсах. Когда его начали спрашивать про ханипоты, IDS/IPS, про то, что делалось для защиты контура, он сделал круглые глаза и ответил: «Ребята, вы так интересно рассказываете! Пойдёмте пообедаем, вы мне всё поподробнее расскажете». То есть он даже не понимал, о чём его спрашивают и что он должен был делать! И это, увы, — повсеместная практика.

Информационная безопасность — это не работа с 9 до 18. Это круглосуточные мониторинг и реагирование. Это требует целой службы, а не одного, пусть даже гениального, специалиста.

Раздолбайство и низкая культура ИБ

По факту в малом и среднем бизнесе процветают раздолбайство и крайне низкая культура информационной безопасности.

Типичная картина: сотрудник приходит со своим ноутбуком (BYOD, да?) и подключается к корпоративной сети. Никого не волнует, что он там дома на этом ноуте делал, чем мог заразиться и что принёс в офис. Это считается нормой. Я лично слышал, как один такой «директор по безопасности» на конференции с пеной у рта доказывал эксперту по форензике, что ничего страшного в этом нет, ведь «Мы же всех выпускаем в Интернет через NAT, к нам никто не попадёт». Без комментариев.

Повсеместно используется устаревшее программное обеспечение. Регулярное обновление ПО — это базовая цифровая гигиена, но в малом бизнесе это экзотика. Яркий пример — Bitrix24 и просто Bitrix. Там каждое обновление — это риск, что слетят все кастомные доработки. Поэтому системы годами не обновляются и кишат известными уязвимостями. Можно вспомнить и OpenStack с его известными, но годами незакрываемыми дырами, — это как пример системной проблемы с обновлением сложного ПО.

Элементарные вещи вроде смены паролей на Wi-Fi после ухода сотрудников или индивидуальный доступ к Wi-Fi для каждого пользователя — это что-то из области фантастики для многих небольших компаний. Даже в довольно крупных зарубежных стартапах бывали случаи, когда уволенный сотрудник просто переименовывался в корпоративном чате под бота и продолжал там сидеть, всё читать и даже что-то писать.

Как взламывают сегодня

Многие до сих пор представляют себе хакеров как неких злодеев в масках Гая Фокса, которые целенаправленно атакуют именно их маленький, никому не нужный бизнес. В большинстве случаев это совсем не так.

Вы лично на фиг никому не нужны. Ломают сейчас всех. Реальность — это массовые автоматизированные атаки. Современные хакеры — это разработчики, которые поставили взломы на поток. Работает это по принципу «воронки»:

- Сначала с помощью огромных ботнетов (заражённых компьютеров, телефонов, «умных» утюгов — чего угодно) идёт массовое сканирование IP-адресов всего Интернета на предмет отклика. Допустим, из 100 миллионов адресов откликнулось 10 миллионов.

- Затем эти 10 миллионов сканируются на наличие открытых портов с потенциально уязвимыми системами (уязвимости и порты, которые они используют, хорошо известны). Нашёлся, скажем, миллион таких.

- Далее идёт проверка версий ПО на этих портах. Любая программа при подключении к ней часто выдаёт свою версию, версию сервера, операционку. Злоумышленники сверяют эту информацию с базами известных уязвимостей. Так из миллиона находится, допустим, 100 тысяч потенциально уязвимых приложений.

- И, наконец, на эти 100 тысяч целей автоматически запускаются эксплойты — специальные программы, эксплуатирующие конкретные уязвимости. Если на 10 тысячах из них эксплойт сработал, то злоумышленники получают доступ.

Результатом может быть что угодно: заражение шифровальщиком (ключ от которого, кстати, почти никогда не возвращают, даже если заплатить выкуп), кража данных, использование вашего сервера для дальнейших атак. Можете сами провести эксперимент: создайте виртуальную машину, дайте ей публичный IP-адрес. Буквально через 10 минут посмотрите логи (команды lastb или tcpdump) — вы увидите шквал попыток подключения и сканирования.

Есть, конечно, и APT (Advanced Persistent Threat) — это уже точечные, сложные и хорошо подготовленные атаки на конкретные организации. Чаще их целью становятся крупные компании или госорганы, но и средний бизнес может попасть под удар, если у него есть что-то ценное, например, поставщик с доступом к крупной компании. Атака на цепочку поставок на сегодняшний день — довольно популярная техника.

APT-атаки многовекторны: используются технические средства, человеческий фактор, социальная инженерия (например, внедрение своего человека в компанию или «случайно» оставленная на собеседовании флешка). Примерами APT-атак можно назвать взломы правительственных департаментов, Google, Пентагона или вот из недавнего российского — удаление всего контента и исходников Rutube. Такие атаки часто выявляются уже постфактум, когда ущерб уже нанесён, и последствия могут быть катастрофическими.

Есть DDoS-атаки. Любой хостинг-провайдер подтвердит, что их инфраструктура и клиенты постоянно находятся под DDoS-атаками, часто — с требованием выкупа.

И вишенка на торте — недобросовестность некоторых «защитников». Миф о том, что разработчики антивирусов сами пишут вирусы, — это, к сожалению, не такой уж и миф. Мне известны случаи, когда, по слухам на рынке, один очень крупный известный российский антивирусный вендор организовывал DDoS-атаки на потенциальных клиентов, чтобы потом «героически» предложить свою помощь в защите. Кроме того, одна из причин запрета многих зарубежных ИБ-решений у нас — это подозрения в наличии программных и аппаратных «закладок», которые могут быть использованы в любой момент. Комментировать правдивость не возьмусь, но слухи ходят очень активно.

Истории:

- Был забавный случай, когда одним махом открыли все постаматы одной известной компании. Представляете картину?

- Я лично больше года имел администраторский доступ к порталу Министерства образования Албании. Нашёл уязвимость в их веб-сервисах, просто сканируя диапазоны IP-адресов. Год читал всё, мог модифицировать данные. Закрылась эта история только после того, как я сам им написал, что, мол, ребята, я тут у вас играюсь уже год, пора бы вам дыры залатать. Это было в начале нулевых, так что сейчас уже можно рассказать. Уверен, что с огромным количеством систем и сейчас происходит то же самое, просто данные этих компаний никому особо не интересны.

- Ещё один интересный кейс, упоминания о котором вдруг стали пропадать, но остались в Коммерсанте: «В апреле корпоративные клиенты 1Cloud, MTSCloud, oblako.kz (ТОО «1 Клауд», входит в ООО «ИТ-ГРАД 1 Клауд», работает на территории Казахстана) направили в Минцифры и уполномоченному по защите прав предпринимателей в России Борису Титову коллективное обращение… Из обращения следует, что в результате сбоя 17 марта стало недоступно более 1 млн виртуальных серверов, размещённых на инфраструктуре ЦОДов в Москве, Санкт-Петербурге и Казахстане.«Инфраструктура провайдеров услуг была взломана, данные клиентов, включая резервные копии, уничтожены или зашифрованы. Ситуация вокруг инцидента, причины, последствия и прогнозы тщательно скрываются», — подчёркивается в обращении.»

- Или вот ещё нашумевший случай, когда предположительно из-за уязвимости у одного крупного банка хакеры получили доступ к городским рекламным панелям и почти сутки крутили на них порноролики. Видео с этих панелей гуляли по Интернету.

Что делать?

Несмотря на всю беспросветность, какие-то шаги сделать всё-таки можно и нужно.

- Реалистично оцените риски. Предположим, что вас взломали теми самыми решениями на потоке. Что будет дальше? Бекапите ли вы клиентскую базу, документы, бухгалтерию? Как быстро всё восстановите?

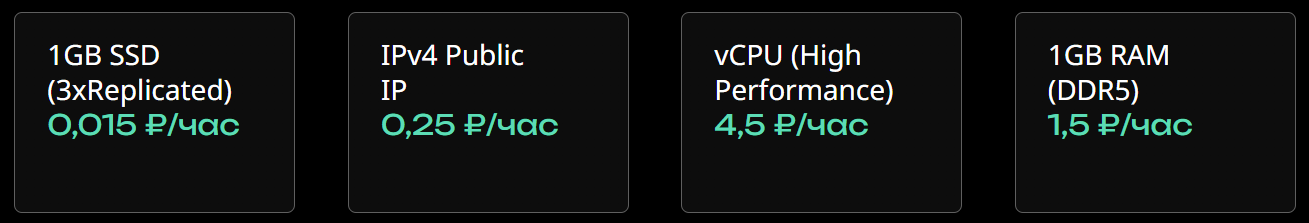

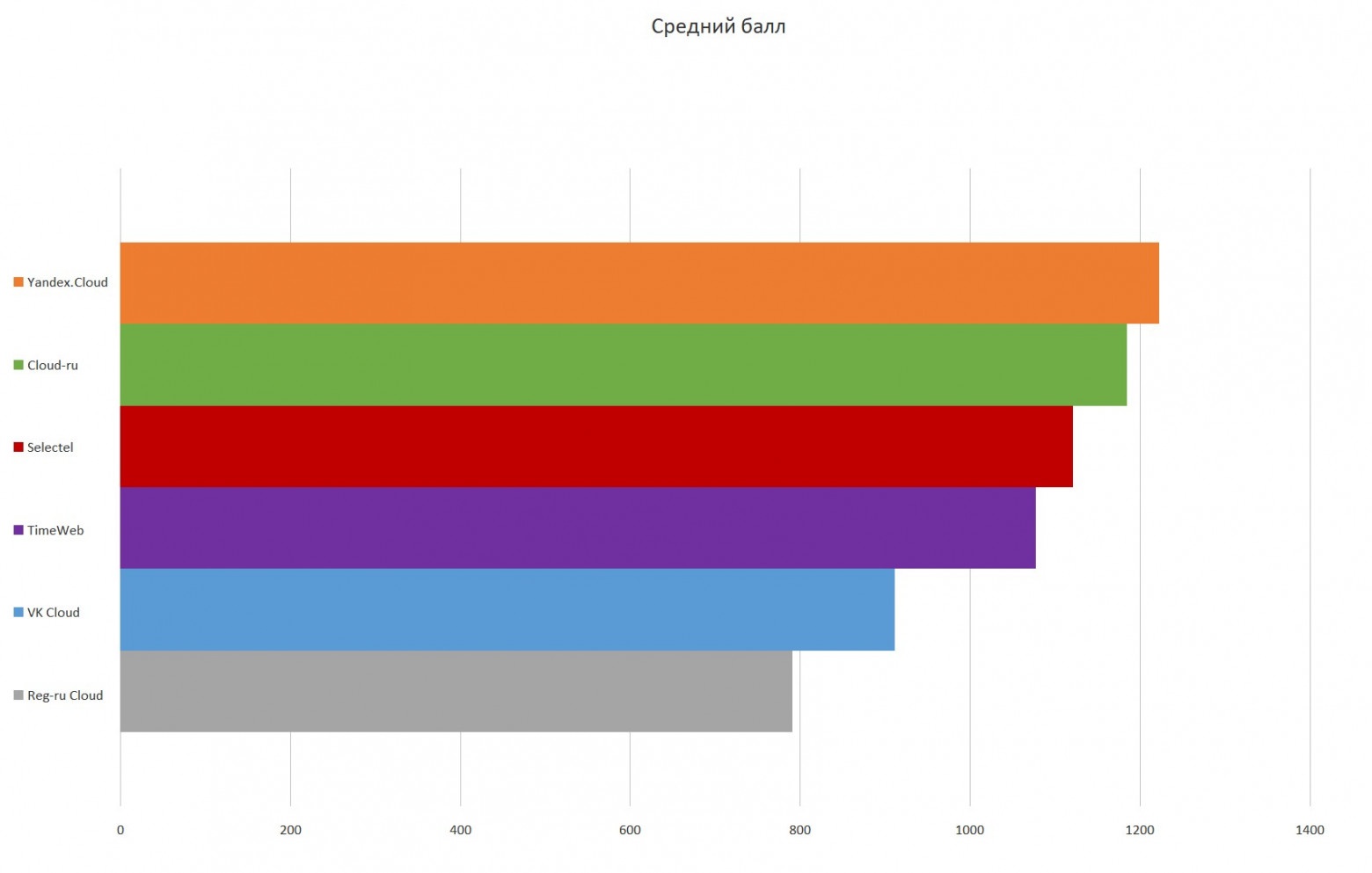

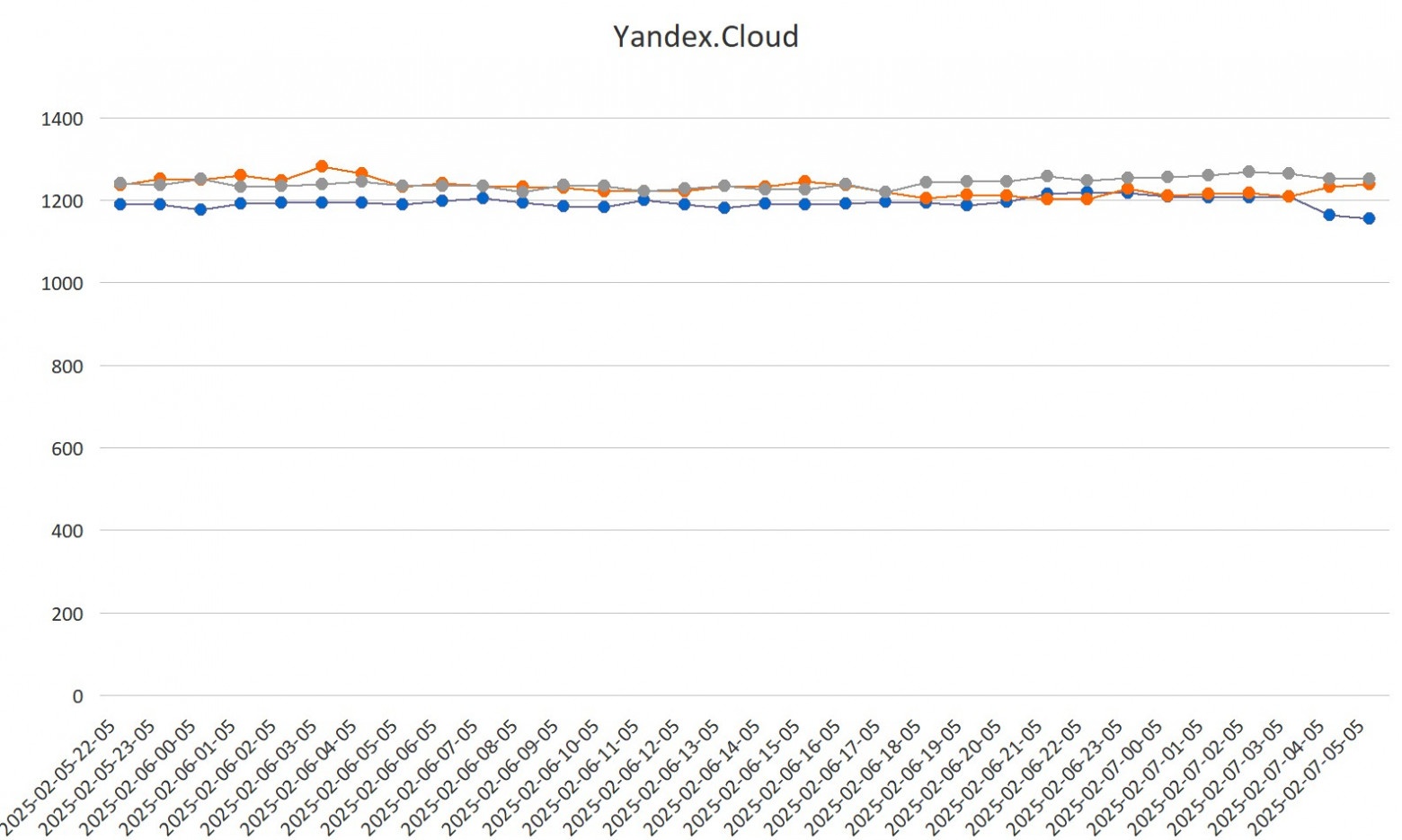

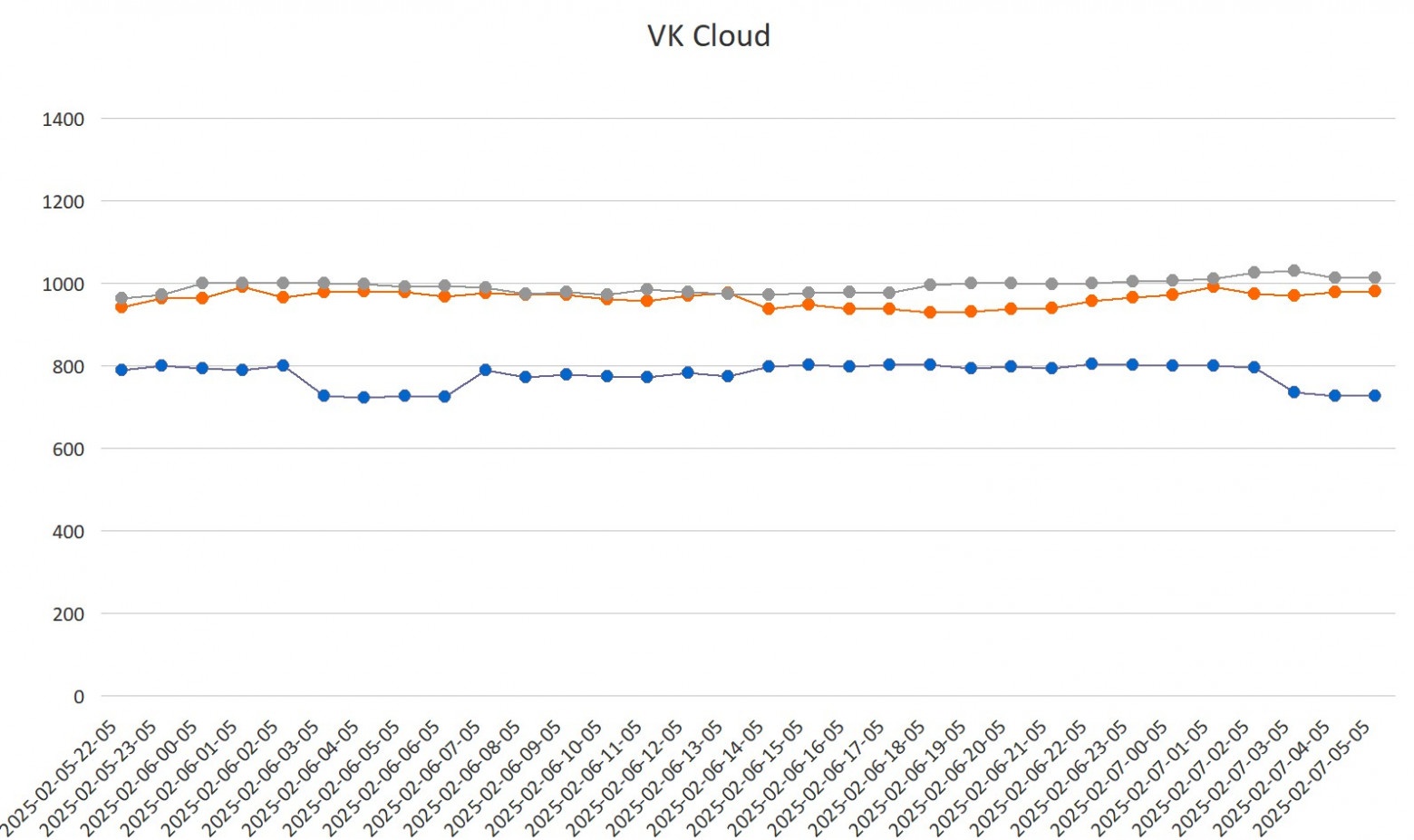

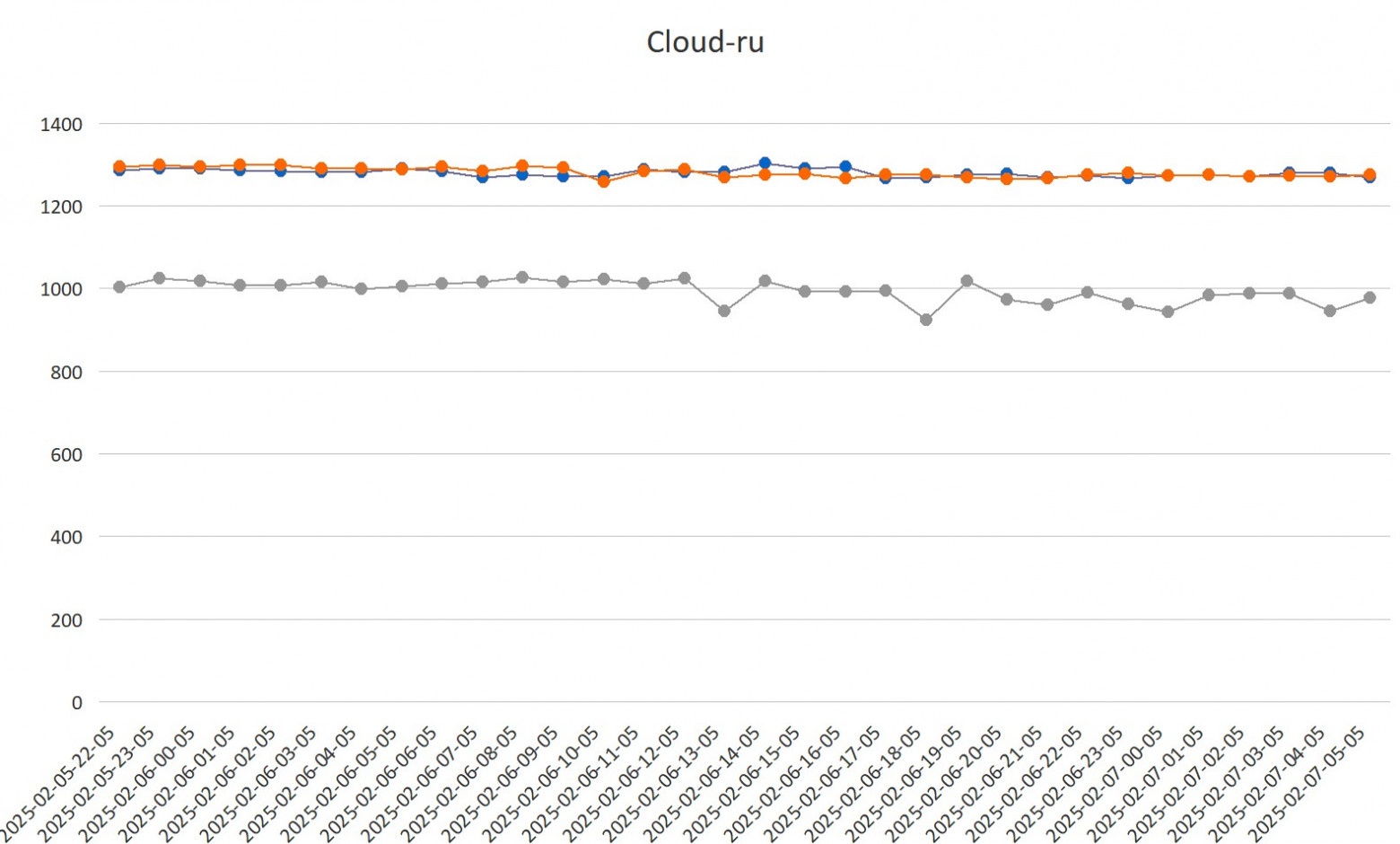

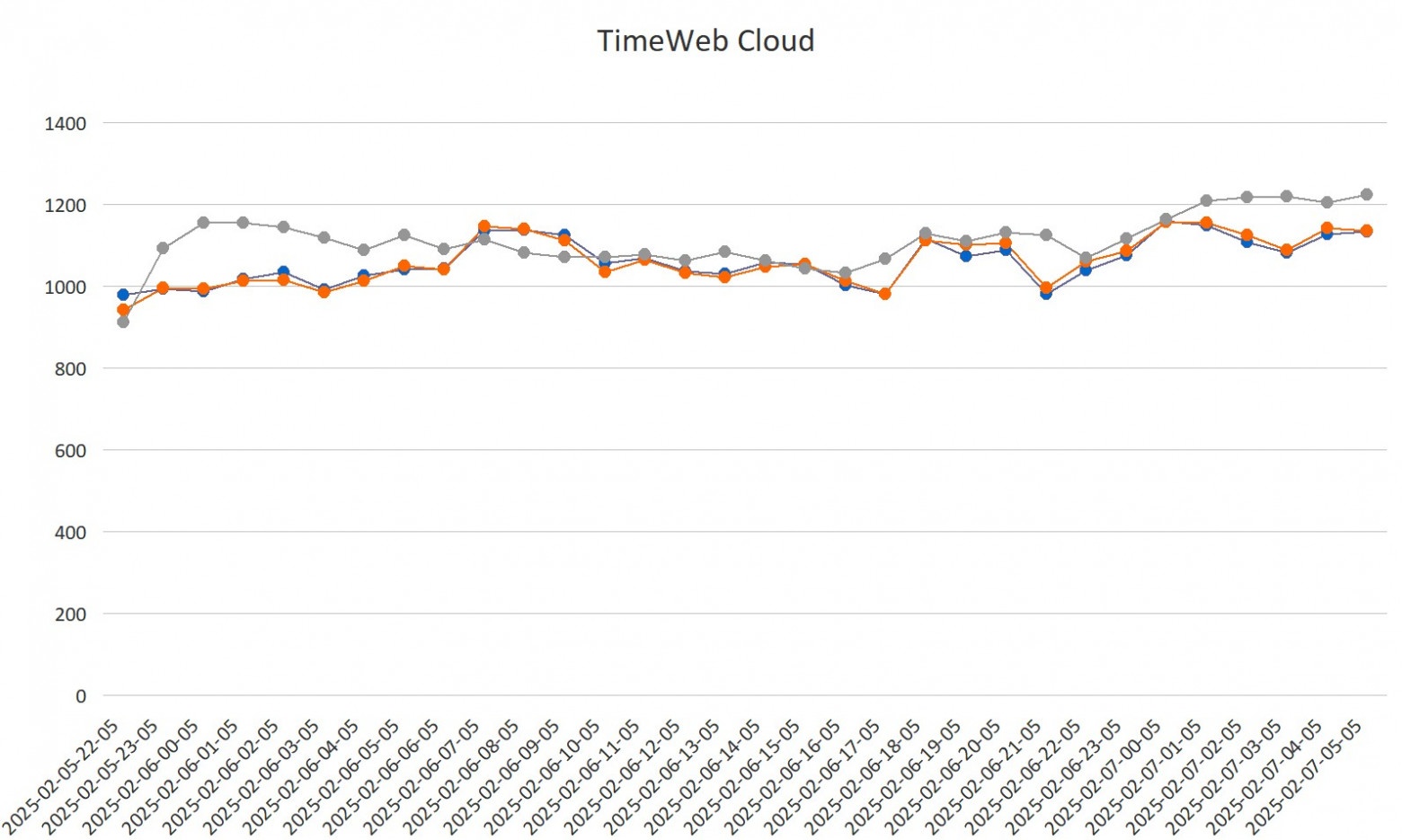

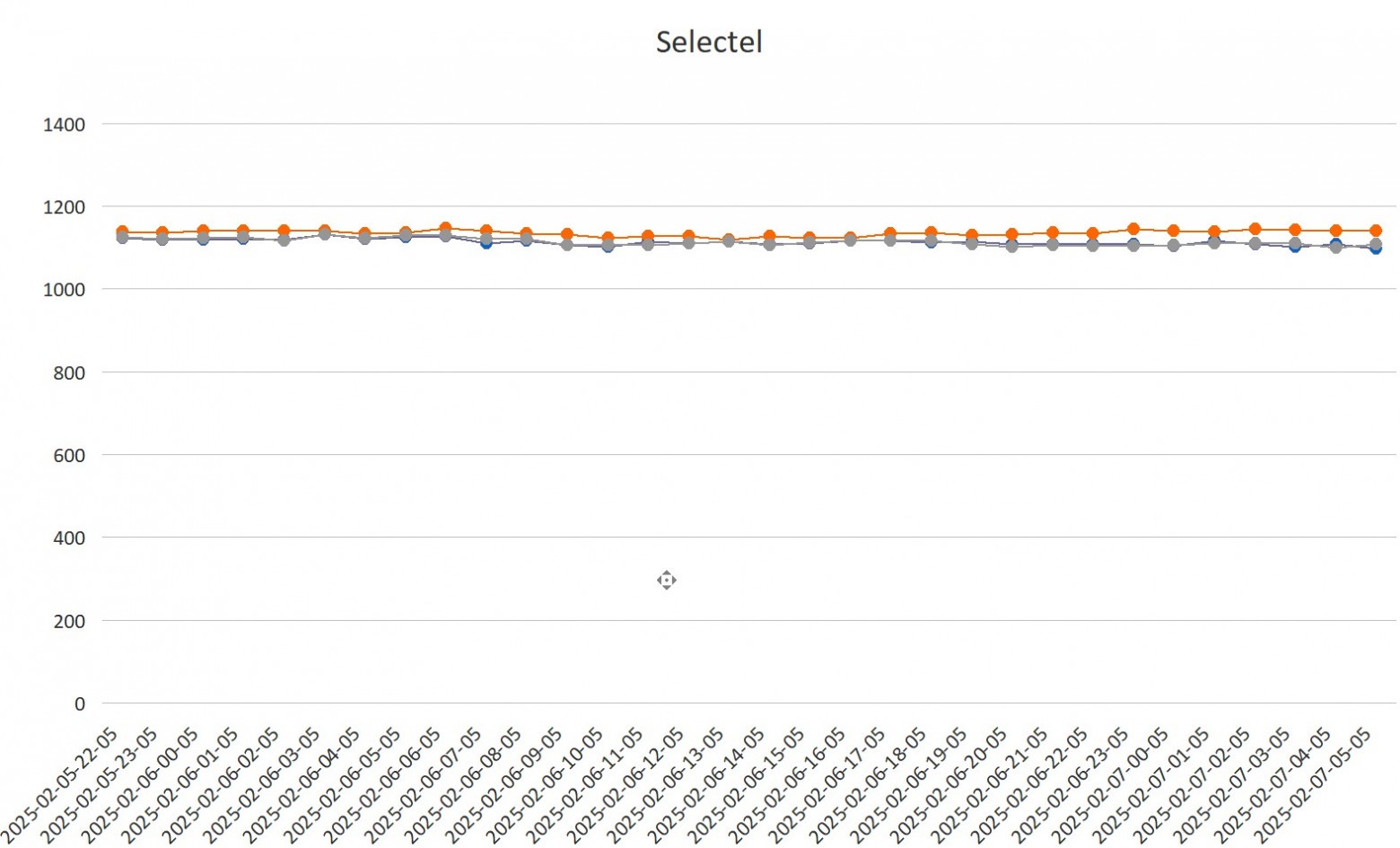

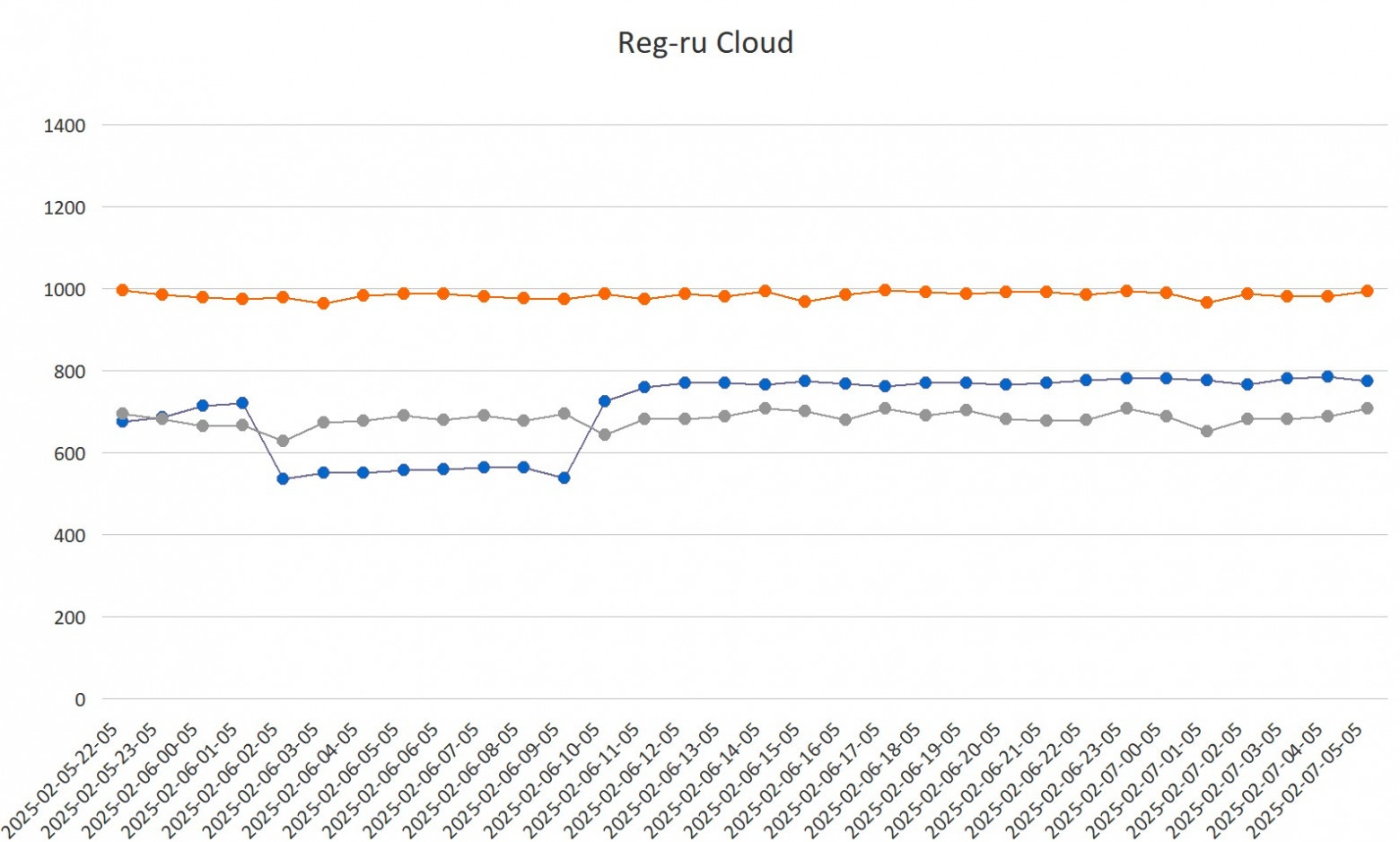

- Рассмотрите облачные сервисы. Почта, 1С, документы, корпоративный чат — можно развернуться в инфраструктуре у кого-то: главное — убедиться, что этот кто-то действительно хоть как-то занимается ИБ.

- Базовая гигиена: минимальные привилегии сотрудников, регулярные обновления ПО на стабильные версии, везде двухфакторная аутентификация, обучение сотрудников не открывать странные файлы в письмах (и пару раз — практическое обучение), если заметили что-то подозрительное (например, взлом telegram-аккаунта сотрудника), то говорить сразу.

- Если вы сразу — ИТ-проект, то в самом начале можно использовать Web Application Firewall, ограничивайте частоту вызовов API-методов, особенно тех, которые приводят к расходным операциям (например, отправке SMS). Этот совет спас уже как минимум один бизнес. Если нет жёстких регуляторных ограничений, то, возможно, стоит рассмотреть «серые» схемы для получения нужного зарубежного ПО, потому что это может быть лучше, чем не иметь никакой защиты вообще.

- Если повезёт найти адекватного специалиста, который не будет просто «разводить на деньги», а действительно поможет разобраться в ваших рисках и подобрать посильные решения, то это может быть очень ценно.

Так какой выбор остаётся у малого и среднего бизнеса?

- Использовать Open Source-решения и пытаться найти или даже «вырастить» собственного специалиста, который сможет всё это настроить и поддерживать. Это сложно, долго и рискованно.

- Не делать ничего — к сожалению, это самый частый вариант.

- Покупка дорогих проприетарных решений и наём суперспециалиста — это, как я уже говорил, для такого бизнеса практически нереально из-за бюджетов.

Возвращаясь к основному тезису: для малого и среднего бизнеса полноценной информационной безопасности как системного явления на сегодня, увы, не существует.

Найти какой-то «здравый баланс» между уровнем защиты и затратами на неё для МСБ сейчас практически нереально. И, к сожалению, я не вижу предпосылок к тому, что ситуация кардинально изменится к лучшему в ближайшее время без каких-то системных сдвигов на рынке ИБ-решений и в подходе к подготовке кадров.

Если интересно посмотреть, как мы обосрёмся (или вдруг нет) с нашим облаком — вот телеграм-канал t.me/+g1JETQ88dDBlZTRi Там есть про то, зачем граната и пистолет айтишнику в России. Очень нужны.

h3llo.cloud/ru

limits.h3llo.cloud

hh.ru/employer/11153353