Институт Гладстона создает огненный шар Backblaze, издание XXXL

Здесь, в Backblaze, мы, как известно, поступаем немного иначе. Мы часто выбираем другой путь — от модулей хранения и хранилищ Backblaze до данных о сельском хозяйстве и жестких дисках. Поэтому неудивительно, что мы любим рассказы о людях, которые нестандартно мыслят, когда сталкиваются с проблемой. Это особенно верно, когда эта история связана с созданием сервера хранения mongo, почтенной Toyota 4Runner и парой ИТ-инженеров, одержимых целью получить 1,2 петабайта данных своей организации за пределами офиса. Давайте познакомимся с Алексом Акостой и Эндрю Дэвисом из Gladstone Institutes.

Данные в бегах

Охранник на стойке регистрации понимающе кивнул, когда Алекс и Эндрю катили три больших чемодана «Черепахи» через вестибюль и выходили из парадной двери Гладстонского института. Хорошо известные и широко уважаемые, два ИТ-инженера составляли в то время две трети персонала ИТ-операций, и у них был 25-летний опыт работы в Гладстоне. Как ни странно, что ИТ-персонал покидает безопасный объект в нерабочее время с тремя крупными делами, все было на подъеме.

В середине февраля были сумерки. Алекс и Эндрю приготовились к холоду, когда они вышли на почти пустую автостоянку, неся драгоценный груз в этих трех ящиках. 4Runner Эндрю был близок к этому, он прибыл рано в тот день — важный день, день переезда. Они осторожно затащили тяжелые чемоданы в 4Runner. Большую часть веса составляли сами корпуса, остальной частью был сервер хранения 4U, а в двух других — 36 жестких дисков. Незначительная часть веса, если вообще была, была причиной того, что они делали все это — 200 терабайт данных исследований Института Гладстона.

Они закрепили чемоданы, захлопнули дверь багажника, сели в 4Runner и привели колеса в движение для следующей части своего плана. Они свернули на шоссе 101 и направились на юг. Движение было ужасным, даже автострада; ужин будет поздно, как и многие предыдущие ужины.

Назад к началу

Было много других поздних ночей с тех пор, как они начали этот проект шесть месяцев назад. Проект Fireball XXXL, как в итоге назвали его Алекс и Эндрю, был продиктован их миссией по защите данных биомедицинских исследований Гладстона от неминуемой катастрофы. В неизвестный день середины лета Алекс и Эндрю находились в серверной в Гладстоне в окружении более 900 лент, которые выдавали себя за систему резервного копирования.

Эндрю размышлял: «Это могла быть программа-вымогатель, здание загорелось, кто-то случайно удалил наборы данных из-за записи в командной строке, может произойти любое количество вещей, которые все это уничтожат». Алекс, махнув рукой по постоянно расширяющейся ленточной библиотеке, добавил: «Мы больше не можем полагаться на это. Ленты громоздкие, грязные и портятся, даже если вы все делаете правильно. Мы тратим так много времени на устранение неполадок, и в 2020 году нам больше не придется заниматься устранением неполадок». Они решили найти лучший способ получить свои данные за пределами офиса.

Проверка в реальных условиях

Алекс и Эндрю перечислили цели своего проекта: получить 1,2 петабайта данных, которые в настоящее время хранятся на месте и в их ленточной библиотеке, безопасно за пределами площадки, иметь возможность добавлять 10–20 терабайт новых данных каждый день и иметь возможность удалять файлы по мере необходимости. Тот факт, что практически каждый байт рассматриваемых данных представляет собой исследование биомедицинских заболеваний, включая данные, непосредственно применимые к борьбе с глобальной пандемией, означал, что они должны были выполнить все вышеперечисленное с минимальным временем простоя и максимальной надежностью. Да, и все это им пришлось делать, не увеличивая свой бюджет. Оптимисты.

Поскольку облачное хранилище является наиболее многообещающим вариантом, они сначала подумали о создании собственного частного облака в удаленном центре обработки данных в пустыне. Они быстро отказались от этой идеи, поскольку первоначальные затраты были ошеломляющими, не говоря уже о текущих затратах на персонал и техническое обслуживание для управления удаленными системами.

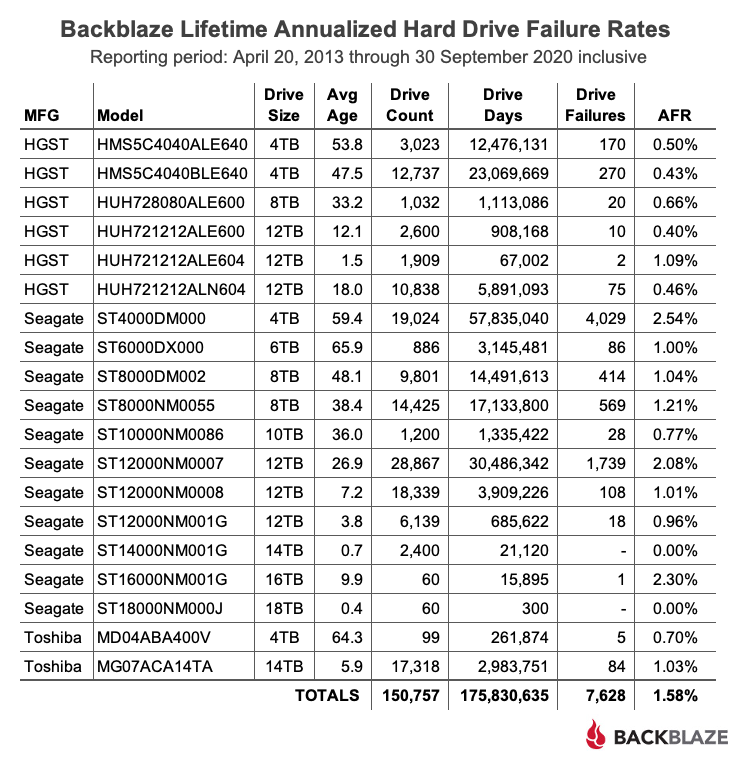

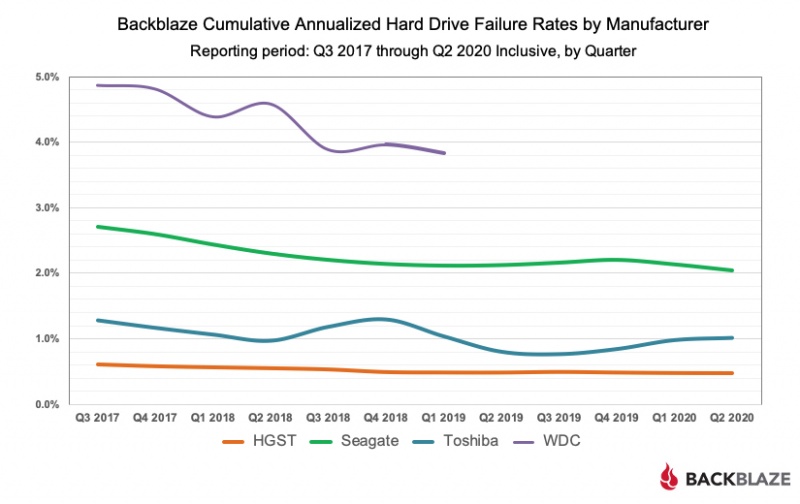

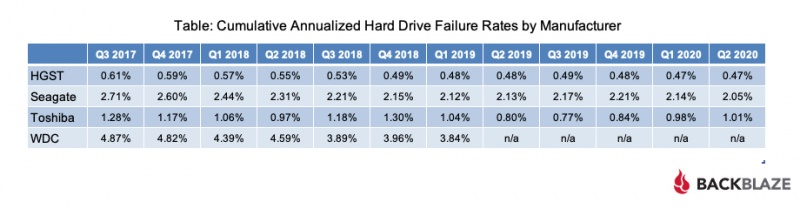

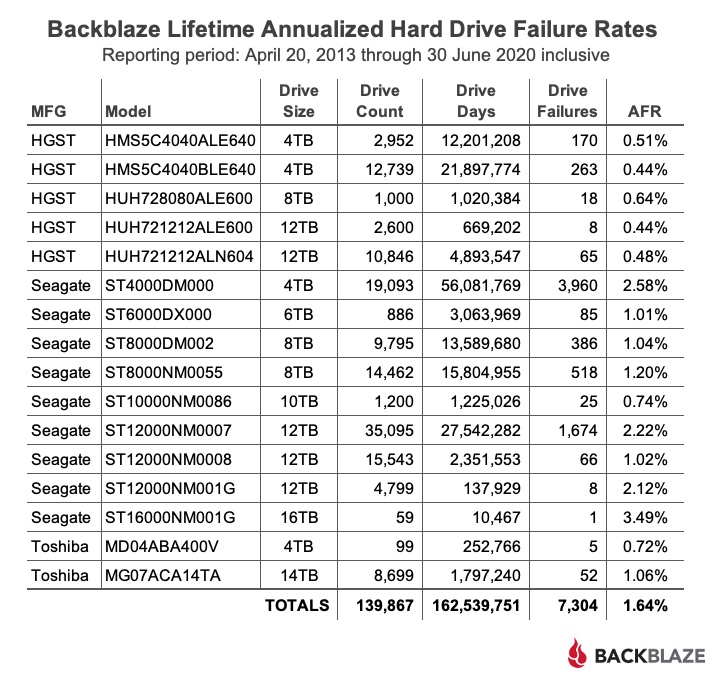

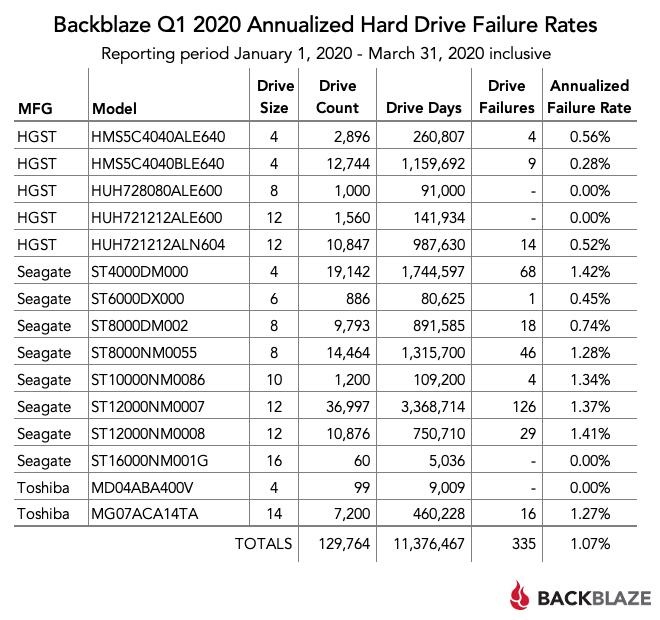

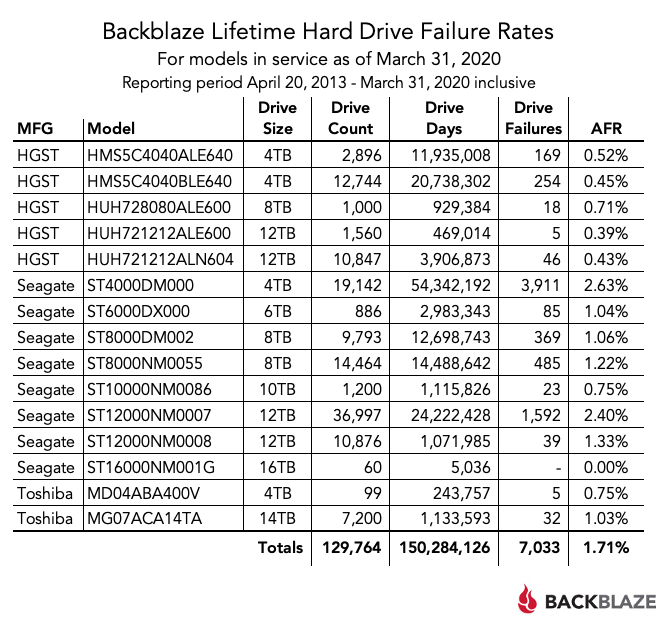

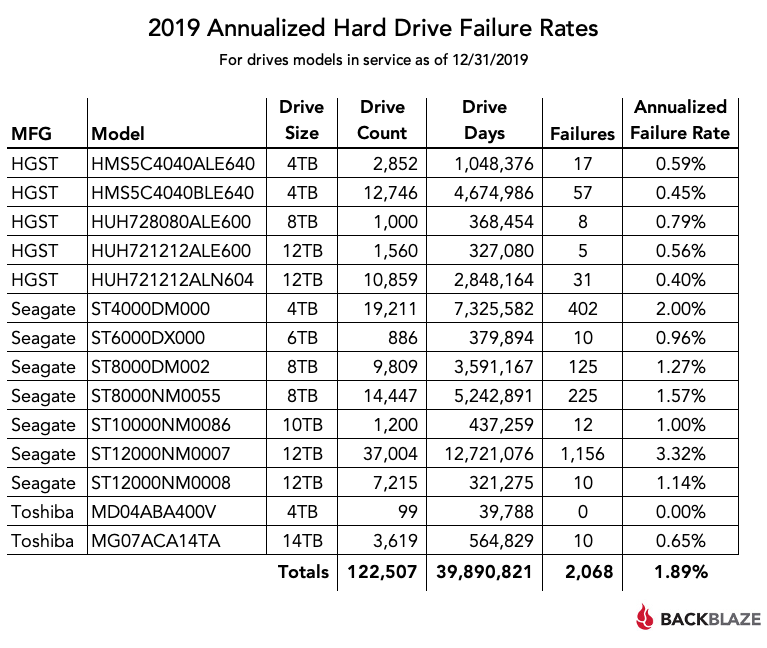

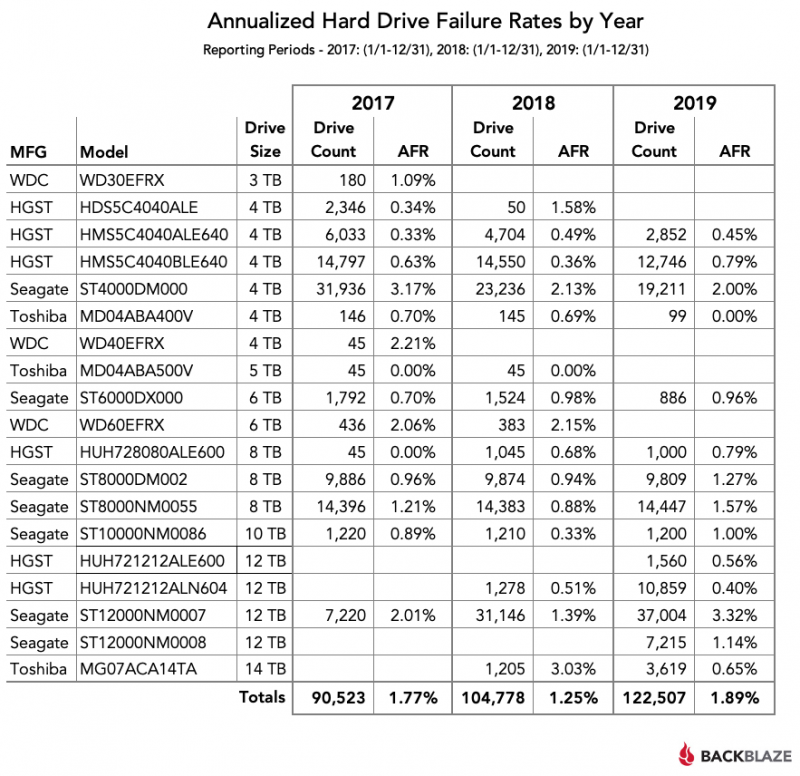

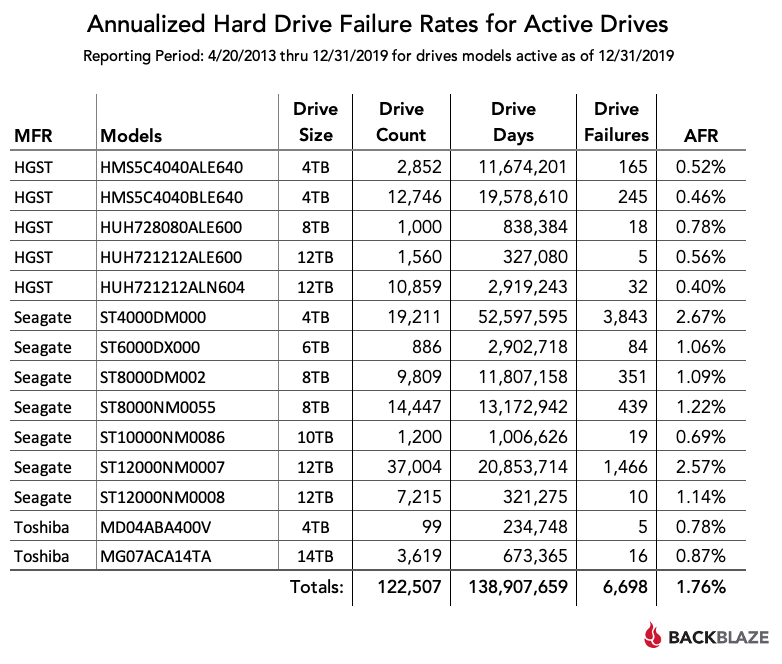

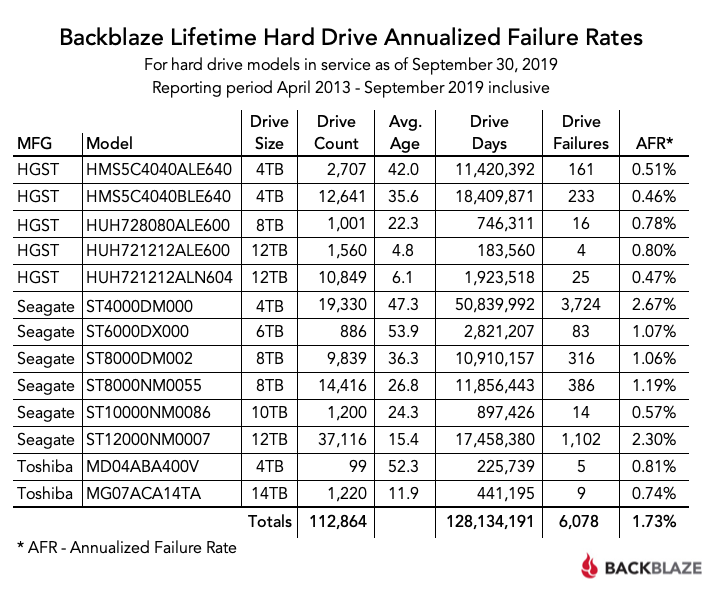

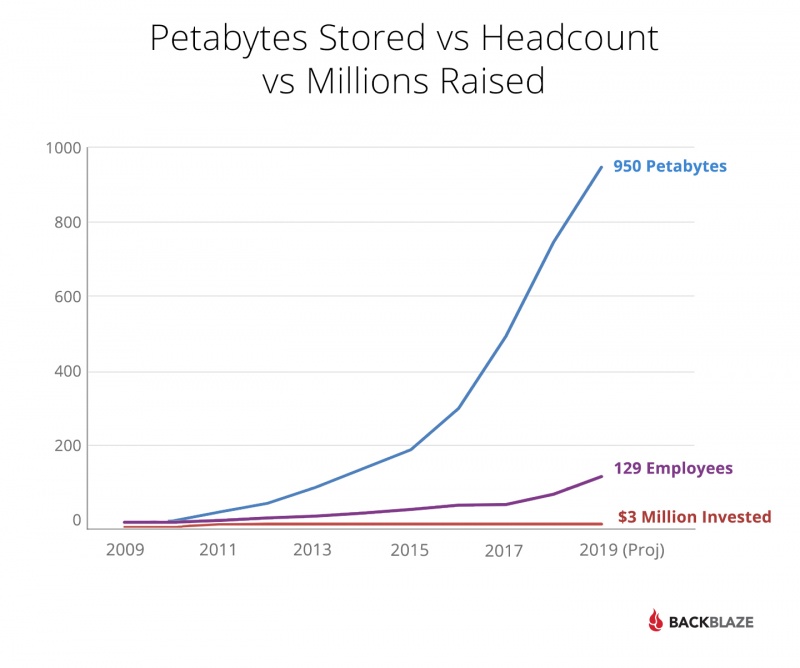

Они решили, что лучший вариант — использовать облачное хранилище, и сравнили ведущих поставщиков. Алекс был знаком с Backblaze, много лет следил за блогом, особенно с сообщениями о статистике дисков и модулях хранения. Более того, облачное хранилище Backblaze B2 было простым и доступным. Кое-что он не мог сказать о других ведущих поставщиках облачных хранилищ.

Следующей проблемой была пропускная способность. Вы могли подумать, что соединения со скоростью 5 Гбит / с будет достаточно, но у них была организация, которая требовала много исследований и данных, и использовала это соединение. Они затачивали свои карандаши для пропускной способности и, с учетом институционального использования, подсчитали, что могут легко поддерживать загрузку 10–20 терабайт в день. Проблема была в том, что загрузить существующие 1,2 петабайта данных было бы совсем другим делом. Они связались со своим поставщиком пропускной способности и им сказали, что они могут удвоить свою текущую пропускную способность до 10 Гбит / с по многолетнему соглашению почти в два раза дороже, и, кстати, пройдет от нескольких месяцев до года, прежде чем они смогут начать работу. Ой.

Они обратились к Backblaze, который предложил свой сервис передачи данных Backblaze Fireball, который мог загружать около 70 терабайт за поездку. «Даже с Fireball нам потребуется 15, может быть, 20 поездок туда и обратно», — сетовал Эндрю во время очередного ночного сеанса просмотра резервных копий. «Я бы хотел, чтобы у них была коробка побольше», — сказал Алекс, на что Эндрю ответил: «Может, мы сможем построить такую».

Родился план: построить сервер хранения mongo, загрузить на него данные и отнести в Backblaze.

Спросите

Прежде чем они появились в центре обработки данных Backblaze со своим творением, они решили, что сначала должны спросить Backblaze. Алекс отметил: «В большинстве компаний, если вы скажете:« Эй, я хочу построить массивный файловый сервер, доставить его в ваш центр обработки данных и подключить. Разве вы мне не доверяете? »Они ответят:« Нет, 'и повесили трубку, но Backblaze этого не сделал, они прислушались».

После долгих размышлений Backblaze согласился разрешить персоналу Gladstone войти в ближайший центр обработки данных, который был точкой пиринга для сети Backblaze. В восторге от того, что они нашли родственных душ, у Алекса и Эндрю появился партнер в проекте Fireball XXXL. Хотя это сотрудничество было уникальной возможностью для обеих сторон, для Эндрю и Алекса это также означало бы больше поздних ночей и буррито в микроволновке. Теперь это не имело значения, они чувствовали, что у них есть отличный шанс реализовать свой проект.

Сборка

Алекс и Эндрю выделили некоторый бюджет на, казалось бы, несвязанный проект: построить собственный сервер хранения, который будет служить системой горячего резервирования для текущих активных лабораторных проектов. Таким образом, если в лаборатории что-то пойдет не так, они смогут при необходимости получить последнюю сохраненную версию данных. Используя эти средства, они поняли, что могут построить что-то, что будет использоваться в качестве их огромного Fireball XXXL, а затем, когда циклы передачи данных будут завершены, они могут перепрофилировать систему в качестве резервного сервера, на который они заложили бюджет.

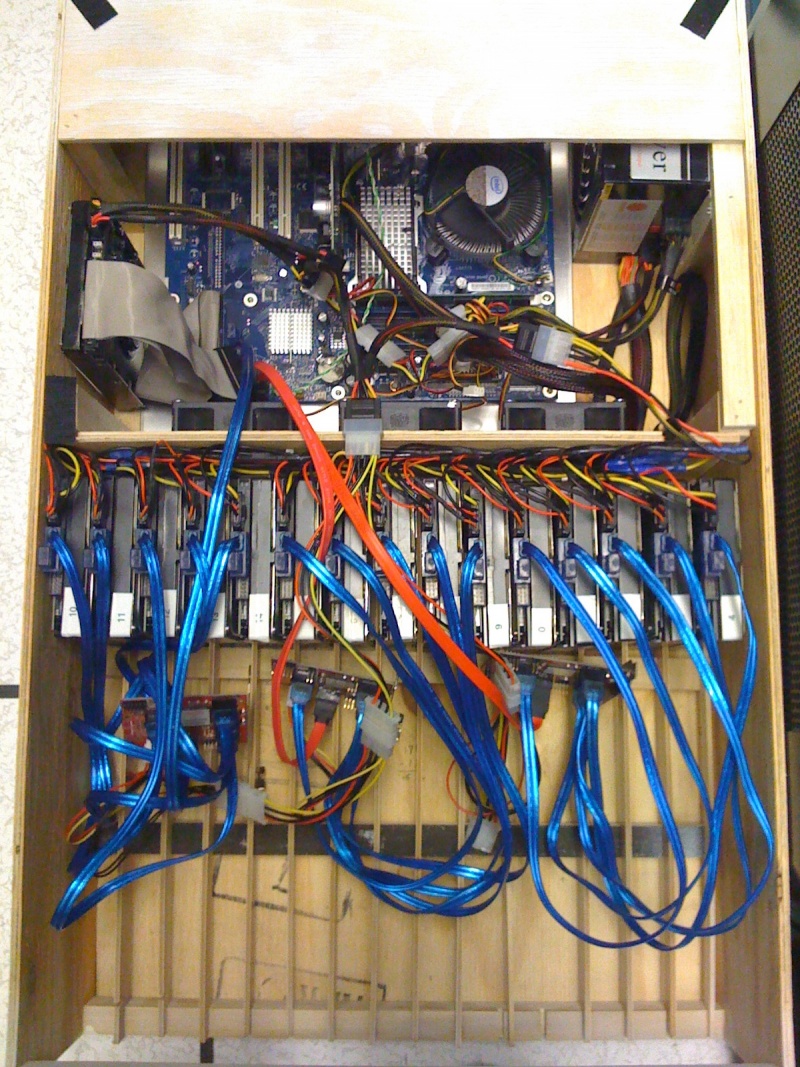

Вдохновленные Backblaze Storage Pod с открытым исходным кодом, они работали с Backblaze над спецификациями для своего Fireball XXXL. Они пошли по пути нестандартной сборки, начав с шасси 4U и больших дисков, а затем добавили несколько мощных компонентов.

Огненный шар XXXL

Загрузка

Gladstone запускает TrueNAS в своих локальных производственных системах, поэтому имело смысл использовать его на недавно построенном сервере передачи данных. «Мы смогли отправить ZFS с наших внутренних серверов на то, что выглядело как гигантский внешний жесткий диск из-за отсутствия лучшего описания», — сказал Эндрю. «Это позволило нам выполнять репликацию на уровне блоков в сжатом виде, поэтому было намного выше производительность при копировании данных в эту систему».

Эндрю и Алекс ранее решили, что они начнут с четырех наборов данных размером более 40 терабайт каждый. Каждый набор данных представляет собой годы исследований в соответствующих лабораториях, помещая их в верхнюю часть очереди резервного копирования за пределами предприятия. В течение 10 дней они загрузили данные в Fireball XXXL. По завершении они выключили систему и удалили диски. Открыв чехлы Turtle с пенопластом, которые они приобрели ранее, они осторожно поместили шасси в один корпус, а 36 дисков — в два других. Они закрыли одеяла и направились в вестибюль Гладстона.

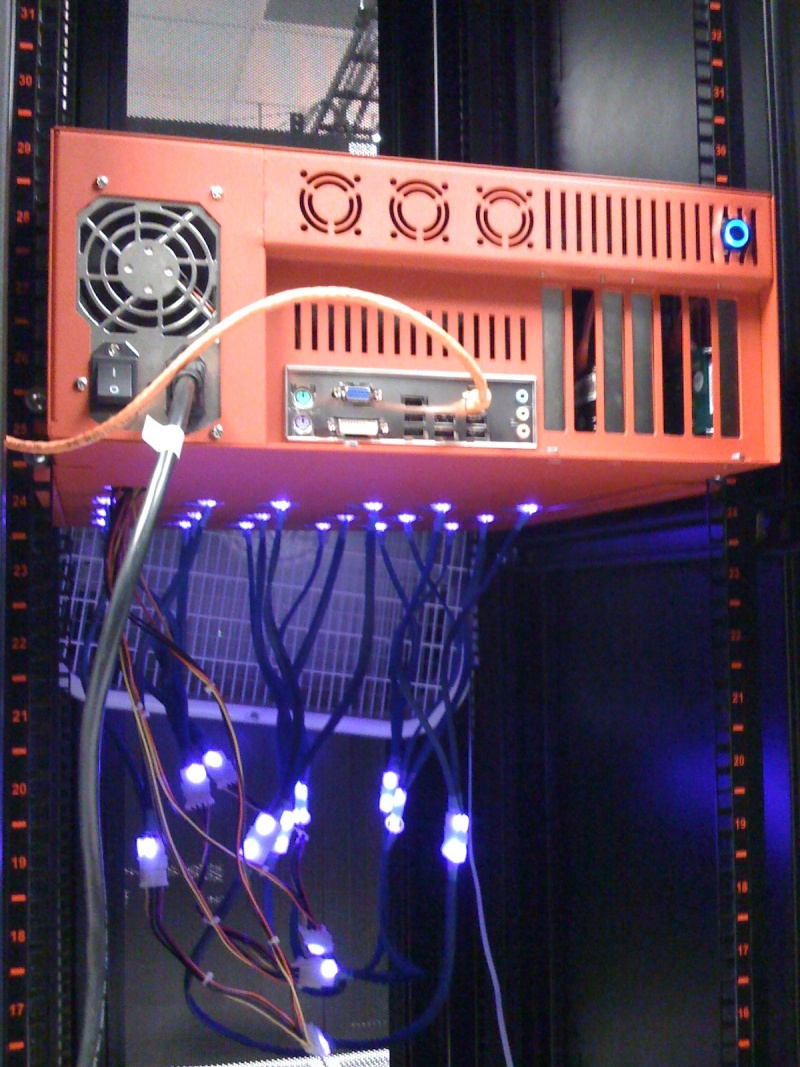

В дата-центре

В конце концов Алекс и Эндрю прибыли в центр обработки данных, где они нашли необходимую точку пиринга сети Backblaze. При входе последовали проверки, и хотя Backblaze поручился за ребят из Гладстона, процесс входа был трудным. Как и должно быть. Оказавшись в назначенной комнате, они подключили несколько кабелей, ввели несколько команд терминала, и данные начали загружаться в их учетную запись Backblaze B2. Fireball XXXL работал, как и ожидалось, с устойчивой скоростью передачи от 8 до 10 Гбит / с. На загрузку всех данных ушло чуть больше трех дней.

Через несколько недель они совершат еще одну поездку и запланировали еще два. С каждой поездкой все больше данных Gladstone надежно хранится за пределами площадки.

Институты Гладстона с более чем 40-летней историей и более 450 сотрудников являются мировым лидером в области биомедицинских исследований сердечно-сосудистых и неврологических заболеваний, геномной иммунологии и вирусологии, причем некоторые лаборатории недавно переключили свое внимание на SARS-CoV- 2, вирус, вызывающий COVID-19. Исследователи из Gladstone полагаются на свою ИТ-команду, чтобы защитить и защитить свои жизненно важные исследования.

Эпилог

Прежде чем вы загрузите свой 200-терабайтный медиа-сервер в заднюю часть внедорожника или пикапа и направитесь в центр обработки данных Backblaze — остановитесь. Хотя мы восхищаемся находчивостью Эндрю и Алекса, с нашей стороны процесс был трудным. Процедуры безопасности, связанные с ними документы и время, необходимое для того, чтобы наши герои Гладстона получили доступ к центру обработки данных и нашей сети с их Fireball XXXL, были «существенными». Тем не менее, мы рады, что сделали это. В ходе этого процесса мы многому научились, и, возможно, когда-нибудь мы предложим наш собственный Fireball XXXL. Если да, то мы знаем, где найти пару парней, которые умеют спроектировать одну систему ударов. Спасибо за поездку, господа.

Данные в бегах

Охранник на стойке регистрации понимающе кивнул, когда Алекс и Эндрю катили три больших чемодана «Черепахи» через вестибюль и выходили из парадной двери Гладстонского института. Хорошо известные и широко уважаемые, два ИТ-инженера составляли в то время две трети персонала ИТ-операций, и у них был 25-летний опыт работы в Гладстоне. Как ни странно, что ИТ-персонал покидает безопасный объект в нерабочее время с тремя крупными делами, все было на подъеме.

В середине февраля были сумерки. Алекс и Эндрю приготовились к холоду, когда они вышли на почти пустую автостоянку, неся драгоценный груз в этих трех ящиках. 4Runner Эндрю был близок к этому, он прибыл рано в тот день — важный день, день переезда. Они осторожно затащили тяжелые чемоданы в 4Runner. Большую часть веса составляли сами корпуса, остальной частью был сервер хранения 4U, а в двух других — 36 жестких дисков. Незначительная часть веса, если вообще была, была причиной того, что они делали все это — 200 терабайт данных исследований Института Гладстона.

Они закрепили чемоданы, захлопнули дверь багажника, сели в 4Runner и привели колеса в движение для следующей части своего плана. Они свернули на шоссе 101 и направились на юг. Движение было ужасным, даже автострада; ужин будет поздно, как и многие предыдущие ужины.

Назад к началу

Было много других поздних ночей с тех пор, как они начали этот проект шесть месяцев назад. Проект Fireball XXXL, как в итоге назвали его Алекс и Эндрю, был продиктован их миссией по защите данных биомедицинских исследований Гладстона от неминуемой катастрофы. В неизвестный день середины лета Алекс и Эндрю находились в серверной в Гладстоне в окружении более 900 лент, которые выдавали себя за систему резервного копирования.

Эндрю размышлял: «Это могла быть программа-вымогатель, здание загорелось, кто-то случайно удалил наборы данных из-за записи в командной строке, может произойти любое количество вещей, которые все это уничтожат». Алекс, махнув рукой по постоянно расширяющейся ленточной библиотеке, добавил: «Мы больше не можем полагаться на это. Ленты громоздкие, грязные и портятся, даже если вы все делаете правильно. Мы тратим так много времени на устранение неполадок, и в 2020 году нам больше не придется заниматься устранением неполадок». Они решили найти лучший способ получить свои данные за пределами офиса.

Проверка в реальных условиях

Алекс и Эндрю перечислили цели своего проекта: получить 1,2 петабайта данных, которые в настоящее время хранятся на месте и в их ленточной библиотеке, безопасно за пределами площадки, иметь возможность добавлять 10–20 терабайт новых данных каждый день и иметь возможность удалять файлы по мере необходимости. Тот факт, что практически каждый байт рассматриваемых данных представляет собой исследование биомедицинских заболеваний, включая данные, непосредственно применимые к борьбе с глобальной пандемией, означал, что они должны были выполнить все вышеперечисленное с минимальным временем простоя и максимальной надежностью. Да, и все это им пришлось делать, не увеличивая свой бюджет. Оптимисты.

Поскольку облачное хранилище является наиболее многообещающим вариантом, они сначала подумали о создании собственного частного облака в удаленном центре обработки данных в пустыне. Они быстро отказались от этой идеи, поскольку первоначальные затраты были ошеломляющими, не говоря уже о текущих затратах на персонал и техническое обслуживание для управления удаленными системами.

Они решили, что лучший вариант — использовать облачное хранилище, и сравнили ведущих поставщиков. Алекс был знаком с Backblaze, много лет следил за блогом, особенно с сообщениями о статистике дисков и модулях хранения. Более того, облачное хранилище Backblaze B2 было простым и доступным. Кое-что он не мог сказать о других ведущих поставщиках облачных хранилищ.

Следующей проблемой была пропускная способность. Вы могли подумать, что соединения со скоростью 5 Гбит / с будет достаточно, но у них была организация, которая требовала много исследований и данных, и использовала это соединение. Они затачивали свои карандаши для пропускной способности и, с учетом институционального использования, подсчитали, что могут легко поддерживать загрузку 10–20 терабайт в день. Проблема была в том, что загрузить существующие 1,2 петабайта данных было бы совсем другим делом. Они связались со своим поставщиком пропускной способности и им сказали, что они могут удвоить свою текущую пропускную способность до 10 Гбит / с по многолетнему соглашению почти в два раза дороже, и, кстати, пройдет от нескольких месяцев до года, прежде чем они смогут начать работу. Ой.

Они обратились к Backblaze, который предложил свой сервис передачи данных Backblaze Fireball, который мог загружать около 70 терабайт за поездку. «Даже с Fireball нам потребуется 15, может быть, 20 поездок туда и обратно», — сетовал Эндрю во время очередного ночного сеанса просмотра резервных копий. «Я бы хотел, чтобы у них была коробка побольше», — сказал Алекс, на что Эндрю ответил: «Может, мы сможем построить такую».

Родился план: построить сервер хранения mongo, загрузить на него данные и отнести в Backblaze.

Спросите

Прежде чем они появились в центре обработки данных Backblaze со своим творением, они решили, что сначала должны спросить Backblaze. Алекс отметил: «В большинстве компаний, если вы скажете:« Эй, я хочу построить массивный файловый сервер, доставить его в ваш центр обработки данных и подключить. Разве вы мне не доверяете? »Они ответят:« Нет, 'и повесили трубку, но Backblaze этого не сделал, они прислушались».

После долгих размышлений Backblaze согласился разрешить персоналу Gladstone войти в ближайший центр обработки данных, который был точкой пиринга для сети Backblaze. В восторге от того, что они нашли родственных душ, у Алекса и Эндрю появился партнер в проекте Fireball XXXL. Хотя это сотрудничество было уникальной возможностью для обеих сторон, для Эндрю и Алекса это также означало бы больше поздних ночей и буррито в микроволновке. Теперь это не имело значения, они чувствовали, что у них есть отличный шанс реализовать свой проект.

Сборка

Алекс и Эндрю выделили некоторый бюджет на, казалось бы, несвязанный проект: построить собственный сервер хранения, который будет служить системой горячего резервирования для текущих активных лабораторных проектов. Таким образом, если в лаборатории что-то пойдет не так, они смогут при необходимости получить последнюю сохраненную версию данных. Используя эти средства, они поняли, что могут построить что-то, что будет использоваться в качестве их огромного Fireball XXXL, а затем, когда циклы передачи данных будут завершены, они могут перепрофилировать систему в качестве резервного сервера, на который они заложили бюджет.

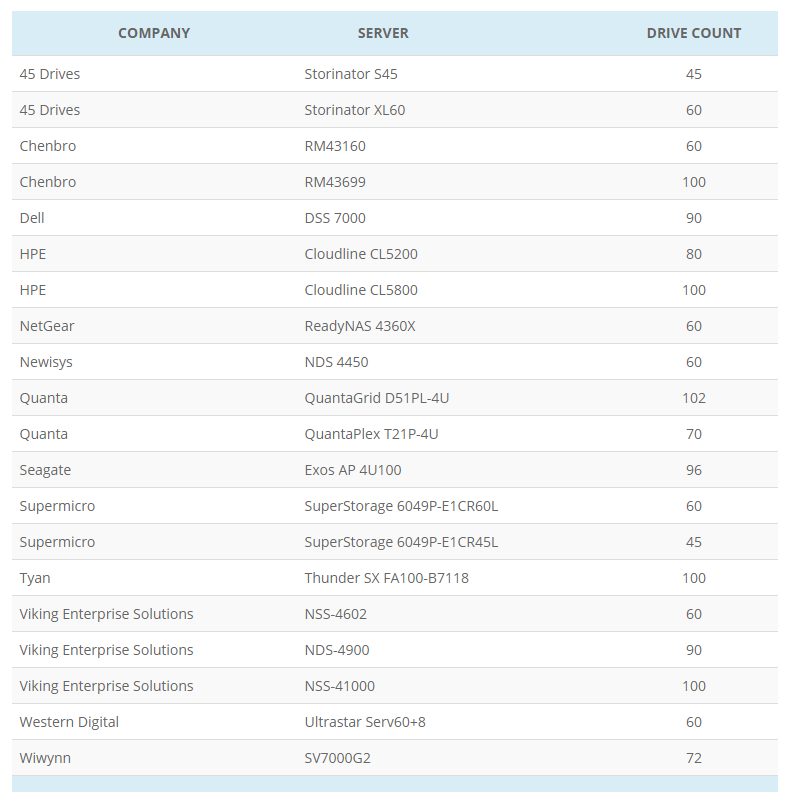

Вдохновленные Backblaze Storage Pod с открытым исходным кодом, они работали с Backblaze над спецификациями для своего Fireball XXXL. Они пошли по пути нестандартной сборки, начав с шасси 4U и больших дисков, а затем добавили несколько мощных компонентов.

Огненный шар XXXL

- Шасси: 4U Supermicro с 36 отсеками, 3,5-дюймовое дисковое шасси, построенное iXsystems.

- Процессор: Двухъядерный Intel Xeon Gold 5217.

- Оперативная память: 4 x 32 ГБ (128 ГБ).

- Диски данных: 36 14 ТБ HE14 от Western Digital.

- ЗИЛ: 120 ГБ NVMe SSD.

- L2ARC: 512 ГБ SSD.

Загрузка

Gladstone запускает TrueNAS в своих локальных производственных системах, поэтому имело смысл использовать его на недавно построенном сервере передачи данных. «Мы смогли отправить ZFS с наших внутренних серверов на то, что выглядело как гигантский внешний жесткий диск из-за отсутствия лучшего описания», — сказал Эндрю. «Это позволило нам выполнять репликацию на уровне блоков в сжатом виде, поэтому было намного выше производительность при копировании данных в эту систему».

Эндрю и Алекс ранее решили, что они начнут с четырех наборов данных размером более 40 терабайт каждый. Каждый набор данных представляет собой годы исследований в соответствующих лабораториях, помещая их в верхнюю часть очереди резервного копирования за пределами предприятия. В течение 10 дней они загрузили данные в Fireball XXXL. По завершении они выключили систему и удалили диски. Открыв чехлы Turtle с пенопластом, которые они приобрели ранее, они осторожно поместили шасси в один корпус, а 36 дисков — в два других. Они закрыли одеяла и направились в вестибюль Гладстона.

В дата-центре

В конце концов Алекс и Эндрю прибыли в центр обработки данных, где они нашли необходимую точку пиринга сети Backblaze. При входе последовали проверки, и хотя Backblaze поручился за ребят из Гладстона, процесс входа был трудным. Как и должно быть. Оказавшись в назначенной комнате, они подключили несколько кабелей, ввели несколько команд терминала, и данные начали загружаться в их учетную запись Backblaze B2. Fireball XXXL работал, как и ожидалось, с устойчивой скоростью передачи от 8 до 10 Гбит / с. На загрузку всех данных ушло чуть больше трех дней.

Через несколько недель они совершат еще одну поездку и запланировали еще два. С каждой поездкой все больше данных Gladstone надежно хранится за пределами площадки.

Институты Гладстона с более чем 40-летней историей и более 450 сотрудников являются мировым лидером в области биомедицинских исследований сердечно-сосудистых и неврологических заболеваний, геномной иммунологии и вирусологии, причем некоторые лаборатории недавно переключили свое внимание на SARS-CoV- 2, вирус, вызывающий COVID-19. Исследователи из Gladstone полагаются на свою ИТ-команду, чтобы защитить и защитить свои жизненно важные исследования.

Эпилог

Прежде чем вы загрузите свой 200-терабайтный медиа-сервер в заднюю часть внедорожника или пикапа и направитесь в центр обработки данных Backblaze — остановитесь. Хотя мы восхищаемся находчивостью Эндрю и Алекса, с нашей стороны процесс был трудным. Процедуры безопасности, связанные с ними документы и время, необходимое для того, чтобы наши герои Гладстона получили доступ к центру обработки данных и нашей сети с их Fireball XXXL, были «существенными». Тем не менее, мы рады, что сделали это. В ходе этого процесса мы многому научились, и, возможно, когда-нибудь мы предложим наш собственный Fireball XXXL. Если да, то мы знаем, где найти пару парней, которые умеют спроектировать одну систему ударов. Спасибо за поездку, господа.