CyberBunker.com — пионер анонимного хостинга, который начал работу в 1998 году. Компания разместила серверы в одном из самых необычных мест: внутри бывшего подземного комплекса НАТО, построенного в 1955 году как защищённый бункер на случай ядерной войны.

Клиенты становились в очередь: все серверы обычно были заняты, несмотря на завышенные цены: VPS стоил от €100 до €200 в месяц, без учёта платы за установку, при этом планы VPS не поддерживали Windows. Зато хостер успешно игнорировал любые жалобы DMCA из США, принимал биткоины и не требовал от клиентов никакой личной информации, кроме адреса электронной почты.

Но теперь «анонимному беспределу» пришёл конец. Ночью 26 сентября 2019 года бойцы немецкого спецназа и полиции штурмом взяли защищённый и охраняемый бункер. Захват произведён под предлогом борьбы с детской порнографией.

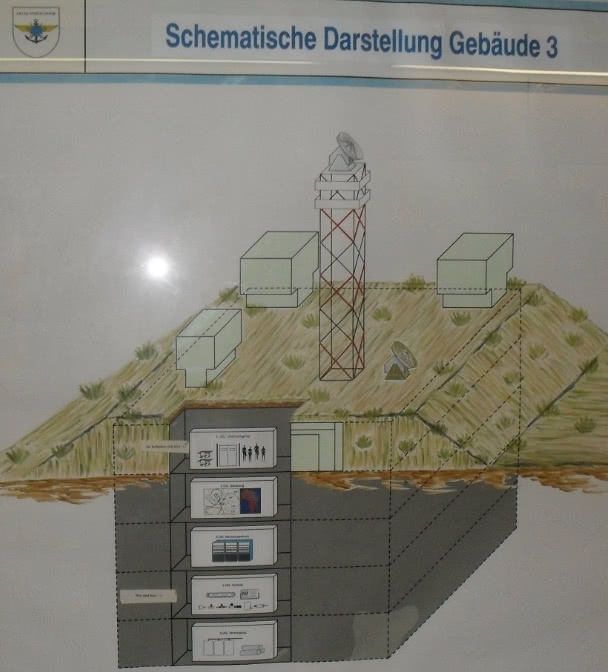

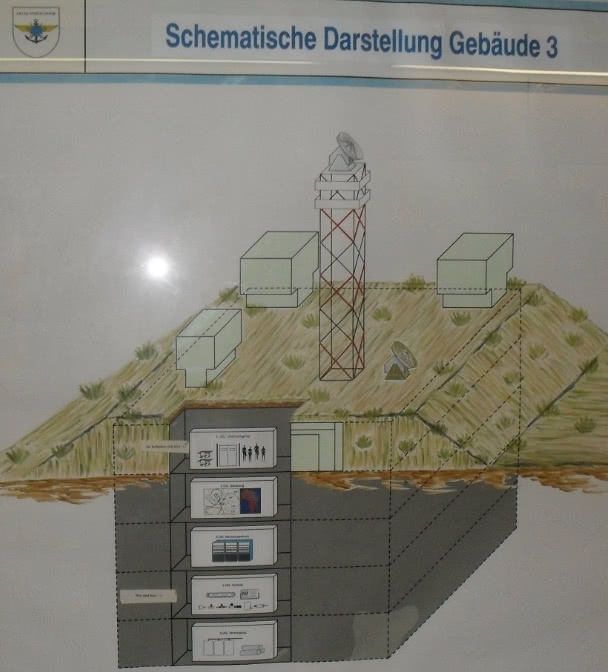

Штурм дался непросто, поскольку бункер находится в труднодоступном месте в лесном массиве, а сам дата-центр расположен на нескольких уровнях под землёй.

В операции приняли участие около 650 человек, включая сотрудников правоохранительные органов, спасательные службы, пожарных, медицинский персонал, операторов дронов и т.д.

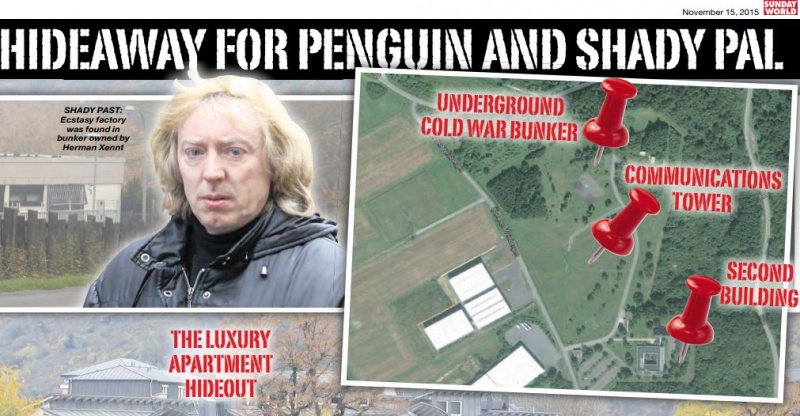

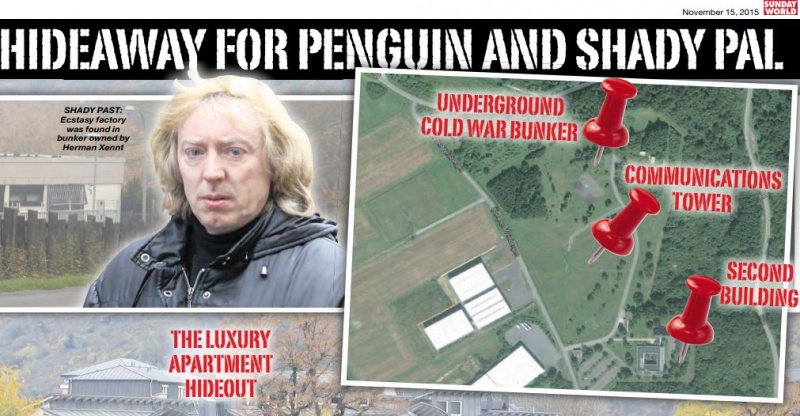

Вход в бункер можно рассмотреть рядом с тремя зданиями в левой верхней части фотографии. По центру — вышка связи. Справа — второе здание дата-центра. Фото сделано с полицейского дрона

Спутниковая карта этого района

www.google.com/maps/@49.9664317,7.1207858,660m/data=!3m1!1e3

Полиция перед входом в бункер после начала операции

Захваченный объект находится около городка Трабен-Трарбах в юго-западной части Германии (земля Рейнланд-Пфальц, столица Майнц). Четыре подземных этажа бункера уходят в глубину на 25 метров.

Прокурор Юрген Бауэр (Juergen Bauer) рассказал журналистам, что расследование деятельности анонимного хостинга велось несколько лет. Операция тщательно готовилось. Одновременно со штурмом задержано семь человек в ресторане Трабен-Трарбаха и в городе Швальбах, недалеко от Франкфурта. Главным подозреваемым является 59-летний голландец. Задержаны он и трое его соотечественников (49, 33 и 24 года), один немец (23 года), болгарин и единственная женщина (немка, 52 года).

Обыски проведены также в Польше, Нидерландах и Люксембурге. Всего конфисковано около 200 серверов, бумажные документы, многочисленные носители данных, мобильные телефоны и большая сумма наличных денег (примерно 41 млн долларов в эквиваленте). Следователи говорят, что анализ улик займёт несколько лет.

В ходе рейда немецкие власти также захватили по крайней мере два домена, в том числе домен голландской компании ZYZTM Research (zyztm[.]com) и cb3rob[.]org.

По информации властей, вышеупомянутый голландец приобрёл бывший военный бункер в 2013 году — и превратил его в большой и хорошо защищённый центр обработки данных, «чтобы сделать его доступным для клиентов, согласно нашим расследованиям, исключительно в незаконных целях», — добавил Бауэр.

В Германии хостера нельзя привлечь к ответственности за размещение незаконных веб-сайтов, если не будет доказано, что он знал и поддерживал незаконную деятельность.

Бывший объект НАТО был куплен у геоинформационного подразделения Бундесвера. Пресс-релизы в то время описывают его как многоэтажное защитное сооружение площадью 5500 м². У него два смежных офисных здания площадью 4300 м², общая территория построек занимает 13 гектаров земли.

Начальник региональной уголовной полиции Йоханнес Кунц (Johannes Kunz) добавил, что подозреваемый «связан с организованной преступностью» и большую часть своего времени проводил в этом районе, хотя подал документы на переезд в Сингапур. Вместо эмиграции владелец дата-центра, предположительно, жил прямо в подземном бункере.

Всего под следствием находятся тринадцать человек в возрасте от 20 до 59 лет, в том числе трое граждан Германии и семь граждан Нидерландов, сообщил Брауэр.

Семерых взяли под арест, потому что есть вероятность их бегства из страны. Их подозревают в участии в преступной организации, налоговых нарушениях, а также в соучастии в «сотнях тысяч преступлений», связанных с наркотиками, отмыванием денег и поддельными документами, а также в пособничестве распространению детской порнографии. Власти не назвали ни одного имени.

Следователи описали дата-центр как «пуленепробиваемый хостинг», предназначенный для сокрытия незаконной деятельности от глаз властей.

«Я думаю, что это огромный успех… что мы вообще смогли ввести полицейские силы в бункерный комплекс, который защищён на самом высоком военном уровне, — сказал Кунц. — Мы должны были преодолеть не только реальную или аналоговую защиты, но и взломать цифровую защиту центра обработки данных».

Среди незаконных услуг, предположительно размещённых в немецком дата-центре, были Cannabis Road, Flight Vamp 2.0, Orange Chemicals и вторая в мире по размеру платформа для продажи наркотиков Wall Street Market.

Например, на площадке Cannabis Road было зарегистрировано 87 продавцов нелегальных наркотиков. В целом, платформа обработала как минимум несколько тысяч продаж продуктов из каннабиса.

Платформа Wall Street Market обработала около 250 000 сделок по незаконному обороту наркотиков с объёмом продаж более 41 миллиона евро.

Flight Vamp считается крупнейшей в Швеции площадкой для незаконной продажи наркотиков. Розыск её операторов ведут шведские следственные органы. По данным следствия, там отметились 600 продавцов и около 10 000 покупателей.

Через Orange Chemicals по всей Европе распространялись синтетические наркотики разного вида.

Вероятно, теперь всем перечисленным магазинам придётся переехать на другой хостинг в даркнете.

По словам Бауэра, ботнет-атака на немецкую телекоммуникационную компанию Deutsche Telekom в конце 2016 года, которая вывела из строя около 1 миллиона маршрутизаторов клиентов, также велась с серверов в Кибербункере.

Когда бункер купили в 2013 году, покупатель сразу не назвал себя, но сказал, что связан с CyberBunker, оператором аналогичного голландского дата-центра, расположенного в другом бункере времён холодной войны. Это один из старейших анонимных хостингов в мире. Он декларировал независимость так называемой «Республики Кибербункер» и готовность размещать любой сайт, кроме детской порнографии и всего, что связано с терроризмом. В настоящее время сайт недоступен. На главной странице красуется гордая надпись от правоохранительных органов: «Сервер конфискован» (DIESE SERVER WURDE BESCHLAGNAHMT).

Согласно историческим записям whois, Zyztm.com первоначально был зарегистрирован на имя Германа Йохана Ксеннта (Herman Johan Xennt) из Нидерландов. Домен Cb3rob.org принадлежал организации, которая хостилась в CyberBunker и была зарегистрирована на Свена Олафа Кампхейса, самопровозглашённого анархиста, осуждённого несколько лет назад за участие в вышеупомянутой крупномасштабной атаке, которая ненадолго нарушила работу интернета в некоторых местах.

Предполагаемый владелец и оператор кибербункеров Герман Йохан Ксеннт. Изображение: The Sunday World, 26 июля 2015 года

59-летний Ксеннт и Кампхейс вместе работали над предыдущим проектом «пуленепробиваемого» хостинга CyberBunker, который размещался внутри военного бункера в Нидерландах, пишет исследователь в области информационной безопасности Брайан Кребс.

По словам директора компании Disaster-Proof Solutions Гвидо Блаау (Guido Blaauw), он купил у Ксеннта голландский бункер площадью 1800 м² в 2011 году за $700 тыс. Вероятно, после этого Ксеннт нашёл похожий объект в Германии.

Гвидо Блаау утверждает, что после пожара 2002 года, когда в голландском бункере среди серверов нашли лабораторию по производству экстази, там не размещалось ни одного сервера: «В течение 11 лет они рассказывали всем об этом ультра-безопасном бункере, но [их серверы] размещались в Амстердаме, и в течение 11 лет они обманывали всех своих клиентов».

Аккумуляторы в дата-центре CyberBunker 2.0

Тем не менее, «Республику Кибербункер» возродили в 2013 году на немецкой территории, и предприниматели начали предлагать многие из тех же услуг, и тем же клиентам, что и раньше: «Они известны тем, что принимают мошенников, педофилов, фишеров, всех, — сказал Блаау. — Это то, что они делали в течение многих лет, и они известны этим».

CyberBunker входил в топ хостеров для аниме. К ним предъявляются специфические требования, в том числе гарантия анонимности клиентов. Хотя Кибербункера больше нет, но другие защищённые и анонимные хостеры продолжают работать. Они обычно физически размещены за пределами американской юрисдикции, в офшорных зонах, и декларируют максимальную приватность. Ниже сервисы расположены по позициям в рейтинге сайта любителей аниме:

- Anonymously.io

- Aruba.it

- ShinJiru.com

- CCIHosting.com

- HostingFlame.org

- CyberBunker.com

- DarazHost.com

- SecureHost.com

Анонимный хостинг в литературе

Бывшая фотография из профиля в Facebook Свена Олафа Кампхейса. После ареста в 2013 году он грубо разговаривал с властями и заявлял о независимости Республики Кибербункер

История с Республикой Кибербункер и другими офшорными хостингами чем-то напоминает вымышленное государство Кинакута из романа «Криптономикон» Нила Стивенсона. Роман написан в жанре «альтернативная история» и показывает, в каком направлении могло пойти развитие человечества при небольшом изменении входных параметров или в результате случайности.

Султанат Кинакута — маленький островок в углу моря Сулу, в середине пролива между Калимантаном и филиппинским островом под названием Палаван. Во время Второй мировой войны японцы использовали Кинакуту как плацдарм для нападения на голландскую Ост-Индию и Филиппины. Там была база ВМФ и аэродром. После войны Кинакута вновь обрела независимость, в том числе финансовую, благодаря запасам нефти.

По какой-то причине султан Кинакуты решил сделать из своего государства «информационный рай». Был принят закон, который касается всех телекоммуникаций, идущих через территорию Кинакуты: «Я отказываюсь от всякой административной власти над информационными потоками внутри страны и через её границы, — объявил правитель. — Ни при каких обстоятельствах правительство не будет совать нос в информационные потоки или использовать свою власть для ограничения этих потоков. Таков новый закон Кинакуты». После этого на территории Кинакуты было создано виртуальное государство Крипта:

Крипта. «Реальная» столица Сети. Рай хакеров. Кошмар корпораций и банков. «Враг номер один» ВСЕХ мировых правительств. В сети нет ни стран, ни национальностей. Есть только СВОБОДНЫЕ люди, готовые сражаться за свою свободу!..

Нил Стивенсон. «Криптономикон»

В преломлении на современные реалии офшорные анонимные хостинги представляют собой некое подобие Крипты — независимой платформы, которая не подконтрольна мировым правительствам. В романе описан даже дата-центр в искусственной пещере (информационное «сердце» Крипты), который немного похож на немецкий Кибербункер:

В стене есть ещё отверстие — видимо, от этой пещеры ответвляются несколько боковых. Том ведет Рэнди туда и почти сразу предостерегающе берёт за локоть: впереди пятиметровый колодец, вниз уходит деревянная лестница.

— То, что ты сейчас видел, — главная коммутаторная, — говорит Том.

— Когда её закончат, получится самый большой маршрутизатор в мире. В соседних комнатах мы разместим компьютеры и систему хранения. По сути — самый большой в мире RAID с большим пребольшим кешем.

RAID означает избыточный массив недорогих дисков — способ надёжно и дёшево хранить большое количество информации. Как раз то, что нужно для информационного рая.

— Мы пока ещё расширяем соседние помещения, — продолжает Том, — и кое на что там наткнулись. Думаю, тебе будет интересно. — Он поворачивается и начинает спускаться по лестнице. — Ты знаешь, что в войну у японцев здесь было бомбоубежище?

У Рэнди в кармане — отксеренная карта из книги. Он вынимает её и подносит к лампочке. Разумеется, высоко в горах отмечен «ВХОД В БОМБОУБЕЖИЩЕ И КОМАНДНЫЙ ПУНКТ».

Нил Стивенсон. «Криптономикон»

Крипта заняла ту же экологическую нишу, какую в реальном финансовом мире занимает Швейцария.

В реальности организовать такой «информационный рай» не так просто, как в литературе. Впрочем, в некоторых аспектах альтернативная история Стивенсона начинает постепенно сбываться. Например, сегодня значительная часть международной коммуникационной инфраструктуры, в том числе подводные кабели, принадлежит уже не правительствам, а частным корпорациям.