Протестировали DeepSeek (и не только) на наших серверах с GPU

В первой части статьи мы запускали DeepSeek-R1 на CPU и рассказывали, как он работает без видеокарты, исследовали особенности и подробно разобрали дистилляты.

Во второй части:

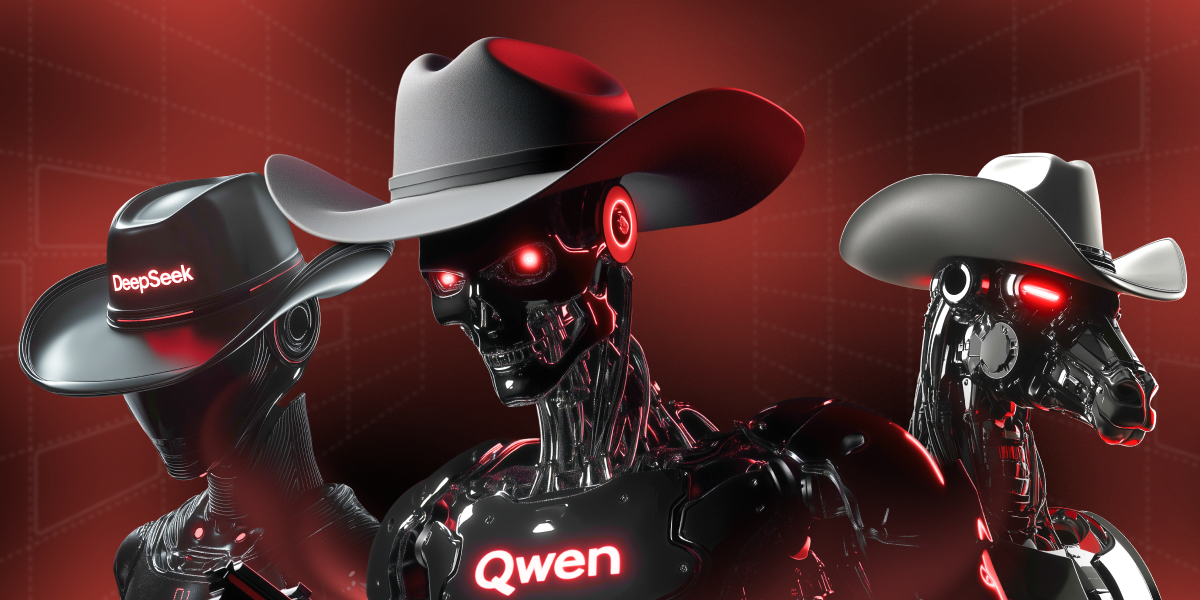

- Тестируем три актуальные языковые модели: DeepSeek-R1, Qwen2.5 и Llama3.3;

- Запускаем их на серверах с GPU:

- GeForce RTX 4090 (AMD Ryzen 9700X, 128 Гб RAM, 2 Тб NVMe);

- NVIDIA L40S (AMD EPYC 9334, 128 Гб RAM, 2 Тб NVMe);

- Анализируем качество ответов, стабильность, скорость генерации и нагрузку на «железо»;

Наша цель — выяснить, какая языковая модель лучше всего подойдёт для локального запуска.

Спойлер:

У одной модели возникали ошибки при генерации токенов и бессмысленные ответы. Другая успешно создала рабочий код на Python.

1dedic.ru/articles/lokalnoe-ispolzovanie-yazykovoy-modeli-na-vydelennom-servere-chast-vtoraya-deepseek-r1

0 комментариев

Вставка изображения

Оставить комментарий