все новости по филиалам

Поиск

Руководство по графическому процессору для вывода LLM

Несколько дней назад мы обсуждали стратегию использования графических процессоров для ИИ в OVHcloud. После нескольких часов звонков я понял, что нашим финансовым коллегам всё ещё сложно разобраться в технических аспектах этой темы, поэтому я решил написать для них руководство. Потом кто-то пошутил, что многие наши клиенты тоже были в замешательстве, поэтому руководство теперь оформлено в виде поста в блоге.

Это руководство посвящено графическому процессору для вывода больших языковых моделей (LLM). Под «производительностью» мы подразумеваем количество токенов в секунду. Это руководство не претендует на техническое погружение, но оно поможет вам выбрать правильную конфигурацию графического процессора для вашего сценария использования. Многие детали были упрощены для удобства и доступности информации.

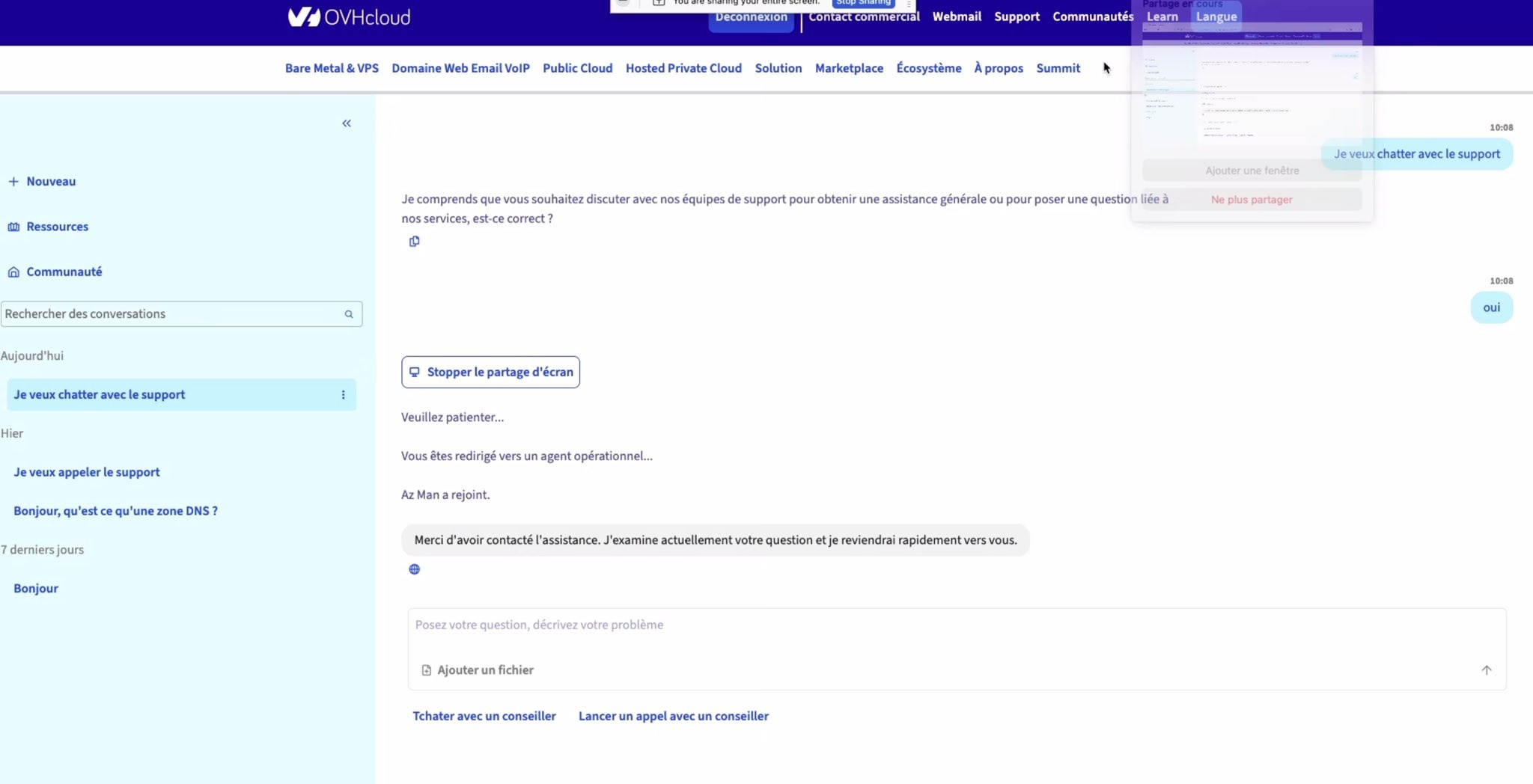

TL:DR – Лучшие варианты вывода LLM в OVHcloud (по состоянию на июль 2025)

Это лучшие варианты развертывания, доступные на данный момент в OVHcloud для LLM-инференса. Предложение будет развиваться по мере выпуска новых графических процессоров.

1 — Определите область своих требований

Прежде чем двигаться дальше, попробуйте определить свои требования (ответы на следующие вопросы помогут вам выбрать наилучшее решение).

- Какую модель вы хотите развернуть? (Например, Llama3 70B)

- Сколько у него параметров? (например, 7B, 70B, 120B)

- Какая длина контекста вам нужна? (например, 32 КБ, 128 КБ)

- Какой уровень точности или квантования? (FP16, FP8 и т. д.)

- Сколько пользователей одновременно? (Один пользователь? 10? 500? 10000 ?)

- Какой сервер вывода? (например, LLM, TensorRT, Ollama…)

- Необходимая пропускная способность? (например, задержка на пользователя, общее количество транзакций в секунду)

- Использование стабильное или нестабильное? Предсказуемое или нет?

2 – Выбор модели графического процессора – Дискриминантный критерий

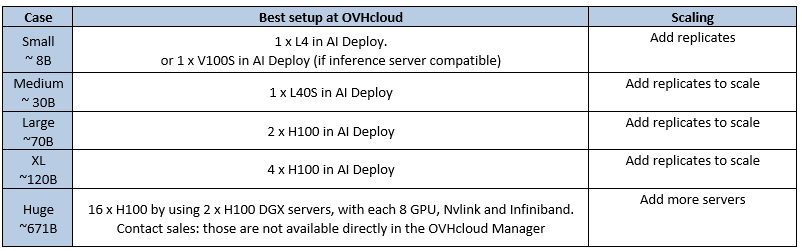

а) Поддержка квантования/точности

Что такое квантование? Идея заключается в снижении точности весовых коэффициентов модели для уменьшения объёма памяти и вычислительных затрат ценой небольшого снижения качества модели. Квантование снижает затраты памяти и вычислительных затрат за счёт снижения точности (например, FP16 → FP8 → FP4), как правило, в ущерб качеству модели. Это компромисс.

В настоящее время модели LLM чаще всего публикуются в FP16, но часто развертываются в FP8, поскольку выигрыш в скорости значительно перевешивает потерю качества.

Поддержка квантования GPU

Большинство графических процессоров поддерживают не все типы точности/квантования, поэтому это дискриминантный критерий. Выберите графический процессор, поддерживающий нужный вам формат квантования.

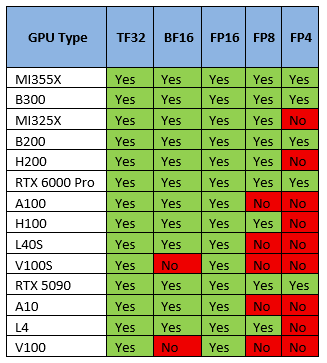

б) Минимальное количество графических процессоров для запуска вашей модели

Для вывода необходимо загрузить все веса модели (**) в память (память видеокарты, а не ОЗУ) и оставить место для контекста/кэша. Либо памяти достаточно, либо это просто не сработает.

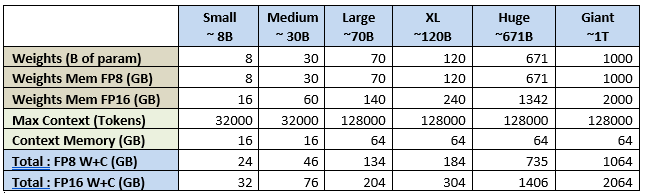

Вот практическое правило расчета необходимого объема памяти GPU для LLM:

Total GPU memory = (Parameters × Precision Factor) + (Context Size × 0.0005)

Пример: Llama 3.3 70B с контекстом 128 КБ в FP8 потребует 70 ГБ для весов модели + 62,5 ГБ для контекста.

Если мы применим эту формулу к нескольким стандартным размерам/контекстам LLM, то получим следующее:

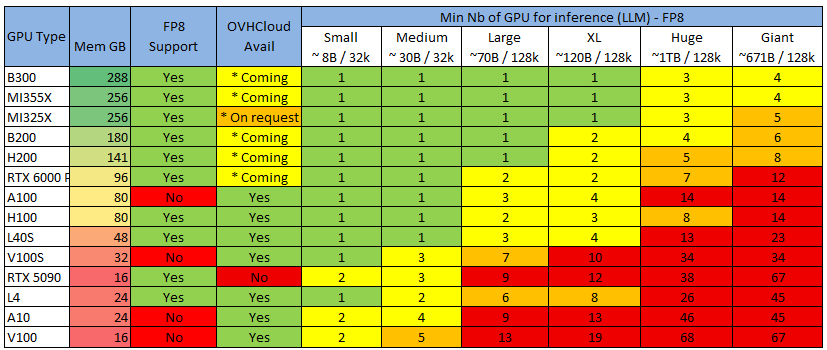

Теперь применим это к самому распространенному графическому процессору, который вы сможете найти, чтобы получить минимально необходимое вам количество графических процессоров:

Color Legend, учитывая, что серверы обычно поставляются с 4 или 8 GPU (скоро 16 GPU)

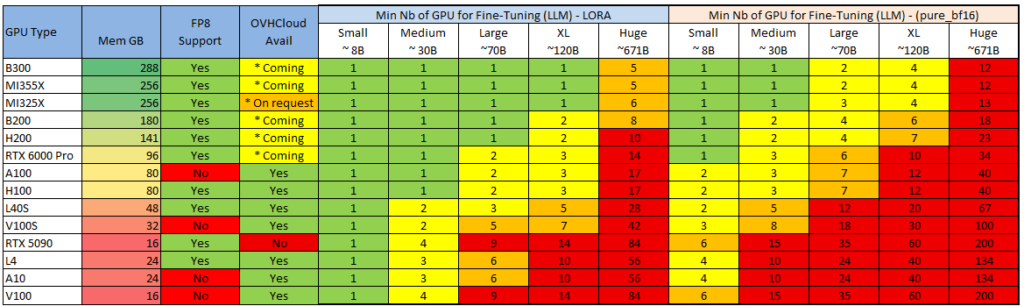

См. также 2 распространенных метода точной настройки:

Примечание: возможно запустить (небольшой) вывод LLM на ЦП (см. Llama.cpp ), но только для небольших моделей (или высоких уровней квантования с более низким качеством).

Примечание: можно сократить потребность в памяти, «выгрузив» часть слоев модели из ОЗУ, но я не буду об этом рассказывать (посмотрите Reddit-подписку LocalLlama — некоторые делают из этого вид спорта), так как производительность низкая, и я думаю, что если вы переходите в облако, то это ради реальных впечатлений

c) Совместимость с оборудованием

Последним критерием выбора графического процессора является аппаратная совместимость с некоторыми функциями серверов вывода.

Серверы вывода (программное обеспечение, на котором работает модель) могут иметь функции, несовместимые с определенными графическими процессорами (марки или поколения).

Они часто меняются, поэтому я не буду их перечислять, но вот пример для VLLM: docs.vllm.ai/en/latest/features/compatibility_matrix.html#feature-x-hardware_1

Самый распространенный пример, который мы видим, — это то, что механизм «Flash Attention» не поддерживается на видеокартах Nvidia поколения Tesla, таких как V100 и V100S

3 – Выбор конфигурации и развертывания графического процессора – Критерий производительности

а) Что влияет на производительность вывода?

Обзор

На общую производительность (т. е. количество токенов в секунду) влияют несколько элементов, приблизительный порядок важности которых следующий:

- 1 – Производительность графического процессора

- 2 – Производительность сети (между графическими процессорами и между серверами)

- 3 – Программное обеспечение (сервер вывода, драйверы, ОС)

Ниже приведено описание каждого из вариантов и варианты, которые можно выбрать.

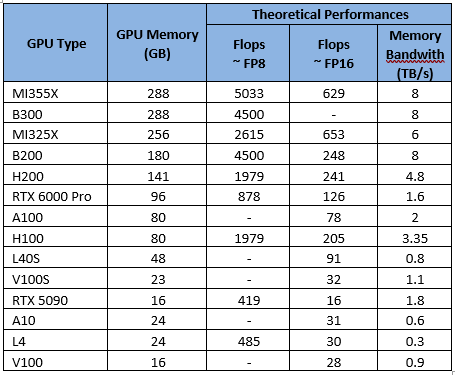

Производительность графического процессора

В основном это связано с вычислительной мощностью («флопсами») графического процессора и пропускной способностью его памяти (в зависимости от поколения).

Ознакомьтесь с теоретическими характеристиками (заявленными Nvidia и AMD), перечисленными ниже:

Производительность сети

При выполнении вывода ваши данные распространяются несколькими способами:

- Видеокарта — материнская плата: скорость зависит от типа и версии подключения. Обычно это PCIE или SXM (фирменное подключение Nvidia).

- Видеокарта-видеокарта: связь осуществляется либо через материнскую плату (PCIE/SXM), либо через прямое соединение с видеокартой. Nvlink — это решение от Nvidia.

- Сеть между серверами (при использовании нескольких серверов): Ethernet, Infiniband

Производительность программного обеспечения (сервер вывода, драйверы)

Производительность будет значительно варьироваться в зависимости от сервера вывода (VLLM, Ollama, TensorRT…), используемых базовых библиотек (Pytorch…) и базовых драйверов (Cuda, RocM).

В двух словах: используйте последние версии!

Не все серверы вывода обеспечивают одинаковую производительность и одинаковый набор функций. Я не буду вдаваться в подробности, но вот несколько советов:

- Ollama: Простота настройки и использования. Лучший вариант для одного пользователя.

- VLLM: Лучше всего подходит для быстрого получения последних моделей и функций, но сложно настроить.

- TensorRT: Лучшая пропускная способность, но есть задержка в поддержке новых моделей/функций и работает только на графических процессорах Nvidia.

а) Различные варианты развертывания

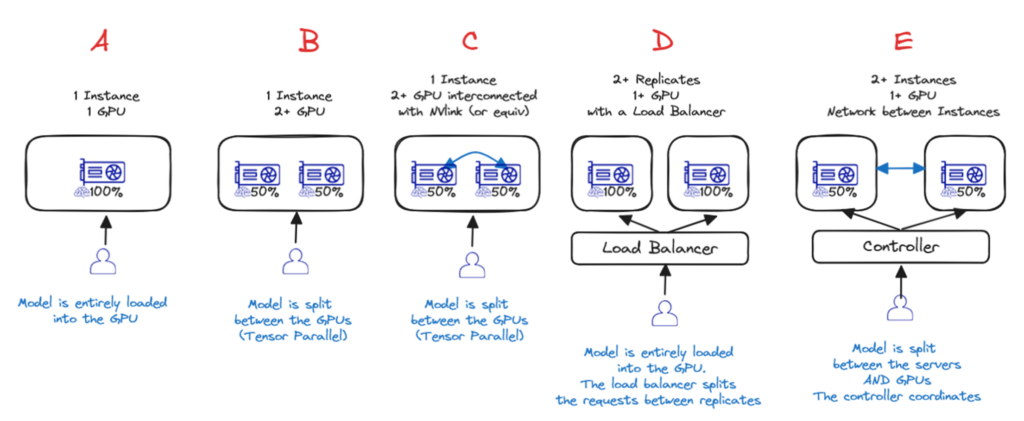

Теперь, когда вы знаете, какой графический процессор и сервер выбрать, у вас также есть несколько вариантов настройки архитектуры.

Вариант A — Один графический процессор

Если модель достаточно мала, чтобы поместиться в один графический процессор, то это лучший вариант!

Вариант B и C — один экземпляр, несколько графических процессоров (с межсоединени ем или без него)

Если для одного GPU это слишком много, то лучшим вариантом будет один сервер с несколькими GPU. Либо с Nvlink ( вариант C ), либо без него ( вариант B ). В этих двух случаях веса моделей распределяются по разным GPU, но за это приходится платить: производительность не будет в два раза выше, чем у одного GPU!

Вариант D — один экземпляр, несколько реплик с балансировкой нагрузки

Если модель помещается на 1 сервере (1+ GPU), но производительности недостаточно или вам необходимо динамическое масштабирование в зависимости от текущих потребностей, то лучшим вариантом будет использование нескольких реплик и добавление балансировщика нагрузки ( вариант D ) — это то, что AI Deploy предоставляет по умолчанию.

Вариант E — Распределенный вывод по нескольким серверам

Если модель слишком велика для размещения на одном сервере, необходимо распределить вывод по нескольким серверам ( вариант E ). Это самый сложный вариант (необходимо настроить сеть и программное обеспечение для кластеризации) и приводит к наибольшей потере производительности (из-за узких мест в межсерверной сети, а также из-за взаимодействия графических процессоров).

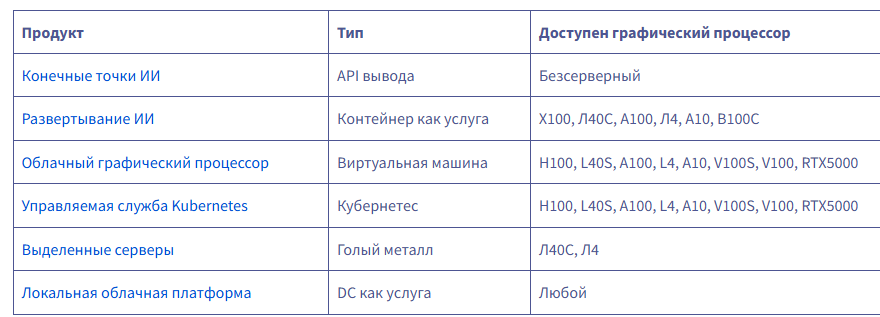

в) Какой продукт OVHcloud использовать?

Для вывода у вас сегодня есть шесть вариантов на выбор:

endpoints.ai.cloud.ovh.net/

www.ovhcloud.com/en/public-cloud/ai-deploy/

www.ovhcloud.com/en-ie/public-cloud/compute/

www.ovhcloud.com/en/public-cloud/kubernetes/

www.ovhcloud.com/en-ie/bare-metal/prices/

www.ovhcloud.com/en/dc-as-a-service/

Если вам нужен полностью управляемый вывод, то AI Endpoints — определённо лучший вариант: это бессерверный сервис, где вы платите за количество использованных токенов. Вам не нужно развертывать модель или управлять ею.

Важно отметить, что вам нужно выбрать одну из предлагаемых нами моделей (вы не можете добавить свою). Тем не менее, мы приглашаем вас запрашивать новые модели на нашем Discord!

discord.com/invite/ovhcloud

AI Deploy — это продукт, специально разработанный для запуска серверов вывода, обладающий несколькими ключевыми функциями:

- Это контейнер как услуга: вы привозите свой собственный контейнер, мы им управляем.

- Простая конфигурация: вы можете запускать контейнер несколько раз с помощью одной командной строки и изменять параметры непосредственно через эту командную строку.

- Масштабируемость заложена в конструкцию: в любой момент вы можете добавить реплики, и мы управимся балансировкой нагрузки.

- Автомасштабирование: вы можете настроить автомасштабирование на основе пороговых значений ЦП/ОЗУ, а вскоре вы также сможете использовать пользовательские метрики (например, задержку вывода).

- Масштабирование до 0: Скоро вы сможете масштабироваться до 0. Если в течение некоторого времени на ваш сервер не отправляется ни одного запроса, мы останавливаем машину.

- Оплата поминутно, без обязательств.

SHAI — ваш помощник по программированию на базе искусственного интеллекта

SHAI — это передовой ИИ-помощник для терминала, призванный упростить ваши повседневные задачи по разработке. Создаёте ли вы веб-сайт, редактируете файлы, запускаете команды оболочки или автоматизируете сложные рабочие процессы, Shai поможет вам — и всё это прямо с вашего терминала.

labs.ovhcloud.com/en/shai/

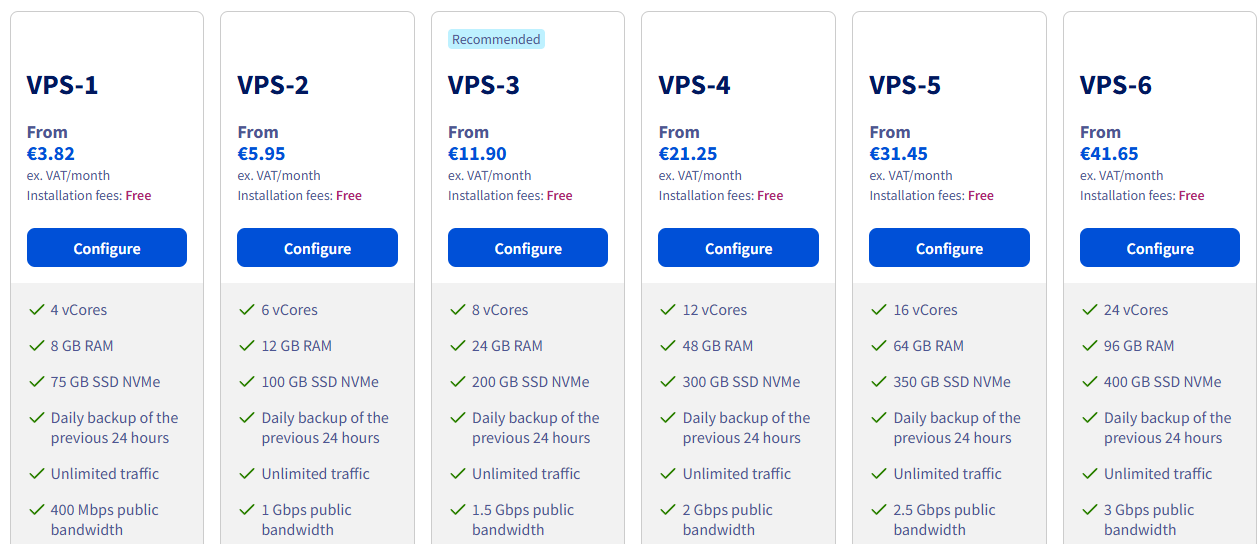

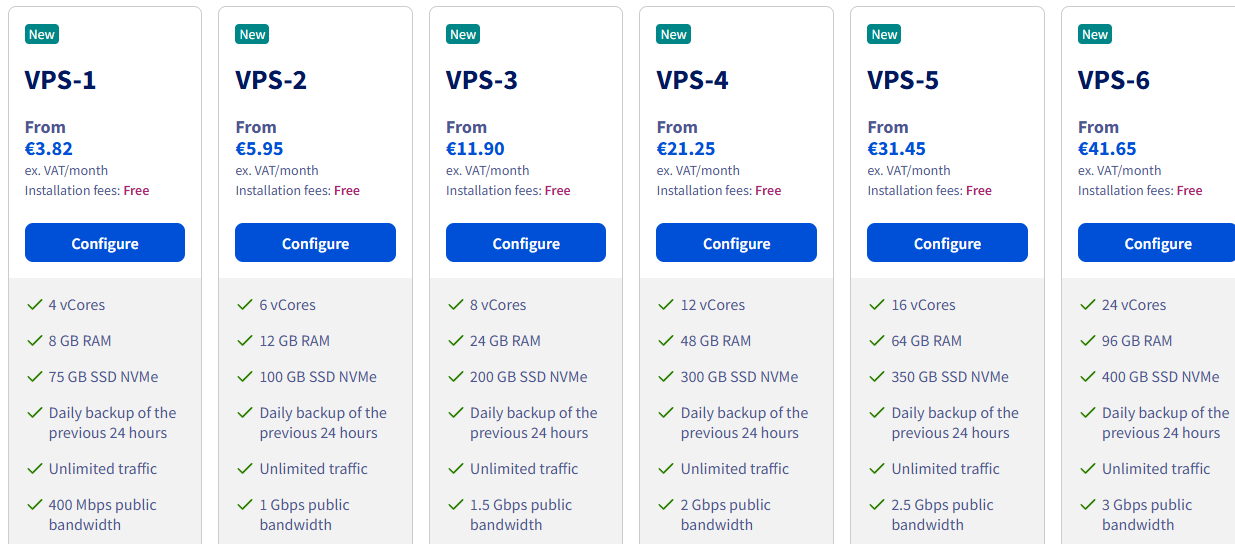

С VPS'26 мы сделали первый шаг к «возвращению к истокам»

С VPS'26 мы сделали первый шаг к «возвращению к истокам». Высокопроизводительные и недорогие предложения доступны по всему миру. Гиковское дело ;) Мы подготовили значительный запас серверов для медленного старта в августе. За 20 дней мы всё продали, а ещё 10 дней налаживали производство! Вот и всё! Производственный процесс только что перезапустился, и в ближайшие месяцы мы произведём несколько десятков тысяч серверов для обеспечения нескольких сотен тысяч VPS'26. Хватит всем! Наша цель — вернуть себе лидерство на «цифровом» рынке и, кстати, познакомить с OVHcloud множество новых клиентов.

Кто говорит о дешёвом VPS, тот говорит о спаме. Поэтому в июле/августе мы проделали большую работу по отчётам о спаме, чтобы предотвратить использование нас для распространения спама и фишинга. Это связано со злоупотреблениями. Это позволит нам создать значительно более эффективную службу обнаружения фишинга и спама и предложить более специализированные услуги электронной почты как нашим клиентам, так и за пределами нашей сети, с помощью новых сервисов «рассылки».

Главным условием создания хорошей базы сигнатур спама и фишинга было ускорение вывода ИИ на поток. Лично я считаю, что ИИ недостаточно дорог и слишком медленен с точки зрения количества токенов в секунду. Очевидно, что существует премиальный рынок для быстрых токенов. Поэтому мы инвестировали в технологии вывода, чтобы достичь скорости x5/x10 токенов в секунду на поток. Скоро мы сможем реализовать эту технологию для всех, а значит, и для нас.

Благодаря этой улучшенной скорости вывода мы наконец-то можем сделать использование ИИ общедоступным для наших внутренних команд. Поддержка чата, диагностики, кодирования вибраций, модульного тестирования, создания документации, PoC, интерфейсов…

VPS, Спам, ИИ

После запуска VPS'26 вчера, который постепенно станет доступен в наших 12 кампусах на четырёх континентах, следующим шагом станет VPS LL (Low Latency), который постепенно станет доступен в округе Колумбия +50. На данный момент только VPS-1 доступен по цене +1e/mo.

Те же предложения будут доступны в Public Cloud / VM / Discovery. Также необходимо вернуться ко всем лицензиям Plesk, CPanel, N8N и Windows.

Внимание:

В настоящее время мы проверяем всю обработку спама в OVHcloud. С поступлением новых стоек ИИ в сентябре мы увеличиваем производительность наших конечных точек ИИ до 10–15 млн TPM (миллионов токенов в минуту) со временем получения первого токена < 0,5 с. Этого достаточно для обработки нескольких тысяч писем в секунду.

Это позволит нам:

На VPS мы рассмотрим, как:

Короче говоря, дешевый VPS — да, спам — нет.

Те же предложения будут доступны в Public Cloud / VM / Discovery. Также необходимо вернуться ко всем лицензиям Plesk, CPanel, N8N и Windows.

Внимание:

В настоящее время мы проверяем всю обработку спама в OVHcloud. С поступлением новых стоек ИИ в сентябре мы увеличиваем производительность наших конечных точек ИИ до 10–15 млн TPM (миллионов токенов в минуту) со временем получения первого токена < 0,5 с. Этого достаточно для обработки нескольких тысяч писем в секунду.

Это позволит нам:

- лучше анализировать сообщения о злоупотреблениях и очень-очень быстро закрывать спамеров (я закончил код, очень весело)

- лучше обнаруживать спам и фишинг на входящих и исходящих SMTP-сообщениях в наших электронных письмах, защищать наших клиентов и предотвращать рассылку спама

- лучше блокировать спам на SMTP OUT виртуального хостинга

- лучше обнаруживать исходящий спам на границе сети

- предлагать SMTP OUT с фильтрацией спама на выходе OVHcloud для клиентов

- предложить партнерство SMTP OUT с почтовыми ящиками (которые находятся в нашей сети), задачей которых является отправка маркетинговых писем

На VPS мы рассмотрим, как:

- разрешить клиентам использовать порт 25 для отправки легитимных писем

- временно заблокировать порт 25 для взломанных клиентов

- быстро заткнуть тех, кто злоупотребляет

- предлагать услуги SMTP OUT для тех, кто хочет спокойствия, в том числе во время праздников

Короче говоря, дешевый VPS — да, спам — нет.

Постоянное снижение риска DDoS-атак — Окончание поддержки (EOL)

Мы хотели бы сообщить вам, что «Центр постоянной очистки от DDoS-атак» (ранее «Постоянное смягчение»), включенный на некоторых ваших публичных IP-адресах, приближается к концу своего срока службы и будет отключен 8 сентября 2025 года.

Все IP-адреса с включенной этой опцией будут автоматически перенесены в течение недели с 15 по 18 сентября (неделя 38).

Благодаря последним обновлениям нашей инфраструктуры защиты от DDoS-атак, предыдущая функция «Постоянное смягчение» теперь интегрирована на границе сети (для пользователей с межсетевыми экранами Edge Network), что делает автономную функцию устаревшей. Этот важный шаг позволит нам предложить вам усиленную защиту в будущем.

Нужно ли мне что-то делать?

Нет, OVHcloud выполнит автоматическую миграцию всех ваших IP-адресов с максимальной осторожностью. Это включает в себя переключение из режима «Постоянный центр очистки» в режим «Центр автоматической очистки» и включение межсетевого экрана Edge Network для затронутых IP-адресов.

Однако, если вы предпочитаете контролируемую миграцию, затрагивающую только определённые IP-адреса во время планового технического обслуживания, мы рекомендуем выполнить миграцию вручную не позднее 8 сентября 2025 года. Любые IP-адреса, переведённые в автоматический режим до этой даты, исключаются из процесса автоматической миграции.

Для ручной миграции:

Откройте Панель управления, Сеть, Публичные IP-адреса.

Выберите IP, перейдите в меню (справа) и:

- Выберите «Центр очистки: автоматически» и подтвердите выбор. Эта опция отключит функцию «Постоянное смягчение».

- Выберите «Создать брандмауэр» и подтвердите (если доступно). Эта опция создаст экземпляр брандмауэра Edge Network (если он ещё не существует).

- Выберите «Включить межсетевой экран Edge Network» и подтвердите выбор. Это включит межсетевой экран Edge Network.

- Необязательно: вы можете перейти в раздел «Конфигурация межсетевого экрана пограничной сети» и просмотреть или добавить правила межсетевого экрана, чтобы разрешить или заблокировать определённый тип сетевого трафика. Подробнее об этом шаге см. в этом руководстве.

Ключевые даты:

- Приостановка обслуживания: 8 сентября 2025 г. (изменения конфигурации заморожены: API и панель управления)

- Автоматическая миграция конфигурации: 15–18 сентября 2025 г. (для всех ваших IP-адресов с опцией «постоянно»)

- Прекращение обслуживания: 22 сентября 2025 г. (API и панель управления больше не доступны)

Спасибо, что выбрали OVHcloud.

Команда OVHcloud

Находятся в разработке и будут запущены в ближайшие месяцы

Дальше больше: вот некоторые из новых проектов STG, которые находятся в разработке и будут запущены в ближайшие месяцы.

И ещё несколько тем, которые я только что осветил:

- Поддержка (следующего поколения: чат-бот, чат, телефон и т. д.)

- Цифровые технологии (забота о наших (небольших) клиентах)

- Веб-облако (множество идей!)

- ИИ (платформа тонкой настройки и набора данных, а также omisimo)

- SNC (публичное облако)

- OPCP (ядро и облачное хранилище)

- Критически важные решения (банковское дело, больницы)

Много интересного в ближайшие 12 месяцев!

-STG.0 — CDN

-STG.0 — Лучшие облачные решения

-STG.0 — Внеполосное подключение

-STG.0 — Предложения доменов

-STG.0 — Веб-хостинг

-STG.1 — VPS ‘26

-STG.1 — ADV ‘26

-STG.1 — HGR ‘26

-STG.1 — HSM

-STG.1 — Управляемый WordPress

-STG.1 — Новая цена DBaaS

-STG.1 — Nutanix NC2

-STG.1 — OCC Edge и OCC Cross Cloud

-STG.1 — Видео о WebCloud

-STG.1 — Видео о публичном облаке

-STG.1 — Публичный пропускной способности

-STG.1 — QRNG

-STG.1 — DbaaS Redis

-STG.1 — Управление секретами

-STG.1 — Телекоммуникации и ИИ

-STG.3 — ADV ‘26

-STG.3 — FRIEND Quantum

-STG.3 — Сервис BGP

-STG.3 — GAME‘26

-STG.3 — Здравоохранение/EDS

-STG.3 — HGR‘26

-STG.3 — MKS Premium

-STG.3 — Новый T2 (Rise) ‘26

-STG.3 — Объектное хранилище 3AZ

-STG.3 — Публичное облако 3AZ

-STG.3 — Публичный VCF aaS — Новые клиенты

-STG.3 — SCALE‘26

-STG.3 — VPS‘26

-STG.3 — Межсетевой экран WAF

-STG.3 — Водопад

-STG.3 — Управляемый WordPress

-STG.3 — Блочное хранилище

Что OVH делает за 12 месяцев ?

Частное облако, Sec Num Cloud, локальная среда

Июнь/Июль/Авг 2024.

-VMware — Торонто — GA

-VEEAM — Veeam 12.1 — GA

-NSX-T — Многопользовательские серверы — Только API

Сентябрь-октябрь-ноябрь 2024

-SNC de Bare Metal POD — RBX SBG GRA — Бета-версия

-Nutanix — Сертификация KMS

-OPCP Core — Альфа-версия

-VEEAM — Veeam Enterprise 12.2 — GA

-VMware — LDP для PCIDSS

-SNC Bare Metal POD — RBX SBG GRA — Аудит

-SNC VMware — RBX SBG GRA — Аудит

-Veeam — Veeam Managed Backup 12.2 — GA

-Zerto — Zerto v10 — GA

-HYCU — GA

-KMS — CMK — GA

-LDP — Журналы сервисов OVH — Webcloud DB

-LDP — Журналы сервисов OVH — VMware PCI DSS

-KMS — CMK — GA

Дек-Янв-Фев 2025

-SNC VMware — RBX SBG GRA — Повторная валидация

-VMware — Миграция публичных VCFaaS GA

-Veeam — VEEAM для публичных VCFaaS

-Veeam — Veeam Enterprise 12.3 — GA

-Veeam — Veeam Managed Backup 12.3 — GA

-Nutanix — Масштабируемая цифровая продажа EMR

-VMware — vSphere 8 — GA

-OPCP Core – БЕТА

Март-Апр-Май 2025

-SNC de Bare Metal POD — RBX SBG GRA — GA

-Windows — Менеджер оптимизации и расширения

-VMware — Многооконные решения с биллингом и менеджером

-Zerto — Готово к SecNumCloud — GA

-Nutanix — Горизонтальное/вертикальное масштабирование — GA

-Nutanix — Масштабируемое оборудование (США) — GA

-uIAM — Интеграция с частным реестром — GA

-uIAM — Интеграция конечных точек ИИ — GA

-LDP — Журналы сервисов OVH — KMS — Бета-версия

-LDP — Журналы сервисов OVH — Развертывание K8S в США

-Публичное облако SNC — RBX SBG GRA — J0

Июнь-июль 2025

-OPCP Core — GA

-OPCP CloudStore — Альфа-версия

-OPCP для CIO — Альфа-версия

-Secret Manager — Альфа-версия

Web Cloud

Июнь/Июль/Авг 2024-Web – Инструмент копирования базы данных – GA

-Web многосайтовая DNS-диагностика – GA

-Domain – Сохранение настроек DashB – GA

-Domain – Улучшение менеджера видимости

-OTB v3 – Новое оборудование

-Web GIT-интеграция – GA

-Web – Новые вычисления для Perf- (Int/deploy)

Сент-Окт-Ноябрь 2024

-ECO – Waterfall Baremetal – GA

-Domain – Автоматическое продление нового сервера – GA

-Domain – DNS mngt CX – GA

-Domain – Многолетний #1 – GA

-Softcall – Полная бета-версия

-Zimbra – Бета-версия

-Web – Окончание поддержки WebPaaS – Запуск

-Domain – Автоматическое продление текущего сервера – GA

-Web – Миграция базы данных на MySQL8.0 – GA

-Softcall — Полная бета-версия

Дек-Янв-Фев 2025

-Домен — Многолетний #2 — GA

-ECO — Новый реферальный T2 — GA

-Zimbra — Автономный стартовый — GA

-Zimbra — Zimbra Starter + DN — GA

-VPS — Выбор всех вариантов — GA

-Веб — Веб-сервис PaaS — EOL

-Веб — Инструмент копирования базы данных — GA

Март-Апр-Май 2025

-Телефония — Софтфон — GA

-Веб — Обновление карточек продуктов — GA

-Веб — Менеджер просмотра веб-сайта — GA

Июнь-Июль 2025

-Диагностика DNS для веб-сайта — GA

-Электронная почта — Zimbra Pro — Бета

-Связь — FTTO-ISP (Bytel) — Бета

-Телефония — Расшифровка голосовой почты — Бета

Что OVH делает за 12 месяцев ?

Публичное облако:

Июнь/июль/август 2024-Шлюз XL/2XL – GA

-LB log2cust – GA

-Объектное хранилище — асинхронная реплика

-Объектное хранилище в Торонто – GA

-LocalZone – Нью-Йорк/Чикаго

-LocalZone – МВД/ПАО/ЛА

Сентябрь-октябрь-ноябрь 2024

-LocalZone – DEN/ATL

-Ранчер – GA

-Шлюз 2XL – GA

-Объектное хранилище SYD – GA

-МКС ЛБ Октавия – ГА

-Базы данных — Переработанный пользовательский интерфейс (React)

-LocalZone – Рабат

-CDA Обновление 3 ТБ – GA

-PCI Gen3 в MUM/SYD – GA

-Сберегательный план – GA

-LocalZone — резервное копирование экземпляра

-PCI/AI — графические процессоры (A10)

-Базы данных — MongoDB в США

-ИИ — Конечные точки ИИ – Бета

-Локальная зона — Объектное хранилище

-Новое блочное хранилище – Бета

-Объектное хранилище, Париж, 3 AZ – GA

Дек-Янв-Фев 2025

-LB XL – GA

-PCI — Windows 3-го поколения – GA

-PCI — Разновидности XL/XXL 3-го поколения – GA

-Справедливая почасовая оплата – GA

-Города LZ – Вена – GA

-Города LZ – Sto/Dub/Lux/Sea – GA

-Объектное хранилище – Внешняя служба – GA

-PCI, Париж, 3 AZ (VM/Block/Net) – Бета

-Локальная зона — Снимок тома – GA

-Базы данных / Аналитика — Переименование – GA

-Quantum — Notebook Quobly – GA

-Блочное хранилище – GA

Март-Апр-Май 2025

-Платформа данных — GA

— Резервное копирование томов LZ — GA

— PCI — 3AZ IaaS — GA

— Хранилище объектов — Управление жизненным циклом — GA

— Локальная зона — Города (Bos/Osl/Hel/Cop)

— Графические процессоры PCI — RTX5000 — GA

— Премиум MKS — 3AZ — Бета

— Конечные точки ИИ — GA

— Базы данных и аналитика — 3AZ DBaaS в Париже — Бета

— Базы данных — M3DB и Агрегатор — EoL

— MKS — Список пулов узлов/Навигация improv — GA

— Локальная зона — Города (Man/Lis/SLC) — GA

— Quantum — Notebook Qperfect — GA

— Планы сохранения — Панель управления — GA

— Базы данных — Valkey — GA

— Локальная зона — Города (SL/Sofia/Buc) — GA

— Объектное хранилище — Нечастый доступ — GA

Июнь-июль 2025

— Gateway XL/2XL — GA

— Блочное хранилище OMK Encryption — GA

— Решения ИИ в США — GA

— Базы данных — Аналитика — Redis — EoL

— Базы данных — Аналитика — Обработка данных — EoL

— Города LZ — Phoenix — GA

Облако и сеть «голого металла»:

Июнь/Июль/Авг 2024-IPLB в Торонто — Внутренний

-HGR/SCALE gen2 — MUM

-HGR Intel gen2 — SGP

-Поставщик OCC — Colt — GA

-IPv6 в vRack — Бета

-ADV gen3 — GA

Сентябрь-октябрь-ноябрь 2024

-ADV gen3 — SGP

-RTvRack Торонто — GA

-ADV3/HGR2/SCALE2 — SYD

-BYOIP TOR — GA

-BYOIP SYD — GA

-IPLB TOR, MUM, SYD — GA

-IPLB US VH/HB — GA

-Scale gen2 Intel EMR — GA

-Поставщик OCC — Digital Realty — GA

-GAME gen3 (Patty) — GA

-OCC PoP Лилль — GA

-Поставщик OCC — Цифровая недвижимость — GA

Дек—Янв—Фев 2025

— OCC Console Connect SEA/TOR — GA

— RISE-S (T2) — GA

— vMAC (ADV Gen3) — GA

— ADV-5 SGP2/SYD — GA

— ADV-1/2/3/4 MUM — GA

— ADV Gen 3 SBG — GA

— vRack services with EFS — GA

— OCC Console Connect SEA/TOR — GA

— OCC Reseller US — GA

— BYOIP PAR + APNIC — GA

— IPv4+RTvRack PAR (1-AZ) — GA

— BGP Service — Альфа

— OCC Diagnostics — GA

— OCC Notifications — GA

Март-Апр— Май 2025

— ADVANCE-5 — MUM

— ECO repricing — GA

— IPv6 в vRack — GA

-NAS-HA — Шаблон использования — GA

-Дополнительные варианты KS — GA

-IPLB HTTP2 (фронтенд) — GA

-Панель безопасности IAM — GA

-Обновление UX BM Listing Manager — GA

-vMAC (SCALE/HGR) — GA

-RISE-7/8/9 — GA

-Мониторинг поставщика OCC — GA

Июнь-июль 2025

-Тегирование ресурсов BM IAM Milest.1 — GA

-Листинг BM Manager Milest.1 — GA

-EFS — Trident CS — Альфа

-Предложение Discovery BM 3AZ — GA

-ECO KS-6B и SYS-6 — GA

-Общее обновление пропускной способности — GA

-Переоценка SCALE gen 2 — GA

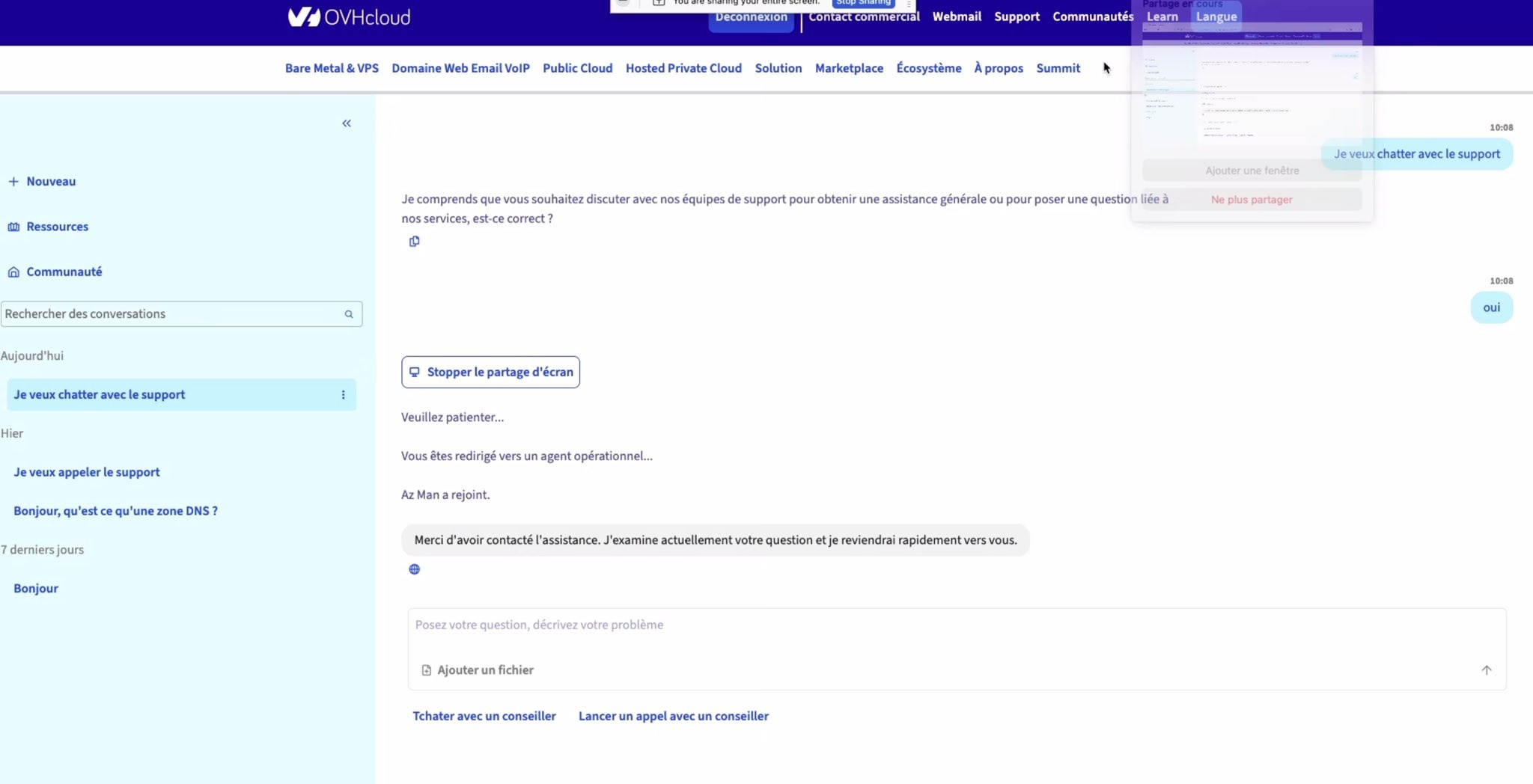

Мы продолжаем работу по улучшению поддержки в OVHcloud

Мы продолжаем работу по улучшению поддержки в OVHcloud, начатую в этом году. Цель — повысить релевантность ответов службы поддержки и сократить время ответа.

Это подразумевает изменение опыта и обобщение обмена информацией с нашими агентами посредством чата.

Таким образом, наши клиенты смогут:

Мы планируем перейти на ALPHA где-то в октябре.

Это подразумевает изменение опыта и обобщение обмена информацией с нашими агентами посредством чата.

Таким образом, наши клиенты смогут:

- пройти аутентификацию и, следовательно, получить расширенную помощь с меньшим количеством формальностей

- получить помощь через чат-бота на базе искусственного интеллекта и попросить его выполнить определенные действия (без участия менеджера)

- общайтесь с нашими агентами в режиме реального времени 24/7 через чат и получайте быстрые ответы

- создать тикет и отслеживать сложные проблемы

- позвоните нам через webrtc (или позвоните по номеру телефона)

- предоставьте общий доступ к своему экрану, терминалу SSH и браузеру (только для чтения), чтобы мы могли вам лучше помочь.

Мы планируем перейти на ALPHA где-то в октябре.