Отчеты показывают, что количество DDoS-атак растет. Каковы ваши варианты?

В прошлом году фонд NBIP поделился своим отчетом о DDoS-атаках в 2019 году. Их служба защиты от DDoS-атак (NaWas) защищает 43% всех голландских доменов. Если мы посмотрим на их выводы из отчета, мы увидим тенденцию к более крупным атакам и увеличению их сложности. Но не в цифрах. Фонд обнаружил небольшое снижение по сравнению с прошлым годом. Если мы посмотрим на отчет компании Neustar, базирующейся в Соединенных Штатах, за тот же год, они в целом пришли к такому же выводу. Единственная разница в их статистике заключалась в том, что во всем мире количество DDoS-атак в целом увеличилось на 180% по сравнению с 2018 годом.

В 2020 году мы оказались ограничены своими домами из-за глобальной пандемии. Неудивительно, что в этот период интернет-трафик растет. Следуя статистике прошлого года, мы видим, что пандемия оказала эффект снежного кома на распространение DDoS-атак. Хотя статистика за 2019 год уже показала тенденцию к увеличению количества DDoS-атак, первая половина 2020 года выглядела не лучше. Neustar сравнил цифры с аналогичным периодом прошлого года и пришел к выводу, что количество DDoS-атак увеличилось более чем в два с половиной раза. Сообщения из других источников, таких как Nexusguard и Netscout, подчеркивают эти цифры.

Но это еще не все, атаки тоже увеличились. В то время как нейтрализация в 587 Гбит / с была рекордной в 2019 году для Neustar, самая большая атака в 2020 году была уменьшена на 1,17 Тбит / с. Так совпало, что в июне 2020 года Amazon смягчил еще более масштабную атаку (2,3 Тбит / с). Первые шесть месяцев 2020 года принесли нам более масштабные, продолжительные и сложные атаки. Если принять цифры за чистую монету, возникает вопрос: как мы сможем защитить себя от растущих DDoS-атак?

От сложной кибератаки до простой передачи, которую может запустить любой

Согласно отчету NBIP, меньшие атаки (менее 1 Гбит / с) снижаются, что основано на общепринятом понятии DDoS-атаки; сеть компьютеров, связанных вместе (ботнет), чтобы нарушить работу службы. Это подводит нас к множеству способов отказа в обслуживании. Больше всего беспокоит то, что в большинстве недавних атак удалось обойти брандмауэры прикладного уровня. Меньшие атаки обычно предназначены для нацеливания на конкретное приложение или сайт. Как только меньшая атака будет успешной, она позволяет использовать другой тип атаки. Комбинированные DDoS-атаки считаются многовекторными. Они могут показаться сложными, но обычно представляют собой смесь общих атак.

Согласно исследованию, проведенному в 2010 году, можно сразу купить DDoS-атаку. В исследовании говорится, что это стоит около 67 долларов в день. Более недавнее исследование Каперски подчеркнуло, что 25 долларов дают атаку продолжительностью один час. Это быстрое и относительно дешевое решение для перевода службы в автономный режим. Но даже без третьей стороны есть несколько простых вариантов. Отправка ping-потока на чей-то IP-адрес или установка такого инструмента, как Low Orbit Ion Cannon. Что может сделать кто угодно. Но, честно говоря, однозначно это не назовешь. Если у вас есть какая-либо защита, такая атака практически не даст никакого эффекта.

Если у вас есть служба, которая должна быть в сети 24/7, подумайте о защите

Ни одно организационное подразделение не может обозначить себя полностью защищенным от DDoS-атак, так как мы можем сделать вывод, что рост наблюдается повсюду. По размеру, объему и сложности. Но это не значит, что мы не можем смягчить и, таким образом, полностью предотвратить DDoS-атаки. Он начинается с определения потребности в защите, которая является обязательной, если у вас есть какие-либо услуги, которые должны быть в сети круглый год. Чтобы обеспечить защиту ваших сервисов без использования дорогостоящего оборудования, сначала задайте себе вопрос, способна ли ваша ИТ-инфраструктура противодействовать DDoS-атакам. Решением может стать привлечение внешней стороны.

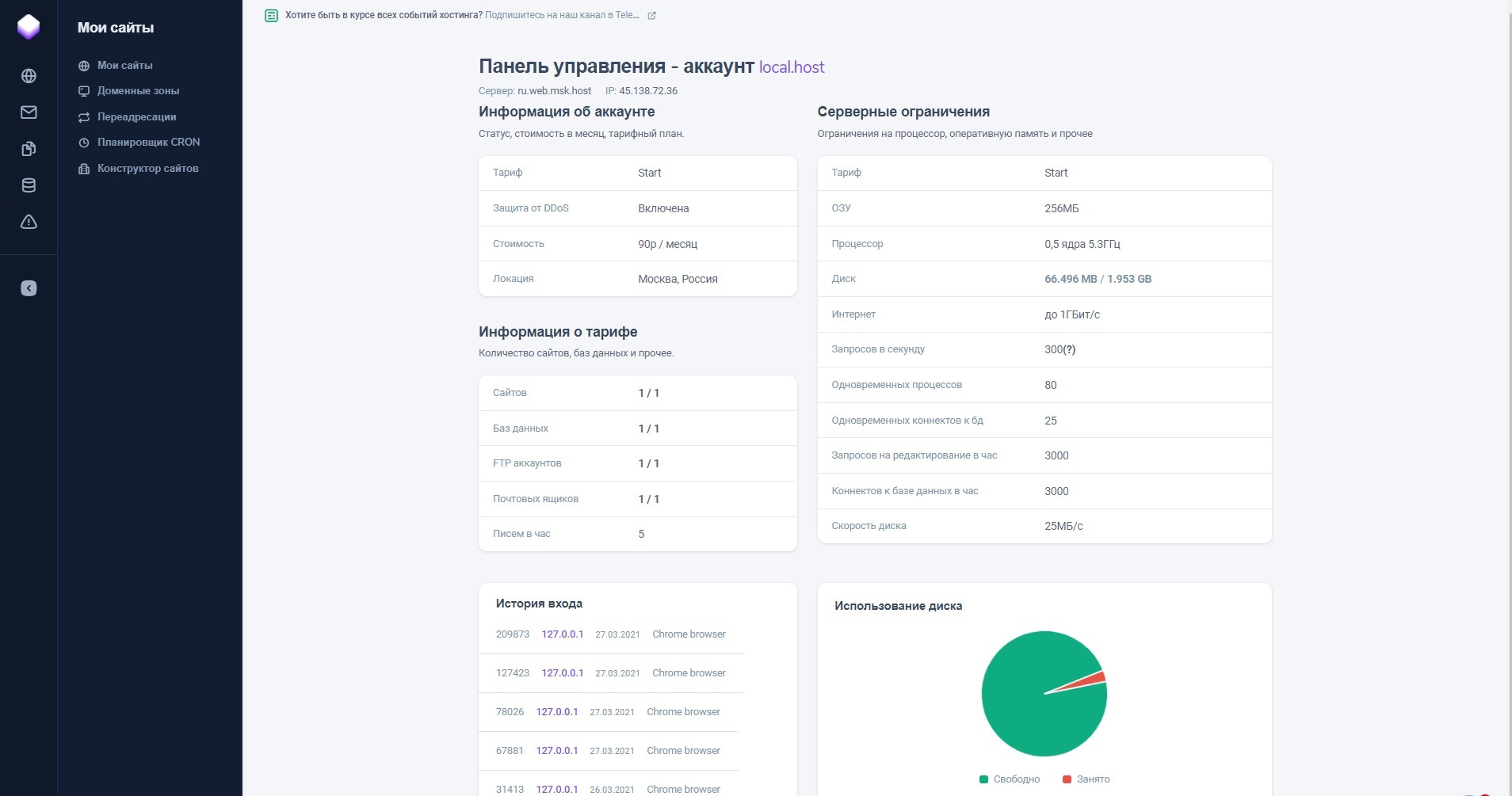

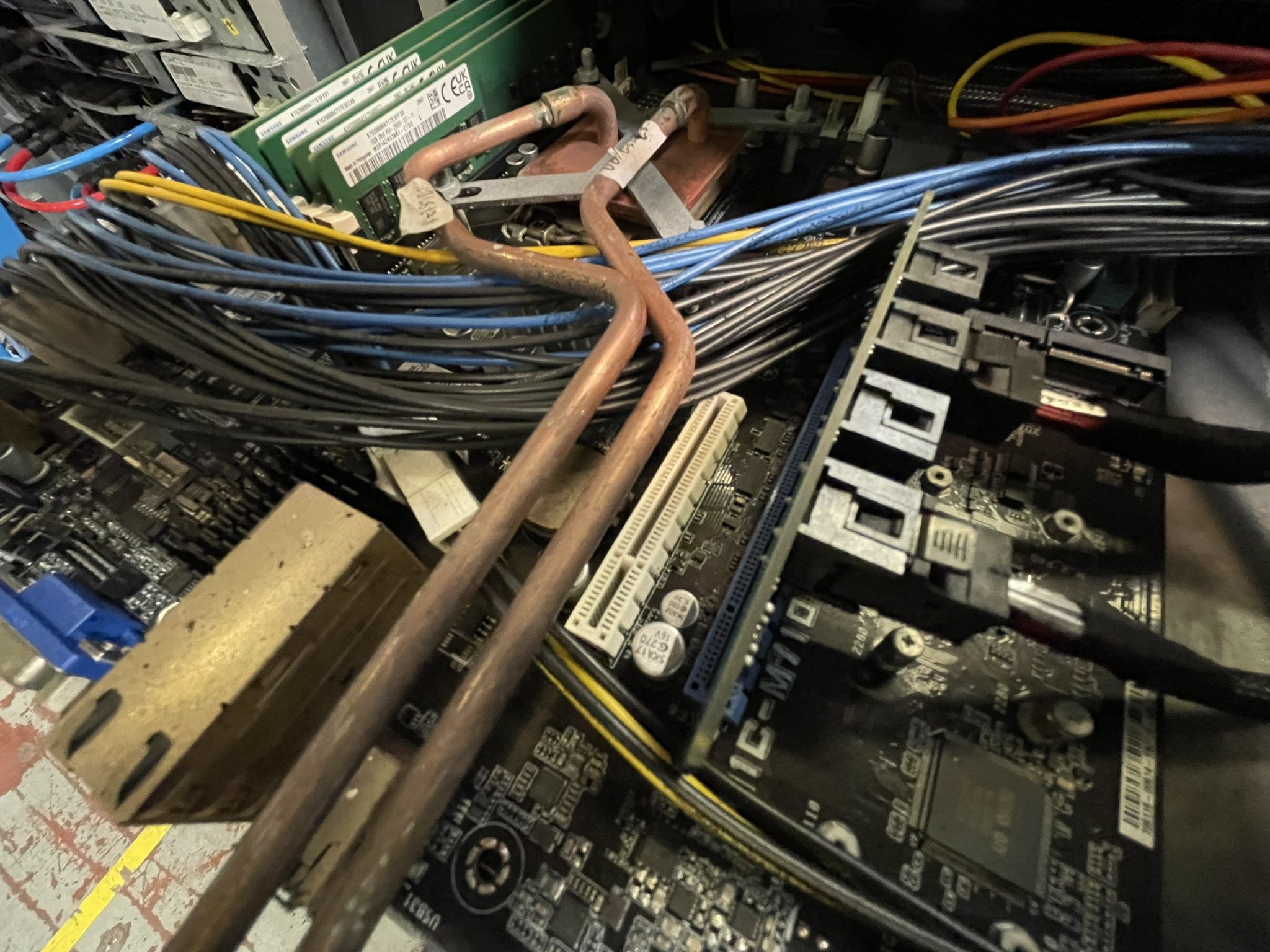

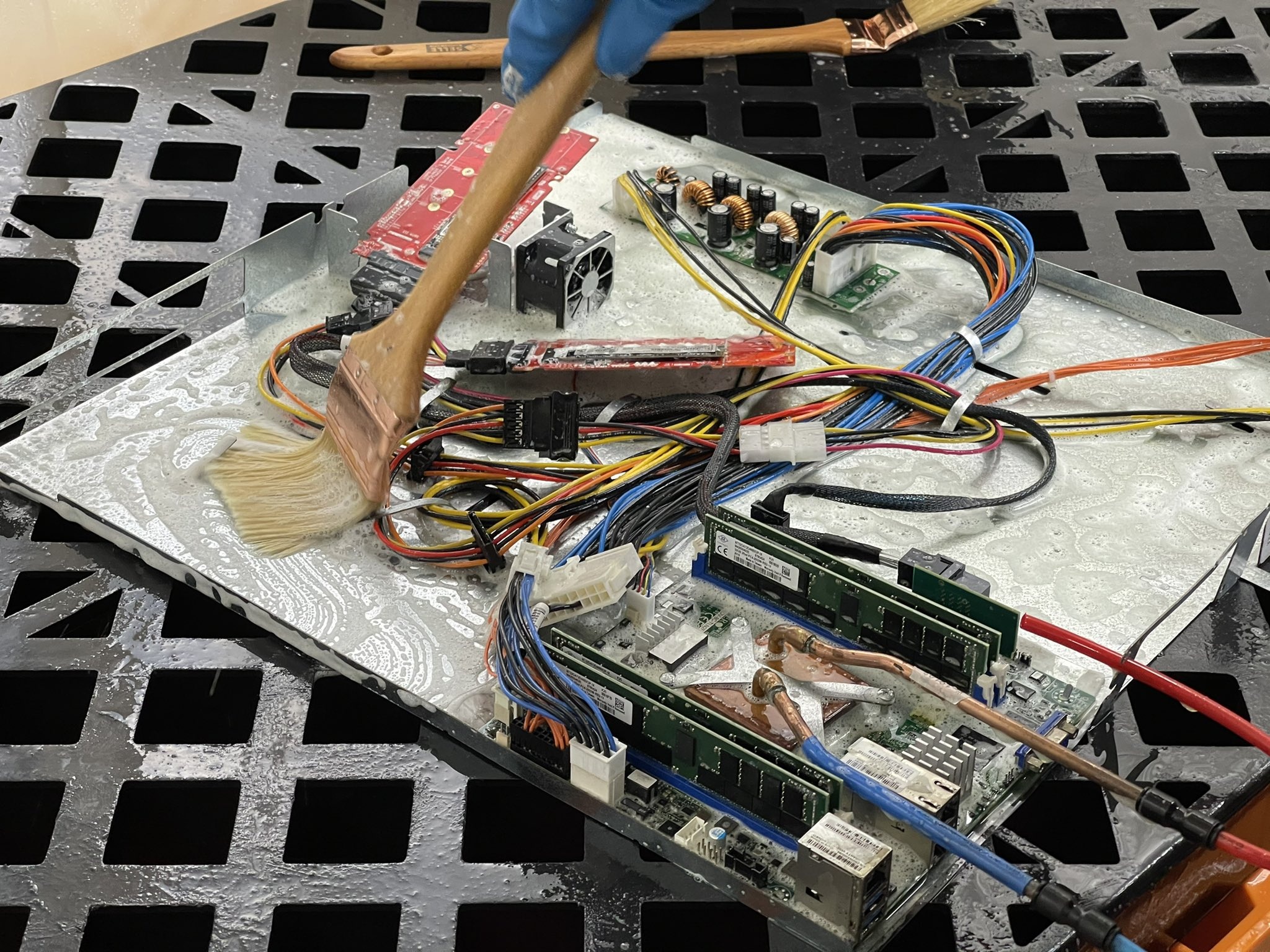

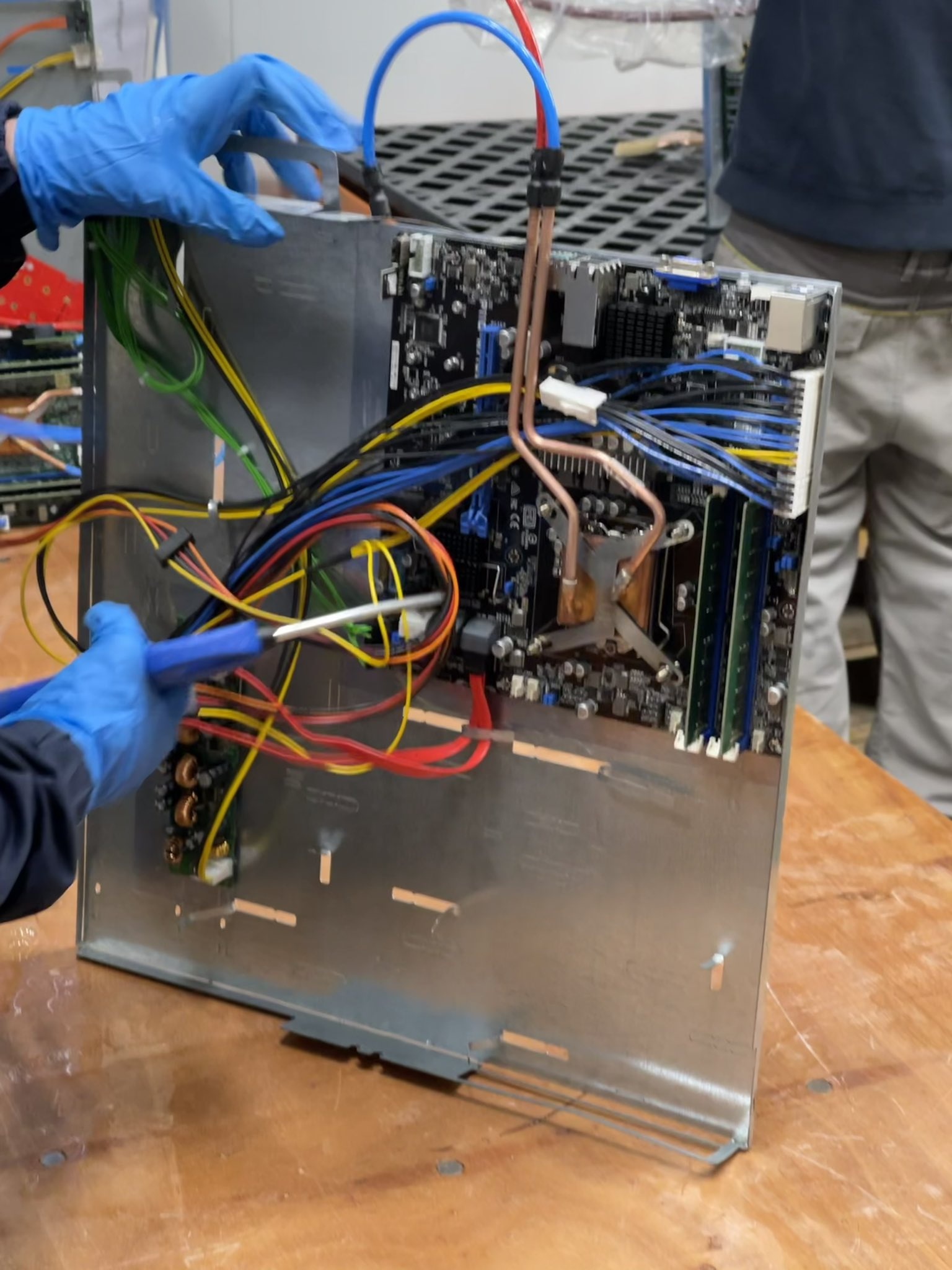

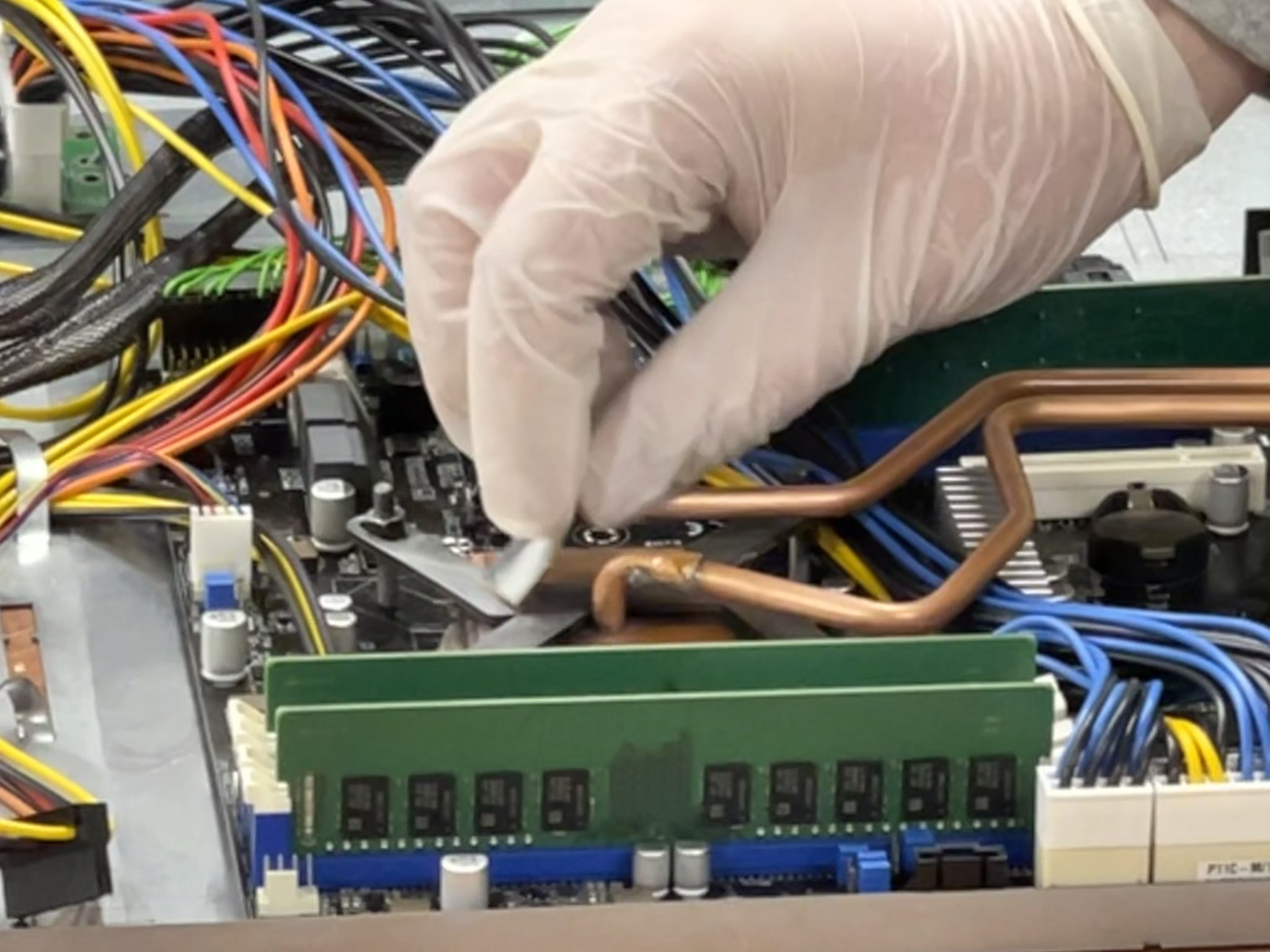

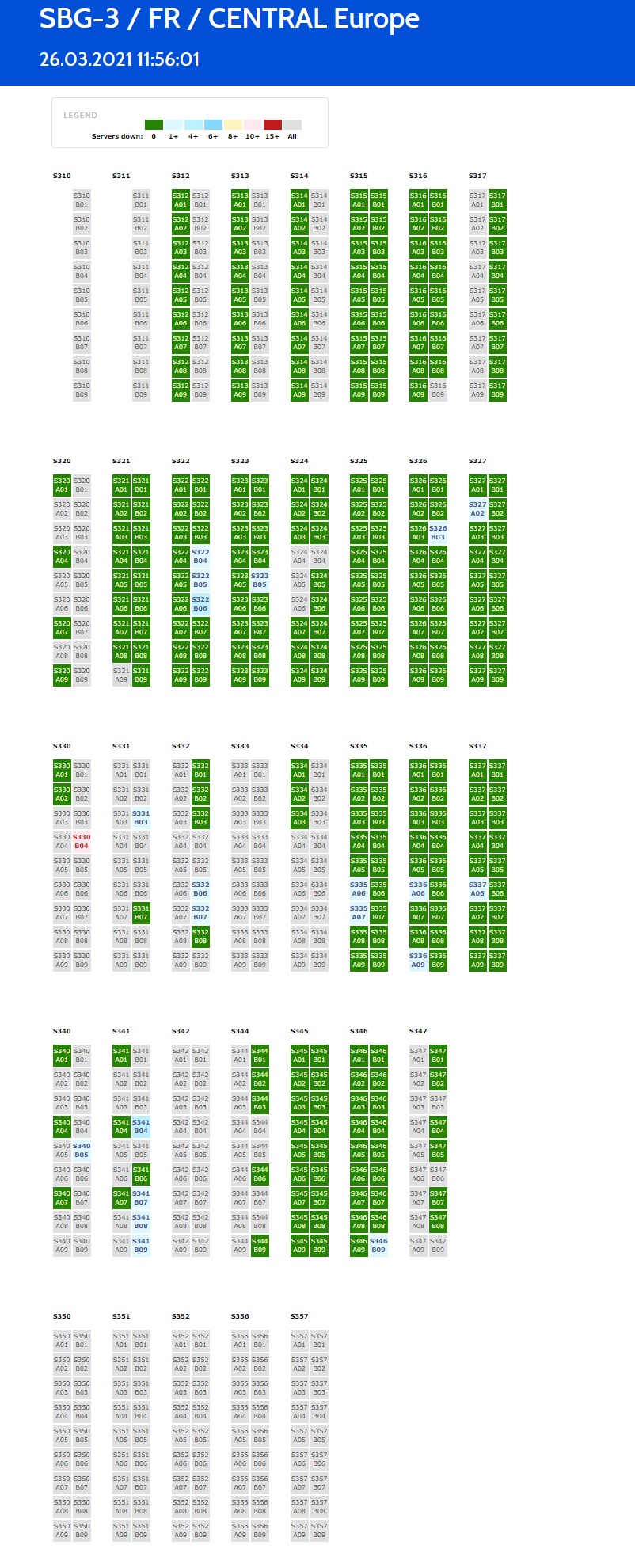

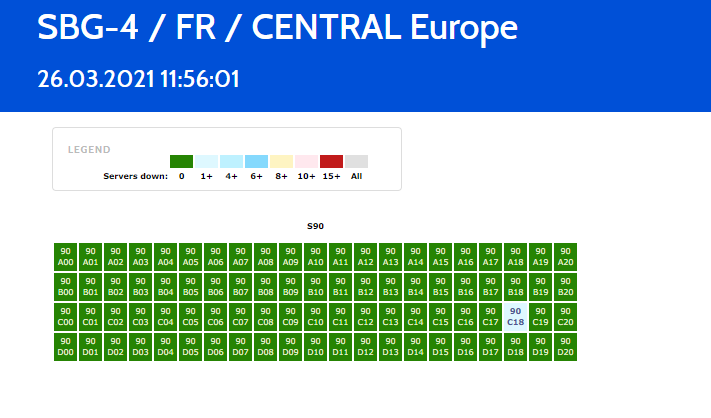

Большинство голландских интернет-провайдеров используют DDoS-сервис NaWas фонда NBIP. Приобрести, разработать и настроить устройство защиты от DDoS-атак относительно дорого. Это основная причина того, что защита с помощью третьей стороны более распространена, чем собственная. В то время как дорогие устройства обычно привязаны только к одному узлу, Worldstream предлагает более горизонтальный подход и, следовательно, несколько узлов. За последние несколько лет Worldstream разработала собственную платформу DDoS, Worldshield, которая представляет собой уникальную систему защиты от DDoS, привязанную к нашей ИТ-инфраструктуре. Это означает, что он может быть применен только к нашей собственной сети и является эксклюзивным для наших клиентов. Это часть решения, включающего инфраструктуру как услугу. Worldshield специально предназначен для ИТ-специалистов, которые хотят иметь всю свою инфраструктуру в одном месте.

Но как Worldshield снова защитит от DDoS-атак? Для отражения DDoS-атак мы отслеживаем весь входящий трафик на основных маршрутизаторах. Эти маршрутизаторы отправляют данные sFlow, которые анализируются в режиме реального времени для распознавания шаблонов. Если обнаружена аномалия, она перенаправляется в кластер Worldshield.

www.worldstream.com/en/solutions/ddos-protection