Новый розыгрыш — 2 комплекта Xbox One X

Первый поощрительный розыгрыш в поддержку Cloud2 успешно завершился и приз нашел своего владельца. Мы решили, что это не предел и запланировали еще один розыгрыш еще большего масштаба. В рамках этой акции мы планируем подарить 2 комплекта Xbox One X — самой прогрессивной консоли для игр и медиаконтента.

Стать участником нового розыгрыша очень просто:

Свяжитесь с нашим специалистом по работе с клиентами Натальей:

Определение победителей

Розыгрыш состоится 10 февраля 2019 года. Розыгрыш будет осуществляться случайным выбором из всех счетов в биллинге, которые удовлетворяют указанным выше критериям. Номера всех счетов, участвующих в розыгрыше, будут опубликованы на сайте НетПоинт.

Мы напоминаем, что Вы можете заказать бесплатный перенос вашего ресурса как с услуги CS1 так и с других услуг НетПоинт в Cloud2, а так же со сторонних площадок.

Все аккаунты, которые уже используют Cloud2 и соответствуют критериям, описанным выше участвуют в розыгрыше.

Стать участником нового розыгрыша очень просто:

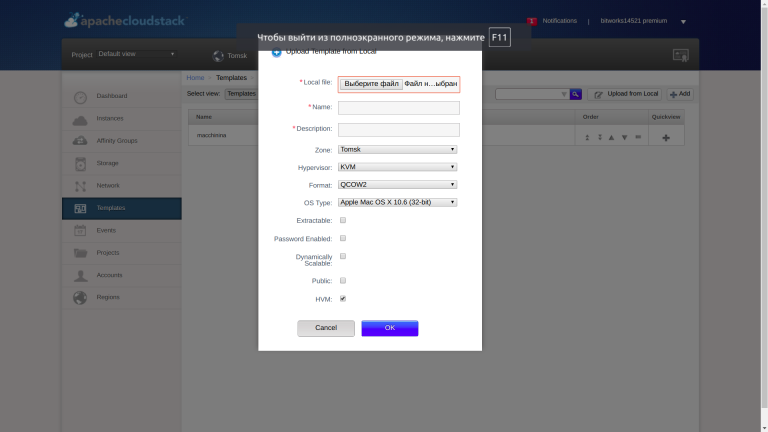

- закажите аккаунт в Cloud2 с объемом заказанных ресурсов не менее 4 GB RAM, 60 GB дискового пространства (1100 рублей в месяц);

- перенесите в аккаунт ваш сайт или информационную систему самостоятельно или закажите бесплатный перенос силами наших специалистов. Мы выполняем перенос с хостинга, виртуальных серверов, аппаратных серверов.

- своевременно пополняйте и оплачивайте услуги.

Свяжитесь с нашим специалистом по работе с клиентами Натальей:

- С понедельника по пятницу c 9:00 до 17:00 (Москва +4 часа): +7 (3822) 705-476

- В любое время по e-mail: nov@netpoint-dc.com

- В розыгрыше участвуют счета, по которым расходы на услугу Cloud2 с 1 по 31 января 2019 года превысили 1100 рублей.

Определение победителей

Розыгрыш состоится 10 февраля 2019 года. Розыгрыш будет осуществляться случайным выбором из всех счетов в биллинге, которые удовлетворяют указанным выше критериям. Номера всех счетов, участвующих в розыгрыше, будут опубликованы на сайте НетПоинт.

Мы напоминаем, что Вы можете заказать бесплатный перенос вашего ресурса как с услуги CS1 так и с других услуг НетПоинт в Cloud2, а так же со сторонних площадок.

Все аккаунты, которые уже используют Cloud2 и соответствуют критериям, описанным выше участвуют в розыгрыше.