Туристический сезон стартовал и на PQ!

Объявляем горячие летние скидки 15% на серверы PQ.Hosting в разных странах мира.

А именно:

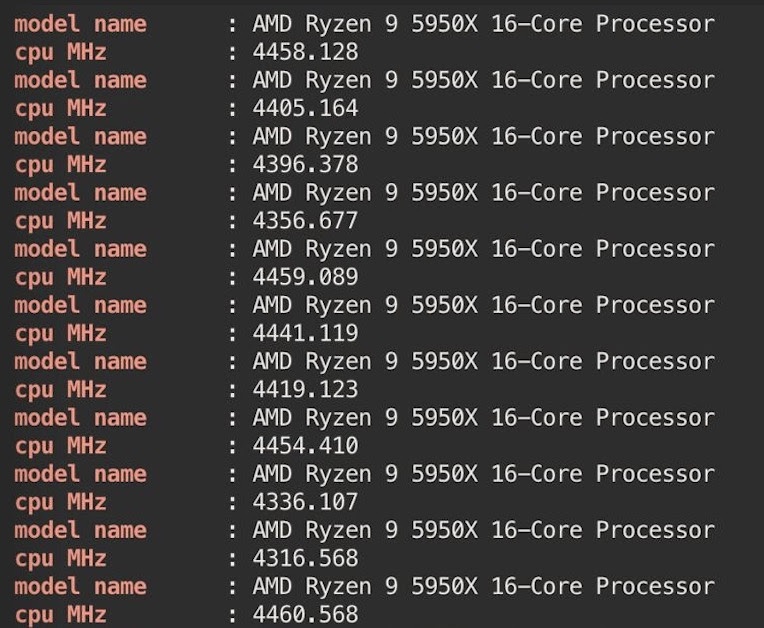

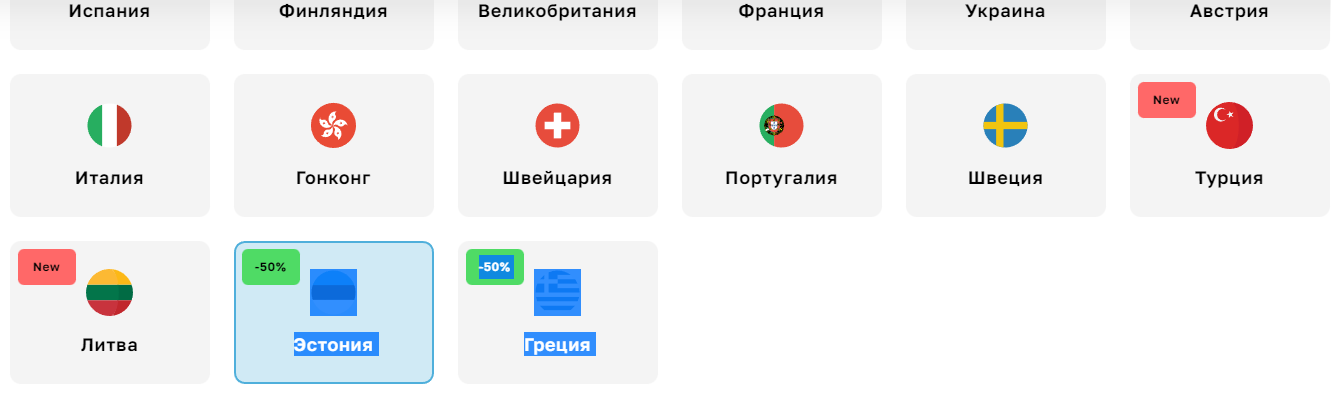

Нидерланды, США, Великобритания, Украина, Швейцария, Сербия, Испания, Россия, Молдова, Болгария.

Кроме того, акция действует и на выделенные серверы!

Выделенный сервер в Нидерландах -15% на заказ.

Заказывая новые серверы в этих странах, вы получите 15% скидки

Пожалуйста, обратите внимание, что скидка действует только при покупке нового тарифа: на продление действующих услуг она не распространяется.

Чтобы воспользоваться скидкой – используйте промокод Summer15.

Акция действует до 30 июня, успейте купить для себя свой лучший сервер!

Желаем вам спокойного и яркого лета с идеальным хостингом!

https://pq.hosting

The tourist season has started on PQ!

We are announcing hot summer 15% discounts on PQ.Hosting servers in different countries of the world.

Namely:

Netherlands, USA, UK, Ukraine, Switzerland, Serbia, Spain, Russia, Moldova, Bulgaria.

In addition, the promotion is valid for dedicated servers!

Dedicated server in the Netherlands -15% per order.

When ordering new servers in these countries, you will receive a 15% discount

Please note that the discount is valid only when purchasing a new tariff: it does not apply to the renewal of existing services.

Use promo code Summer15 to take advantage of the discount.

The promotion is valid until June 30, have time to buy your best server for yourself!

We wish you a calm and bright summer with perfect hosting!

https://pq.hosting