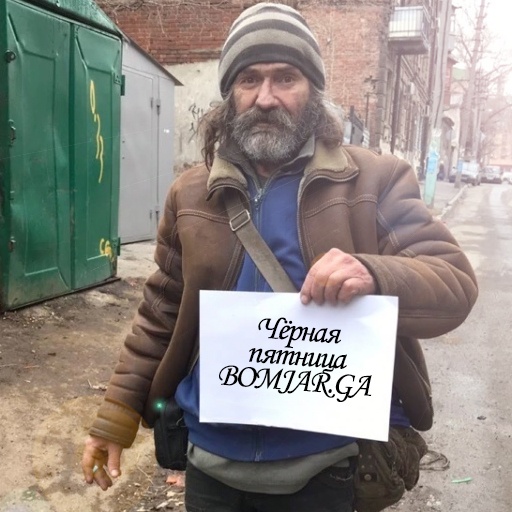

BLACK FRIDAY 2019: СКИДКА 55% НА ВСЕ SSD VDS!

BLACK FRIDAY 2019: СКИДКА 55% НА ВСЕ SSD VDS!

Мы начинаем ежегодную распродажу «Чёрная пятница», которая начинается с 24 ноября и продлится до 3-го декабря 2019 года. В рамках данной распродажи мы подготовили гигантскую скидку для новых заказов и приятные бонусы для продления уже заказанных vds.

friendhosting.net/promo/blackfriday2019.php

1. Для новых заказов. Не упустите свой шанс заказать vds со скидкой 55%. Для получения скидки во время заказа используйте промо-код

BF2019

Обратите внимание, что скидка активируется исключительно для первого периода оплаты, поэтому для получения максимальной выгоды рекомендуем заказывать vds на максимальный период действия промо-кода, который составляет 6 месяцев.

2. Для существующих заказов. Если у Вас уже есть vds, то Вы также можете получить бонус: продлите заказ на год (при продлении на 12 месяцев будет учитываться скидка 10% + скидка по программе лояльности автоматически) и получите в подарок 1 месяц бесплатно. Для получения бонуса необходимо создать запрос в финансовый отдел.

Акция действует с 24.11.2019 по 03.12.2019.