SpaceWeb расширил DDoS-защиту на виртуальные серверы

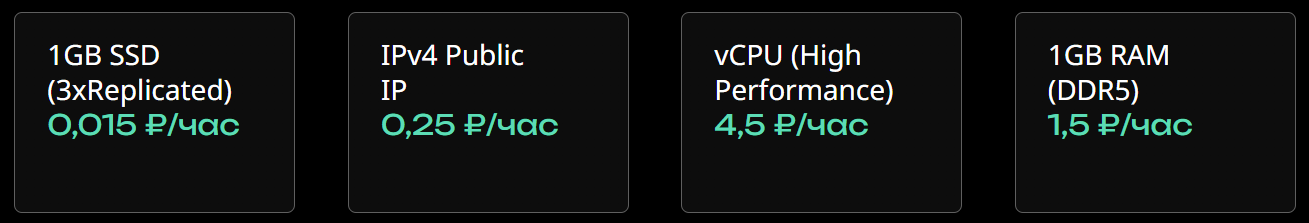

Теперь пользователям SpaceWeb доступен защищённый IP-адрес с фильтрацией трафика через DDoS Guard.

Хостинг-провайдер SpaceWeb расширил линейку безопасности и подключил DDoS-защиту для VPS/VDS. Ранее хостер увеличил защиту сайтов от DDoS-атак, внедрив решение с максимальным уровнем защиты L7.

Новая услуга ориентирована на веб-разработчиков, которым важна бесперебойная работа сайта, приложения или другого веб-проекта в период пиковой нагрузки или DDoS-атаки. Также защищенный IP подойдет для работы с конфиденциальной информацией и базами данных, где недопустима утечка или сбои.

Сегодня качество кибератак заметно увеличилась. Наша новая услуга по защите DDoS Guard способна отразить разные уровни угроз, в том числе и уровень L7. Даже при начавшейся DDoS-атаке веб-проекты пользователей будут работать бесперебойно и с минимальной задержкой откликаговорит Егор Шилов, руководитель продуктового направления SpaceWeb.

Защищённый IP-адрес проходит через специализированные серверы, которые анализируют входящий трафик в реальном времени. Если на защищенном IP фиксируется атака или подозрительная активность, вредоносный трафик блокируется еще до VPS.

sweb.ru/cloud/DDoS-protection/