До 192 Гб RAM на процессорах AMD Ryzen и Intel Core

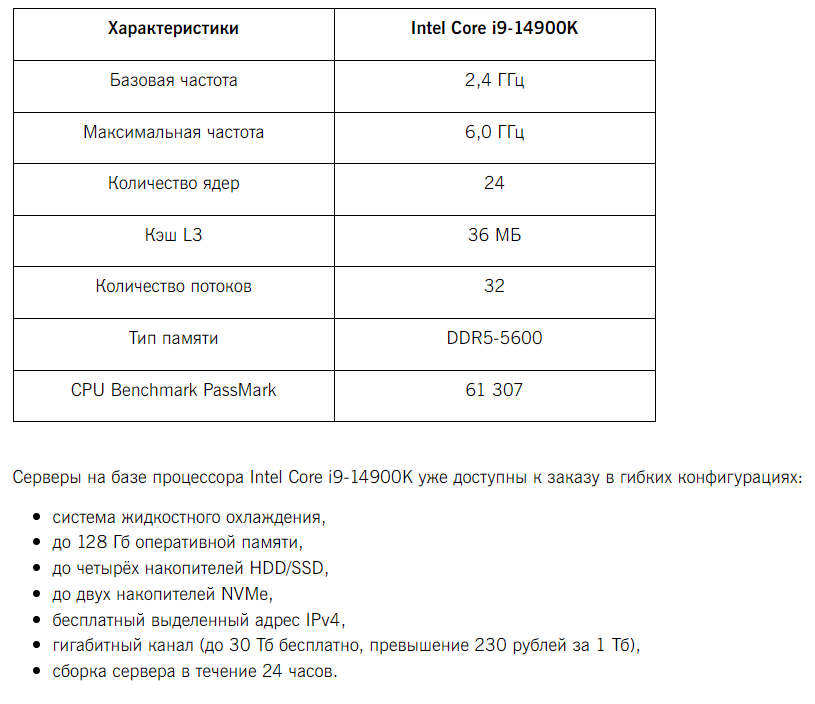

При заказе сервера с высокочастотными процессорами Intel Core i9-13900K (до 5.8 ГГц, 24 ядра), i9-14900K (до 6.0 ГГц, 24 ядра) и AMD Ryzen 9 7950X (до 5.7 ГГц, 16 ядер) — можно выбрать до 192 Гб оперативной памяти! Оформить заказ можно в конфигураторе, сервер будет готов уже в течение 24 часов.

Особенности платформы:

- система жидкостного охлаждения;

- накопители: до 4 HDD/SSD и до 2 NVMe;

- бесплатный выделенный адрес IPv4;

- бесплатный гигабитный канал (до 30 Тб).