Backblaze Hard Drive Stats Q1 2020

На 31 марта 2020 года компания Backblaze имела 132 339 вращающихся жестких дисков в нашей экосистеме облачных хранилищ, распределенных по четырем центрам обработки данных. Из этого числа было 2380 загрузочных дисков и 129 959 дисков с данными. В этом обзоре рассматриваются показатели Q1 2020 и частоты отказов жестких дисков на моделях накопителей данных, которые в настоящее время используются в наших центрах обработки данных, а также приводится несколько примеров и наблюдений. Кроме того, ближе к концу поста мы рассмотрим несколько прогнозов на 2019 год, которые мы представили год назад. Как всегда, мы с нетерпением ждем ваших комментариев.

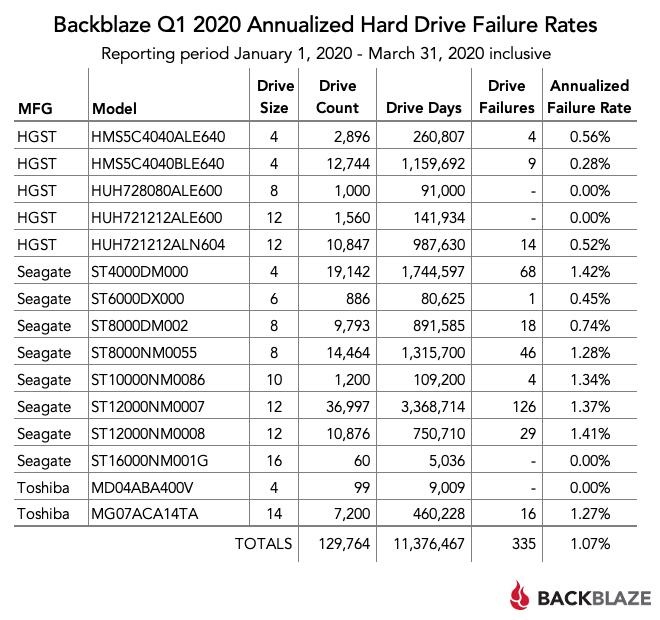

Статистика отказов жесткого диска за первый квартал 2020 года

В конце первого квартала 2020 года Backblaze использовала 129 959 жестких дисков для хранения данных клиентов. Для нашей оценки мы исключаем из рассмотрения те диски, которые использовались в целях тестирования, и модели, для которых у нас не было как минимум 60 дисков (см. Почему ниже). Это оставляет нам 129 764 жестких дисков. В таблице ниже показано, что произошло в первом квартале 2020 года.

Примечания и наблюдения

Годовой процент отказов (AFR) за первый квартал 2020 года составил 1,07%. Это самая низкая AFR за любой квартал с тех пор, как мы начали отслеживать в 2013 году. Кроме того, AFR за первый квартал 2020 года значительно ниже, чем AFR за первый квартал 2019 года, который составил 1,56%.

В течение этого квартала 4 (четыре) модели дисков от 3 (трех) производителей имели 0 (ноль) отказов дисков. Ни один из дисков Toshiba 4TB и Seagate 16TB не вышел из строя в первом квартале, но в течение квартала на обоих дисках было менее 10 000 дней. Как следствие, AFR может широко варьироваться от небольшого изменения отказов привода. Например, если вышел из строя только один накопитель Seagate 16 ТБ, AFR составит 7,25% за квартал. Точно так же AFR накопителя Toshiba 4TB составит 4,05% с одним провалом в квартале.

Напротив, оба накопителя HGST с 0 (нулевыми) отказами за квартал имеют разумное количество дней накопления, поэтому AFR менее изменчив. Если бы у модели 8 ТБ был 1 (один) сбой за квартал, AFR составила бы только 0,40%, а модель 12 ТБ имела бы AFR всего 0,26% с 1 (одним) отказом за квартал. В обоих случаях 0% AFR за квартал впечатляет.

Было 195 накопителей (129 959 минус 129 764), которые не были включены в приведенный выше список, поскольку они использовались в качестве тестовых накопителей или у нас не было как минимум 60 накопителей данной модели. Например, у нас есть: 20 накопителей Toshiba 16 ТБ (модель: MG08ACA16TA), 20 накопителей HGST 10 ТБ (модель: HUH721010ALE600) и 20 накопителей Toshiba 8 ТБ (модель: HDWF180). Когда мы публикуем квартальную, годовую или пожизненную статистику накопителей, модели с менее чем 60 накопителями не включаются в расчеты или графики. Мы используем как минимум 60 дисков, так как во всех вновь развернутых блоках хранения есть 60 дисков.

Тем не менее, все данные со всех моделей накопителей, включая загрузочные накопители, включены в файлы, к которым можно получить доступ и загрузить их на нашей веб-странице с данными испытаний накопителей.

Вычисление годовой частоты отказов

Во всех наших отчетах мы используем термин «Годовой процент отказов» (AFR). Слово «в годовом исчислении» здесь означает, что независимо от периода наблюдения (месяц, квартал) Частота отказов будет преобразована в годовой показатель. Для данной группы приводов (то есть модель, производитель) Мы рассчитываем AFR для периода наблюдения следующим образом:

- Отказ дисков — это количество дисков, которые вышли из строя в течение периода наблюдения.

- Дни привода — это количество дней, в течение которых все наблюдаемые диски работали в течение периода наблюдения.

- В 2020 году 366 дней, очевидно, что в не високосные годы мы используем 365.

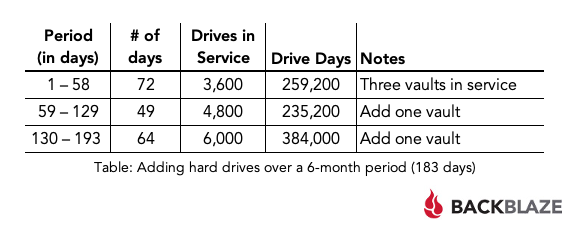

- За период наблюдения (шесть месяцев) было 28 сбоев в работе.

- В конце периода наблюдения было 6000 жестких дисков.

- Общее количество дней работы всех накопителей модели BB007 за период наблюдения (6 месяцев) составило 878 400 дней.

За шесть месяцев модель накопителя BB007 имела годовой коэффициент отказов 1,17%.

Суммируя количество дней вождения, вы получаете 878 400, но количество дисков в конце периода наблюдения составляет 6000. Формула дней суток реагирует на изменение количества дисков за период наблюдения, в то время как формула количества дисков реагирует только на счет в конце.

Частота отказов в 0,93% по формуле количества дисков значительно ниже, что хорошо, если вы являетесь производителем дисков, но не соответствует тому, как диски фактически интегрированы и используются в нашей среде. Вот почему Backblaze выбирает метод «дни вождения», так как он лучше соответствует реальности нашего бизнеса.

Прогнозы на первый квартал 2019 года

В обзоре статистики жестких дисков за первый квартал 2019 года мы сделали несколько прогнозов относительно жестких дисков о том, что произойдет к концу 2019 года. Давайте посмотрим, как мы это сделали.

Прогноз: Backblaze продолжит переносить диски емкостью 4 ТБ, и к концу 2019 года их будет менее 15 000: у нас сейчас около 35 000.

Реальность: количество дисков 4 ТБ по состоянию на 31 декабря 2019 года: 34 908.

Обзор: мы были слишком заняты добавлением дисков для переноса любого из них.

Предсказание. Мы установим как минимум двадцать накопителей емкостью 20 ТБ для тестирования.

Реальность: у нас ноль 20ТБ накопителей.

Обзор. Нам не предлагалось тестировать диски емкостью 20 ТБ или иным образом.

Предсказание: Backblaze превысит один эксабайт (1000 петабайт) доступного облачного хранилища. В настоящее время мы имеем около 850 петабайт доступного хранилища.

Реальность: мы объявили один эксабайт в марте 2020 года, сразу после конца 2019 года.

Рецензия: Цитируя Максвелла Смарта, «так сильно скучал».

Прогноз. Для целей тестирования мы установим как минимум 1 накопитель на основе HAMR от Seagate и / или 1 накопитель MAMR от Western Digital.

Реальность: не нюхать диски HAMR или MAMR.

Обзор: Надеюсь, к концу 2020 года.

Подводя итог, я думаю, что вернусь к статистике жесткого диска и оставлю прогнозирование предсказателям и предсказателям.

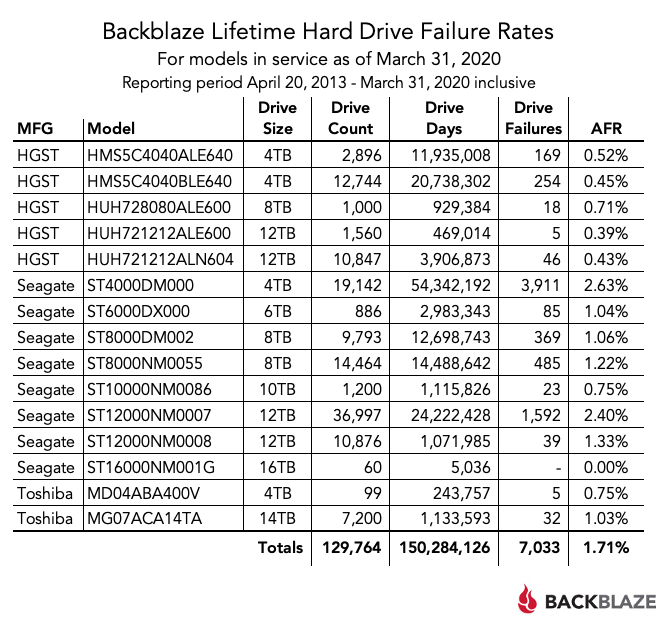

Статистика срока службы жесткого диска

В приведенной ниже таблице показана частота отказов в течение срока службы моделей жестких дисков, которые мы эксплуатировали по состоянию на 31 марта 2020 года. Отчетный период — с апреля 2013 года по 31 декабря 2019 года. Все перечисленные диски были установлены в течение этого периода времени.

Но как насчет Drive Count?

Некоторым из вас может быть интересно, где «количество накопителей» вписывается в эту формулу? Это не так, и это беспокоит некоторых людей. В конце концов, было бы проще рассчитать AFR как:

AFR = (Отказы двигателя / Счетчик движения) * (366 дней в период наблюдения) * 100

Давайте вернемся к нашему примеру в предыдущем абзаце. В конце периода наблюдения было 6 000 жестких дисков; делать математику:

AFR = (28/6000) * (366/183) * 100 = (0,00467) * (2) * 100 = 0,93%

Используя метод подсчета накопителей, модель BB007 имела частоту отказов 0,93%. Причина различия заключается в том, что Backblaze постоянно добавляет и вычитает диски. Новые хранилища Backblaze появляются каждый месяц; новые функции, такие как совместимость с S3, быстро увеличивают спрос; миграция заменяет старые диски малой емкости на новые диски большей емкости; и иногда в смеси присутствуют клонированные и временные диски. Среда очень динамичная. Количество поездок в любой день в течение периода наблюдения будет варьироваться. При использовании метода подсчета накопителей частота отказов зависит от дня подсчета накопителей. В этом случае последний день периода наблюдения. При использовании метода дней привода частота отказов определяется на весь период наблюдения.

В нашем примере в следующей таблице показано количество накопителей по мере добавления накопителей за шестимесячный период наблюдения:

Данные о жестком диске

Полный набор данных, использованный для создания информации, использованной в этом обзоре, доступен на нашей веб-странице с данными испытаний жесткого диска. Вы можете скачать и использовать эти данные бесплатно в своих целях. Все, что мы просим, — это три вещи: 1) Вы цитируете Backblaze в качестве источника, если вы используете данные, 2) Вы соглашаетесь с тем, что несете единоличную ответственность за то, как вы используете данные, и 3) Вы не продаете эти данные кому-либо — это бесплатно.

Если вы просто хотите, чтобы сводные данные использовались для создания таблиц и диаграмм в этом сообщении в блоге, вы можете загрузить ZIP-файл, содержащий электронную таблицу MS Excel.

f001.backblazeb2.com/file/Backblaze_Blog/Q1_2020_Drive_Stats_Charts_Data.zip

Удачи и дайте нам знать, если найдете что-нибудь интересное.