Строительство ЦОДов в Марфино и Мытищах продолжается

Марфино: усиливаем надёжность первой очереди

Август был месяцем грандиозных планов на газоснабжение, а сентябрь стал месяцем конкретных шагов по обеспечению максимальной отказоустойчивости нашего первого контейнерного ЦОДА.

1. Резервный генератор: мощность в резерве

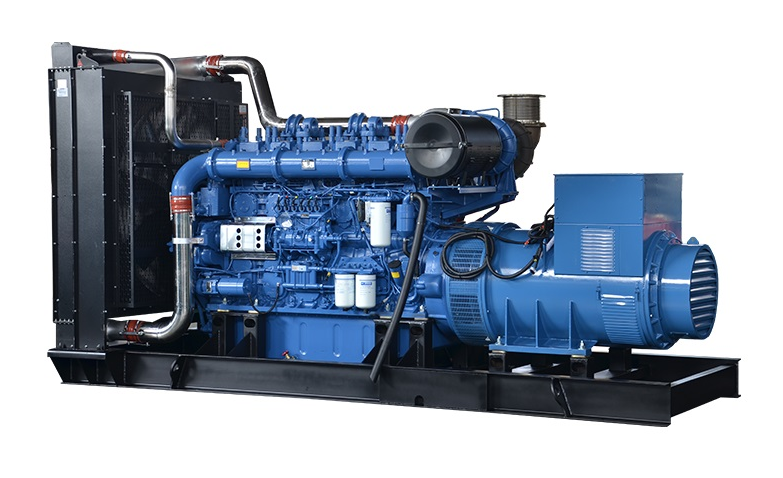

Мы приобрели резервную дизель-генераторную установку (ДГУ). Затем протестировали её с нагрузочным модулем. Это важный шаг для бесперебойной работы первого контейнера. Теперь у объекта будет дополнительный независимый источник питания.

2. Связь: прокладываем цифровую магистраль

Подписан договор на создание выделенного оптического канала связи до М9 — центрального узла обмена трафиком в стране. Так мы формируем высокоскоростную защищённую цифровую артерию — основу гарантированной доступности сервисов для наших клиентов.

3. Снабжение: работа кипит

Продолжаются закупки оборудования. Да, это не всегда зрелищно, но именно на этапе обеспечения стройки закладывается фундамент эффективности и надёжности наших дата-центров.

Мытищи: этап исследований завершён, начинается энергетика

На площадке в Мытищах сентябрь был посвящён получению точных данных и созданию условий для будущего строительства.

1. Инженерно-геодезические изыскания: фундамент знаний

Мы завершили часть комплекса изысканий: провели инженерно-геодезические изыскания. Теперь у нас есть детальный план местности, точные координаты и высотные отметки. Эти данные — основа для корректного проектирования конструкций и прокладки коммуникаций. Без этого — никуда.

2. Строительное электроснабжение: первый ток

На объект подведено временное строительное электроснабжение. Строители получили энергию для проведения работ, освещения площадки и бытовых городков, что позволяет приступать к следующим этапам.

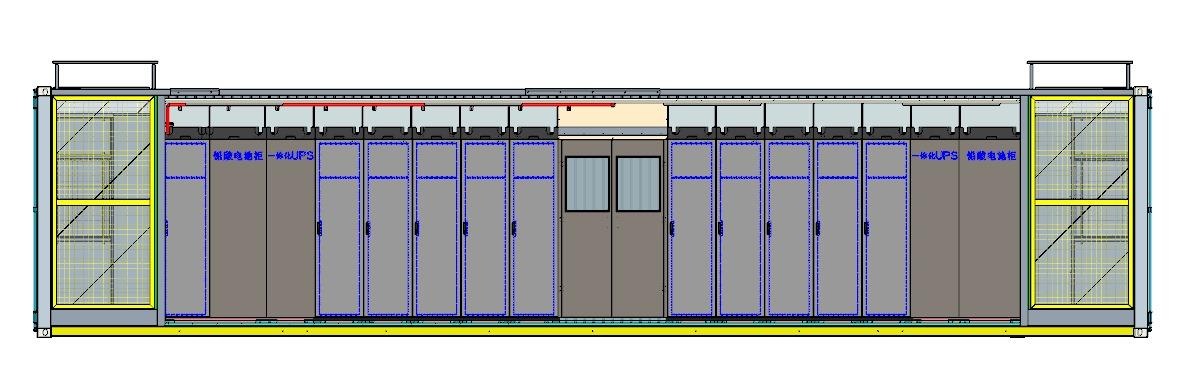

3. Работа с проектировщиками: создаём цифрового двойника

Мы углублённо работаем с проектировщиками над архитектурой будущего ЦОД. Сейчас прорабатываются все нюансы — от системы охлаждения до размещения серверных стоек.

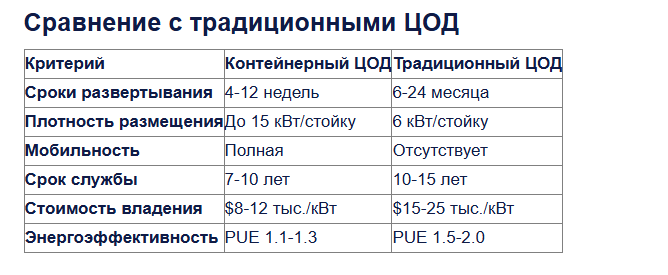

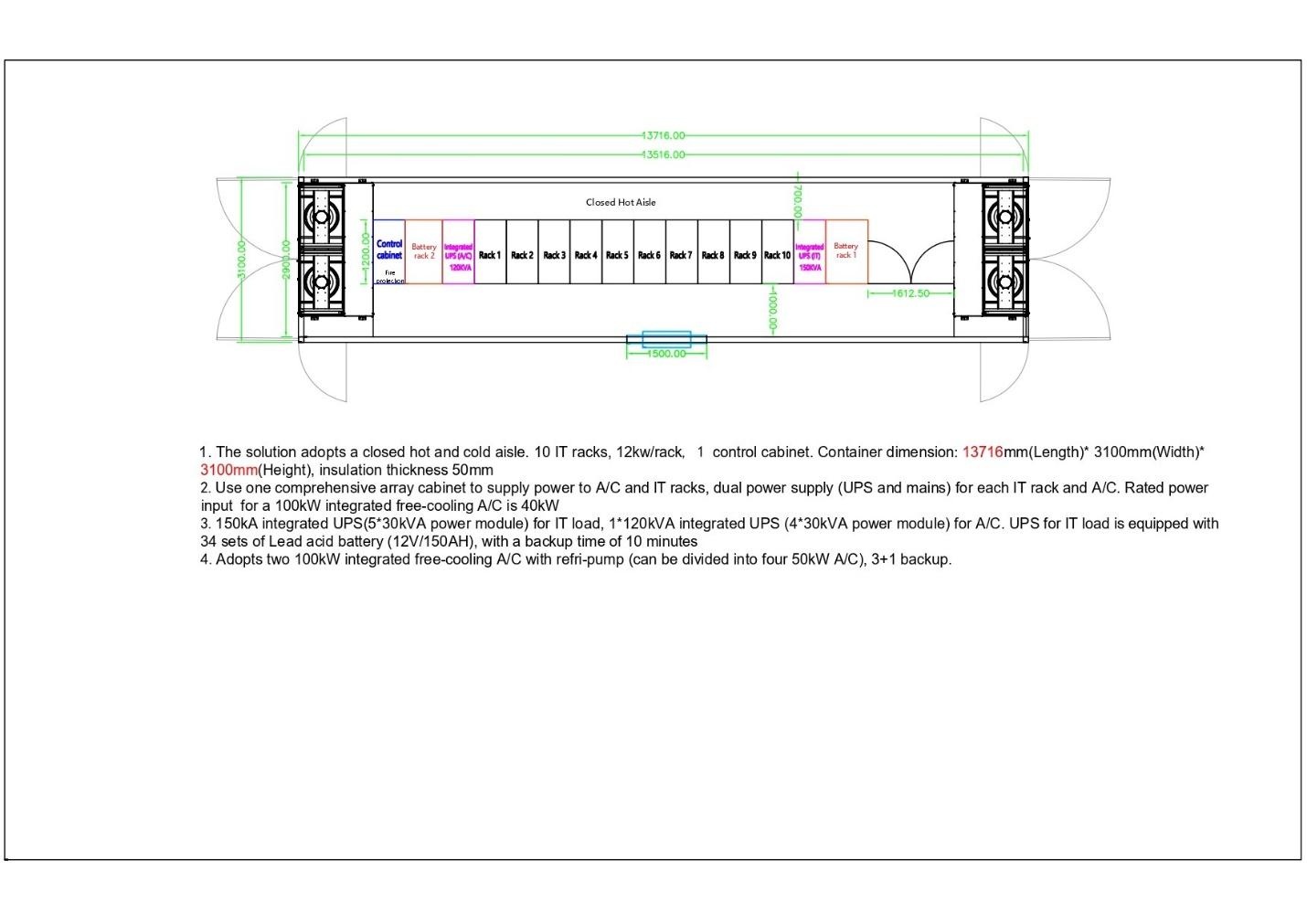

Не только стройка: почему мы закладываем 15-20 кВт на стойку?

В прошлых статьях мы рассказывали, где мы строим. Сегодня хотим поговорить о том, что мы строим, а именно — почему одна из ключевых характеристик наших новых площадок — максимальная мощность в 15-20 кВт на стойку. Этот вопрос нам часто задают, и он действительно ключевой для современных задач.

Эволюция нагрузки: почему 5 кВт — это вчерашний день?

Многие действующие ЦОДы строились по нормам, для которых стандартом были 4-6 кВт на стойку. Однако мир данных изменился. Сегодня даже один сервер с современными процессорами и GPU для задач искусственного интеллекта может потреблять 1-1.5 кВт. Представьте: чтобы разместить в стойке всего 3-4 таких сервера, уже требуется 5 кВт! А ведь нужно место для коммутаторов, систем хранения и резервирования, а в отдельных случаях и охлаждения.

Что получают наши клиенты от 15 кВт?

Как нам это удаётся?

Всё дело в точном расчёте. Ещё на этапе проектирования мы закладываем соответствующую мощность. Но главный вызов — это отвод тепла. Наши системы охлаждения проектируются именно под такие высокие нагрузки, обеспечивая стабильный температурный режим для вашего оборудования 24/7.

Таким образом, выбор в пользу 15-20кВт — это не гонка за цифрами. Решение стратегическое — оно основано на понимании текущих и будущих потребностей рынка. Мы строим инфраструктуру, которая будет способствовать развитию вашего бизнеса.

Марфино

Здесь мы сфокусировались на двух направлениях: развитие ключевых коммуникаций и стратегическая подготовка к холодному сезону.

1. Прокладываем цифровой хайвей: дорабатываем подключение к М9

Мы выполнили дополнительные этапы по подключению волоконно-оптической линии связи (ВОЛС) к М9 — центральному узлу обмена трафиком в стране. Со стороны это может выглядеть как «протянули ещё несколько проводов», но на деле это кропотливая работа: прокладка в кабельной канализации, сварка оптических волокон, тестирование каждого соединения. Каждый такой метр — это кирпичик в будущей сети с минимальными задержками, которая свяжет ваш будущий сервис с крупнейшими узлами обмена трафиком.

2. Невидимая работа: закладываем инженерные артерии

Пока одни работают с оптоволокном, другие продолжают масштабные работы по прокладке инженерных коммуникаций. На территории вовсю кипит работа: роются траншеи, укладываются трубы будущих систем водоснабжения и водоотведения. Это та самая «нефотогеничная» стадия, которая является жизненно важным фундаментом для любого современного ЦОД — без неё невозможна ни работа систем охлаждения, ни штатное функционирование объекта в целом.

3. Стратегическая подготовка к зиме: обеспечиваем бесперебойность

За окном осень, и мы активно проводим работы по консервации и укреплению площадки. Уборка и укладка внутренних дорог — это не про эстетику, а про логистику. Устойчивое покрытие гарантирует, что подрядчики и техника смогут попасть на объект в любую погоду.

Герметизация неиспользуемых строений — это защита от холода и влаги, которые проникают через микротрещины. Это прямые инвестиции в сохранность будущего оборудования и снижение эксплуатационных расходов.

Также проводим ремонтные работы. Так мы поддерживаем существующие активы в идеальном состоянии.

Эти, казалось бы, рутинные задачи — важная часть нашей философии: создавать инфраструктуру, которая стабильно работает 24/7/365, независимо от внешних обстоятельств.

Мытищи

На этой площадке октябрь прошёл под знаком проектной и договорной работы. Это тот случай, когда тишина и отсутствие громких событий — признак правильного системного движения вперёд.

1. Детальная проработка проектной документации

Мы активно ведём договорную работу с проектировщиками. Сейчас создаётся модель будущего ЦОД, где прорабатывается каждая деталь — от размещения серверных стоек и прокладки кабельных трасс до алгоритмов работы систем охлаждения и резервирования. Именно на этом этапе мы можем виртуально «испытать» будущий дата-центр на отказоустойчивость и эффективность, чтобы в реальности вы получили идеальный продукт.

2. Получаем официальные «добро» на подключения

Продолжаем согласование подключений к внешним коммуникациям. Каждое такое техническое условие — это кирпичик в фундаменте жизнеспособности объекта. Электричество, водоснабжение, канализация — без официальных разрешений и чёткого понимания точек подключения дальнейшее строительство невозможно. Эта работа требует терпения и внимания к деталям, и мы её планомерно ведём.

В фокусе — ваша стабильность завтра

Каждый согласованный документ, каждый отремонтированный квадратный метр и каждый уложенный метр дороги — это вклад в ваше спокойствие. Мы не просто строим, мы создаём среду, где ваше оборудование будет работать предсказуемо и эффективно. Наши собственные ЦОД — это синоним независимости, контроля и уверенности в завтрашнем дне для вашего бизнеса.

Марфино: от проектов — к реальной мощности

В ноябре мы развивали сразу несколько важных направлений.

1. Электричество: получен согласованный проект на 150 кВт

Мы получили на руки согласованный проект по электрическим мощностям для контейнерного ЦОД. Теперь у нас есть официальный документ, разрешающий подключение мощности 150 кВт — солидный энергетический пакет для старта. Впереди — выполнение всех технических условий, но самый важный административный барьер взят.

2. Коммуникации: подключаемся к городским сетям

Завершили работы по трассе канализации, ведущей от нашей площадки в городскую сеть. Вопрос водоотведения будущего ЦОД решён. Также провели сварку оптического кабеля, соединяющего наш ЦОД с магистральной трассой. По сути, мы проложили постоянную «цифровую артерию», которая будет питать объект данными.

3. Энергоснабжение: резервируем мощность в лизинг

Заключён договор лизинга на оборудование контейнерной газопоршневой установки (ГПУ). Это стратегический шаг, который обеспечит объекту независимость и надёжность в вопросах энергоснабжения в будущем.

Мытищи: этап изысканий завершён

На этой площадке ноябрь был посвящён исследованиям. В результате геологические изыскания полностью завершены. Инженеры получили исчерпывающие данные о свойствах грунтов и строении площадки. Эта информация абсолютно необходима для корректного проектирования фундаментов и будущих сооружений. Без преувеличения, от этих данных зависит долговечность и безопасность всего объекта.

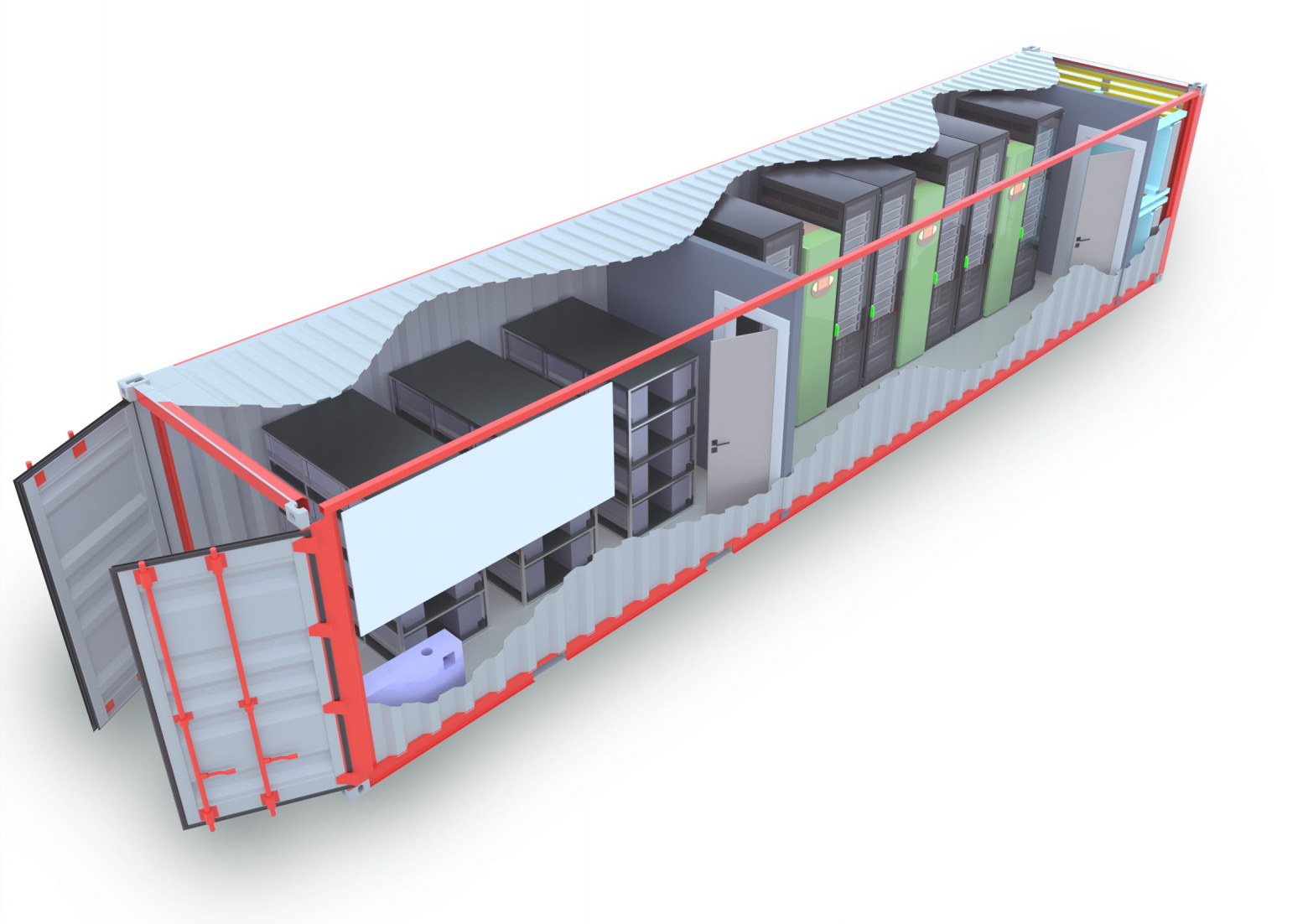

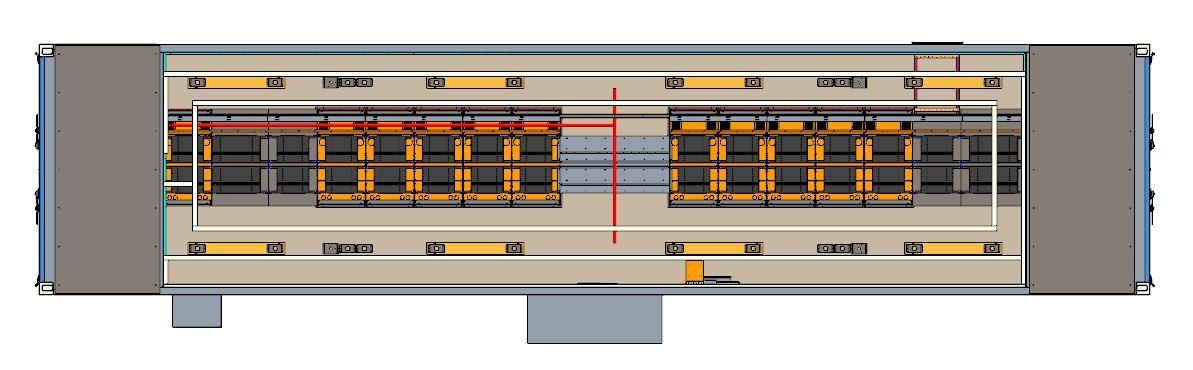

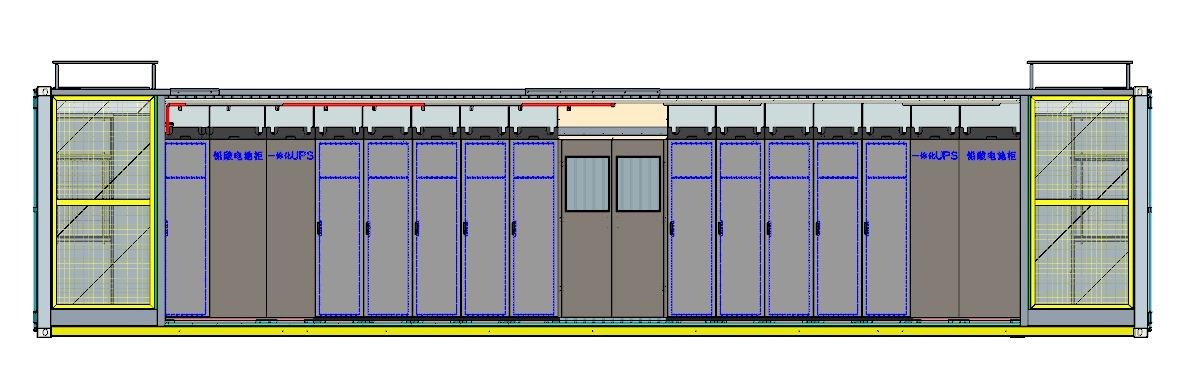

Итак, в 2025 году мы подготовили две площадки. В Марфино привезли и установили первый контейнерный ЦОД и проложили прямое оптоволокно к центральному узлу обмена трафиком (М9), заложив основу энергонезависимости. А в Мытищах провели все изыскания, чтобы строить наверняка. У нас теперь есть собственный, созданный с нуля, фундамент для роста. И это только основа для ещё более продуктивного 2026-го.

За 12 месяцев в Марфино мы прошли путь от заброшенной территории с полуразрушенными зданиями до готового ЦОДа. Таким образом, 2025-й был годом начала строительства и масштабной подготовки к запуску первого контейнера. А 2026-й должен стать годом капстроя: к этому всё идёт — большая часть оборудования уже закуплена.

Август был месяцем грандиозных планов на газоснабжение, а сентябрь стал месяцем конкретных шагов по обеспечению максимальной отказоустойчивости нашего первого контейнерного ЦОДА.

1. Резервный генератор: мощность в резерве

Мы приобрели резервную дизель-генераторную установку (ДГУ). Затем протестировали её с нагрузочным модулем. Это важный шаг для бесперебойной работы первого контейнера. Теперь у объекта будет дополнительный независимый источник питания.

2. Связь: прокладываем цифровую магистраль

Подписан договор на создание выделенного оптического канала связи до М9 — центрального узла обмена трафиком в стране. Так мы формируем высокоскоростную защищённую цифровую артерию — основу гарантированной доступности сервисов для наших клиентов.

3. Снабжение: работа кипит

Продолжаются закупки оборудования. Да, это не всегда зрелищно, но именно на этапе обеспечения стройки закладывается фундамент эффективности и надёжности наших дата-центров.

Мытищи: этап исследований завершён, начинается энергетика

На площадке в Мытищах сентябрь был посвящён получению точных данных и созданию условий для будущего строительства.

1. Инженерно-геодезические изыскания: фундамент знаний

Мы завершили часть комплекса изысканий: провели инженерно-геодезические изыскания. Теперь у нас есть детальный план местности, точные координаты и высотные отметки. Эти данные — основа для корректного проектирования конструкций и прокладки коммуникаций. Без этого — никуда.

2. Строительное электроснабжение: первый ток

На объект подведено временное строительное электроснабжение. Строители получили энергию для проведения работ, освещения площадки и бытовых городков, что позволяет приступать к следующим этапам.

3. Работа с проектировщиками: создаём цифрового двойника

Мы углублённо работаем с проектировщиками над архитектурой будущего ЦОД. Сейчас прорабатываются все нюансы — от системы охлаждения до размещения серверных стоек.

Не только стройка: почему мы закладываем 15-20 кВт на стойку?

В прошлых статьях мы рассказывали, где мы строим. Сегодня хотим поговорить о том, что мы строим, а именно — почему одна из ключевых характеристик наших новых площадок — максимальная мощность в 15-20 кВт на стойку. Этот вопрос нам часто задают, и он действительно ключевой для современных задач.

Эволюция нагрузки: почему 5 кВт — это вчерашний день?

Многие действующие ЦОДы строились по нормам, для которых стандартом были 4-6 кВт на стойку. Однако мир данных изменился. Сегодня даже один сервер с современными процессорами и GPU для задач искусственного интеллекта может потреблять 1-1.5 кВт. Представьте: чтобы разместить в стойке всего 3-4 таких сервера, уже требуется 5 кВт! А ведь нужно место для коммутаторов, систем хранения и резервирования, а в отдельных случаях и охлаждения.

Что получают наши клиенты от 15 кВт?

- Плотность и эффективность. Вы можете размещать самое современное и производительное «железо» без искусственных ограничений. Это означает существенную экономию на аренде пространства — вам не придётся арендовать несколько стоек для одного высоконагруженного кластера.

- Запас на будущее. Мы закладываем инфраструктуру на будущее. Ведь технологии не стоят на месте — потребляемая мощность будет только расти. Размещая оборудование у нас, вы страхуете свой бизнес от необходимости срочного и дорогого переезда.

- Решение конкретных бизнес-задач. Высокая плотность — это не просто цифры. Это возможность эффективно запускать решать ресурсоёмкие задачи, которые просто не реализуемы в стойках с низким лимитом мощности.

Как нам это удаётся?

Всё дело в точном расчёте. Ещё на этапе проектирования мы закладываем соответствующую мощность. Но главный вызов — это отвод тепла. Наши системы охлаждения проектируются именно под такие высокие нагрузки, обеспечивая стабильный температурный режим для вашего оборудования 24/7.

Таким образом, выбор в пользу 15-20кВт — это не гонка за цифрами. Решение стратегическое — оно основано на понимании текущих и будущих потребностей рынка. Мы строим инфраструктуру, которая будет способствовать развитию вашего бизнеса.

Марфино

Здесь мы сфокусировались на двух направлениях: развитие ключевых коммуникаций и стратегическая подготовка к холодному сезону.

1. Прокладываем цифровой хайвей: дорабатываем подключение к М9

Мы выполнили дополнительные этапы по подключению волоконно-оптической линии связи (ВОЛС) к М9 — центральному узлу обмена трафиком в стране. Со стороны это может выглядеть как «протянули ещё несколько проводов», но на деле это кропотливая работа: прокладка в кабельной канализации, сварка оптических волокон, тестирование каждого соединения. Каждый такой метр — это кирпичик в будущей сети с минимальными задержками, которая свяжет ваш будущий сервис с крупнейшими узлами обмена трафиком.

2. Невидимая работа: закладываем инженерные артерии

Пока одни работают с оптоволокном, другие продолжают масштабные работы по прокладке инженерных коммуникаций. На территории вовсю кипит работа: роются траншеи, укладываются трубы будущих систем водоснабжения и водоотведения. Это та самая «нефотогеничная» стадия, которая является жизненно важным фундаментом для любого современного ЦОД — без неё невозможна ни работа систем охлаждения, ни штатное функционирование объекта в целом.

3. Стратегическая подготовка к зиме: обеспечиваем бесперебойность

За окном осень, и мы активно проводим работы по консервации и укреплению площадки. Уборка и укладка внутренних дорог — это не про эстетику, а про логистику. Устойчивое покрытие гарантирует, что подрядчики и техника смогут попасть на объект в любую погоду.

Герметизация неиспользуемых строений — это защита от холода и влаги, которые проникают через микротрещины. Это прямые инвестиции в сохранность будущего оборудования и снижение эксплуатационных расходов.

Также проводим ремонтные работы. Так мы поддерживаем существующие активы в идеальном состоянии.

Эти, казалось бы, рутинные задачи — важная часть нашей философии: создавать инфраструктуру, которая стабильно работает 24/7/365, независимо от внешних обстоятельств.

Мытищи

На этой площадке октябрь прошёл под знаком проектной и договорной работы. Это тот случай, когда тишина и отсутствие громких событий — признак правильного системного движения вперёд.

1. Детальная проработка проектной документации

Мы активно ведём договорную работу с проектировщиками. Сейчас создаётся модель будущего ЦОД, где прорабатывается каждая деталь — от размещения серверных стоек и прокладки кабельных трасс до алгоритмов работы систем охлаждения и резервирования. Именно на этом этапе мы можем виртуально «испытать» будущий дата-центр на отказоустойчивость и эффективность, чтобы в реальности вы получили идеальный продукт.

2. Получаем официальные «добро» на подключения

Продолжаем согласование подключений к внешним коммуникациям. Каждое такое техническое условие — это кирпичик в фундаменте жизнеспособности объекта. Электричество, водоснабжение, канализация — без официальных разрешений и чёткого понимания точек подключения дальнейшее строительство невозможно. Эта работа требует терпения и внимания к деталям, и мы её планомерно ведём.

В фокусе — ваша стабильность завтра

Каждый согласованный документ, каждый отремонтированный квадратный метр и каждый уложенный метр дороги — это вклад в ваше спокойствие. Мы не просто строим, мы создаём среду, где ваше оборудование будет работать предсказуемо и эффективно. Наши собственные ЦОД — это синоним независимости, контроля и уверенности в завтрашнем дне для вашего бизнеса.

Марфино: от проектов — к реальной мощности

В ноябре мы развивали сразу несколько важных направлений.

1. Электричество: получен согласованный проект на 150 кВт

Мы получили на руки согласованный проект по электрическим мощностям для контейнерного ЦОД. Теперь у нас есть официальный документ, разрешающий подключение мощности 150 кВт — солидный энергетический пакет для старта. Впереди — выполнение всех технических условий, но самый важный административный барьер взят.

2. Коммуникации: подключаемся к городским сетям

Завершили работы по трассе канализации, ведущей от нашей площадки в городскую сеть. Вопрос водоотведения будущего ЦОД решён. Также провели сварку оптического кабеля, соединяющего наш ЦОД с магистральной трассой. По сути, мы проложили постоянную «цифровую артерию», которая будет питать объект данными.

3. Энергоснабжение: резервируем мощность в лизинг

Заключён договор лизинга на оборудование контейнерной газопоршневой установки (ГПУ). Это стратегический шаг, который обеспечит объекту независимость и надёжность в вопросах энергоснабжения в будущем.

Мытищи: этап изысканий завершён

На этой площадке ноябрь был посвящён исследованиям. В результате геологические изыскания полностью завершены. Инженеры получили исчерпывающие данные о свойствах грунтов и строении площадки. Эта информация абсолютно необходима для корректного проектирования фундаментов и будущих сооружений. Без преувеличения, от этих данных зависит долговечность и безопасность всего объекта.

Итак, в 2025 году мы подготовили две площадки. В Марфино привезли и установили первый контейнерный ЦОД и проложили прямое оптоволокно к центральному узлу обмена трафиком (М9), заложив основу энергонезависимости. А в Мытищах провели все изыскания, чтобы строить наверняка. У нас теперь есть собственный, созданный с нуля, фундамент для роста. И это только основа для ещё более продуктивного 2026-го.

За 12 месяцев в Марфино мы прошли путь от заброшенной территории с полуразрушенными зданиями до готового ЦОДа. Таким образом, 2025-й был годом начала строительства и масштабной подготовки к запуску первого контейнера. А 2026-й должен стать годом капстроя: к этому всё идёт — большая часть оборудования уже закуплена.