С сотнями тысяч жёстких дисков, работающих круглосуточно, наши центры обработки данных больше похожи не на тихие оазисы, а на череду полос препятствий, если бы речь шла об управлении более чем четырьмя эксабайтами данных клиентов — от архивных резервных копий до потокового мультимедиа и наборов данных для обучения ИИ. Конечно, это полосы препятствий, которые мы все (и я включаю вас, пользователей интернета) создаём коллективно, но найти участников (хм, жёстких дисков) — это не менее сложная задача.

И мы, дорогие читатели, можем наблюдать за всем этим. Добро пожаловать в Drive Stats: где неудачи неизбежны, выживание — увлекательно, а каждый квартал приносит новую таблицу лидеров.

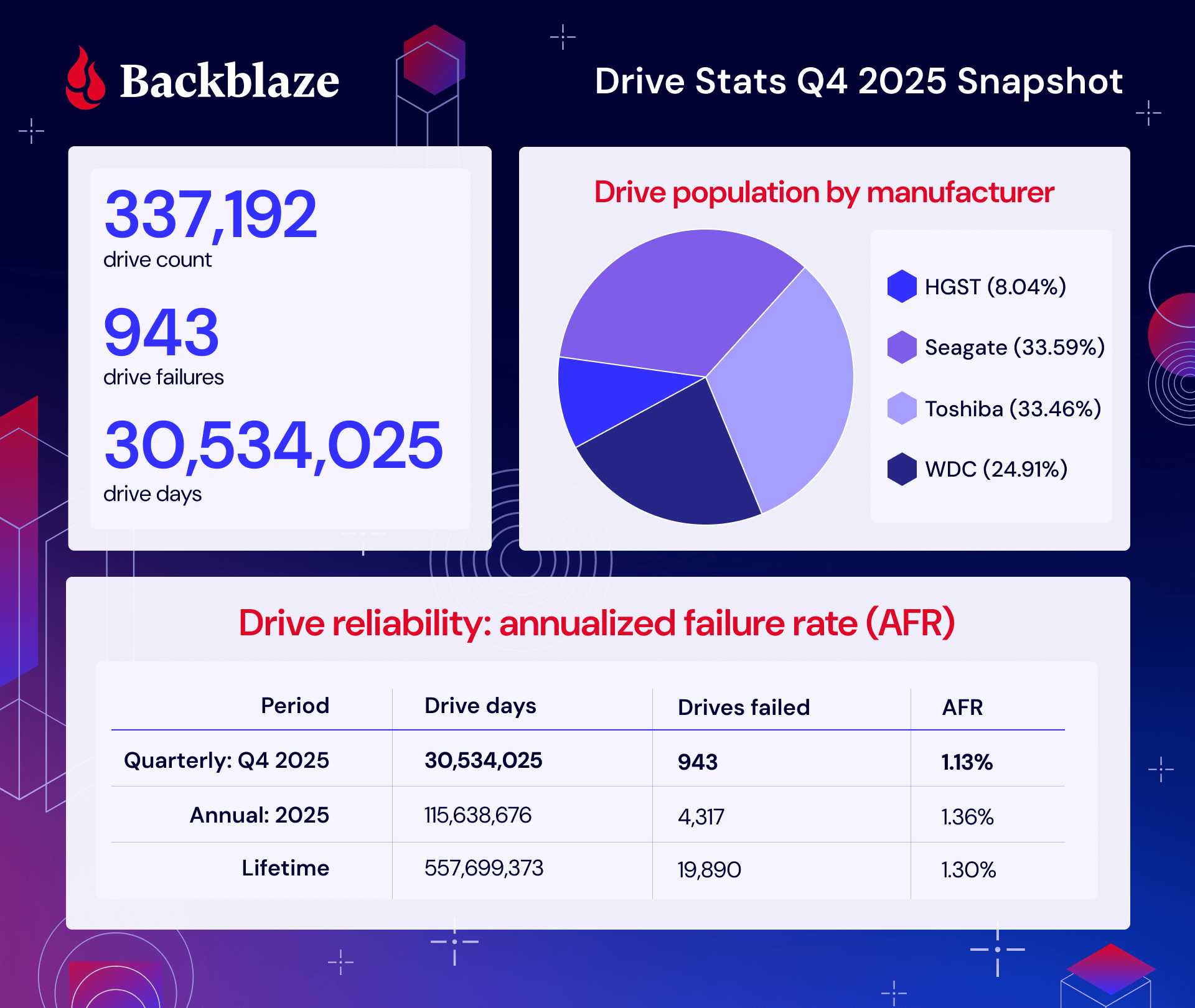

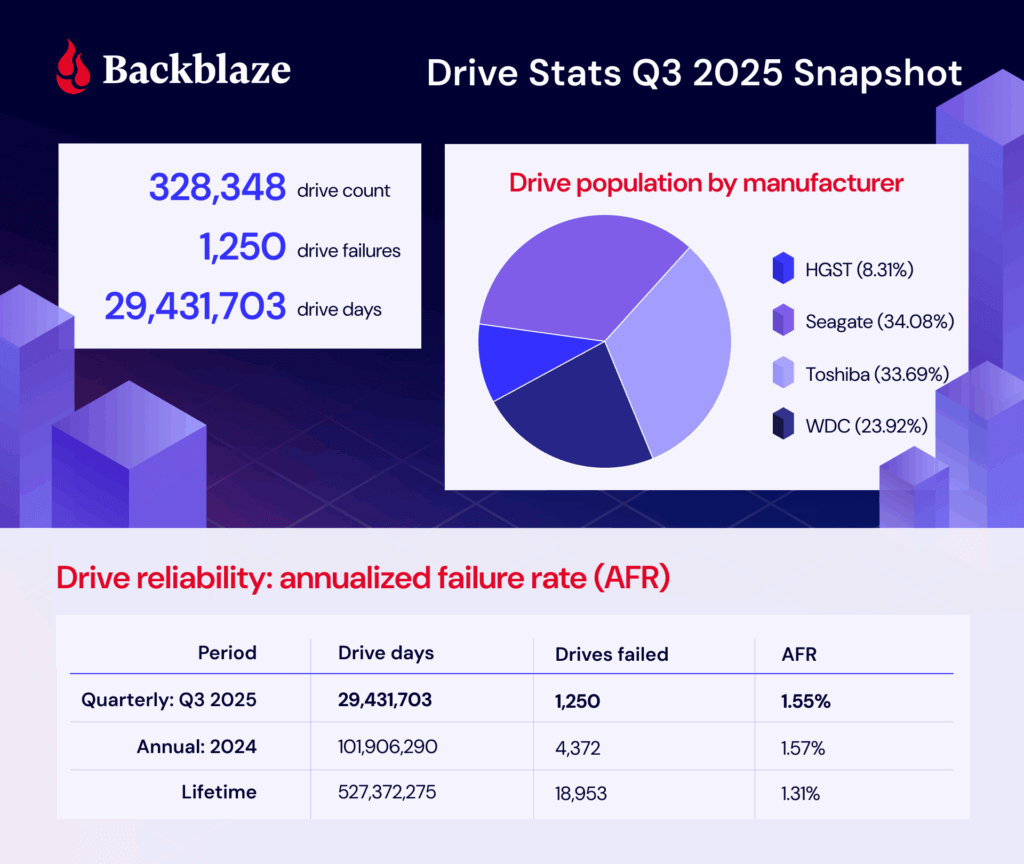

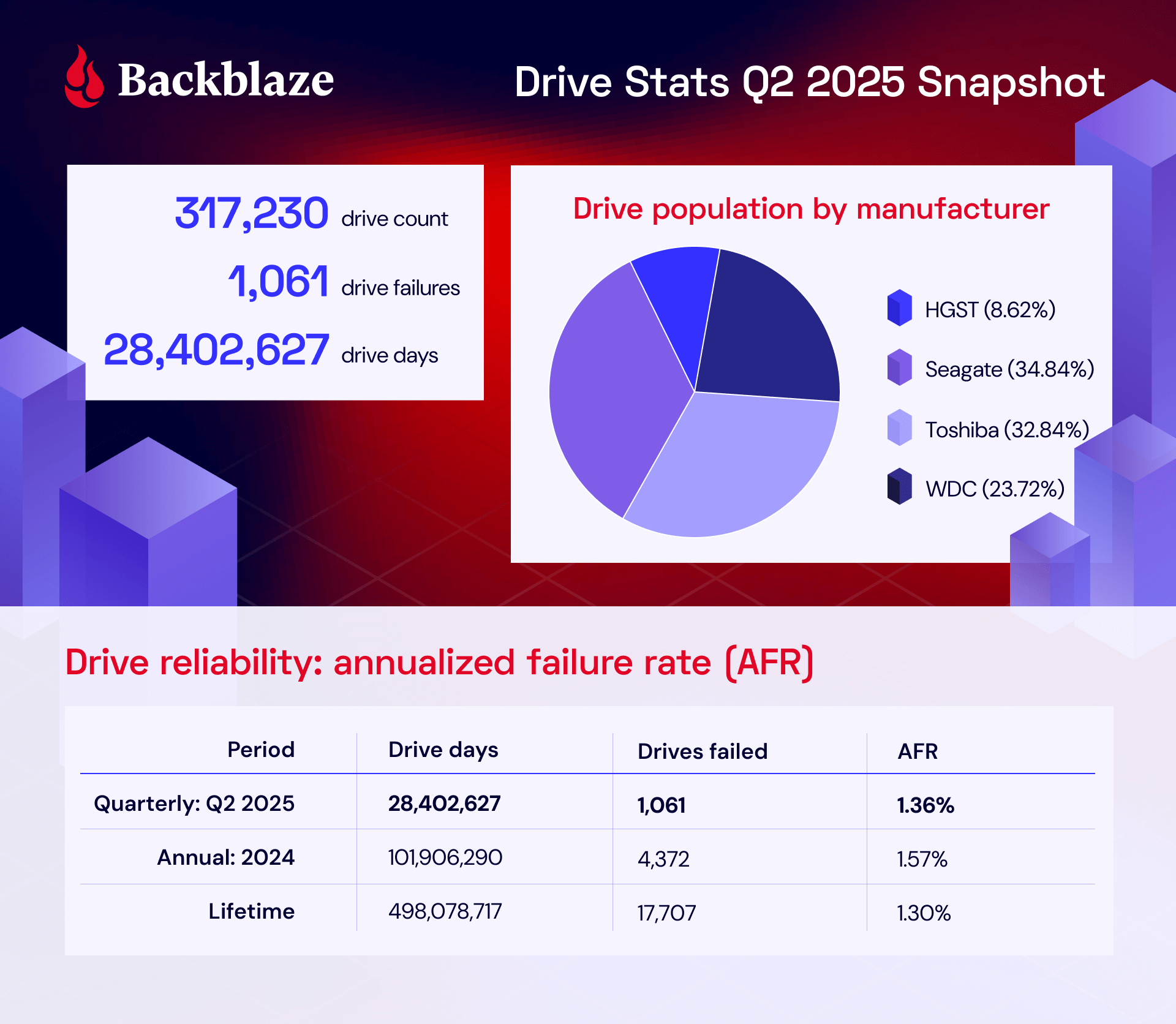

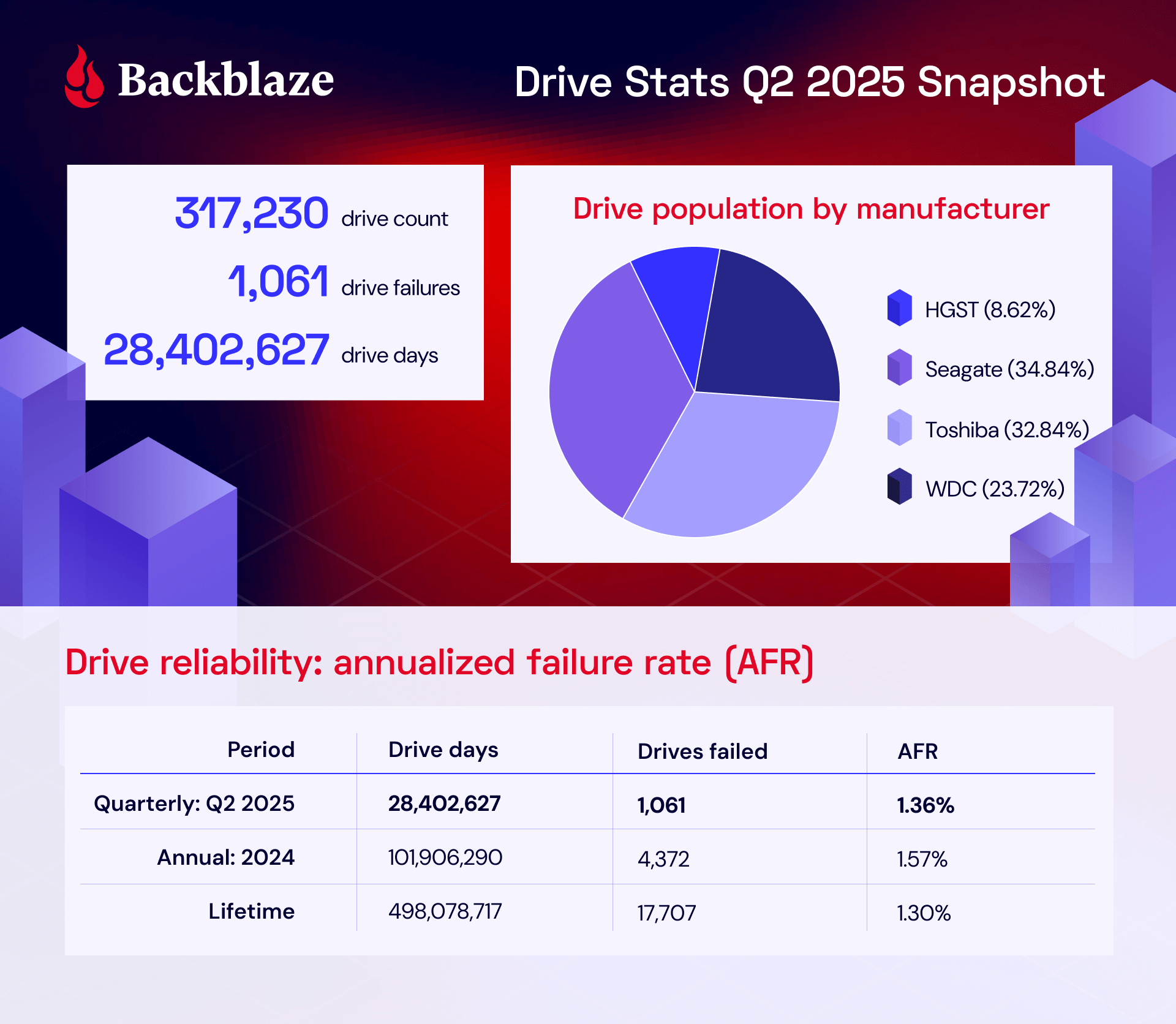

По состоянию на 30 июня 2025 года у нас под управлением находилось 321 201 диск. Из них 3971 загрузочный диск и 317 230 дисков с данными. Следите за новостями: мы публикуем стандартный обзор квартальных и общих показателей отказов, а также подробно изучаем диски объёмом более 20 ТБ.

Как всегда, увидимся в комментариях. В этом месяце у вас также будет три (считайте, целых три!) возможности пообщаться с нами лично — виртуально на нашей прямой трансляции Drive Stats LinkedIn Live 5 августа (сегодня) или дважды в Лас-Вегасе на DefCon 7 и 8 августа.

А после DefCon мы задержимся в Вегасе, чтобы посетить выставку Ai4 с 11 по 13 августа. Если вы будете поблизости, загляните на стенд 226 и послушайте выступление нашего коллеги Джеронимо Де Леона о системах хранения данных и искусственном интеллекте, если у вас есть свободное время.

Статистика привода в цифрах: дайджест-версия

оказатели отказов жестких дисков во втором квартале 2025 года

оказатели отказов жестких дисков во втором квартале 2025 года

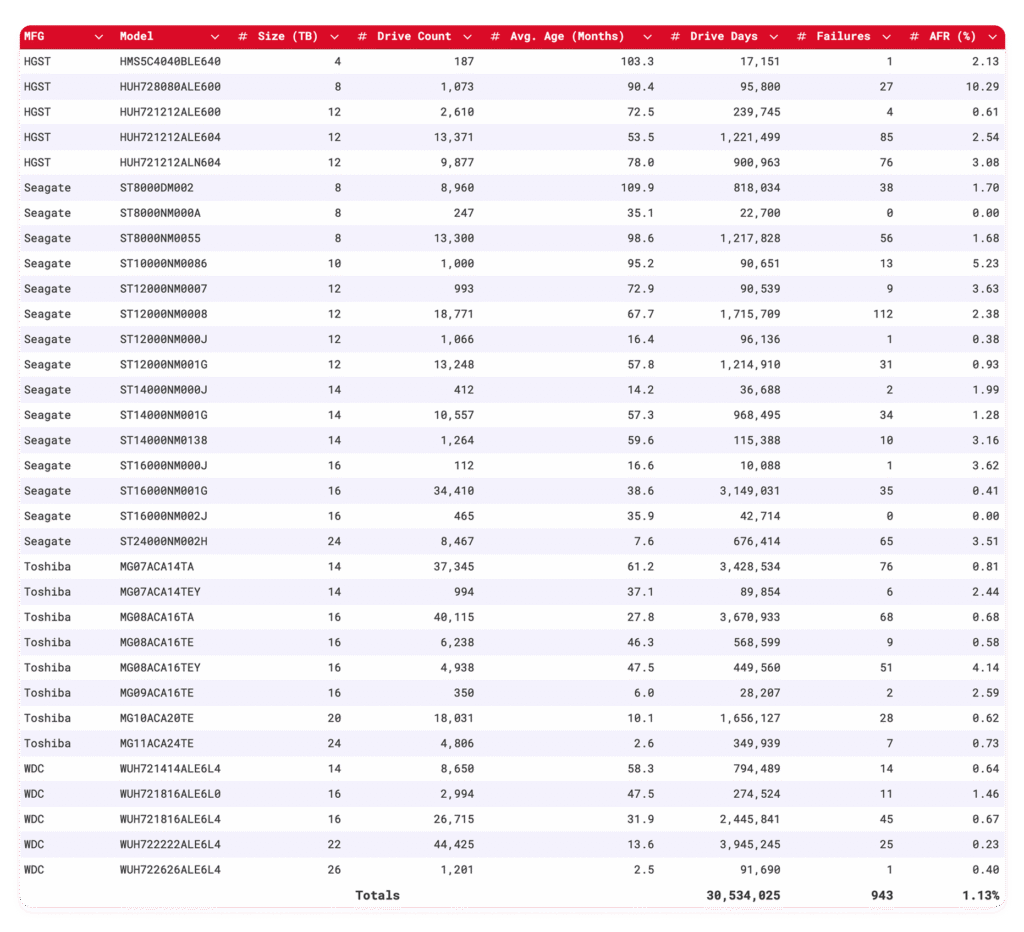

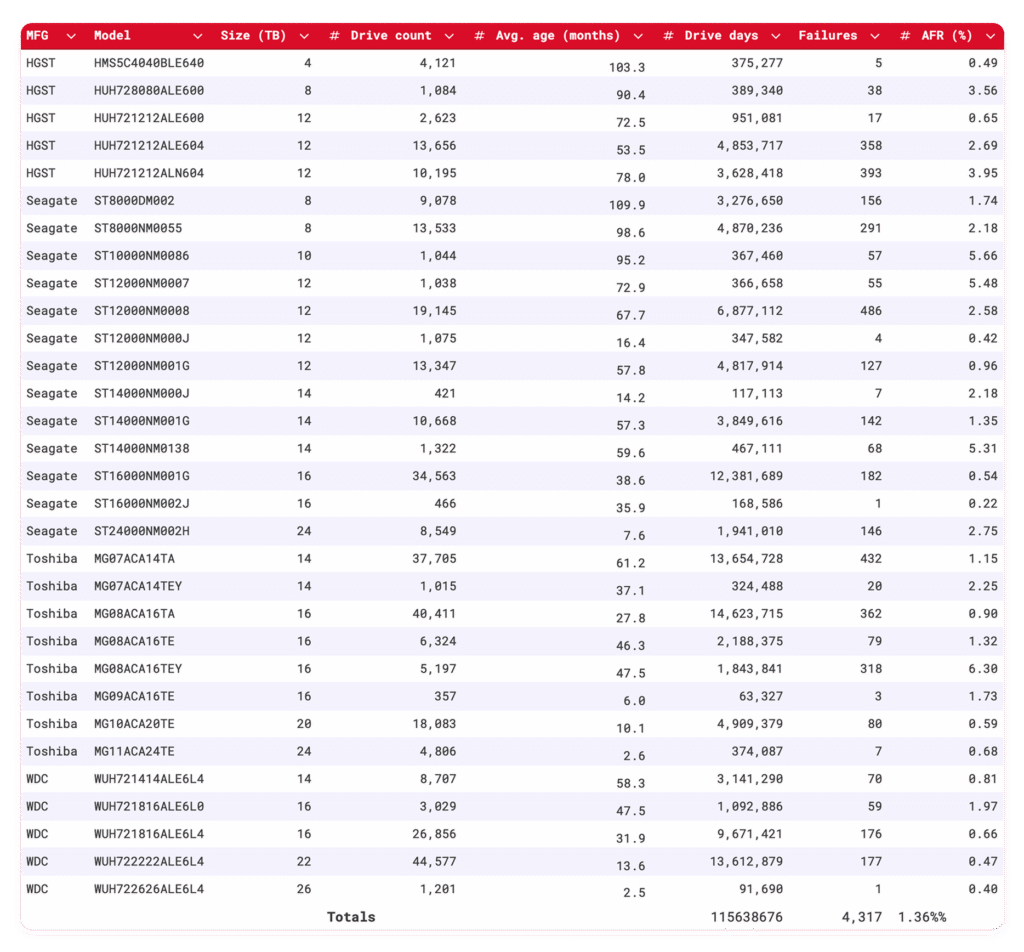

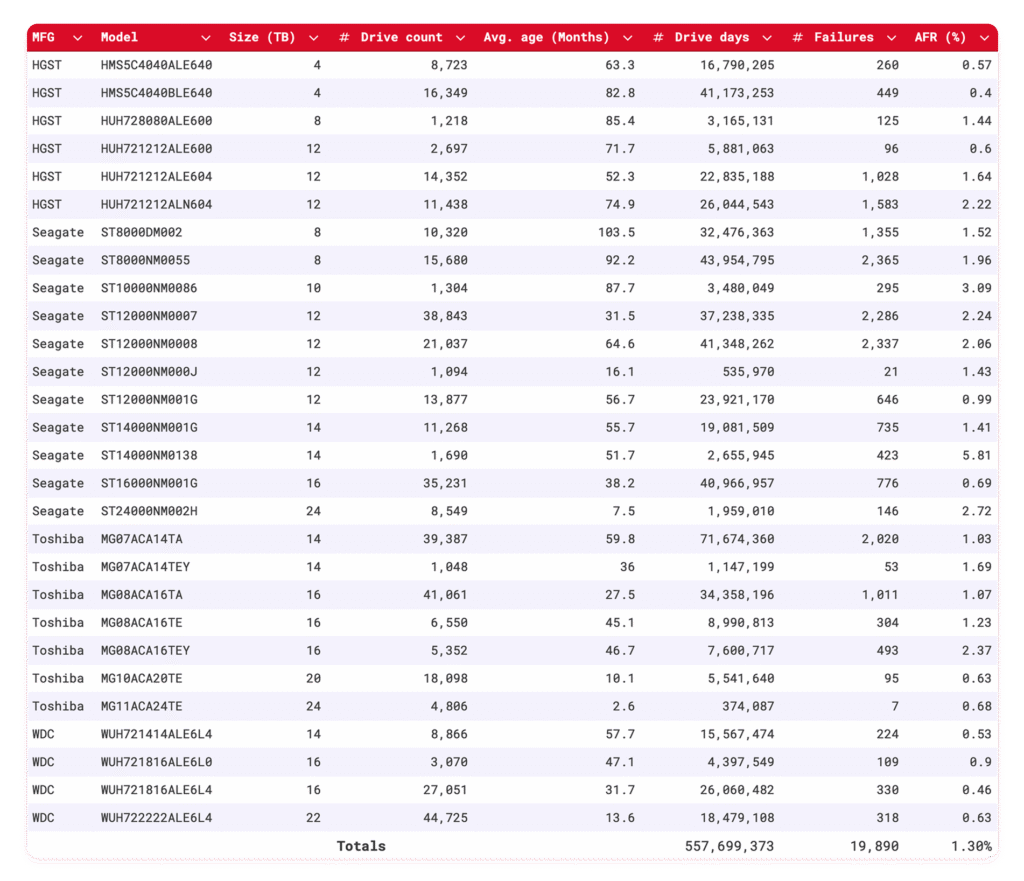

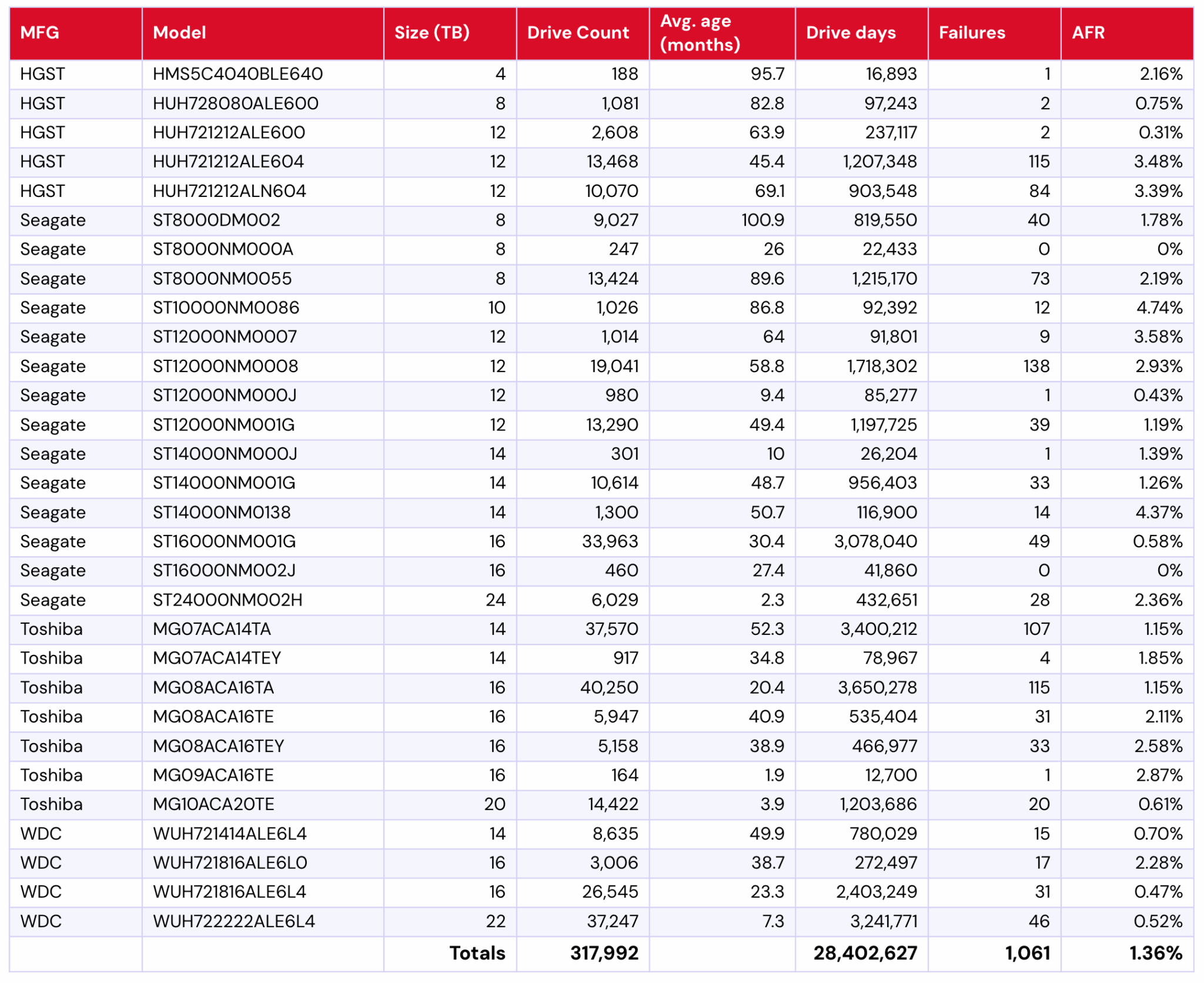

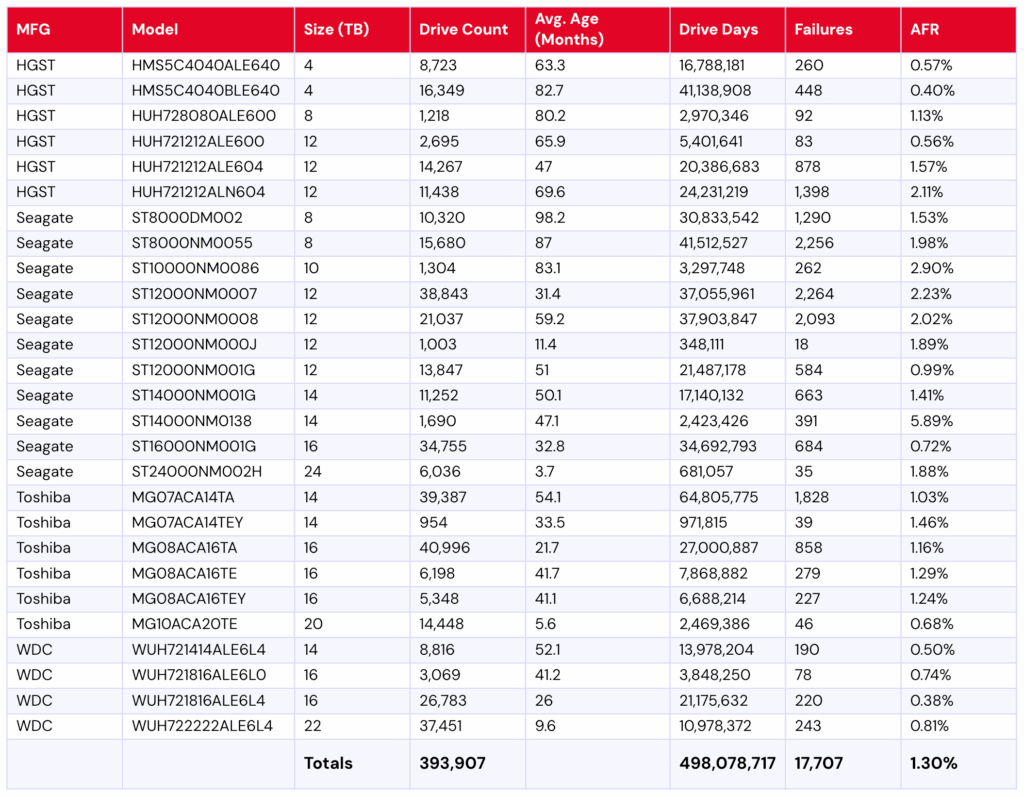

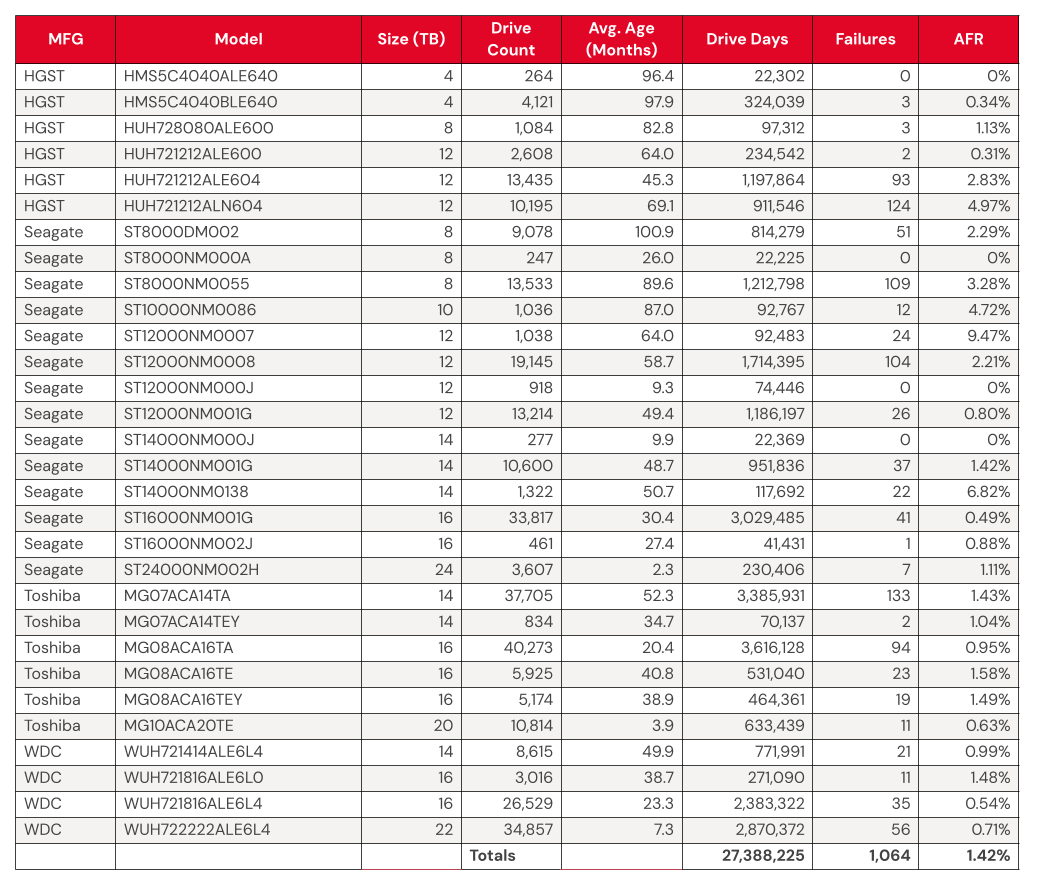

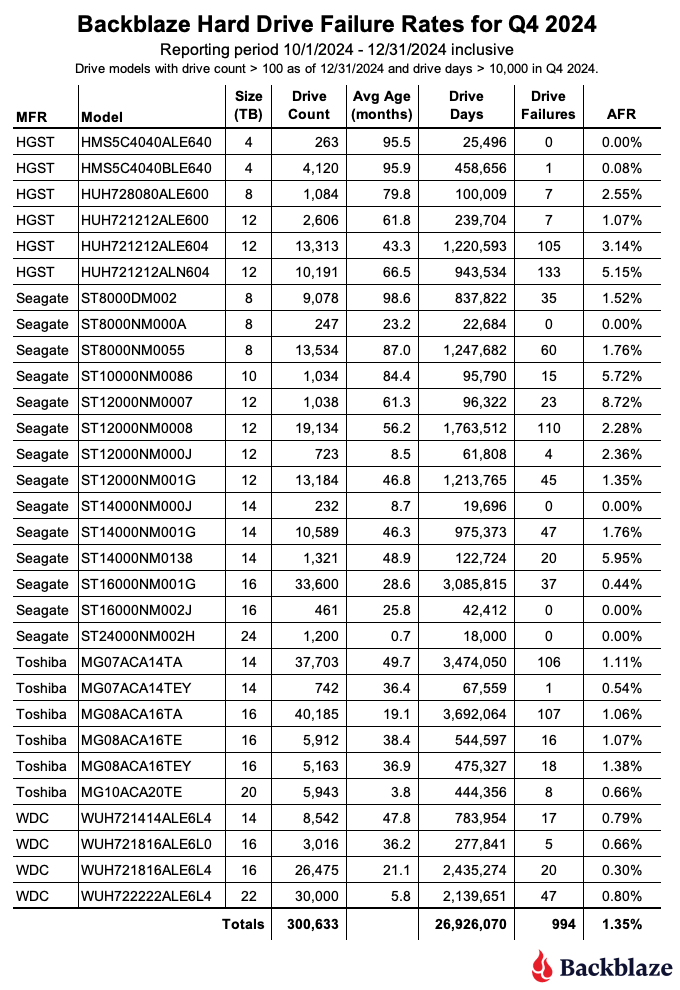

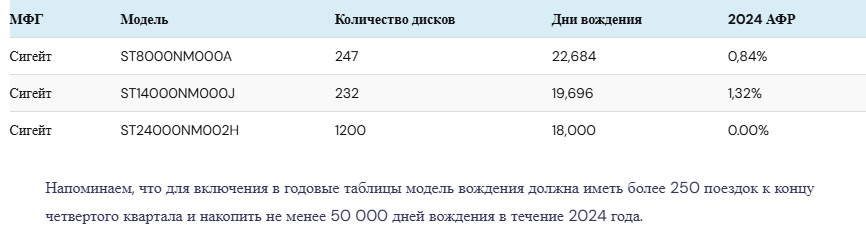

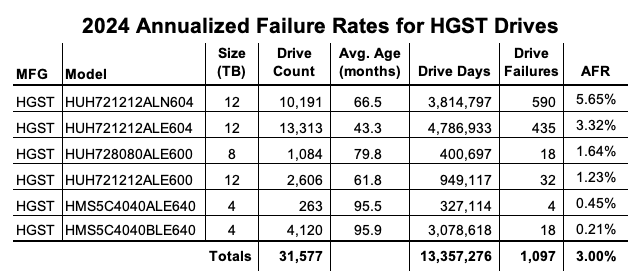

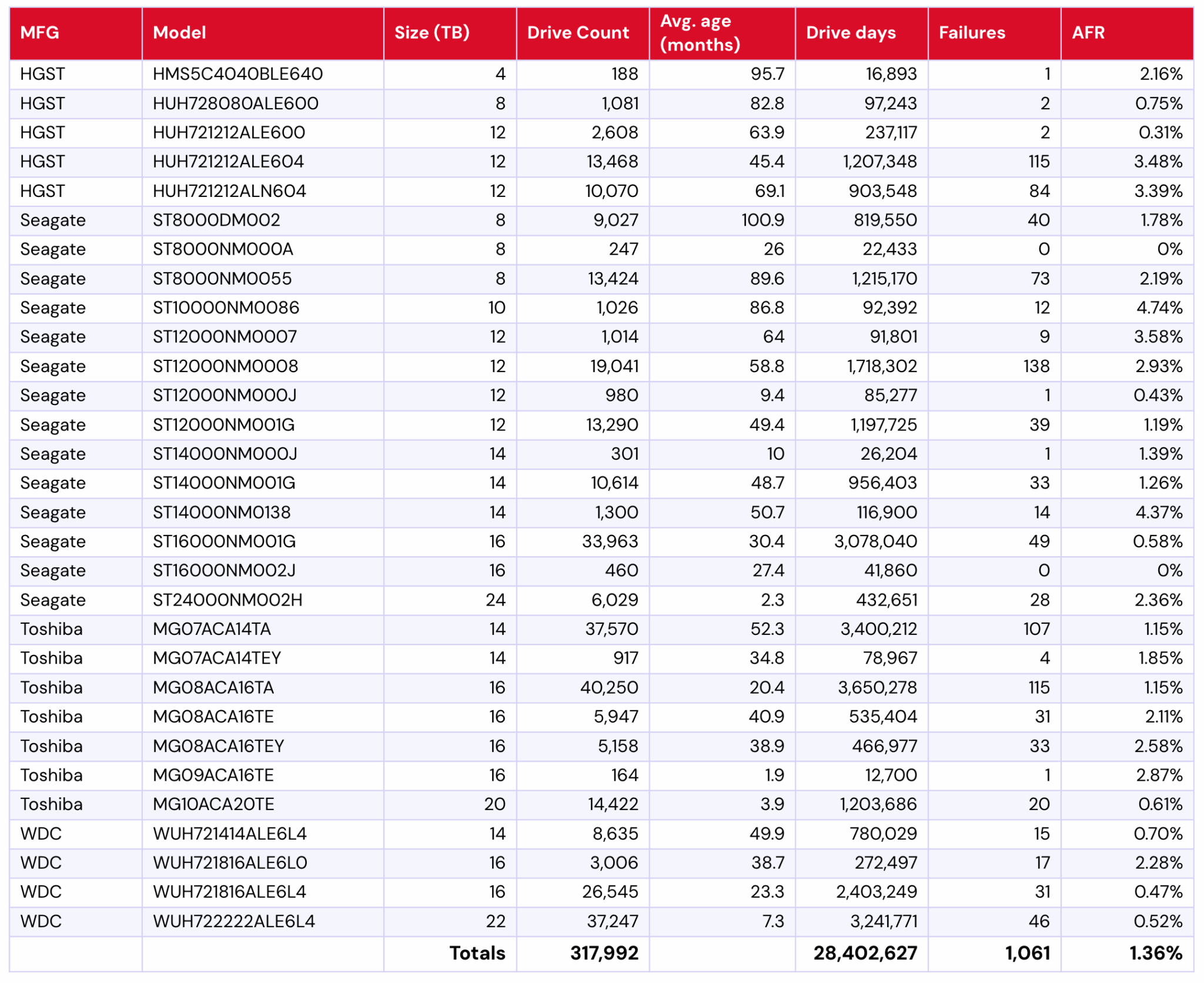

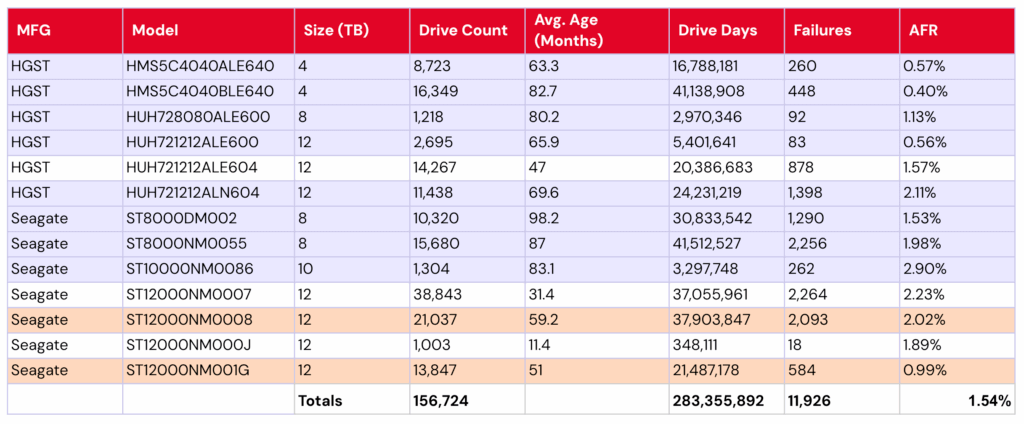

Для тех, кто впервые знаком с отчётом Drive Stats, стоит отметить, что у нас есть определённые критерии, по которым мы отбираем рассматриваемые накопители каждый квартал. Мы обсудим их в следующем разделе, а пока давайте поговорим о данных. В таблице ниже представлены данные о частоте отказов за второй квартал 2025 года.

Показатели отказов жестких дисков Backblaze во втором квартале 2025 года

Отчетный период с 1 апреля 2025 г. по 30 июня 2025 г. включительно.

Модели автомобилей с количеством поездок > 100 по состоянию на 30 июня 2025 г. и количеством дней поездок > 10 000 во II квартале 2025 г.

Заметки и наблюдения

Заметки и наблюдения

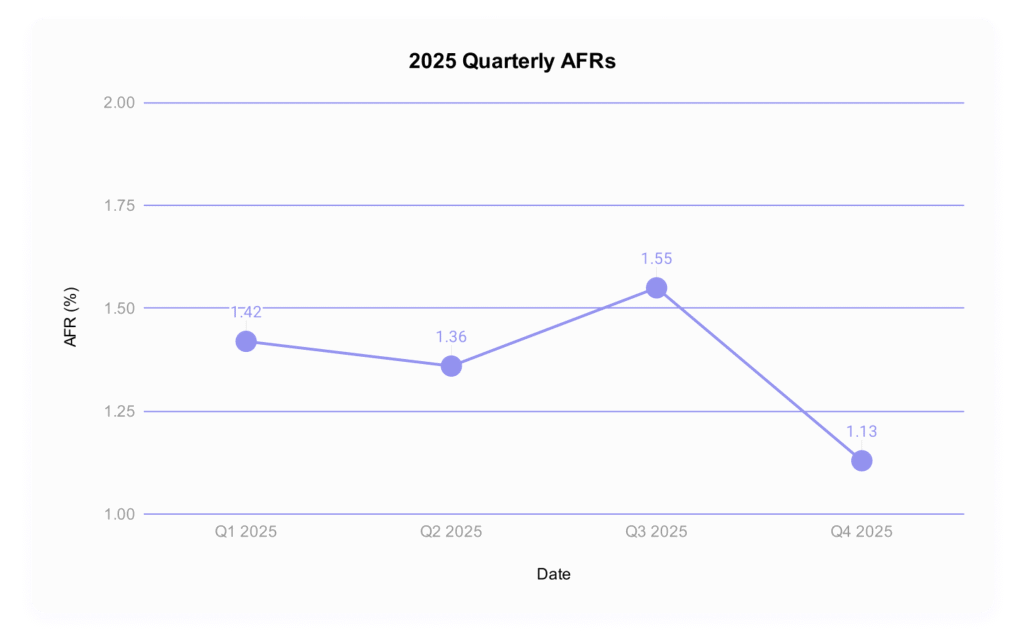

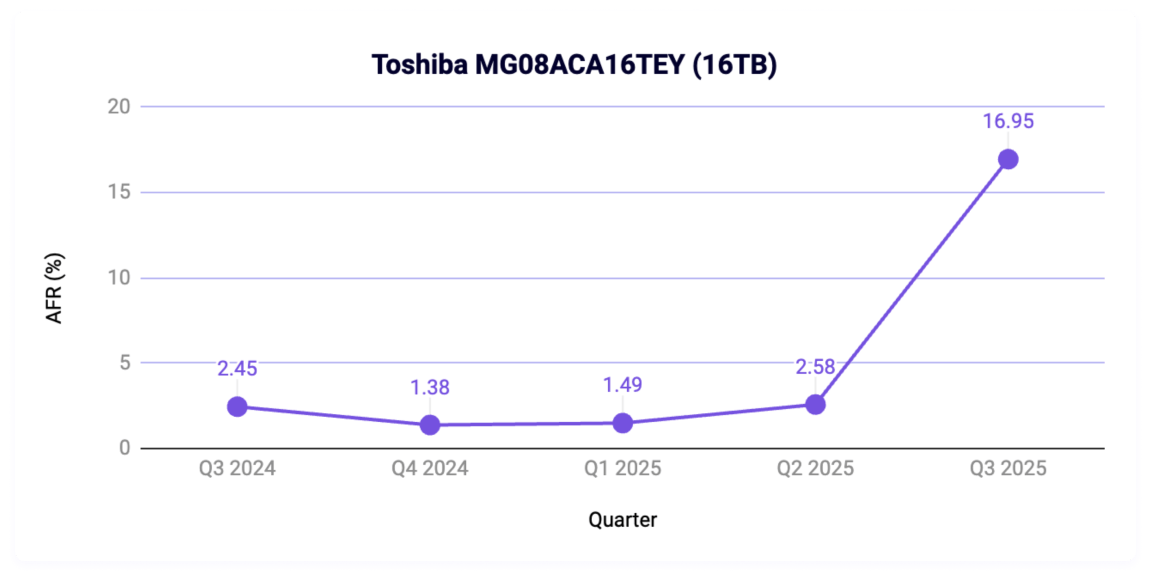

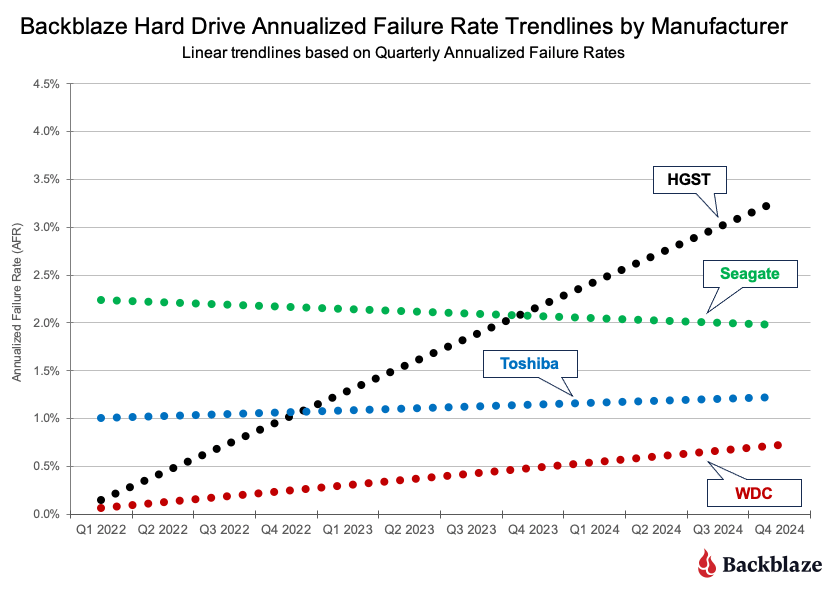

Годовой процент отказов в этом квартале снизился. В прошлом квартале у нас были серьёзные колебания. Цитируем себя (май 2025 года):

Квартальный процент отказов немного выше. Он вырос с 1,35% до 1,42%. Как и в случае с «клубом без отказов», наши показатели годовых отказов (AFR) для более высоких уровней выбросов демонстрируют некоторые типичные признаки:

Сейчас мы снова снизились до 1,36%. Что изменилось?

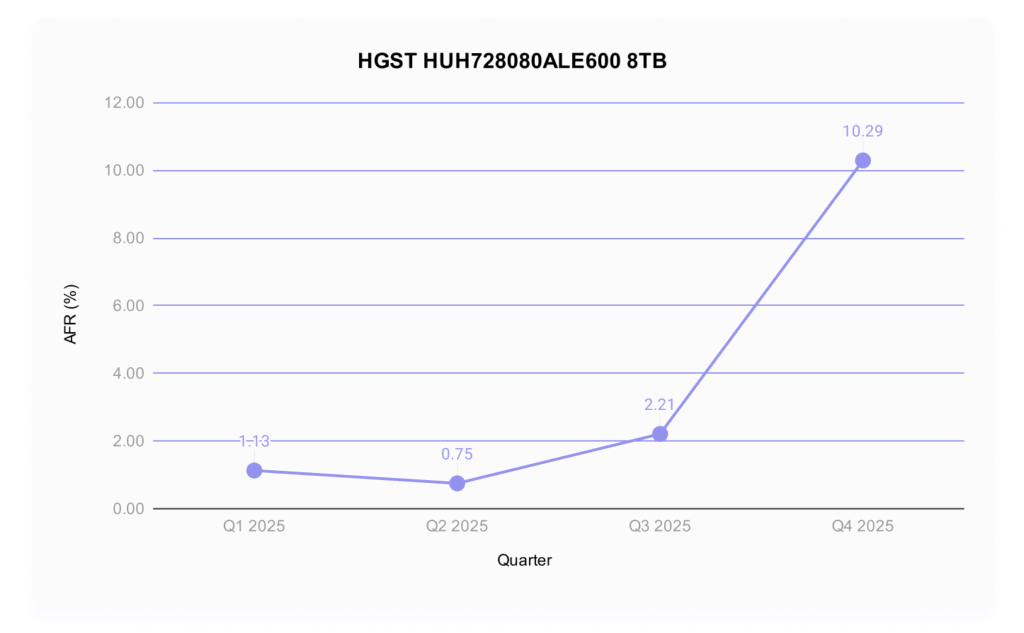

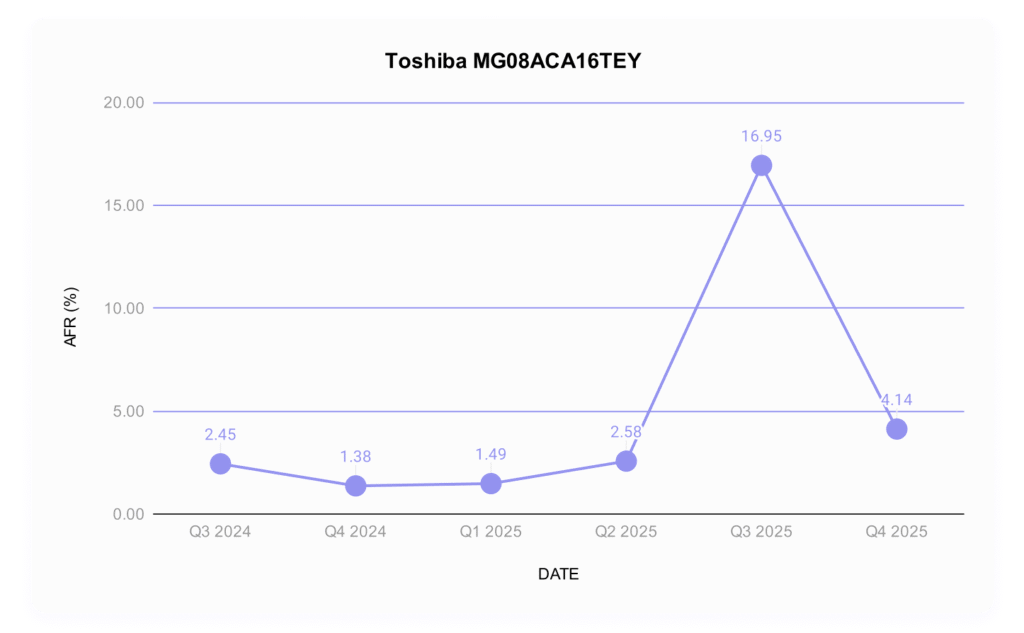

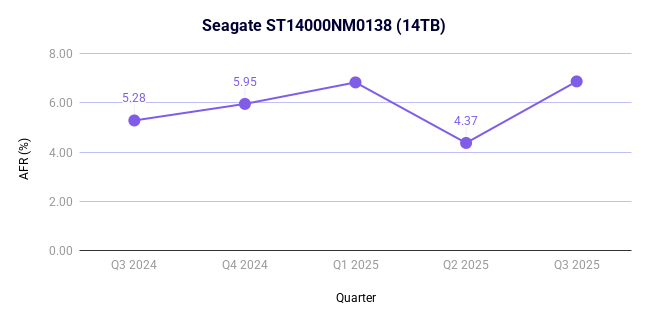

Значительные колебания в частоте отказов в наших дисках премиум-класса: некоторые диски с более высокой частотой отказов значительно снизились. В частности, это касается модели Seagate ST12000NM0007 ёмкостью 12 ТБ, частота отказов которой в прошлом квартале составила целых 9,47%, а в этом квартале снизилась до всего лишь 3,58%. Учитывая, что количество дисков в этой модели остаётся более-менее стабильным (1038 в первом квартале и 1014 во втором), это означает существенное изменение частоты отказов. Обратите внимание, что в четвёртом квартале 2024 года частота отказов этого диска составляла 8,72%, поэтому стоит следить за этим, чтобы понять, является ли это случайностью или новой тенденцией. Другие значительные снижения продаж коснулись модели HGST HUH721212ALN604 емкостью 12 ТБ (Q1: 4,97%; Q2: 3,39%) и модели Seagate ST14000NM0138 емкостью 14 ТБ (Q1: 6,82%, Q2: 4,37%).

Новая модель накопителя уже на подходе: встречайте Toshiba MG09ACA16TE (16 ТБ).

Ноль неудач за квартал: Поднимаясь на вершину, на этот раз у нас всего две неудачи:

- Seagate ST8000NM000A (8 ТБ)

- Seagate ST16000NM002J (16 ТБ)

Этот 8 ТБ Seagate действительно великолепен, учитывая, что это уже третий квартал без сбоев.

Бонус: один отказавший диск: поскольку у нас всего два отказавших диска (и это выглядит немного уныло, не правда ли?), стоит также упомянуть диски, у которых в этом квартале вышел из строя только один диск:

- HGST HMS5C4040BLE640 (4 ТБ)

- Seagate ST12000NM000J (12 ТБ)

- Seagate ST14000NM000J (14 ТБ)

- Toshiba MG09ACA16TE (16 ТБ)

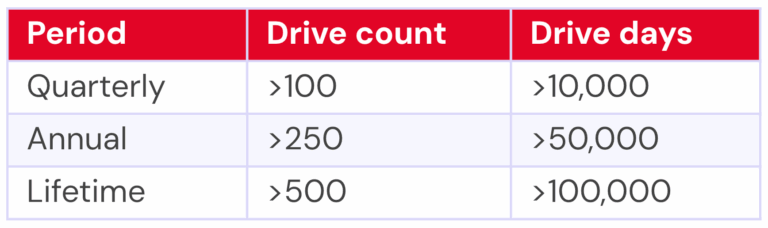

Критерии модели привода

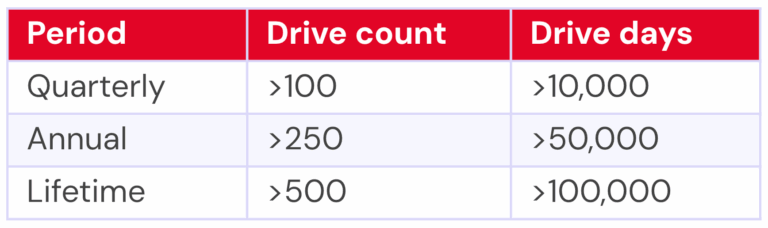

Ранее мы отмечали, что при составлении приведенной выше таблицы, охватывающей второй квартал 2025 года, мы исключили из рассмотрения 495 накопителей. Существует две основные причины, по которым мы не рассматривали эти модели накопителей.

Тестирование. Это диски определённой модели, которые мы отслеживаем и собираем данные Drive Stats, но в настоящее время они не считаются производственными. Например, диски, проходящие сертификационные испытания для определения их производительности для нашей среды, не учитываются в расчётах Drive Stats.

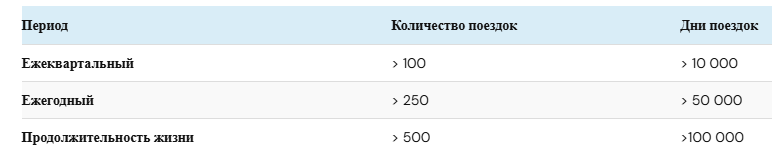

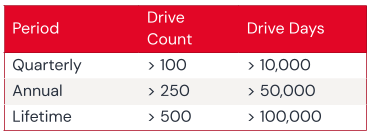

Недостаточно данных. При расчете среднегодовой интенсивности отказов для модели привода за заданный период времени (ежеквартально, ежегодно или за весь срок службы) мы хотим убедиться, что у нас достаточно данных для надежного расчета. Поэтому мы определили критерии включения модели привода в таблицы и диаграммы за указанный период. Модели, не соответствующие этим критериям, не включаются в таблицы и диаграммы за рассматриваемый период.

Независимо от того, включена ли конкретная модель привода в диаграммы и таблицы, все данные по всем используемым нами приводам включены в наш набор данных Drive Stats, который вы можете загрузить, посетив страницу Drive Stats.

Как и в случае с квартальными результатами за второй квартал, мы применим эти критерии к диаграммам за весь период, представленным в этом отчете.

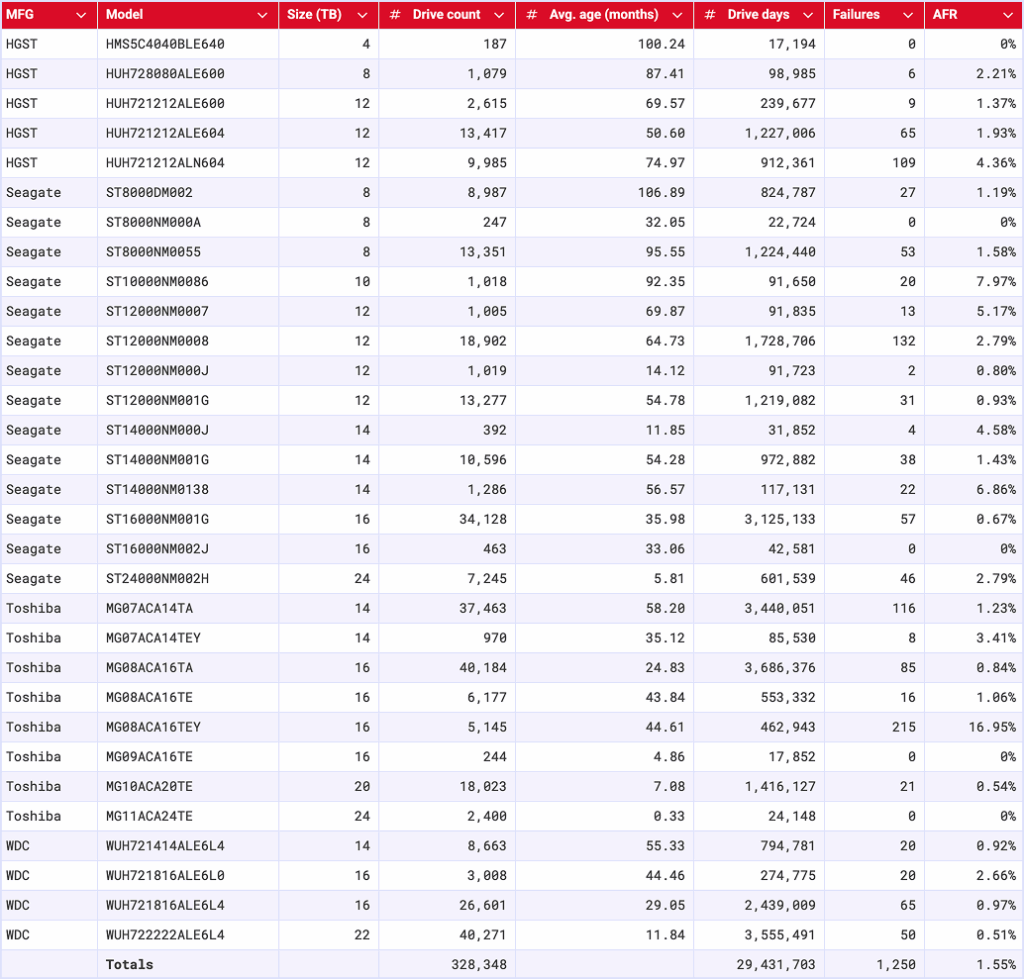

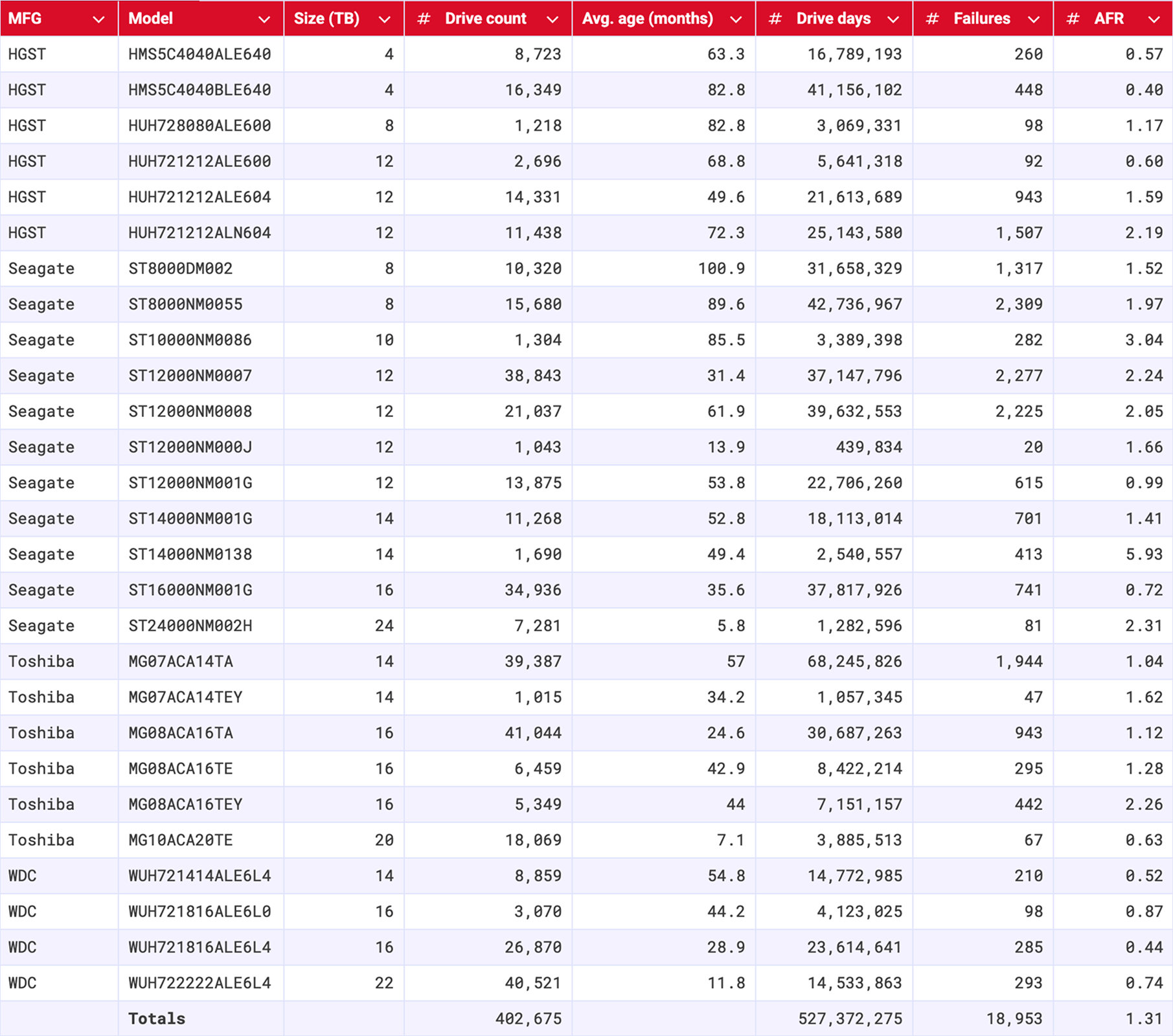

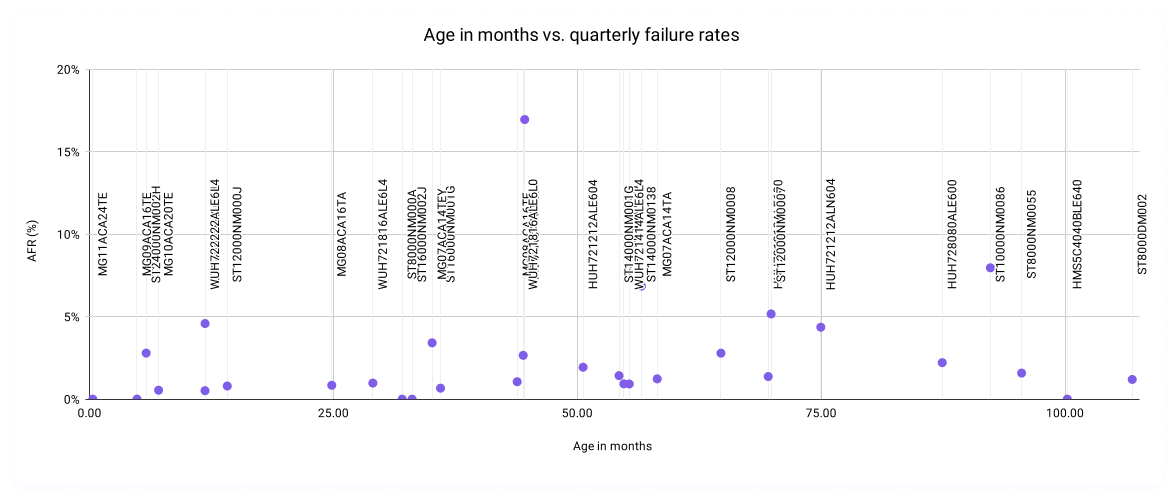

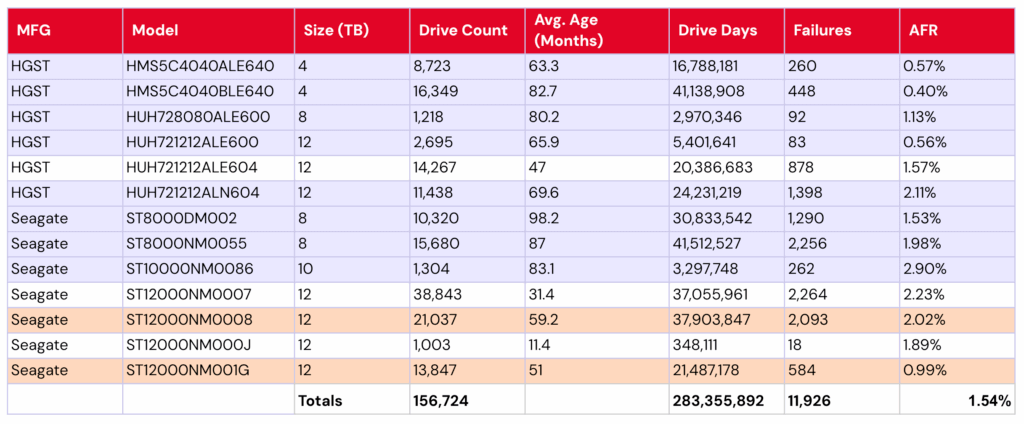

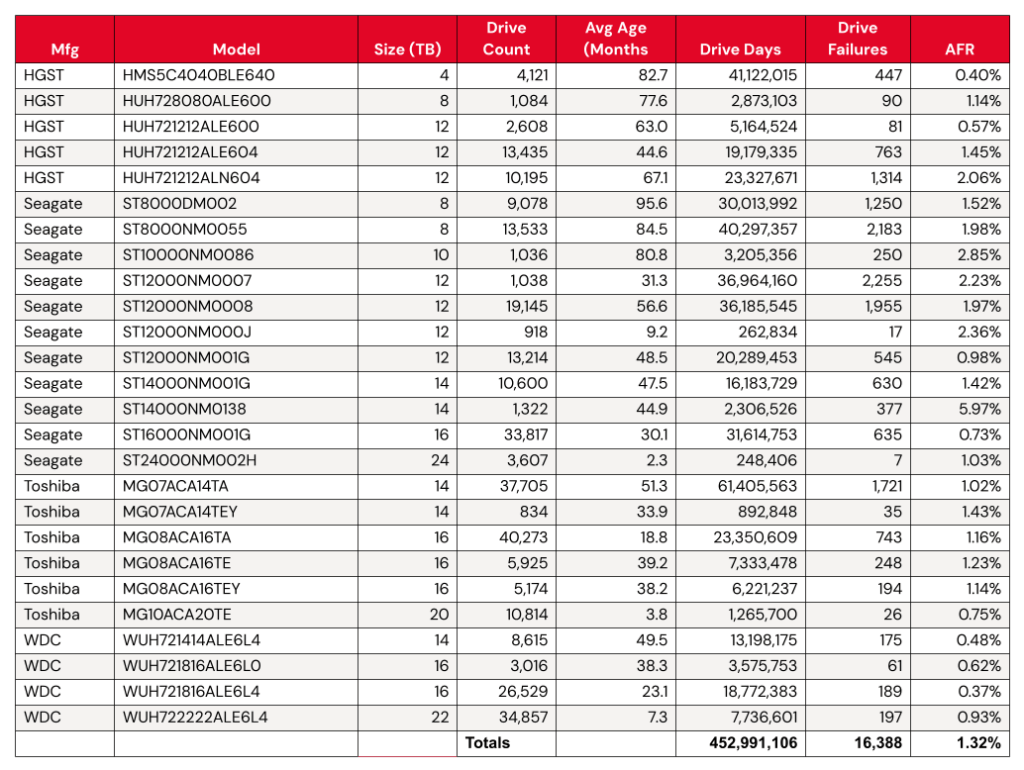

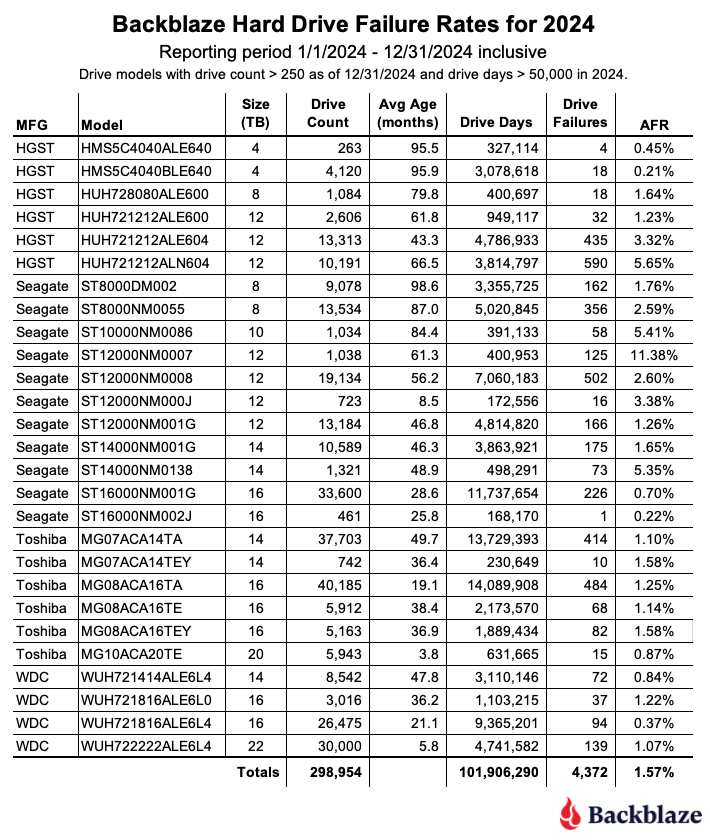

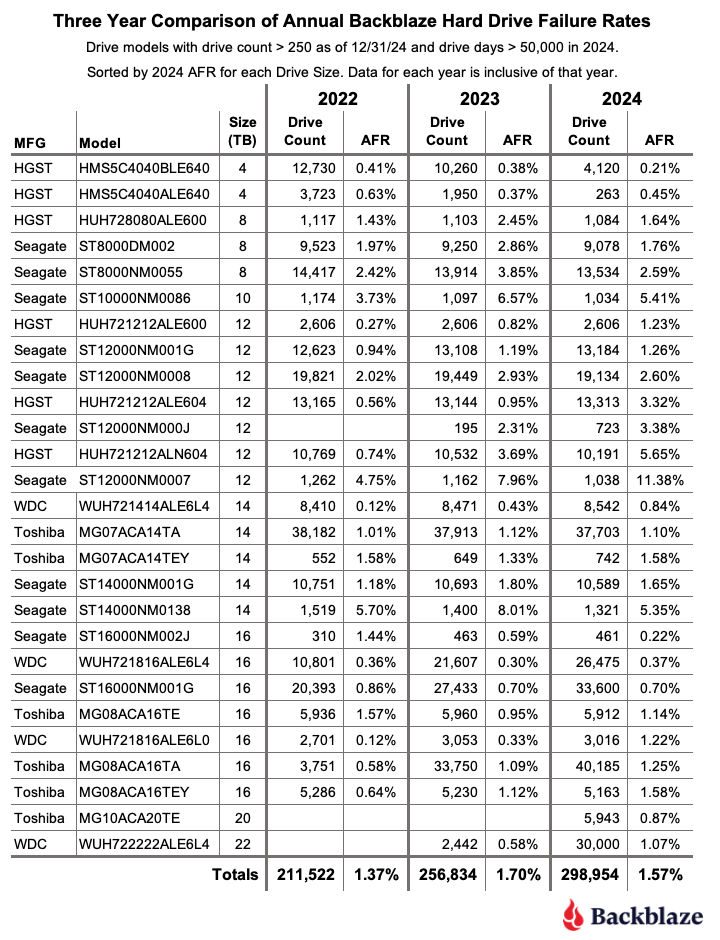

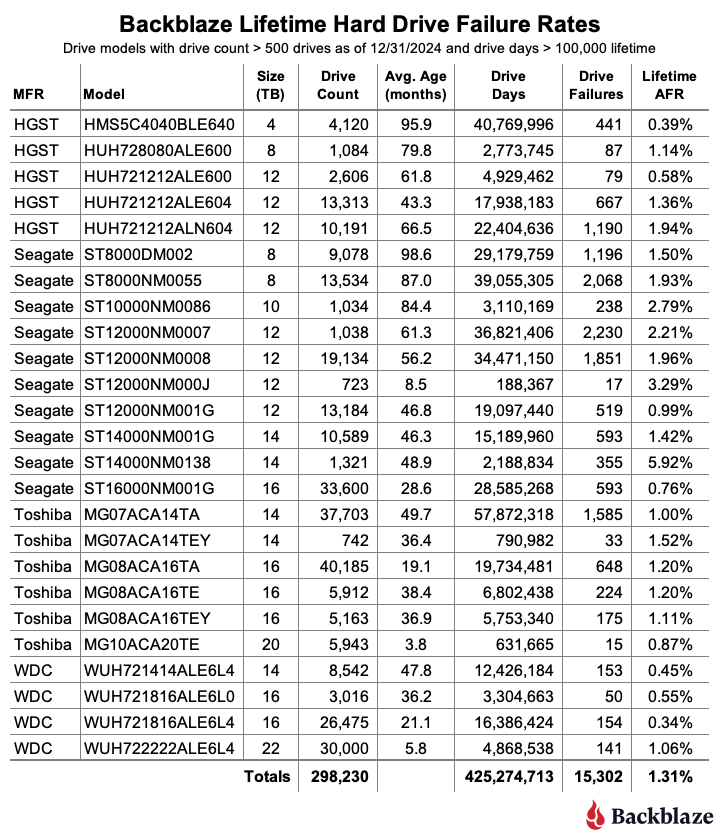

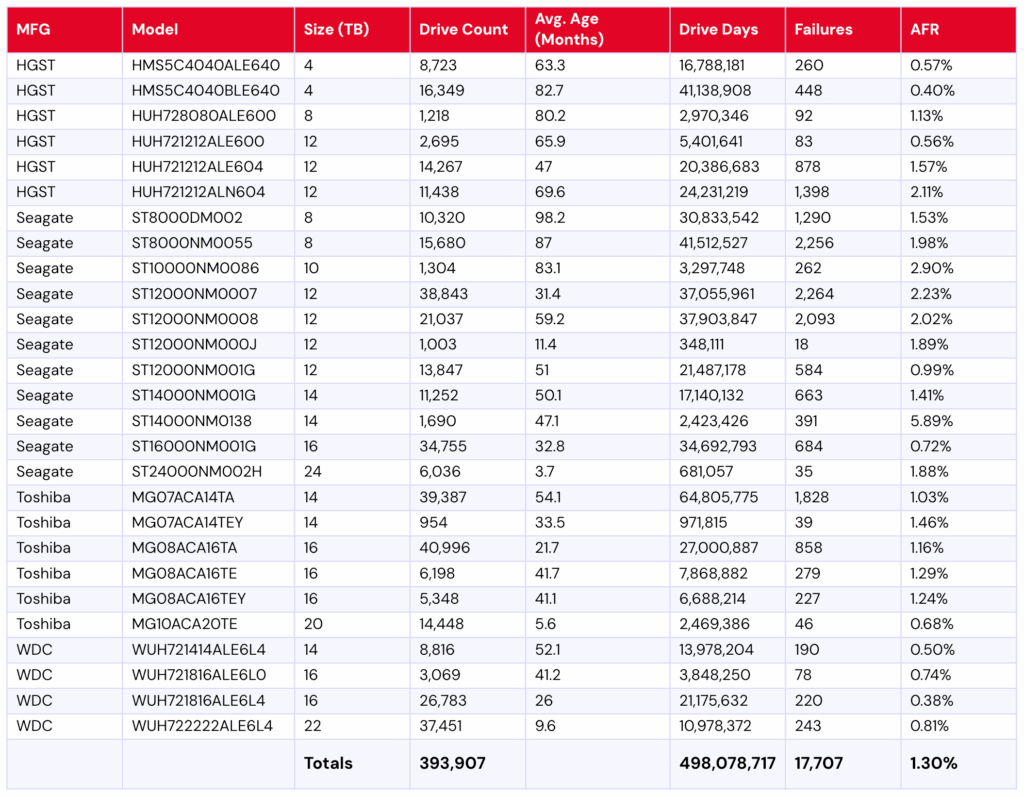

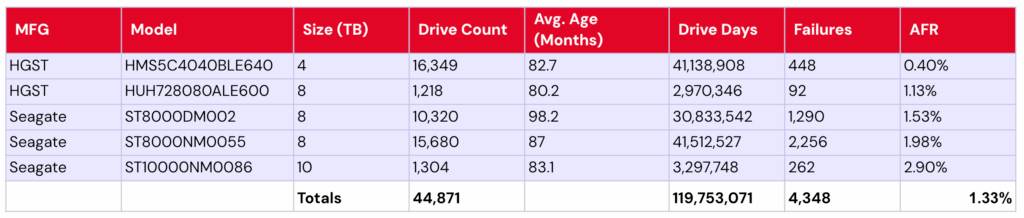

Показатели отказов жесткого диска за весь срок службы

Для рассмотрения на предмет оценки жизненного цикла модели накопителя требовалось наличие 500 или более накопителей по состоянию на конец второго квартала 2025 года и более 100 000 дней эксплуатации за весь срок службы. После исключения моделей накопителей, не соответствующих критериям оценки жизненного цикла, для анализа осталось 393 907 накопителей, сгруппированных в 27 моделей, как показано в таблице ниже.

Показатели отказов жестких дисков Backblaze во втором квартале 2025 года

Отчетный период заканчивается 30 июня 2025 г.

Модели приводов > 500 приводов и > 100 000 дней эксплуатации приводов за весь срок службы

Заметки и наблюдения

Заметки и наблюдения

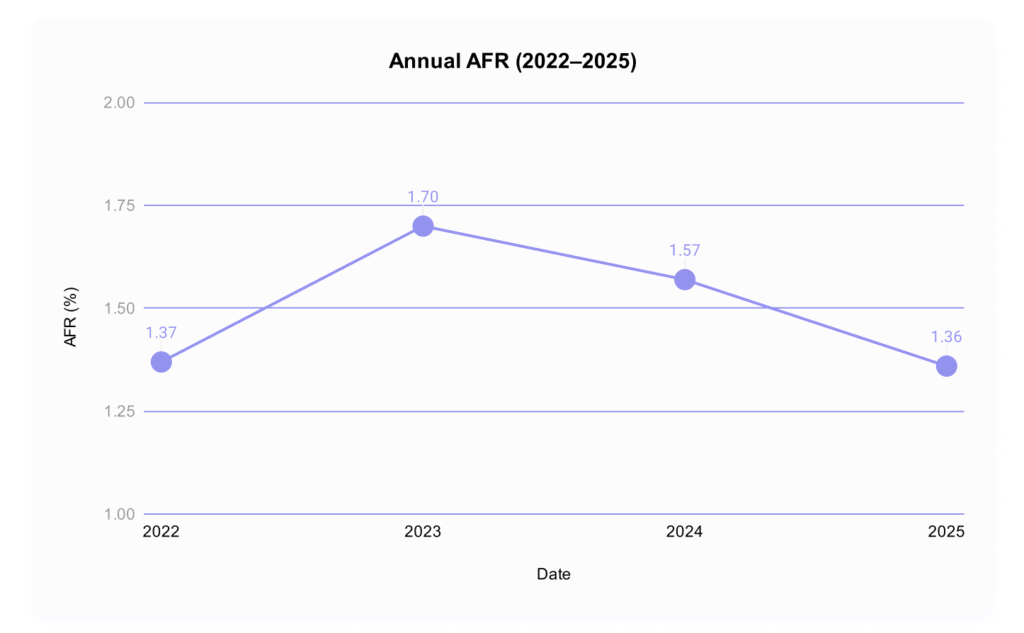

Опять же, показатель AFR за весь срок службы остался стабильным, снизившись с 1,31% в первом квартале 2025 года до 1,30%.

Теперь вы меня видите: в таблице за этот квартал также есть интересный момент, связанный с нашими исключениями дисков, поскольку модель HGST HMS5C4040ALE640 ёмкостью 4 ТБ скоро выйдет из обращения. Она соответствует нашим критериям пожизненного срока службы, поэтому включена во вторую таблицу, но не попала в квартальную таблицу, поскольку к концу квартала у неё было слишком мало работающих дисков. Обычно наблюдается обратная ситуация: модели дисков отображаются в квартальных требованиях, но не в сроке службы. В этом квартале этому стандарту соответствуют четыре модели (модели Seagate ST8000NM000A, ST14000NM000J, ST16000NM002J и Toshiba MG09ACA16TE).

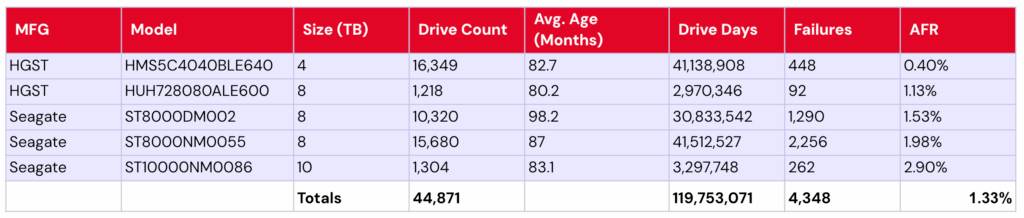

Диски меньшего объёма устаревают: возможно, это неудивительная тенденция — диски Backblaze меньшего объёма устаревают. Всего у нас 13 моделей дисков ёмкостью 12 ТБ и меньше, с общим уровнем отказов 1,54%. См. таблицу ниже:

Диски Backblaze емкостью ≤12 ТБ

Из этих моделей восемь — пятилетние и старше (отмечены фиолетовым цветом). Ещё две модели — четырёхлетние и старше (это ваш оранжевый цвет). Если брать только эти 10 моделей — накопителей, достигших своего «золотого века», — то общая годовая норма годовых составляет 1,42%.

Примечательно, что этот показатель AFR обусловлен некоторыми хорошо работающими моделями с низким уровнем отказов, включая обе модели Seagate емкостью 4 ТБ (0,57% и 0,40%), модель HGST HUH721212ALE600 емкостью 12 ТБ (0,56%) и модель Seagate ST12000NM001G емкостью 12 ТБ (0,99%).

Тем не менее, пожалуй, ещё более впечатляет тот факт, что, когда мы говорим «восемь из них — пятилетние и старше», из этих восьми моделей приводов пять — шестилетние и старше. Их общая годовая частота кадров (AFR) составляет 1,33%.

Это поднимает извечный вопрос: возраст — это всего лишь цифра? Или мы просто наблюдаем несколько исключительных моделей накопителей? В любом случае, это интересная группа накопителей, за которой стоит следить, поскольку она составляет 156 724 из наших 393 907 (~40%) общего пула накопителей за всё время существования.

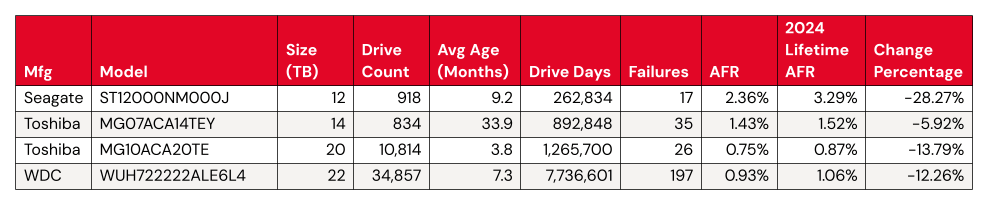

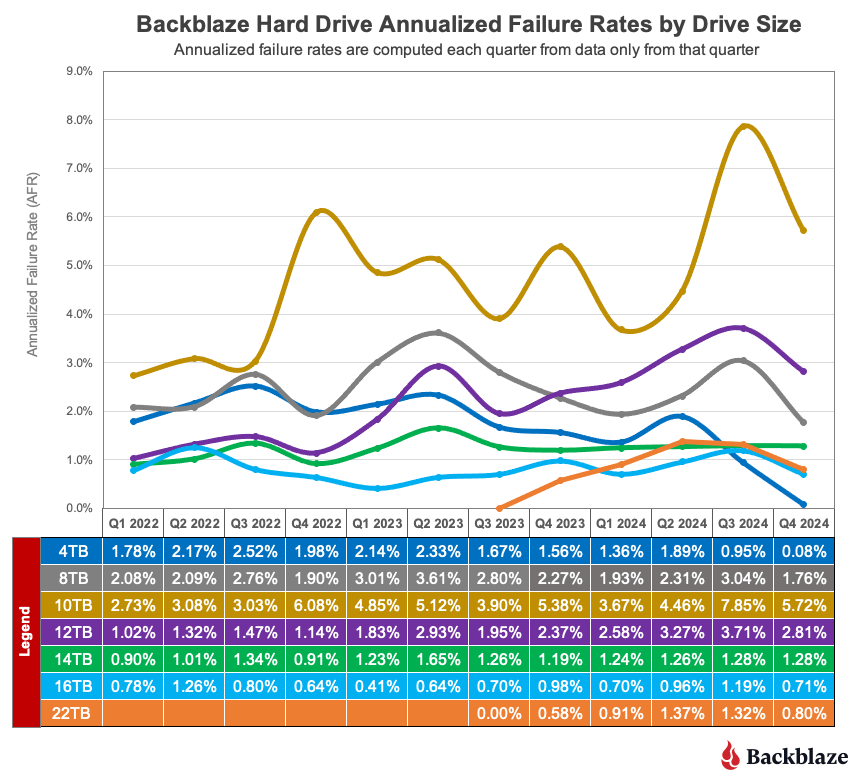

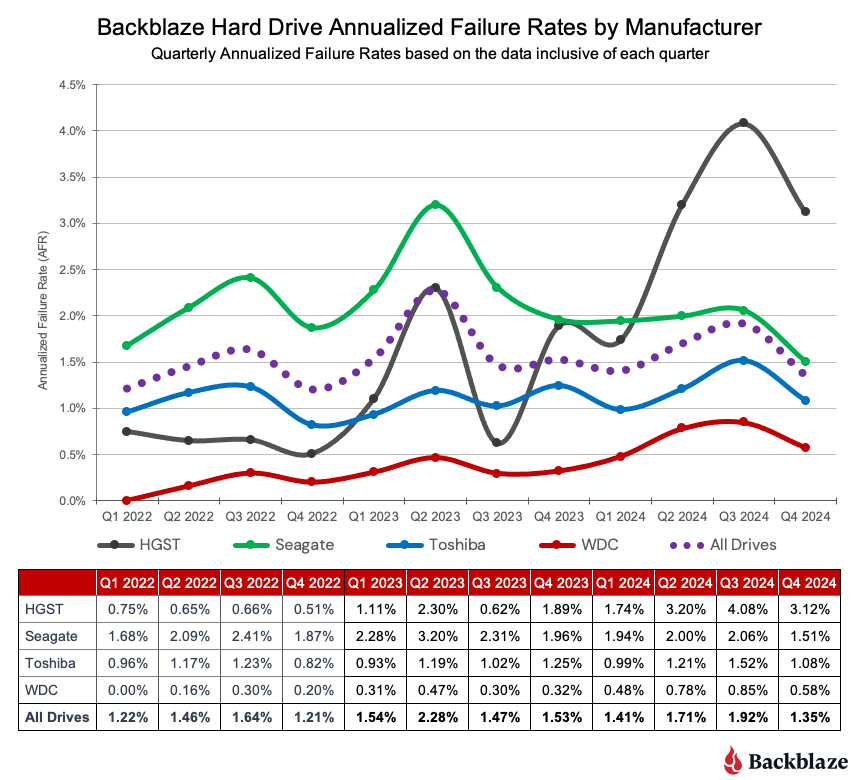

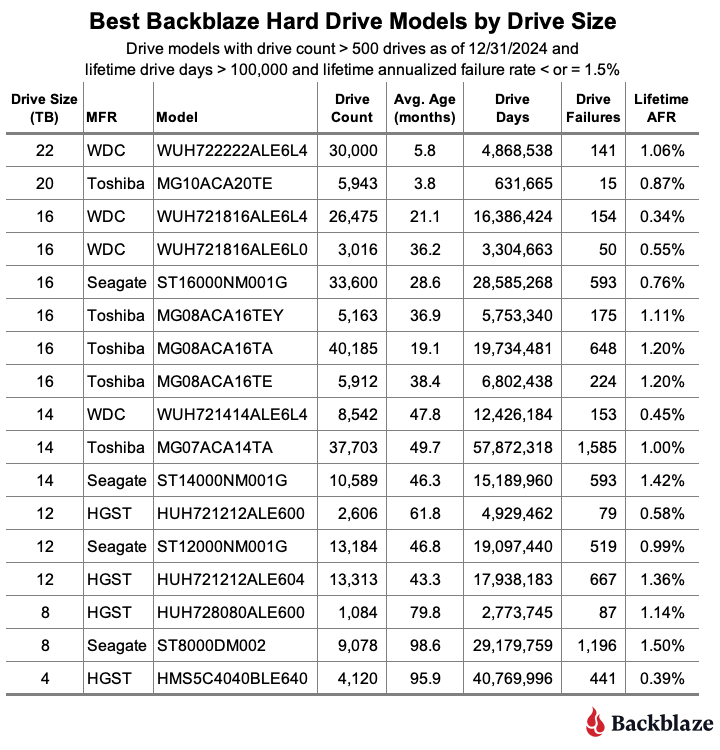

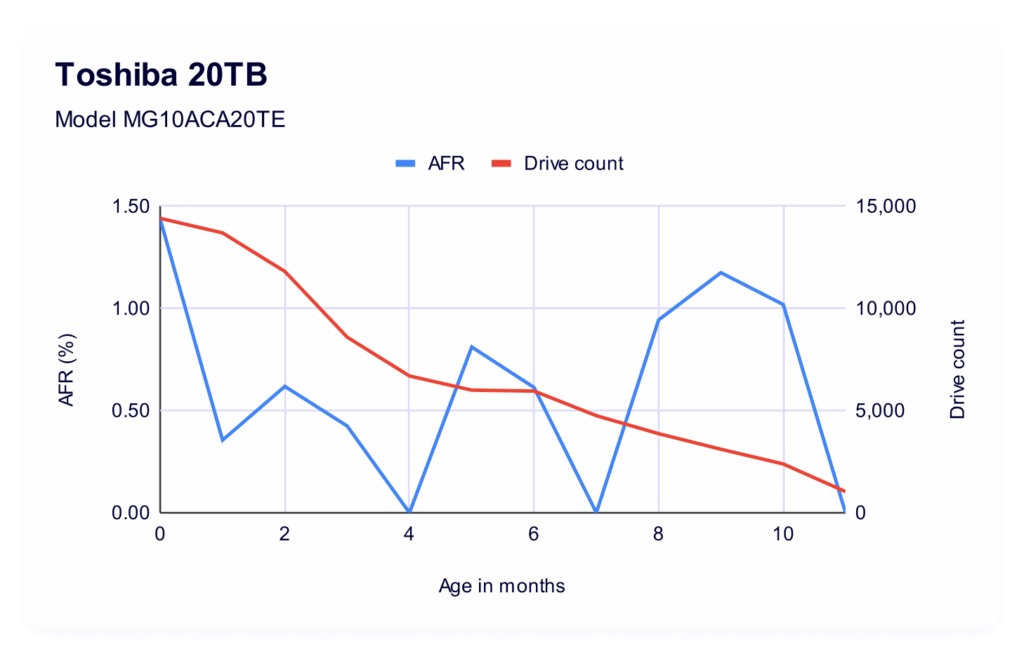

Клуб 20 ТБ+

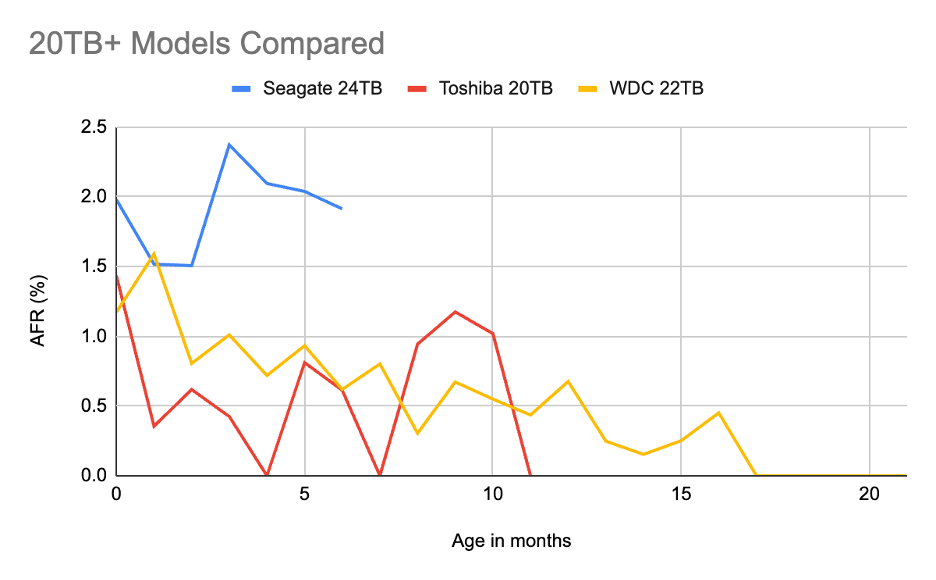

В последних нескольких отчётах мы бегло рассматривали диски ёмкостью 20 ТБ и более, но сейчас самое время изучить их более подробно. Сейчас наша группа дисков ёмкостью 20 ТБ и более, соответствующих критериям жизненного цикла, состоит из трёх: Toshiba MG10ACA20TE ёмкостью 20 ТБ, WDC ёмкостью 22 ТБ, WUH722222ALE6L4 ёмкостью 22 ТБ и Seagate ST24000NM002H ёмкостью 24 ТБ. Это довольно точно, что мы получаем по одному диску от каждого производителя, что позволяет проводить своего рода прямое сравнение. Хотя, конечно, учитывая вариабельность, наблюдаемую в отдельных дисках одного производителя, мы не будем придавать этому слишком большого значения.

Давайте рассмотрим каждый из них.

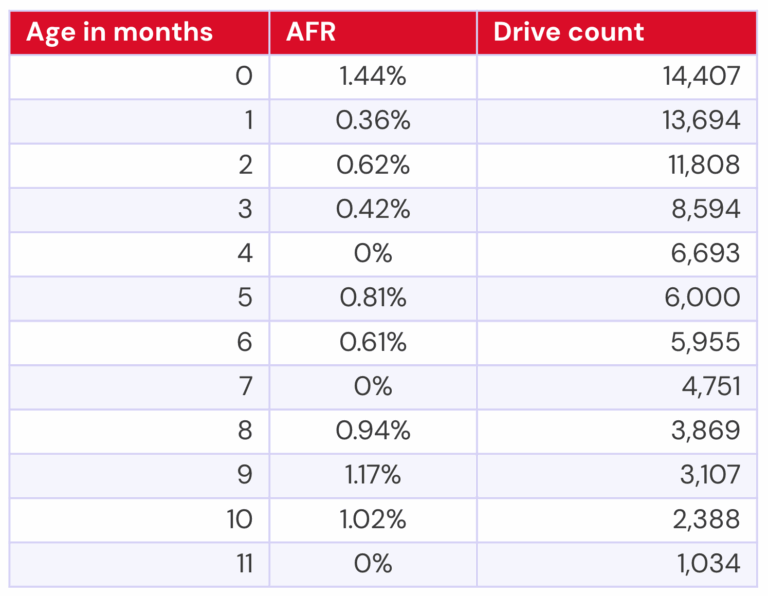

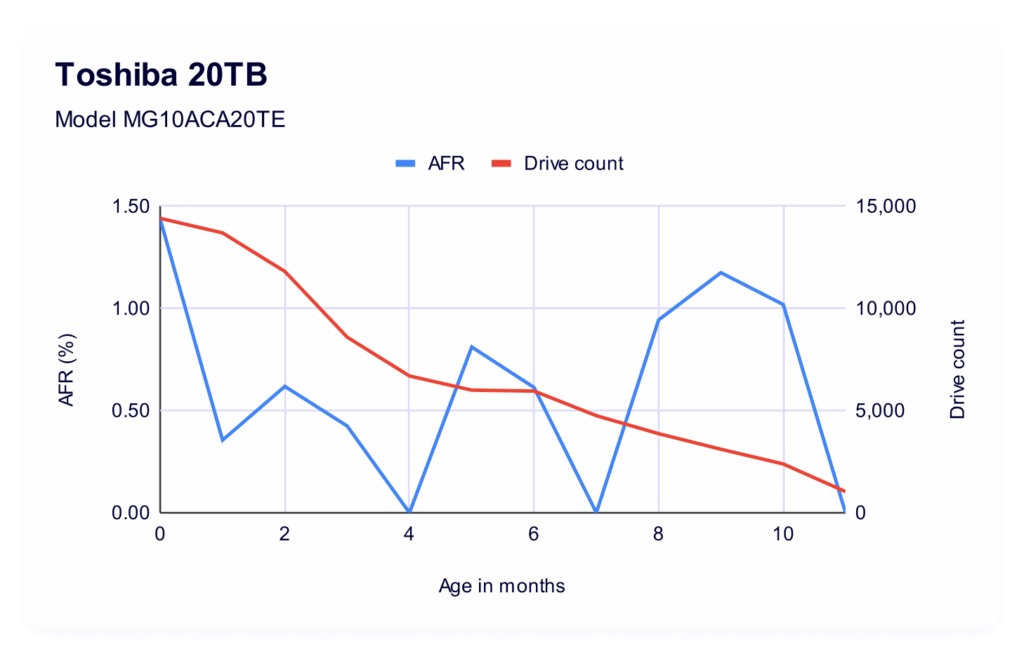

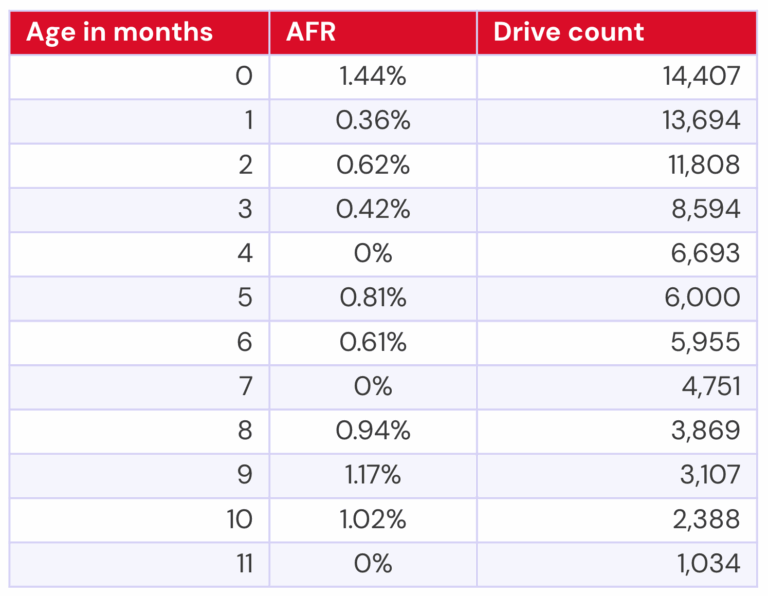

20 ТБ Toshiba MG10ACA20TE

На самом деле, Toshiba находится в нашем парке накопителей уже 22 месяца, но ещё чуть меньше года назад их было всего два. Поэтому для большей значимости мы исключим значительно меньшее количество накопителей — к счастью, у каждой модели есть своего рода естественный предел, когда номера накопителей переходят от однозначных значений к сотням.

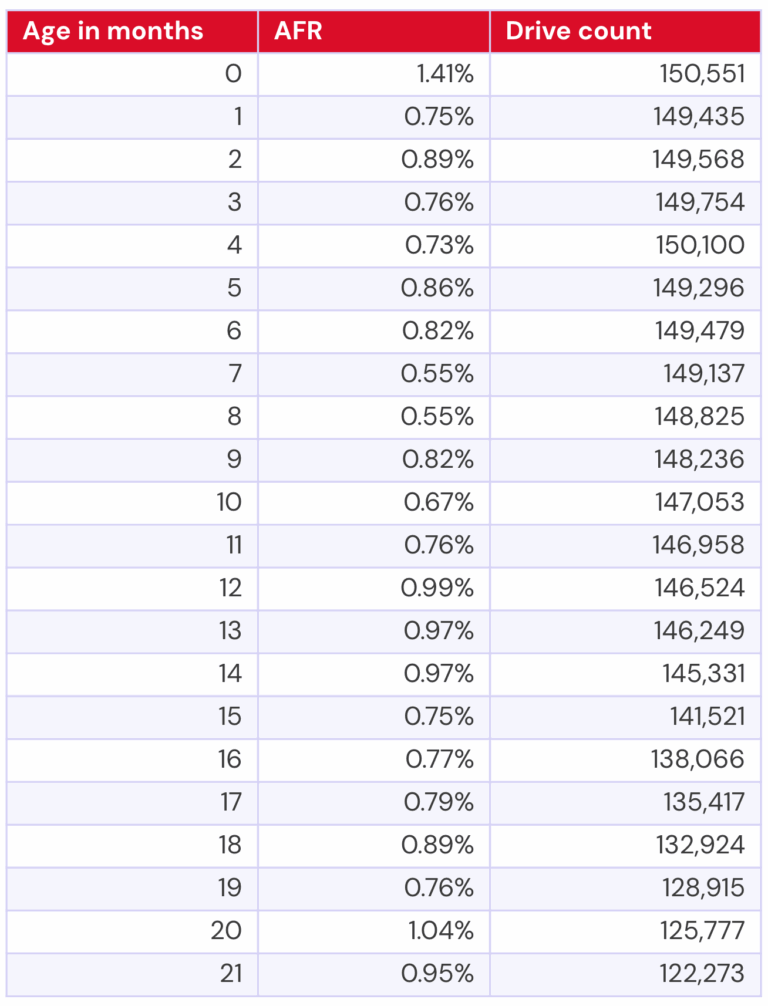

Для Toshiba это дает нам следующие данные:

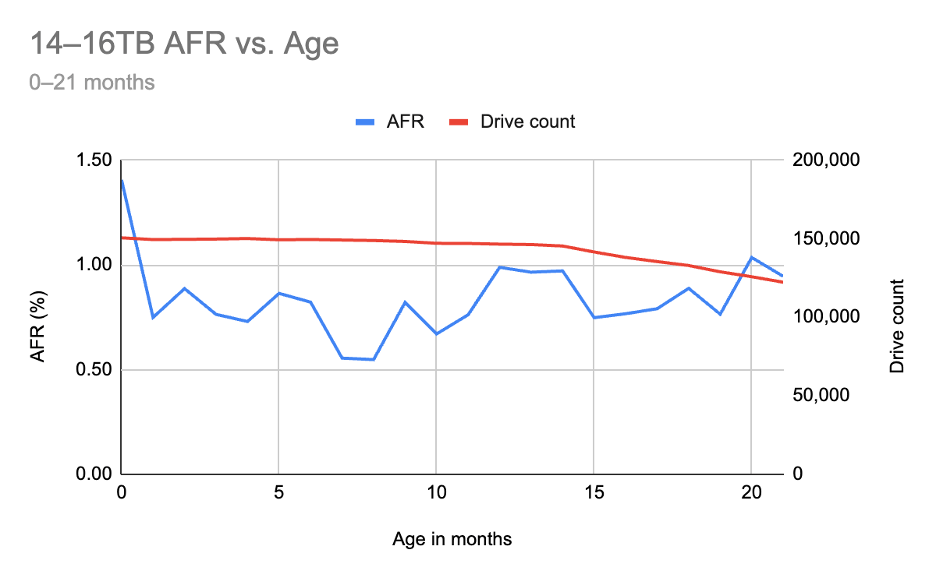

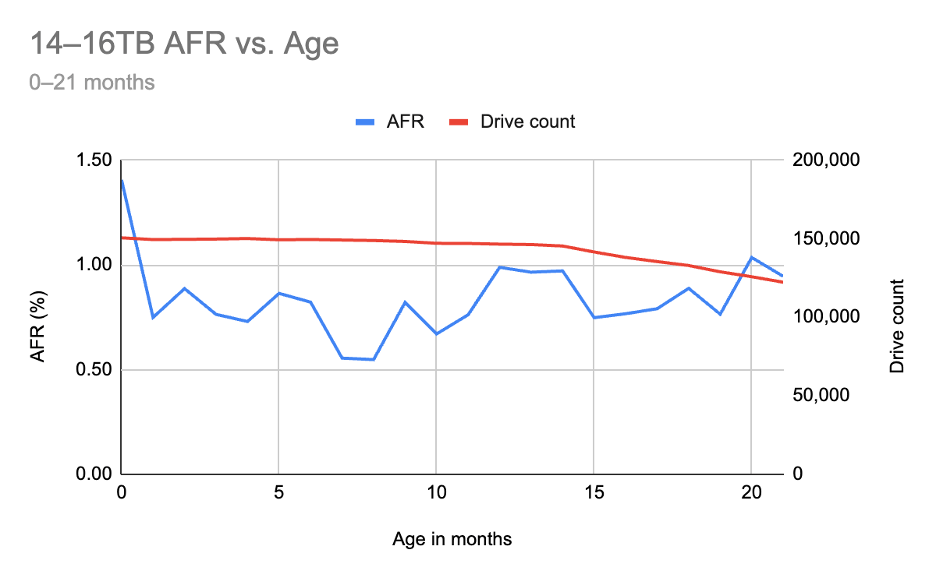

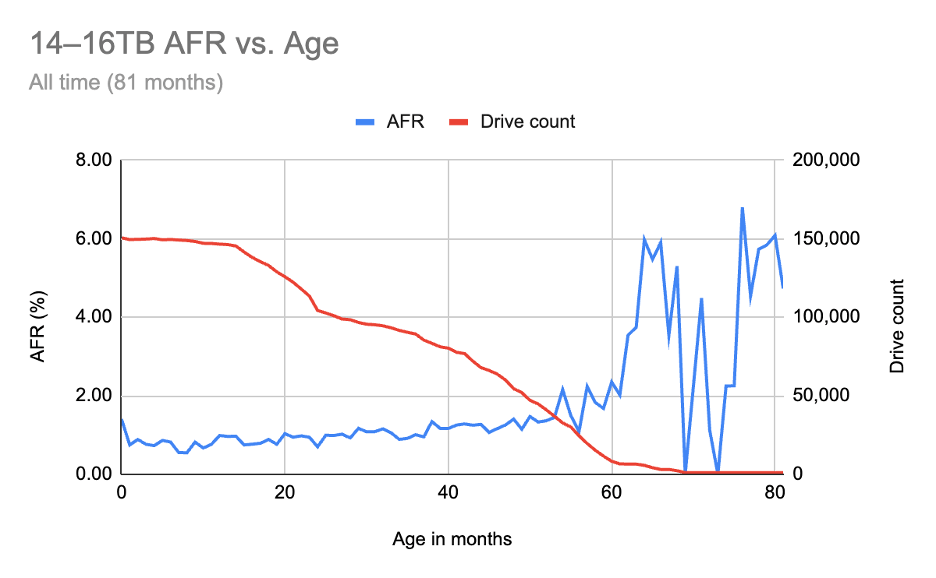

Преобразовав это в график, мы получаем следующее:

На этом графике синяя линия представляет собой годовую частоту (AFR), а красная — количество дисков. С количеством дисков может быть немного сложнее, поскольку ось X — это возраст, и мы начинаем с возраста = 0, что означает, что количество дисков (с нашей точки зрения) уменьшается. То есть, по мере старения дисков их становится меньше по количеству — у вас есть первоначальная когорта покупателей, затем диски добавляются со временем. Можно интерпретировать это как первую точку данных, представляющую диски возрастом от 0 до 1 месяца, следующую точку данных — от 1 до 2 месяцев и т. д.

Мы сделали это, чтобы иметь возможность напрямую сравнивать частоту отказов накопителей в зависимости от их возраста. Те, кто знаком с нашим анализом U-образной кривой, могут узнать нашу методологию: мы просто концентрируемся на конкретных накопителях и их ёмкости.

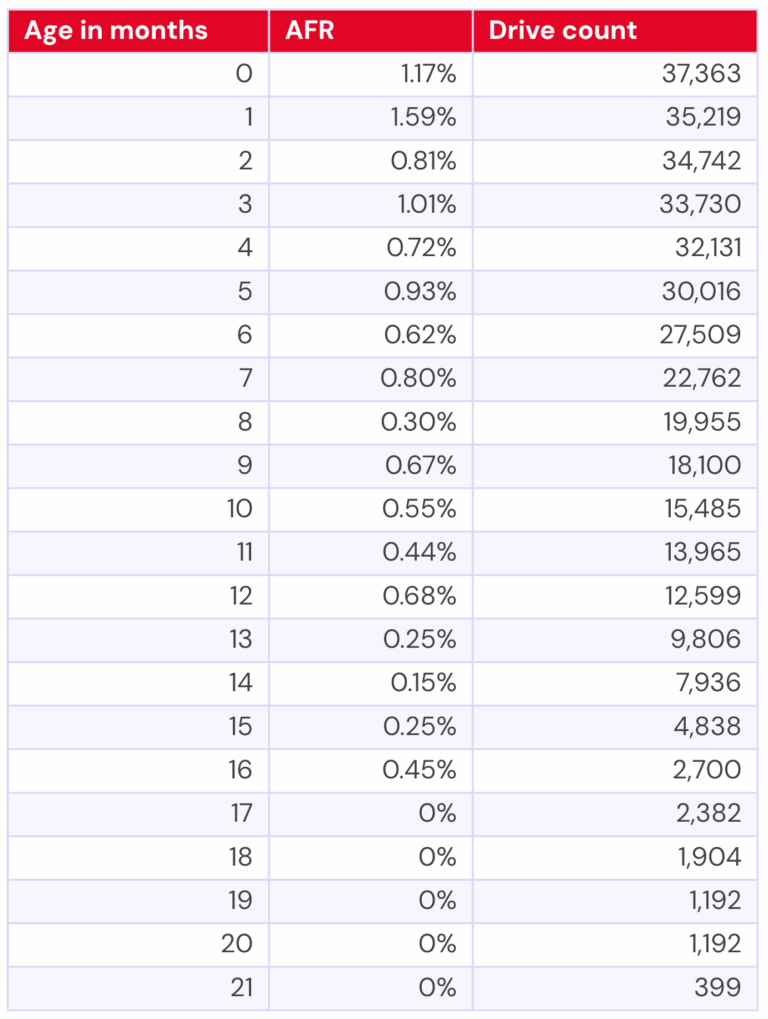

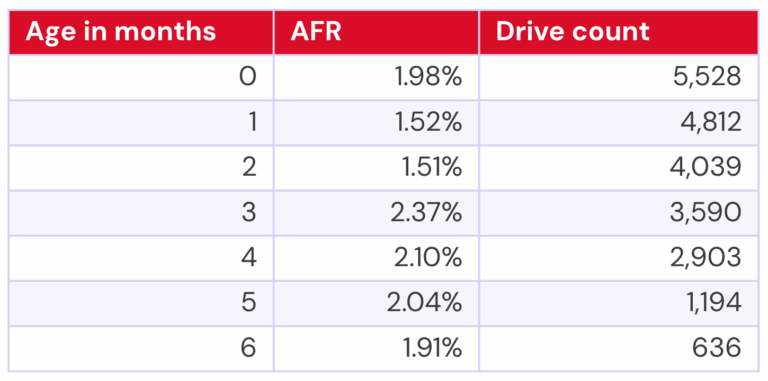

22 ТБ WDC WUH722222ALE6L4

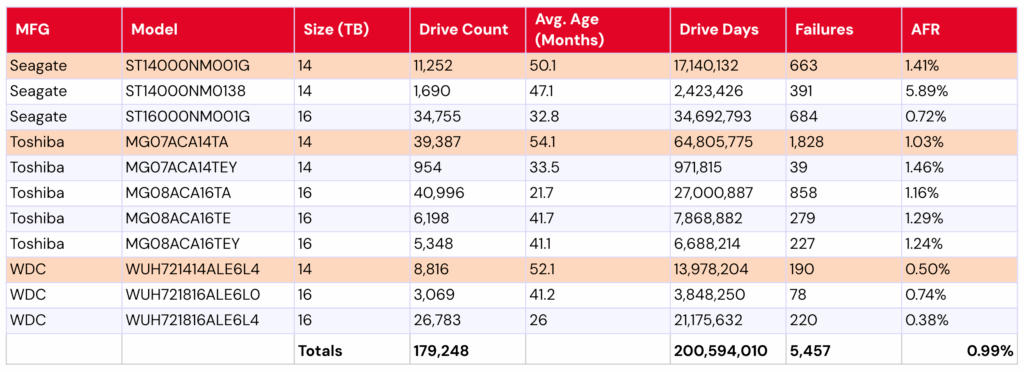

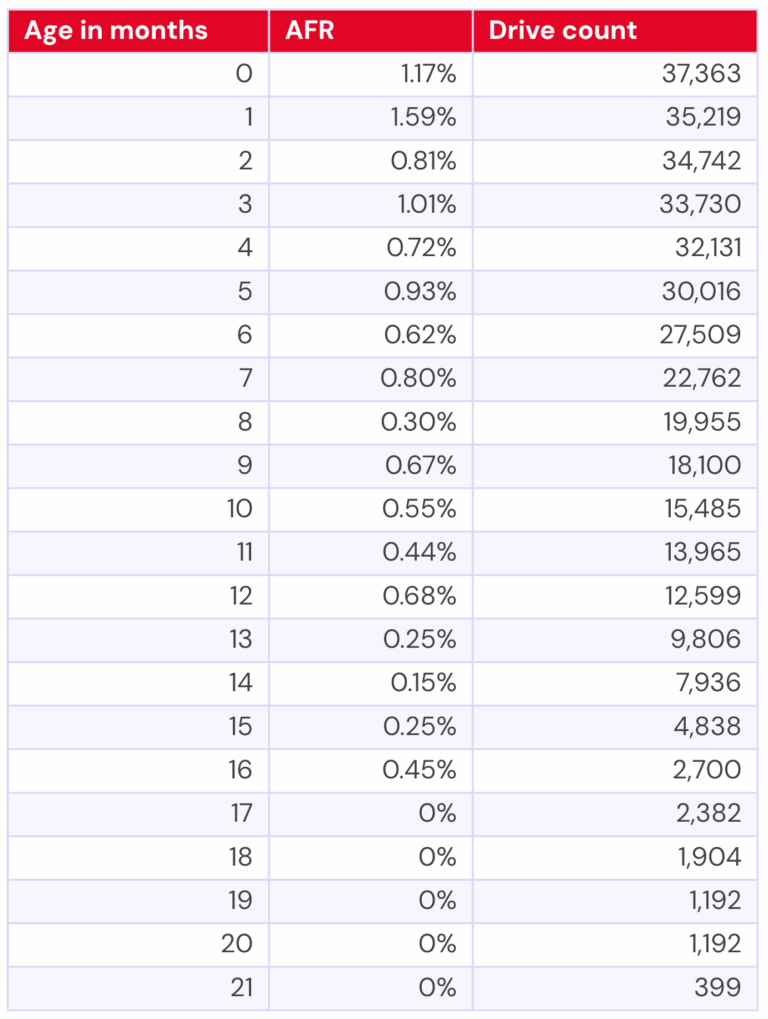

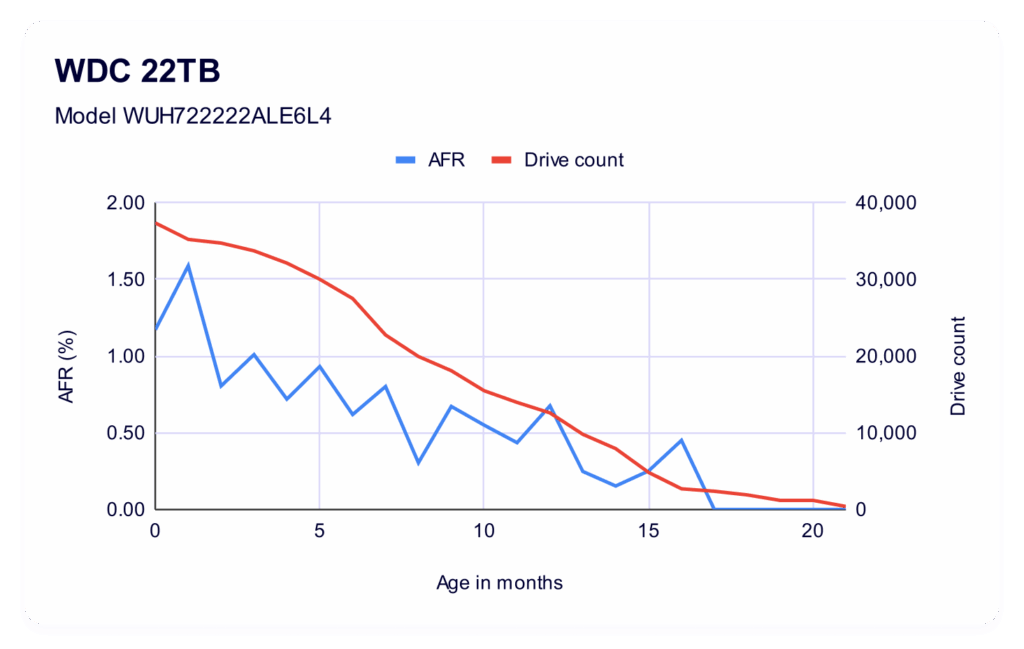

Теперь давайте взглянем на модель WDC. У нас есть пригодные для использования данные примерно за 21 месяц эксплуатации накопителя:

Интересно, что мы видим гораздо меньшую вариативность в промежутке времени, когда у нас есть прямое сравнение. При этом у модели WDC также было как минимум вдвое больше накопителей, если рассматривать аналогичный период времени: так, в самом раннем возрасте (0 месяцев) у Toshiba было 14 407 накопителей против 37 363 у WDC; а в 11 месяцев у Toshiba было 1034 накопителя против 13 965 у WDC.

Хотя показатели AFR в целом дают нам равные условия в плане возможности сравнения 1:1, важно помнить, что в небольших парках накопителей один сбой может значительно усилить последствия.

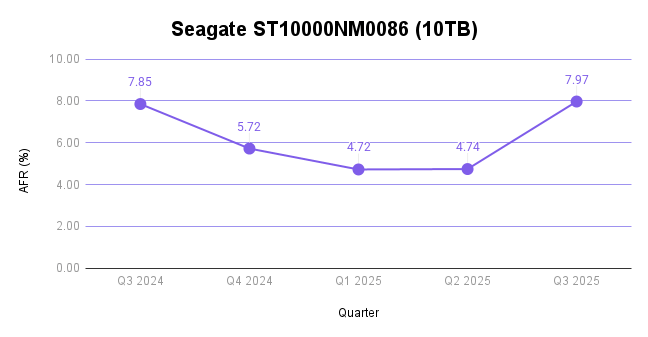

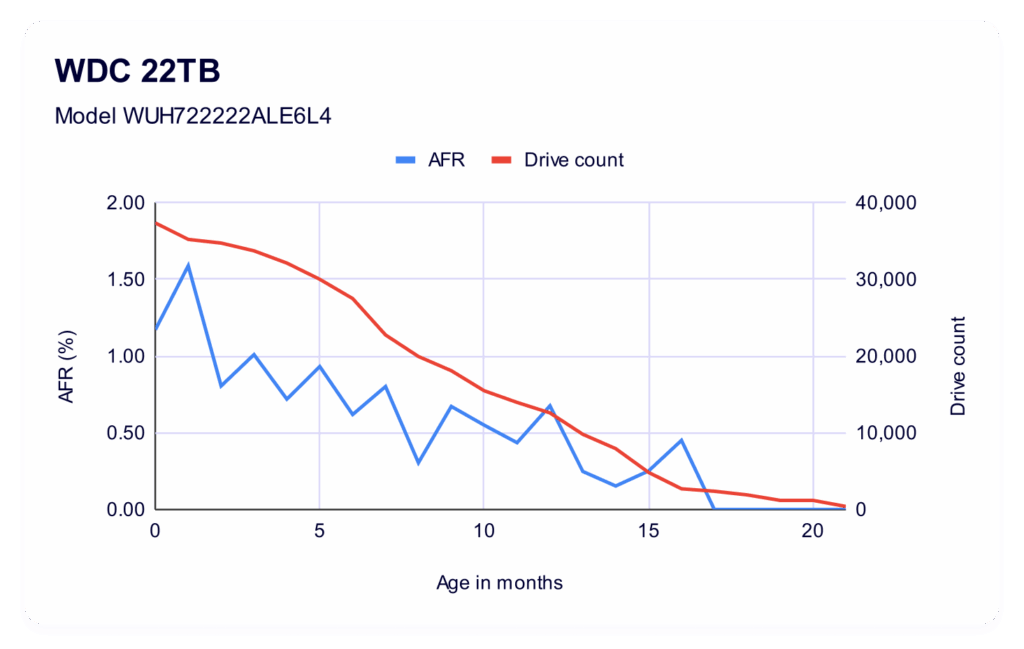

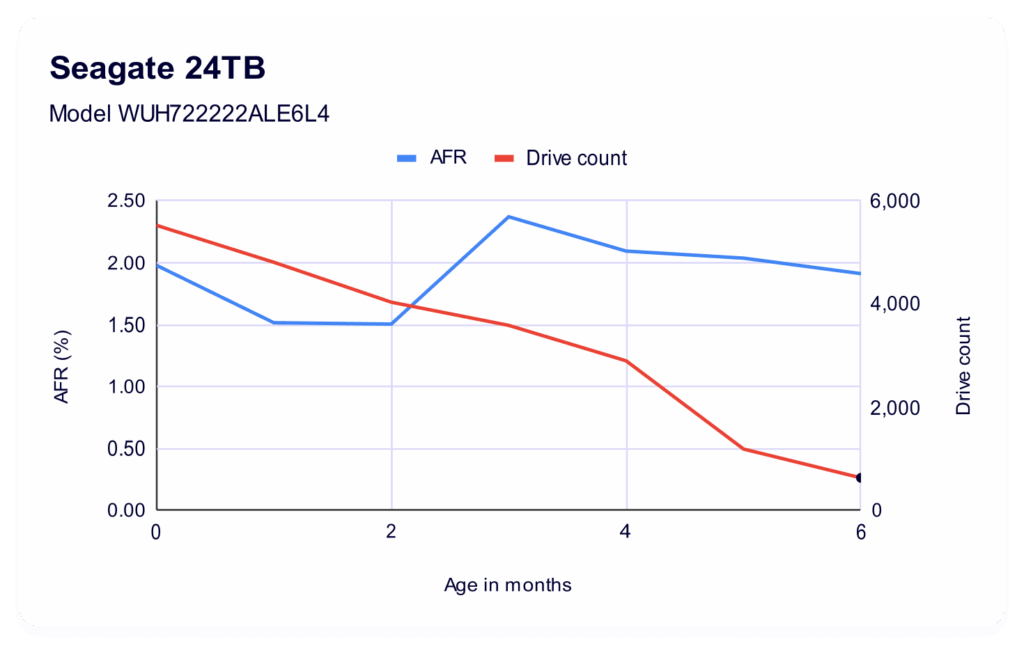

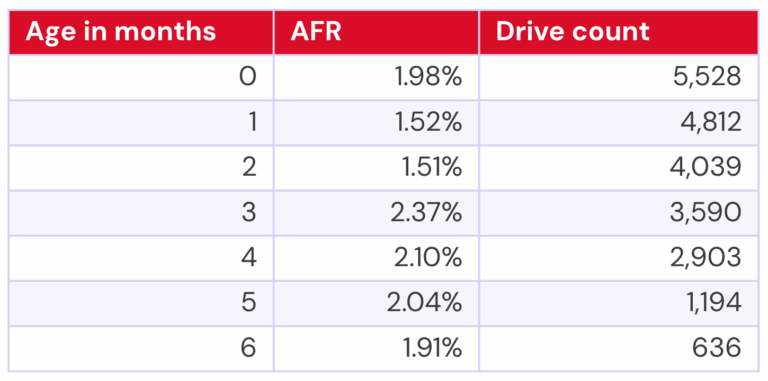

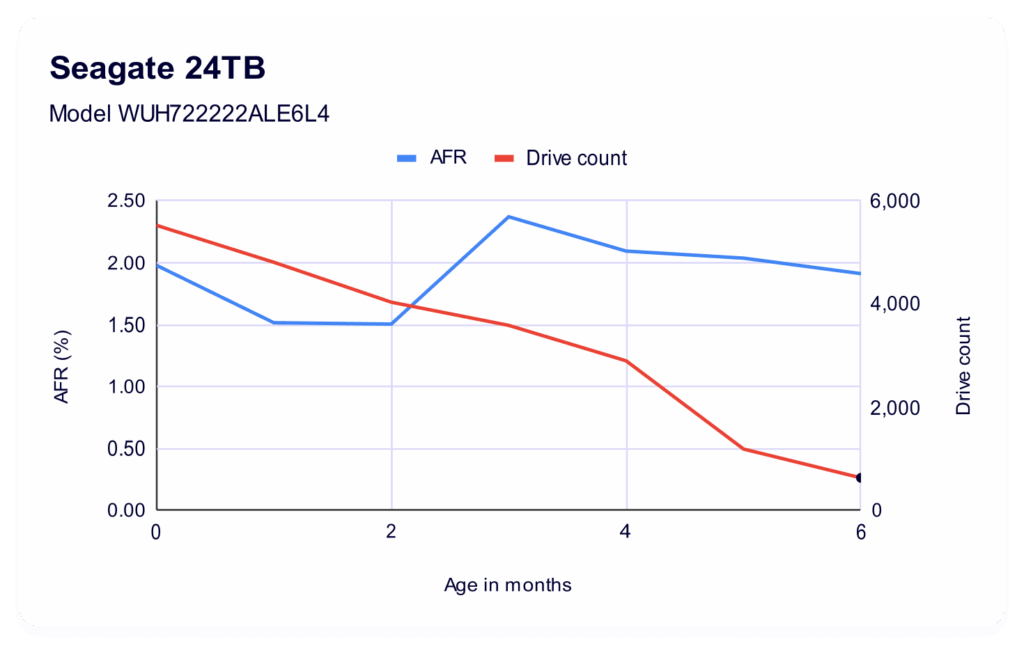

24 ТБ Seagate ST24000NM002H

Самая новая модель нашего накопителя, Seagate ST24000NM002H емкостью 24 ТБ, содержит данные всего за полгода.

По сравнению с двумя другими нашими моделями дисков, у Seagate ёмкостью 24 ТБ определённо самый высокий процент отказов. Отчасти это можно объяснить тем, что диск новый — находится ли он на переднем крае традиционной кривой отказов? Поэтому, безусловно, стоит следить за ним со временем, чтобы понять, не усядется ли он по мере старения.

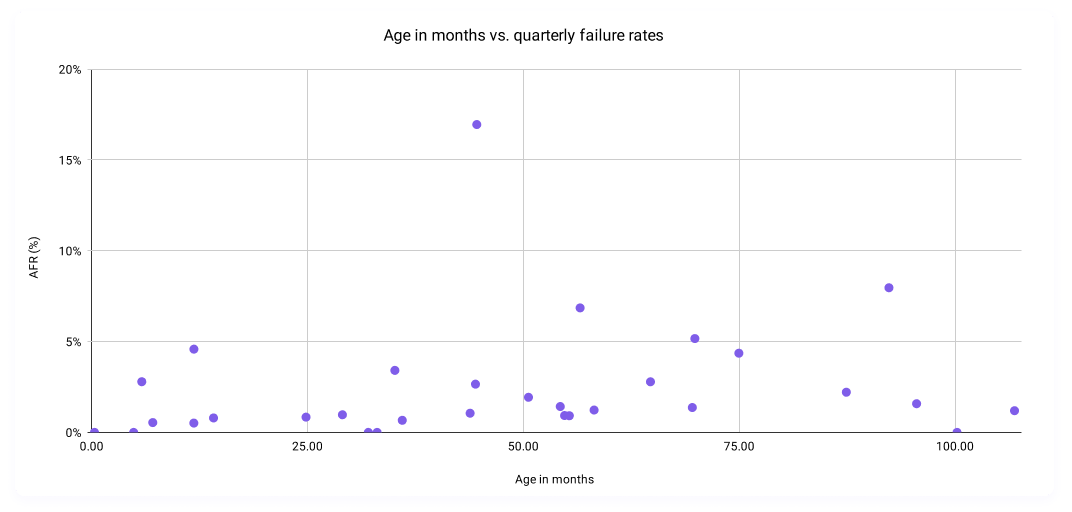

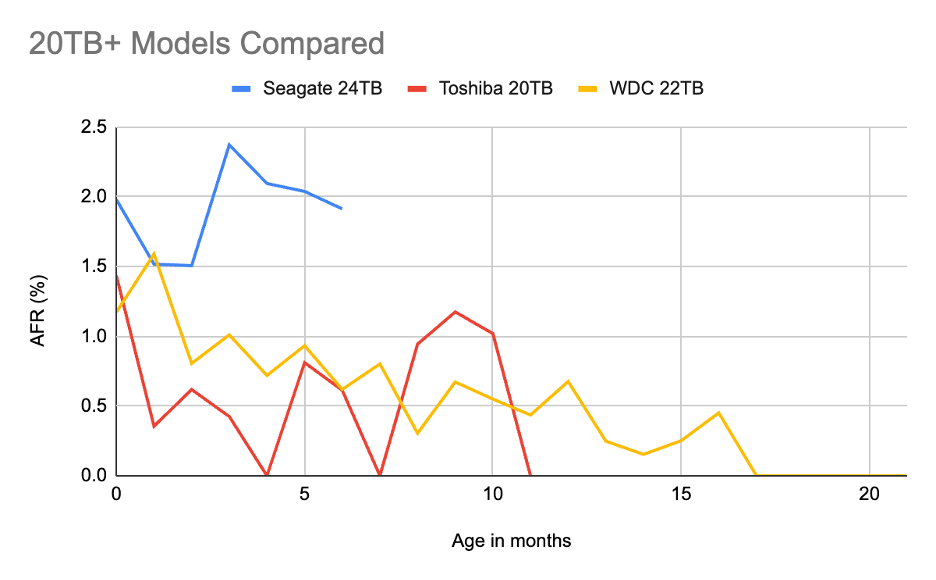

Теперь все вместе: сравнение каждого диска емкостью 20 ТБ+

Мы разработали это представление для непосредственного сравнения в определенные моменты времени, поэтому вот ваш график, на котором каждый диск представлен в одной и той же временной шкале:

Какой вывод? Что ж, как по количеству дисков, так и по сроку службы, пока рано делать однозначные выводы о тенденциях для Seagate и Toshiba. Конечно, мы видим, что Seagate на первых порах демонстрирует более высокую частоту отказов. В то же время, для Toshiba ёмкостью 20 ТБ первый год был довольно нестабильным. Но, опять же, учитывая значительное разнообразие дисков во всех моделях, мы не можем сравнивать всё на равных. (Мы решили не отображать количество дисков на этой диаграмме — она быстро становится запутанной.) К тому же, Seagate, в частности, потенциально находится в начале кривой «ванны», и со временем мы можем увидеть её изменения.

С другой стороны, модель WDC ёмкостью 22 ТБ показала значительно более низкий показатель годового резервирования (AFR) для пула накопителей всех размеров и возрастов, и это модель с наибольшим объёмом данных. Но как это соотносится с другими моделями, которые появятся в продаже?

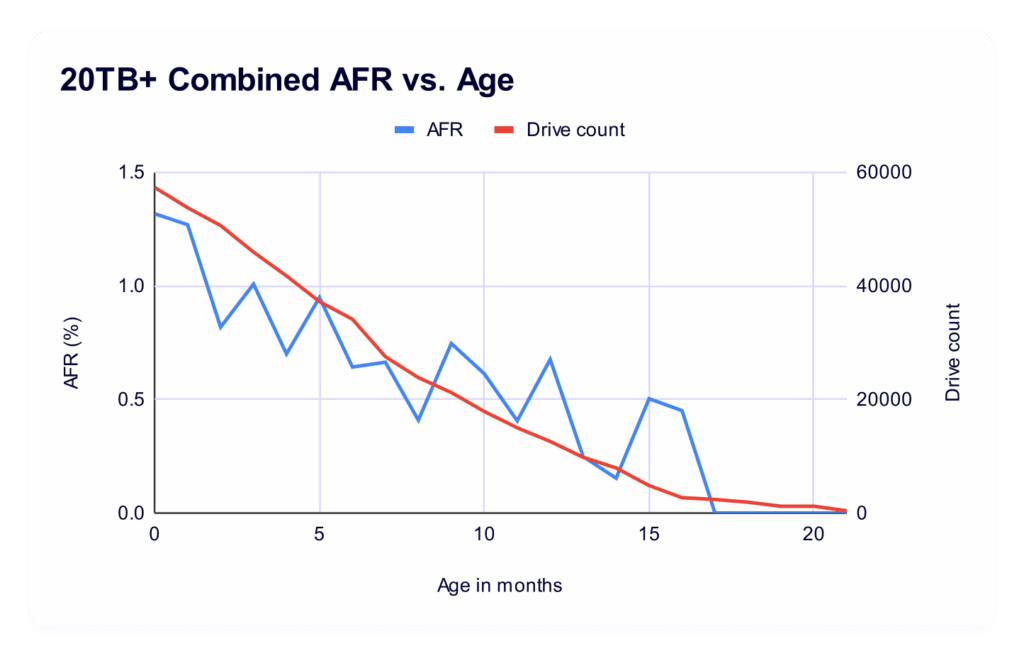

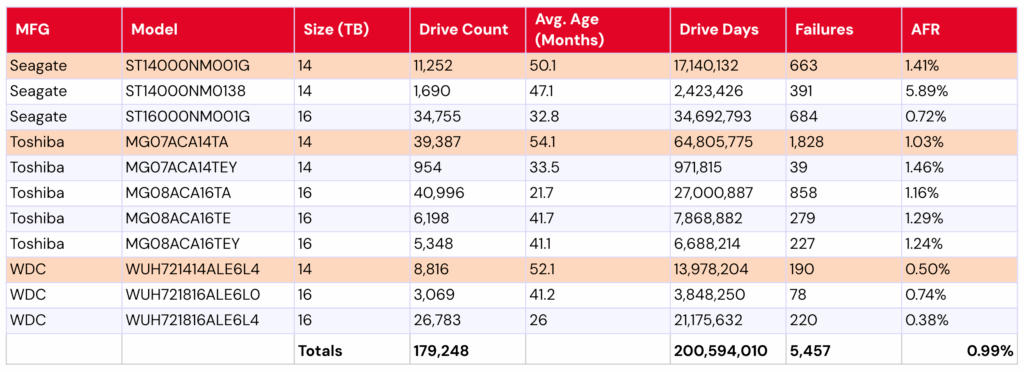

Сравнение: пул объемом 20 ТБ и более против пула объемом 14–16 ТБ

Когда мы размышляли, будет ли эта информация полезным фрагментом данных, нашим главным вопросом было, как её контекстуализировать по отношению к дискам. Возможно, это немного неточно, но мы решили объединить диски ёмкостью 14–16 ТБ в пул, в основном потому, что они содержат значительное количество точек данных и были последними установленными дисками, то есть, по сути, представляют собой последнее поколение оборудования.

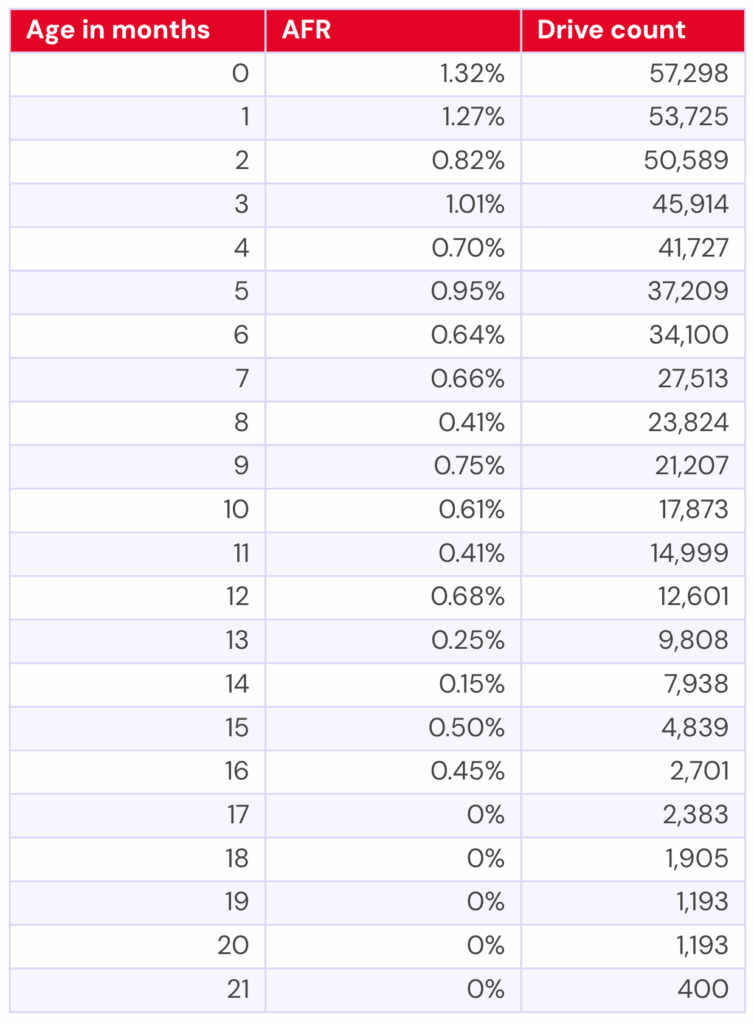

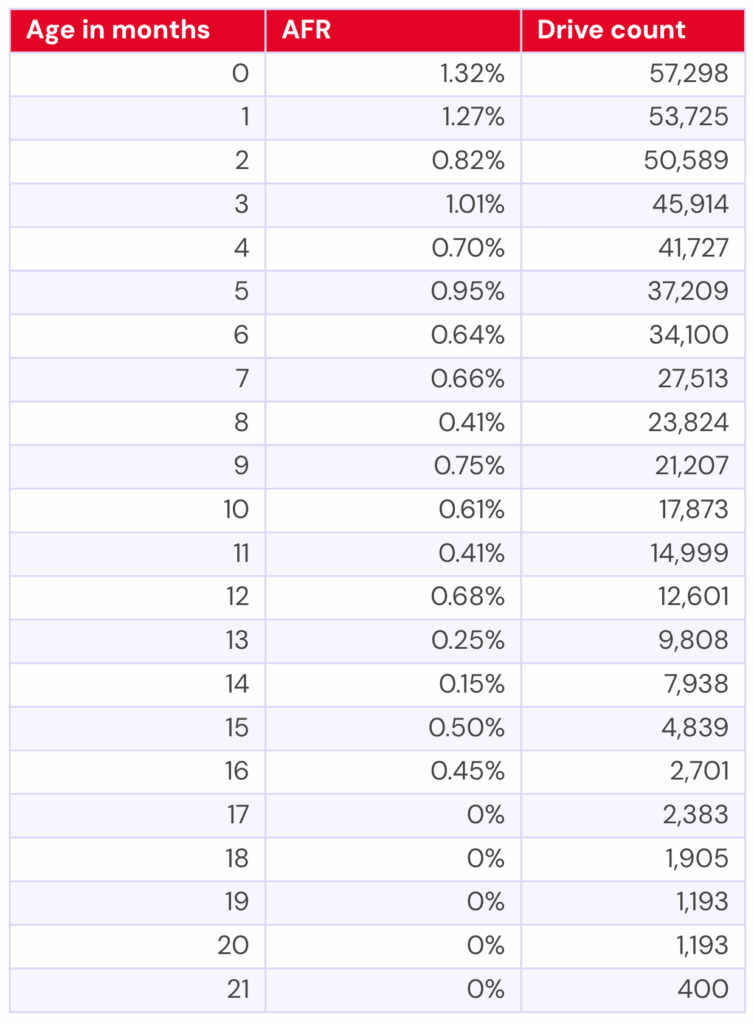

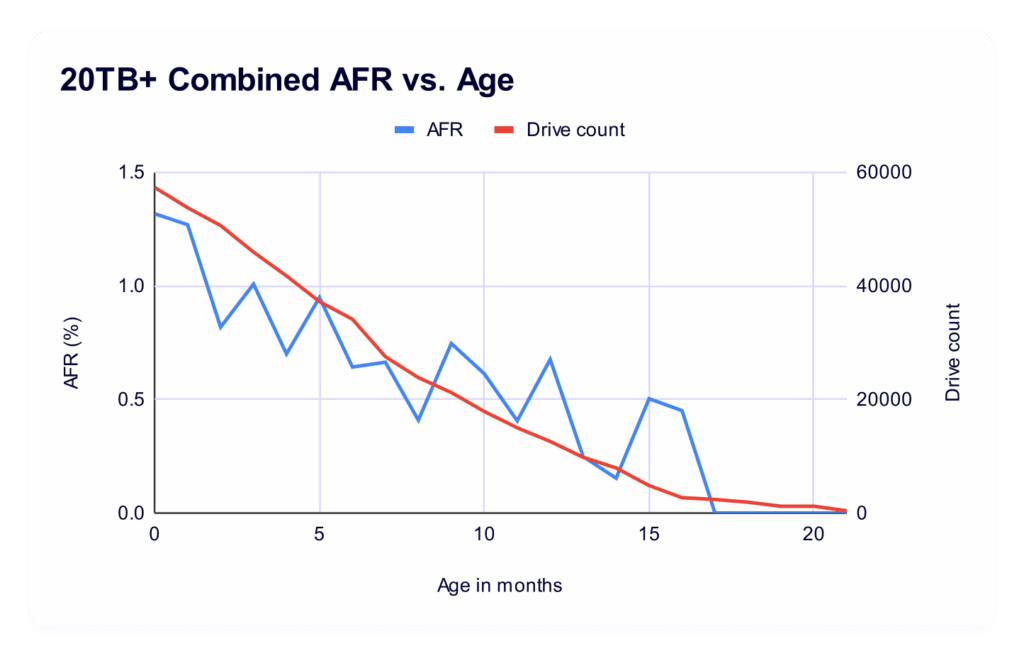

Еще один момент, на который следует обратить внимание, заключается в том, что после объединения дисков емкостью 20 ТБ в пул некоторые данные, которые мы отфильтровали по каждому диску, были добавлены обратно. Таким образом, по истечении 21 месяца, когда у модели Toshiba был только один диск, мы добавили этот единственный диск к 399 дискам, которые использовала наша модель WDC, и рассчитали AFR для всего пула (что дает нам 400 дисков для работы).

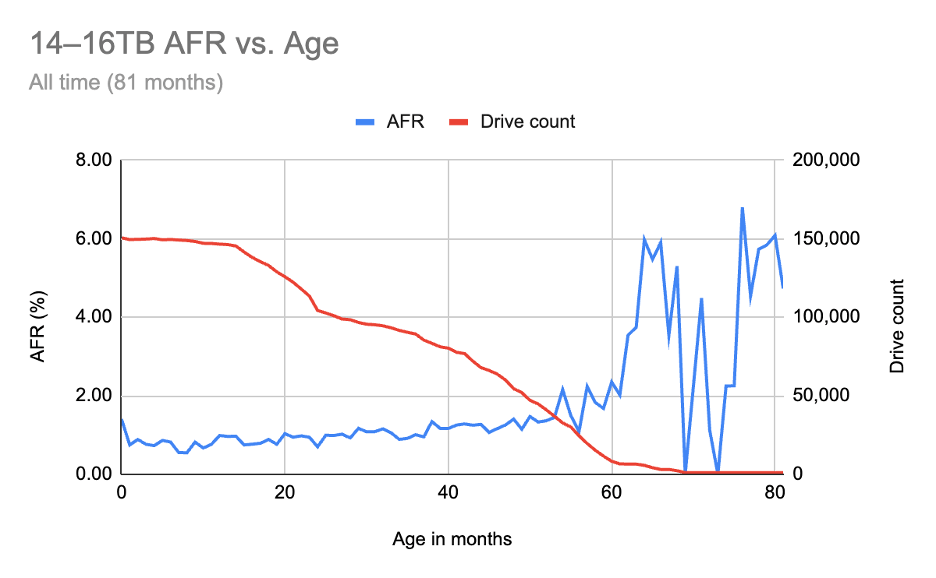

Вот цифры для пула дисков емкостью 20 ТБ+:

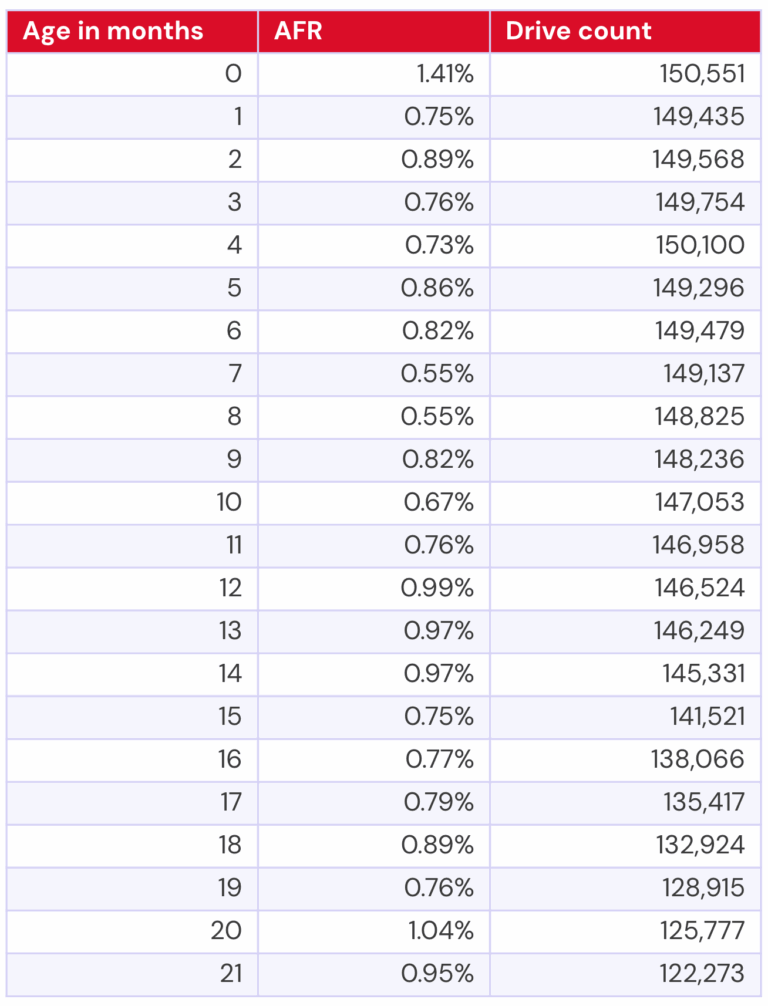

Теперь сравним их с дисками ёмкостью 14–16 ТБ того же возраста. У нас есть обширные данные по этой группе за почти семь лет, но, чтобы сэкономить вам три страницы, я приведу таблицу с данными, которые напрямую коррелируют с данными за 21 месяц для дисков ёмкостью 20 ТБ и более.

Сравнивая возраст дисков, можно предположить, что наши 20 ТБ соответствуют целевому уровню и, возможно, показывают результаты немного лучше, чем ожидалось. Однако это сравнение определённо не идеальное, учитывая, что диски ёмкостью 14–16 ТБ имеют более стабильное и большое количество дисков. Итак, давайте посмотрим на график за весь период, почти семь лет:

Это представление начинает показывать нам некоторые резкие изменения по мере старения дисков емкостью 14–16 ТБ, которые, конечно, усугубляются уменьшением количества дисков с течением времени.

Так что же все это значит?

Из данных ясно, что нам нужно дать дискам емкостью 20 ТБ и более время, чтобы созреть, и что по мере того, как мы (в зависимости от нашего покупательского поведения, конечно) добавим больше дисков, мы можем увидеть некоторые интересные изменения в данных.

Что касается пула емкостью 14–16 ТБ, то он следует относительно ожидаемым моделям износа в диапазоне от пяти лет и более, но что это значит по сравнению с тем, что мы наблюдаем в нашей текущей статистике по сроку службы, где мы видим, что наш пул дисков емкостью 12 ТБ и меньше работает так хорошо?

Не рассматривая диски ёмкостью 14–16 ТБ более подробно, сложно сказать, что у них нет тех же аномальных тенденций, что и у пула ёмкостью 12 ТБ и меньше, что просто повышает частоту отказов. Даже беглый взгляд на диски ёмкостью 14–16 ТБ в нашей текущей таблице сроков службы подтверждает это (сроки от четырёх лет и старше выделены оранжевым цветом, как и в предыдущем выводе):

Однако эти данные не включают все накопители объёмом 14–16 ТБ, которые у нас когда-либо были, а только те, которые работают в настоящее время. Поэтому, как всегда, предстоит ещё провести исследование.

Данные статистики жесткого диска

Полный набор данных, использованный для создания таблиц и диаграмм в этом отчёте, доступен на нашей странице «Данные для тестирования жёстких дисков». Вы можете бесплатно скачать эти данные и использовать их в своих целях. Мы просим вас лишь о трёх условиях: 1) при использовании данных указывать Backblaze в качестве источника; 2) признавать, что несёте исключительную ответственность за использование данных; и 3) не продавать эти данные кому-либо; они бесплатны.

Удачи, и дайте нам знать, если найдете что-нибудь интересное.