#СOVID-2019: Selectel просто работает

В материале расскажем о принятых мерах по обеспечению непрерывного функционирования услуг и сервисов Selectel. Мы также собрали полезные инструменты в помощь тем, кто перешел на удаленку и настраивает привычные процессы в digital-среде.

Бесперебойная работа сервисов

Selectel относится к предприятиям непрерывного цикла работы и продолжит оказание услуг клиентам с соблюдением SLA вне зависимости от ЧС, карантина и всего остального происходящего в мире. Все сотрудники Selectel, отвечающие за инженерные системы дата-центров и обслуживание оборудования клиентов, остаются на рабочих местах.

Для обеспечения непрерывности функционирования предприятия мы создали специальные запасы топлива для дизельно-генераторных установок, а также, дополнительно заключили договоры на поставку топлива с несколькими компаниями, имеющими право на работу в режиме ЧС.

Важно помнить, что Selectel также является оператором связи. Мы обладаем собственной резервированной сетью, напрямую подключенной к точкам обмена трафиком и магистральным операторам. Сеть объединяет воедино дата-центры в разных регионах. Даже в случае проблем с доступом в интернет в одном регионе, сеть продолжит работать непрерывно и без потери качества.

Продукты Selectel в помощь

Если вы переводите ваш бизнес на удаленную работу, мы готовы помочь сделать это максимально эффективно и быстро. Собрали (и опробовали на себе!) лучшие инструменты для связи с командой, контроля над задачами и любого взаимодействия с офисом на расстоянии в Топ-5 решений для бизнеса на удаленке.

promo.selectel.ru/remote-work-equipment/

Вот, что вошло в список:

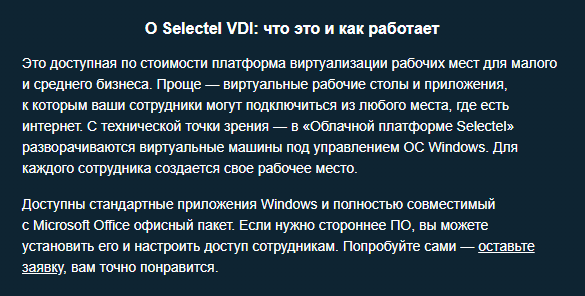

Selectel VDI — платформа виртуализации рабочих мест. Решение для удобного и безопасного доступа к корпоративным данным с любых устройств. Можно установить свои программы и настроить к ним доступ в один клик. Пользоваться Selectel VDI до 30 апреля можно бесплатно.

promo.selectel.ru/page9856855.html

Офисные приложения Google G Suite. Набор сервисов для совместной удаленной работы от Google. Более 10 приложений для работы с документами, взаимодействия с коллегами и хранения файлов. Специальное предложение на Google G Suite — скидка 30% на первый месяц использования.

selectel.ru/services/cloud-apps/gsuite/

Офисный пакет Microsoft Office 365. Лицензии облачных сервисов Office 365 по подписке. Пакет Microsoft Office 365 объединяет более 10 приложений в облачной инфраструктуре. Специальное предложение на Microsoft Office 365 — скидка 30% на первый месяц использования.

selectel.ru/services/cloud-apps/office365/

1C в облаке. Продукты 1С на базе услуг Selectel. 1С для работы из облака в любой точке мира. 1С легко масштабировать, а сервисы Selectel гарантируют постоянную доступность системы и аварийное восстановление данных в случае сбоя.

selectel.ru/services/1c-leasing/

Selectel Chat. Безопасный мессенджер для общения с коллегами. В отличие от публичных мессенджеров Selectel Chat развертывается локально для каждой компании — за несколько часов мы создаем отдельную независимую инсталляцию, а при необходимости и в защищенном контуре в соответствии с требованиями 152-ФЗ. Пользоваться Selectel Chat до 30 мая можно бесплатно.

promo.selectel.ru/remote-work-equipment/#rec171588459

Важно: порядок посещения дата-центров клиентами

Мы рекомендуем клиентам воздержаться от посещения дата-центров, или делать это только в случаях крайней необходимости. Большинство действий с размещенным оборудованием производится бесплатно силами наших дежурных инженеров — по заявке в техническую поддержку. В том случае, когда необходим прямой доступ к консоли размещенного оборудования, мы предоставляем его посредством подключения внешнего устройства управления (IP-KVM).

Если вам все же необходимо посетить дата-центр, просим обязательно прийти в собственной маске. На данный момент мы располагаем ограниченными запасами этих медицинских изделий из-за дефицита на рынке и выдаем их в первую очередь сотрудникам, которые обеспечивают непрерывность работы дата-центров.

Напоминаем, что мы измеряем температуру всем посетителям и не впускаем в дата-центры людей с любыми признаками ОРВИ, а также тех, кто выезжал за пределы РФ в последний месяц.

Все наши службы технической поддержки и обслуживания клиентов, за исключением работающих непосредственно в дата-центрах, переведены в удаленный режим. Для наших клиентов ничего не меняется: мы оперативно обрабатываем заявки, отвечаем на вопросы, открыты к общению online и готовы помочь.