Новые тарифы «Выделенный CPU» и «Больше памяти»

Новые тарифы «Выделенный CPU» и «Больше памяти»

Привет!

В линейке облачных серверов REG.RU новые тарифы! Отличие от тарифов «Стандарт» — вычислительная мощность ядра процессора гарантированно доступна виртуальному серверу.

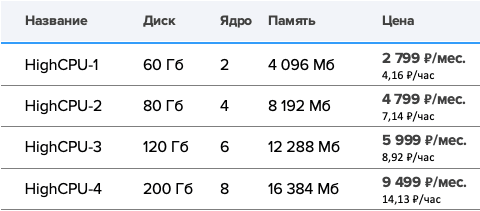

Тарифы «Выделенный CPU»

Подойдут для проектов со стабильно высокой нагрузкой на процессор. Например, для continuous integration/delivery, кодирования видео, машинного обучения и пакетной обработки. Цена начинается с 4,16 ₽ в час.

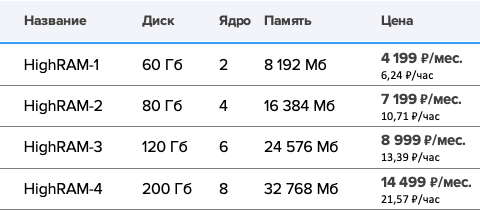

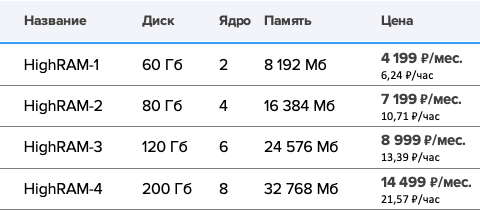

Тарифы «Больше памяти»

Тарифы «Больше памяти»

Также имеют выделенное ядро процессора, а объём памяти увеличен в 2 раза по сравнению с тарифами «Выделенный CPU». Эти тарифы подойдут для высоконагруженных веб-приложений и баз данных. Цена начинается с 6,24 ₽ в час.

Оборудование

Оборудование

Мы запускаем услугу на базе процессоров Intel Skylake с частотой 2,2 ГГц, чтобы протестировать спрос на серверы со стабильно высокой загрузкой процессора. Напишите нам, если вам требуются более производительные процессоры.

Почасовая оплата

Почасовая оплата позволяет использовать облачные серверы в коротких проектах или периодических задачах. Остановите сервер в любое время и деньги спишутся только за место на диске и ip-адрес — 5 ₽ за 1 ГБ в месяц, 79 ₽/мес. за ipv4 и 1 ₽/мес. за ipv6.

Преимущества

Облачные серверы с выделенным процессором сопоставимы по цене с дешёвыми физическими серверами, но предлагают больше гибкости:

- сервер создаётся в среднем за 30 секунд;

- конфигурация легко изменяется;

- есть снэпшоты — это снимок состояния сервера из которого его можно восстановить;

- сервер может стоять на паузе за минимальную плату.

Управляйте облачными серверами в панели управления и через API. Встраивайте инфраструктуру REG.RU в свои сценарии — это получение мощности точно в нужное время и экономия на развёртывании собственной инфраструктуры.

www.reg.ru/vps/cloud