Уже более десяти лет мы являемся лидерами в проектировании, создании и эксплуатации центров обработки данных.

Когда мы начали строить наш первый центр обработки данных, мы столкнулись со многими проблемами, такими как:

- Как мы оптимизируем энергетический след таких объектов?

- Как мы можем предотвратить потерю мощности?

- Как мы можем обеспечить надлежащее охлаждение?

- Как мы можем сделать его модульным?

В течение первых лет операций все эти вопросы часто не спали ночью. Тем не менее, благодаря испытаниям и ошибкам, трудолюбию и настойчивости, мы наконец получили опыт, чтобы сделать наши центры обработки данных эффективными и масштабируемыми. Сегодня наши центры обработки данных — это проверенные бизнесом объекты, управляемые профессиональными и целеустремленными командами. На сегодняшний день мы являемся одним из крупнейших операторов центров обработки данных во Франции с более чем 42 000 квадратных метров и 43 МВт в производстве.

Наш новый объект DC5 является одним из самых значительных проектов центров обработки данных во Франции. Предлагая более 24 МВт ИТ-мощности, DC5 состоит из 12 частных апартаментов, обеспечивающих 1,8 МВт ИТ-мощности каждый на общей площади 16 000 квадратных метров. Мы разработали это средство для масштабируемых облачных вычислений и больших инфраструктур данных.

В этом сообщении в блоге мы подробно расскажем о том, как мы преобразовали здание сортировки почты в беспрецедентный центр обработки данных с гипермасштабированием. Сообщение состоит из трех разделов:

- Стратегическое местоположение здания

- Эффективная система охлаждения

- Ультра-высокая плотность по дизайну

Стратегическое местоположение здания

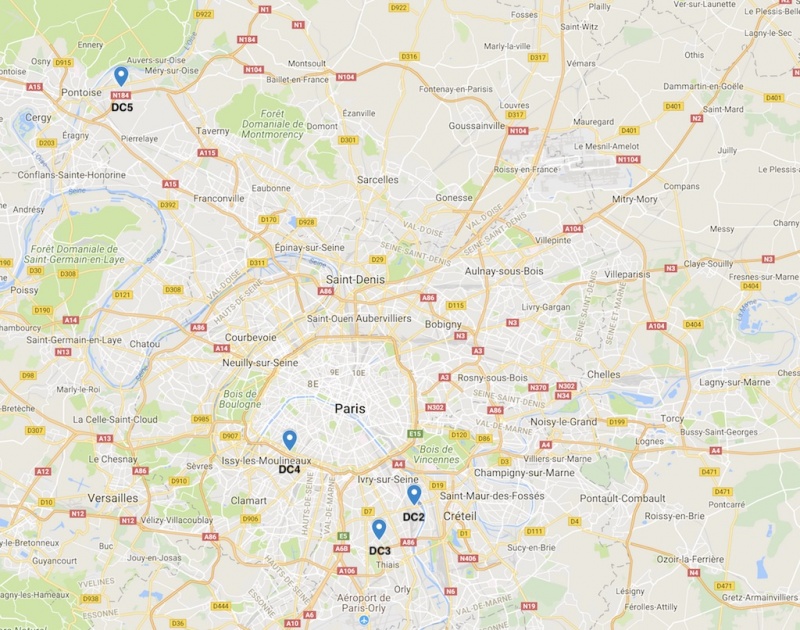

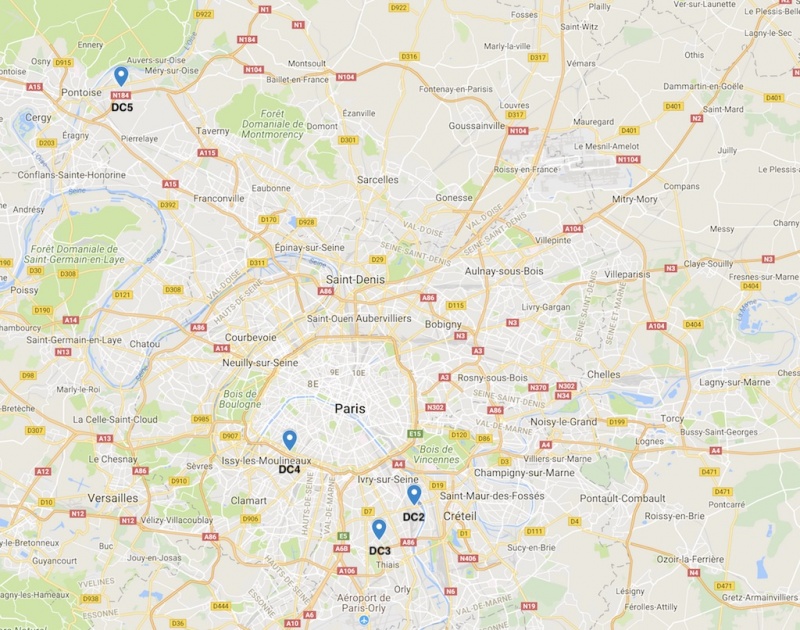

Расположенная на северо-западе Парижа, сайт изначально занимался сортировкой почты до 2013 года. Это здание имеет множество стратегических преимуществ, которые привели к принятию нашего решения превратить его в гипермагистральный центр обработки данных.

Прежде всего, здание расположено в Сен-Оуэн-Аумне в крупнейшем бизнес-парке в Европе и близко к двум магистралям Интернета операторов Tier-1. Более того, его «локализация» дает огромную мощность. Наконец, это больше чем 40 км от наших других центров обработки данных, что позволяет нам предлагать (среднесрочную, долгосрочную) зону диссоциирования для региона Парижа.

На приведенном выше рисунке вы можете увидеть географические местоположения каждого из наших центров обработки данных и где DC5 находится по сравнению с DC2, DC3 и DC4.

Эффективная система охлаждения

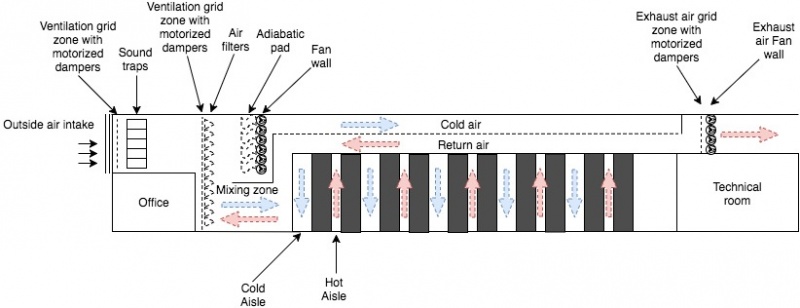

В DC5 мы используем систему прямого бесплатного охлаждения с испарительным охлаждением для охлаждения помещений IT и прямого бесплатного охлаждения с использованием традиционных чиллеров для охлаждения помещений Meet Me и ИБП. Поэтому нет реального кондиционирования воздуха, что осложняется во Франции, потому что в стране умеренный климат. В отличие от Финляндии, температура не достаточно холодная, чтобы использовать внешний воздух круглый год, и в отличие от Испании, это не так жарко, чтобы ежедневно использовать горячий воздух.

Используя систему прямого бесплатного охлаждения с испарительным охлаждением, воздух, поступающий в центр обработки данных, охлаждается перед входом в комнаты ИТ. Этот метод предлагает эффективную альтернативу механическому охлаждению. При DC5 испарительное охлаждение активируется, когда температура воздуха превышает 30 ° C. Благодаря системе прямого свободного охлаждения с испарительным охлаждением мы можем поддерживать постоянную температуру 30 ° C ± 1 ° C в холодных проходах.

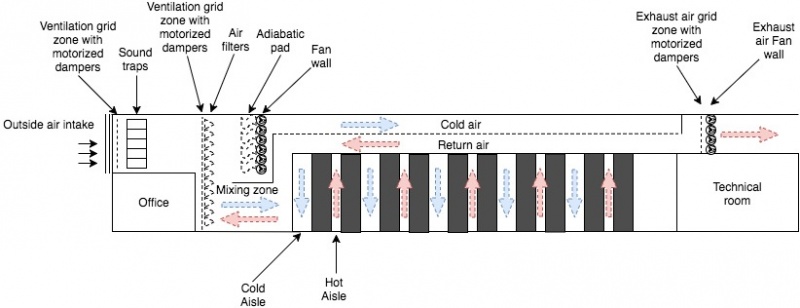

В DC5, из двух этажей, одна комната IT, а другая — пленум, посвященный перемещению большого количества воздуха. Затем холодный воздух вводится в холодный проход, а горячий воздух извлекается из горячего коридора.

Охлаждение, электрическое и сетевое распределение производятся из потолка, в то время как в традиционном дизайне распределение обычно осуществляется через проход доступа.

Воздухозаборные решетки на картинке выше только позволяют воздуху проникать и удерживать дождь, птиц и других предприимчивых животных.

За решеткой воздухозаборника решетка вентиляционной решетки оснащена программируемыми логическими контроллерами (PLC) для регулирования открытия сетки и контроля потока воздуха. Чем прохладнее воздух, тем больше сетка закрывается и наоборот.

ПЛК управляются датчиками температуры и влажности для настройки их открытия и использования адиабатических сред. В общей сложности мы можем обрабатывать более 400 информации в режиме реального времени для настройки и оптимизации системы с использованием AI и сложных алгоритмов.

Как только воздух находится, поток воздуха поступает во вторую серию сеток. Их роль заключается в обеспечении равного перераспределения воздушного потока на всей фильтрующей стенке. Без этих сеток воздушный поток неравный между дном и верхней частью стены.

Чтобы заблокировать и удалить воздушные частицы в здании, мы установили воздушные фильтры класса F7.

Как раз за воздушными фильтрами, стена вентилятора толкает очищенный воздух в холодные проходы с потолка.

Чтобы охладить оба, комнаты Meet Me и механические области, мы используем прямое бесплатное охлаждение с использованием традиционных чиллеров. Эти чиллеры используются только тогда, когда наружная температура выше 20 ° C. Наш дизайн новаторский, поскольку мы также используем блок хранения льда мощностью 6 МВт-ч. Блок хранения льда предлагает множество преимуществ:

- Он быстро реагирует на спрос на охлаждение без использования чиллеров.

- Это позволяет избежать короткого цикла на чиллерах.

- Он обеспечивает потребность в охлаждении в случае отказа чиллера.

- Это экономически выгодно, поскольку лед производится ночью, когда энергия дешевле.

Кроме того, система охлаждения DC5 может считаться инновационной:

- 100% воздух снаружи проходит через адиабатический процесс, который позволяет воздуху испаряться через систему охлаждения и увлажнения.

- Он перерабатывает воздух, поступающий из горячих проходов. Отработанное тепло смешивается с наружным воздухом в зоне смешивания для достижения заданного значения температуры и нагревает воздух до того, как он попадет в центр обработки данных, чтобы поддерживать температуру 30 ° C в холодных проходах.

- Мы используем хранение льда для всех инфраструктур, которые нуждаются в механическом охлаждении и низкой температуре атмосферы.

Использование прямого бесплатного охлаждения с испарительным охлаждением дает много преимуществ по сравнению с традиционной системой охлаждения. Эта конструкция является достаточной для энергии и значительно снижает потери воды в отличие от чиллеров или градирен. Кроме того, его низкая сложность сводит к минимуму риск отказа холодильного оборудования. Наконец, упрощение дизайна делает систему более простой в обслуживании и функционировании для команды на месте.

Сверхплотная конструкция

Мы разработали DC5 для ультра-высокой плотности и инфраструктуры сверхмасштабирования. Каждая стойка может поддерживать до 6 кВт с общей емкостью 300 стоек на номер.

На стойках DC5 питание осуществляется двумя разными путями.

На стойках DC5 питание осуществляется двумя разными путями.

Только один путь защищен автономными ИБП и генераторами. ИБП работают только тогда, когда сетка ниже наших критериев качества. Другой путь защищен только генератором. Поскольку все наши серверы имеют двойной шнур, это абсолютно не влияет.

Этот дизайн дает нам правильный уровень избыточности с гораздо более эффективной инфраструктурой и почти 100% установленной емкости, которую можно использовать за все время, в отличие от традиционной архитектуры 2N с максимальной 50% установленной емкости, пригодной для серверов.

В случае сбоя питания, путь А становится недоступным до тех пор, пока генераторы не начнут работать, поскольку он не защищен ИБП. Путь B обеспечивает бесперебойное питание до тех пор, пока генераторы не будут полностью работоспособны. Эта операция занимает менее 12 секунд. Наши генераторы — это двигатели с непрерывным ходом, работающие в фазе и синхронизированные с сеткой. Другими словами, они могут работать одновременно с использованием сетки. Когда электросеть возвращается, нагрузка может быть перенесена из генераторов в сетку без перерыва и отключена по мощности на пути A.

Вывод

Конструкция DC5 позволила нам создать очень эффективную и сверхвысокую плотность. Используя более простую конструкцию, мы повысили надежность. Наличие меньшего количества компонентов означает более высокую надежность, так как меньше деталей, которые могут выйти из строя. DC5 поможет нам значительно поддержать рост Scaleway & Online в течение следующих 6 лет.