Статистика Backblaze Drive за второй квартал 2024

По состоянию на конец второго квартала 2024 года Backblaze отслеживал 288 665 жестких дисков (HDD) и твердотельных накопителей (SSD) на наших серверах облачного хранения, расположенных в наших центрах обработки данных по всему миру. Мы исключили из этого анализа 3789 загрузочных дисков, состоящих из 2923 твердотельных накопителей и 866 жестких дисков. Это оставляет нам 284 876 жестких дисков под управлением для обзора в этом отчете. Мы рассмотрим годовые показатели отказов (AFR) за второй квартал 2024 года и AFR за весь срок службы соответствующих моделей дисков, а также проверим возраст дисков в зависимости от показателей отказов с течением времени. По ходу дела мы поделимся нашими наблюдениями и идеями по представленным данным и, как всегда, ждем, что вы сделаете то же самое в разделе комментариев в конце поста.

Показатели отказов жестких дисков во втором квартале 2024 г.

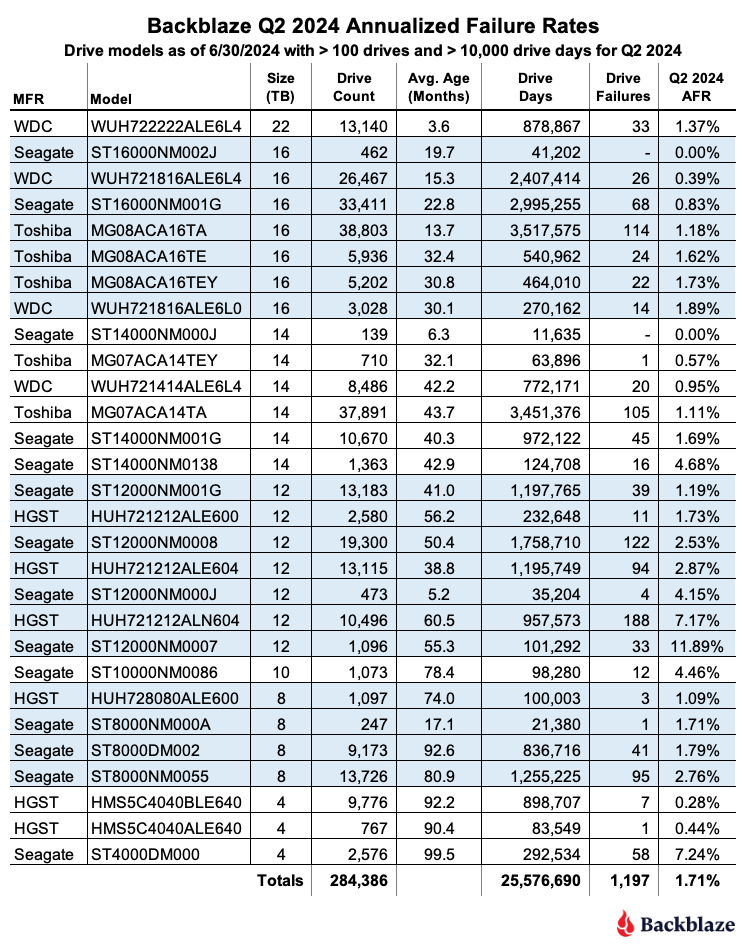

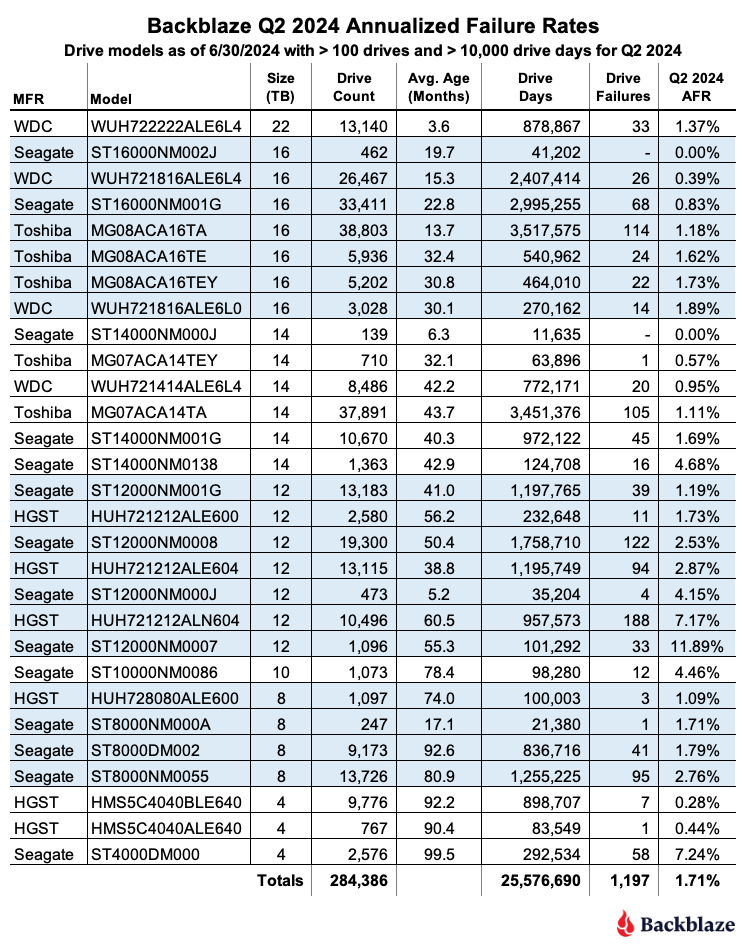

Для нашего квартального анализа Q2 2024 мы исключаем из рассмотрения: модели приводов, которые имели не менее 100 приводов в эксплуатации на конец квартала, модели приводов, которые не накопили 10 000 или более дней привода в течение квартала, и отдельные приводы, которые превысили температурные характеристики производителя в течение своего срока службы. Удаленный пул составил в общей сложности 490 приводов, оставив нам 284 386 приводов, сгруппированных в 29 моделей приводов для нашего анализа Q2 2024.

В таблице ниже перечислены AFR и соответствующие данные для этих моделей приводов. Таблица отсортирована от большего к меньшему по размеру привода, а затем по AFR в пределах размера привода.

Заметки и наблюдения по статистике движения за второй квартал 2024 г.

Рост AFR: AFR для Q2 2024 года составил 1,71%. Это выше, чем в Q1 2024 года на 1,41%, но ниже, чем год назад (Q2 2023) на 2,28%. Хотя квартальный рост был немного неожиданным, ожидаются квартальные колебания AFR. Шестнадцать моделей приводов имели AFR 1,71% или ниже, а 13 моделей приводов имели AFR выше.

Два хороших нуля: во втором квартале 2024 года две модели дисков не имели ни одного отказа, Seagate на 14 ТБ (модель: ST14000NM000J) и Seagate на 16 ТБ (модель: ST16000NM002J). У обеих моделей относительно небольшое количество дисков и дней работы за квартал, поэтому их успех несколько сдержан, но у модели диска Seagate на 16 ТБ очень приличный показатель отказов за весь срок службы — 0,57%.

Еще один GOAT ушел: в первом квартале мы перенесли последний из наших 4-терабайтных дисков Toshiba. Во втором квартале мы перенесли последний из наших 6-терабайтных дисков, включая все 6-терабайтные диски Seagate, средний возраст которых составил девять лет (108 месяцев). Эта модель диска Seagate завершила свою карьеру в Backblaze с впечатляющим показателем AFR в 0,86%.

В настоящее время 4-терабайтный Seagate (модель: ST4000DM000) является нашей старейшей моделью дисков для хранения данных, средний возраст которой составляет 99,5 месяцев. Данные с этих дисков планируется перенести в течение следующего квартала или двух с помощью CVT, нашей внутренней системы миграции дисков. Они никогда не прослужат девять лет.

Клуб 10-летних: с переносом 6-терабайтных дисков Seagate, которым исполнилось 10 лет, мы задались вопросом: какой диск с данными является самым старым в эксплуатации? Ответ: диск HGST емкостью 4 ТБ (модель: HMS5C4040ALE640) со сроком службы 9 лет, 11 месяцев и 23 дня по состоянию на конец второго квартала. Увы, хранилище Backblaze, в котором находится этот диск, теперь переносится, как и многие другие диски со сроком службы более девяти лет. Посмотрим в следующем квартале, успеют ли они попасть в Клуб 10-летних до того, как будут выведены из эксплуатации.

Хотя нет ни одного диска с данными со сроком службы 10 лет, есть 11 загрузочных жестких дисков, которые превышают эту отметку. Фактически, один из них, диск WD емкостью 500 ГБ (модель: WD5000BPKT), прослужил более 11 лет. (Псс, не говорите об этом команде CVT.)

Сюрприз от HGST: на протяжении многих лет модели дисков HGST, которые мы использовали, работали очень хорошо. Поэтому, когда диск HGST емкостью 12 ТБ (модель: HUH721212ALN604) появился с AFR 7,17% во втором квартале, это стало новостью. Такие нехарактерные квартальные показатели отказов для этой модели на самом деле появились около года назад, хотя AFR 7,17% является самым большим квартальным значением на сегодняшний день. В результате AFR за весь срок службы вырос с 0,99% до 1,57% за последний год. Хотя AFR за весь срок службы не вызывает тревоги, мы обращаем внимание на эту тенденцию.

Показатели отказов жестких дисков за весь срок службы

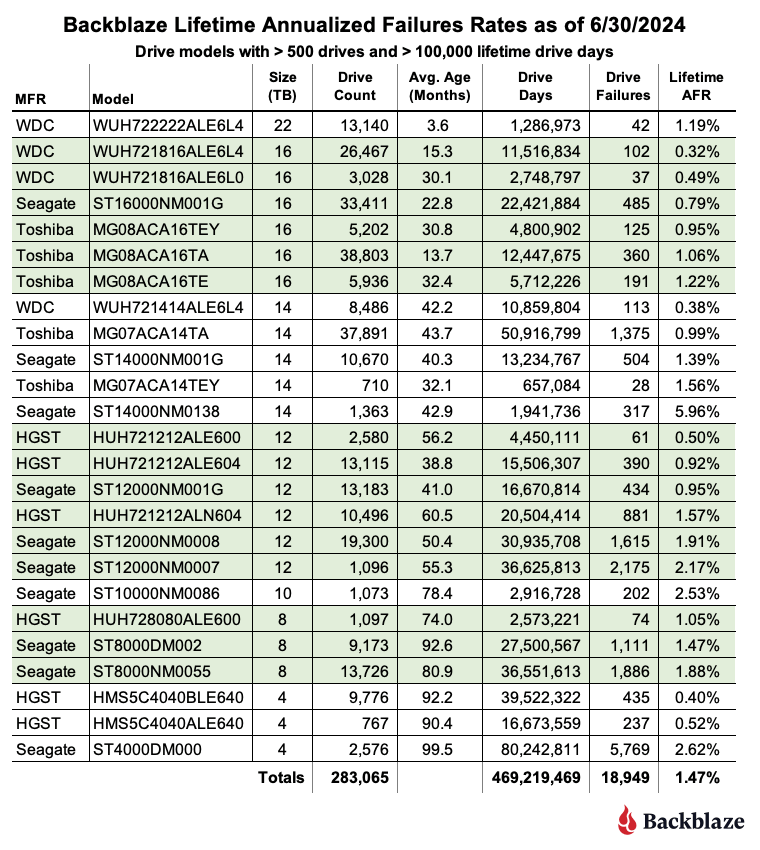

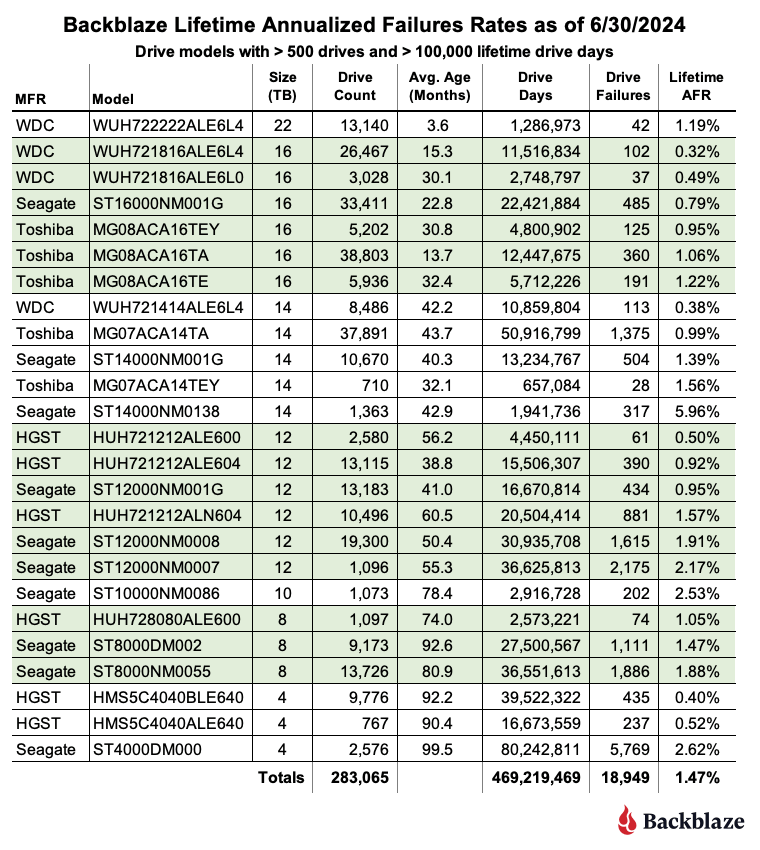

По состоянию на конец второго квартала 2024 года мы отслеживали 284 876 работающих жестких дисков. Чтобы быть рассмотренной для обзора жизненного цикла, модель накопителя должна была иметь 500 или более дисков по состоянию на конец второго квартала 2024 года и иметь более 100 000 накопленных дней использования в течение срока службы. Когда мы удалили те модели накопителей, которые не соответствовали критериям жизненного цикла, у нас осталось 283 065 накопителей, сгруппированных в 25 моделей для анализа, как показано в таблице ниже.

Возраст, AFR и змеи

Одной из истин в нашем бизнесе является то, что разные модели дисков выходят из строя с разной скоростью. Наша цель — разработать профиль отказов для данной модели диска с течением времени. Такой профиль может помочь оптимизировать наши стратегии замены и миграции дисков и в конечном итоге сохранить долговечность нашего сервиса облачного хранения.

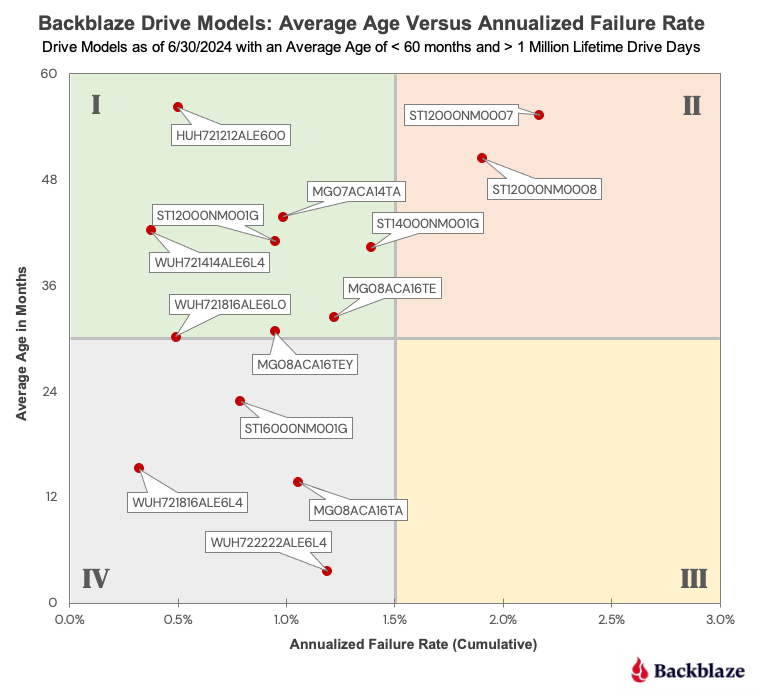

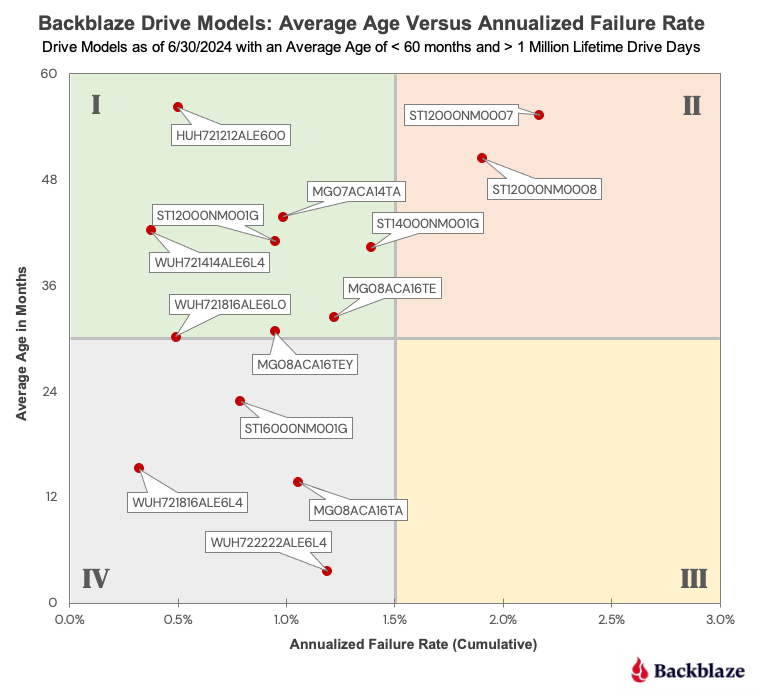

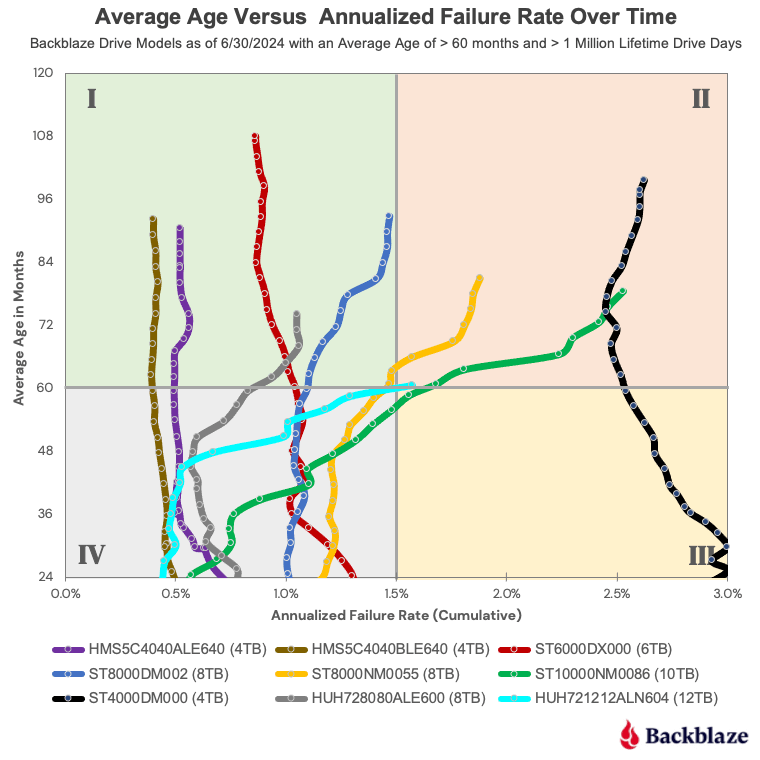

Для нашей группы дисков с данными мы рассмотрим изменения в годовом показателе годового ресурса (AFR) с течением времени для моделей дисков с не менее чем миллионом дней использования по состоянию на конец второго квартала 2024 года. Это дает нам 23 модели дисков для обзора. Мы разделим модели дисков на две группы: те, средний возраст которых составляет пять лет (60 месяцев) или меньше, и те, средний возраст которых превышает 60 месяцев. Почему именно этот предел? Это типичный гарантийный срок для жестких дисков корпоративного класса.

Начнем с построения графика текущего срока службы AFR для 14 моделей приводов, средний возраст которых составляет 60 месяцев или меньше, как показано на диаграмме ниже.

Давайте рассмотрим модели приводов, охарактеризовав четыре квадранта следующим образом:

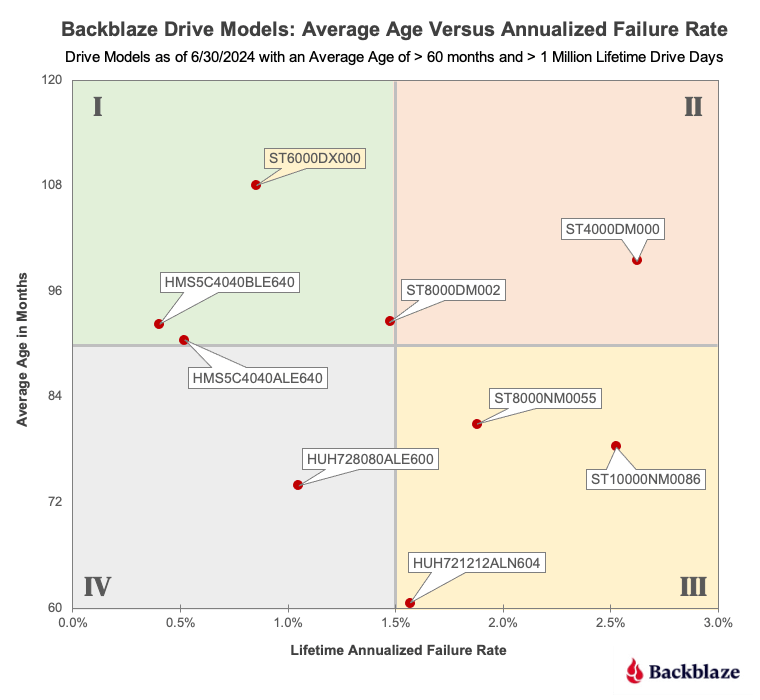

Есть девять моделей дисков, которые соответствуют критериям среднего возраста, включая диск Seagate 6 ТБ (желтый), диски которого были выведены из эксплуатации во втором квартале. Как вы можете видеть, модели дисков распределены по всем четырем квадрантам. Как и прежде, квадрант I содержит хорошие диски, квадранты II и III — диски, о которых нам нужно беспокоиться, а модели квадранта IV пока выглядят хорошо.

Если бы мы остановились здесь, мы могли бы решить, например, что диски Seagate емкостью 4 ТБ являются первыми в очереди на процесс миграции CVT, но не так быстро. Все эти модели дисков существуют уже не менее пяти лет, и у нас есть их показатели отказов с течением времени. Поэтому вместо того, чтобы полагаться только на момент времени, давайте посмотрим на изменение их показателей отказов с течением времени в приведенной ниже таблице.

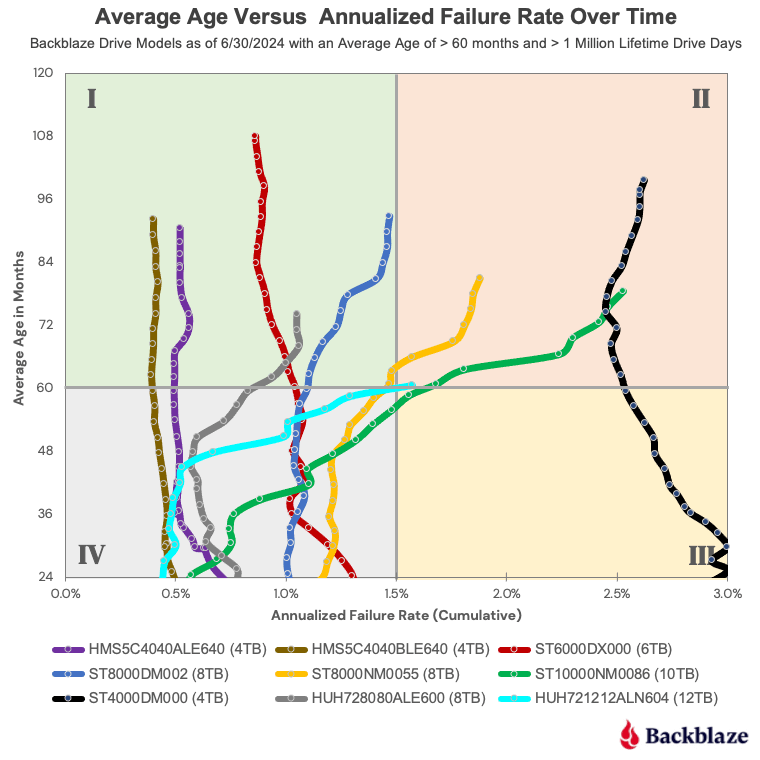

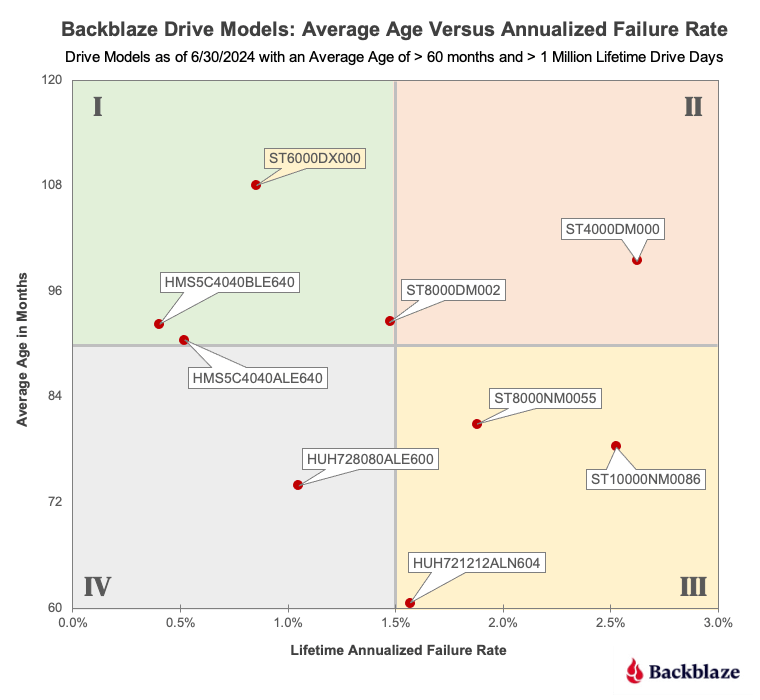

Диаграмма-змея, как мы ее называем, показывает частоту отказов в течение срока службы каждой модели привода с течением времени. Мы начали с 24 месяцев, чтобы сделать диаграмму менее запутанной. Независимо от этого, модели приводов сортируются либо в квадрант I, либо в квадрант II, как только их средний возраст превышает 60 месяцев. Давайте рассмотрим приводы в каждом из этих квадрантов.

Квадрант I: Пять из девяти моделей дисков находятся в квадранте I по состоянию на второй квартал 2024 года. Два диска HGST емкостью 4 ТБ (коричневая и фиолетовая линии), а также диск Seagate емкостью 6 ТБ (красная линия) имеют почти вертикальные линии, указывающие на то, что их показатели отказов были постоянны с течением времени, особенно после 60 месяцев эксплуатации. Такая продемонстрированная последовательность с течением времени — это профиль отказов, который нам нравится видеть.

Профиль отказов 8 ТБ Seagate (синяя линия) и 8 ТБ HGST (серая линия) менее постоянны, и каждый из них увеличивает свои показатели отказов по мере старения. В случае диска HGST срок службы AFR вырос примерно с 0,5% до 1,0% за 18-месячный период, начиная с 48 месяцев, прежде чем выровняться. Диску Seagate потребовалось около двух лет, начиная с 60 месяцев, чтобы вырасти с 1,0% до почти 1,5% до выровняться.

Квадрант II: Оставшиеся 4 модели дисков оказались в этом квадранте. Три из моделей, Seagate 8 ТБ (желтая линия), Seagate 10 ТБ (зеленая линия) и HGST 12 ТБ (бирюзовая линия), имеют схожие профили отказов. Все три достигли определенного момента в своем сроке службы, и их кривая начала изгибаться вправо. Другими словами, их показатели отказов со временем ускорились. Хотя Seagate 8 ТБ (желтый) показывает некоторые признаки выравнивания, все три модели будут внимательно следить и заменяться, если эта тенденция сохранится.

Также в квадранте II находится диск Seagate 4 ТБ (черная линия). Эта модель диска активно переносится и заменяется дисками емкостью 16 ТБ и более с помощью процесса CVT. Таким образом, трудно сказать, является ли почти вертикальный профиль отказов функцией процесса замены или выравнивания интенсивности отказов модели диска с течением времени. В любом случае ожидается, что миграция этой модели диска будет завершена в следующем квартале или двух.

Нормальный профиль отказа

Если бы нам пришлось выбрать одну из моделей дисков для представления нормального профиля отказов, это был бы Seagate емкостью 8 ТБ (синяя линия, модель: ST800DM002). Почему? Частота отказов в течение первых 60 месяцев постоянно составляла около 1,0%, прогнозируемого Seagate AFR. Через 60 месяцев AFR увеличился по мере старения диска, как и ожидалось. Вы могли бы подумать, что мы выберем профиль отказов одной из двух моделей дисков HGST емкостью 4 ТБ (коричневая и фиолетовая линии). «Проблема» в том, что их частота отказов значительно ниже любого опубликованного AFR любого производителя дисков. Хотя это здорово для нас, их годовые частоты отказов с течением времени, к сожалению, не являются нормальными.

Может ли ИИ помочь?

Идея использования методов AI/ML для прогнозирования сбоя накопителя существует уже несколько лет, но в качестве первого шага давайте посмотрим, является ли прогнозирование сбоя накопителя проблемой, достойной применения ИИ. Недавно мы провели вебинар « Использование данных облачного хранилища в приложениях и службах AL/ML », в котором мы изложили общие критерии, которые следует использовать при оценке необходимости использования AI/ML для решения определенной проблемы, в данном случае прогнозирования сбоя накопителя. Наиболее существенным критерием, который здесь применяется, является то, что ИИ лучше всего использовать для решения проблемы, для которой вы не можете последовательно применять набор правил для ее решения.

Модель обучается путем взятия исходных данных и применения алгоритма для итеративного объединения и взвешивания нескольких факторов. Выходными данными является модель, которая может быть использована для ответа на вопросы о предмете модели, в данном случае отказе диска. Например, мы обучаем модель, используя данные Drive Stats для данной модели диска за последний год. Затем мы задаем модели вопрос, используя ежедневную статистику SMART диска Z и связанную с ней информацию. Мы используем эти данные в качестве входных данных для модели, и хотя точного соответствия нет, модель будет использовать вывод для разработки ответа вероятности отказа диска Z с течением времени. Таким образом, кажется, что прогнозирование отказа диска было бы хорошим кандидатом для использования ИИ.

Неясно, можно ли применить то, что изучено для одной модели диска, к другой модели диска. Один взгляд на змеиную диаграмму выше наглядно демонстрирует проблему, поскольку профиль отказов для каждой модели диска отличается, иногда радикально отличается. Например, как вы думаете, можно ли обучить модель на дисках Seagate емкостью 4 ТБ (черная линия) и использовать ее для прогнозирования отказов дисков для любой из моделей дисков HGST емкостью 4 ТБ (фиолетовая и коричневая линии)? Ответ может быть «да», но это определенно не кажется вероятным.

При всем при этом, за эти годы было опубликовано несколько исследовательских работ и исследований, в которых пытались определить, можно ли использовать AI/ML для прогнозирования отказов дисков. Мы сделаем обзор этих публикаций в ближайшие пару месяцев и, надеемся, прольем свет на возможность использования AI для точного и своевременного прогнозирования отказов дисков.

Показатели отказов жестких дисков во втором квартале 2024 г.

Для нашего квартального анализа Q2 2024 мы исключаем из рассмотрения: модели приводов, которые имели не менее 100 приводов в эксплуатации на конец квартала, модели приводов, которые не накопили 10 000 или более дней привода в течение квартала, и отдельные приводы, которые превысили температурные характеристики производителя в течение своего срока службы. Удаленный пул составил в общей сложности 490 приводов, оставив нам 284 386 приводов, сгруппированных в 29 моделей приводов для нашего анализа Q2 2024.

В таблице ниже перечислены AFR и соответствующие данные для этих моделей приводов. Таблица отсортирована от большего к меньшему по размеру привода, а затем по AFR в пределах размера привода.

Заметки и наблюдения по статистике движения за второй квартал 2024 г.

Рост AFR: AFR для Q2 2024 года составил 1,71%. Это выше, чем в Q1 2024 года на 1,41%, но ниже, чем год назад (Q2 2023) на 2,28%. Хотя квартальный рост был немного неожиданным, ожидаются квартальные колебания AFR. Шестнадцать моделей приводов имели AFR 1,71% или ниже, а 13 моделей приводов имели AFR выше.

Два хороших нуля: во втором квартале 2024 года две модели дисков не имели ни одного отказа, Seagate на 14 ТБ (модель: ST14000NM000J) и Seagate на 16 ТБ (модель: ST16000NM002J). У обеих моделей относительно небольшое количество дисков и дней работы за квартал, поэтому их успех несколько сдержан, но у модели диска Seagate на 16 ТБ очень приличный показатель отказов за весь срок службы — 0,57%.

Еще один GOAT ушел: в первом квартале мы перенесли последний из наших 4-терабайтных дисков Toshiba. Во втором квартале мы перенесли последний из наших 6-терабайтных дисков, включая все 6-терабайтные диски Seagate, средний возраст которых составил девять лет (108 месяцев). Эта модель диска Seagate завершила свою карьеру в Backblaze с впечатляющим показателем AFR в 0,86%.

В настоящее время 4-терабайтный Seagate (модель: ST4000DM000) является нашей старейшей моделью дисков для хранения данных, средний возраст которой составляет 99,5 месяцев. Данные с этих дисков планируется перенести в течение следующего квартала или двух с помощью CVT, нашей внутренней системы миграции дисков. Они никогда не прослужат девять лет.

Клуб 10-летних: с переносом 6-терабайтных дисков Seagate, которым исполнилось 10 лет, мы задались вопросом: какой диск с данными является самым старым в эксплуатации? Ответ: диск HGST емкостью 4 ТБ (модель: HMS5C4040ALE640) со сроком службы 9 лет, 11 месяцев и 23 дня по состоянию на конец второго квартала. Увы, хранилище Backblaze, в котором находится этот диск, теперь переносится, как и многие другие диски со сроком службы более девяти лет. Посмотрим в следующем квартале, успеют ли они попасть в Клуб 10-летних до того, как будут выведены из эксплуатации.

Хотя нет ни одного диска с данными со сроком службы 10 лет, есть 11 загрузочных жестких дисков, которые превышают эту отметку. Фактически, один из них, диск WD емкостью 500 ГБ (модель: WD5000BPKT), прослужил более 11 лет. (Псс, не говорите об этом команде CVT.)

Сюрприз от HGST: на протяжении многих лет модели дисков HGST, которые мы использовали, работали очень хорошо. Поэтому, когда диск HGST емкостью 12 ТБ (модель: HUH721212ALN604) появился с AFR 7,17% во втором квартале, это стало новостью. Такие нехарактерные квартальные показатели отказов для этой модели на самом деле появились около года назад, хотя AFR 7,17% является самым большим квартальным значением на сегодняшний день. В результате AFR за весь срок службы вырос с 0,99% до 1,57% за последний год. Хотя AFR за весь срок службы не вызывает тревоги, мы обращаем внимание на эту тенденцию.

Показатели отказов жестких дисков за весь срок службы

По состоянию на конец второго квартала 2024 года мы отслеживали 284 876 работающих жестких дисков. Чтобы быть рассмотренной для обзора жизненного цикла, модель накопителя должна была иметь 500 или более дисков по состоянию на конец второго квартала 2024 года и иметь более 100 000 накопленных дней использования в течение срока службы. Когда мы удалили те модели накопителей, которые не соответствовали критериям жизненного цикла, у нас осталось 283 065 накопителей, сгруппированных в 25 моделей для анализа, как показано в таблице ниже.

Возраст, AFR и змеи

Одной из истин в нашем бизнесе является то, что разные модели дисков выходят из строя с разной скоростью. Наша цель — разработать профиль отказов для данной модели диска с течением времени. Такой профиль может помочь оптимизировать наши стратегии замены и миграции дисков и в конечном итоге сохранить долговечность нашего сервиса облачного хранения.

Для нашей группы дисков с данными мы рассмотрим изменения в годовом показателе годового ресурса (AFR) с течением времени для моделей дисков с не менее чем миллионом дней использования по состоянию на конец второго квартала 2024 года. Это дает нам 23 модели дисков для обзора. Мы разделим модели дисков на две группы: те, средний возраст которых составляет пять лет (60 месяцев) или меньше, и те, средний возраст которых превышает 60 месяцев. Почему именно этот предел? Это типичный гарантийный срок для жестких дисков корпоративного класса.

Начнем с построения графика текущего срока службы AFR для 14 моделей приводов, средний возраст которых составляет 60 месяцев или меньше, как показано на диаграмме ниже.

Давайте рассмотрим модели приводов, охарактеризовав четыре квадранта следующим образом:

- Квадрант I: Модели приводов в этом квадранте работают хорошо и имеют приемлемый показатель AFR менее 1,5%. Модели приводов справа в этом квадранте могут потребовать немного больше внимания в ближайшие месяцы, чем те, что слева.

- Квадрант II: Эти модели приводов имеют частоту отказов выше 1,5%, но все еще разумны при AFR около 2% за весь срок службы. Важно то, что AFR не увеличивается значительно со временем.

- Квадрант III: В этом квадранте сейчас нет приводов, но если бы они были, это не было бы причиной для беспокойства. Почему? Некоторые модели приводов испытывают более высокие показатели отказов на ранней стадии, а затем, следуя кривой ванны, их AFR падает по мере старения.

- Квадрант IV: Эти модели приводов только начинают развиваться и только начинают формировать свой профиль отказов, что на данный момент является положительным фактором.

Есть девять моделей дисков, которые соответствуют критериям среднего возраста, включая диск Seagate 6 ТБ (желтый), диски которого были выведены из эксплуатации во втором квартале. Как вы можете видеть, модели дисков распределены по всем четырем квадрантам. Как и прежде, квадрант I содержит хорошие диски, квадранты II и III — диски, о которых нам нужно беспокоиться, а модели квадранта IV пока выглядят хорошо.

Если бы мы остановились здесь, мы могли бы решить, например, что диски Seagate емкостью 4 ТБ являются первыми в очереди на процесс миграции CVT, но не так быстро. Все эти модели дисков существуют уже не менее пяти лет, и у нас есть их показатели отказов с течением времени. Поэтому вместо того, чтобы полагаться только на момент времени, давайте посмотрим на изменение их показателей отказов с течением времени в приведенной ниже таблице.

Диаграмма-змея, как мы ее называем, показывает частоту отказов в течение срока службы каждой модели привода с течением времени. Мы начали с 24 месяцев, чтобы сделать диаграмму менее запутанной. Независимо от этого, модели приводов сортируются либо в квадрант I, либо в квадрант II, как только их средний возраст превышает 60 месяцев. Давайте рассмотрим приводы в каждом из этих квадрантов.

Квадрант I: Пять из девяти моделей дисков находятся в квадранте I по состоянию на второй квартал 2024 года. Два диска HGST емкостью 4 ТБ (коричневая и фиолетовая линии), а также диск Seagate емкостью 6 ТБ (красная линия) имеют почти вертикальные линии, указывающие на то, что их показатели отказов были постоянны с течением времени, особенно после 60 месяцев эксплуатации. Такая продемонстрированная последовательность с течением времени — это профиль отказов, который нам нравится видеть.

Профиль отказов 8 ТБ Seagate (синяя линия) и 8 ТБ HGST (серая линия) менее постоянны, и каждый из них увеличивает свои показатели отказов по мере старения. В случае диска HGST срок службы AFR вырос примерно с 0,5% до 1,0% за 18-месячный период, начиная с 48 месяцев, прежде чем выровняться. Диску Seagate потребовалось около двух лет, начиная с 60 месяцев, чтобы вырасти с 1,0% до почти 1,5% до выровняться.

Квадрант II: Оставшиеся 4 модели дисков оказались в этом квадранте. Три из моделей, Seagate 8 ТБ (желтая линия), Seagate 10 ТБ (зеленая линия) и HGST 12 ТБ (бирюзовая линия), имеют схожие профили отказов. Все три достигли определенного момента в своем сроке службы, и их кривая начала изгибаться вправо. Другими словами, их показатели отказов со временем ускорились. Хотя Seagate 8 ТБ (желтый) показывает некоторые признаки выравнивания, все три модели будут внимательно следить и заменяться, если эта тенденция сохранится.

Также в квадранте II находится диск Seagate 4 ТБ (черная линия). Эта модель диска активно переносится и заменяется дисками емкостью 16 ТБ и более с помощью процесса CVT. Таким образом, трудно сказать, является ли почти вертикальный профиль отказов функцией процесса замены или выравнивания интенсивности отказов модели диска с течением времени. В любом случае ожидается, что миграция этой модели диска будет завершена в следующем квартале или двух.

Нормальный профиль отказа

Если бы нам пришлось выбрать одну из моделей дисков для представления нормального профиля отказов, это был бы Seagate емкостью 8 ТБ (синяя линия, модель: ST800DM002). Почему? Частота отказов в течение первых 60 месяцев постоянно составляла около 1,0%, прогнозируемого Seagate AFR. Через 60 месяцев AFR увеличился по мере старения диска, как и ожидалось. Вы могли бы подумать, что мы выберем профиль отказов одной из двух моделей дисков HGST емкостью 4 ТБ (коричневая и фиолетовая линии). «Проблема» в том, что их частота отказов значительно ниже любого опубликованного AFR любого производителя дисков. Хотя это здорово для нас, их годовые частоты отказов с течением времени, к сожалению, не являются нормальными.

Может ли ИИ помочь?

Идея использования методов AI/ML для прогнозирования сбоя накопителя существует уже несколько лет, но в качестве первого шага давайте посмотрим, является ли прогнозирование сбоя накопителя проблемой, достойной применения ИИ. Недавно мы провели вебинар « Использование данных облачного хранилища в приложениях и службах AL/ML », в котором мы изложили общие критерии, которые следует использовать при оценке необходимости использования AI/ML для решения определенной проблемы, в данном случае прогнозирования сбоя накопителя. Наиболее существенным критерием, который здесь применяется, является то, что ИИ лучше всего использовать для решения проблемы, для которой вы не можете последовательно применять набор правил для ее решения.

Модель обучается путем взятия исходных данных и применения алгоритма для итеративного объединения и взвешивания нескольких факторов. Выходными данными является модель, которая может быть использована для ответа на вопросы о предмете модели, в данном случае отказе диска. Например, мы обучаем модель, используя данные Drive Stats для данной модели диска за последний год. Затем мы задаем модели вопрос, используя ежедневную статистику SMART диска Z и связанную с ней информацию. Мы используем эти данные в качестве входных данных для модели, и хотя точного соответствия нет, модель будет использовать вывод для разработки ответа вероятности отказа диска Z с течением времени. Таким образом, кажется, что прогнозирование отказа диска было бы хорошим кандидатом для использования ИИ.

Неясно, можно ли применить то, что изучено для одной модели диска, к другой модели диска. Один взгляд на змеиную диаграмму выше наглядно демонстрирует проблему, поскольку профиль отказов для каждой модели диска отличается, иногда радикально отличается. Например, как вы думаете, можно ли обучить модель на дисках Seagate емкостью 4 ТБ (черная линия) и использовать ее для прогнозирования отказов дисков для любой из моделей дисков HGST емкостью 4 ТБ (фиолетовая и коричневая линии)? Ответ может быть «да», но это определенно не кажется вероятным.

При всем при этом, за эти годы было опубликовано несколько исследовательских работ и исследований, в которых пытались определить, можно ли использовать AI/ML для прогнозирования отказов дисков. Мы сделаем обзор этих публикаций в ближайшие пару месяцев и, надеемся, прольем свет на возможность использования AI для точного и своевременного прогнозирования отказов дисков.