Мы рады сообщить Вам, что с сегодняшнего дня к заказу доступна новая локация на карте предоставления услуг —

Польша. Наша новая локация имеет отличную связанность как с европейскими странами, так и другими материками.

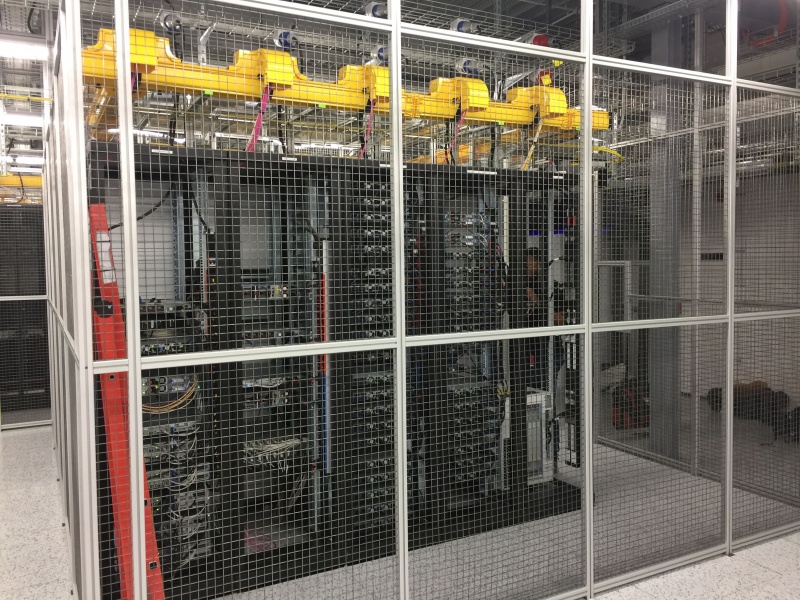

Оборудование находится в современном центре обработки данных Tier -3 в Варшаве.

Крупнейшая инфраструктура центров обработки данных в этой части Европы.

Доступность: 99.9%

Стандарты: ISO 9001, ISO / IEC 27001, DCOS-4

В новой локации доступны для заказа VPS и колокация.

Проверить скорость доступа от вас и к другим ресурсам можно с помощью Looking Glass

Способы оплаты: WMZ, Crypto (BTC, ETH, ...), PayPal, Payeer (Qiwi, YandexMoney, VISA/Master, Mir), InterKassa, Bank Transfer

bluevps.ru