travaux.ovh.net/?do=details&id=28247

Сегодня утром в 7:23 утра у нас был большой перерыв на нашем сайте в Страсбурге (SBG): перерыв в электроснабжении, который оставил три датацентра без электроэнергии в течение 3,5 часов. SBG1, SBG2 и SBG4. Вероятно, это самый худший сценарий, который мог произойти с нами.

Участок SBG питается от линии электропередачи 20 кВА, состоящей из 2 кабелей, каждая из которых обеспечивает 10MVA. 2 кабеля работают вместе и подключены к одному и тому же источнику и к тому же автоматическому выключателю в ELD (Strasbourg Electricity Networks). Сегодня утром один из двух кабелей был поврежден, и автоматический выключатель отключил питание от центра обработки данных.

Сайт SBG предназначен для работы без ограничений по времени на генераторах. Для SBG1 и SBG4 мы создали первую резервную систему из 2 генераторов по 2MVA каждый, сконфигурированных в N + 1 и 20kv. Для SBG2 мы создали 3 группы в конфигурации N + 1 1,4 МВА каждый. В случае сбоя внешнего источника питания высоковольтные ячейки автоматически перенастраиваются с помощью моторной отказоустойчивой системы. Менее чем за 30 секунд дата-центры SBG1, SBG2 и SBG4 могут восстановить мощность с 20 кВА. Чтобы сделать это переключение без отключения питания серверов, у нас есть источники бесперебойного питания (ИБП), которые могут поддерживать питание до 8 минут.

Сегодня утром моторная отказоустойчивая система работала не так, как ожидалось. Команда запуска генераторов резервного копирования не была предоставлена NSM. Это NSM (двигатель с нормальной аварийной ситуацией), предоставляемый поставщиком высоковольтных ячеек 20 кВ. Мы контактируем с производителем / супером, чтобы понять происхождение этой проблемы. Тем не менее, это дефект, который должен был быть обнаружен во время периодических испытаний на неисправность внешнего источника. Последний тест SBG для восстановления резервных копий был в конце мая 2017 года. Во время этого последнего теста мы приводили SBG только из генераторов в течение 8 часов без каких-либо проблем, и каждый месяц мы тестируем генераторы резервных копий бесплатно. И, несмотря на все это, этой системы было недостаточно, чтобы избежать сегодняшнего юрта.

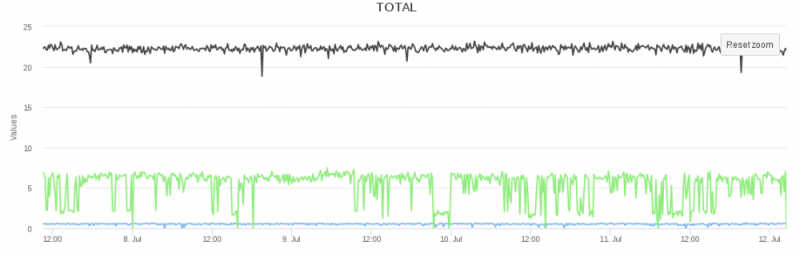

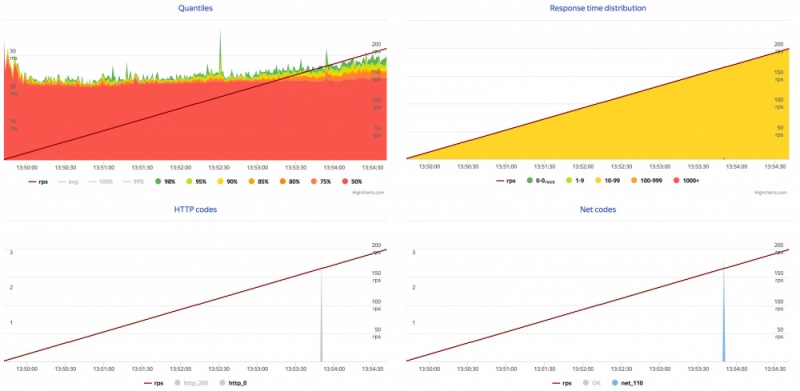

Примерно в 10 часов нам удалось переключить ячейки вручную и снова начать работу центра обработки данных с генераторами. Мы попросили ELD отсоединить неисправный кабель от высоковольтных ячеек и снова включить автоматический выключатель только с одним из двух кабелей и, следовательно, были ограничены 10MVA. Это действие было выполнено ELD, и мощность была восстановлена примерно в 10:30. Маршрутизаторы SBG были подключены к сети с 10:58 утра.

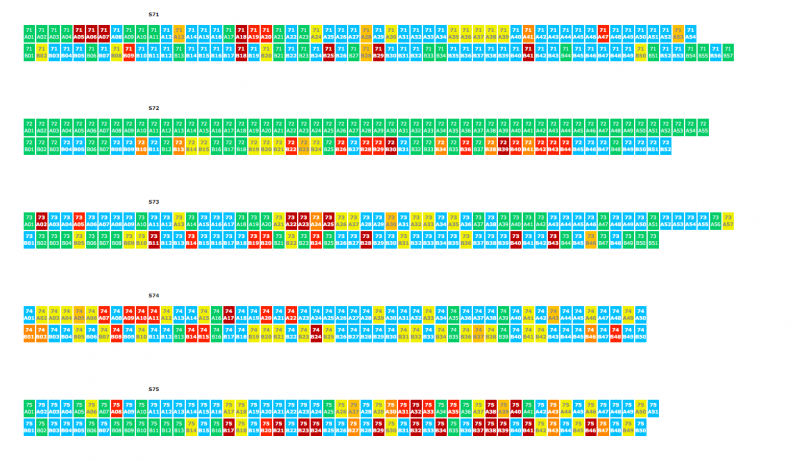

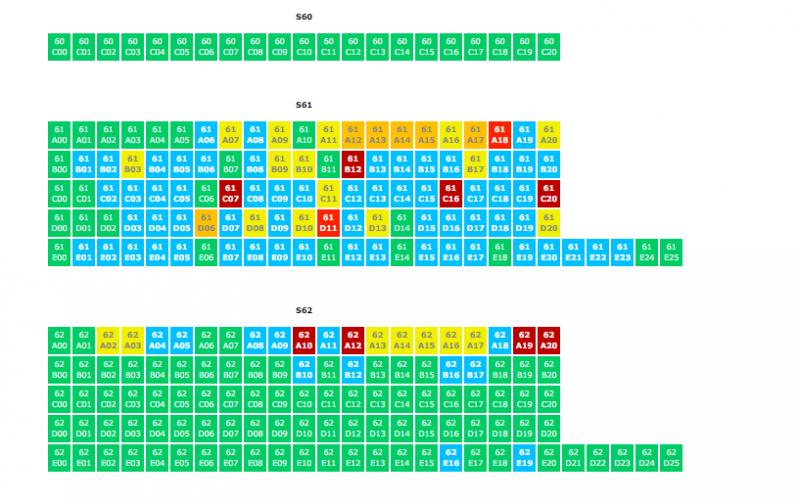

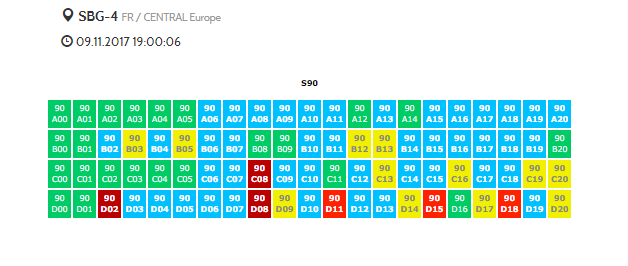

С тех пор мы работаем над перезагрузкой сервисов. Включение источника энергии с помощью энергии позволяет перезапускать серверы, но службы, запущенные на серверах, все равно необходимо перезапустить. Вот почему каждый сервис постепенно возвращается с 10:30. Наша система мониторинга позволяет нам узнать список успешно запущенных серверов и те, которые все еще имеют проблему. Мы вмешиваемся на каждом из этих серверов, чтобы выявить и решить проблему, которая препятствует ее перезапуску.

В 7:50 мы создали кризисную единицу в RBX, где мы централизовали информацию и действия всех вовлеченных команд. Грузовик из RBX был загружен запасными частями для SBG. Он прибыл в пункт назначения около 17:30. Чтобы помочь нашим местным командам, мы отправили команды из центра данных LIM, расположенного в Германии, и персонала из центра обработки данных RBX, все из которых были мобилизованы на месте с 16:00. В настоящее время более 50 техников работают в SBG, чтобы вернуть все услуги в Интернете. Мы готовим работу ночью и, если необходимо, завтра утром.

Во избежание катастрофических сценариев, таких как этот, за последние 18 лет OVH разработала электрические архитектуры, которые могут выдерживать всевозможные отключения электроэнергии. Каждый тест, каждый недостаток, каждая новая идея обогатили наш опыт, позволяющий нам сегодня создавать надежные центры обработки данных.

Так почему же этот провал? Почему SBG не выдержала простой сбой питания? Почему весь интеллект, который мы развили в OVH, не смог предотвратить эту катастрофу?

Быстрый ответ: энергосистема SBG унаследовала все недостатки дизайна, которые были результатом небольших амбиций, которые первоначально ожидались для этого местоположения.

Теперь вот длинный ответ:

Еще в 2011 году мы планировали развертывание новых центров обработки данных в Европе. Чтобы проверить аппетит для каждого рынка, с новыми городами и новыми странами, мы изобрели новую технологию развертывания центров обработки данных. С помощью этой внутренней технологии мы надеялись получить гибкость при развертывании центра обработки данных без ограничений времени, связанных с разрешениями на строительство. Первоначально мы хотели получить возможность подтвердить наши гипотезы, прежде чем делать значительные инвестиции в определенном месте.

Таким образом, в начале 2012 года мы запустили дата-центр SBG1 из морских контейнеров. Мы развернули 8 грузовых контейнеров, и SBG1 работает менее чем за 2 месяца. Благодаря этому сверхбыстрому развертыванию, которое заняло менее 6 месяцев, мы смогли подтвердить, что SBG действительно является стратегическим местом для OVH. К концу 2012 года мы решили построить SBG2, а в 2016 году мы начали строительство SBG3. Эти 2 датацентра не были построены из контейнеров, но были основаны на нашей технологии «Башня». Строительство SBG2 заняло 9 месяцев, и SBG3 будет запущен в производство в течение месяца. Чтобы решить проблему пространства, в начале 2013 года мы быстро построили SBG4, основываясь на разговорах о транспортировочных контейнерах.

Проблема заключалась в том, что, развертывая SBG1 с технологией, основанной на транспортных контейнерах, мы не смогли подготовить сайт для крупномасштабного проекта.

Мы допустили две ошибки:

- Мы не сделали сайт SBG совместимым с внутренними стандартами, для которых требуется 2 отдельных электропитания 20 кВ, как и все наши места постоянного тока, которые оснащены двумя электрическими каналами. Это крупные инвестиции в размере от 2 до 3 миллионов евро за электрическую подачу, но мы считаем, что это часть нашего внутреннего стандарта.

- Мы построили энергосистему SBG2, поместив ее в энергосистему SBG1 вместо того, чтобы сделать их независимыми друг от друга, как и во всех наших центрах обработки данных. В OVH каждый номер центра данных указывает, что силовая сеть не зависит от других датацентров. Где угодно, кроме сайта SBG.

Технология, основанная на транспортных контейнерах, использовалась только для сборки SBG1 и SBG4. На самом деле мы поняли, что контейнерный центр обработки данных не соответствует требованиям нашей торговли. На основе темпов роста SBG минимальный размер сайта должен быть равен нескольким центрам обработки данных и, следовательно, иметь общую емкость 200 000 серверов. Вот почему сегодня для развертывания нового датацентра мы используем только два типа конструкций, которые были широко протестированы и спланированы для крупномасштабных проектов и надежности:

- строительство 5-6-этажных башен (RBX4, SBG2-3, BHS1-2) для 40 000 серверов.

- приобретение зданий (RBX1-3,5-7, P19, GRA1-2, LIM1, ERI1, WAW1, BHS3-7, VIH1, HIL1) для 40 000 или 80 000 серверов.

Даже если этот утренний инцидент был вызван сторонним автоматом, мы не можем отрицать свою ответственность за провал. У нас есть кое-что, что нужно сделать для SBG, чтобы достичь того же уровня стандартов, что и другие OVH-сайты.

В течение дня мы приняли следующий план действий:

- установка второго, полностью отдельного электрического питания 20MVA;

- разделение силовой сети SBG2 от SBG1 / SBG4, а также отделение будущего SBG3 от SBG2 и SBG1 / SBG4;

- миграция клиентов SBG1 / SBG4 в SBG3;

- закрытие SBG1 / SBG4 и удаление транспортных контейнеров.

Это инвестиционный план в размере 4-5 миллионов евро, который мы запускаем завтра, и надеемся, что мы сможем восстановить доверие наших клиентов к SBG и OVH.

Наши команды по-прежнему трудно на работе, чтобы восстановить услуги последний из затронутых клиентов. Как только инцидент будет полностью разрешен, мы применим SLA по нашим контрактам.

Мы очень сожалеем об этом инциденте, и мы благодарим доверие, которое вы оказываете нам.