SBG1 61E, 62E

Диск, процессор, оперативная память работают хорошо, но нам нужно заменить материнскую плату всех серверов. Чтобы сделать это быстро, мы заменим их все на одну стандартную материнскую плату с Atom и позволим пользователям получать и переносить данные на другой сервер.

18-03-2021 log sbg

- В панели управления OVHcloud каждый затронутый клиент может просмотреть статус своих служб, расположенных в Страсбурге (SBG), как подробно описано в FAQ. => help.ovhcloud.com/en/faq/strasbourg-incident/how-can-get-overview-impact/

- Платформа сообщества OVHcloud теперь доступна для взаимодействия с членами сообщества и поддержки вас. => Https://community.ovh.com/en/

- Следуя протоколу безопасности, определенному для локальных операций: перезапуск будет выполняться комната за комнатой, проход за проходом и стойка за стойкой.

- Процедуры перезапуска сервисов будут сообщены затронутым клиентам по мере того, как подробности станут доступны в ближайшие дни.

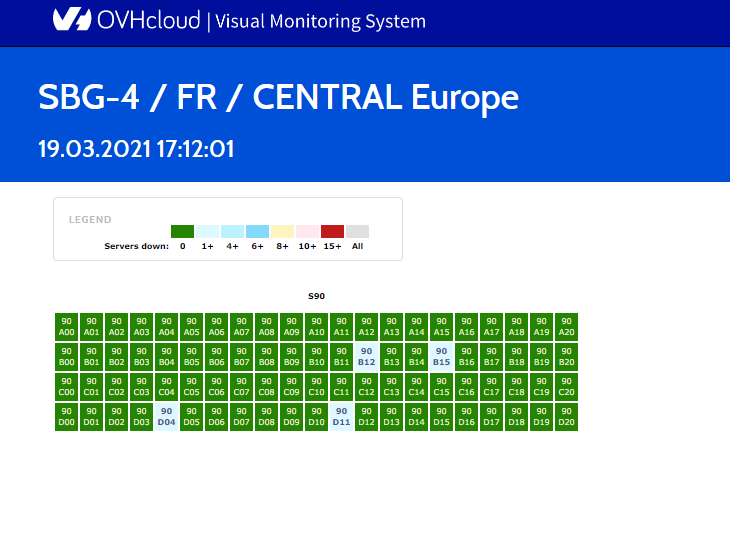

- Мониторинг перезапуска SBG по помещениям и запланированным стойкам в реальном времени доступен по адресу: status.ovh.com/vms/sbg/

SBG-1

- — Ситуация: центр обработки данных работает.

- — Электрический перезапуск: выполнен

- — Перезагрузка сети: завершена

- — Перезагрузка сервера: первые стойки успешно протестированы. Передача клиенту сегодня с видимостью статуса в его панели управления клиентами OVHcloud.

SBG-2

- — Ситуация: здание не используется. Проведена структурная экспертиза. Сайт защищен

- — Перезагрузка сервера: замена инфраструктуры в других центрах обработки данных Gravelines (GRA), Roubaix (RBX), Лондон (LON), Варшава (WAW), Франкфурт (FRA)

SBG-3

- — Ситуация: центр обработки данных работает. Серверы не повреждены.

- — Электрический перезапуск: выполнен

- — Перезагрузка сети: завершена

- — Перезапуск сервера: протестируйте сегодня на одной стойке и, если окончательно, предварительную оценку на пятницу, 19 марта, для постепенного перезапуска служб.

SBG-4

- — Ситуация: центр обработки данных работает. Все этажи и серверы в целости и сохранности.

- — Электрический перезапуск: выполнен

- — Перезагрузка сети: завершена

- — Перезапуск сервера: предварительное время прибытия: понедельник, 22 марта, для постепенного перезапуска служб.

- • Сегодня на территории мобилизовано 136 человек.

- o Составлен график ротации команд на предстоящие выходные.

- Очистка сайта:

- o Команды по уборке работают на SBG1 и SBG3 во всех пострадавших районах.

- o Некоторые серверы в SBG3 требуют специальной очистки перед их возвратом в эксплуатацию. Мы начали этот процесс.

Обновленная информация о поставках с 10 марта:

- — Оголенный метал

- + Bare Metal — серверы — Количество: 4519

- + NAS-HA — TB — Количество: 246

- — Публичное облако

- + VPS — VM — Количество: 12353

- — Размещенное частное облако

- + Хост — серверы — Количество: 485

- + Хранилище данных

- + Количество Zpool: 522

- + Объем ТБ: 3067

Сегодня произведено 400 серверов.

Чтобы следить за обновлениями об этой ситуации в режиме реального времени:

Нашим основным средством коммуникации остается «Статус задачи».

Статусные видео доступны здесь:

FR: twitter.com/olesovhcom/status/1370045226929299461

EN: twitter.com/olesovhcom/status/1370045891806175232

Аккаунт Октава Клабы в Twitter: twitter.com/olesovhcom

OVHcloud Twitter: twitter.com/ovhcloud

Наша миссия по-прежнему заключается в том, чтобы предоставлять нашим клиентам услуги высочайшего качества, поддерживать их онлайн-бизнес. и мы знаем, насколько это важно для них. Приносим искренние извинения за возможные неудобства, связанные с данной ситуацией. В настоящее время проводится расследование причин. Какой бы ни была причина инцидента, OVHcloud в настоящее время оценивает возможные технические и эксплуатационные меры, чтобы предложить решения всем затронутым клиентам.

VDS на OpenVZ больше не будут доступны к заказу

Мы долго взвешивали все «за» и «против» и всё-таки приняли решение отказаться от виртуализации OVZ. Под технологией OpenVZ (в нашем случае RHEL6 based) нельзя запустить многие современные ОС, а к 2024 году большинство ОС и вовсе перестанут поддерживаться этой виртуализацией.

C 31 марта тарифы на виртуализации OVZ станут недоступны для заказа как через личный кабинет, так и на сайте.

В связи с этим, также с 31 марта, пропадёт возможность заказа VDS Разминка, так так этот тариф построен на виртуализации OVZ.

Для действующих клиентов, заказавших серверы на виртуализации OpenVZ до 31 марта, условия не изменятся — вы всё так же сможете продолжать ими пользоваться и получать от нас техническую поддержку. Обратите внимание, что после удаления рабочего сервера, заказать повторно VDS с виртуализацией OVZ будет невозможно.

https://firstvds.ru

Как организовать работу в 1С

Виталий Никсенкин, добрый день. Сегодня хотим рассказать как организовать работу в 1С в разных условиях. А еще предложить варианты решений и способы экономии. Кратко и по делу :)

Узнать больше про аренду 1С

Условия: Кампания новая, лицензий 1С еще нет. Количество пользователей «плавающее».

Решение: Есть классический вариант в виде покупки лицензии 1С: Предприятие с его установкой на ПК или локальный сервер компании. Или более прогрессивный вариант — аренда программы 1С: Предприятие на пользователя с ежемесячной оплатой и удаленным доступом.

Плюсы аренды: Отсутствие единоразовых затрат на покупку лицензий, удобное управление количеством пользователей, удаленный доступ в 1С, доступен разный тип баз данных. Вы не покупаете и не обслуживаете оборудование для программы. Нет платежей за подписку ИТС, обновления входят в стоимость аренды.

Минусы аренды: Нельзя дорабатывать платформу. 1С предоставляется в стандартном виде с доступными конфигурациями: 1C: Бухгалтерия 8, 1С: ЗУП 8, 1С: Управление торговлей 8, Комплексная автоматизация.

Цена вопроса: От 1 202 руб./мес. за 1 пользователя.

rackstore.ru/arenda-1c.html

Облачные серверы для 1С

Условия: Есть своя лицензия 1С: Предприятие с файловым типом базы. Нужен удаленный доступ и стабильная работа в программе.

Решение: Потребуется сервер. Вы можете использовать собственный сервер и заниматься его администрированием и настройками доступа самостоятельно. Либо арендуете сервер для 1С в дата-центре. Поскольку база файловая, выгоднее будет обратить внимание на облачный сервер.

Плюсы аренды: Вы не покупаете, не настраиваете и не обслуживаете оборудование для платформы 1С. Лицензии Microsoft Windows Server уже включены в стоимость облачного сервера. Интернет в дата-центре резервируется, техподдержка решает вопросы работоспособности оборудования и сетей 24х7. Вы получаете удаленный доступ сотрудников и стабильную работу в 1С. При росте нагрузки или увеличении количества пользователей, можно добавить необходимые параметры сервера.

Минусы аренды: Для удаленного подключения потребуются пользовательские доступы RDP/RDS, которые нужно будет арендовать. Есть альтернативы, об этом расскажем ниже.

Цена вопроса: От 3 048 руб./мес. за облачный сервер.

rackstore.ru/arenda-servera-1c.html

Физические серверы для 1С

Условия: Есть своя лицензия 1С: Предприятие с клиент-серверным типом базы. Нужен удаленный доступ и стабильная работа в 1С.

Решение: Свой или арендованный сервер. Отличие от предыдущего примера будет только в лицензиях Microsoft SQL Server. Для физического сервера также потребуются лицензии Windows Server.

Цена вопроса: От 6 400 руб./мес. за физический сервер.

rackstore.ru/arenda-servera-1c.html

Сервер 1С на ОС Linux

Как и на чем можно сэкономить?

Обычно для 1С-сервера применяется операционная система Windows, хотя существует и альтернативный вариант — ОС Linux. Это бесплатная операционная система, которая поддерживает стабильную работу как файловой, так и клиент-серверной базы данных 1С: Предприятие.

Как это работает:

- Мы подбираем подходящий под задачи сервер.

- Устанавливаем вашу лицензию 1С: Предприятие, проводим все необходимые настройки сервера, переносим базы данных.

- Вы получаете ссылку для доступа к программе 1С через интуитивно понятный интерфейс.

- Спокойно работаете, получая все преимущества удаленного сервера, без затрат на лицензии Windows.

Серверы с быстрой установкой

В связи с пожаром в одном из дата центре OVH SBG2, были нарушены поставки серверов, серверы теперь могут устанавливаться до 10 дней, но следующие серверы вы можете заказать с быстрой установкой в течении дня.

Актуальные выделенные серверы с быстрой установкой в течении дня:

- FR,CA / E3-1245v2 [4c-8t] (3.8GHz) / 32 DDR3 1600 MHz / 2x 480 SSD — 3220р./месяц, 1980р. установка.

- FR / E5-2690v2 [10c-20t] (3.6GHz) / 64 GB DDR3 ECC 1866 MHz / 2x 480GB SSD — 7800р./месяц, 0р. установка.

- FR,CA / i7-4790K [4c-8t] (4,4GHz) / 16 GB DDR3 1600 MHz / 240 GB SSD — 2760р./месяц, 1980р. установка.

- FR,CA / i7-4790K [4c-8t] (4,4GHz) / 32 GB DDR3 1600 MHz / 240 GB SSD — 3565р./месяц, 1980р. установка.

- FR,PL / E3-1230v6 [4c-8t] (3.9GHz) / 32GB DDR4 ECC 2133MHz / 2×450 SSD NVMe — 6380р./месяц, 0р. установка.

- FR / E3-1230v6 [4c-8t] (3.9GHz) / 64GB DDR4 ECC 2133MHz / 2×450 SSD NVMe — 7920р./месяц, 0р. установка.

Anti-DDoS

Выделенные серверы под бэкапы:

- CA / Intel i3-2130 [2c-4t] (3.4GHz) / 8 GB DDR3 / 2 TB SATA — 1150р./месяц, 990р. установка.

- FR / Atom N2800 [2c-4t] (1.86GHz) / 4 GB DDR3 / 2 TB SATA — 920р./месяц, 990р. установка.

VPS:

- FR / i7-6700k [8vCore] / 16 ddr4 / 100 ГБ SSD — 2500р./месяц.

- FR / i7-6700k [8vCore] / 32 ddr4 / 200 ГБ SSD — 4950р./месяц.

- FI / Ryzen-9 3900 [24vCore] / 16 ddr4 / 400 NVME — 2650р./месяц.

- FI / Ryzen-9 3900 [24vCore] / 32 ddr4 / 800 NVME — 5150р./месяц.

Панель VMmanager 6.

Заказать на сайте: abcd.host/all-vps

Подробнее: abcd.host/servery-s-bystroj-ustanovkoj

Спасибо что остаетесь с нами!

С уважением, ABCD.HOST.

Идеальный бэкап за пять минут с ZFS

Программисты уже давно стараются использовать серьёзные production-ready решения для сохранения личных данных. Требования к инструментам растут, и если когда-то было принято держать домашние файлы на NAS и перекачивать снапшоты сервера через Rsync, то сейчас на передовой гораздо более сложные и функциональные проекты. Один из них — возможно, самый перспективный и мощный — файловая система ZFS. Оставив конкурента (btrfs) далеко позади и отстояв право на опен-сорс, она активно применяется как в хайлоаде, так и в личных системах хранения. Далее мы разберём её основные аспекты и за несколько минут поднимем рабочую систему бэкапа на удалённой VPSке. Поехали!

Кратко о ZFS

В ZFS заложена одна простая идея: должна существовать единая файловая система, заточенная под идеальное локальное хранение данных. Без лишних слоёв над LVM, без жёсткой привязки к железу, с максимальным покрытием задач прямо из коробки. И список возможностей у неё впечатляющий, вот самые базовые:

- Copy-on-write: данные никогда не перезаписываются, все старые версии доступны напрямую с диска, без необходимости использовать write-ahead log (и как следствие, сверять журналы). ZFS работает на дереве хэшей (Merkle tree), гарантирующее консистентность в обмен на затратные вычисления всего дерева. Таким образом, система прежде всего нацелена на максимальную сохранность всех данных.

- Так как любое сохранение состояния выполняется через атомарные транзакции, доступны «мгновенные снапшоты», которые действительно можно снимать с почти неограниченной частотой благодаря фиксированной стоимости. Не нужно проверять изменения всех данных, достаточно оперировать хэшами, за валидацию которых отвечает корневой блок дерева.

- Программный RAID через mirror или raidz — аналог RAID 5/6/7 — конфигурируется через виртуальные устройства (vdev). Нет зависимости от конкретного железа (не придётся бояться write-hole), можно выбрать между надёжностью и производительностью на одном и том же наборе дисков. А ещё при избыточности ZFS автоматически выполняет self-healing при случайных ошибках.

- Потоковое сжатие (LZ4/gzip) работает из коробки, не накладывая заметной задержки при записи. При этом слегка возрастающий расход процессорного времени компенсируется меньшей нагрузкой на диск, что полезно и для отказоустойчивости, и для вариативности в выборе дисков.

- Категория «прочее»: дедупликация данных (отключаемая), независимые вложенные файловые системы со своими настройками, недостижимый лимит на размер файлов (ZFS 128-битная), и самое главное для нас: встроенный трансфер снапшотов через команды send/receive с триггерами before и after.

Здесь, здесь и здесь можно почитать подробнее про внутреннее устройство ZFS, её историю и нюансы администрирования.

Если сравнивать возможности Rsync и кастомных скриптов для синхронизации с ZFS, у них не будет ни шанса. Комбинируем плюсы выше: инкрементальные консистентные бэкапы + мгновенные снапшоты + программный RAID + отправка бэкапов из коробки = идеальный инструмент, объединяющий в себе мощный функционал и огромную производительность. Чтобы добиться подобного привычным инструментарием, понадобится оркестрировать кучу сервисов с многочисленными точками отказа.

Настраиваем бэкап за чашкой кофе

Разнообразие возможных хост-систем огромно — ZFS поддерживается на FreeBSD, Linux, Windows и MacOS, и разобрать все возможные сценарии в рамках одной статьи невозможно, поэтому рассмотрим самый расхожий вариант. Дано: локальная машина или сервер на Ubuntu/CentOS с данными (скажем, веб или база данных), которые необходимо сохранить на удалённый сервер (VPS на тех же системах), с версионированием и быстрым откатом.

Важный момент: за рокетсайнс под капотом ZFS расплачивается высокими требованиями к ресурсам при использовании raidz на обычных SSD (и при больших объёмах хранения, само собой). Поэтому для комфортной работы и на хост-машине, и на VPS потребуется как минимум двухъядерный процессор с 4гб памяти.

В последних версиях Ubuntu:

sudo apt install -y zfsВ версиях до 20.04:

sudo apt-get install zfsutils-linuxCentOS 8

sudo dnf install https://zfsonlinux.org/epel/zfs-release.el8_3.noarch.rpm

gpg --import --import-options show-only /etc/pki/rpm-gpg/RPM-GPG-KEY-zfsonlinux

# в большинстве случаем также потребуется DKMS:

sudo dnf install epel-release

sudo dnf install kernel-devel zfsКоманда zfs без переданных аргументов откроет help:

missing command

usage: zfs command args ...

where 'command' is one of the following:

version

create [-p] [-o property=value] ... <filesystem>

create [-ps] [-b blocksize] [-o property=value] ... -V <size> <volume>

destroy [-fnpRrv] <filesystem|volume>

destroy [-dnpRrv] <filesystem|volume>@<snap>[%<snap>][,...]

destroy <filesystem|volume>#<bookmark>

snapshot [-r] [-o property=value] ... <filesystem|volume>@<snap> ...

rollback [-rRf] <snapshot>

clone [-p] [-o property=value] ... <snapshot> <filesystem|volume>

Создадим пулы на хосте и на сервере командой zpool:

zpool create rpool

zpool create hotspare mirror sda sdbСоздадим в пулах файловые системы:

zfs create rpool/send-remote

zfs create hotspare/receive-remoteЗапишем тестовый файл и создадим снапшот:

touch /rpool/send-remote/tmp

zfs snapshot rpool/send-remote@test0Как видно, сохранение не заняло и секунды.

Теперь реплицируем данные на сервер (предполагается, что авторизация в ssh по ключу настроена, о том как это сделать, можно прочитать здесь):

zfs send -R rpool/send-remote@test0 | ssh my-vps-host zfs receive -A hotspare/receive-remoteТеперь у нас есть реплика данных хоста. Обновим данные на хосте:

echo 123 > /rpool/send-remote/tmp

zfs snapshot rpool/send-remote@test1Теперь нам не нужно делать можную реплику, достаточно инкрементальной записи:

zfs send -i rpool/send-remote@test1 | ssh my-vps-host zfs receive -A hotspare/receive-remoteГотово! Данные сохраняются на сервере, остаётся только настроить отправку по вашим триггерам (и/или регулярную синхронизацию). Для этого есть много готовых скриптов (пример), но лучше разобраться и написать свой, используя документацию

Заключение

Полностью разобраться в ZFS — огромный труд, освоив который, можно смело идти админить кровавый энтерпрайз. Но не всегда нужно идти на такие жертвы, достаточно изучить базовый функционал и написать пару скриптов, чтобы добиться результата, который потребовал бы куда более неудобного управления цепочкой более простых, но узкоспециализированных инструментов.

https://macloud.ru

IPv6 - Интернет-протокол будущего

Вы слышали об IP-адресах и IPv6? Адрес Интернет-протокола (IP-адрес) — это цифровая метка для идентификации и определения местоположения сетевых устройств. Каждое устройство, подключенное к любой компьютерной сети, которая использует Интернет-протокол для связи, будет иметь IP-адрес.

Его основные цели — идентифицировать сетевой интерфейс устройства и указывать местоположение хоста в сети, тем самым устанавливая путь к этому хосту. Если вы умеете читать этот текст, значит, у вашего компьютера должен быть IP-адрес.

Инженерная группа Интернета (IETF) и IANA впервые развернули исходную версию Интернет-протокола в 1983 году и назвали ее Интернет-протоколом v4 (IPv4). Каждый адрес IPv4 имеет 32 бита, что ограничивает адресное пространство до 4 294 967 296 доступных адресов. Может показаться, что это много, и еще в 1983 году этого, безусловно, было достаточно для нужд всех пользователей Интернета. Но к концу 1990-х, по мере того, как использование Интернета росло и росло, стало очевидно, что это не так, и многие провайдеры интернет-услуг увидели быстрое исчерпание своих доступных адресов IPv4.

В Интернете появилось все больше и больше услуг, и изменилось использование Интернета в домашних хозяйствах. В то время как общего IP-пула было достаточно для большого числа пользователей, которые были подключены всего несколько часов в день с использованием коммутируемых соединений, ситуация изменилась по мере того, как широкополосные соединения становились все более и более распространенными. Будучи подключенным круглосуточно, каждому абоненту теперь требовался выделенный IP-адрес.

Все это побудило к созданию новой версии Интернет-протокола для решения этих проблем. Новая версия протокола была разработана и выпущена в 1998 году и получила название Internet Protocol v6 (IPv6). Размер IPv6-адреса составляет 128 бит, поэтому в его адресном пространстве имеется около 340 282 366 920 938 000 000 000 000 000 000 000 000 уникальных IP-адресов. Или записано цифрами: 340 триллионов, 282 миллиарда, 366 миллионов, 920 тысяч, 938 — с последующими 24 нулями. Достаточно, чтобы каждый атом на поверхности Земли имел IP-адрес. Предположим, этого нам хватит на некоторое время.

После нескольких лет тестирования новый протокол получил более широкое распространение в течение 2000 года. Поскольку последний доступный блок IPv4 / 8 был назначен в апреле 2018 года, мы сейчас находимся в ситуации, когда текущие потребности IPv4 могут быть удовлетворены только путем восстановления неиспользуемых подсетей или обмен IP-адресами между поставщиками услуг. Поскольку Интернет растет с каждым днем, полное исчерпание IPv4, без каких-либо адресов для обмена или подсетей для использования, не за горами. Вот почему в Scaleway мы поощряем использование IPv6 в ваших производственных системах. В этом сообщении блога мы объясним, как использовать IPv6 в различных продуктах Scaleway.

В Scaleway Elements и Scaleway Dedibox все виртуальные экземпляры и выделенные серверы совместимы с IPv6, а возможность подключения по IPv6 предоставляется без каких-либо дополнительных затрат.

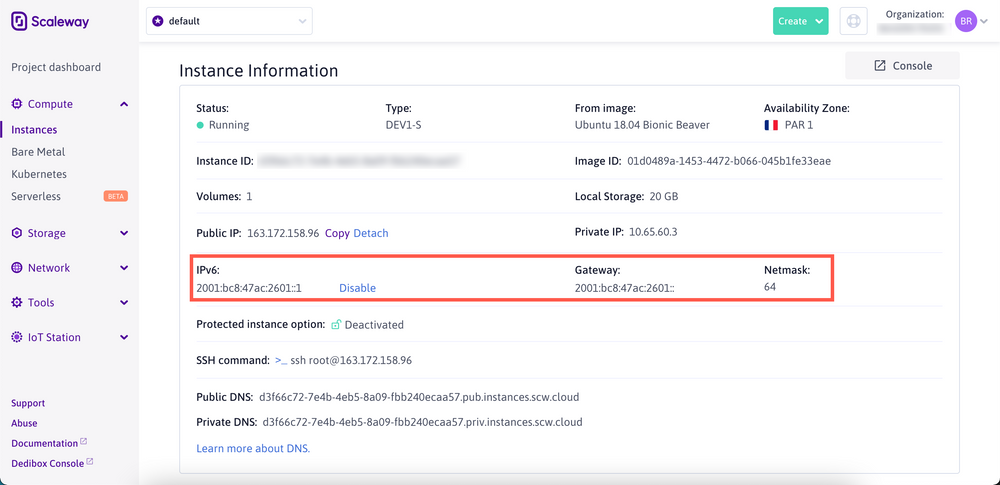

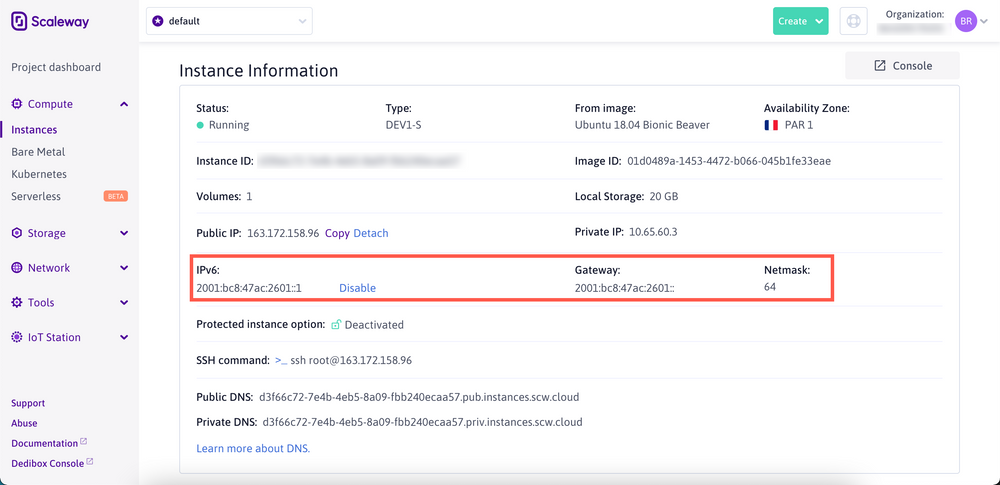

IPv6 в виртуальных экземплярах Scaleway Elements

Виртуальные экземпляры Scaleway Elements имеют подсеть / 64 IPv6 каждый. Подсеть статически маршрутизируется к виртуальному экземпляру, и по умолчанию для каждого из ваших экземпляров настроен один IPv6-адрес. Вы можете увидеть настроенные адреса IPv4 и IPv6 вашего экземпляра, а также сетевую маску и информацию о вашей подсети на странице информации об экземпляре каждого виртуального экземпляра:

IPv6 в частных сетях Scaleway на виртуальных экземплярах

Частная сеть на Scaleway Elements — это сеть Ethernet второго уровня, подобная локальной сети. Новый сетевой интерфейс с уникальным адресом управления доступом к среде передачи (MAC-адресом) настраивается на каждом экземпляре в частной сети. Это виртуальные, но полностью частные локальные сети, которые надежно соединяют ваши экземпляры, не открывая их публично. Каждая частная сеть полностью совместима с IPv6. Чтобы настроить IPv6 в своей частной сети, вы всегда должны использовать подсеть / 64, и мы рекомендуем использовать диапазон уникальных локальных адресов (ULA) fc00 :: / 7. Генераторы адресов ULA IPv6 широко доступны для создания персонализированного диапазона.

IPv6 на балансировщиках нагрузки Scaleway

Управляемые балансировщики нагрузки Scaleway — это высокодоступные и полностью управляемые экземпляры, которые распределяют рабочие нагрузки между вашими серверами. В настоящее время общедоступный интерфейс балансировщиков нагрузки поддерживает IPv4, и скоро появится поддержка IPv6. Однако вы уже можете использовать соединения IPv6 для связи между балансировщиком нагрузки и внутренними серверами. Это позволяет вам развертывать свои вычислительные экземпляры без необходимости в общедоступном IPv4, поэтому вы все равно можете помочь избежать исчерпания IPv4.

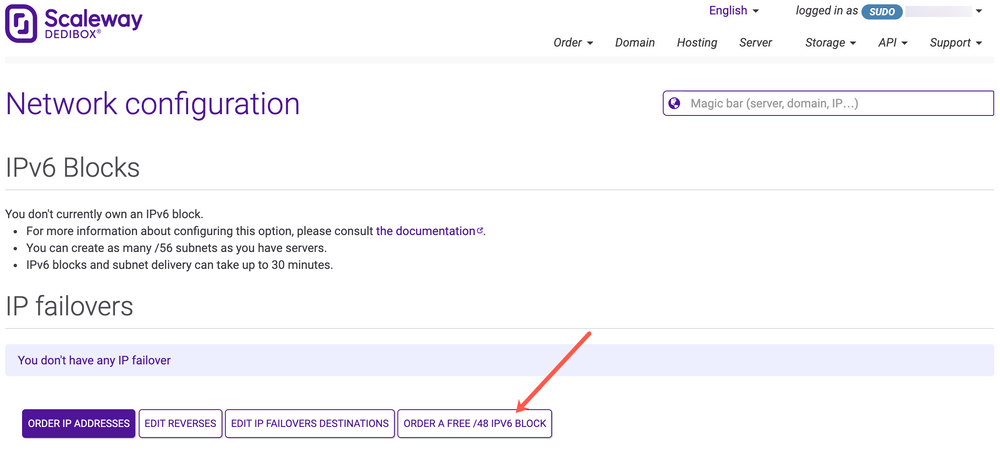

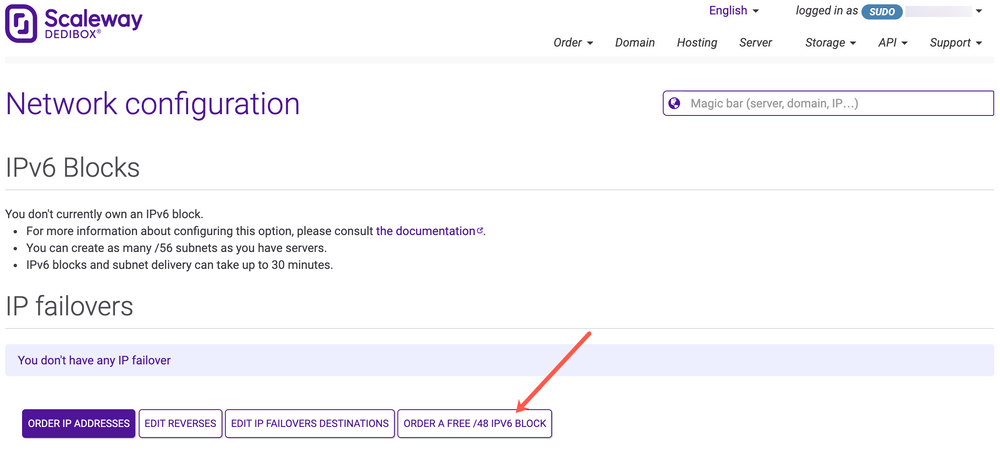

IPv6 в Scaleway Dedibox

В целях борьбы с полным исчерпанием доступных адресов IPv4 каждый клиент может запросить бесплатную подсеть IPv6 / 48 из консоли Scaleway Dedibox. Это обеспечивает теоретический максимум 18 446 744 073 709 551 616 адресов IPv6.

В отличие от IPv4, IPv6 не имеет маски подсети. Вместо этого используется длина префикса или, для краткости, «префикс». Длина префикса IPv6 работает аналогично CIDR (бесклассовая междоменная маршрутизация) в IPv4. Он определяет, сколько битов адреса определяют сеть, в которой он существует. Длина префикса может иметь любое значение от 1 до 128, но наиболее распространенные префиксы, используемые в сетях IPv6, кратны четырем.

Чтобы использовать подсеть IPv6 на нескольких выделенных серверах, вы можете разделить эту подсеть на более мелкие префиксы со следующими ограничениями:

Конфигурация подсети на вашем Dedibox выполняется с использованием клиента DHCPv6 и DUID подсети (уникальный идентификатор DHCP). DUID — это ваш «ключ» для подсети, и DHCP-сервер выделяет подсеть вашему компьютеру, сравнивая DUID со своей базой данных. Если соответствующая комбинация найдена, он доставляет данные конфигурации (адрес, время аренды, DNS-серверы и т. Д.) Клиенту.

Для получения дополнительной информации о настройке IPv6 на вашем сервере Dedibox, в том числе в различных дистрибутивах Linux и Windows, обратитесь к нашей специальной документации.

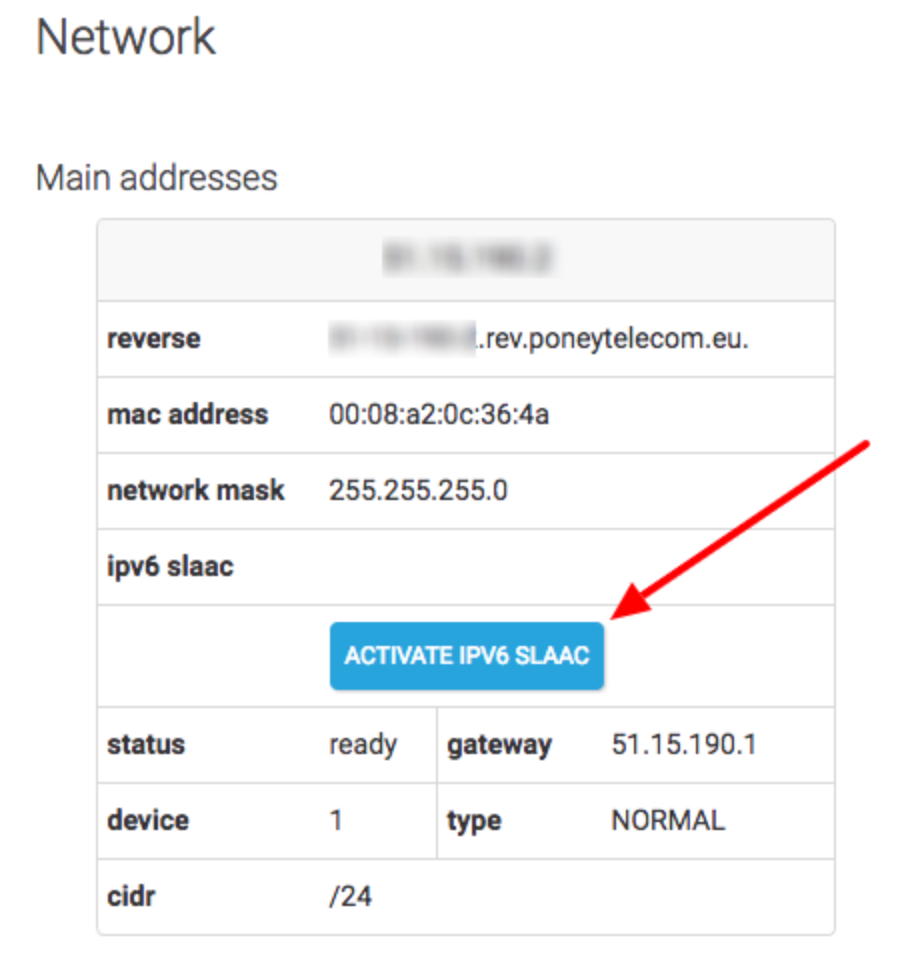

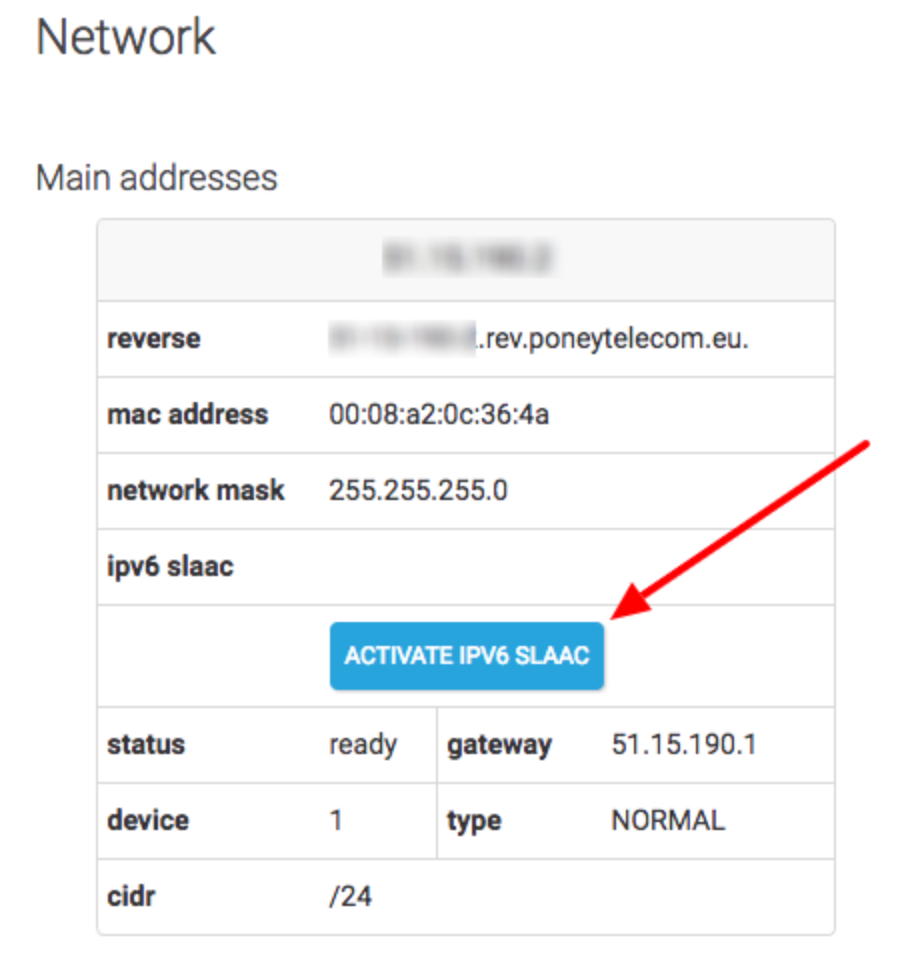

Автоконфигурация IPv6-адреса без сохранения состояния на серверах Dedibox

На нескольких выделенных серверах Dedibox вы также можете использовать автоконфигурацию адреса без сохранения состояния (SLAAC), что позволяет вашему серверу автоматически получать адрес IPv6. При использовании SLAAC сервер отправляет запрос маршрутизатора для получения префикса IPv6 с глобальной маршрутизацией, который генерирует полный адрес IPv6 на основе идентификатора сетевого интерфейса, известного как EUI-64. Это делается посредством обмена запросом маршрутизатора -> объявлением маршрутизатора. RA позволяет настроить маршрут по умолчанию и позволяет получить постоянно назначенный статический IPv6 для вашего Dedibox без какой-либо ручной настройки. Вы можете включить эту функцию прямо из консоли, нажав соответствующую кнопку:

IPv6 на серверах Scaleway Bare Metal Cloud

Серверы Scaleway Bare Metal Cloud имеют подсеть / 128 IPv6 и позволяют использовать один IPv6-адрес на вашем сервере. Этот IP-адрес настраивается автоматически во время установки машины, и каждый сервер Bare Metal Cloud поддерживает IPv6 без необходимости дополнительной настройки.

Его основные цели — идентифицировать сетевой интерфейс устройства и указывать местоположение хоста в сети, тем самым устанавливая путь к этому хосту. Если вы умеете читать этот текст, значит, у вашего компьютера должен быть IP-адрес.

Инженерная группа Интернета (IETF) и IANA впервые развернули исходную версию Интернет-протокола в 1983 году и назвали ее Интернет-протоколом v4 (IPv4). Каждый адрес IPv4 имеет 32 бита, что ограничивает адресное пространство до 4 294 967 296 доступных адресов. Может показаться, что это много, и еще в 1983 году этого, безусловно, было достаточно для нужд всех пользователей Интернета. Но к концу 1990-х, по мере того, как использование Интернета росло и росло, стало очевидно, что это не так, и многие провайдеры интернет-услуг увидели быстрое исчерпание своих доступных адресов IPv4.

В Интернете появилось все больше и больше услуг, и изменилось использование Интернета в домашних хозяйствах. В то время как общего IP-пула было достаточно для большого числа пользователей, которые были подключены всего несколько часов в день с использованием коммутируемых соединений, ситуация изменилась по мере того, как широкополосные соединения становились все более и более распространенными. Будучи подключенным круглосуточно, каждому абоненту теперь требовался выделенный IP-адрес.

Все это побудило к созданию новой версии Интернет-протокола для решения этих проблем. Новая версия протокола была разработана и выпущена в 1998 году и получила название Internet Protocol v6 (IPv6). Размер IPv6-адреса составляет 128 бит, поэтому в его адресном пространстве имеется около 340 282 366 920 938 000 000 000 000 000 000 000 000 уникальных IP-адресов. Или записано цифрами: 340 триллионов, 282 миллиарда, 366 миллионов, 920 тысяч, 938 — с последующими 24 нулями. Достаточно, чтобы каждый атом на поверхности Земли имел IP-адрес. Предположим, этого нам хватит на некоторое время.

После нескольких лет тестирования новый протокол получил более широкое распространение в течение 2000 года. Поскольку последний доступный блок IPv4 / 8 был назначен в апреле 2018 года, мы сейчас находимся в ситуации, когда текущие потребности IPv4 могут быть удовлетворены только путем восстановления неиспользуемых подсетей или обмен IP-адресами между поставщиками услуг. Поскольку Интернет растет с каждым днем, полное исчерпание IPv4, без каких-либо адресов для обмена или подсетей для использования, не за горами. Вот почему в Scaleway мы поощряем использование IPv6 в ваших производственных системах. В этом сообщении блога мы объясним, как использовать IPv6 в различных продуктах Scaleway.

В Scaleway Elements и Scaleway Dedibox все виртуальные экземпляры и выделенные серверы совместимы с IPv6, а возможность подключения по IPv6 предоставляется без каких-либо дополнительных затрат.

IPv6 в виртуальных экземплярах Scaleway Elements

Виртуальные экземпляры Scaleway Elements имеют подсеть / 64 IPv6 каждый. Подсеть статически маршрутизируется к виртуальному экземпляру, и по умолчанию для каждого из ваших экземпляров настроен один IPv6-адрес. Вы можете увидеть настроенные адреса IPv4 и IPv6 вашего экземпляра, а также сетевую маску и информацию о вашей подсети на странице информации об экземпляре каждого виртуального экземпляра:

IPv6 в частных сетях Scaleway на виртуальных экземплярах

Частная сеть на Scaleway Elements — это сеть Ethernet второго уровня, подобная локальной сети. Новый сетевой интерфейс с уникальным адресом управления доступом к среде передачи (MAC-адресом) настраивается на каждом экземпляре в частной сети. Это виртуальные, но полностью частные локальные сети, которые надежно соединяют ваши экземпляры, не открывая их публично. Каждая частная сеть полностью совместима с IPv6. Чтобы настроить IPv6 в своей частной сети, вы всегда должны использовать подсеть / 64, и мы рекомендуем использовать диапазон уникальных локальных адресов (ULA) fc00 :: / 7. Генераторы адресов ULA IPv6 широко доступны для создания персонализированного диапазона.

IPv6 на балансировщиках нагрузки Scaleway

Управляемые балансировщики нагрузки Scaleway — это высокодоступные и полностью управляемые экземпляры, которые распределяют рабочие нагрузки между вашими серверами. В настоящее время общедоступный интерфейс балансировщиков нагрузки поддерживает IPv4, и скоро появится поддержка IPv6. Однако вы уже можете использовать соединения IPv6 для связи между балансировщиком нагрузки и внутренними серверами. Это позволяет вам развертывать свои вычислительные экземпляры без необходимости в общедоступном IPv4, поэтому вы все равно можете помочь избежать исчерпания IPv4.

IPv6 в Scaleway Dedibox

В целях борьбы с полным исчерпанием доступных адресов IPv4 каждый клиент может запросить бесплатную подсеть IPv6 / 48 из консоли Scaleway Dedibox. Это обеспечивает теоретический максимум 18 446 744 073 709 551 616 адресов IPv6.

В отличие от IPv4, IPv6 не имеет маски подсети. Вместо этого используется длина префикса или, для краткости, «префикс». Длина префикса IPv6 работает аналогично CIDR (бесклассовая междоменная маршрутизация) в IPv4. Он определяет, сколько битов адреса определяют сеть, в которой он существует. Длина префикса может иметь любое значение от 1 до 128, но наиболее распространенные префиксы, используемые в сетях IPv6, кратны четырем.

Чтобы использовать подсеть IPv6 на нескольких выделенных серверах, вы можете разделить эту подсеть на более мелкие префиксы со следующими ограничениями:

- Столько префиксов / 56, сколько у вас выделенных серверов

- Столько префиксов / 64, сколько у вас есть резервных IP-адресов

Конфигурация подсети на вашем Dedibox выполняется с использованием клиента DHCPv6 и DUID подсети (уникальный идентификатор DHCP). DUID — это ваш «ключ» для подсети, и DHCP-сервер выделяет подсеть вашему компьютеру, сравнивая DUID со своей базой данных. Если соответствующая комбинация найдена, он доставляет данные конфигурации (адрес, время аренды, DNS-серверы и т. Д.) Клиенту.

Для получения дополнительной информации о настройке IPv6 на вашем сервере Dedibox, в том числе в различных дистрибутивах Linux и Windows, обратитесь к нашей специальной документации.

Автоконфигурация IPv6-адреса без сохранения состояния на серверах Dedibox

На нескольких выделенных серверах Dedibox вы также можете использовать автоконфигурацию адреса без сохранения состояния (SLAAC), что позволяет вашему серверу автоматически получать адрес IPv6. При использовании SLAAC сервер отправляет запрос маршрутизатора для получения префикса IPv6 с глобальной маршрутизацией, который генерирует полный адрес IPv6 на основе идентификатора сетевого интерфейса, известного как EUI-64. Это делается посредством обмена запросом маршрутизатора -> объявлением маршрутизатора. RA позволяет настроить маршрут по умолчанию и позволяет получить постоянно назначенный статический IPv6 для вашего Dedibox без какой-либо ручной настройки. Вы можете включить эту функцию прямо из консоли, нажав соответствующую кнопку:

IPv6 на серверах Scaleway Bare Metal Cloud

Серверы Scaleway Bare Metal Cloud имеют подсеть / 128 IPv6 и позволяют использовать один IPv6-адрес на вашем сервере. Этот IP-адрес настраивается автоматически во время установки машины, и каждый сервер Bare Metal Cloud поддерживает IPv6 без необходимости дополнительной настройки.

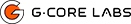

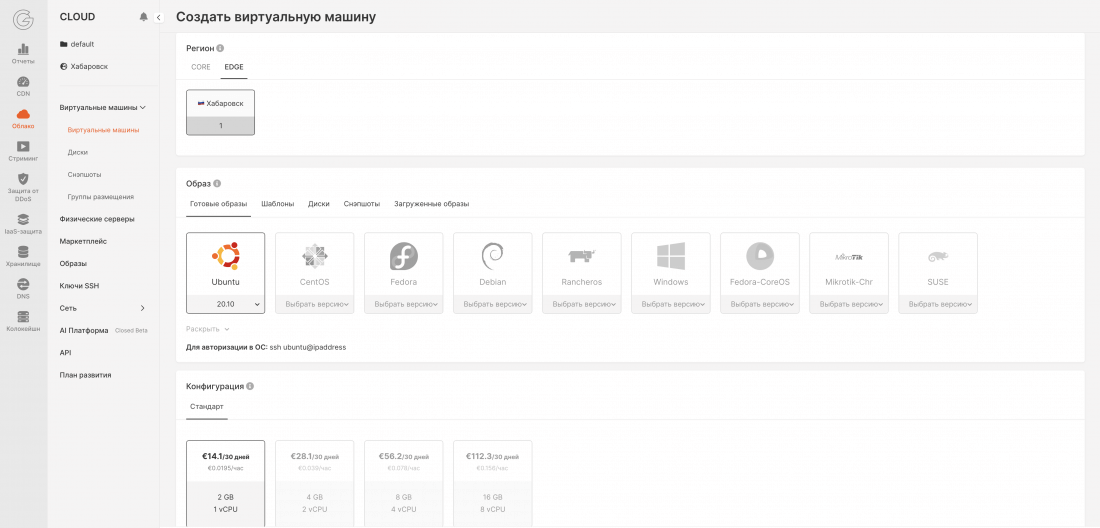

Локация Cloud в Хабаровске и другие новости G-Core Labs

Как интегрировать видеозвонки в платформу для офлайн- и онлайн-мероприятий: опыт Momento Solutions

gcorelabs.com/ru/cases/momentosolutions

Новый регион G-Core Labs Cloud: Хабаровск

Точки присутствия G‑Core Labs Cloud уже открыты в Люксембурге, Москве, Манассасе и Сингапуре.

Мы запускаем новую edge-локацию нашего облака в Хабаровске.

Новая точка поможет развивать бизнес на Дальнем Востоке России и в азиатском регионе в целом, сократить задержки для конечных пользователей.

Масштабируйте IT-инфраструктуру, ускоряйте процессы разработки, тестирования и вывода новых продуктов на рынок с помощью наших сервисов.

БЛИЖАЙШИЕ ПЛАНЫ

Скоро мы добавим автоматическое развёртывание Kubernetes-кластеров для оркестрации контейнеров.

Следующую edge-локацию мы планируем запустить в Амстердаме.

https://gcorelabs.com

17-03-2021 log sbg

Статус услуги

Коммерческие действия

Обновленная информация о поставках с 10 марта:

Облачная вселенная:

В связи с текущим спросом сроки доставки наших услуг для изделий из чистого металла могут быть дольше, чем обычно. Наши команды полностью мобилизованы, и мы прилагаем все усилия, чтобы доставить их нашим клиентам как можно быстрее, особенно всем пострадавшим клиентам.

С другой стороны, услуги Public Cloud, Web Cloud и VPS предоставляются в обычном режиме во всех центрах обработки данных.

- Октав Клаба, основатель OVHcloud, выпустил новое видео о ситуации в Страсбурге (SBG). => twitter.com/olesovhcom/status/1371934994751500288

- В Панели управления каждый затронутый клиент может просмотреть статус своих услуг, расположенных в Страсбурге (SBG), как подробно описано в FAQ. => help.ovhcloud.com/en/faq/strasbourg-incident/how-can-get-overview-impact/

- Платформа сообщества OVHcloud теперь доступна для взаимодействия с членами сообщества и поддержки вас.

- Следуя протоколу безопасности, определенному для локальных операций: перезапуск будет выполняться комната за комнатой, от прохода к проходу и стойка за стойкой.

- Процедуры перезапуска служб будут сообщены затронутым клиентам по мере того, как подробности станут доступны в ближайшие дни.

- Мониторинг перезапуска SBG в режиме реального времени по помещению и запланированной стойке через: travaux.ovh.net/vms/index_sbg1.html

- Постепенное обновление страницы состояния для служб и резервных копий в Страсбурге (SBG), начиная с сегодняшнего дня, доступно через FAQ.

- Обновление и отслеживание процента перезапущенных сервисов для каждого центра обработки данных, запланированных в интерфейсе «Состояние задачи» в ближайшие дни.

- Создана новая форма заказа (для Bare Metal Cloud), чтобы предлагать заинтересованным клиентам услуги, аналогичные тем, которые они имели на сайте в Страсбурге (SBG).

Коммерческие действия

- Все заинтересованные клиенты получили в начале недели сообщение о коммерческих мерах, которые будут применяться к их ситуации. Для клиентов, которые не получили электронное письмо, процедура была указана в FAQ.

- Для каждого заинтересованного клиента:

- Уведомление о приостановке выставления счетов за март было добавлено в Панель управления клиентов.

- Указаны коммерческие акции, подробности которых будут сообщены на этой неделе.

Обновленная информация о поставках с 10 марта:

Облачная вселенная:

- — Оголенный метал

- + Bare Metal — серверы — Количество: 4200

- + NAS-HA — TB — Количество: 276

- — Публичное облако

- + VPS — VM — Количество: 11998

- — Размещенное частное облако

- + Хост — серверы — Количество: 434

- + Хранилище данных

- + Количество Zpool: 466

- + Объем ТБ: 2950

Сегодня произведено 400 серверов.

В связи с текущим спросом сроки доставки наших услуг для изделий из чистого металла могут быть дольше, чем обычно. Наши команды полностью мобилизованы, и мы прилагаем все усилия, чтобы доставить их нашим клиентам как можно быстрее, особенно всем пострадавшим клиентам.

С другой стороны, услуги Public Cloud, Web Cloud и VPS предоставляются в обычном режиме во всех центрах обработки данных.