Как настроить VLAN на двух и более выделенных серверах

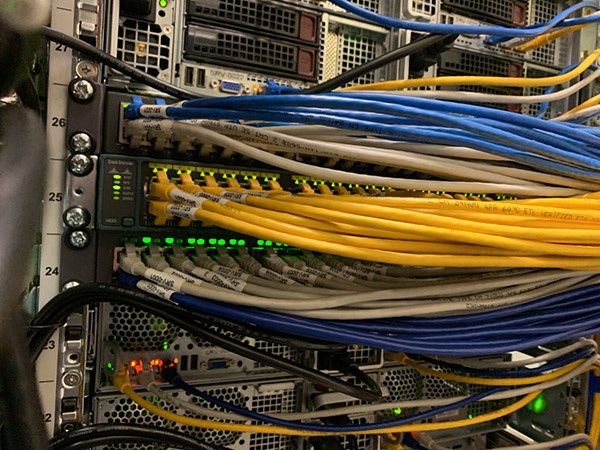

VLAN — это функция сетевого оборудования, которая помогает объединять компьютеры (серверы), подключенные к разным коммутаторам доступа, в единую локальную вычислительную сеть. Причем, изолированную от других сетей. Похоже на создание закрытого чата для друзей, живущих в разных подъездах. Как один секретный чат не виден другому, так и компьютеры, подключенные к одной виртуальной сети будут невидимы для компьютеров другой.

Таким образом, при подключении VLAN повышается уровень безопасности при передаче данных, а перехват трафика другими пользователями становится невозможным. И это ещё не все плюсы. Так на интерфейсах, принадлежащих VLAN, вы можете использовать любые IP-адреса, не боясь конфликтов с другими клиентами. Кроме того, VLAN позволяет объединять серверы из разных помещений дата-центра в группы по нужным вам критериям — и для каждой виртуальной сети могут действовать свои требования и правила.

Посмотреть, что за услуга VLAN и сколько стоит.

1dedic.ru/additional/vlan

ВЫ ПРИОБРЕЛИ УСЛУГУ, ЧТО ДАЛЬШЕ

Чтобы объединить выделенные серверы на Linux или на Windows в локальную виртуальную сеть, первое, что вы должны сделать, — это составить запрос в службу технической поддержки на подключение выделенных серверов вторыми сетевыми адаптерами в коммутатор.

Второй шаг — настроить сетевую адресацию. В качестве настроек для сетевого адаптера можно использовать любые IP-адреса из диапазона серых подсетей. «Серыми», частными или внутрисетевыми называют IP-адреса, которые не используется в сети Интернет.

Например, следующие:

- 10.0.0.0/8;

- 172.16.0.0/12;

- 192.168.0.0/16.

После того, как вы определились с IP-адресами, можно приступать к настройке.

Подробнее

1dedic.ru/articles/kak-nastroit-vlan-na-dvuh-i-bolee-vydelennyh-serverah