Снова в школу новости из Scaleway Dedibox

Каталог Dedibox

С одним из крупнейших каталогов выделенного сервера, вы можете выбрать сервер, который наилучшим образом соответствует вашим потребностям для нового сезона 2019 Нашего Начала диапазона для начинающих, Pro для производства, Core и хранить диапазоны для большей производительности или хранений предназначены для всех видов, в Scaleway Dedibox вы найдете идеальный сервер по лучшей цене / соотношение и с высокой стабильностью.

www.online.net/en/dedicated-servers

Новинка: Bare Metal Dedibox в бета-версии

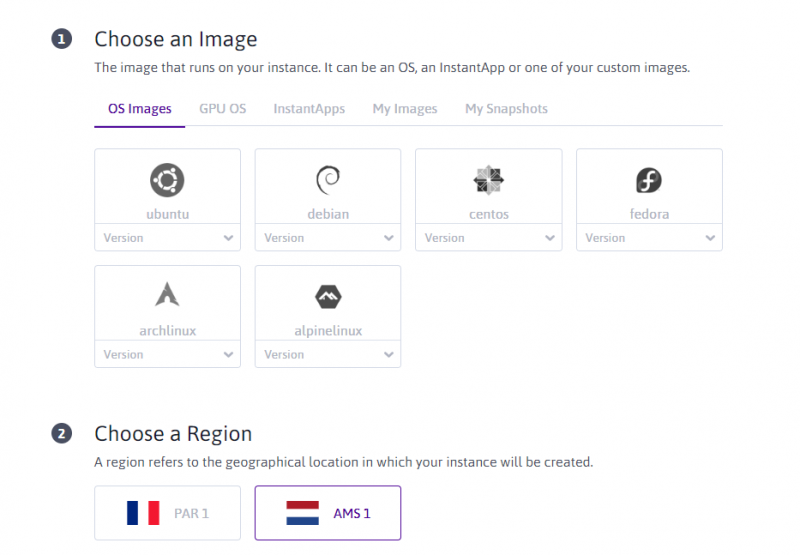

Bare Metal Dedibox — это новое поколение выделенных серверов Scaleway со 100% выделенным оборудованием, которое оплачивается по часам, и теперь оно находится в публичной бета-версии:

- 3 диапазона серверов: общего назначения, высокая загрузка ЦП и высокая оперативная память

- 4 высококлассных предложения с программным обеспечением RAID1

- дистрибутивы Ubuntu, Debian и CentOS

- KVM IP удаленный доступ, режим восстановления, удаленная загрузка с ISO

- Защита от DDoS

Все, что вам нужно сделать, это подключиться к консоли: console.scaleway.com, а затем перейти к Bare Metal Dedibox.