Как установить DeepSeek AI на серверах Contabo: пошаговое руководство с изображением в один клик и Ollama

DeepSeek AI

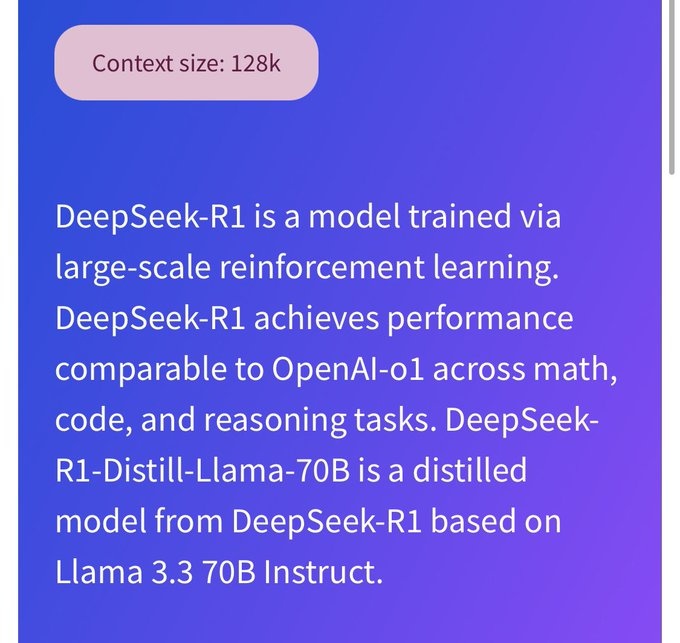

DeepSeek AI представляет собой большой шаг вперед в моделях языка с открытым исходным кодом, предоставляя мощные возможности рассуждения без специализированного оборудования GPU. В сочетании с Ollama, легким инструментом управления моделями, он обеспечивает практическое решение для локального запуска моделей AI с лучшей конфиденциальностью и контролем производительности.

Почему стоит использовать самостоятельный хостинг DeepSeek?

Запуск DeepSeek на вашем собственном сервере Contabo дает вам явные преимущества конфиденциальности и безопасности. Это стало еще важнее после того, как исследователи безопасности недавно обнаружили незащищенную базу данных DeepSeek, которая раскрыла конфиденциальную информацию, включая историю чатов, ключи API и данные бэкэнда. Самостоятельный хостинг хранит всю информацию в вашей контролируемой инфраструктуре, предотвращая такие уязвимости, а также обеспечивая соответствие GDPR и HIPAA.

Революционная производительность на базе процессора

Модели DeepSeek могут эффективно работать также на системах на базе CPU. Это устраняет необходимость в дорогостоящем оборудовании GPU, делая расширенный ИИ доступным большему количеству пользователей для их целей. Используете ли вы модель 1.5b или 14b, DeepSeek заявляет, что работает на стандартных конфигурациях серверов, включая виртуальные частные серверы.

Локальный контроль и гибкость для целей тестирования

Самостоятельное размещение дает вам полный доступ к API и полный контроль над настройками модели. Эта настройка позволяет запускать тесты и песочницы для пользовательских реализаций, улучшенных мер безопасности и плавной интеграции с существующими системами. Природа открытого исходного кода DeepSeek обеспечивает прозрачность и позволяет вносить улучшения, инициированные сообществом, что делает его отличным выбором для организаций, которые ценят как производительность, так и конфиденциальность.

Пошаговое руководство: установка DeepSeek на Contabo

Отказ от ответственности: Мы рекомендуем наши модели VDS M-XXL, которые обеспечивают необходимые ресурсы для оптимальной производительности. Планы с более низкими характеристиками могут быть пригодными для использования, но определенно повлияют на производительность LLM.

Эксклюзив: предварительно настроенное изображение DeepSeek от Contabo

Contabo лидирует в отрасли как первый и единственный поставщик, предлагающий готовый образ с DeepSeek из коробки. Это решение устраняет сложные процедуры настройки и позволяет начать работу в течение нескольких минут. Наш предварительно настроенный образ обеспечивает оптимальные настройки производительности и возможности немедленного развертывания.

Выберите предварительно настроенный образ DeepSeek во время настройки сервера:

- Перейдите к шагу 4 «Изображение» в Конфигураторе продукта.

- Выберите изображение DeepSeek из доступных вариантов на вкладке «Популярное».

- Продолжайте настройку сервера в соответствии с вашими требованиями для целей тестирования.

Этот предварительно настроенный образ обеспечивает возможности немедленного развертывания и дает вам пространство для дальнейшего тестирования оптимизации производительности модели. После того, как ваш сервер будет подготовлен, вы можете начать использовать DeepSeek сразу же без дополнительных шагов по установке.

Ручная установка

Для пользователей, предпочитающих индивидуальную настройку, процесс ручной установки прост, но требует нескольких шагов. Давайте разберем его:

Перед установкой DeepSeek на сервер Contabo убедитесь, что у вас установлена Ubuntu 22.04 LTS.

Сначала убедитесь, что ваша система обновлена:

sudo apt update && sudo apt upgrade -y

Затем установите Ollama — легкий инструмент управления моделями, который будет управлять вашим развертыванием DeepSeek:

curl -fsSL https://ollama.com/install.sh | sh

После установки запустите службу Ollama, чтобы подготовиться к развертыванию модели:

sudo systemctl start ollama

Теперь вы готовы вытащить выбранную вами модель DeepSeek. Версия 14b предлагает отличный баланс производительности и использования ресурсов:

ollama pull deepseek-r1:14b

Развертывание модели

После завершения установки вы можете начать использовать DeepSeek. Запустите модель напрямую для интерактивного использования:

ollama run deepseek-r1:14b

Для доступа к API, который обеспечивает интеграцию с вашими приложениями:

ollama serve

Шаги проверки

Проверьте установку с помощью этих простых проверок:

# Check model status

ollama list

# Run a simple test

ollama run deepseek-r1:14b "Hello, please verify if you're working correctly."

Руководство по распределению ресурсов

Управление памятью является ключом к оптимальной производительности. Всегда выделяйте в два раза больше размера модели в ОЗУ для бесперебойной работы. Например, модель 14b (9 ГБ) лучше всего работает с ОЗУ не менее 20 ГБ для выполнения задач загрузки и обработки модели. Что касается хранилища: выбирайте диски NVMe для более быстрой загрузки модели.

Почему стоит выбрать Contabo для размещения DeepSeek в целях тестирования

Серверы Contabo обеспечивают высокопроизводительное хранилище NVMe, существенный ежемесячный трафик (32 ТБ) и конкурентоспособные цены без скрытых платежей. Имея центры обработки данных в 12 местах в 9 регионах, охватывающих 4 континента, включая несколько площадок в Европе, США (Нью-Йорк, Сиэтл, Сент-Луис), Азии (Сингапур, Токио), Австралии (Сидней) и Индии, Contabo предлагает глобальный охват для ваших развертываний ИИ. Сочетание надежного оборудования и экономически эффективных планов делает его идеальным выбором для самостоятельных развертываний ИИ.

Заключительные мысли

Сочетание эффективных моделей DeepSeek и надлежащей серверной инфраструктуры открывает новые возможности для организаций, ценящих конфиденциальность данных и производительность. Оставайтесь с нами на связи, поскольку мы продолжаем развиваться в этой области — этот предварительно настроенный образ — только начало наших обязательств по повышению доступности и управляемости передовых технологий ИИ.

contabo.com