Новости

- Virtual Router 99 ₽/месяц

- Private Network 99 ₽/месяц

- Public IP 69 ₽/месяц

- Public Floating IP 99 ₽/месяц

18.03.2025

Повышение цен на тарифы

Уважаемые клиенты, с 24 марта изменится стоимость следующих планов:

- 1-й тариф – 59 ₽

- 2-й тариф – 99 ₽

- 3-й тариф – 299 ₽

03.10.2024

Мы — RocketCloud!

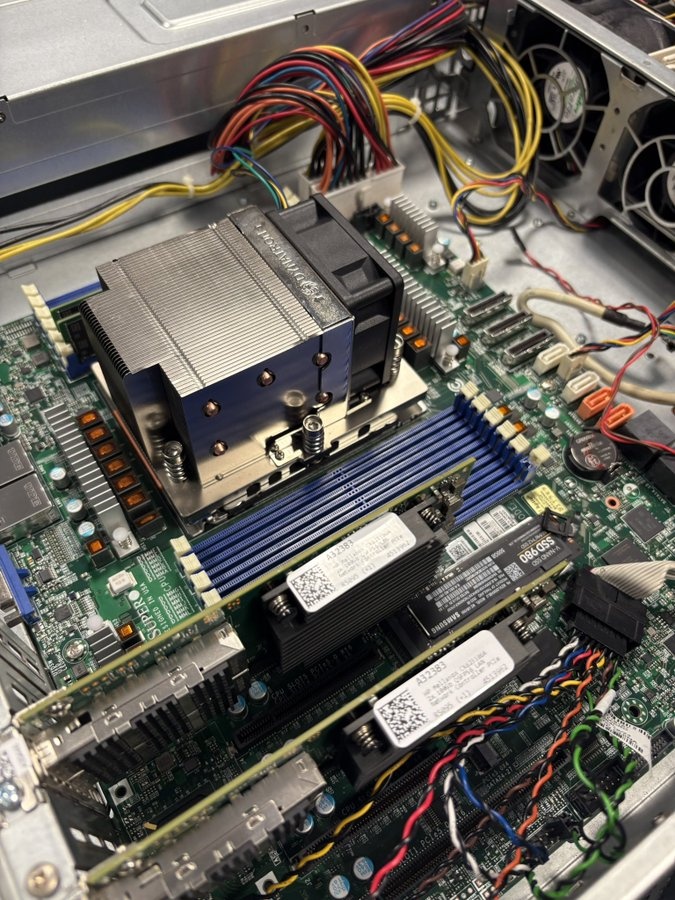

Мы создали высокопроизводительное публичное облако на базе OpenStack, чтобы удовлетворить ваши потребности в облачных вычислениях. RocketCloud предлагает мощные решения по доступной цене, обеспечивая гибкость и надежность для любых задач — от разработки приложений до хранения данных.

Наше облако настроено специально для вас: мы обеспечиваем высокую производительность, безопасность и легкость в управлении. Оцените преимущества облачных технологий с RocketCloud и получите возможность масштабировать свои проекты без лишних затрат!