Product updates | August 6, 2018

NETWORKING

Новый Лос-Анджелес, Калифорния, регион: GAНовый регион Лос-Анджелес в настоящее время и работает. По сравнению с хостингом приложений в следующем ближайшем регионе, их приютили в новом регионе может значительно сократить время задержки для конечных пользователей, в Южный и Северной Калифорнии и юго-западе.

cloudplatform.googleblog.com/2018/07/our-los-angeles-cloud-region-is-open-for-business.html

COMPUTE

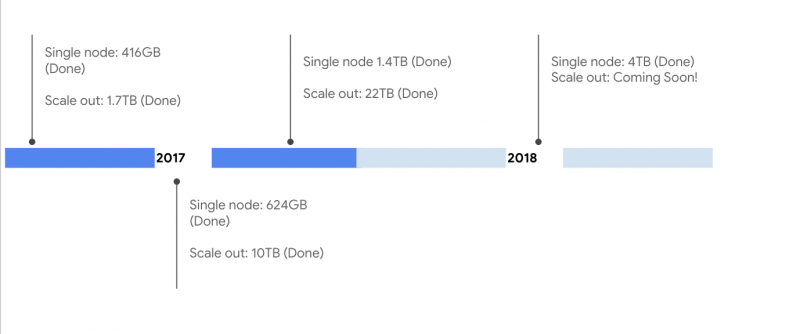

типы машин Ultramem: GAВы можете предоставление памяти оптимизированные типы машин с до 160 виртуальных ЦП и почти 4 ТБ памяти. Обладая более чем 14 ГБ памяти на VCPU, они хорошо подходят для в памяти баз данных и аналитики, такие как SAP HANA и рабочие нагрузки бизнеса-хранилищах.

cloud.google.com/compute/docs/machine-types

cloudplatform.googleblog.com/2018/07/now-shipping-ultramem-machine-types-with-up-to-4tb-of-ram.html

MARKETPLACE

Google Cloud Platform MarketplaceGCP Marketplace, ранее Cloud Launcher, теперь предлагает производство готового Kubernetes приложений. С упрощенным биллингом и лицензированием третьих сторон, теперь вы можете быстро развернуть в различных средах: на территории, на кластерах Kubernetes, работающие на GCP, или на Kubernetes Engine, а также другие общественных облаках.

cloud.google.com/marketplace/

cloudplatform.googleblog.com/2018/07/introducing-commercial-kubernetes-applications-in-gcp-marketplace.html

Cloud Filestore: beta

Облако FILESTORE теперь позволяет предсказуемо высокую производительность для рабочих нагрузок на основе файлов. Она обеспечивает отечественный опыт для управляемых стоя сетевое устройство хранения данных с Compute Engine и Kubernetes Engine экземпляров.

cloud.google.com/filestore/docs/

COMPUTE

Kubernetes Engine minimum CPU platform: GAТеперь вы можете выбрать базовый минимум платформу процессора при создании кластера или узел бассейна. Повысьте скорость и производительность ресурсоемких рабочих нагрузок для графики, игр, а также аналитику, обеспечивая при этом узлы никогда не использовать платформу процессора, что это не подходит для их нужд.

cloud.google.com/kubernetes-engine/docs/how-to/min-cpu-platform

Compute Engine instance templates: GA

Эта функция позволяет создавать и управлять шаблонами экземпляра из экземпляров виртуальных машин, что позволяет быстро дублировать, резервное копирование, и воссоздать экземпляры.

cloud.google.com/sdk/gcloud/reference/beta/dataproc/workflow-templates/instantiate

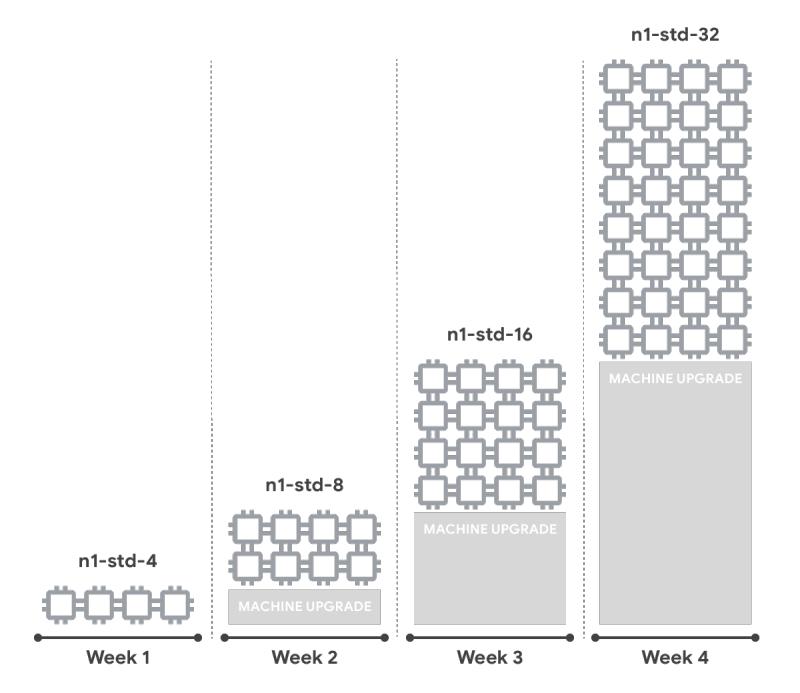

VM rightsizing recommendations: GA

VM рекомендация проклейки — которые предоставляют Вам рекомендуемое экземпляр размера для существующих экземпляров виртуальных машин, основанных на прошлых Memory- и CPU-метрике утилизации — доступна для всех экземпляров Compute Engine, на основе данных мониторинга от хоста VM.

cloud.google.com/compute/docs/instances/apply-sizing-recommendations-for-instances

IDENTITY & SECURITY

Cloud Identity and Access Management domain restricted policies: betaПолитика организации совместного использования домена ограниченно позволяет гарантировать, что только тождества из настроенных доменов могут быть добавлены к политике Cloud IAM, в том числе учетных записей служб. Это предотвращает ресурсы общего доступа с идентичностей вне домена (ов) вашей организации.

cloud.google.com/resource-manager/docs/organization-policy/restricting-domains

STORAGE & DATABASES

Key Visualizer for Cloud Bigtable: betaПолучите лучшее понимание того, как получить доступ к данным, хранящимся в облаке Bigtable с ключевым визуализатором, который генерирует визуальные отчеты ключевых моделей доступа. Устранение неполадок, связанных с производительностью и получить понимание моделей использования в масштабе.

cloud.google.com/bigtable/docs/keyvis-overview

Import/export support for Cloud Spanner: GA

Это очень Запрошенная функция позволяет легко перемещать данные для улучшения аварийного восстановления, тестирования и переноса базы данных. Экспорт любой базы данных Cloud Spanner в облачном хранилище в формате Apache Avro и импортировать файлы из Cloud Storage в новую базу данных Cloud Spanner.

cloudplatform.googleblog.com/2018/07/cloud-spanner-adds-import-export-functionality-to-ease-data-movement.html

NETWORKING

Virtual Private Cloud Flow Logs: GAзапись сеть VPC поток Бревно потоков послана или получена с помощью экземпляров VM на пять-секундные интервалах, и включает в себя богатый набор аннотаций. Вы можете использовать эти журналы для мониторинга сети, судебно-медицинской экспертизы, анализа безопасности в режиме реального времени, а также оптимизации расходов.

cloud.google.com/vpc/docs/using-flow-logs

Cloud Dataproc workflow templates: beta

Облако Dataflow обработки потоков теперь позволяет автору потокового задания и запускать их на облаке DataFlow. Неподвижные, раздвижные и сеансовые окна, а также основная триггерная семантика, все поддерживаются.

cloud.google.com/dataproc/docs/concepts/workflows/workflow-parameters

BigQuery Data Transfer Service for Google Ads: GA

BigQuery Data Transfer Service для объявлений Google (ранее известный как AdWords) позволяет автоматически планировать, запускать и управлять повторяющейся объемными задания загрузки данных экспорта для Google Ads

cloud.google.com/bigquery/docs/adwords-transfer

API MANAGEMENT

Service Usage: betaИспользование службы, служба ГКП инфраструктуры, позволяет обнаружить, включать и отключать службы и их API-интерфейсы для ваших проектов. Они включают в себя услуги и их интерфейсы, созданные Google или третьими лицами с использованием облачных Endpoints

cloud.google.com/service-usage/docs/overview

MARKETPLACE

GCP Marketplace no-obligation software trials: GAВы можете теперь выбрать назначенный программное обеспечение с GCP Marketplace на без обязательств экспериментальной основе. Это делает его легче найти оптимальные решения в соответствии с вашими потребностями.

cloud.google.com/marketplace/docs/understanding-billing

GOOGLE MAPS PLATFORM

Google Maps Платформа введена единая плата, поскольку Вы идете ценовой план его основных карт, маршрутов и мест продукции, без ежегодных, авансовых обязательств, прекращение платежей или ограничений на использование. Все разработчики получат $ 200 стоит свободного ежемесячного использования по отношению к основной продукции.cloud.google.com/maps-platform/user-guide/pricing-changes/