Основные моменты выпуска CloudPanel 2.2.1

1. Поддержка обратного прокси

Обратный прокси-сервер — это сервер, который находится между клиентскими устройствами и внутренним сервером. Он выступает в качестве посредника для клиентских запросов.

Версия CloudPanel 2.2.1 теперь предлагает поддержку обратного прокси.

Обратный прокси-сервер защищает веб-серверы от атак и может обеспечить преимущества в производительности и надежности.

Балансировка нагрузки: обратные прокси-серверы могут распределять входящие запросы на несколько внутренних серверов. Это помогает повысить производительность и надежность веб-сайта.

Повышение безопасности: обратный прокси-сервер может выступать в качестве барьера между клиентскими устройствами и внутренними серверами. Вы получаете дополнительный уровень безопасности.

Кэширование: обратные прокси-серверы могут кэшировать часто используемый контент. Это помогает повысить производительность сайта и снизить нагрузку на сервер.

Фильтрация контента. Обратный прокси-сервер можно использовать для фильтрации контента, например, для блокировки доступа к определенным веб-сайтам или типам контента.

Упрощенное управление сервером: с помощью обратного прокси-сервера вы можете объединить несколько внутренних серверов в один IP-адрес. Это упрощает управление вашей инфраструктурой.

Веб-ускорение: обратные прокси-серверы могут ускорить трафик веб-сайта между клиентом и серверами. Это достигается за счет сжатия данных, кэширования часто запрашиваемого контента и выполнения таких задач, как шифрование SSL, для снижения нагрузки на веб-серверы.

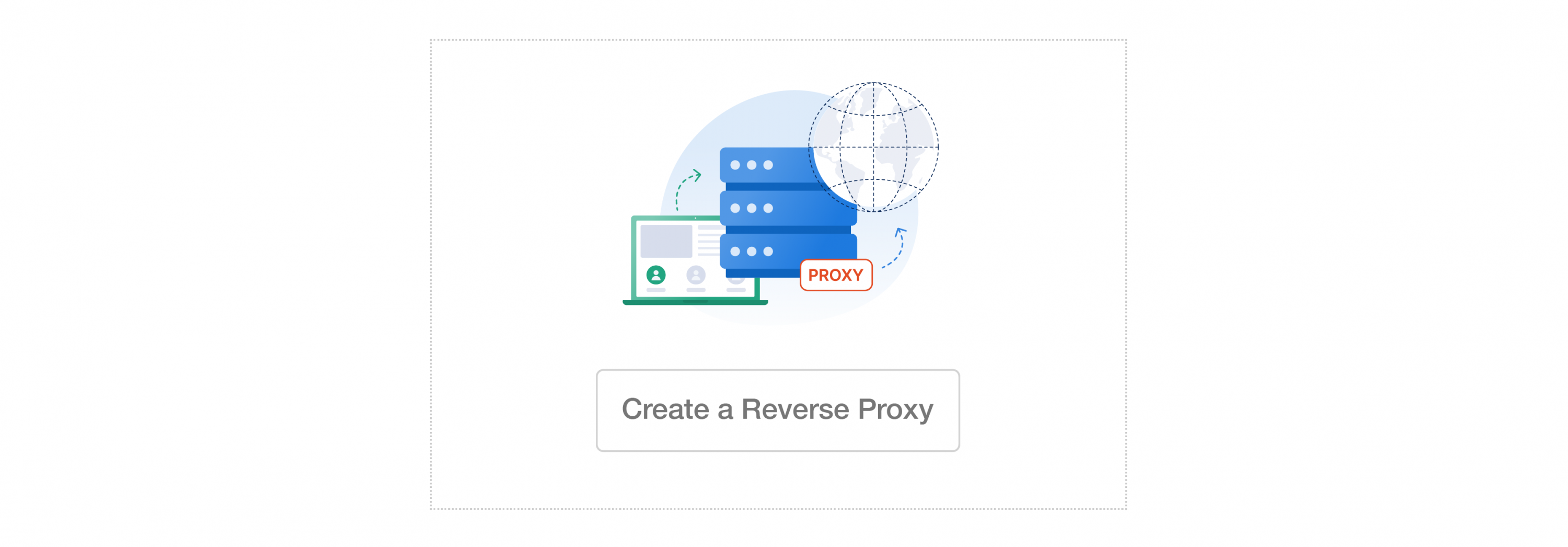

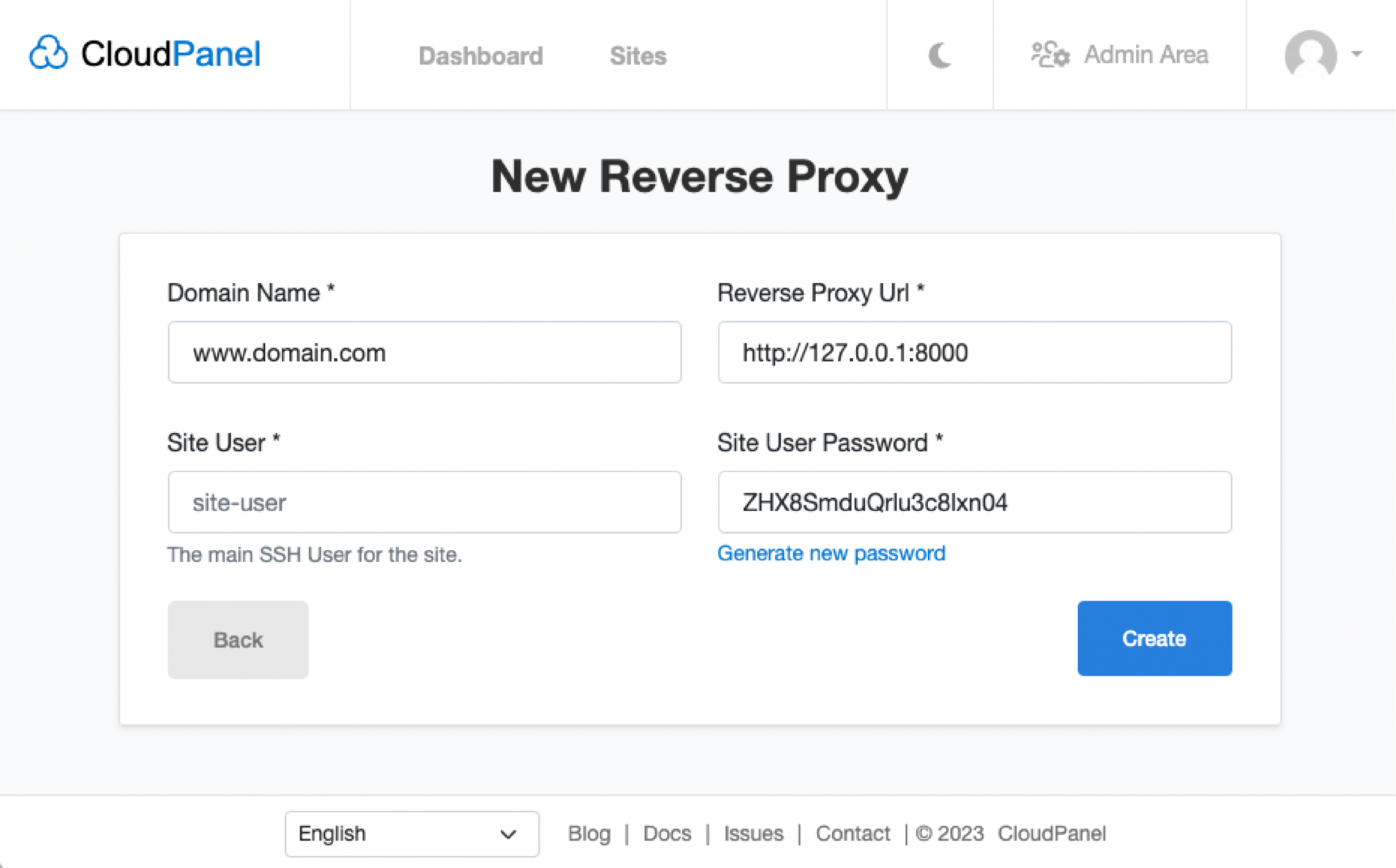

В пользовательском интерфейсе CloudPanel вы можете ввести имя домена, URL-адрес обратного прокси-сервера, пользователя сайта и пароль пользователя сайта.

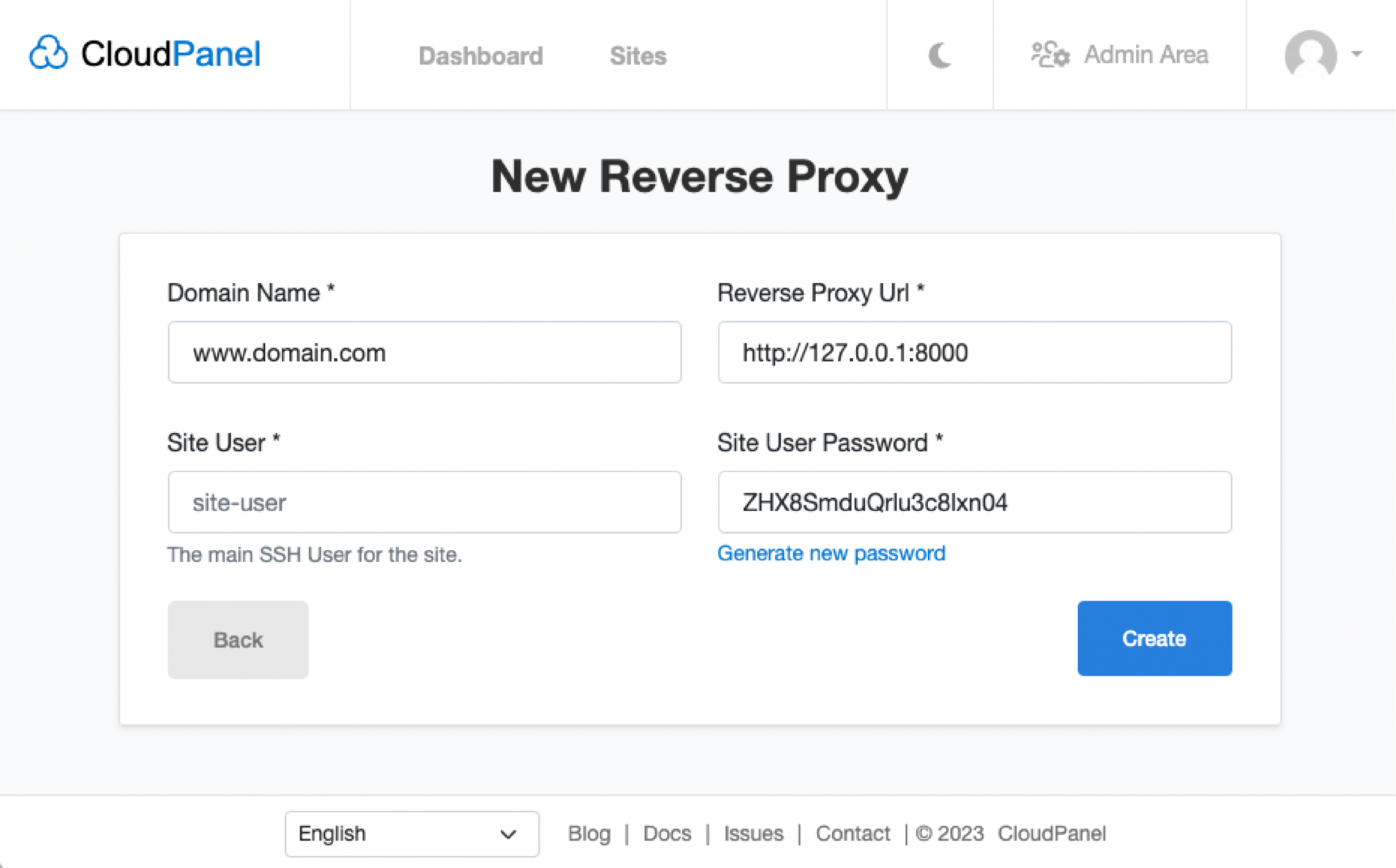

2. Переводы

CloudPanel 2.2.1 теперь поддерживает следующие языки:

- Китайский упрощенный)

- Китайский (Тайвань)