По состоянию на 30 сентября 2020 г. в нашей экосистеме облачного хранилища Backblaze было 153 727 вращающихся жестких дисков, распределенных по четырем центрам обработки данных. Из этого числа было 2780 загрузочных дисков и 150 947 дисков с данными. В этом обзоре рассматривается частота отказов жестких дисков в третьем квартале 2020 года и на протяжении всего срока службы моделей дисков с данными, которые в настоящее время используются в наших центрах обработки данных, а также содержится ряд аналитических данных и наблюдений на этом пути. Как всегда, ждем ваших комментариев.

Квартальная статистика отказов жестких дисков за третий квартал 2020 г.

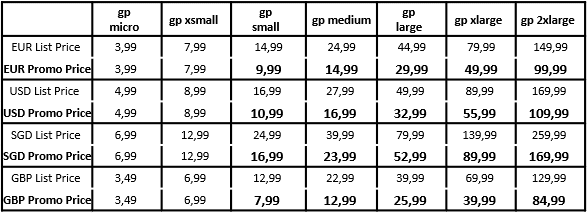

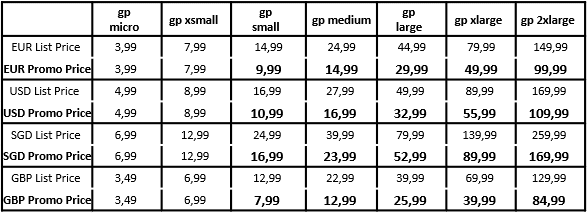

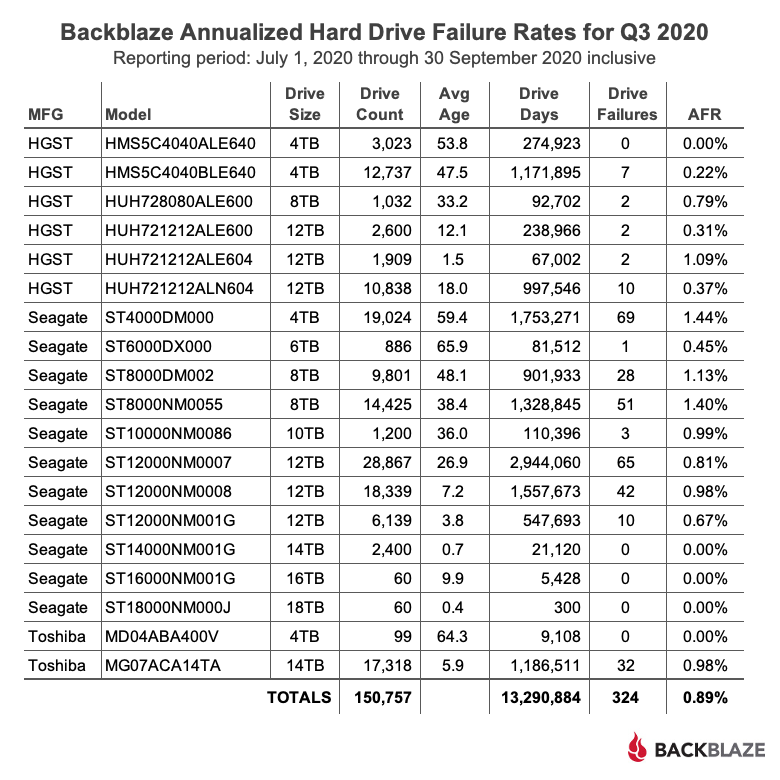

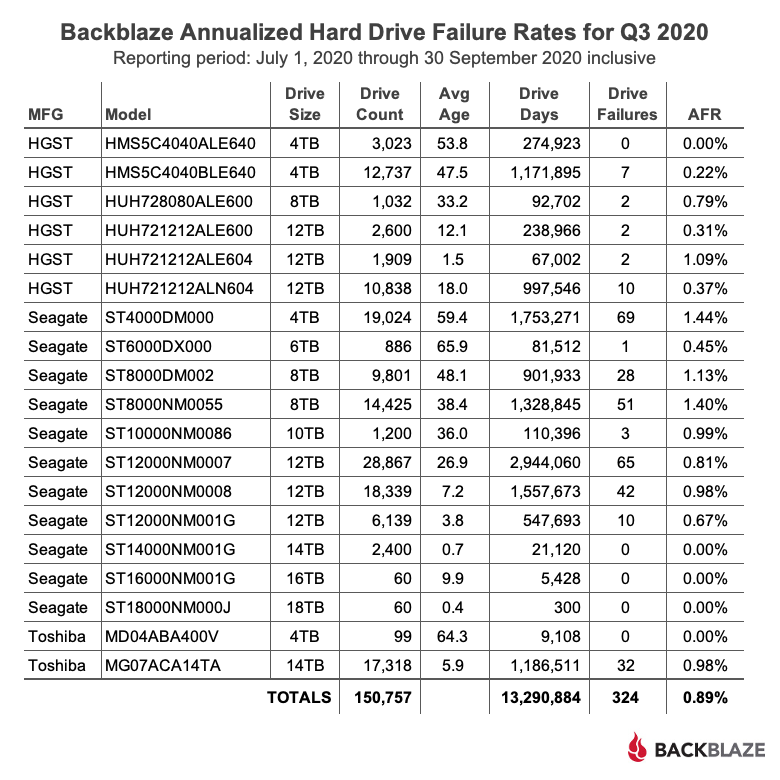

В конце третьего квартала 2020 года Backblaze использовала 150 974 жестких диска для хранения данных клиентов. Для оценки мы исключаем из рассмотрения те модели накопителей, для которых у нас не было хотя бы 60 накопителей (об этом позже). В нашем обзоре осталось 150 757 жестких дисков. В таблице ниже показано, что произошло в третьем квартале 2020 года.

Наблюдения за статистикой за третий квартал

Наблюдения за статистикой за третий квартал

В квартале есть несколько моделей с нулевым количеством отказов дисков. Это здорово, но если немного углубиться, мы узнаем разные истории для каждого из двигателей.

Модель Seagate емкостью 18 ТБ (ST18000NM000J) рассчитана на 300 дней вождения и находится в эксплуатации около 12 дней. Необычных отказов не было, и это хорошее начало, но это все, что вы можете сказать.

Модель Seagate емкостью 16 ТБ (ST16000NM001G) имеет 5 428 дней вождения, что мало, но в среднем они существуют почти 10 месяцев. Тем не менее, я бы пока не пытался делать какие-либо выводы, но еще четверть или две таких, и нам, возможно, будет что сказать.

Модель Toshiba емкостью 4 ТБ (MD04ABA400V) имеет всего 9 108 дней вождения, но они ставят нули в течение семи кварталов подряд. Это должно что-то значить.

Модель Seagate емкостью 14 ТБ (ST14000NM001G) имеет 21 120 дней работы с 2400 дисками, но они проработали менее одного месяца. Следующий квартал даст нам лучшую картину.

4 ТБ HGST (модель: HMS5C4040ALE640) имеет 274 923 диско-дня без сбоев в этом квартале. Все остальное круто, но подождите, пока не кончитесь покупать один. Почему? Скорее всего, вы не получите новый, а если и получите, то ему действительно будет не менее трех лет, поскольку HGST / WDC не выпускает эти диски по крайней мере так долго. Если кто-то из HGST / WDC может подтвердить или опровергнуть это для нас в комментариях, это будет здорово. Есть истории, относящиеся к 2016 году, когда люди пытались заказать этот диск, а вместо этого получали отремонтированный диск. Если вы хотите попробовать отремонтированный диск, это нормально, но наши цифры основаны не на этом.

Годовая частота отказов (AFR) в третьем квартале 2020 года в 0,89% немного выше, чем в предыдущем квартале на уровне 0,81%, но значительно ниже, чем 2,07% год назад. Даже при более низком уровне отказов дисков специалисты нашего центра обработки данных не скучают. В этом квартале они добавили около 11000 новых дисков общим объемом более 150 ПБ, при этом все они работают по строгим протоколам Covid-19. Мы расскажем, как им это удалось, в одной из следующих статей, но давайте просто скажем, что они были заняты.

Остров несоответствующих дисков

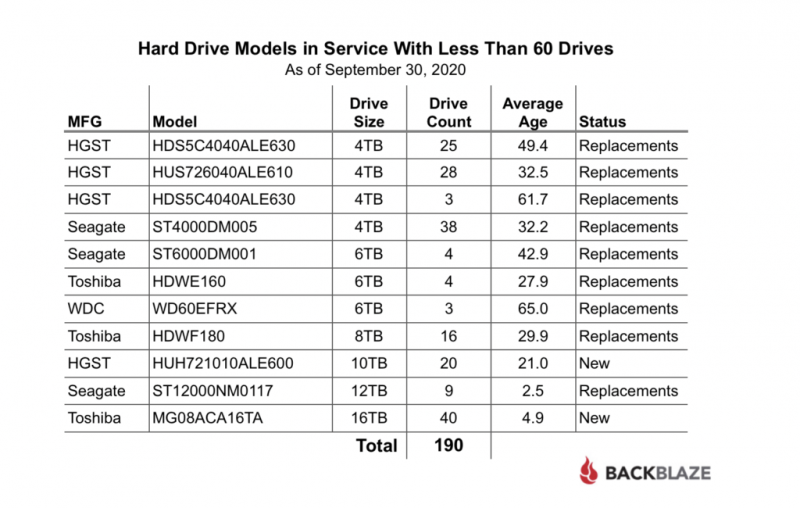

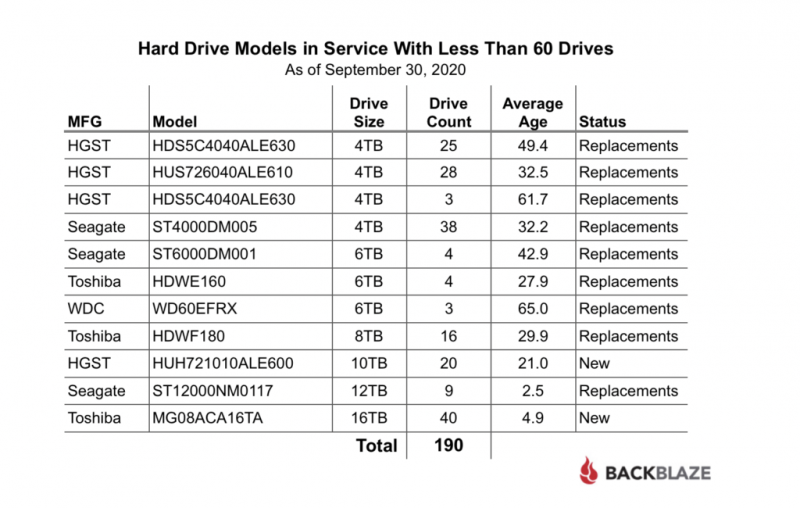

190 приводов (150 947 минус 150 757) не были включены в квартальную диаграмму за 3 квартал 2020 года выше, потому что у нас не было как минимум 60 приводов данной модели. Вот разбивка:

Почти все эти приводы использовались в качестве запасных. Это происходит, когда данная модель привода больше не доступна для покупки, но многие из них уже работают, и нам нужна замена. Например, у нас все еще используются три диска WDC 6 ТБ; они установлены в трех разных модулях Storage Pod вместе с дисками емкостью 6 ТБ от Seagate и HGST. Большинство этих дисков были новыми, когда они были установлены, но иногда мы повторно используем диск, который был выведен из эксплуатации, обычно в результате миграции. Такие диски, конечно, переформатируются, стираются, а затем должны пройти наш процесс квалификации для повторной установки.

В нашем списке два «новых» диска. Это диски, которые подходят для использования в наших центрах обработки данных, но мы еще не развернули их в большом количестве. В случае диска HGST емкостью 10 ТБ доступность и квалификация нескольких моделей емкостью 12 ТБ снизили вероятность того, что мы будем использовать больше этой модели диска. Модель диска Toshiba емкостью 16 ТБ с большей вероятностью будет развернута в будущем, когда мы будем готовы к развертыванию следующей волны больших дисков.

Большие диски здесь

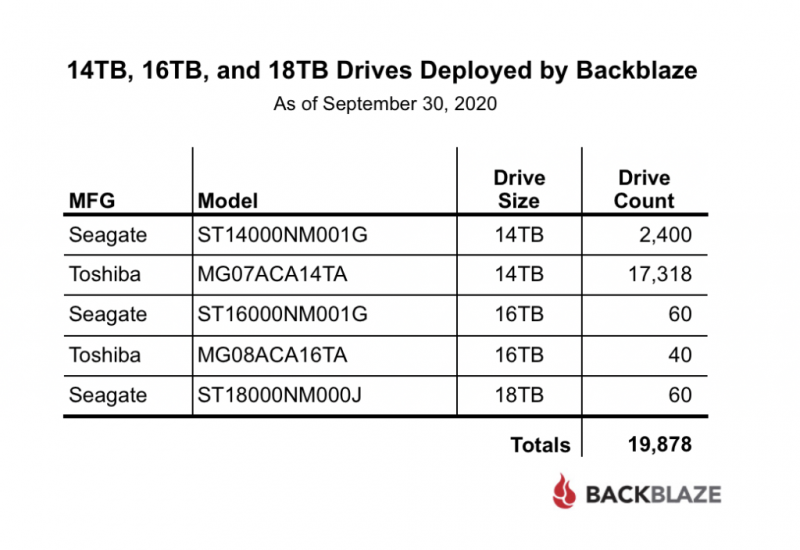

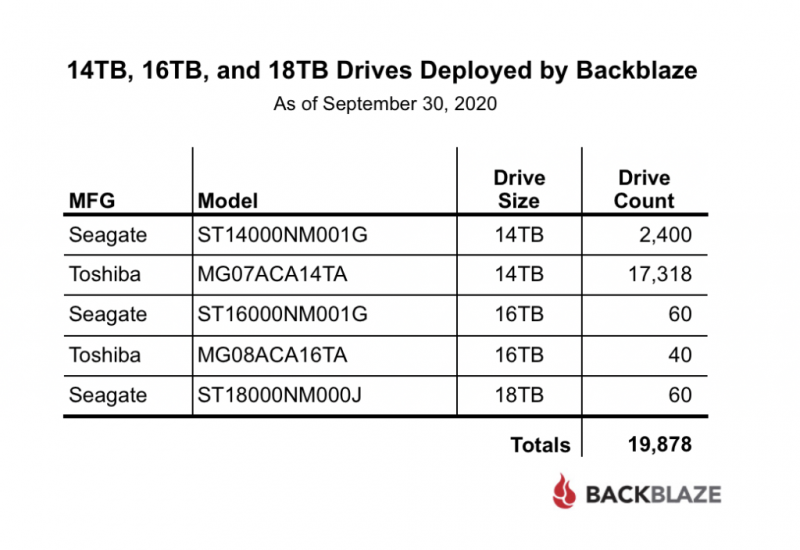

Когда мы впервые начали сбор данных с жестких дисков еще в 2013 году, большой диск был 4 ТБ, а диски на 5 и 6 ТБ только выходили на рынок. Сегодня мы будем определять большие диски как диски емкостью 14, 16 и 18 ТБ. В таблице ниже приведены сведения о текущем использовании этих дисков.

Общее количество 19878 представляет 13,2% наших рабочих дисков с данными. Хотя большинство из них — это диски Toshiba емкостью 14 ТБ, все вышеперечисленное было допущено к использованию в наших центрах обработки данных.

Для всех моделей накопителей, за исключением накопителя Toshiba 14 ТБ, количество дней, проведенных за рулем, по-прежнему слишком мало, чтобы делать какие-либо выводы, хотя модели Seagate 14 ТБ, модель Toshiba 16 ТБ и модель Seagate 18 ТБ на сегодняшний день не испытывали сбоев.

Мы продолжим добавлять эти большие диски в ближайшие кварталы и отслеживать их по пути. По состоянию на 3 квартал 2020 года AFR срока службы для этой группы накопителей составляет 1,04%, что, как мы увидим, ниже AFR срока службы для всех моделей приводов в эксплуатации.

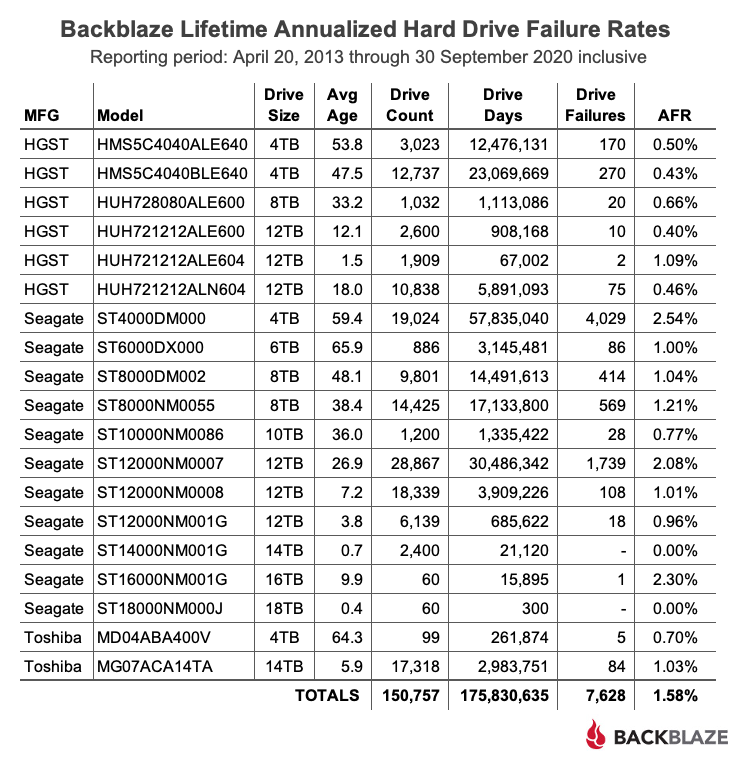

Частота отказов жестких дисков за весь срок службы

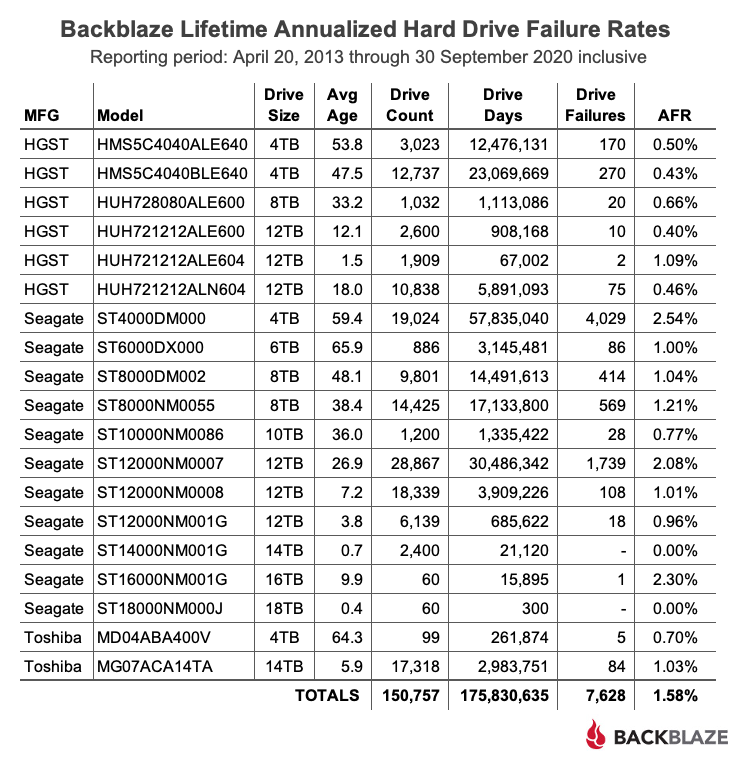

В таблице ниже показан срок службы AFR для моделей жестких дисков, которые у нас были в эксплуатации по состоянию на 30 сентября 2020 г. Все перечисленные модели дисков находились в эксплуатации в течение этого периода.

AFR за весь срок службы по состоянию на третий квартал 2020 года составлял 1,58%, самый низкий показатель с момента начала отслеживания в 2013 году. Это ниже 1,73% год назад и 1,64% в прошлом квартале.

Мы вернули столбец среднего возраста как «Средний возраст». Он измеряется в месяцах и представляет собой средний возраст дисков, используемых для вычисления данных в таблице, основанный на количестве времени, в течение которого они находились в эксплуатации. Следует помнить, что наша среда очень динамична: диски добавляются, переносятся и удаляются на регулярной основе, и это может повлиять на средний возраст. Например, мы могли бы отказаться от Storage Pod с в основном более старыми дисками, и это могло бы снизить средний возраст оставшихся дисков этой модели, в то время как эти оставшиеся диски стали старше.

Если судить по среднему возрасту, диски Seagate емкостью 6 ТБ являются самой старой когортой: каждый из них прослужит в среднем почти пять с половиной лет. Эти диски действительно стали лучше за последние пару лет, и их текущий срок службы AFR составляет 1,0%.

Данные статистики жесткого диска

Полный набор данных, использованных для создания информации, использованной в этом обзоре, доступен на нашей веб-странице с данными тестирования жесткого диска. Вы можете бесплатно скачать и использовать эти данные в своих целях. Все, что мы просим, — это три вещи: 1) вы указываете Backblaze в качестве источника, если используете данные, 2) вы соглашаетесь с тем, что несете исключительную ответственность за то, как вы используете данные, и 3) вы никому не продаете эти данные — они это бесплатно.

www.backblaze.com/b2/hard-drive-test-data.html

Если вам просто нужны обобщенные данные, используемые для создания таблиц и диаграмм в этом сообщении в блоге, вы можете загрузить ZIP-файл, содержащий электронную таблицу MS Excel.

f001.backblazeb2.com/file/Backblaze_Blog/Q3_2020_Drive_Stats_Tables.zip

Удачи и дайте нам знать, если найдете что-нибудь интересное.