все новости по филиалам

Поиск

WaterCooling designed by OVH

OVHcloud Summit

Добро пожаловать в IOStream, бета, наш полностью управляемый сервис потоковой передачи событий

На основе ApachePulsar — скоро разоблачение Kafka API и многое другое. Теперь доступно бесплатно для всех наших пользователей публичного облака.

labs.ovh.com/iostream

OVHcloud Team

Франция привлекла к участию в разработке технологий компании Dassault Systemes и OVH

Франция привлекла к участию в разработке технологий компании Dassault Systemes и OVH, чтобы разработать планы по преодолению доминирования американских компаний в облачных вычислениях, заявил в четверг министр финансов.

Париж стремится создать потенциал для хранения конфиденциальных данных во Франции на фоне опасений, что правительство США может получить данные, хранящиеся на серверах американских компаний, таких как Amazon и Microsoft.

Мы попросили Dassault Systemes и OVH также поработать над этим, и у нас будут первые результаты в декабре 2019 годазаявил министр финансов Бруно Ле Мэр на конференции во французской рекламной онлайн-компании Criteo.

Основываясь на этих результатах, мы хотим создать надежное облако для хранения наиболее конфиденциальных данных наших компанийсказал он, добавив, что сначала проект будет реализован на франко-германском уровне и, возможно, на европейском уровне.

Dassault Systemes — французская компания по разработке программного обеспечения, а OVH — частная французская компания по облачным вычислениям.

Париж обеспокоен тем, что закон США от 2018 года под названием «Закон об облаке» позволяет любому агентству США получать доступ к европейским корпоративным данным, хранящимся в центрах обработки данных американских компаний, не сообщая им об этом.

Это абсолютно неприемлемосказал Ле Мэр, добавив, что необходимо срочно найти решение между Вашингтоном и Европейским союзом.

По словам Ле Маира, к 2020 году Франция инвестирует 1,5 миллиарда евро (1,6 миллиарда долларов) в искусственный интеллект (ИИ), 600 миллионов — в исследования, 800 миллионов — в начальные деньги и средства для вывода проектов ИИ на рынок.

Деньги поступят из инновационного фонда, финансируемого за счет продажи государственных активов, начиная с продажи доли в французской лотерейной монополии la Francaise des Jeux «в ближайшие недели», сказал он.

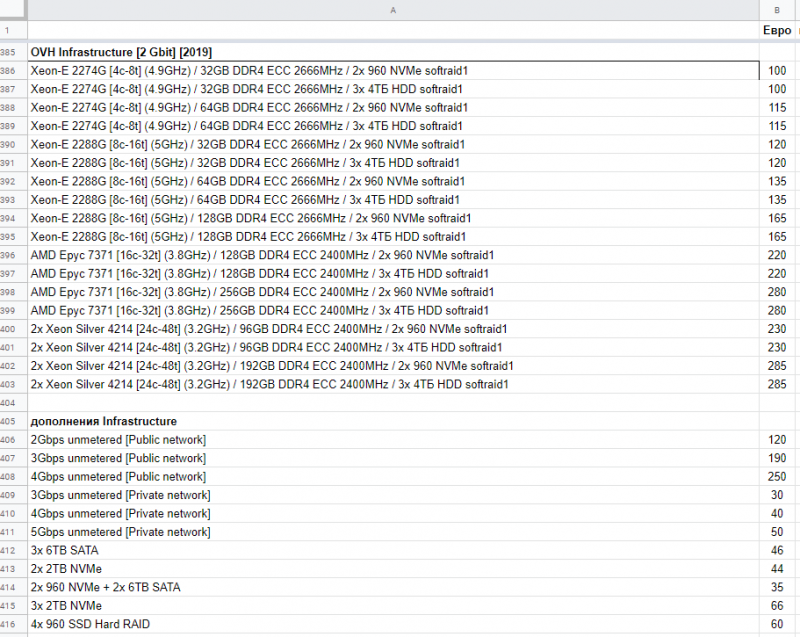

Новая инфраструктурная линейка

Приглашение: OVHcloud Summit

Привет.

Уже 20 лет! OVH Эти осенью будет отмечать два десятилетия технологических инноваций на службе наших клиентов. Тем не менее, каждое утро, я продолжаю просыпаться с тысячами идей в уме! И я надеюсь, что в ближайшие 20 лет OVH ознаменуется совместного строительства глобальной технологической экосистемы, уважая наши европейские ценности.

10 октября, я надеюсь увидеть вас в Париже на 7е издание Саммита OVHcloud. Мишель Полин, и наша команда, у нас есть много красивых новостей, чтобы поделиться с вами.

Утром Keynote, мы разделим наше видение, стратегия и инновационные продукты. Для того, чтобы помочь вам перевести все эти технологии в своем бизнесе, мы предоставили во второй половине дня лекций, лабораторий, демонстраций, семинаров и круглых столов. Они позволяют обнаружить наши решения и дать вашу обратную связь, чтобы пройти обучение по их использованию, обмен опытом с экспертами и встретиться с нашими партнерами.

Это было 20 лет назад, не было никакого имени для нашего бизнеса. Мы поэтому называется OVH «On You Спит". Сегодня все знают, что OVH предлагает облако. Для того, чтобы прояснить и вновь подтвердить нашу стратегию в этом году «OVH» меняет свое название на «OVHcloud». Саммит OVHcloud также возможность возобновить наши обязательства в качестве европейского лидера, представляющего собой альтернативу во всем мире, мы делаем пункт, чтобы позволить вам контролировать свои данные, обновлять и осуществлять свободно.

Я буду очень рад видеть вас четверг, 10 Октября.

Приходите!

С уважением, октава

@olesovhcom

summit.ovhcloud.com/fr/subscription/

PoC работает в Лотарингии в течение 2 лет

Это «тихоходная ветряная турбина прямого действия», которую наши команды разрабатывали и запатентовали в течение 5 лет. PoC работает в Лотарингии в течение 2 лет: производство 8 ветряных турбин 8x 800 кВА с очень слабым ветром.

patents.google.com/patent/EP0864748A1/fr

patents.google.com/patent/EP0864748A1/fr

EU-C (Strasbourg, FR)

EU-C (Страсбург, FR) Так рад видеть SBG на вершине. Отличная команда! Удивительная работа проделана за последние 2 года. Новый SBG5 скоро.