Мы предполагаем, что новые тарифы вступят в силу 1 апреля 2026 года или 1 мая 2026 года

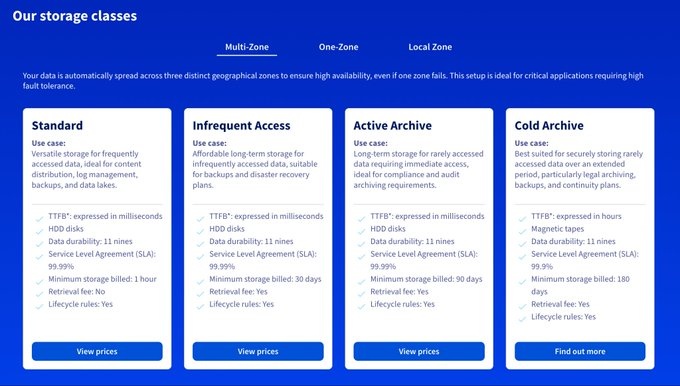

Как вам известно, в глобальном масштабе три крупнейших производителя памяти перенаправили свои производственные мощности на удовлетворение спроса на графические процессоры. Поскольку глобальный спрос не снизился, это привело к резкому росту цен на оперативную память и жесткие диски с сентября 2025 года. Ожидается, что эта тенденция сохранится, и новое равновесие между спросом и предложением, вероятно, будет достигнуто к концу 2026 года.

Тем не менее, цены останутся высокими как минимум до 2028 года, пока будут развиваться новые производственные мощности по выпуску памяти. Эта ситуация коренным образом меняет стоимость ИТ-оборудования, и не только в облачной среде. Рост цен, в зависимости от объема оперативной памяти и дискового пространства, может составлять от +15% до +200%. Это огромная разница!

Однако, даже при таком повышении цен, оперативная память и жесткие диски не всегда легко доступны на рынке. Для гарантированной доставки заказы необходимо размещать за 12 месяцев вперед, не зная точной цены! Цены объявляются только через 1-2 месяца после поставки, в зависимости от спроса и предложения в течение квартала.

Эта ситуация неизбежно повлияет на объемы продаж, поскольку некоторые покупатели сочтут продукцию слишком дорогой, в то время как у других не останется выбора, кроме как сделать заказ. Таким образом, это противоречие между спросом и предложением приведет к новому глобальному равновесию. По оценкам, к концу 2026 года оперативная память будет на 250–300% дороже, чем в сентябре 2025 года!

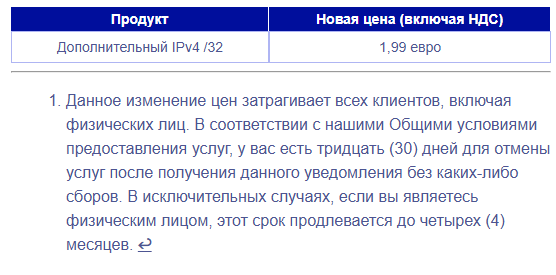

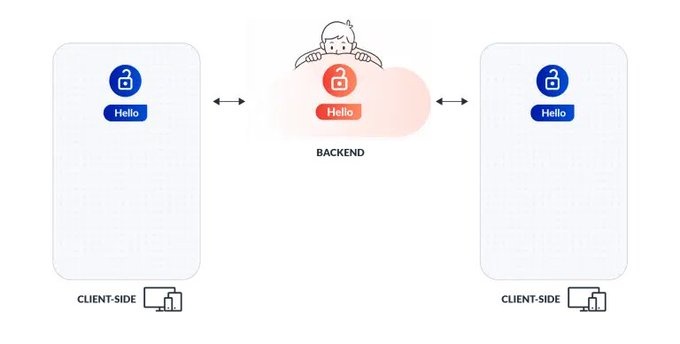

В OVHcloud мы хотим смягчить последствия повышения цен на компоненты, чтобы предотвратить чрезмерное удорожание нашего облака (публичного облака, частного облака, физического оборудования). Поэтому для облака, которое мы развернем в период с 2026 по 2028 год, мы решили повысить цены меньше, чем фактическая стоимость оперативной памяти и дисков. Таким образом, цена нашего облака в период с 2026 по 2028 год вырастет в среднем всего на 9–11%. В качестве компенсации мы планируем незначительно повлиять на цены облака, развернутого в период с 2021 по 2025 год, в среднем на 2–6%, в зависимости от возраста оборудования, и немного скорректировать цены на IPv4. Мы надеемся, что это сделает цены в период 2021–2028 годов более доступными, а возвращение к нормальным ценам ожидается в 2029 году.

В настоящее время мы работаем над серией электронных писем, которые будут отправлены вам со всей необходимой информацией. Мы предполагаем, что новые тарифы вступят в силу 1 апреля 2026 года или 1 мая 2026 года. Конечно, до этого времени у вас есть возможность продлить услуги по текущим ценам на срок до двух лет. Во всех случаях новые цены будут действовать только по окончании срока действия договора на каждую услугу.

Мы переживаем исключительно непредсказуемый период. Никто не может предсказать ситуацию дальше, чем на одну-две недели. Мы надеемся, что цены на память стабилизируются к 2026 году, чтобы избежать новых негативных новостей. Тем не менее, именно в такие времена мы осознаем реальное преимущество наличия глобальной цепочки поставок и двух собственных производственных мощностей, поскольку мы продолжаем получать компоненты и производить серверы в условиях реального дефицита памяти.